Python 爬虫从入门到进阶之路(十四)

之前的文章我们已经可以根据 re 模块,Xpath 模块和 BeautifulSoup4 模块来爬取网站上我们想要的数据并且存储在本地,但是我们并没有对存储数据的格式有要求,本章我们就来看数据的存储格式 JSON 及 Python 中的 json 模块。

JSON(JavaScript Object Notation) 是一种轻量级的数据交换格式,它使得人们很容易的进行阅读和编写。同时也方便了机器进行解析和生成。适用于进行数据交互的场景,比如网站前台与后台之间的数据交互。

JSON和XML的比较可谓不相上下。

Python 中自带了JSON模块,直接import json就可以使用了。

官方文档:http://docs.python.org/library/json.html

Json在线解析网站:http://www.json.cn/#

json简单说就是javascript中的对象和数组,所以这两种结构就是对象和数组两种结构,通过这两种结构可以表示各种复杂的结构

对象:对象在js中表示为

{ }括起来的内容,数据结构为{ key:value, key:value, ... }的键值对的结构,在面向对象的语言中,key为对象的属性,value为对应的属性值,所以很容易理解,取值方法为 对象.key 获取属性值,这个属性值的类型可以是数字、字符串、数组、对象这几种。数组:数组在js中是中括号

[ ]括起来的内容,数据结构为["Python", "javascript", "C++", ...],取值方式和所有语言中一样,使用索引获取,字段值的类型可以是 数字、字符串、数组、对象几种。

Python中 json 模块提供了四个功能:dumps、dump、loads、load,用于字符串 和 python数据类型间进行转换。

1. json.loads()

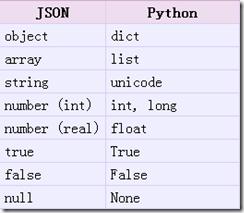

把Json格式字符串解码转换成Python对象 从json到python的类型转化对照如下:

import json strList = '[1, 2, 3, 4]'

strDict = '{"city": "北京", "name": "大猫"}' print(json.loads(strList)) # [1, 2, 3, 4]

print(json.loads(strDict)) # {'city': '北京', 'name': '张三'}

2. json.dumps()

实现 python 类型转化为 json 字符串,返回一个str对象 把一个 Python 对象编码转换成 Json 字符串

从 python 原始类型向 json 类型的转化对照如下:

import json listStr = [1, 2, 3, 4]

tupleStr = (1, 2, 3, 4)

dictStr = {"city": "北京", "name": "张三"} print(json.dumps(listStr)) # '[1, 2, 3, 4]'

print(json.dumps(tupleStr)) # '[1, 2, 3, 4]'

print(json.dumps(dictStr)) # '{"city": "\u5317\u4eac", "name": "\u5f20\u4e09"}'

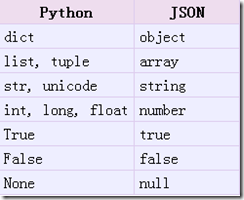

3. json.dump()

将Python内置类型序列化为json对象后写入文件

import json

listStr = [{"city": "北京"}, {"name": "张三"}]

json.dump(listStr, open("listStr.json", "w"))

dictStr = {"city": "北京", "name": "李四"}

json.dump(dictStr, open("dictStr.json", "w"), ensure_ascii=False) # 添加参数 ensure_ascii=False 禁用ascii编码,按utf-8编码

输出结果:

4. json.load()

读取文件中json形式的字符串元素 转化成python类型

import json

strList = json.load(open("listStr.json"))

print(strList) # [{'city': '北京'}, {'name': '张三'}]

strDict = json.load(open("dictStr.json"))

print(strDict) # {'city': '北京', 'name': '李四'}

JsonPath

JsonPath 是一种信息抽取类库,是从JSON文档中抽取指定信息的工具,提供多种语言实现版本,包括:Javascript, Python, PHP 和 Java。

JsonPath 对于 JSON 来说,相当于 XPATH 对于 XML。

下载地址:https://pypi.python.org/pypi/jsonpath

安装方法:点击

Download URL链接下载jsonpath,解压之后执行python setup.py install

JsonPath与XPath语法对比:

Json结构清晰,可读性高,复杂度低,非常容易匹配,下表中对应了XPath的用法。

| XPath | JSONPath | 描述 |

|---|---|---|

/ |

$ |

根节点 |

. |

@ |

现行节点 |

/ |

.or[] |

取子节点 |

.. |

n/a | 取父节点,Jsonpath未支持 |

// |

.. |

就是不管位置,选择所有符合条件的条件 |

* |

* |

匹配所有元素节点 |

@ |

n/a | 根据属性访问,Json不支持,因为Json是个Key-value递归结构,不需要。 |

[] |

[] |

迭代器标示(可以在里边做简单的迭代操作,如数组下标,根据内容选值等) |

| | | [,] |

支持迭代器中做多选。 |

[] |

?() |

支持过滤操作. |

| n/a | () |

支持表达式计算 |

() |

n/a | 分组,JsonPath不支持 |

示例:

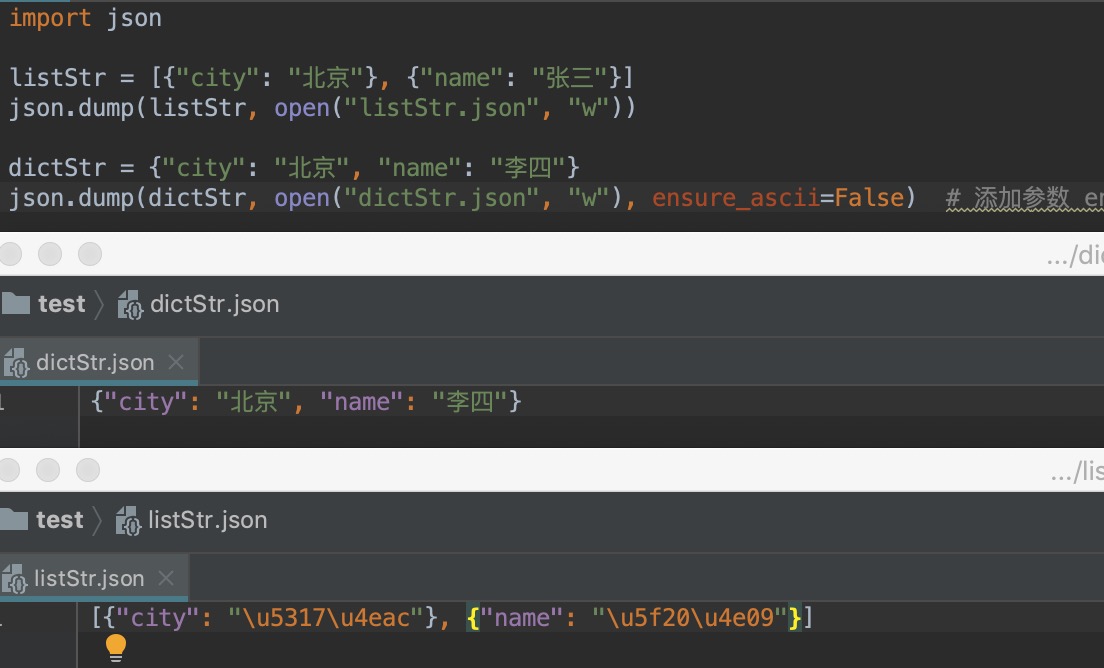

我们以拉勾网城市JSON文件 https://www.lagou.com/lbs/getAllCitySearchLabels.json 为例,获取所有城市。

import urllib.request

import json

import jsonpath

import ssl # 取消代理验证

ssl._create_default_https_context = ssl._create_unverified_context url = 'https://www.lagou.com/lbs/getAllCitySearchLabels.json'

headers = {

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.121 Safari/537.36"}

# 发送请求

request = urllib.request.Request(url, headers=headers)

response = urllib.request.urlopen(request)

html = response.read().decode("utf-8")

# 把json格式字符串转换成python对象

jsonobj = json.loads(html)

# 从根节点开始,匹配name节点

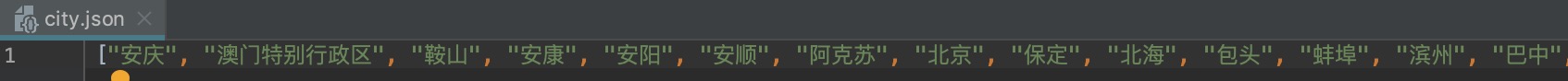

citylist = jsonpath.jsonpath(jsonobj, '$..name') fp = open('city.json', 'w')

content = json.dumps(citylist, ensure_ascii=False)

fp.write(content)

fp.close()

程序启动后会在本地生成一个 city.json 的文件,结果如下:

Python 爬虫从入门到进阶之路(十四)的更多相关文章

- Python 爬虫从入门到进阶之路(四)

之前的文章我们做了一个简单的例子爬取了百度首页的 html,我们用到的是 urlopen 来打开请求,它是一个特殊的opener(也就是模块帮我们构建好的).但是基本的 urlopen() 方法不支持 ...

- Python 爬虫从入门到进阶之路(八)

在之前的文章中我们介绍了一下 requests 模块,今天我们再来看一下 Python 爬虫中的正则表达的使用和 re 模块. 实际上爬虫一共就四个主要步骤: 明确目标 (要知道你准备在哪个范围或者网 ...

- Python 爬虫从入门到进阶之路(二)

上一篇文章我们对爬虫有了一个初步认识,本篇文章我们开始学习 Python 爬虫实例. 在 Python 中有很多库可以用来抓取网页,其中内置了 urllib 模块,该模块就能实现我们基本的网页爬取. ...

- Python 爬虫从入门到进阶之路(六)

在之前的文章中我们介绍了一下 opener 应用中的 ProxyHandler 处理器(代理设置),本篇文章我们再来看一下 opener 中的 Cookie 的使用. Cookie 是指某些网站服务器 ...

- Python 爬虫从入门到进阶之路(九)

之前的文章我们介绍了一下 Python 中的正则表达式和与爬虫正则相关的 re 模块,本章我们就利用正则表达式和 re 模块来做一个案例,爬取<糗事百科>的糗事并存储到本地. 我们要爬取的 ...

- Python 爬虫从入门到进阶之路(十二)

之前的文章我们介绍了 re 模块和 lxml 模块来做爬虫,本章我们再来看一个 bs4 模块来做爬虫. 和 lxml 一样,Beautiful Soup 也是一个HTML/XML的解析器,主要的功能也 ...

- Python 爬虫从入门到进阶之路(十五)

之前的文章我们介绍了一下 Python 的 json 模块,本章我们就介绍一下之前根据 Xpath 模块做的爬取<糗事百科>的糗事进行丰富和完善. 在 Xpath 模块的爬取糗百的案例中我 ...

- Python 爬虫从入门到进阶之路(十六)

之前的文章我们介绍了几种可以爬取网站信息的模块,并根据这些模块爬取了<糗事百科>的糗百内容,本章我们来看一下用于专门爬取网站信息的框架 Scrapy. Scrapy是用纯Python实现一 ...

- Python 爬虫从入门到进阶之路(十七)

在之前的文章中我们介绍了 scrapy 框架并给予 scrapy 框架写了一个爬虫来爬取<糗事百科>的糗事,本章我们继续说一下 scrapy 框架并对之前的糗百爬虫做一下优化和丰富. 在上 ...

- Python 爬虫从入门到进阶之路(五)

在之前的文章中我们带入了 opener 方法,接下来我们看一下 opener 应用中的 ProxyHandler 处理器(代理设置). 使用代理IP,这是爬虫/反爬虫的第二大招,通常也是最好用的. 很 ...

随机推荐

- 用WPF实现在ListView中的鼠标悬停Tooltip显示

原文:用WPF实现在ListView中的鼠标悬停Tooltip显示 一.具体需求描述 在WPF下实现,当鼠标悬停在ListView中的某一元素的时候能弹出一个ToolTip以显示需要的信息. 二.代码 ...

- ng-zorro 子菜单

效果 代码 // 初始化菜单 // res.menu是一个Menu数组 // 在后端创建子菜单 res.menu.push({ text: "", i18n: "子菜单& ...

- Windows静态库和动态库的创建和使用(VS2005)

偶们在实际的编程开发中,经常会遇到运行时无法找到某个DLL文件或者链接时无法找到某个LIB文件.然后,我们就开始乱GOOGLE一下,然后将VS2005的设置改变一下,或许就Ok了,我们将别人开发的DL ...

- Angular语法(二)——模板语法

双花括号{{}} <img src="{{heroImageUrl}}" style="height:30px"> <!-- "Th ...

- DELPHI7中 TObjectList sort排序问题

网上收集了一点东西 TOBJECTLIST里,有自带的排序功能 TLIST,TSTRINGLIST也有,MS是一样的 SORT里有一个参数: Compare:TListSortCompare 那我们先 ...

- WPF 界面实现多语言支持 中英文切换 动态加载资源字典

1.使用资源字典,首先新建两个字典文件en-us.xaml.zh-cn.xaml.定义中英文的字符串在这里面[注意:添加xmlns:s="clr-namespace:System;assem ...

- swift4.0 Http 请求

// // HttpHelper.swift // NavigateDemo // // Created by yixin ran on 07/08/2017. // Copyright © 2017 ...

- 获取控件中应用的模版的内部的控件,使用LoadContent()方法获取模版跟节点

treeview获取内部控件元素 Button btnAdd = ((tvks.HeaderTemplate as DataTemplate).LoadContent() as StackPanel) ...

- UBUTUN 通过蓝牙连接Hoary和诺基亚手机

通过蓝牙连接Hoary和诺基亚手机 这个how to已经用Hoary.诺基亚6630和一个道尔芯片(Dongle)蓝牙(Usb蓝牙)测试过了.通过这个How to,你可以:-通过蓝牙,从你的电脑发送文 ...

- svn文件合并

cd 目标目录svn merge -r 开始版本号:结束版本号 源目录或单个文件URL或svn merge 源目录或单个文件URL