爬虫学习--Requests库详解 Day2

什么是Requests Requests是用python语言编写,基于urllib,采用Apache2 licensed开源协议的HTTP库,它比urllib更加方便,可以节约我们大量的工作,完全满足HTTP测试需求。

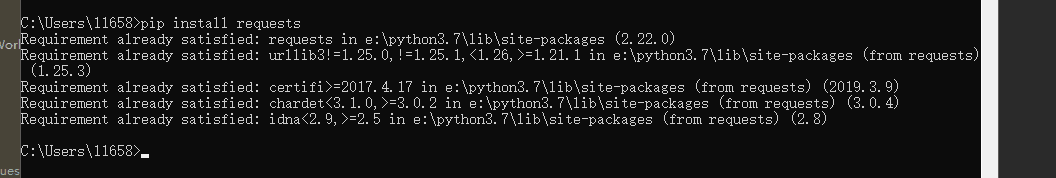

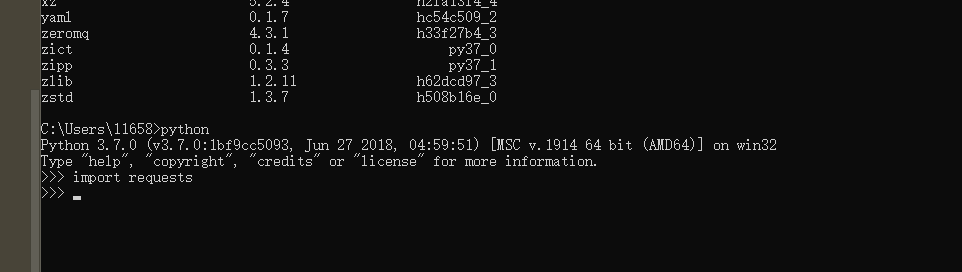

一句话总结:它是Python实现的简单易用的HTTP库 安装Requests pip install requests

验证没有报错,表示已经成功的安装了

实例引入

import requests

response = requests.get('https://www.baidu.com')

print(type(response))

print(response.status_code) # 状态码

print(type(response.text))

print(response.text) # 响应的内容

print(response.cookies) # 获取cookie

各种请求方式

import requests

print(requests.post('http://httpbin.org/post')) #

print(requests.put('http://httpbin.org/put'))

print(requests.delete('http://httpbin.org/delete'))

print(requests.head('http://httpbin.org/get'))

print(requests.options('http://httpbin.org/get'))

Requests库请求具体怎么用的

基本GET请求-----------------------------------------------------------------------------------------------------------

基本写法

import requests

response = requests.get('http://httpbin.org/get')

print(response.text) # 请求头啊,请求的IP地址,请求的链接

带参数的GET请求

import requests

response = requests.get('http://httpbin.org/get?name=germey&age=22')

print(response.text)

也可以用字典的形式传参 params

import requests

data = {

'name':'xiaohu',

'age':''

}

response = requests.get('http://httpbin.org/get',params=data)

print(response.text)

解析json

import requests

response = requests.get('http://httpbin.org/get')

print(type(response.text))

print(response.json())

print(type(response.json())) # 它是一个字典的类型

区别用json.loads与直接.json有什么不一样,结果其实是一样的

import requests

import json response = requests.get('http://httpbin.org/get')

print(type(response.text))

print(response.json())

print(json.loads(response.text)) #区别用json.loads与直接.json有什么不一样,结果其实是一样的

print(type(response.json())) # 它是一个字典的类型

获取二进制数据

import requests

response = requests.get('https://github.com/favicon.ico')

print(type(response.text),type(response.content)) # .content是二进制内容

print(response.text)

print(response.content)

获取到图片把它保存

import requests

response = requests.get('https://github.com/favicon.ico')

with open('favicon','wb') as f:

f.write(response.content)

f.close()

添加headers 如果不加headers 报错500

import requests headers = {

'User-Agent':'Mozilla/5.0(Macintosh;intel Mac OS X 10_11_4)AppleWebKit/537.36(KHTML,like Gecko)Chrome/52.0.2743.116 Safari/537.36'

}

response = requests.get("https://www.zhihu.com/explore",headers=headers)

print(response.text)

基本POST请求

import requests

data = {

'name':'xiaohu',

'age':'',

'job':'IT'

}

response = requests.post('http://httpbin.org/post',data=data)

print(response.text)

import requests

data = {

'name':'xiaohu',

'age':'',

'job':'IT'

}

headers = {

'User-Agent':'Mozilla/5.0(Macintosh;intel Mac OS X 10_11_4)AppleWebKit/537.36(KHTML,like Gecko)Chrome/52.0.2743.116 Safari/537.36'

}

response = requests.post('http://httpbin.org/post',data=data,headers=headers)

print(response.json())

响应

response属性

import requests

response = requests.get('http://www.jianshu.com')

print(type(response.status_code),response.status_code) # 状态码

print(type(response.headers),response.headers) # 请求头

print(type(response.cookies),response.cookies) #

print(type(response.url),response.url)

print(type(response.history),response.history) # 访问的历史记录

高级操作

文件上传

import requests

files = {

'file':open('favicon','rb')

}

response = requests.post('http://httpbin.org/post',files=files)

print(response.text)

获取cookie

import requests

response = requests.get('https://www.baidu.com')

print(response.cookies)

print(type(response.cookies))

for key,value in response.cookies.items():

print(key+'='+value)

会话维持

import requests

requests.get('http://httpbin.org/cookies/set/number/1165872335') # 为网站设置一个cookies

response = requests.get('http://httpbin.org/cookies') # 再用get访问这个cookies

print(response.text) # 为空,因为这里进行了两次get请求,相当于两个浏览器分别设置cookies和访问cookies,相对独立的

改进

import requests

S = requests.Session() # 声明对象

S.get('http://httpbin.org/cookies/set/number/1165872335') # 实现在同一个浏览器进行设置rookies和访问rookies

response = S.get('http://httpbin.org/cookies') # 再用get访问这个cookies

print(response.text) # 此时不为空

证书验证

import requests

from requests.packages import urllib3

urllib3.disable_warnings() # 消除警告信息 response = requests.get('https://www.12306.cn',verify=False) # verify=False 不需要验证进入,但是有警告

print(response.status_code)

import requests

response = requests.get('https://www.12306.cn',cert=('/path/server.crt','/path/key')) # 指定的证书

print(response.status_code)

代理设置

import requests

import socks5 proxies = {

"http":"socks5://127.0.0.1:8080",

"https":"socks5://127.0.0.1:8080",

} response = requests.get('https://www.taobao.com',proxies=proxies)

print(response.status_code)

超时设置

import requests

from requests.exceptions import ReadTimeout try:

response = requests.get('https://www.httpbin.org/get',timeout = 0.2)

print(response.status_code)

except ReadTimeout:

print("timeout")

认证设置

import requests

from requests.auth import HTTPBasicAuth r = requests.get('http://127.27.34.24:9001',auth=HTTPBasicAuth('user',''))

print(r.status_code) # 第二种方式

import requests r = requests.get('http://127.27.34.24:9001',auth=('user',''))

print(r.status_code)

异常处理

import requests

from requests.exceptions import ReadTimeout,HTTPError,RequestException,ConnectionError

try:

response = requests.get('http://httpbin.org/get',timeout = 0.2)

print(response.status_code)

except ReadTimeout:

print('Timeout')

except HTTPError:

print('Http error')

except ConnectionError:

print('Connection Error')

except RequestException:

print('error')

爬虫学习--Requests库详解 Day2的更多相关文章

- Python爬虫:requests 库详解,cookie操作与实战

原文 第三方库 requests是基于urllib编写的.比urllib库强大,非常适合爬虫的编写. 安装: pip install requests 简单的爬百度首页的例子: response.te ...

- Python爬虫系列-Requests库详解

Requests基于urllib,比urllib更加方便,可以节约我们大量的工作,完全满足HTTP测试需求. 实例引入 import requests response = requests.get( ...

- Python爬虫系列-Urllib库详解

Urllib库详解 Python内置的Http请求库: * urllib.request 请求模块 * urllib.error 异常处理模块 * urllib.parse url解析模块 * url ...

- Python爬虫学习==>第八章:Requests库详解

学习目的: request库比urllib库使用更加简洁,且更方便. 正式步骤 Step1:什么是requests requests是用Python语言编写,基于urllib,采用Apache2 Li ...

- python WEB接口自动化测试之requests库详解

由于web接口自动化测试需要用到python的第三方库--requests库,运用requests库可以模拟发送http请求,再结合unittest测试框架,就能完成web接口自动化测试. 所以笔者今 ...

- python接口自动化测试之requests库详解

前言 说到python发送HTTP请求进行接口自动化测试,脑子里第一个闪过的可能就是requests库了,当然python有很多模块可以发送HTTP请求,包括原生的模块http.client,urll ...

- requests库详解 --Python3

本文介绍了requests库的基本使用,希望对大家有所帮助. requests库官方文档:https://2.python-requests.org/en/master/ 一.请求: 1.GET请求 ...

- python的requests库详解

快速上手 迫不及待了吗?本页内容为如何入门 Requests 提供了很好的指引.其假设你已经安装了 Requests.如果还没有,去安装一节看看吧. 首先,确认一下: Requests 已安装 Req ...

- 爬虫学习--http请求详解

上篇博客里面写了,爬虫就是发http请求(浏览器里面打开发送的都是http请求),然后获取到response,咱们再从response里面找到想要的数据,存储到本地. 咱们本章就来说一下什么是http ...

随机推荐

- Label的作用是什么,是怎么用的?

label标签来定义表单控制间的关系,当用户选择该标签时,浏览器会自动将焦点转到标签相关的表单控件上. 如: <form> <label for="male"&g ...

- kafka-0.10.2.1:Producer生产时无法自动创建Topic

集群环境: CenterOS 1台 Kafka:0.10.2.1版本. 今天在测试环境下,我们的Kafka集群工作不正常,具体现象为,使用confulentkafka向kafka集群生产消息失败,且并 ...

- python编程基础之三十

时间模块: 时间戳:就是当前是键距离1970年1月1日0:0:0的秒数,后面还带小数,可以说是非常精确 时间的表示形式: a.以整数或者浮点数表示一个以秒为单位的时间间隔,这个时间的基础值1970.1 ...

- oracle查询当前用户下所有的表,包括所有的字段

oracle查询当前用户下所有的表,包括所有的字段 背景: 前两天接到一个需求,做一个展示所有表名,表备注,表数据,表字段数,点击查看按钮查看字段名和注释,支持导出. 在Oracle中,可用使用视 ...

- 介绍ArcGIS中各种数据的打开方法——mxd(地图文档)

1.加载地图文档 在ArcGIS中,以mxd作为扩展名的文件叫地图文档. 地图文档中只是包含图层的引用,即存储当前地图的图层路径.符号.状态.修饰等信息,并不存储真实的数据层. ArcGIS Map中 ...

- Python_散点图绘制

为了可视化一些数据分布,需要以散点图的形式呈现 引入绘图工具 import matplotlib.pyplot as plt from matplotlib.font_manager import F ...

- Qt5教程: (6) 菜单栏、工具栏、状态栏及核心控件

1. 新建QMainWindow工程 取消生成.ui文件 2. 菜单栏 在mainwindow.cpp中添加头文件 和 #include <QMenuBar> #include <Q ...

- 代码审计-phpcms9.6.2任意文件下载漏洞

漏洞文件: phpcms\modules\content\down.php 1.在download函数中对文件的校验部分 首先 if(preg_match('/(php|phtml|php3|php4 ...

- phpstorm 新加入项目的文件--全局搜索不到 ctrl + shift + R

通过文件名查找文件 ,能搜到其他的现有文件,只是新加入的文件,无法出现在搜索到的结果中 . 总不可能在搜索的关键词一直拼写错误吧 , 那能想到的只有缓存出问题了. 新加入的文件,新加入的文件.... ...

- 05jmeter正则表达式

1.必须掌握的正则字符 "^" :^会匹配行或者字符串的起始位置,有时还会匹配整个文档的起始位置."$" :$会匹配行或字符串的结尾."\w" ...