Ubuntu 12.04下spark1.0.0 集群搭建(原创)

spark1.0.0新版本的于2014-05-30正式发布啦,新的spark版本带来了很多新的特性,提供了更好的API支持,spark1.0.0增加了Spark SQL组件,增强了标准库(ML、streaming、GraphX)以及对JAVA和Python语言的支持;

下面,我们首先进行spark1.0.0集群的安装,在这里我使用了两台服务器,一台作为master即namenode主机,另一台作为slave即datanode主机,增加更多的slave只需重复slave部分的内容即可。:

系统版本:

- master:Ubuntu 12.04

- slave:Ubuntu 12.04

- hadoop:hadoop 2.2.0

- spark:spark 1.0.0

1. 安装JDK和hadoop集群

安装过程参见这里

2. 下载安装Scala

- scala下载地址,这里下载的是最新版scala-2.11.1版本

- 解压scala,放到/usr/lib目录下

tar -xzvf scala-2.11.1.tgz

mv scala-2.11.1 /usr/lib/

- 配置scala环境变量:sudo vi /etc/profile

在文件末尾添加scala路径

输入 source /etc/profile 使路径生效

- 测试scala:scala -version #若出现scala版本信息说明安装成功

PS:scala需要在所有slave节点上配置

3. 下载安装spark

- spark1.0.0下载地址,解压spark,放到/home/hadoop下

tar -xzvf spark-1.0.0-bin-hadoop2.tgz

- 配置spark环境变量:sudo vi /etc/profile

在文件末尾添加spark路径

输入 source /etc/profile 使路径生效

- 配置conf/spark-env.sh文件

若没有该文件,则将 spark-env.sh.template 文件重命名即可,向文件中添加scala、java、hadoop路径以及master ip等信息。

mv spark-env.sh.template spark-env.sh

vi spark-env.sh

- 在conf/slaves中添加slave节点的hostname一行一个:

vi slaves

4. 在所有slave机器上安装配置spark

现在可以将master主机上的spark文件分发给所有的slave节点,注意slave与master的spark所在目录必须一致,因为master会登录到slave上执行命令,并认为slave的spark路径与自己一样scp -r spark-1.0.0-bin-hadoop2 hadoop@slave:/home/hadoop/

5.启动spark集群

在master主机上执行命令:

cd ~/spark-1.0.0-bin-hadoop2/sbin

./start-all.sh

检测进程是否启动:输入 jps

配置完成

6. 下面体验一下spark自带的例子

./bin/run-example SparkPi

scala实现一个spark app

官方说明地址,这个小例子用于统计输入文件中字母“a”和字母“b”的个数。网站上提供了scala、java、python三种实现,这里就只做一下scala的吧,这里需要安装SBT(我们使用 sbt 创建、测试、运行和提交作业,可以简单将SBT看做是Scala世界的Maven)。

spark-1.0.0木有自带的sbt,我们可以选择手动安装,当然也可以选择sudo apt-get install sbt的方式(我的系统中木有找到sbt包,所以就只有手动安装咯)。安装方法如下:

下载:sbt下载地址,我下载的是现在的最新版本sbt-0.13.5解压sbt到/home/hadoop/主目录下(hadoop是我的用户名,其实就是我的HOME啦)

tar -zxvf sbt-0.13.5.tgz

cd sbt/bin

java -jar sbt-launch.jar #进行sbt安装,时间大约一个小时吧,会下载很多东东,所以记得要联网哦

- 成功后可以在/etc/profile中配置sbt的环境变量

sudo vi /etc/profile

输入source /etc/profile 使路径生效

sbt安装完成,下面就来写这个简单的spark app吧

- 创建一个目录:mkdir ~/SimpleApp

- 在SimpleApp目录下,创建如下的目录结构:

- simple.sbt文件内容如下:

name := "Simple Project"

version := "1.0"

scalaVersion := "2.10.4"

libraryDependencies += "org.apache.spark" %% "spark-core" % "1.0.0"

resolvers += "Akka Repository" at "http://repo.akka.io/releases/"

- SimpleApp.scala文件内容如下:

/* SimpleApp.scala */

import org.apache.spark.SparkContext

import org.apache.spark.SparkContext._

import org.apache.spark.SparkConf object SimpleApp {

def main(args: Array[String]) {

val logFile = "YOUR_SPARK_HOME/README.md" // Should be some file on your system

val conf = new SparkConf().setAppName("Simple Application")

val sc = new SparkContext(conf)

val logData = sc.textFile(logFile, ).cache()

val numAs = logData.filter(line => line.contains("a")).count()

val numBs = logData.filter(line => line.contains("b")).count()

println("Lines with a: %s, Lines with b: %s".format(numAs, numBs))

}

}

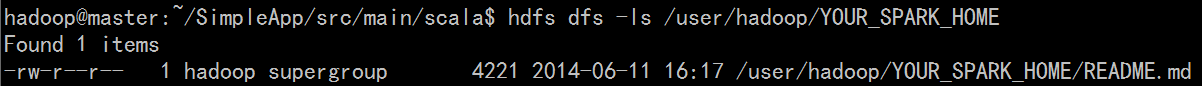

PS:由于我们之前在spark配置过程中将hadoop路径配置好了,因此这里的输入路径YOUR_SPARK_HOME/XXX实际上为HDFS文件系统中的文件,存储位置与hadoop配置文件core-site.xml中的<name>相关(具体可参见这里,这个地方很容易出错)。因此需要先将README.md文件put到hdfs上面:

- 编译:

cd ~/SimpleApp

sbt package #打包过程,时间可能会比较长,最后会出现[success]XXX

PS:成功后会生成许多文件 target/scala-2.10/simple-project_2.10-1.0.jar等

- 运行:

spark-submit --class "SimpleApp" --master local target/scala-2.10/simple-project_2.10-1.0.jar

- 结果:

7. 停止spark集群

cd ~/spark-1.0.0-bin-hadoop2/sbin

./stop-all.sh

本文为原创博客,若转载请注明出处。

Ubuntu 12.04下spark1.0.0 集群搭建(原创)的更多相关文章

- Ubuntu 14.04下Hadoop2.4.1集群安装配置教程

一.环境 系统: Ubuntu 14.04 64bit Hadoop版本: hadoop 2.4.1 (stable) JDK版本: OpenJDK 7 台作为Master,另3台作为Slave. 所 ...

- Ubuntu 12.04下安装thrift 0.9

Thrift这里就不介绍了,只说一句--Facebook很牛逼. 我这里安装Thrift主要是为Accumulo数据库作准备,所以java语言为必选项. 具体安装参考官方Apache Thrift R ...

- Ubuntu 12.04下Hadoop 2.2.0 集群搭建(原创)

现在大家可以跟我一起来实现Ubuntu 12.04下Hadoop 2.2.0 集群搭建,在这里我使用了两台服务器,一台作为master即namenode主机,另一台作为slave即datanode主机 ...

- Ubuntu 12.04下GAMIT10.40安装说明

转载于:http://www.itxuexiwang.com/a/liunxjishu/2016/0225/164.html?1456481297 Ubuntu 12.04下GAMIT10.40安装步 ...

- Angularjs学习---angularjs环境搭建,ubuntu 12.04下安装nodejs、npm和karma

1.下载angularjs 进入其官网下载:https://angularjs.org/,建议下载最新版的:https://ajax.googleapis.com/ajax/libs/angular ...

- [转]ubuntu(12.04)下, 命令 ,内核 源代码的获取

[转]ubuntu(12.04)下, 命令 ,内核 源代码的获取 http://blog.chinaunix.net/uid-18905703-id-3446099.html 1.命令:例如:要查看l ...

- Ubuntu 12.04 下安装 Eclipse

方法一:(缺点是安装时附加openjdk等大量程序并无法去除,优点是安装简单) $ sudo apt-get install eclipse 方法二:(优点是安装内容清爽,缺点是配置麻烦)1.安装JD ...

- 升级Ubuntu 12.04下的gcc到4.7

我们知道C++11标准开始支持类内初始化(in-class initializer),Qt creator编译出现error,不支持这个特性,原因在于,Ubuntu12.04默认的是使用gcc4.6, ...

- ubuntu 12.04下安装Qt出现cannot execute binary file的解决方案

最近在ubuntu 12.04下安装QT的过程中,遇到一个问题. ./qt-opensource-linux-x64-5.7.0.run出现了bash: ./qt-opensource-linux-x ...

随机推荐

- python笔记之BytesIO

1. 什么是BytesIO BytesIO与StringIO类似,不同的是StringIO只能存放string,BytesIO是用来存放bytes的,它提供了在内存中读写字节的能力. 即在内存中读写字 ...

- Git其他的命令------(四)

git除了在工作当中可以进行对代码进行管理的设置之外,git的其他指令也偶尔会被用到~ 1:删除某一个文件: rm -rf node,然后按下tab 2:查看修改文件的修改的详细信息: git ...

- react 修改state某一属性值

1.state // 筛选框相关数据 searchSelect: { term: { value: '学期', key: '', options: [] }, type_of_personnel: { ...

- javaScript语法和风格的检查工具

一.JSLint. JSHint. JSCS. ESLint 1.JSLint是由Douglas Crockford开发的,可能是最早的JavaScript Lint工具.JSLint定义了一组编码约 ...

- WordPress友情链接插件的安装

插件:link manager 这样就安装成功! 在外观小工具里 把右边即可 这样在前台页面上就可看见添加的友情链接了!!!

- ThinkPHP的运行流程-2

Thinkphp为了提高编译的效率,第一次运行的时候thinkphp会把文件全部编译到temp目录下的~runtime.php文件,在第二次运行的时候会直接读取这个文件.所以我们在线下自己写代码测试的 ...

- Python3 re模块正则表达式中的re.S

在Python的正则表达式中,有一个参数为re.S.它表示"."(不包含外侧双引号,下同)的作用扩展到整个字符串,包括"\n".看如下代码: import re ...

- 78.PL和PS通过BRAM交互共享数据

本篇文章目的是使用Block Memory进行PS和PL的数据交互或者数据共享,通过zynq PS端的Master GP0端口向BRAM写数据,然后再通过PS端的Mater GP1把数据读出来,将结果 ...

- 64_n2

nodejs-from-0.1.3-4.fc26.noarch.rpm 11-Feb-2017 15:01 9982 nodejs-from2-2.1.0-6.fc26.noarch.rpm 11-F ...

- python 多线程, 多进程, 协程

1. 介绍: threading用于提供线程相关的操作,线程是应用程序中工作的最小单元.python当前版本的多线程库没有实现优先级.线程组,线程也不能被停止.暂停.恢复.中断. 2. 1 线程执行 ...