Perl爬虫的简单实现

由于工作中有个项目需要爬取第三方网站的内容,所以在Linux下使用Perl写了个简单的爬虫。

相关工具

1. HttpWatch/浏览器开发人员工具

一般情况下这个工具是用不到的,但是如果你发现要爬取的内容在页面的HTML源码里找不到,如有的页面是通过AJAX异步请求数据的,这时候就需要HttpWatch之类的工具来找到实际的HTTP请求的URL了,当然现在很多浏览器都有开发人员工具(如Chrome, Firefox等),这样可以更方便查看所有请求的URL了。

2. curl/wget

这是爬虫中最重要的工具了,作用就是模拟浏览器的HTTP请求,从而获取数据。一般来说就是请求一个URL来获取相应的Web页面的HTML源码,还可以下载文件。使用curl和wget都可以很方便完成这个任务。

3. Perl

把页面爬下来后,就要从HTML中提取所需要的信息,这时候就要用到正则表达式了。我用的是Perl来编写爬虫脚本。之所以不使用Shell,是因为Shell的正则匹配功能还是太弱了。当然有很多脚本语言在正则匹配方面都很强大,如Python,如果你对这些脚本语言都不熟悉,相对而言,Perl会更容易上手一些。

4. 正则表达式

正则表达式的语法大部分都是通用的,但是不用的语言又会有些小的差别,下面列举Perl中正则表达式的一些重要的语法:

元字符 .

锚位 ^ $ \b

字符集 \d \w \s

量词 * ? + {m,n}

分组 () (abc)*

择一匹配 | (ab|bc)

捕获变量 ()

修饰符 /i /s /g

爬取步骤

下面以爬取某网站的手机App为例,说明一下爬取的步骤。

1. 爬取目录

假设我需要爬取的目录页是http://www.anzhi.com/sort_39_1_new.html,首先找到页索引和URL的规律,这个是很简单的,只需要把http://www.anzhi.com/sort_39_[i]_new.html中的[i]替换为页索引即可。接下来,需要知道一共有多少页,才能知道爬取目录页什么时候时候完成。一般页面上会显示共多少页,但这里要爬的页面是没有的,那怎么办呢?可以通过人工的方式去看一共有多少页,还有一个方法是,爬取到某一页发现没有匹配的目录项了,就说明所有目录页已经爬完了。

把目录页爬取下来后,把二级页面的ULR通过正则匹配提取出来,写到数据库中,URL可以标识一个页面的唯一性,所以要保证写入数据的URL不重复。需要注意的是在HTML中的URL可能是相对路径,需要把URL补全。

大部分情况是需要增量爬取的,如每天只爬取新增的目录项,为了防止重复无效的爬取,选择的目录页最好是按更新时间排序的,这样只需要爬取有更新的前几页就可以了。那怎么知道哪些目录页是有更新的呢?如果目录项有更新时间的话,可以通过比较这个时间来确定。还有一种更简单的方法是,如果某一页所有的URL在数据库都存在了,说明这一页没有新的目录项了,可以停止爬取了。

2. 爬取详细信息

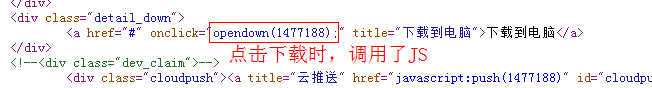

在第一步中已经把二级页面的URL爬取下来了,接下来就是要爬取详细信息了,如手机App的各种信息,截图和安装包的URL。对于文字信息是很容易在HTML中提取的,但对于安装包URL就不是一眼能找到的,这里的下载地址隐藏在JS中,如下图,在页面里提取到id后,就能拼出安装包URL。对于爬取完成的URL,在数据库中应该用状态字段标示其爬取完成,避免重复爬取。

3. 文件下载

有时候我们不仅要爬取文字信息,还需要下载图片或文件,比如这里我们还需要下载截图和安装包,在前一步中已经爬取了截图和安装包的URL,使用curl或wget可以很方便地进行文件下载。同样也需要状态字段来标示文件的下载状态。

通用和扩展

1. 通用爬取接口

为了减少一些爬取的重复代码,这里提取了一些公共代码,写了一个比较通用的爬取接口,需要注意的是,由于页面的编码和数据编码可能不一致,所以需要把页面的编码转化成数据库编码,否则写入数据就可能出现乱码。接口说明和代码如下:

调用方式:@results=&CrawlUrl($url, $page_charset, $expect_charset, \@regexs, \$crawl_result)

参数:URL,页面编码,期望编码,正则表达式数组,爬取是否成功(0成功,否则失败)

返回值:匹配结果二维数组(一个正则表达式可以匹配一组数据)

#!/usr/bin/perl sub ParseUrl

{

my $url=$_[];

$url=~s/\[/\\\[/g;

$url=~s/\]/\\\]/g;

return $url;

} sub CrawlUrl

{

my $url=$_[];

my $page_charset=$_[];

my $expect_charset=$_[];

my $regex_ref=$_[];

my $crawl_result_ref=$_[];

my @regexs=@$regex_ref;

my @results; my $file=`echo -n "$url" | md5sum | awk '{print \$1".htm"}'`;

chomp($file);

$url=&ParseUrl($url);

`curl -o "$file" "$url"`;

my $curl_result=`echo $?`;

chomp($curl_result);

if($curl_result!=)

{

$$crawl_result_ref=;

return @results;

} my $html="";

if($page_charset ne "" && $expect_charset ne "" && $page_charset ne $expect_charset)

{

$html=`iconv -f $page_charset -t $expect_charset "$file"`;

}

else

{

$html=`cat "$file"`;

}

`rm -f $file`; for(my $i=;$i<=$#regexs;$i++)

{

my $reg=@regexs[$i];

my @matches=($html=~/$reg/sg);

$results[$i]=\@matches;

} $$crawl_result_ref=;

return @results;

}

2. 爬虫通用性

我们可能需要爬去同一个类型的多个网站,比如我需要爬取数十个来源的手机App,如果每个网站都写一个特定的爬虫,会带来大量的编码工作,这时候就要考虑爬虫的通用性,如何让一套代码能够适应一类网站。这里采用的方法是把各个网站的差异化信息作为配置存储在数据库,如目录页URL、网站编码、各字段正则表达式等,这样爬虫通过读取这些配置就可以去适配不同的网站,达到一定的通用性。如果要新增一个网站的爬取,只需要增加相应的配置,而不需要修改任何代码。

3. 多进程爬取

如果要爬取的页面或要下载的文件数量比较大,会比较耗时,这时候可以考虑多个进程同时进行爬取。写一个进程控制模块,通过查询数据库中未爬取的URL和检测当前启用爬取的进程数,来确定是否启用新的进程,达到对多进程爬取的控制。

4. 代理

有些网站可能会限制IP的访问频率,如果对网站的爬取频率比较高,可能就会导致IP被封了,可以通过在多个代理服务器随机切换的方式来规避这个问题。为了避免代码重复,写了一个使用代理的wget封装的Shell工具。

#!/bin/bash PROXY_HOST=(代理服务器列表) function GetProxyStr()

{

rand=$(($RANDOM%(${#PROXY_HOST[*]}+1)))

if [ $rand -lt ${#PROXY_HOST[*]} ]

then

PROXY_STR="-e http_proxy=${PROXY_HOST[$rand]}"

fi

} PROXY_STR=""

PATH_TYPE="$1"

FILE_PATH="$2"

URL="$3" GetProxyStr

GetPath wget --user-agent="Mozilla/5.0 (X11; U; Linux i686; en-US; rv:1.9.0.3) Gecko/2008092416 Firefox/3.0.3" $PROXY_STR $PATH_TYPE "$FILE_PATH" "$URL"

5. 监控

还有一个问题就是,如果爬虫是每天定时运行的,在网站目录页URL发生变化或页面改版了,爬取就会失败。这就要求对这些失败进行监控,在爬取页面失败或者正则匹配失败时,通过短信、邮件等方式进行告警。

Perl爬虫的简单实现的更多相关文章

- Perl读写Excel简单操作

Perl读写Excel简单操作 使用模块 Spreadsheet::ParseExcel Spreadsheet::WriteExcel 读Excel #!/usr/bin/perl -w use s ...

- php面试题7(1、unset变量是删除栈变量,并不删除堆变量)(2、php爬虫特别简单: 可以file_get_contents和直接fopen)

php面试题7(1.unset变量是删除栈变量,并不删除堆变量)(2.php爬虫特别简单: 可以file_get_contents和直接fopen) 一.总结 1.unset变量是删除栈变量,并不删除 ...

- 初学Python之爬虫的简单入门

初学Python之爬虫的简单入门 一.什么是爬虫? 1.简单介绍爬虫 爬虫的全称为网络爬虫,简称爬虫,别名有网络机器人,网络蜘蛛等等. 网络爬虫是一种自动获取网页内容的程序,为搜索引擎提供了重要的 ...

- Python爬虫的简单入门(一)

Python爬虫的简单入门(一) 简介 这一系列教学是基于Python的爬虫教学在此之前请确保你的电脑已经成功安装了Python(本教程使用的是Python3).爬虫想要学的精通是有点难度的,尤其是遇 ...

- python爬虫:爬虫的简单介绍及requests模块的简单使用

python爬虫:爬虫的简单介绍及requests模块的简单使用 一点点的建议: (学习爬虫前建议先去了解一下前端的知识,不要求很熟悉,差不多入门即可学习爬虫,如果有不了解的,我也会补充个一些小知识. ...

- 使用Scrapy爬虫框架简单爬取图片并保存本地(妹子图)

初学Scrapy,实现爬取网络图片并保存本地功能 一.先看最终效果 保存在F:\pics文件夹下 二.安装scrapy 1.python的安装就不说了,我用的python2.7,执行命令pip ins ...

- 利用树莓派跑python爬虫的简单教程——从无到有

因为学校项目的原因入手了树莓派,到手先折腾了两天,发现网上的教程大都是拿他搭建服务器,mail,或者媒体服务器之类,对于在学校限时的宽带来说有点不太现实,不过低功耗适合一直开着的确启发了我.所以想到拿 ...

- 用Perl做个简单”下载者病毒”

一直学的perl, 有时perl不理解时就用python写一下,这样或许perl就理解了 这里参照python写法,做了个perl的版本,当然,是为了学习用,这个下载者病毒有点简单过头了 backdo ...

- Java爬虫——Gecco简单入门程序(根据下一页一直爬数据)

为了完成作业,所以学习了一下爬虫Gecco,这个爬虫集合了以往所有的爬虫的特点,但是官方教程中关于Gecco的教程介绍的过于简单,本篇博客是根据原博客的地址修改的,原博客中只有程序的截图,而没有给出一 ...

随机推荐

- 准备在electron上用vue,结果卡在了sqlite3

vue.js看书有一段时间了,也准备动手做一个electron的程序.目录似乎有两种方式搭建方式 一种是使用vue.cli构建工具,就是所谓的脚手架,分别安装vue和electron https:// ...

- python3调用zabbix api

前言 今天写了一个zabbix api,这里整理一下,过程中自己也学习了一些东西. 需求 我们需要查一个文件内容如下: cat /ops/flume_hosts node1 node2 需要把这个文件 ...

- visual2017专业版MFC编程环境搭建及第一个MFC程序的创建

1.MFC介绍及环境搭建 MFC全程为Microsoft Foundation class Library,即微软的基本类库,MFC实际上是一个庞大的文件库,它由指向文件和源文件组成. 首先,打开vi ...

- .net core mvc发布项目到IIS上出现500错误

如题,我把.net core mvc项目以应用程序方式挂到IIS默认网站下,结果出现了如下错误:HTTP Error 500.0 - ANCM In-Process Handler Load Fail ...

- 代码的重构(Refactor-Extract)

1.vs中的代码重构快捷方式:Refactor-Extract: 选中两个需要重构的部分完整代码,右击,选中Refactoe-Extract-Extract Method: 该选中的代码会自动形成一个 ...

- 基于DobboX的SOA服务集群搭建

本人第一次发博客,有什么不对的地方希望各位批评指正,我就不把文章copy过来了,直接上有道笔记的链接,希望各位喜欢. 第一部分: 准备工作 第二部分: dubbox的安装和使用 第三部分: RESTf ...

- 在Shell脚本中获取指定进程的PID

注意这条命令用反引号(Tab上面的那个键)括起来,作用类似于${ } processId = ` ps -ef | grep fms.jar | grep -v grep | awk '{print ...

- python中两种栈实现方式的性能对比

在计算机的世界中,同一个问题,使用不同的数据结构和算法实现,所使用的资源有很大差别 为了方便量化python中算法的资源消耗,对性能做测试非常有必要,这里针对stack做了python语言 下的性能分 ...

- Testing - 软件测试知识梳理 - 软件性能测试

软件性能测试的基本概念 软件的性能是软件的一种非功能特性,它关注的不是软件是否能够完成特定的功能,而是软件在完成该功能时展示出来的及时性. 软件性能的指标 响应时间:是指系统对请求作出响应的时间,并且 ...

- 修改idea打开新窗口的默认配置

使用idea开发maven项目时,发现使用新窗口创建一个项目时,例如file-settings的maven库配置都是用的用户下的maven库,如何配置一个全局的maven配置呢,操作如下: File- ...