CDH-5.9.2整合spark2

1.编写目的:由于cdh-5.9.2自带spark版本是spark1.6,现需要测试spark2新特性,需要整合spark2,

且spark1.x和spark2.x可以同时存在于cdh中,无需先删除spark1.x;

2.安装包下载

2.1首先下载csd包,地址: http://archive.cloudera.com/spark2/csd/

2.2 parcel包下载地址:http://archive.cloudera.com/spark2/parcels/2.1.0.cloudera1/

需要注意的是要下载对应的版本和对应的操作系统包;

3.安装开始

将安装包放到对应目录,修改安装包所属用户,以及组,如下图:

将该节点执行 :

service cloudera-scm-server restart

service cloudera-scm-agent restart

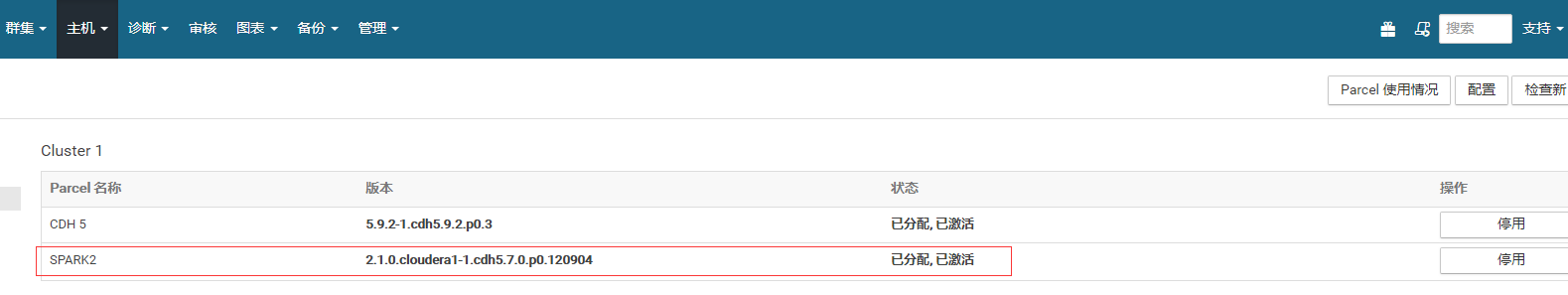

然后点击主机->Parcel页面,看是否多了个spark2的选项。如下图,你这里此时应该是分配按钮,点击,等待操作完成后,点击激活按钮

然后在dashboard页面,向集群添加服务,就可以看到spark2:

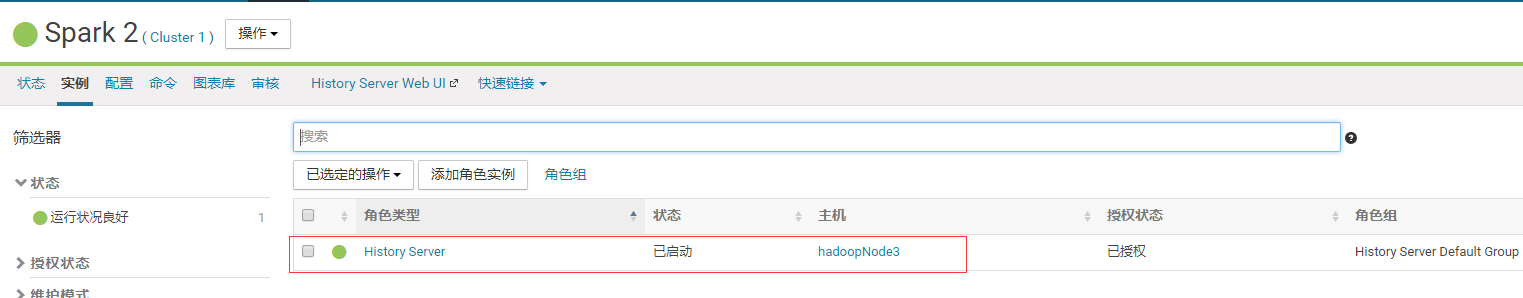

我这里把spark2的history server装在了第三个节点:

至此,安装完成;

4.测试验证:

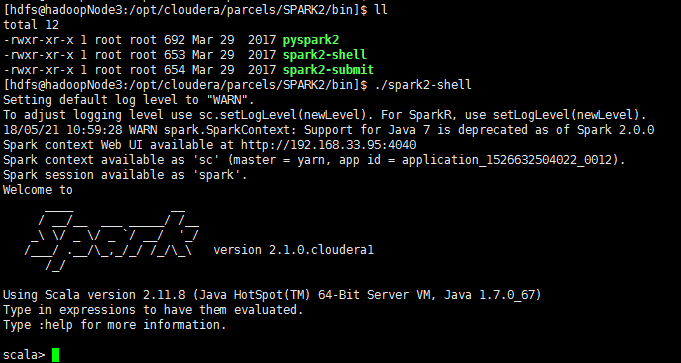

spark2-shell启动成功;

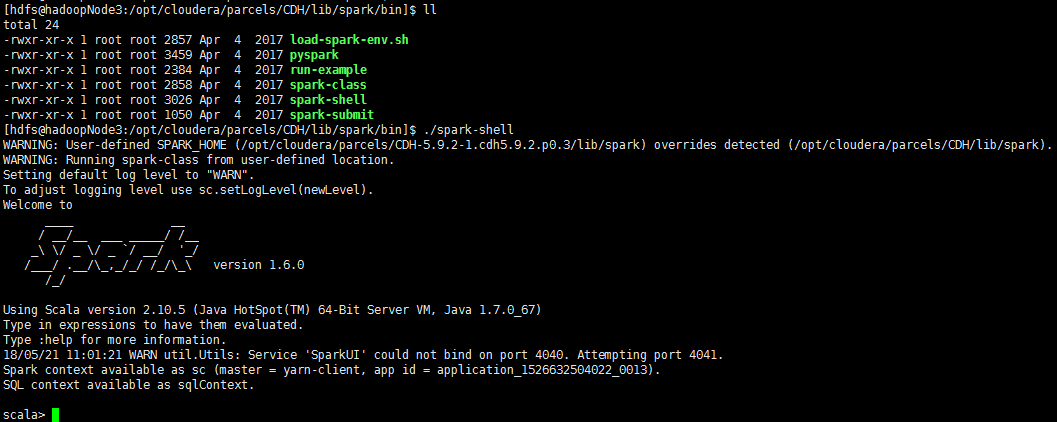

spark-shell,即spark1也启动成功;

=====》使用spark-submit模式几条job:

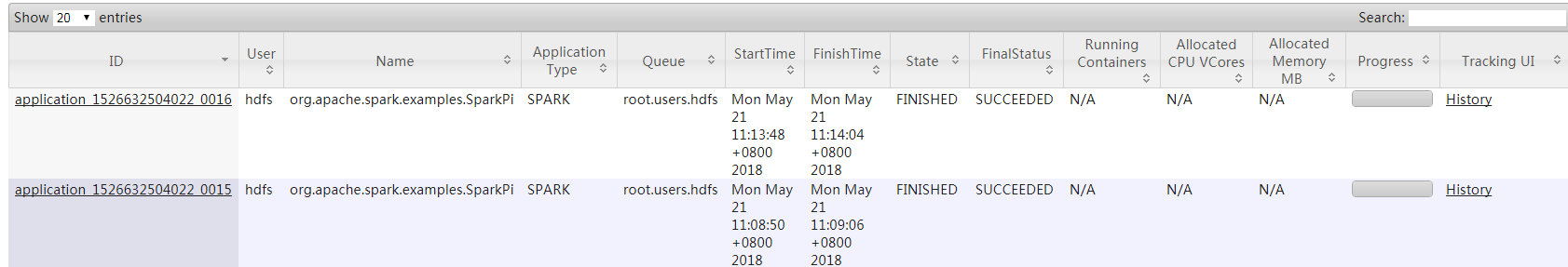

[hdfs@hadoopNode3:/opt/cloudera/parcels/SPARK2/bin]$ ./spark2-submit --master yarn --deploy-mode cluster --conf spark.driver.memory=2g --class org.apache.spark.examples.SparkPi --executor-cores 4 /opt/cloudera/parcels/CDH/lib/spark/examples/lib/spark-examples-1.6.0-cdh5.9.2-hadoop2.6.0-cdh5.9.2.jar

[hdfs@hadoopNode3:/opt/cloudera/parcels/CDH/lib/spark/bin]$ ./spark-submit --master yarn --deploy-mode cluster --conf spark.driver.memory=2g --class org.apache.spark.examples.SparkPi --executor-cores 4 /opt/cloudera/parcels/CDH/lib/spark/examples/lib/spark-examples-1.6.0-cdh5.9.2-hadoop2.6.0-cdh5.9.2.jar

可以看到用集群模式也都能运行job成功

五.问题总结:

1.在安装过程中,可能会碰到在向集群添加spark2这个服务时候,没有spark2这个选项,这个是csd文件没有放对路劲;

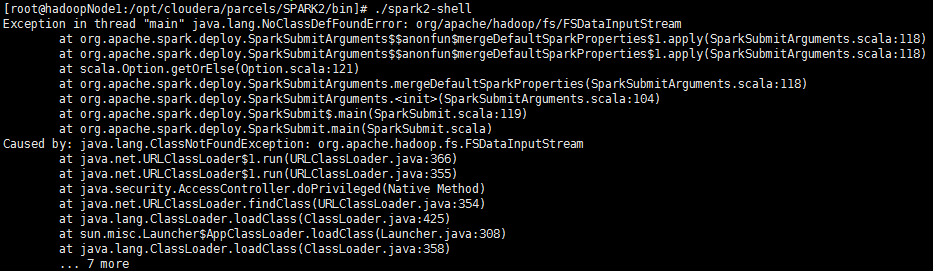

2.在集群其他节点运行spark2的时候,会报错

spark2安装在哪个节点,就要到对应节点运行,否则会有这个报错;

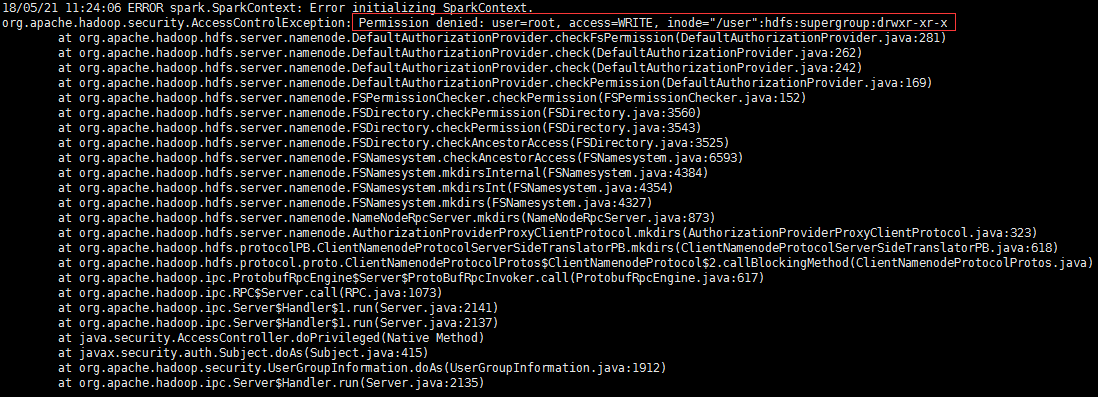

3.运行spark2对应命令,要切换到hdfs用户,否则会报错:

CDH-5.9.2整合spark2的更多相关文章

- CDH下集成spark2.2.0与kafka(四十一):在spark+kafka流处理程序中抛出错误java.lang.NoSuchMethodError: org.apache.kafka.clients.consumer.KafkaConsumer.subscribe(Ljava/util/Collection;)V

错误信息 19/01/15 19:36:40 WARN consumer.ConsumerConfig: The configuration max.poll.records = 1 was supp ...

- 开源版本 hadoop-2.7.5 + apache-hive-2.1.1 + spark-2.3.0-bin-hadoop2.7整合使用

一,开源软件版本: hadoop版本 : hadoop-2.7.5 hive版本 :apache-hive-2.1.1 spark版本: spark-2.3.0-bin-hadoop2.7 各个版本到 ...

- CentOS7安装CDH 第十章:CDH中安装Spark2

相关文章链接 CentOS7安装CDH 第一章:CentOS7系统安装 CentOS7安装CDH 第二章:CentOS7各个软件安装和启动 CentOS7安装CDH 第三章:CDH中的问题和解决方法 ...

- Ambari HDP 下 SPARK2 与 Phoenix 整合

1.环境说明 操作系统 CentOS Linux release 7.4.1708 (Core) Ambari 2.6.x HDP 2.6.3.0 Spark 2.x Phoenix 4.10.0-H ...

- spark-2.0.0与hive-1.2.1整合

SparkSQL与Hive的整合 1. 拷贝$HIVE_HOME/conf/hive-site.xml和hive-log4j.properties到 $SPARK_HOME/conf/ 2. 在$SP ...

- 将CDH中的hive和hbase相互整合使用

一..hbase与hive的兼容版本: hive0.90与hbase0.92是兼容的,早期的hive版本与hbase0.89/0.90兼容,不需要自己编译. hive1.x与hbase0.98.x或则 ...

- CDH spark2切换成anaconda3的问题

最近spark2有同事想用anaconda3做开发,原因是上面可以跑机器学习的库(服务器因为没外网pip装whl确实麻烦) 1.先在每台机器安装anaconda3 2.把用户的~/.bashrc配置进 ...

- SparkStreaming整合flume

SparkStreaming整合flume 在实际开发中push会丢数据,因为push是由flume将数据发给程序,程序出错,丢失数据.所以不会使用不做讲解,这里讲解poll,拉去flume的数据,保 ...

- geotrellis使用(二十五)将Geotrellis移植到spark2.0

目录 前言 升级spark到2.0 将geotrellis最新版部署到spark2.0(CDH) 总结 一.前言 事情总是变化这么快,前面刚写了一篇博客介绍如何将geotrellis移植 ...

随机推荐

- 失去光标display=none事件的坑

1.实现效果: 失去光标进行判断,如果内容为空出现提示. 2.页面代码: <tr class="tableform_tr"> <td width="15 ...

- react中 props,state与render函数的关系

我们很明显的能够感受到,react是一门数据驱动的框架,当数据发生变化,页面就会自动发生变化,他背后的原理是怎么样子的呢 比如todolist例子里面,inputValue变了,框里面的内容就会自动变 ...

- bzoj 2434 [Noi2011]阿狸的打字机——AC自动机

题目:https://www.lydsy.com/JudgeOnline/problem.php?id=2434 dfs AC自动机,走过的点权值+1,回溯的时候权值-1:走到询问的 y 串的节点,看 ...

- (第四场)G Maximum Mode 【YY+暴力】

链接:https://www.nowcoder.com/acm/contest/142/G 来源:牛客网 题目描述 The mode of an integer sequence is the val ...

- 应用性能指数(APDEX)是如何计算出来的?

应用性能指数(APDEX)是如何计算出来的?在应用性能管理领域聚合指标是一种常见手段,主要是用来把成百上千的指标通过某种计算方法聚合成一个或几个指标,用来反映应用的整体健康状态.在这些聚合指标中,比较 ...

- HDU 1210 Eddy's 洗牌问题(找规律,数学)

传送门: http://acm.hdu.edu.cn/showproblem.php?pid=1210 Eddy's 洗牌问题 Time Limit: 2000/1000 MS (Java/Other ...

- 浅谈二分查找 JavaScript

算法介绍 二分查找,也称折半查找,是一种在有序数组中查找特定元素的搜索算法.查找过程经历一下步骤: (1)从有序数组的中间的元素开始搜索,如果该元素正好是目标元素,则停止搜索并返回该元素的索引值,否则 ...

- 18.Shiro与Springboot整合下登陆验证UserService未注入的问题

Shiro与Springboot整合下登陆验证UserService未注入的问题 前言: 刚开始整合的情况下,UserService一执行,就会报空指针异常. 看了网上各位大神的讲解,什么不能用ser ...

- Qt基于model/view数据库编程3

QSqlQueryModel和QSqlQuery类: 工程开发过程中将这两个类合起来使用,用QSqlQueryModel查询展示数据库中的数据,用QSqlQuery类执行sql语言,实现对数据库的操作 ...

- [NOI2002]荒岛野人(exgcd,枚举)

题目描述 克里特岛以野人群居而著称.岛上有排列成环行的M个山洞.这些山洞顺时针编号为1,2,…,M.岛上住着N个野人,一开始依次住在山洞C1,C2,…,CN中,以后每年,第i个野人会沿顺时针向前走Pi ...