ElasticSearch教程——自定义分词器(转学习使用)

一、分词器

Elasticsearch中,内置了很多分词器(analyzers),例如standard(标准分词器)、english(英文分词)和chinese(中文分词),默认是standard.

standard tokenizer:以单词边界进行切分

standard token filter:什么都不做

lowercase token filter:将所有字母转换为小写

stop token filer(默认被禁用):移除停用词,比如a the it等等

二、修改分词器设置

启用english,停用词token filter

PUT /my_index

{

"settings": {

"analysis": {

"analyzer": {

"es_std":{

"type":"standard",

"stopwords":"_english_"

}

}

}

}

}

三、标准分词测试代码

GET /my_index/_analyze

{

"analyzer": "standard",

"text":"a dog is in the house"

}

结果:

{

"tokens": [

{

"token": "a",

"start_offset": 0,

"end_offset": 1,

"type": "<ALPHANUM>",

"position": 0

},

{

"token": "dog",

"start_offset": 2,

"end_offset": 5,

"type": "<ALPHANUM>",

"position": 1

},

{

"token": "is",

"start_offset": 6,

"end_offset": 8,

"type": "<ALPHANUM>",

"position": 2

},

{

"token": "in",

"start_offset": 9,

"end_offset": 11,

"type": "<ALPHANUM>",

"position": 3

},

{

"token": "the",

"start_offset": 12,

"end_offset": 15,

"type": "<ALPHANUM>",

"position": 4

},

{

"token": "house",

"start_offset": 16,

"end_offset": 21,

"type": "<ALPHANUM>",

"position": 5

}

]

}

四、设置的英文分词测试代码

GET /my_index/_analyze

{ "analyzer": "es_std", "text":"a dog is in the house" }

结果:

{

"tokens": [

{

"token": "dog",

"start_offset": 2,

"end_offset": 5,

"type": "<ALPHANUM>",

"position": 1

},

{

"token": "house",

"start_offset": 16,

"end_offset": 21,

"type": "<ALPHANUM>",

"position": 5

}

]

}

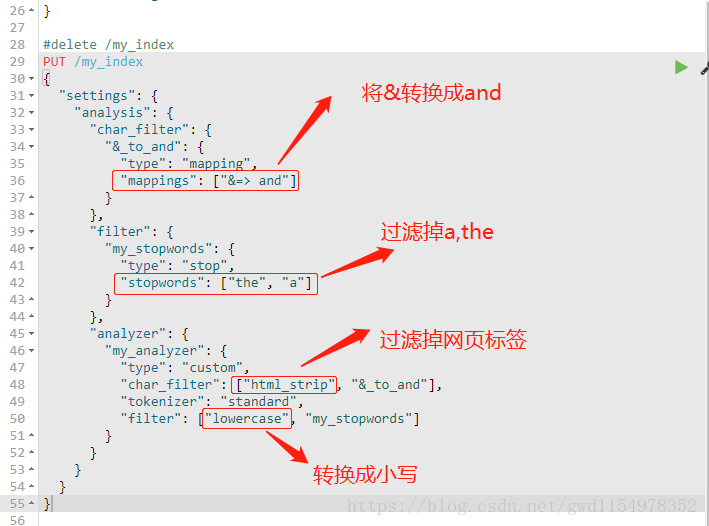

五、自定义分词器

PUT /my_index

{

"settings": {

"analysis": {

"char_filter": {

"&_to_and": {

"type": "mapping",

"mappings": ["&=> and"]

}

},

"filter": {

"my_stopwords": {

"type": "stop",

"stopwords": ["the", "a"]

}

},

"analyzer": {

"my_analyzer": {

"type": "custom",

"char_filter": ["html_strip", "&_to_and"],

"tokenizer": "standard",

"filter": ["lowercase", "my_stopwords"]

}

}

}

}

}

测试:

GET /my_index/_analyze

{

"text": "tom&jerry are a friend in the house, <a>, HAHA!!",

"analyzer": "my_analyzer"

}

结果:

{

"tokens": [

{

"token": "tomandjerry",

"start_offset": 0,

"end_offset": 9,

"type": "<ALPHANUM>",

"position": 0

},

{

"token": "are",

"start_offset": 10,

"end_offset": 13,

"type": "<ALPHANUM>",

"position": 1

},

{

"token": "friend",

"start_offset": 16,

"end_offset": 22,

"type": "<ALPHANUM>",

"position": 3

},

{

"token": "in",

"start_offset": 23,

"end_offset": 25,

"type": "<ALPHANUM>",

"position": 4

},

{

"token": "house",

"start_offset": 30,

"end_offset": 35,

"type": "<ALPHANUM>",

"position": 6

},

{

"token": "haha",

"start_offset": 42,

"end_offset": 46,

"type": "<ALPHANUM>",

"position": 7

}

]

}

六、type中的使用

PUT /my_index/_mapping/my_type

{

"properties": {

"content": {

"type": "text",

"analyzer": "my_analyzer"

}

}

}

ElasticSearch教程——自定义分词器(转学习使用)的更多相关文章

- elasticsearch教程--中文分词器作用和使用

概述 本文都是基于elasticsearch安装教程 中的elasticsearch安装目录(/opt/environment/elasticsearch-6.4.0)为范例 环境准备 ·全新最小 ...

- Elasticsearch集成HanLP分词器-个人学习

1.通过git下载分词器代码. 连接如下:https://gitee.com/hualongdata/hanlp-ext hanlp官网如下:http://hanlp.linrunsoft.com/ ...

- Elasticsearch之中文分词器插件es-ik的自定义热更新词库

不多说,直接上干货! 欢迎大家,关注微信扫码并加入我的4个微信公众号: 大数据躺过的坑 Java从入门到架构师 人工智能躺过的坑 Java全栈大联盟 ...

- Elasticsearch笔记六之中文分词器及自定义分词器

中文分词器 在lunix下执行下列命令,可以看到本来应该按照中文"北京大学"来查询结果es将其分拆为"北","京","大" ...

- 【自定义IK词典】Elasticsearch之中文分词器插件es-ik的自定义词库

Elasticsearch之中文分词器插件es-ik 针对一些特殊的词语在分词的时候也需要能够识别 有人会问,那么,例如: 如果我想根据自己的本家姓氏来查询,如zhouls,姓氏“周”. 如 ...

- 【分词器及自定义】Elasticsearch中文分词器及自定义分词器

中文分词器 在lunix下执行下列命令,可以看到本来应该按照中文”北京大学”来查询结果es将其分拆为”北”,”京”,”大”,”学”四个汉字,这显然不符合我的预期.这是因为Es默认的是英文分词器我需要为 ...

- Elasticsearch修改分词器以及自定义分词器

Elasticsearch修改分词器以及自定义分词器 参考博客:https://blog.csdn.net/shuimofengyang/article/details/88973597

- ElasticSearch最全分词器比较及使用方法

介绍:ElasticSearch 是一个基于 Lucene 的搜索服务器.它提供了一个分布式多用户能力的全文搜索引擎,基于 RESTful web 接口.Elasticsearch 是用 Java 开 ...

- elasticsearch安装ansj分词器

1.概述 elasticsearch用于搜索引擎,需要设置一些分词器来优化索引.常用的有ik_max_word: 会将文本做最细粒度的拆分.ik_smart: 会做最粗粒度的拆分.ansj等. ...

随机推荐

- Android基础02

初识安卓的另一个重要的组件---广播. 1.广播的分类 标准广播:是一种完全异步执行的广播,在广播发出之后,所有的广播 接收器几乎都会在同一时刻接收到这条广播消息,因此它们之间没有任何先后顺序可言.这 ...

- Google浏览器PostMan插件版安装步骤

PostMan插件版安装步骤: 第一步:把下载后的.crx扩展名的离线Chrome插件的文件扩展名改成.zip或者.rar 第二步:右键点击该文件,并使用压缩软件(如winrar.360压缩等)对该压 ...

- HBase的基本使用(安装配置、启动关闭、hbash shell的基本操作、phoenix、实战)

HBase的前提条件: JDK SSH Hadoop JDK:Hadoop和JDK运行的环境,他们的守护进程运行在JVM下.HBase支持JDK 1.6以上的版本.比如: jdk-8u161-linu ...

- bugkuctf 这 是 一 个 神 奇 的 登 录 界 面

首先结合源码可以看出这是一道sql注入题. 然后开始萌新的日常操作,尝试单引号闭合,可是并没有用,而且因为单引号注入的题太多,导致并没有立刻开始尝试双引号,之后想起双引号(对,双引号木得牌面)得到如下 ...

- maven私有仓库搭建(nexus)

搭建是参考博客:https://blog.csdn.net/zn353010922/article/details/79441122 切换到nexus目录的bin下 启动.状态.停止:./nexus ...

- Jenkins的war包安装

安装Jenkins首先要安装jdk,在官网下载jdk安装并配置环境变量 1.Jenkins下载地址,下载war包 https://www.jenkins.io/download/ 2.打开命令行窗口, ...

- mysql主从双机keepalived配置

1.关闭selinux SELINUX=disabled 2.yum安装keepalived yum install -y keepalived 3.修改配置文件 主库配置文件: ! Configur ...

- 面试 HTTP和HTML 浏览器

HTTP和HTML 浏览器 #说一下http和https #参考回答: https的SSL加密是在传输层实现的. (1)http和https的基本概念 http: 超文本传输协议,是互联网上应用最为广 ...

- 面试 11-00.JavaScript高级面试

11-00.JavaScript高级面试 #前言 一.基础知识: ES 6常用语法:class .module.Promise等 原型高级应用:结合 jQuery 和 zepto 源码 异步全面讲解: ...

- Python高级语法-私有属性-with上下文管理器(4.7.3)

@ 目录 1.说明 2.代码 关于作者 1.说明 上下文管理器 这里使用with open操作文件,让文件对象实现了自动释放资源.我们也能自定义上下文管理器,通过__enter__()和__exit_ ...