ELK7.3实战安装配置文档

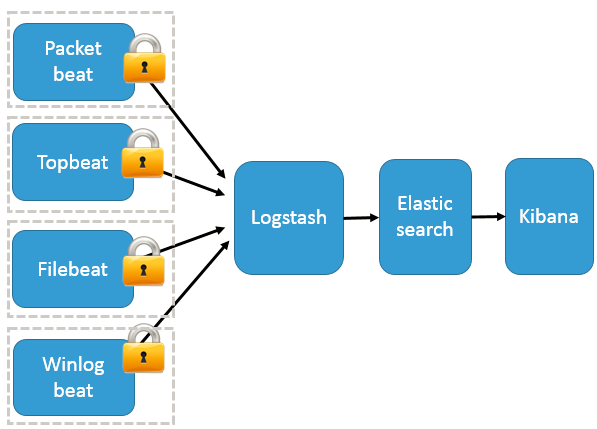

整体架构

一:环境准备

192.168.43.16 jdk,elasticsearch-master ,logstash,kibana

192.168.43.17 jdk,elasticsearch-node1

192.168.43.18 jdk,elasticsearch-node2

192.168.43.19 liunx ,filebeat

#解压

tar -zxvf jdk-12.0.2_linux-x64_bin.tar.gz -C /usr/ #设置环境变量

vim /etc/profile

export JAVA_HOME=/usr/jdk-12.0.2/

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=.:$JAVA_HOME/lib:$JRE_HOME/lib:$CLASSPATH

export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH #使环境变量生效

source /etc/profile

# 修改系统文件

vim /etc/security/limits.conf #增加的内容

* soft nofile 65536

* hard nofile 65536

* soft nproc 2048

* hard nproc 4096 #修改系统文件

vim /etc/security/limits.d/20-nproc.conf #调整成以下配置

* soft nproc 4096

root soft nproc unlimited vim /etc/sysctl.conf

#在最后追加

vm.max_map_count=262144

fs.file-max=655360 #使用 sysctl -p 查看修改结果

sysctl -p

vim /etc/hosts

192.168.43.16 elk-master-node

192.168.43.17 elk-data-node1

192.168.43.18 elk-data-node2

sed -i "s/SELINUX=enforcing/SELINUX=disabled/g" /etc/selinux/config

setenforce 0

systemctl stop firewalld

systemctl disable firewalld

groupadd elk

useradd ‐g elk elk

mkdir -p /home/app/elk

chown -R elk:elk /home/app/elk

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-7.3.2-linux-x86_64.tar.gz

wget https://artifacts.elastic.co/downloads/logstash/logstash-7.3.2.tar.gz

wget https://artifacts.elastic.co/downloads/kibana/kibana-7.3.2-linux-x86_64.tar.gz

tar -zxvf elasticsearch-7.3.2-linux-x86_64.tar.gz -C /home/app/elk && \

tar -zxvf logstash-7.3.2.tar.gz -C /home/app/elk && \

tar -zxvf kibana-7.3.2-linux-x86_64.tar.gz -C /home/app/elk

二、安装elasticsearch

1、配置elasticsearch(切换至elk用户)

创建Elasticsearch数据目录 mkdir /home/app/elk/elasticsearch-7.3.2/data -p

创建Elasticsearch日志目录 mkdir /home/app/elk/elasticsearch-7.3.2/logs -p

主节点配置:vim /home/app/elk/elasticsearch-7.3.2/config/elasticsearch.yml

# 集群名称

cluster.name: es

# 节点名称

node.name: es-master

# 存放数据目录,先创建该目录

path.data: /home/app/elk/elasticsearch-7.3.2/data

# 存放日志目录,先创建该目录

path.logs: /home/app/elk/elasticsearch-7.3.2/logs

# 节点IP

network.host: 192.168.43.16

# tcp端口

transport.tcp.port: 9300

# http端口

http.port: 9200

# 种子节点列表,主节点的IP地址必须在seed_hosts中

discovery.seed_hosts: ["192.168.43.16:9300","192.168.43.17:9300","192.168.43.18:9300"]

# 主合格节点列表,若有多个主节点,则主节点进行对应的配置

cluster.initial_master_nodes: ["192.168.43.16:9300"]

# 主节点相关配置 # 是否允许作为主节点

node.master: true

# 是否保存数据

node.data: true

node.ingest: false

node.ml: false

cluster.remote.connect: false # 跨域

http.cors.enabled: true

http.cors.allow-origin: "*"

192.168.43.17数据节点从配置:vim /home/app/elk/elasticsearch-7.3.2/config/elasticsearch.yml

# 集群名称

cluster.name: es

# 节点名称

node.name: es-data1

# 存放数据目录,先创建该目录

path.data: /home/app/elk/elasticsearch-7.3.2/data

# 存放日志目录,先创建该目录

path.logs: /home/app/elk/elasticsearch-7.3.2/logs

# 节点IP

network.host: 192.168.43.17

# tcp端口

transport.tcp.port: 9300

# http端口

http.port: 9200

# 种子节点列表,主节点的IP地址必须在seed_hosts中

discovery.seed_hosts: ["192.168.43.16:9300","192.168.43.17:9300","192.168.43.18:9300"]

# 主合格节点列表,若有多个主节点,则主节点进行对应的配置

cluster.initial_master_nodes: ["192.168.43.16:9300"]

# 主节点相关配置 # 是否允许作为主节点

node.master: false

# 是否保存数据

node.data: true

node.ingest: false

node.ml: false

cluster.remote.connect: false # 跨域

http.cors.enabled: true

http.cors.allow-origin: "*"

# 集群名称

cluster.name: es

# 节点名称

node.name: es-data2

# 存放数据目录,先创建该目录

path.data: /home/app/elk/elasticsearch-7.3.2/data

# 存放日志目录,先创建该目录

path.logs: /home/app/elk/elasticsearch-7.3.2/logs

# 节点IP

network.host: 192.168.43.18

# tcp端口

transport.tcp.port: 9300

# http端口

http.port: 9200

# 种子节点列表,主节点的IP地址必须在seed_hosts中

discovery.seed_hosts: ["192.168.43.16:9300","192.168.43.17:9300","192.168.43.18:9300"]

# 主合格节点列表,若有多个主节点,则主节点进行对应的配置

cluster.initial_master_nodes: ["192.168.43.16:9300"]

# 主节点相关配置 # 是否允许作为主节点

node.master: false

# 是否保存数据

node.data: true

node.ingest: false

node.ml: false

cluster.remote.connect: false # 跨域

http.cors.enabled: true

http.cors.allow-origin: "*"

2、启动elasticserach

sh /home/app/elk/elasticsearch-7.3.2/bin/elasticsearch -d

3、监控检查

curl -X GET 'http://192.168.43.16:9200/_cluster/health?pretty'

[root@localhost elk]# curl -X GET 'http://192.168.43.16:9200/_cluster/health?pretty'

{

"cluster_name" : "es",

"status" : "green",

"timed_out" : false,

"number_of_nodes" : 3,

"number_of_data_nodes" : 3,

"active_primary_shards" : 5,

"active_shards" : 10,

"relocating_shards" : 0,

"initializing_shards" : 0,

"unassigned_shards" : 0,

"delayed_unassigned_shards" : 0,

"number_of_pending_tasks" : 0,

"number_of_in_flight_fetch" : 0,

"task_max_waiting_in_queue_millis" : 0,

"active_shards_percent_as_number" : 100.0

}

#status=green表示服务正常

三、安装kibana

1、修改配置文件

cd /home/app/elk/kibana-7.3.2-linux-x86_64/config

vim kibana.yml

# 配置kibana的端口

server.port: 5601

# 配置监听ip

server.host: "192.168.43.16"

# 配置es服务器的ip,如果是集群则配置该集群中主节点的ip

elasticsearch.hosts: "http://192.168.43.16:9200/"

# 配置kibana的日志文件路径,不然默认是messages里记录日志

logging.dest:/home/app/elk/kibana-7.3.2-linux-x86_64/logs/kibana.log

2、启动kibana

nohup /home/app/elk/kibana-7.3.2-linux-x86_64/bin/kibana &

三、安装filebeat(192.168.43.19上事先跑了jumpserver服务)

本次实验我们在192.168.43.19上安装filebeat单独对nginx的访问日志和错误日志进行采集,网上有关于发送json格式的配置,在此为了练习grok,直接发送原格式进行配置

1、下载filebeat

wget https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-7.3.2-linux-x86_64.tar.gz

mkdir -p /opt/software

tar -zxvf filebeat-7.3.2-linux-x86_64.tar.gz -C /opt/software

2、配置filebeat.yml

vim /opt/software/filebeat-7.3.2/filebeat.yml

#=========================== Filebeat inputs =============================

filebeat.inputs:

- type: log

paths:

- /var/log/nginx/access.log

fields:

log_source: nginx-access

- type: log

paths:

- /var/log/nginx/error.log

fields:

log_source: nginx-error

#============================== Dashboards =====================================

setup.dashboards.enabled: false

#============================== Kibana =====================================

#添加libana仪表盘

setup.kibana:

host: "192.168.43.16:5601"

#----------------------------- Logstash output --------------------------------

output.logstash:

# The Logstash hosts

hosts: ["192.168.43.16:5044"]

3、启动filebeat

cd /opt/software/filebeat-7.3.2

nohup ./filebeat -c filebeat.yml &

四、安装logstash

1、创建logstash.conf文件

vim /home/app/elk/logstash-7.3.2/config/logstash.conf

input {

beats {

port => 5044

}

}

filter {

if [fields][log_source]=="nginx-access"{

grok {

match => {

"message" => '%{IP:clientip}\s*%{DATA}\s*%{DATA}\s*\[%{HTTPDATE:requesttime}\]\s*"%{WORD:requesttype}.*?"\s*%{NUMBER:status:int}\s*%{NUMBER:bytes_read:int}\s*"%{DATA:requesturl}"\s*%{QS:ua}'

}

overwrite => ["message"]

}

}

if [fields][log_source]=="nginx-error"{

grok {

match => {

"message" => '(?<time>.*?)\s*\[%{LOGLEVEL:loglevel}\]\s*%{DATA}:\s*%{DATA:errorinfo},\s*%{WORD}:\s*%{IP:clientip},\s*%{WORD}:%{DATA:server},\s*%{WORD}:\s*%{QS:request},\s*%{WORD}:\s*%{QS:upstream},\s*%{WORD}:\s*"%{IP:hostip}",\s*%{WORD}:\s*%{QS:referrer}'

}

overwrite => ["message"]

}

}

}

output {

if [fields][log_source]=="nginx-access"{

elasticsearch {

hosts => ["http://192.168.43.16:9200"]

action => "index"

index => "nginx-access-%{+YYYY.MM.dd}"

}

}

if [fields][log_source]=="nginx-error"{

elasticsearch {

hosts => ["http://192.168.43.16:9200"]

action => "index"

index => "nginx-error-%{+YYYY.MM.dd}"

}

}

stdout { codec => rubydebug }

}

2、启动logstash

/home/app/elk/logstash-7.3.2/bin/logstash -f /home/app/elk/logstash-7.3.2/config/logstash.conf

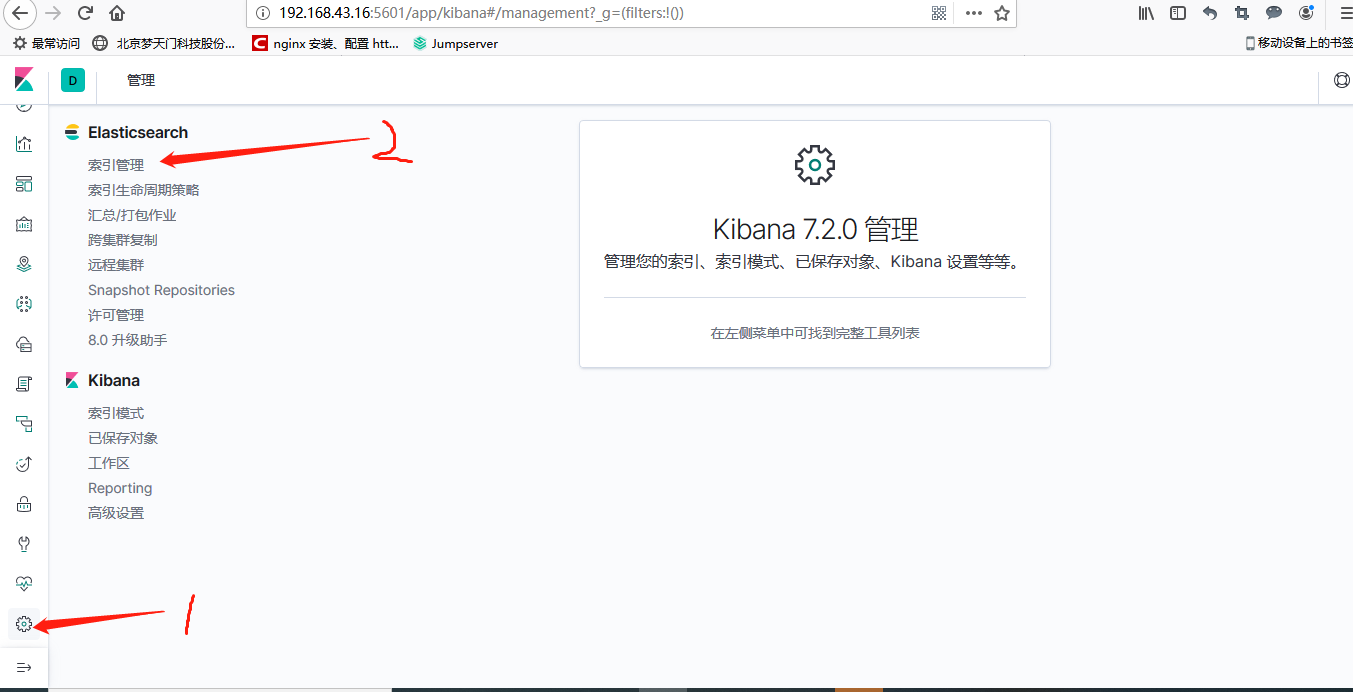

六、登陆kibana平台

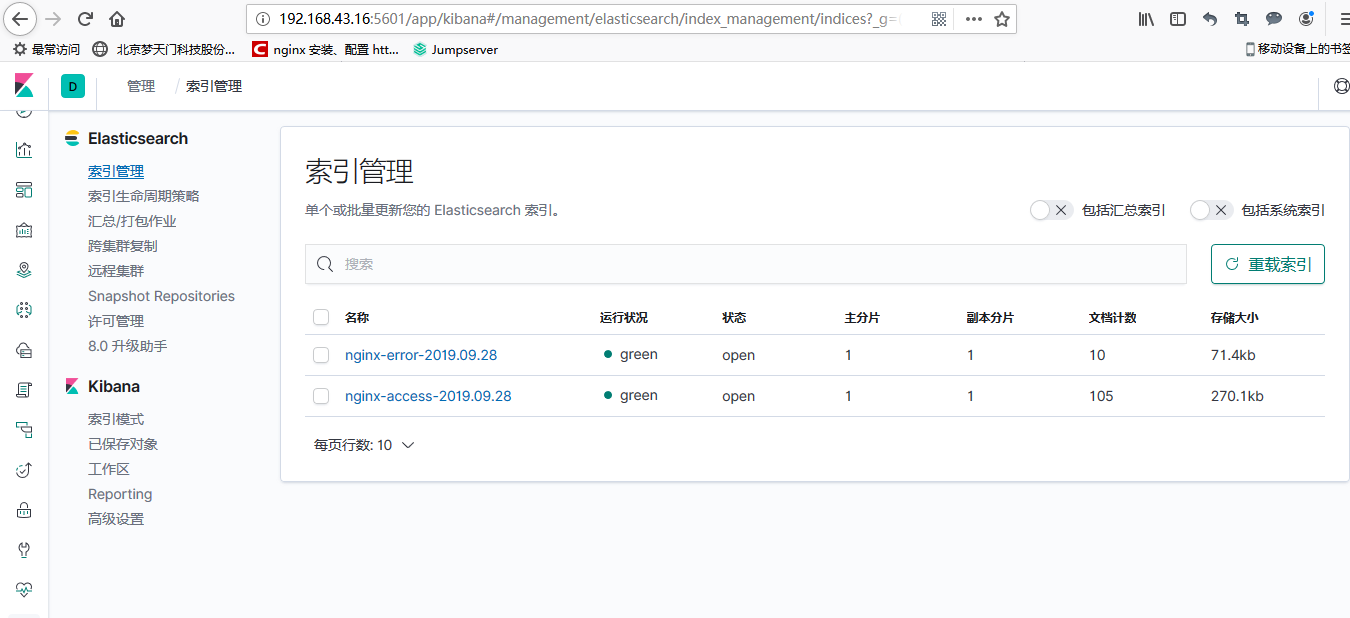

分别点击管理--》索引管理,这时候就能看到nginx的访问日志和错误日志的数据了

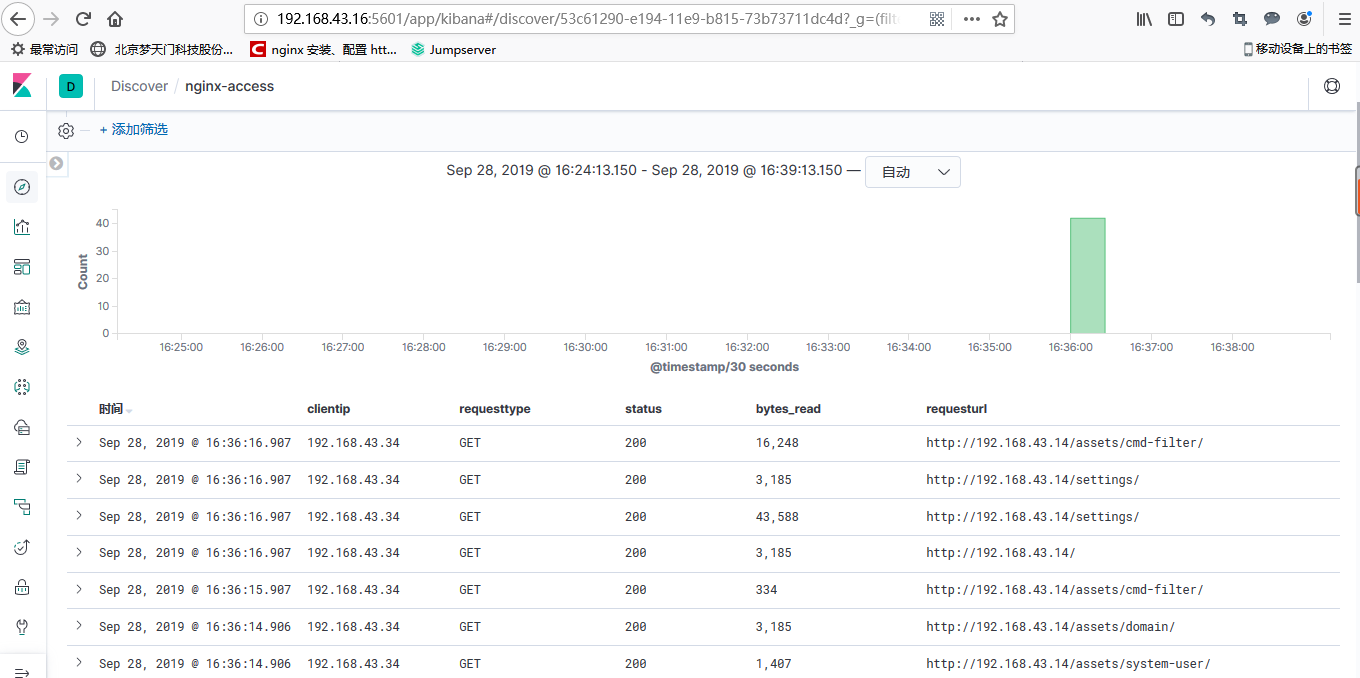

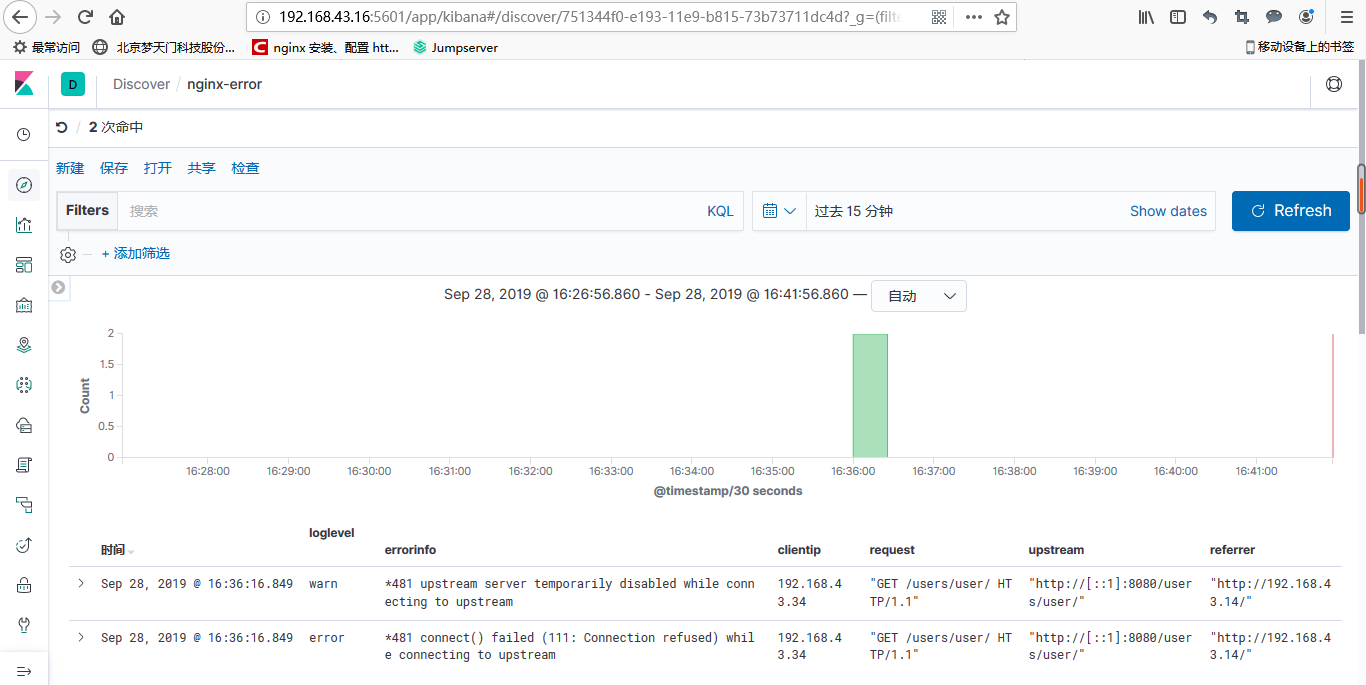

接下来创建索引,分别对访问日志和错误日志建立索引,建立完之后点击discover,就能看到日志数据了

nginx-access

nginx-error

参考文档:

https://elkguide.elasticsearch.cn/logstash/plugins/filter/mutate.html

ELK7.3实战安装配置文档的更多相关文章

- azkaban编译安装配置文档

azkaban编译安装配置文档 参考官方文档: http://azkaban.github.io/azkaban/docs/latest/ azkaban的配置文件说明:http://azkaban. ...

- Oracle12C安装配置文档

Oracle12C安装配置文档 Oracle12C安装配置文档 准备软件: 开始安装: 打开从官网下载下来的两个压缩包,进行解压 打开解压好的后缀为2of2的文件夹找到路径为database下的“ ...

- IDEA2018.1安装配置文档

一.软件安装 1. 下载地址: https://www.jetbrains.com/idea/download/#section=windows 2. 安装: 点击.exe,选择安装路径,点击next ...

- ELK6.x_Kafka 安装配置文档

1. 环境描述 1.1. 环境拓扑 如上图所示:Kafka为3节点集群负责提供消息队列,ES为3节点集群.日志通过logstash或者filebeat传送至Kafka集群,再通过logstash发 ...

- RHEL6-HA集群在VMware虚拟机环境安装配置文档

(一)系统环境描述 本文档基于RHEL6u5 系统安装,配置为2节点高可用集群,节点为两台VMware虚拟机. 也可参考http://blog.51cto.com/ty1992/1325327 (二) ...

- MySQL5.6.36 linux rpm包安装配置文档

一.卸载自带mysql,删除MySQL的lib库,服务文件 [root@localhost ~]#rpm -qa|grep mysql qt-mysql-4.6.2-26.el6_4.x86_64 m ...

- Weblate 2.11安装配置文档

一.系统环境: OS:CentOS 6.8 x64 Minimal HostName:Weblate IP:192.168.75.153 Python:2.7.13 pip:9.0.1 Weblate ...

- ganlia安装配置文档

gangliaz在ubuntu中安装和配置很简单 1. 服务器端安装 sudo apt-get install ganglia-monitor ganglia-webfrontend rrdtool ...

- WebLogic12C安装配置文档

jdk版本:1.8; jdk安装路径不准有空格 JDK安装: jdk版本:1.8; jdk安装路径不准有空格 WebLogic安装: 解压安装包 解压JAR 找到fmw_12.2.1.3.0_wls\ ...

随机推荐

- 消息中间件——RabbitMQ(八)高级特性全在这里!(下)

前言 上一篇消息中间件--RabbitMQ(七)高级特性全在这里!(上)中我们介绍了消息如何保障100%的投递成功?,幂等性概念详解,在海量订单产生的业务高峰期,如何避免消息的重复消费的问题?,Con ...

- C笔记_动态库和静态库

1. 静态库 创建 工程属性配置中设置为lib静态库,编辑.h文件和.c文件,生成即可. 使用 方法一: 添加工程的头文件目录:工程---属性---配置属性---c/c++---常规---附加包含目录 ...

- HDU 6044

题意略. 思路: I.对于整个区间a1,....,an,必然有一个区间[1,n]与之对应,因为a1,...,an是1,...,n的一个排列,所以在[1,n]中定然有一个最小的数字1, 如果最大的区间[ ...

- Java网络编程之UDP

Java网络编程之UDP 一.C/S架构中UDP网络通信流程 ①创建DatagramSocket与DatagramPacket对象 ②建立发送端,接收端 ③建立数据包 ④调用Socket的发送.接收方 ...

- 从零开始搭建Java开发环境第四篇:精选IDEA中十大提高开发效率的插件!

Lombok 知名的插件,无需再写那么多冗余的get/set代码 JRebel 热部署插件 alibaba java coding guide 阿里巴巴代码规范插件,自动检查代码规范问题 [在这里插入 ...

- 猫眼电影和电影天堂数据csv和mysql存储

字符串常用方法 # 去掉左右空格 'hello world'.strip() # 'hello world' # 按指定字符切割 'hello world'.split(' ') # ['hello' ...

- netcore 之动态代理(微服务专题)

动态代理配合rpc技术调用远程服务,不用关注细节的实现,让程序就像在本地调用以用. 因此动态代理在微服务系统中是不可或缺的一个技术.网上看到大部分案例都是通过反射自己实现,且相当复杂.编写和调试相当不 ...

- C#开发BIMFACE系列12 服务端API之文件转换

系列目录 [已更新最新开发文章,点击查看详细] 在代表模型的源文件上传到BIMFACE后,一般会进行三种API调用操作: 发起模型转换 查询转换状态 如转换成功,获取模型转换后的BIM数据 在 ...

- C#开发BIMFACE系列14 服务端API之批量获取转换状态详情

系列目录 [已更新最新开发文章,点击查看详细] 上一篇<C#开发BIMFACE系列13 服务端API之获取转换状态>中介绍了根据文件ID查询单个文件的转换状态. 本文介绍批量获取转 ...

- EF的3种开发模式

那么明显开发模式是三种. 即:DateBase First(数据库优先).Model First(模型优先)和Code First(代码优先). 当然,如果把Code First模式的两种具体方式独立 ...