Pytorch多卡训练

前一篇博客利用Pytorch手动实现了LeNet-5,因为在训练的时候,机器上的两张卡只用到了一张,所以就想怎么同时利用起两张显卡来训练我们的网络,当然LeNet这种层数比较低而且用到的数据集比较少的神经网络是没有必要两张卡来训练的,这里只是研究怎么调用两张卡。

现有方法

在网络上查找了多卡训练的方法,总结起来就是三种:

- nn.DataParallel

- pytorch-encoding

- distributedDataparallel

第一种方法是pytorch自带的多卡训练的方法,但是从方法的名字也可以看出,它并不是完全的并行计算,只是数据在两张卡上并行计算,模型的保存和Loss的计算都是集中在几张卡中的一张上面,这也导致了用这种方法两张卡的显存占用会不一致。

第二种方法是别人开发的第三方包,它解决了Loss的计算不并行的问题,除此之外还包含了很多其他好用的方法,这里放出它的GitHub链接有兴趣的同学可以去看看。

第三种方法是这几种方法最复杂的一种,对于该方法来说,每个GPU都会对自己分配到的数据进行求导计算,然后将结果传递给下一个GPU,这与DataParallel将所有数据汇聚到一个GPU求导,计算Loss和更新参数不同。

这里我先选择了第一个方法进行并行的计算

并行计算相关代码

首先需要检测机器上是否有多张显卡

USE_MULTI_GPU = True

# 检测机器是否有多张显卡

if USE_MULTI_GPU and torch.cuda.device_count() > 1:

MULTI_GPU = True

os.environ["CUDA_DEVICE_ORDER"] = "PCI_BUS_ID"

os.environ["CUDA_VISIBLE_DEVICES"] = "0, 1"

device_ids = [0, 1]

else:

MULTI_GPU = False

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

其中os.environ["CUDA_VISIBLE_DEVICES"] = "0, 1"是将机器中的GPU进行编号

接下来就是读取模型了

net = LeNet()

if MULTI_GPU:

net = nn.DataParallel(net,device_ids=device_ids)

net.to(device)

这里与单卡的区别就是多了nn.DataParallel这一步操作

接下来是optimizer和scheduler的定义

optimizer=optim.Adam(net.parameters(), lr=1e-3)

scheduler = StepLR(optimizer, step_size=100, gamma=0.1)

if MULTI_GPU:

optimizer = nn.DataParallel(optimizer, device_ids=device_ids)

scheduler = nn.DataParallel(scheduler, device_ids=device_ids)

因为optimizer和scheduler的定义发送了变化,所以在后期调用的时候也有所不同

比如读取learning rate的一段代码:

optimizer.state_dict()['param_groups'][0]['lr']

现在就变成了

optimizer.module.state_dict()['param_groups'][0]['lr']

详细的代码可以在我的GitHub仓库看到

开始训练

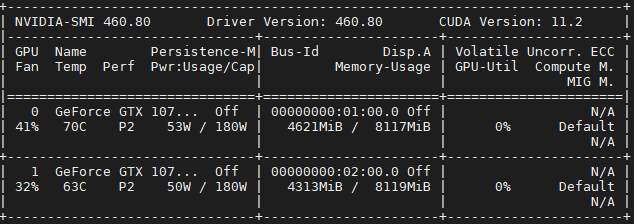

训练过程与单卡一样,这里就展示两张卡的占用情况

可以看到两张卡都有占用,这说明我们的代码起了作用,但是也可以看到,两张卡的占用有明显的区别,这就是前面说到的DataParallel只是在数据上并行了,在loss计算等操作上并没有并行

最后

如果文章那里有错误和建议,都可以向往指出

Pytorch多卡训练的更多相关文章

- Pytorch使用分布式训练,单机多卡

pytorch的并行分为模型并行.数据并行 左侧模型并行:是网络太大,一张卡存不了,那么拆分,然后进行模型并行训练. 右侧数据并行:多个显卡同时采用数据训练网络的副本. 一.模型并行 二.数据并行 数 ...

- 使用Pytorch进行多卡训练

当一块GPU不够用时,我们就需要使用多卡进行并行训练.其中多卡并行可分为数据并行和模型并行.具体区别如下图所示: 由于模型并行比较少用,这里只对数据并行进行记录.对于pytorch,有两种方式可以进行 ...

- Pytorch多GPU训练

Pytorch多GPU训练 临近放假, 服务器上的GPU好多空闲, 博主顺便研究了一下如何用多卡同时训练 原理 多卡训练的基本过程 首先把模型加载到一个主设备 把模型只读复制到多个设备 把大的batc ...

- 计图(Jittor) 1.1版本:新增骨干网络、JIT功能升级、支持多卡训练

计图(Jittor) 1.1版本:新增骨干网络.JIT功能升级.支持多卡训练 深度学习框架-计图(Jittor),Jittor的新版本V1.1上线了.主要变化包括: 增加了大量骨干网络的支持,增强了辅 ...

- pytorch 多GPU训练总结(DataParallel的使用)

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明.本文链接:https://blog.csdn.net/weixin_40087578/artic ...

- pytorch: 准备、训练和测试自己的图片数据

大部分的pytorch入门教程,都是使用torchvision里面的数据进行训练和测试.如果我们是自己的图片数据,又该怎么做呢? 一.我的数据 我在学习的时候,使用的是fashion-mnist.这个 ...

- AMD cpu 下 Pytorch 多卡并行卡死问题解决

dataparallel not working on nvidia gpus and amd cpus https://github.com/pytorch/pytorch/issues/130 ...

- pytorch版yolov3训练自己数据集

目录 1. 环境搭建 2. 数据集构建 3. 训练模型 4. 测试模型 5. 评估模型 6. 可视化 7. 高级进阶-网络结构更改 1. 环境搭建 将github库download下来. git cl ...

- PyTorch Tutorials 4 训练一个分类器

%matplotlib inline 训练一个分类器 上一讲中已经看到如何去定义一个神经网络,计算损失值和更新网络的权重. 你现在可能在想下一步. 关于数据? 一般情况下处理图像.文本.音频和视频数据 ...

随机推荐

- SSM 电影后台管理项目

SSM 电影后台管理项目 概述 通过对数据库中一张表的CRUD,将相应的操作结果渲染到页面上. 笔者通过这篇博客还原了项目(当然有一些隐藏的坑),然后将该项目上传到了Github.Gitee,在末尾会 ...

- 七大php主流框架,你用过几个?

在php中,我们最常用的框架有七个,分别是Yii2.Laravel.Yaf.Thinkphp.Code Igniter.Zend Framework以及CakePHP,今天我们就来详细介绍一下他们.一 ...

- C++并发与多线程学习笔记--多线程数据共享问题

创建和等待多个线程 数据和共享问题分析 只读的数据 有读有写 其他案例 共享数据的保护案例代码 创建和等待多个线程 服务端后台开发就需要多个线程执行不同的任务.不同的线程执行不同任务,并返回执行结果. ...

- JVM(一)内存结构

今日开篇 什么是JVM 定义 Java Virtual Machine,JAVA程序的运行环境(JAVA二进制字节码的运行环境) 好处 一次编写,到处运行 自动内存管理,垃圾回收机制 数组下标越界检查 ...

- 浅入Kubernetes(7):应用部署实例,Deployment、Service、ReplicaSet

目录 Deployment 创建 Deployment kubectl apply/create 网络端口映射和更新 Deployment ReplicaSet 在本文之前,你需要阅读: 尝试 kub ...

- vue Element-ui 表格多选 修改选中行背景色

实现的效果: 整体思路方式: 1.给获取到的数据添加自定义的className 2.在点击行(row-click)和手动点击勾选框的事件(select-all)中获取到当前的row的className ...

- Spring Cloud & Alibaba 实战 | 第十二篇: 微服务整合Sentinel的流控、熔断降级,赋能拥有降级功能的Feign新技能熔断,实现熔断降级双剑合璧(JMeter模拟测试)

目录 一. Sentinel概念 1. 什么是Sentinel? 2. Sentinel功能特性 3. Sentinel VS Hystrix 二. Docker部署Sentinel Dashboar ...

- CentOS7 常用基础操作

系统目录结构了解 CentOS系统中没有磁盘的概念,一切皆文件,/目录下的的一个个文件夹目录就相当于磁盘了,这里简单记录几个常用的目录以及对应的作用: dev:Linux一切皆文件,包括硬件也进行了文 ...

- PAT归纳总结——一些容易记混的概念

在刷题的过程中,有时候会遇到一些数据结构中的一些概念,如果对这些概念理解不清楚,甚至理解有误的话,就很可能把题目做错.所以,专门找出在刷题过程中出现的一些概念,以免考试的时候用到想不起来. 拓扑排序 ...

- Weekly Contest 137

1046. Last Stone Weight We have a collection of rocks, each rock has a positive integer weight. Each ...