Kafka:Springboot整合Kafka消息队列

本文主要分享下Spring Boot和Spring Kafka如何配置整合,实现发送和接收来自Spring Kafka的消息。

项目结构

pom依赖包

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion> <groupId>com.java.zy</groupId>

<artifactId>base-kafka</artifactId>

<version>1.0-SNAPSHOT</version> <parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>2.1.2.RELEASE</version>

<relativePath/>

</parent> <dependencies> <dependency>

<groupId>com.alibaba</groupId>

<artifactId>fastjson</artifactId>

<version>1.2.47</version>

</dependency> <dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency> <!--引入kafak和spring整合的jar-->

<dependency>

<groupId>org.springframework.kafka</groupId>

<artifactId>spring-kafka</artifactId>

<version>2.2.8.RELEASE</version>

</dependency> <!-- https://mvnrepository.com/artifact/org.springframework.kafka/spring-kafka-test -->

<dependency>

<groupId>org.springframework.kafka</groupId>

<artifactId>spring-kafka-test</artifactId>

<version>2.2.8.RELEASE</version>

<scope>test</scope>

</dependency> </dependencies> </project>

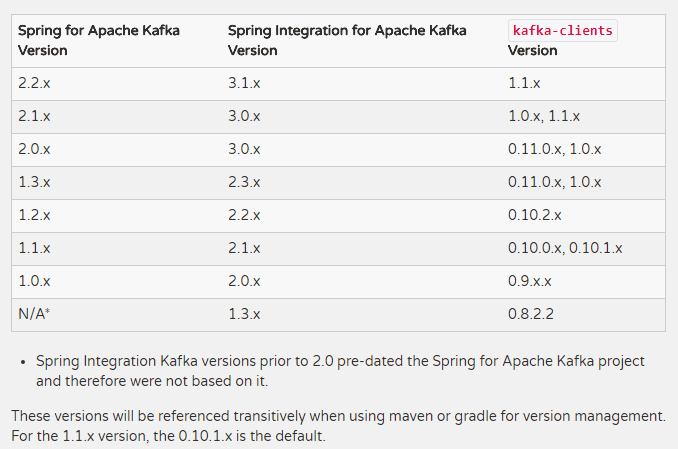

Springboot+kafka对应表

JAVA代码

定义数据传输对象

package com.java.common.entity; import org.springframework.stereotype.Component; @Component

public class UserLog { private String username;

private String userid;

private String state; public String getUsername() {

return username;

} public void setUsername(String username) {

this.username = username;

} public String getUserid() {

return userid;

} public void setUserid(String userid) {

this.userid = userid;

} public String getState() {

return state;

} public void setState(String state) {

this.state = state;

}

}

定义发送信息实体 ( 消息的发送直接使用KafkaTemplate模板即可,都封装好了,直接使用 )

package com.java.common.controller; import com.alibaba.fastjson.JSON;

import com.java.common.entity.UserLog;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.kafka.core.KafkaTemplate;

import org.springframework.stereotype.Component; @Component

public class UserLogProducer { @Autowired

private KafkaTemplate kafkaTemplate; /**

* 发送数据

* @param userid

*/

public void sendLog(String userid){

UserLog userLog = new UserLog();

userLog.setUsername("jhp");

userLog.setUserid(userid);

userLog.setState("0");

System.err.println("发送用户日志数据:"+userLog);

kafkaTemplate.send("user-log", JSON.toJSONString(userLog));

} }

获取消息的消费者实体

注意:消费机制是通过监听器实现的,直接使用@KafkaListener(topics = {"user-log"})注解,根据指定的条件进行消息的监听

package com.java.common.controller; import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.springframework.kafka.annotation.KafkaListener;

import org.springframework.stereotype.Component; import java.util.Optional; @Component

public class UserLogConsumer { @KafkaListener(topics = {"user-log"})

public void consumer(ConsumerRecord<?,?> consumerRecord){

//判断是否为null

Optional<?> kafkaMessage = Optional.ofNullable(consumerRecord.value());

System.out.println(">>>>>>>>>> record = " + kafkaMessage);

if(kafkaMessage.isPresent()){

//得到Optional实例中的值

Object message = kafkaMessage.get();

System.err.println("消费消息:"+message);

}

} }

Springboot应用启动类(方便测试,在容器初始化的就开始模拟消息的发送)

package com.java.common; import com.java.common.controller.UserLogProducer;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication; import javax.annotation.PostConstruct; @SpringBootApplication

public class KafkaApplication { @Autowired

private UserLogProducer kafkaSender;

@PostConstruct

public void init(){

for (int i = 0; i < 10; i++) {

//调用消息发送类中的消息发送方法

kafkaSender.sendLog(String.valueOf(i));

}

} public static void main(String[] args) {

SpringApplication.run(KafkaApplication.class,args);

} }

对应的application.properties配置文件

spring.application.name=base-kafka

server.port=8080

#============== kafka ===================

# 指定kafka 代理地址,可以多个

spring.kafka.bootstrap-servers=localhost:9092,192.168.100.1:9093 #=============== provider =======================

spring.kafka.producer.retries=0

# 每次批量发送消息的数量

spring.kafka.producer.batch-size=16384

spring.kafka.producer.buffer-memory=33554432

# 指定消息key和消息体的编解码方式

spring.kafka.producer.key-serializer=org.apache.kafka.common.serialization.StringSerializer

spring.kafka.producer.value-serializer=org.apache.kafka.common.serialization.StringSerializer #=============== consumer =======================

# 指定默认消费者group id

spring.kafka.consumer.group-id=user-log-group

spring.kafka.consumer.auto-offset-reset=earliest

spring.kafka.consumer.enable-auto-commit=true

spring.kafka.consumer.auto-commit-interval=100

# 指定消息key和消息体的编解码方式

spring.kafka.consumer.key-deserializer=org.apache.kafka.common.serialization.StringDeserializer

spring.kafka.consumer.value-deserializer=org.apache.kafka.common.serialization.StringDeserializer

对应的application.yml配置文件

server:

port: 8080 spring:

application:

name: base-kafka

#============== kafka ===================

# 指定kafka 代理地址,可以多个

kafka:

bootstrap-servers: 192.168.200.27:19092 #=============== provider =======================

producer:

retries: 0

# 每次批量发送消息的数量

batch-size: 16384

buffer-memory: 33554432

# 指定消息key和消息体的编解码方式

key-serializer: org.apache.kafka.common.serialization.StringSerializer

value-serializer: org.apache.kafka.common.serialization.StringSerializer #=============== consumer =======================

consumer:

# 指定默认消费者group id(消息组)

group-id: user-log

auto-offset-reset: earliest

enable-auto-commit: true

auto-commit-interval: 100

# 指定消息key和消息体的编解码方式

key-serializer: org.apache.kafka.common.serialization.StringSerializer

value-serializer: org.apache.kafka.common.serialization.StringSerializer

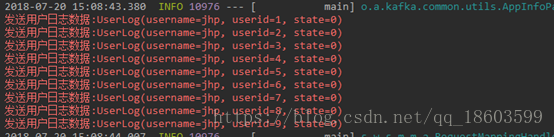

测试结果

启动项目,观察控制台打印的消息

和

springboot和kafka成功整合!

文章转载至:https://blog.csdn.net/qq_18603599/article/details/81169488

Kafka:Springboot整合Kafka消息队列的更多相关文章

- springBoot(11)---整合Active消息队列

Springboot整合Active消息队列 简单理解: Active是Apache公司旗下的一个消息总线,ActiveMQ是一个开源兼容Java Message Service(JMS) 面向消息的 ...

- SpringBoot系列八:SpringBoot整合消息服务(SpringBoot 整合 ActiveMQ、SpringBoot 整合 RabbitMQ、SpringBoot 整合 Kafka)

声明:本文来源于MLDN培训视频的课堂笔记,写在这里只是为了方便查阅. 1.概念:SpringBoot 整合消息服务 2.具体内容 对于异步消息组件在实际的应用之中会有两类: · JMS:代表作就是 ...

- SpringBoot整合Kafka和Storm

前言 本篇文章主要介绍的是SpringBoot整合kafka和storm以及在这过程遇到的一些问题和解决方案. kafka和storm的相关知识 如果你对kafka和storm熟悉的话,这一段可以直接 ...

- SpringBoot整合kafka(安装)

项目路径:https://github.com/zhaopeng01/springboot-study/tree/master/study_14 序言 Kafka 是一种高吞吐的分布式发布订阅消息系统 ...

- SpringBoot整合Kafka

一.准备工作 提前启动zk,kafka,并且创建一个Topic("Hello-Kafk") bin/kafka-topics.sh --create --zookeeper 192 ...

- 为什么要用kafka、rabbit等消息队列

1.解耦: 允许你独立的扩展或修改两边的处理过程,只要确保它们遵守同样的接口约束. 2.冗余: 消息队列把数据进行持久化直到它们已经被完全处理,通过这一方式规避了数据丢失风险.许多消息队列所采用的&q ...

- SpringBoot日记——MQ消息队列整合(一)

除了之前讲到的缓存,我们还会用到消息队列来存储一些消息,为了提升系统的异步性能等等: 消息服务有两个概念需要知道:消息代理-message broker,目的地-destination.消息发送由代理 ...

- Kafka,Mq,Redis作为消息队列有何差异?

Kafka作为新一代的消息系统,mq是比较成熟消息系统,而redis也可以发布订阅,那么这三者有何异同? RabbitMQ 是使用Erlang编写的一个开源的消息队列,本身支持很多的协议:AMQP,X ...

- springboot 整合kafka

本文介绍如何在springboot项目中集成kafka收发message. 1.先解决依赖 springboot相关的依赖我们就不提了,和kafka相关的只依赖一个spring-kafka集成包 &l ...

随机推荐

- Keepalived+nginx高可用

这种方法会把Keepalived进程结束掉,在教育机构学习到的方法,我个人对这种方法不认可. 参考: https://www.cnblogs.com/gshelldon/p/14504236.html ...

- python 如何让俩个对象相等及如何让俩个对象具有相同的id值

- HDFS的小文件问题

HDFS 中任何一个文件,目录或者数据块在 NameNode 节点内存中均以一个对象形式表示(元数据),而这受到 NameNode 物理内存容量的限制.每个元数据对象约占 150 byte,所以如果有 ...

- Docker Registry 简化版

目录 Docker Registry 为什么要使用Registry 依赖 启动 Configuring a registry 配置认证 Docker Registry https://docs.doc ...

- Nginx限制访问速率和最大并发连接数模块--limit

Nginx限制访问速率和最大并发连接数模块--limit Tengine版本采用http_limit_req_module进行限制 具体连接请参考 http://tengine.taobao.org/ ...

- 安装 error: Microsoft Visual C++ 14.0 is required 解决方案

最近写的项目需要用到Python的第三方库,比如:mmh3, pyshark等等,而直接pip install ... 会报错:error: Microsoft Visual C++ 14.0 is ...

- Scrapy中的错误

TabError: Inconsistent use of tabs and spaces in indentation 需要将 .py 文件中的使用 tab 做的空格符删掉,打成空格符.任何一个 ...

- PyTorch 图像分类

PyTorch 图像分类 如何定义神经网络,计算损失值和网络里权重的更新. 应该怎么处理数据? 通常来说,处理图像,文本,语音或者视频数据时,可以使用标准 python 包将数据加载成 numpy 数 ...

- 如何在GPU上优化卷积

本文将演示如何在TVM中编写高性能的卷积实现.以平方大小的输入张量和滤波器为例,并假设卷积的输入量很大.使用不同的布局来存储数据,以实现更好的数据局部性.缓冲区布局为HWCN,代表高度,宽度,通道,批 ...

- 基于TensorRT 3的自动驾驶快速INT8推理

基于TensorRT 3的自动驾驶快速INT8推理 Fast INT8 Inference for Autonomous Vehicles with TensorRT 3 自主驾驶需要安全性,需要一种 ...