【Hadoop离线基础总结】Hue与Hadoop集成

目录

1.更改所有hadoop节点的core-site.xml配置

cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop/

vim core-site.xml

添加以下配置<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

发送到node02,node03

scp core-site.xml node02:$PWD

scp core-site.xml node03:$PWD

2.更改所有hadoop节点的hdfs-site.xml

vim hdfs-site.xml

添加以下配置<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

发送到node02,node03

scp hdfs-site.xml node02:$PWD

scp hdfs-site.xml node03:$PWD

3.重启hadoop集群

在node01执行

cd /export/servers/hadoop-2.6.0-cdh5.14.0

sbin/stop-dfs.sh

sbin/start-dfs.sh

sbin/stop-yarn.sh

sbin/start-yarn.sh

4.停止hue的服务,并继续配置hue.ini

cd /export/servers/hue-3.9.0-cdh5.14.0/desktop/conf

vim hue.ini 最好别用vim编辑

配置hue与hdfs集成

[[hdfs_clusters]]

[[[default]]]

fs_defaultfs=hdfs://node01.hadoop.com:8020

webhdfs_url=http://node01.hadoop.com:50070/webhdfs/v1

hadoop_hdfs_home=/export/servers/hadoop-2.6.0-cdh5.14.0 (前两行是修改,后三行是添加)

hadoop_bin=/export/servers/hadoop-2.6.0-cdh5.14.0/bin

hadoop_conf_dir=/export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

配置hue与yarn集成

[[yarn_clusters]]

[[[default]]]

resourcemanager_host=node01

resourcemanager_port=8032

submit_to=True

resourcemanager_api_url=http://node01:8088

history_server_api_url=http://node01:19888

启动hue进程,查看hadoop是否与Hue集成成功

cd /export/servers/hue-3.9.0-cdh5.14.0/

build/env/bin/supervisor

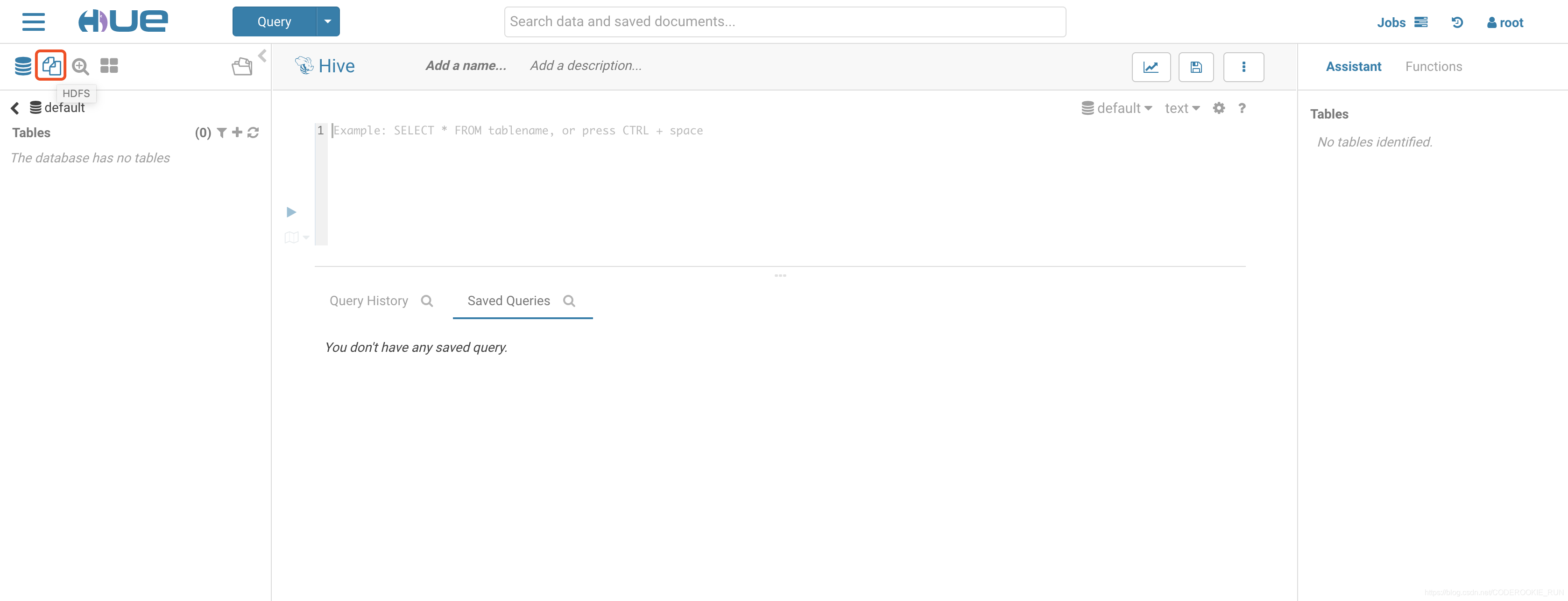

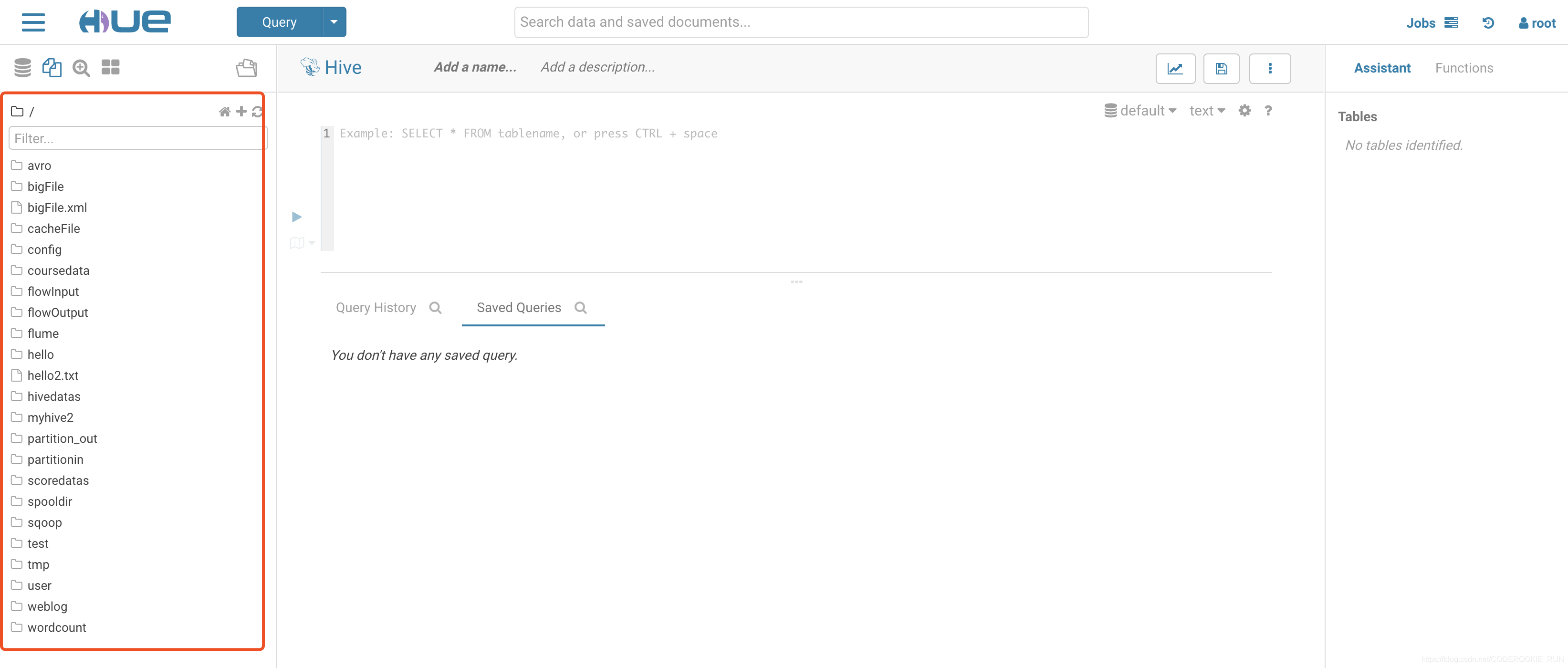

连接到web页面,显示如下图表示配置成功

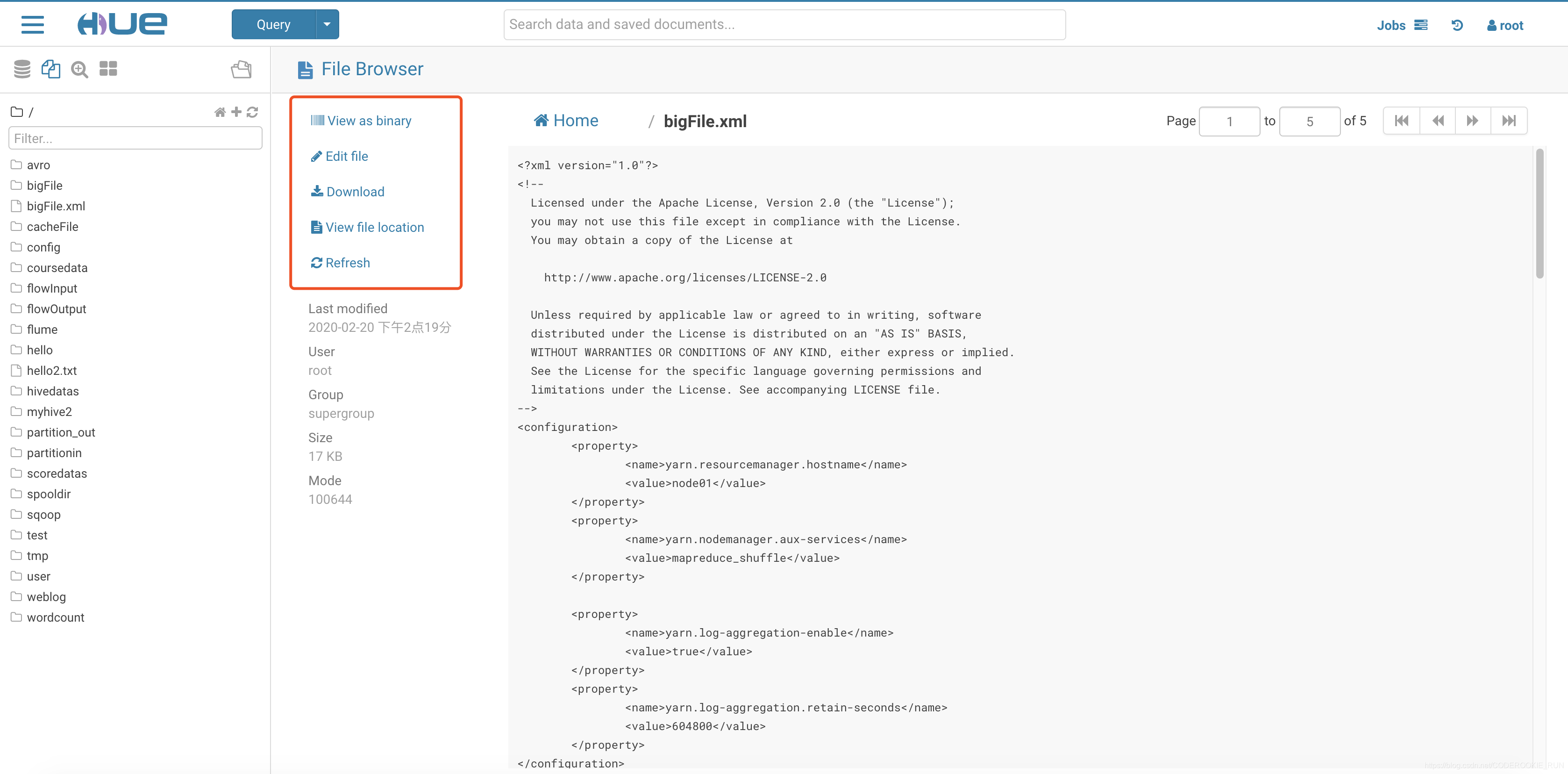

可以直接在网页对HDFS的文件进行操作

【Hadoop离线基础总结】Hue与Hadoop集成的更多相关文章

- 【Hadoop离线基础总结】Apache Hadoop的三种运行环境介绍及standAlone环境搭建

Apache Hadoop的三种运行环境介绍及standAlone环境搭建 三种运行环境 standAlone环境 单机版的hadoop运行环境 伪分布式环境 主节点都在一台机器上,从节点分开到其他机 ...

- 【Hadoop离线基础总结】Hue的简单介绍和安装部署

目录 Hue的简单介绍 概述 核心功能 安装部署 下载Hue的压缩包并上传到linux解压 编译安装启动 启动Hue进程 hue与其他框架的集成 Hue与Hadoop集成 Hue与Hive集成 Hue ...

- 【Hadoop离线基础总结】oozie的安装部署与使用

目录 简单介绍 概述 架构 安装部署 1.修改core-site.xml 2.上传oozie的安装包并解压 3.解压hadooplibs到与oozie平行的目录 4.创建libext目录,并拷贝依赖包 ...

- 【Hadoop离线基础总结】impala简单介绍及安装部署

目录 impala的简单介绍 概述 优点 缺点 impala和Hive的关系 impala如何和CDH一起工作 impala的架构及查询计划 impala/hive/spark 对比 impala的安 ...

- 【Hadoop离线基础总结】流量日志分析网站整体架构模块开发

目录 数据仓库设计 维度建模概述 维度建模的三种模式 本项目中数据仓库的设计 ETL开发 创建ODS层数据表 导入ODS层数据 生成ODS层明细宽表 统计分析开发 流量分析 受访分析 访客visit分 ...

- 【Hadoop离线基础总结】Sqoop常用命令及参数

目录 常用命令 常用公用参数 公用参数:数据库连接 公用参数:import 公用参数:export 公用参数:hive 常用命令&参数 从关系表导入--import 导出到关系表--expor ...

- 【Hadoop离线基础总结】Hive调优手段

Hive调优手段 最常用的调优手段 Fetch抓取 MapJoin 分区裁剪 列裁剪 控制map个数以及reduce个数 JVM重用 数据压缩 Fetch的抓取 出现原因 Hive中对某些情况的查询不 ...

- 【Hadoop离线基础总结】Hue与Mysql集成

Hue与Mysql集成 1.修改hue.ini配置文件 这里要去掉#,打开mysql注释,大概在1547行 [[[mysql]]] nice_name="My SQL DB" en ...

- 【Hadoop离线基础总结】Hue与Impala集成

Hue与Impala集成 1.修改hue.ini配置文件 [impala] server_host=node03 server_port=21050 impala_conf_dir=/etc/impa ...

随机推荐

- Salesforce 产品 | 协同办公“大魔王”,Salesforce Quip的使用攻略!

Salesforce帮助企业渡过疫情难关,支持在线远程办公.7.5亿美金收购的动态文档共享平台Quip,即刻开放给所有Salesforce老客户还有非营利组织免费使用至2020年9月30日. Quip ...

- Jmeter命令行执行并生成HTML报告

前提:准备好jmeter脚本,找到jmeter配置文件查看生成的日志格式是否为csv,如果不是请改为csv 注意:使用命令执行jmeter脚本必须使用jmeter 3.0及以上版本1.使用命令行执行脚 ...

- 常用App用户体验找茬

冯晓云: 哔哩哔哩手机客户端:视频播放只允许横屏全屏:还有长视频的“5分钟诅咒”,遇到网速不好的时候是个大写的悲剧: 必应词典UWP版本:主页新闻链接跳转后,一些页面不支持划词取译,当然本身各个页面也 ...

- fasttext 和pysparnn的安装

- SpringCloud-Bus 消息总线

概述 基本介绍 Spring Cloud Bus 目前支持两种消息代理:RabbitMQ.Kafka Spring Cloud Config 配合 Spring Cloud Bus 使用可以实现配置的 ...

- [函数] PHP取二进制文件头快速判断文件类型

一般我们都是按照文件扩展名来判断文件类型,但其实不太靠谱,因为可以通过修改扩展名来伪装文件类型.其实我们可以通过读取文件信息来识别,比如 PHP扩展中提供了类似 exif_imagetype 这样的函 ...

- centos7源码安装Apache及Tomcat

源码安装Apache (1) 一.通过 https://apr.apache.org/ 下载 APR 和 APR-util 通过 http://httpd.apache.org/download.c ...

- 酷狗音乐快速转换MP3格式的方法

喜欢听音乐的朋友们,散步跑步的时候都是随身听,音乐可以给人带来力量,让人心情愉悦,有时候甚至还可以让我们忘记烦恼和忧愁,是一种不错的解压方式,所以热爱运动的宝宝们是离不来音乐的陪伴的,这样说来随身听的 ...

- 如何在 Amazon AWS 上设置一台 Linux 服务器

摘要: AWS(Amazon Web Services)是全球领先的云服务器提供商之一.你可以使用 AWS 平台在一分钟内设置完服务器.在 AWS 上,你可以微调服务器的许多技术细节,如 CPU 数量 ...

- Python-四则运算-蔡晓晴,杜婷萱

github链接:https://github.com/Amy-CC/Arithmetic-Operation 一.需求 1.使用-n 参数控制生成题目的个数 2.使用-r 参数控制题目中数值(自然数 ...