强化学习--QLearning

1.概述:

QLearning基于值函数的方法,不同与policy gradient的方法,Qlearning是预测值函数,通过值函数来选择

值函数最大的action,而policy gradient直接预测出action。

目标就是选择出最佳action。

2一些定义

2.1值函数

Given an actor π, it evaluates how good the actor is

有2种值函数,V(S) 、Q(s,a).

2.1.1 V(S)

有2种衡量的方法:

MC方法只能等玩完一个episode才能进行统计评价,效率比较低。

TD方法可以每玩一步就更新一次。

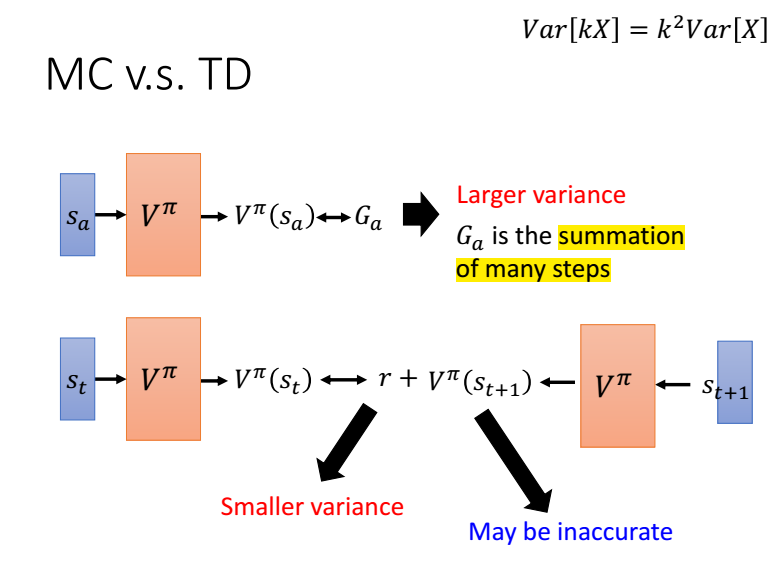

mc与td对比,mc需要估计的是一个episode的值函数,方差比较大,而td是与时间相关的,只有r是需要估计的,方差比较小。

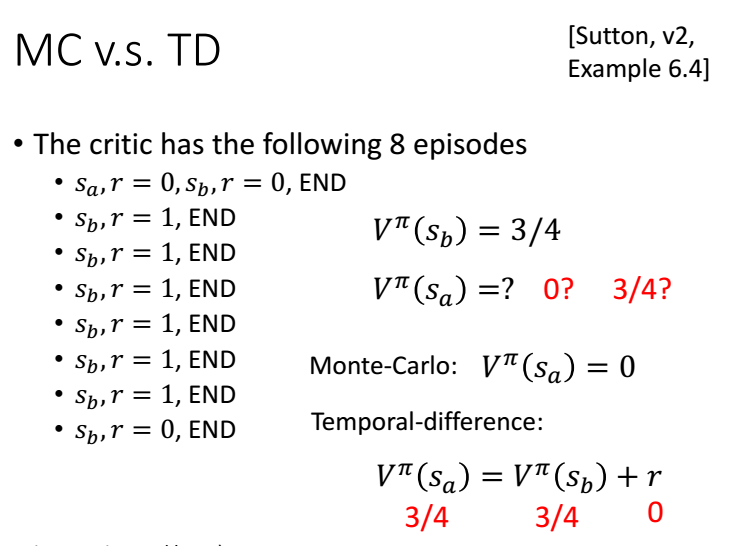

下面看一下例子:

V(Sb)=6/8=1

MC: V(Sa)=0/2=0

TD: V(Sa)=V(Sb)+0=3/4

2.1.2 Q(s,a)

我们可以评估,在当前状态s,采取行动a,在接下来的游戏中获得得奖励累计和的期望为Q(s,a)。但在接下来的游戏中,

不一定采取行动a,而是采取Q值最大的行动。

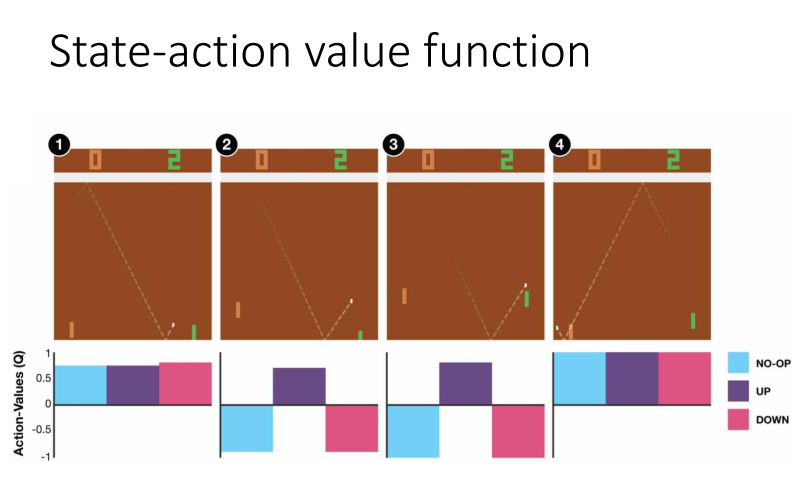

下图中1,无论采取那个行动都无所谓,因为离球还很远,而图2离球比较近了,我们需要向上接到球,接下来游戏才能获得奖励。

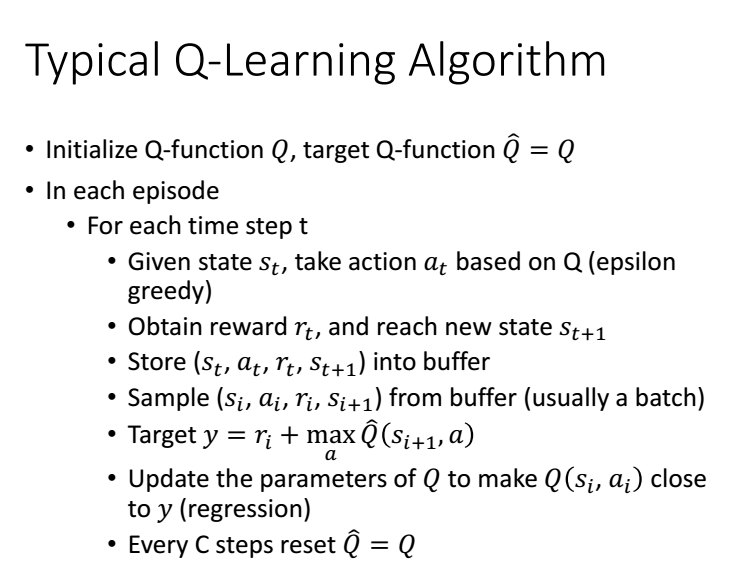

3 怎么用

我们利用PI去与环境互动,得到一些互动数据,通过TDorMC的方法去更新Q(s,a)的参数,

根据更新后的Q,我们选择一个更好的pi_new,然后把pi更新为pi_new,再去与环境互动。

tips:pi_new 是完全取决于Q,没有新参数。

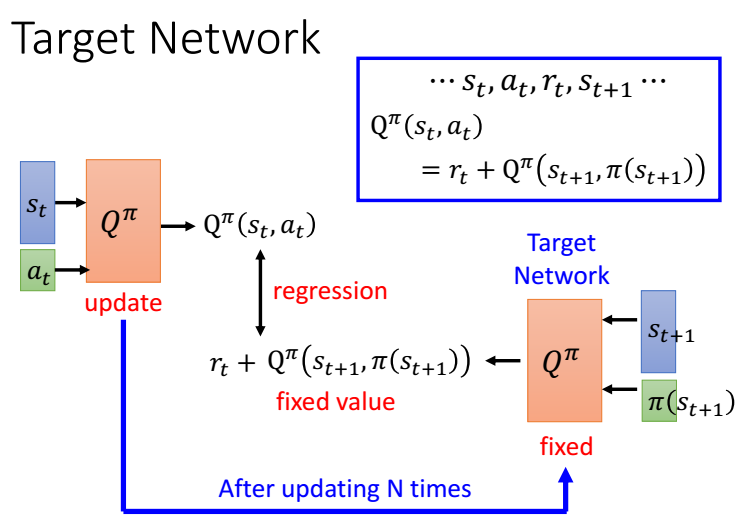

3.1 target network

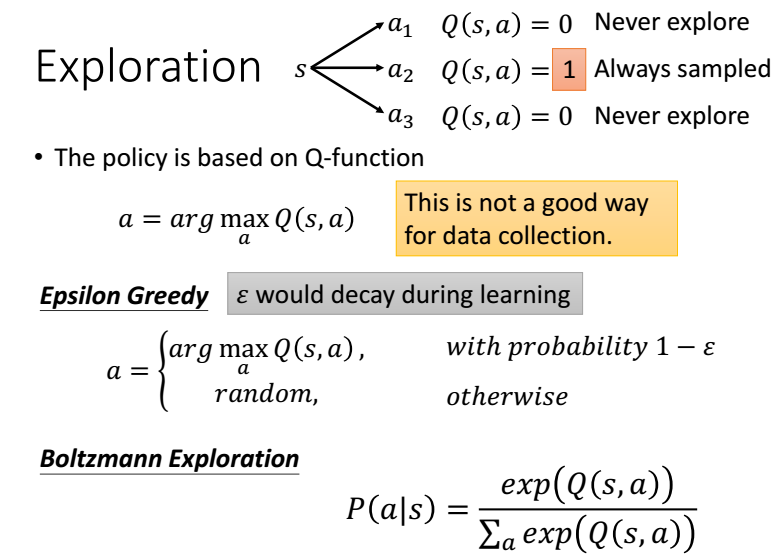

3.2 Epsilon Greedy

如果我们只选择Q值最大的action,如果碰巧其他的action没有被采样到,这样其他的action将更不会被选择,

并不是他们不好,所以需要打破这种循环,我们以一定的几率选择Q最大的,还有几率选择其他的action。

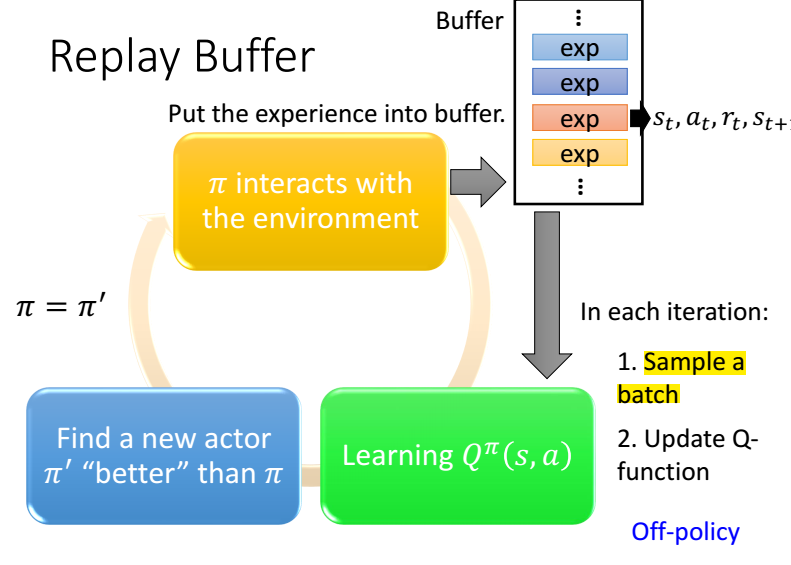

3.3 Replay Buffer

我们将历史数据存到Buffer里,然后训练的时候随机选一批,还要定期更新Buffer

3.4 完整算法

4 QLeaning 进阶

参考:

链接:https://www.zhihu.com/question/49787932/answer/124727629

https://www.youtube.com/watch?v=2-zGCx4iv_k&list=PLJV_el3uVTsODxQFgzMzPLa16h6B8kWM_&index=4

强化学习--QLearning的更多相关文章

- 强化学习 - Q-learning Sarsa 和 DQN 的理解

本文用于基本入门理解. 强化学习的基本理论 : R, S, A 这些就不说了. 先设想两个场景: 一. 1个 5x5 的 格子图, 里面有一个目标点, 2个死亡点二. 一个迷宫, 一个出发点, ...

- 强化学习Q-Learning算法详解

python风控评分卡建模和风控常识(博客主亲自录制视频教程) https://study.163.com/course/introduction.htm?courseId=1005214003&am ...

- 强化学习-Q-Learning算法

1. 前言 Q-Learning算法也是时序差分算法的一种,和我们前面介绍的SARAS不同的是,SARSA算法遵从了交互序列,根据当前的真实行动进行价值估计:Q-Learning算法没有遵循交互序列, ...

- 深度学习之强化学习Q-Learning

1.知识点 """ 1.强化学习:学习系统没有像很多其他形式的机器学习方法一样被告知应该做什么行为, 必须在尝试之后才能发现哪些行为会导致奖励的最大化,当前的行为可能不仅 ...

- 强化学习——Q-learning算法

假设有这样的房间 如果将房间表示成点,然后用房间之间的连通关系表示成线,如下图所示: 这就是房间对应的图.我们首先将agent(机器人)处于任何一个位置,让他自己走动,直到走到5房 ...

- 强化学习-Q-learning学习笔记

Q学习动作探索策略中的ep-greepy,以ep的概率进行随机探索,以1-ep的概率以最大值策略进行开发,因为设定的迭代次数比较多,所以肯定存在一定的次数去搜索不同的动作. 1)Python版本 b站 ...

- 强化学习之Q-learning简介

https://blog.csdn.net/Young_Gy/article/details/73485518 强化学习在alphago中大放异彩,本文将简要介绍强化学习的一种q-learning.先 ...

- 强化学习之QLearning

注:以下第一段代码是 文章 提供的代码,但是简书的代码粘贴下来不换行,所以我在这里贴了一遍.其原理在原文中也说得很明白了. 算个旅行商问题 基本介绍 戳 代码解释与来源 代码整个计算过程使用的以下公式 ...

- (译) 强化学习 第一部分:Q-Learning 以及相关探索

(译) 强化学习 第一部分:Q-Learning 以及相关探索 Q-Learning review: Q-Learning 的基础要点是:有一个关于环境状态S的表达式,这些状态中可能的动作 a,然后你 ...

随机推荐

- [administrator][driver] driverctl 是如何在udev上层管理设备驱动的

https://gitlab.com/driverctl/driverctl driverctl 处于 kernel 与 udev做设备与驱动管理的上层. 理解什么叫override是本文的核心内容. ...

- [daily][CentOS][SELinux]用key免登陆不成功,原来是SElinux在搞事情

为了提高效率,一般情况下,会把公钥放到sshd主机的 $HOME/.ssh/authorized_keys 文件内. 把私钥放在client的 $HOME/.ssh/ 下. 然后就可以免密登录了.然而 ...

- 转:ArcGIS API for JavaScript之图层

参考文章地址: https://developers.arcgis.com/javascript/3/jsapi/layer-amd.html Layer |–TiledMapServiceLayer ...

- 原生js获取到页面上所有的checkbox

<!DOCTYPE html><html lang="en"> <head> <meta charset="UTF-8" ...

- Mysql 数据库几种引擎的区别比较

· MyISAM:默认的MySQL插件式存储引擎,它是在Web.数据仓储和其他应用环境下最常使用的存储引擎之一.注意,通过更改STORAGE_ENGINE配置变量,能够方便地更改MySQL服务器的默认 ...

- Centos安装elasticsearch教程

elasticsearch安装是ytkah在做laravel电商站内搜索要实现的,通过自己的搜索和学习能力不算很费力解决了.下面就整理一下安装elasticsearch教程,服务器是Centos 7, ...

- MySQL复制异常大扫盲:快速溯源与排查错误全解

MySQL复制异常大扫盲:快速溯源与排查错误全解https://mp.weixin.qq.com/s/0Ic8BnUokyOj7m1YOrk1tA 作者介绍王松磊,现任职于UCloud,从事MySQL ...

- what's the python之异常处理

what's the 异常 python程序中会出现异常,即bug.若出现异常程序就报错,异常之后的代码就不会继续往下执行,这是一个正常程序不允许出现的,但是在某些程序交互的时候难免会因为用户输入问题 ...

- xshell帮助

查看内置命令 $help Internal Commands:new: Creates a new session.open: Opens a session or the session dialo ...

- python变量交换及注释种类,注释注意事项/注释排查方法

#小练习作业 # texe1 = '能提笔安天下' # print(texe1) # string1 = '武能上' # string2 = '定乾坤' # print(string1,string2 ...