hadoop的三大组件安装

安装过程分3步走: 1.安装namenode主机一台; 2.安装datanode主机三台; 3.启用集群的三大组件: HDFS,Mapreduce,Yarn.

重要的事情: 新建的虚拟机,预备安装hadoop的disk必须扩容到至少20G,否则后面集群起不来.如果遗漏,请重启主机和服务,扩容才会生效.

一, 安装namenode主机一台,命名主机名称为nn1

1. 配置主机名为nn01,ip为192.168.1.60,配置yum源

[root@nn1 ~]# vim /etc/yum.repos.d/local.repo

[local_repo]

name=CentOS

baseurl="ftp://192.168.1.254/centos-1804"

enabled=1

gpgcheck=1

2. 安装java环境

[root@nn1 ~]# yum -y install java-1.8.0-openjdk-devel

[root@nn1 ~]# java -version

openjdk version "1.8.0_161"

OpenJDK Runtime Environment (build 1.8.0_161-b14)

OpenJDK 64-Bit Server VM (build 25.161-b14, mixed mode)

[root@nn1 ~]# jps (java process show)

754 Jps

3. 安装hadoop

[root@room 04]#rsync -aHS hadoop root@192.168.1.60:/root/ #真机上传安装文件

[root@nn1 ~]# cd /hadoop

[root@nn1 hadoop]# ls

hadoop-2.7.7.tar.gz kafka_2.12-2.1.0.tgz zookeeper-3.4.13.tar.gz

[root@nn1 hadoop]# tar -xf hadoop-2.7.7.tar.gz

[root@nn1 hadoop]# mv hadoop-2.7.7 /usr/local/hadoop

[root@nn1 hadoop]# ls /usr/local/hadoop

LICENSE.txt NOTICE.txt README.txt bin etc include lib libexec sbin share

[root@nn1 hadoop]# cd /usr/local/hadoop

[root@nn1 hadoop]# ./bin/hadoop

Error: JAVA_HOME is not set and could not be found. #报错java程序没有找到

4. 解决java报错问题

[root@nn1 hadoop]# rpm -ql java-1.8.0-openjdk

[root@nn1 hadoop]# cd ./etc/hadoop

[root@nn1 hadoop]# vim hadoop-env.sh

export JAVA_HOME="/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.161-2.b14.el7.x86_64/jre/" #更改java程序调用路径

export HADOOP_CONF_DIR="/usr/local/hadoop/etc/hadoop" #hadoop调用路径

[root@nn1 hadoop]# cd /usr/local/hadoop

[root@nn1 hadoop]# ./bin/hadoop

5. 测试-词频

[root@nn1 hadoop]#mkdir /usr/local/hadoop/input

[root@nn1 hadoop]#cp *.txt /usr/local/hadoop/input

[root@nn1 hadoop]#./bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.7.jar wordcount input output #wordcount统计input文件夹的词频,输出到文件夹output

[root@nn1 hadoop]#cat output/part-r-00000 #查看

二, 环境准备

1. 三台机器配置主机名为dn1,dn2,dn3,配置ip地址,yum源

2. 编辑/etc/hosts(四台主机同样操作,以nn1为例,修改后,任意主机之间可以ping通)

[root@nn1 hadoop]# vim /etc/hosts

# ::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

192.168.1.60 nn1

192.168.1.61 dn1

192.168.1.62 dn2

192.168.1.63 dn3

3. 布置SSH信任关系

[root@nn1 ~]# ssh-keygen -f /root/.ssh/id_rsa -N ''

[root@nn1 ~]# for i in {60..63}

> do

> ssh-copy-id 192.168.1.$i

> done

4. 在dn1,dn2,dn3上面安装java环境

[root@dn1 ~]# yum -y install java-1.8.0-openjdk-devel

[root@dn2 ~]# yum -y install java-1.8.0-openjdk-devel

[root@dn3 ~]# yum -y install java-1.8.0-openjdk-devel

三, 部署hadoop

1. 修改slaves文件

[root@nn1 ~]# vim /usr/local/hadoop/etc/hadoop/slaves

dn1

dn2

dn3

2. hadoop的核心配置文件core-site

[root@nn1 ~]# cd /usr/local/hadoop/etc/hadoop/

[root@nn1 hadoop]# vim core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name> #name标记里面的参数来自https://hadoop.apache.org/docs/r3.2.0/,不可更改.

<value>hdfs://nn1:9000</value> #nn1为namenode主机名

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/var/hadoop</value> #hadoop数据根目录

</property>

</configuration>

[root@nn1 hadoop]# mkdir /var/hadoop #创建hadoop的数据根目录

3. 配置hdfs-site文件

[root@nn1 hadoop]# vim hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.http-address</name>

<value>nn1:50070</value> #namenode及端口

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>nn1:50090</value> #secondary namenode的端口50090

</property>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

</configuration>

4. 同步namenode的/usr/local/hadoop/ 配置到dn1,dn2,dn3.

[root@nn1 hadoop]# for i in {61..63}

> do

> rsync -aSH --delete /usr/local/hadoop 192.168.1.$i:/usr/local/hadoop/ -e 'ssh' &

> done

[1] 23733

[2] 23734

[3] 23735

5. 格式化

[root@nn1 hadoop]# cd /usr/local/hadoop/

[root@nn1 hadoop]# ./bin/hdfs namenode -format

6. 启动集群,并查看状态

[root@nn1 hadoop]# ./sbin/start-dfs.sh

Starting namenodes on [nn1]

nn1: namenode running as process 23891. Stop it first.

dn1: starting datanode, logging to /usr/local/hadoop/logs/hadoop-root-datanode-dn1.out

dn3: starting datanode, logging to /usr/local/hadoop/logs/hadoop-root-datanode-dn3.out

dn2: starting datanode, logging to /usr/local/hadoop/logs/hadoop-root-datanode-dn2.out

Starting secondary namenodes [nn1]

nn1: secondarynamenode running as process 24074. Stop it first.

[root@nn1 hadoop]# jps

23891 NameNode

24074 SecondaryNameNode

24543 Jps

[root@nn1 hadoop]# ./bin/hdfs dfsadmin -report

Live datanodes (3): #出现3个节点,就意味着dfs集群启用成功

四, 配置mapred-site

[root@nn1 hadoop]# cd /usr/local/hadoop/etc/hadoop/

[root@nn1 hadoop]# mv mapred-site.xml.template mapred-site.xml

[root@nn1 hadoop]# vim mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

五, 配置yarn-site

[root@nn1 hadoop]# vim yarn-site.xml

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>nn1</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

六, 同步mapred-site和yarn-site的配置内容到dn1,dn2,dn3

[root@nn1 hadoop]# for i in {61..63}

> do

> rsync -aSH --delete /usr/local/hadoop/ 192.168.1.$i:/usr/local/hadoop/ -e 'ssh' &

> done

[1] 1202

[2] 1203

[3] 1204

七, 验证配置

[root@nn1 hadoop]# cd /usr/local/hadoop

[root@nn1 hadoop]# ./sbin/start-dfs.sh

[root@nn1 hadoop]# ./sbin/start-yarn.sh

[root@nn1 hadoop]# jps #nn1查看有ResourceManager

994 SecondaryNameNode

805 NameNode

1532 ResourceManager

1791 Jps

[root@dn1 ~]# jps #dn1查看有NodeManager

932 Jps

830 NodeManager

687 DataNode

[root@dn2 ~]# jps #dn2查看有NodeManager

833 NodeManager

690 DataNode

935 Jps

[root@dn3 ~]# jps #dn3查看有NodeManager

931 Jps

828 NodeManager

686 DataNode

[root@nn1 hadoop]# ./bin/yarn node -list #验证服务

19/07/20 11:52:14 INFO client.RMProxy: Connecting to ResourceManager at nn1/192.168.1.60:8032

Total Nodes:3

Node-Id Node-State Node-Http-Address Number-of-Running-Containers

dn2:43088 RUNNING dn2:8042 0

dn3:32790 RUNNING dn3:8042 0

dn1:33836 RUNNING dn1:8042 0

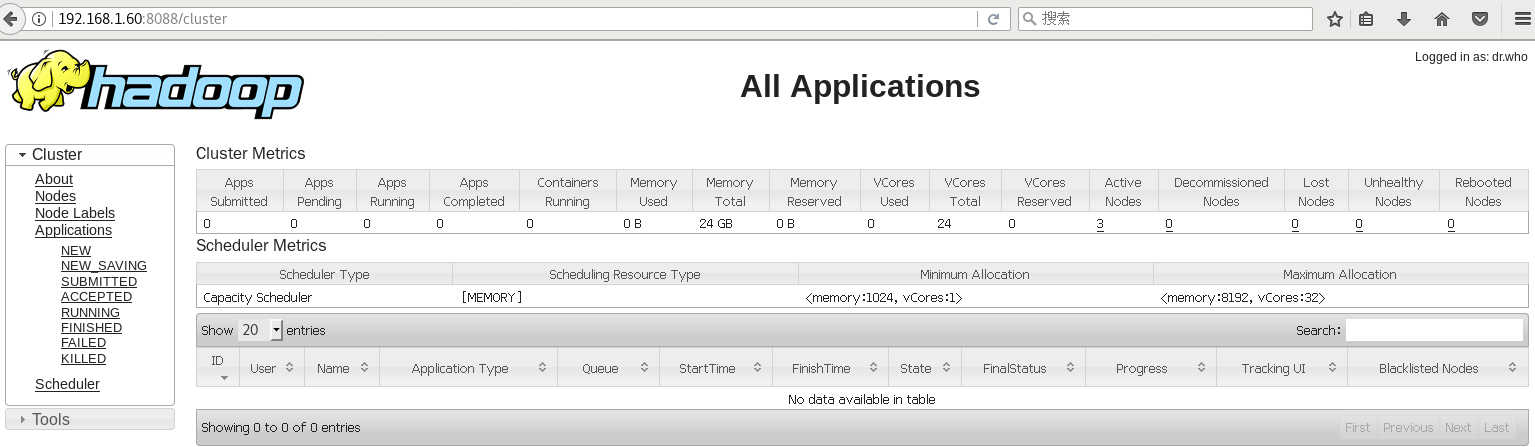

八, 从浏览器访问hadoop

namenode nn1的web页面: http://192.168.1.60:50070/

secondory namenode nn1的web页面: http://192.168.1.60:50090/

datanode dn1的web页面: http://192.168.1.61:50075/

datanode dn2的web页面: http://192.168.1.62:50075/

datanode dn3的web页面: http://192.168.1.62:50075/

resourcemanager nn1的web页面: http://192.168.1.60:8088/

nodemanager dn1的web页面: http://192.168.1.61:8042/

nodemanager dn2的web页面: http://192.168.1.62:8042/

nodemanager dn3的web页面: http://192.168.1.63:8042/

结束.

hadoop的三大组件安装的更多相关文章

- hadoop伪分布式组件安装

一.版本建议 Centos V7.5 Java V1.8 Hadoop V2.7.6 Hive V2.3.3 Mysql V5.7 Spark V2.3 Scala V2.12.6 Flume V1. ...

- 【大数据技术】Hadoop三大组件架构原理(HDFS-YARN-MapReduce)

目前,Hadoop还只是数据仓库产品的一个补充,和数据仓库一起构建混搭架构为上层应用联合提供服务. Hadoop集群具体来说包含两个集群:HDFS集群和YARN集群,两者逻辑上分离,但物理上常在一起. ...

- Hadoop3.x 三大组件详解

Hadoop Hadoop适合海量数据分布式存储和分布式计算 运行用户使用简单的编程模型实现跨机器集群对海量数据进行分布式计算处理 1. 概述 1.1 简介 Hadoop核心组件 HDFS (分布式文 ...

- Hadoop 发行版本 Hortonworks 安装详解(一) 准备工作

一.前言 目前Hadoop发行版非常多,所有这些发行版均是基于Apache Hadoop衍生出来的,之所以有这么多的版本,完全是由Apache Hadoop的开源协议决定的:任何人可以对其进行修改,并 ...

- Hadoop生态圈-使用FreeIPA安装Kerberos和LDAP

Hadoop生态圈-使用FreeIPA安装Kerberos和LDAP 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 有些大数据平台只是简单地通过防火墙来解决他们的网络安全问题.十分 ...

- MapReduce(二)常用三大组件

mapreduce三大组件:Combiner\Sort\Partitioner 默认组件:排序,分区(不设置,系统有默认值) 一.mapreduce中的Combiner 1.什么是combiner C ...

- Apache Hadoop集群离线安装部署(一)——Hadoop(HDFS、YARN、MR)安装

虽然我已经装了个Cloudera的CDH集群(教程详见:http://www.cnblogs.com/pojishou/p/6267616.html),但实在太吃内存了,而且给定的组件版本是不可选的, ...

- 【Hadoop】ZooKeeper组件

目录 一.配置时间同步 二.部署zookeeper(master节点) 1.使用xftp上传软件包至~ 2.解压安装包 3.创建 data 和 logs 文件夹 4.写入该节点的标识编号 5.修改配置 ...

- Flume 组件安装配置

下载和解压 Flume 实验环境可能需要回至第四,五,六章(hadoop和hive),否则后面传输数据可能报错(猜测)! 可 以 从 官 网 下 载 Flume 组 件 安 装 包 , 下 载 地 址 ...

随机推荐

- vue组件化初体验 全局组件和局部组件

vue组件化初体验 全局组件和局部组件 vue组件化 全局组件 局部组件 关于vue入门案例请参阅 https://www.cnblogs.com/singledogpro/p/11938222.h ...

- C# 强命名程序集,防止dll被修改,混淆下发布

未能加载文件或程序集“Jonckers.Service.RedisCacheEngineExtend, Version=1.0.0.0, Culture=neutral, PublicKeyToken ...

- 半硬化树脂PP的型号

1080是PP半固化胶片的型号(perperg),还有7628,2116,2113,2112,1506等等型号,每种型号不一样代表其PP内部的玻纤布不一样,比如7628的玻纤布相对较粗.数值较小则玻纤 ...

- Could not parse configuration: /hibernate.cfg.xml

hibernate需要联网验证dtd,错误原因:未联网或网速不行

- 浏览器端-W3School-HTML:HTML DOM Meta 对象

ylbtech-浏览器端-W3School-HTML:HTML DOM Meta 对象 1.返回顶部 1. HTML DOM Meta 对象 Meta 对象 Meta 对象代表 HTML 的 一个 & ...

- [flask]jinjia2处理表单-实现搜索界面

思路: 通过flask-wtf创建forms表单类 在app.py中创建search_name()视图函数,实例化form表单类,将通过render_template将form传给html模板 创建h ...

- ControlTemplate in WPF —— DatePicker

<ResourceDictionary xmlns="http://schemas.microsoft.com/winfx/2006/xaml/presentation" x ...

- ControlTemplate in WPF —— Shared in all file

<ResourceDictionary xmlns="http://schemas.microsoft.com/winfx/2006/xaml/presentation" x ...

- python学习笔记:(十五)迭代器和生成器

一.迭代器: 1.迭代器是python最强大的功能之一,是访问集合元素的一种方式. 2.迭代器是一个可以记住遍历的位置的对象. 3.迭代器对象从集合的第一个元素开始访问,直到所有的元素被访问结束.迭代 ...

- 关于 if __name__ == '__main__':的使用

当是用 if __name__ == '__main__': 时,下面调用函数只是在当前脚本调试, 而我们需要在别处导入这个脚本中的类或者函数时,这个if __name__ == '__main__ ...