论文解读(DCRN)《Deep Graph Clustering via Dual Correlation Reduction》

论文信息

论文标题:Deep Graph Clustering via Dual Correlation Reduction

论文作者:Yue Liu, Wenxuan Tu, Sihang Zhou, Xinwang Liu, Linxuan Song, Xihong Yang, En Zhu

论文来源:2022, AAAI

论文地址:download

论文代码:download

1 介绍

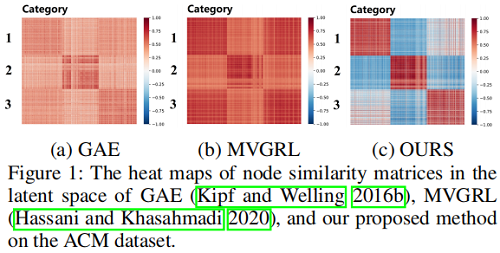

表示崩塌问题:倾向于将所有数据映射到相同表示。

2 方法

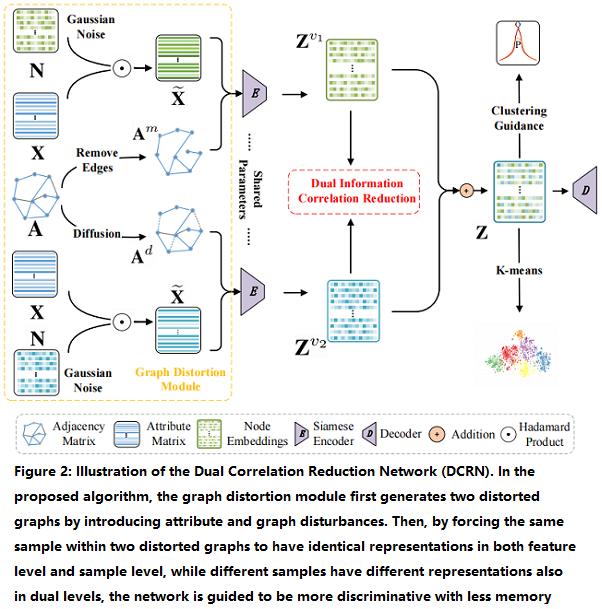

2.1 整体框架

该框架包括两个模块:

- a graph distortion module;

- a dual information correlation reduction (DICR) module;

2.2 相关定义

$\widetilde{\mathbf{A}}=\mathbf{D}^{-1}(\mathbf{A}+\mathbf{I})\quad\quad \text{and} \quad\quad \widetilde{\mathbf{A}} \in \mathbb{R}^{N \times N} $

2.3 Graph Distortion Module

Feature Corruption:

首先从高斯分布矩阵 $ \mathcal{N}(1,0.1)$ 采样一个随机噪声矩阵 $\mathbf{N} \in \mathbb{R}^{N \times D} $,然后得到破坏后的属性矩阵 $\widetilde{\mathbf{X}} \in \mathbb{R}^{N \times D}$ :

$\widetilde{\mathbf{X}}=\mathbf{X} \odot \mathbf{N} \quad\quad\quad(1)$

Edge Perturbation:

- similarity-based edge removing

根据表示的余弦相似性先计算一个相似性矩阵,然后根据相似性矩阵种的值小于 $0.1$ 将其置 $0$ 来构造掩码矩阵(masked matrix)$\mathbf{M} \in \mathbb{R}^{N \times N}$。对采用掩码矩阵处理的邻接矩阵做标准化:

$\mathbf{A}^{m}=\mathbf{D}^{-\frac{1}{2}}((\mathbf{A} \odot \mathbf{M})+\mathbf{I}) \mathbf{D}^{-\frac{1}{2}}\quad\quad\quad(2)$

- graph diffusion

$\mathbf{A}^{d}=\alpha\left(\mathbf{I}-(1-\alpha)\left(\mathbf{D}^{-\frac{1}{2}}(\mathbf{A}+\mathbf{I}) \mathbf{D}^{-\frac{1}{2}}\right)\right)^{-1}\quad\quad\quad(3)$

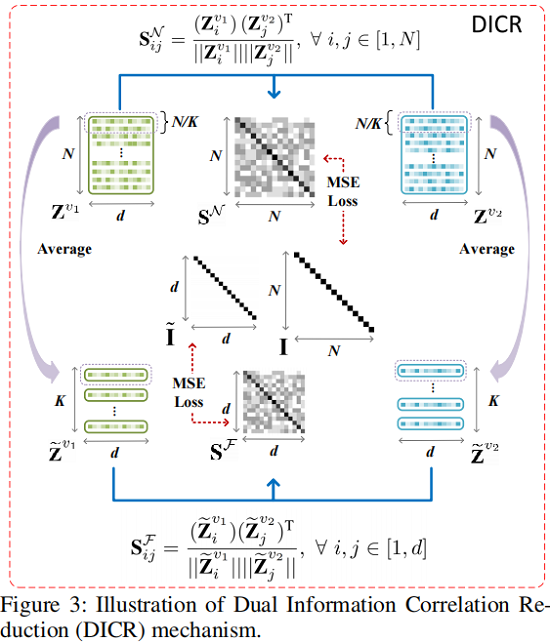

2.4 Dual Information Correlation Reduction

框架如下:

Sample-level Correlation Reduction

对于由 siamese graph encoder 学习到的双视图节点嵌入 $ \mathbf{Z}^{v_{1}} $ 和 $\mathbf{Z}^{v_{2}} $,我们首先通过以下方法计算交叉视图样本相关性矩阵$\mathbf{S}^{\mathcal{N}} \in \mathbb{R}^{N \times N}$ :

${\large \mathbf{S}_{i j}^{\mathcal{N}}=\frac{\left(\mathbf{Z}_{i}^{v_{1}}\right)\left(\mathbf{Z}_{j}^{v_{2}}\right)^{\mathrm{T}}}{\left\|\mathbf{Z}_{i}^{v_{1}}\right\|\left\|\mathbf{Z}_{j}^{v_{2}}\right\|}} , \forall i, j \in[1, N]\quad\quad\quad(4)$

其中:$\mathbf{S}_{i j}^{\mathcal{N}} \in[-1,1] $ 表示第一个视图中第 $i$ 个节点嵌入与第二个视图中第 $j$ 个节点嵌入的余弦相似度。

然后利用 $\mathbf{S}^{\mathcal{N}}$ 计算:

$\begin{aligned}\mathcal{L}_{N} &=\frac{1}{N^{2}} \sum\limits^{N}\left(\mathbf{S}^{\mathcal{N}}-\mathbf{I}\right)^{2} \\&=\frac{1}{N} \sum\limits_{i=1}^{N}\left(\mathbf{S}_{i i}^{\mathcal{N}}-1\right)^{2}+\frac{1}{N^{2}-N} \sum\limits_{i=1}^{N} \sum\limits_{j \neq i}\left(\mathbf{S}_{i j}^{\mathcal{N}}\right)^{2}\end{aligned}\quad\quad\quad(5)$

$\mathcal{L}_{N}$ 的第一项鼓励 $\mathbf{S}^{\mathcal{N}}$ 中的对角线元素等于 $1$,这表明希望两个视图的节点表示一致性高。第二项使 $\mathbf{S}^{\mathcal{N}}$ 中的非对角线元素等于 $0$,以最小化在两个视图中不同节点的嵌入之间的一致性。这种去相关操作可以帮助我们的网络减少潜在空间中节点之间的冗余信息,从而使学习到的嵌入更具鉴别性。

Feature-level Correlation Reduction

首先,我们使用读出函数 $\mathcal{R}(\cdot): \mathbb{R}^{d \times N} \rightarrow \mathbb{R}^{d \times K}$ 将双视图节点嵌入 $\mathbf{Z}^{v_{1}}$ 和 $\mathbf{Z}^{v_{2}} $ 分别投影到 $\widetilde{\mathbf{Z}}^{v_{1}} $ 和 $\widetilde{\mathbf{Z}}^{v_{2}} \in \mathbb{R}^{d \times K}$ 中,该过程公式化为:

$\widetilde{\mathbf{Z}}^{v_{k}}=\mathcal{R}\left(\left(\mathbf{Z}^{v_{k}}\right)^{\mathrm{T}}\right)\quad\quad\quad(6)$

同样此时计算 $\widetilde{\mathbf{Z}}^{v_{1}} $ 和 $\widetilde{\mathbf{Z}}^{v_{2}}$ 之间的相似性:

${\large \mathbf{S}_{i j}^{\mathcal{F}}=\frac{\left(\widetilde{\mathbf{Z}}_{i}^{v_{1}}\right)\left(\widetilde{\mathbf{Z}}_{j}^{v_{2}}\right)^{\mathrm{T}}}{\left\|\widetilde{\mathbf{Z}}_{i}^{v_{1}}\right\|\left\|\widetilde{\mathbf{Z}}_{j}^{v_{2}}\right\|}} , \forall i, j \in[1, d]\quad\quad\quad(7)$

然后利用 $\mathbf{S}^{\mathcal{F}}$ 计算:

$\begin{aligned}\mathcal{L}_{F} &=\frac{1}{d^{2}} \sum\limits^{\mathcal{S}}\left(\mathbf{S}^{\mathcal{F}}-\widetilde{\mathbf{I}}\right)^{2} \\&=\frac{1}{d^{2}} \sum\limits_{i=1}^{d}\left(\mathbf{S}_{i i}^{\mathcal{F}}-1\right)^{2}+\frac{1}{d^{2}-d} \sum\limits_{i=1}^{d} \sum\limits_{j \neq i}\left(\mathbf{S}_{i j}^{\mathcal{F}}\right)^{2}\end{aligned}\quad\quad\quad(8)$

下一步将两个视图的表示合并得:

$\mathbf{Z}=\frac{1}{2}\left(\mathbf{Z}^{v_{1}}+\mathbf{Z}^{v_{2}}\right)\quad\quad\quad(9)$

上述所提出的 DICR 机制从样本视角和特征水平的角度都考虑了相关性的降低。这样,可以过滤冗余特征,在潜在空间中保留更明显的特征,从而学习有意义的表示,避免崩溃,提高聚类性能。

为了缓解网络训练过程中出现的过平滑现象,我们引入了一种传播正则化方法,即:

$\mathcal{L}_{R}=J S D(\mathbf{Z}, \tilde{\mathbf{A}} \mathbf{Z})\quad\quad\quad(10)$

综上 DICR ,模块的目标函数为:

$\mathcal{L}_{D I C R}=\mathcal{L}_{N}+\mathcal{L}_{F}+\gamma \mathcal{L}_{R}\quad\quad\quad(11)$

2.5 目标函数

总损失函数如下:

$\mathcal{L}=\mathcal{L}_{D I C R}+\mathcal{L}_{R E C}+\lambda \mathcal{L}_{K L}\quad\quad\quad(12)$

分别代表着 DICR的损失$\mathcal{L}_{D I C R}$、重建损失$\mathcal{L}_{R E C}$ 和聚类损失 $ \mathcal{L}_{K L}$。

后面两个损失参考 DFCN。

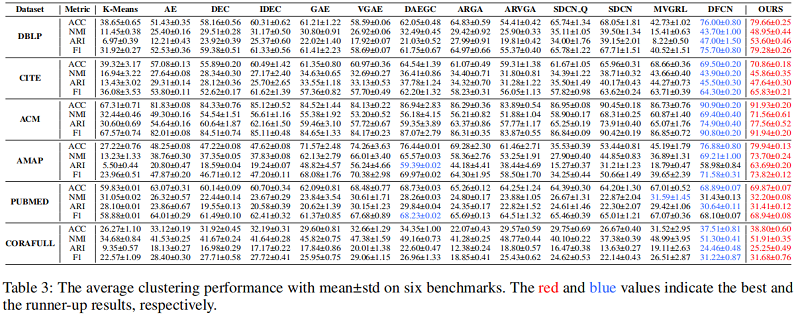

3 实验

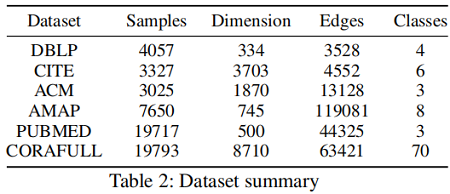

数据集:

基线实验:

4 结论

在这项工作中,我们提出了一种新的自监督深度图聚类网络,称为双相关减少网络(DCRN)。在我们的模型中,引入了一种精心设计的双信息相关减少机制来降低样本和特征水平上的信息相关性。利用这种机制,可以过滤掉两个视图中潜在变量的冗余信息,可以很好地保留两个视图的更鉴别特征。它在避免表示崩溃以实现更好的聚类方面起着重要的作用。在6个基准测试上的实验结果证明了DCRN的优越性。

论文解读(DCRN)《Deep Graph Clustering via Dual Correlation Reduction》的更多相关文章

- 论文解读(GMIM)《Deep Graph Clustering via Mutual Information Maximization and Mixture Model》

论文信息 论文标题:Deep Graph Clustering via Mutual Information Maximization and Mixture Model论文作者:Maedeh Ahm ...

- 论文解读《Deep Attention-guided Graph Clustering with Dual Self-supervision》

论文信息 论文标题:Deep Attention-guided Graph Clustering with Dual Self-supervision论文作者:Zhihao Peng, Hui Liu ...

- 论文解读《Bilinear Graph Neural Network with Neighbor Interactions》

论文信息 论文标题:Bilinear Graph Neural Network with Neighbor Interactions论文作者:Hongmin Zhu, Fuli Feng, Xiang ...

- 论文解读《Deep Resdual Learning for Image Recognition》

总的来说这篇论文提出了ResNet架构,让训练非常深的神经网络(NN)成为了可能. 什么是残差? "残差在数理统计中是指实际观察值与估计值(拟合值)之间的差."如果回归模型正确的话 ...

- 论文解读《Deep Plug-and-Play Super-Resolution for Arbitrary Blur Kernel》

Deep Plug-and-Play Super-Resolution for Arbitrary Blur Kernels: 一旦退化模型被定义,下一步就是使用公式表示能量函数(energy fun ...

- 论文解读《Cauchy Graph Embedding》

Paper Information Title:Cauchy Graph EmbeddingAuthors:Dijun Luo, C. Ding, F. Nie, Heng HuangSources: ...

- 论文解读(AGC)《Attributed Graph Clustering via Adaptive Graph Convolution》

论文信息 论文标题:Attributed Graph Clustering via Adaptive Graph Convolution论文作者:Xiaotong Zhang, Han Liu, Qi ...

- 论文解读(DGI)《DEEP GRAPH INFOMAX》

论文标题:DEEP GRAPH INFOMAX 论文方向:图像领域 论文来源:2019 ICLR 论文链接:https://arxiv.org/abs/1809.10341 论文代码:https:// ...

- 论文解读(GRACE)《Deep Graph Contrastive Representation Learning》

Paper Information 论文标题:Deep Graph Contrastive Representation Learning论文作者:Yanqiao Zhu, Yichen Xu, Fe ...

随机推荐

- 类型转换Java day8

类型转换自动类型转换 从同种类型的低字节类型值直接转换到高类型字节值的转换可自动转换 类型自动转换示例 byte a = 20; int b = a;//不报错可正常转换 有些类型它在计算时默认以指定 ...

- swap分区扩展的三种方法

redhat linux swap分区扩展的三种方法 2016-12-26 11:41:08 分类: LINUX 原文地址:redhat linux swap分区扩展的三种方法 作者:quanshen ...

- mock axios vue的数据传递关系

最近有一个项目要快速出一个前端demo,选择了vue-element框架(虽然其实很想用react,但是为了求快) 本人的基础只有初级的html/css/js知识,和python后端的一些简单工作,和 ...

- sqlserver下载地址及密匙

SqlServer 2017 下载地址及密钥 下载地址: ed2k://|file|cn_sql_server_2017_developer_x64_dvd_11296175.iso|17697771 ...

- Java并发机制(1)--线程状态与方法(转)

Java并发编程:Thread类的使用 个人总结:参考:博客园-海子-http://www.cnblogs.com/dolphin0520/p/3920357.html 参考:https://blog ...

- 服务端处理 Watcher 实现 ?

1.服务端接收 Watcher 并存储 接收到客户端请求,处理请求判断是否需要注册 Watcher,需要的话将数据节点 的节点路径和 ServerCnxn(ServerCnxn 代表一个客户端和服务端 ...

- 初识mybatis(为什么是mybatis?)

对原生态的 jdbc 中的问题总结 1.数据库连接,使用就创建,不使用立即释放,对数据库进行频繁连接开启和关闭,造成数据库资源浪费,影响数据库性能. 设想:使用数据库连接池管理数据库连接 2.将sql ...

- idea常见设置一

1.顶部执行栏调整 原: 设置:勾选view==>toolbar 后: 这个一看其实没有什么太大的作用,但是你看这个按钮 这个按钮就是File==>Settings,这样会稍微方便点,只要 ...

- k-medoids算法

k-medoids算法 对上面图形的解释 第一幅图:原来p属于Oj的(实线),当Orandom代替了Oj,p属于Oi了(虚线):第二幅图:原来p属于Oj的(实线),当Orandom代替了Oj,p属于O ...

- 还能这样?把 Python 自动翻译成 C++

作者:byronhe,腾讯 WXG 开发工程师 一.问题背景 随着深度学习的广泛应用,在搜索引擎/推荐系统/机器视觉等业务系统中,越来越多的深度学习模型部署到线上服务. 机器学习模型在离线训练时,一般 ...