【爬虫+情感判定+Top10高频词+词云图】“谷爱凌”热门弹幕python舆情分析

一、背景介绍

最近几天,谷爱凌在冬奥会赛场上夺得一枚宝贵的金牌,为中国队贡献了自己的荣誉!

针对此热门事件,我用Python的爬虫和情感分析技术,针对小破站的弹幕数据,分析了众网友弹幕的舆论导向,下面我们来看一下,是如何实现的分析过程。

二、代码讲解-爬虫部分

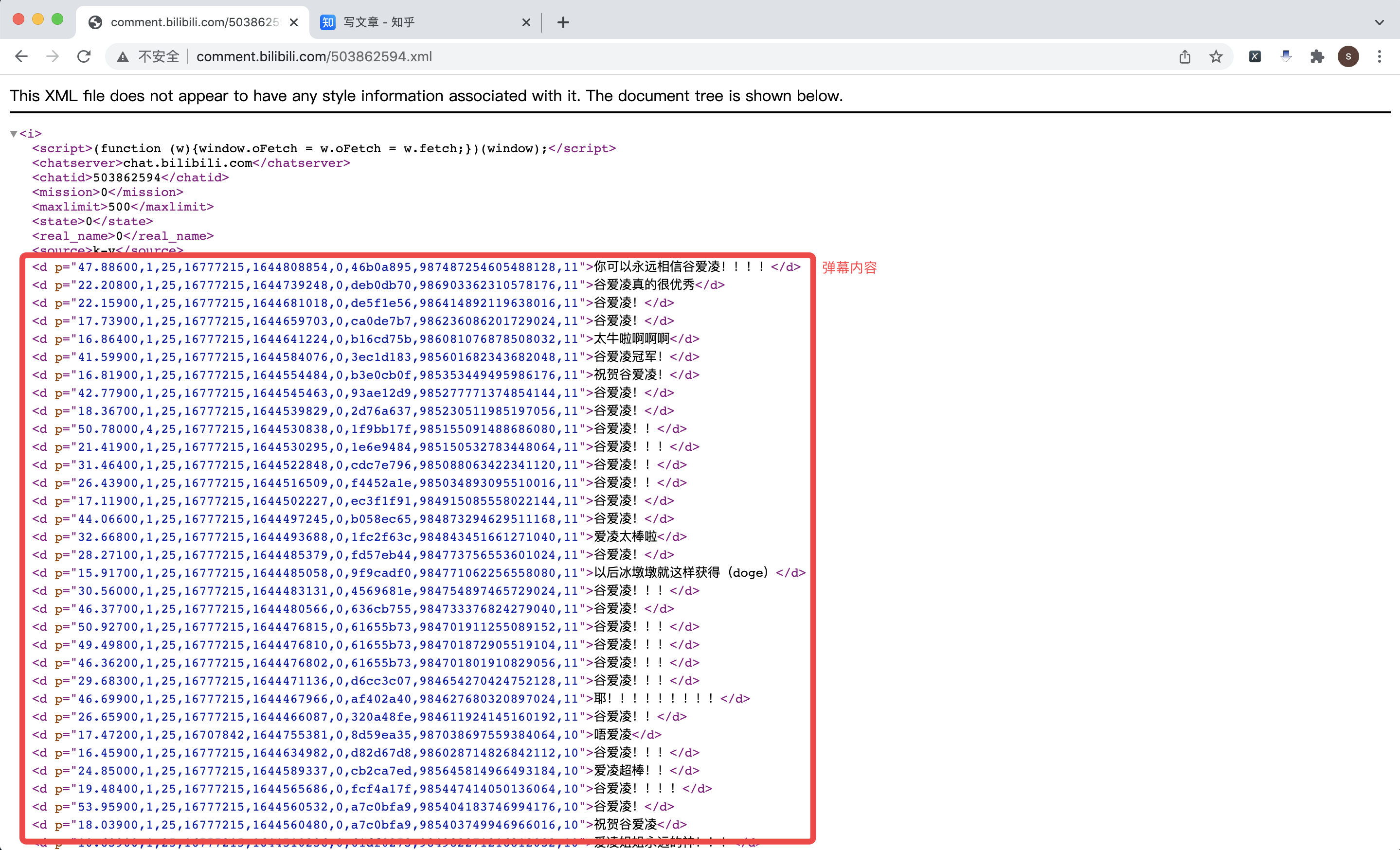

2.1 分析弹幕接口

首先分析B站弹幕接口。

经过分析,得到的弹幕地址有两种:

第一种:http://comment.bilibili.com/{cid}.xml

第二种:https://api.bilibili.com/x/v1/dm/list.so?oid={cid}

这两种返回的结果一致!但都不全,都是只有部分弹幕!

以视频 https://www.bilibili.com/video/BV1YY41157dk 为例,查看网页源代码,可以找到对应的cid为503862594,所以该视频对应的弹幕接口地址是:http://comment.bilibili.com/503862594.xml

既然这样,就好办了,开始撸代码!

2.2 讲解爬虫代码

首先,导入需要用到的库:

import re # 正则表达式提取文本

import requests # 爬虫发送请求

from bs4 import BeautifulSoup as BS # 爬虫解析页面

import time

import pandas as pd # 存入csv文件

import os

然后,向视频地址发送请求,解析出cid号:

r1 = requests.get(url=v_url, headers=headers)

html1 = r1.text

cid = re.findall('cid=(.*?)&aid=', html1)[0] # 获取视频对应的cid号

print('该视频的cid是:', cid)

根据cid号,拼出xml接口地址,并再次发送请求:

danmu_url = 'http://comment.bilibili.com/{}.xml'.format(cid) # 弹幕地址

print('弹幕地址是:', danmu_url)

r2 = requests.get(danmu_url)

解析xml页面:标签的文本内容为弹幕,标签内p属性值(按逗号分隔)的第四个字段是时间戳:

soup = BS(html2, 'xml')

danmu_list = soup.find_all('d')

print('共爬取到{}条弹幕'.format(len(danmu_list)))

video_url_list = [] # 视频地址

danmu_url_list = [] # 弹幕地址

time_list = [] # 弹幕时间

text_list = [] # 弹幕内容

for d in danmu_list:

data_split = d['p'].split(',') # 按逗号分隔

temp_time = time.localtime(int(data_split[4])) # 转换时间格式

danmu_time = time.strftime("%Y-%m-%d %H:%M:%S", temp_time)

video_url_list.append(v_url)

danmu_url_list.append(danmu_url)

time_list.append(danmu_time)

text_list.append(d.text)

print('{}:{}'.format(danmu_time, d.text))

保存时应注意,为了避免多次写入csv标题头,像这样:

这里,我写了一个处理逻辑,大家看注释,应该能明白:

if os.path.exists(v_result_file): # 如果文件存在,不需写入字段标题

header = None

else: # 如果文件不存在,说明是第一次新建文件,需写入字段标题

header = ['视频地址', '弹幕地址', '弹幕时间', '弹幕内容']

df.to_csv(v_result_file, encoding='utf_8_sig', mode='a+', index=False, header=header) # 数据保存到csv文件

三、代码讲解-情感分析部分

3.1 整体思路

针对情感分析需求,我主要做了三个步骤的分析工作:

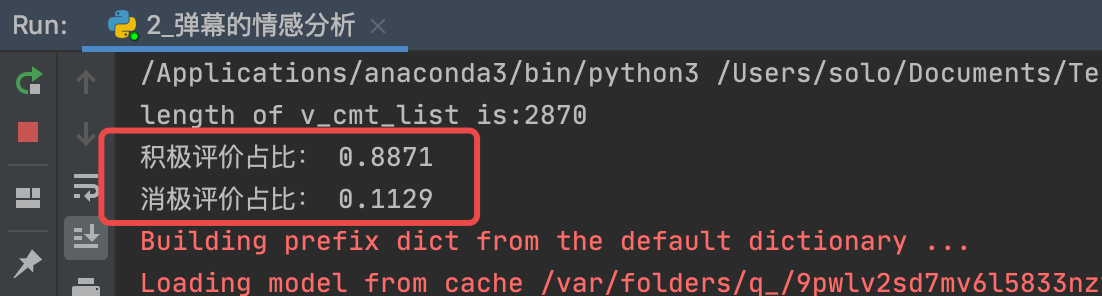

- 用SnowNLP给弹幕内容打标:积极、消极,并统计占比情况

- 用jieba.analyse分词,并统计top10高频词

- 用WordCloud绘制词云图

首先,导入csv数据,并做数据清洗工作,不再赘述。

下面,正式进入情感分析代码部分:

3.2 情感分析打标

情感分析计算得分值、分类打标,并统计积极/消极占比。

# 情感分析打标

def sentiment_analyse(v_cmt_list):

"""

情感分析打分

:param v_cmt_list: 需要处理的评论列表

:return:

"""

score_list = [] # 情感评分值

tag_list = [] # 打标分类结果

pos_count = 0 # 计数器-积极

neg_count = 0 # 计数器-消极

for comment in v_cmt_list:

tag = ''

sentiments_score = SnowNLP(comment).sentiments

if sentiments_score < 0.3:

tag = '消极'

neg_count += 1

else:

tag = '积极'

pos_count += 1

score_list.append(sentiments_score) # 得分值

tag_list.append(tag) # 判定结果

print('积极评价占比:', round(pos_count / (pos_count + neg_count), 4))

print('消极评价占比:', round(neg_count / (pos_count + neg_count), 4))

df['情感得分'] = score_list

df['分析结果'] = tag_list

# 把情感分析结果保存到excel文件

df.to_excel('谷爱凌_情感评分结果.xlsx', index=None)

print('情感分析结果已生成:谷爱凌_情感评分结果.xlsx')

这里,我设定情感得分值小于0.3为消极,否则为积极。(这个分界线,没有统一标准,根据数据分布情况和分析经验自己设定分界线即可)

占比结果:

打标结果:(最后两列,分别是得分值和打标结果)

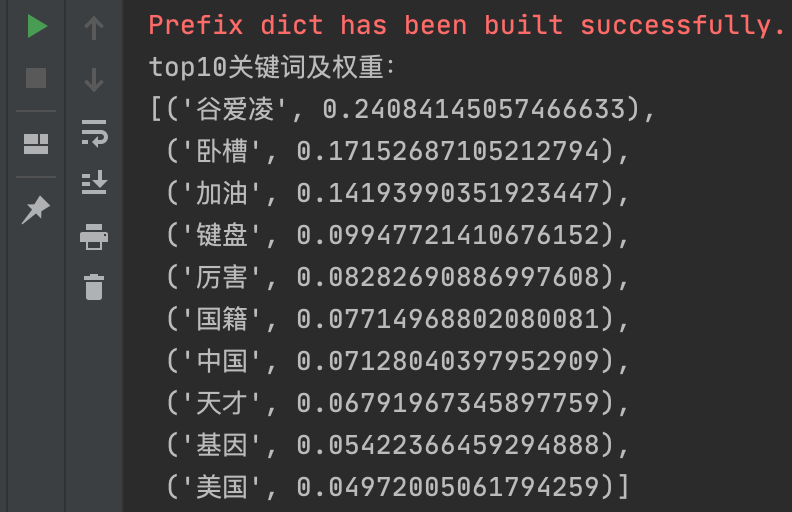

3.3 统计top10高频词

# 2、用jieba统计弹幕中的top10高频词

keywords_top10 = jieba.analyse.extract_tags(v_cmt_str, withWeight=True, topK=10)

print('top10关键词及权重:')

pprint(keywords_top10)

这里需要注意,在调用jieba.analyse.extract_tags函数时,要导入的是import jieba.analyse 而不是 import jieba

统计结果为:(分为10组关键词及其权重,权重按倒序排序)

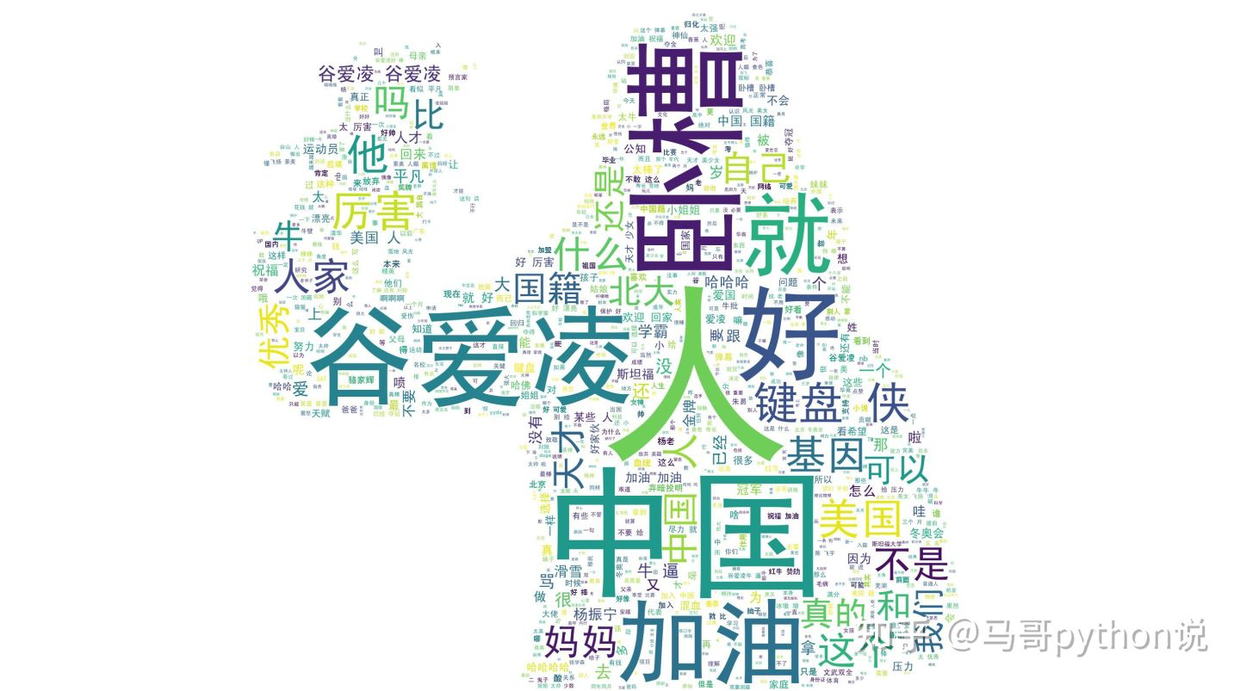

3.4 绘制词云图

注意别踩坑:

想要通过原始图片的形状生成词云图,原始图片一定要白色背景(实在没有的话,PS修图修一个吧),否则生成的是满屏词云!!

def make_wordcloud(v_str, v_stopwords, v_outfile):

"""

绘制词云图

:param v_str: 输入字符串

:param v_stopwords: 停用词

:param v_outfile: 输出文件

:return: None

"""

print('开始生成词云图:{}'.format(v_outfile))

try:

stopwords = v_stopwords # 停用词

backgroud_Image = np.array(Image.open('谷爱凌背景图.png')) # 读取背景图片

wc = WordCloud(

background_color="white", # 背景颜色

width=1500, # 图宽

height=1200, # 图高

max_words=1000, # 最多字数

font_path='/System/Library/Fonts/SimHei.ttf', # 字体文件路径,根据实际情况(Mac)替换

# font_path="C:\Windows\Fonts\simhei.ttf", # 字体文件路径,根据实际情况(Windows)替换

stopwords=stopwords, # 停用词

mask=backgroud_Image, # 背景图片

)

jieba_text = " ".join(jieba.lcut(v_str)) # jieba分词

wc.generate_from_text(jieba_text) # 生成词云图

wc.to_file(v_outfile) # 保存图片文件

print('词云文件保存成功:{}'.format(v_outfile))

except Exception as e:

print('make_wordcloud except: {}'.format(str(e)))

得到的词云图:

和原始背景图对比:

3.5 情感分析结论

- 打标结果中,积极评价占0.8871,远远大于消极评价!

- top10关键词统计结果中,"加油"、"厉害"、"天才"等好评词汇占据多数!

- 词云图中,"中国"、"好"、"厉害"、"卧槽"等好评词看上去更大(词频高)!

综上所述,经分析"谷爱凌"相关弹幕,得出结论:

众多网友对谷爱凌的评价都很高,也很喜欢她,毕竟不但年轻、颜值高、有才华,还能为祖国争得宝贵的荣誉!

致敬!!

四、同步讲解视频

上集:(爬虫采集)

https://www.zhihu.com/zvideo/1476299216318857217

下集:(情感分析)

https://www.zhihu.com/zvideo/1476300807759294464

by 马哥python说

【爬虫+情感判定+Top10高频词+词云图】“谷爱凌”热门弹幕python舆情分析的更多相关文章

- 【爬虫+情感判定+Top10高频词+词云图】“刘畊宏“热门弹幕python舆情分析

一.背景介绍 最近一段时间,刘畊宏真是火出了天际,引起一股全民健身的热潮,毕竟锻炼身体,是个好事! 针对此热门事件,我用Python的爬虫和情感分析技术,针对小破站的弹幕数据,分析了众多网友弹幕的舆论 ...

- 【爬虫+情感判定+Top10高频词+词云图】"王心凌"热门弹幕python舆情分析

目录 一.背景介绍 二.代码讲解-爬虫部分 2.1 分析弹幕接口 2.2 讲解爬虫代码 三.代码讲解-情感分析部分 3.1 整体思路 3.2 情感分析打标 3.3 统计top10高频词 3.4 绘制词 ...

- python爬虫之採集——360联想词W2版本号

http://blog.csdn.net/recsysml/article/details/30541197,我的这个博文介绍了对应的简单的方法做一个联想词的爬虫,并且还承诺了下面优化: 下一版本号的 ...

- python爬虫实践--求职Top10城市

前言 从智联招聘爬取相关信息后,我们关心的是如何对内容进行分析,获取用用的信息.本次以上篇文章“5分钟掌握智联招聘网站爬取并保存到MongoDB数据库”中爬取的数据为基础,分析关键词为“python” ...

- 孤荷凌寒自学python第八十天开始写Python的第一个爬虫10

孤荷凌寒自学python第八十天开始写Python的第一个爬虫10 (完整学习过程屏幕记录视频地址在文末) 原计划今天应当可以解决读取所有页的目录并转而取出所有新闻的功能,不过由于学习时间不够,只是进 ...

- 孤荷凌寒自学python第七十九天开始写Python的第一个爬虫9并使用pydocx模块将结果写入word文档

孤荷凌寒自学python第七十九天开始写Python的第一个爬虫9 (完整学习过程屏幕记录视频地址在文末) 今天在上一天的基础上继续完成对我的第一个代码程序的书写. 到今天终于完成了对docx模块针对 ...

- 孤荷凌寒自学python第七十八天开始写Python的第一个爬虫8

孤荷凌寒自学python第七十八天开始写Python的第一个爬虫8 (完整学习过程屏幕记录视频地址在文末) 今天在上一天的基础上继续完成对我的第一个代码程序的书写. 到今天止基本完成了对docx模块针 ...

- 孤荷凌寒自学python第七十七天开始写Python的第一个爬虫7

孤荷凌寒自学python第七十七天开始写Python的第一个爬虫7 (完整学习过程屏幕记录视频地址在文末) 今天在上一天的基础上继续完成对我的第一个代码程序的书写. 今天的学习仍然是在纯粹对docx模 ...

- 孤荷凌寒自学python第七十六天开始写Python的第一个爬虫6

孤荷凌寒自学python第七十六天开始写Python的第一个爬虫6 (完整学习过程屏幕记录视频地址在文末) 今天在上一天的基础上继续完成对我的第一个代码程序的书写. 不过由于对python-docx模 ...

随机推荐

- @Autowired 注解有什么用?

@Autowired 可以更准确地控制应该在何处以及如何进行自动装配.此注解用于在 setter 方法,构造函数,具有任意名称或多个参数的属性或方法上自动装配bean.默认情况下,它是类型驱动的注入. ...

- MySQL_fetch_array 和 MySQL_fetch_object 的区别是什么?

以下是 MySQL_fetch_array 和 MySQL_fetch_object 的区别: MySQL_fetch_array() – 将结果行作为关联数组或来自数据库的常规数组返回. MySQL ...

- MySQL 里记录货币用什么字段类型?

NUMERIC 和 DECIMAL 类型被 MySQL 实现为同样的类型,这在 SQL92 标准允 许.他们被用于保存值,该值的准确精度是极其重要的值,例如与金钱有关的数 据.当声明一个类是这些类型之 ...

- 什么是 UML?

UML 是统一建模语言(Unified Modeling Language)的缩写,它发表于 1997 年,综合了当时已经存在的面向对象的建模语言.方法和过程,是一个支持模型 化和软件系统开发的图形化 ...

- 学习zabbix(十)

Zabbix 3.0 基础介绍 [一] 一.Zabbix介绍 zabbix 简介 Zabbix 是一个高度集成的网络监控解决方案,可以提供企业级的开源分布式监控解决方案,由一个国外的团队持续维护更 ...

- 内网穿透系列-Go语言

一.介绍 软件在KCP出现后进行了重构,将其底层UDP支持替换为了KCP,使其效率大大提高,在某些恶劣的网络环境下依旧能有不错的效果.当然,它也是支持TCP模式的,另外它也是支持加密的,在P2P打洞失 ...

- 【Android开发】【布局】 仿QQ的UI

Demo地址

- PAT B1031查验身份证

一个合法的身份证号码由17位地区.日期编号和顺序编号加1位校验码组成.校验码的计算规则如下: 首先对前17位数字加权求和,权重分配为:{7,9,10,5,8,4,2,1,6,3,7,9,10,5,8, ...

- C++中的算法头文件<algorithm>,<numeric>和<functional>

算法部分主要由头文件<algorithm>,<numeric>和<functional>组成.<algorithm>是所有STL头文件中最大的一个,它是 ...

- JSTL详解(常用标签以及c:forEach遍历集合)

JSTL标签 一. JSTL的简介 1. 什么是JSTL 2. JSTL常用标签库 3. JSTL使用步骤 二. 核心标签库常用标签 1. c: set 标签 2. c: out 标签 3. c: i ...