Flink WordCount入门

下面通过一个单词统计的案例,快速上手应用 Flink,进行流处理(Streaming)和批处理(Batch)

单词统计(批处理)

- 引入依赖

<!--flink核心包-->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId>

<version>1.7.2</version>

</dependency>

<!--flink流处理包-->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_2.12</artifactId>

<version>1.7.2</version>

</dependency>

- 代码实现

public class WordCountBatch {

public static void main(String[] args) throws Exception {

String inputFile= "E:\\data\\word.txt";

String outPutFile= "E:\\data\\wordResult.txt";

ExecutionEnvironment executionEnvironment = ExecutionEnvironment.getExecutionEnvironment();

//1. 读取数据

DataSource<String> dataSource = executionEnvironment.readTextFile(inputFile);

//2. 对数据进行处理,转成word,1的格式

FlatMapOperator<String, Tuple2<String, Integer>> flatMapOperator = dataSource.flatMap(new FlatMapFunction<String, Tuple2<String, Integer>>() {

@Override

public void flatMap(String s, Collector<Tuple2<String, Integer>> collector) throws Exception {

String[] words = s.split(" ");

for (String word : words) {

collector.collect(new Tuple2<>(word, 1));

}

}

});

//3. 对数据分组,相同word的一个组

UnsortedGrouping<Tuple2<String, Integer>> tuple2UnsortedGrouping = flatMapOperator.groupBy(0);

//4. 对分组后的数据求和

AggregateOperator<Tuple2<String, Integer>> sum = tuple2UnsortedGrouping.sum(1);

//5. 写出数据

sum.writeAsCsv(outPutFile).setParallelism(1);

//执行

executionEnvironment.execute("wordcount batch process");

}

}

执行 main 方法,得出结果。我测试的 word.txt 内容如下:

ni hao hi

wang mei mei

liu mei

ni hao

wo hen hao

this is a good idea

Apache Flink

输出的文件结果:

a,1

mei,3

Apache,1

Flink,1

good,1

hen,1

hi,1

idea,1

ni,2

is,1

liu,1

this,1

wo,1

hao,3

wang,1

单词统计(流数据)

需求:Socket 模拟实时发送单词,使用 Flink 实时接收数据,对指定时间窗口内(如 5s)的数据进行聚合统计,每隔 1s 汇总计算一次,并且把时间窗口内计算结果打印出来

public class WordCountStream {

public static void main(String[] args) throws Exception {

int port = 7000;

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> textStream = executionEnvironment.socketTextStream("192.168.56.103", port, "\n");

SingleOutputStreamOperator<Tuple2<String, Integer>> tuple2SingleOutputStreamOperator = textStream.flatMap(new FlatMapFunction<String, Tuple2<String, Integer>>() {

@Override

public void flatMap(String s, Collector<Tuple2<String, Integer>> collector) throws Exception {

String[] split = s.split("\\s");

for (String word : split) {

collector.collect(Tuple2.of(word, 1));

}

}

});

SingleOutputStreamOperator<Tuple2<String, Integer>> word = tuple2SingleOutputStreamOperator.keyBy(0)

.timeWindow(Time.seconds(5),Time.seconds(1)).sum(1);

word.print();

executionEnvironment.execute("wordcount stream process");

}

}

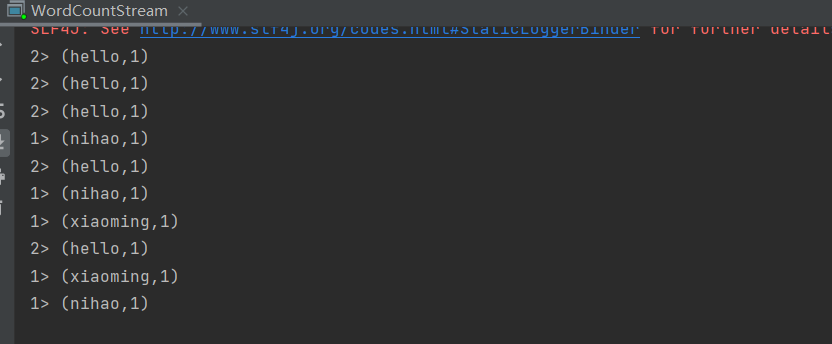

运行起来之后,我们就可以开始发送 socket 请求过去。我们测试可以使用 netcat 工具。

在 linux 上安装好后,使用下面的命令:

nc -lk 7000

然后发送数据即可。

Flink WordCount入门的更多相关文章

- [转帖]Flink(一)Flink的入门简介

Flink(一)Flink的入门简介 https://www.cnblogs.com/frankdeng/p/9400622.html 一. Flink的引入 这几年大数据的飞速发展,出现了很多热门的 ...

- Flink从入门到放弃(入门篇2)-本地环境搭建&构建第一个Flink应用

戳更多文章: 1-Flink入门 2-本地环境搭建&构建第一个Flink应用 3-DataSet API 4-DataSteam API 5-集群部署 6-分布式缓存 7-重启策略 8-Fli ...

- Flink从入门到放弃(入门篇3)-DataSetAPI

戳更多文章: 1-Flink入门 2-本地环境搭建&构建第一个Flink应用 3-DataSet API 4-DataSteam API 5-集群部署 6-分布式缓存 7-重启策略 8-Fli ...

- Flink从入门到放弃(入门篇1)-Flink是什么

戳更多文章: 1-Flink入门 2-本地环境搭建&构建第一个Flink应用 3-DataSet API 4-DataSteam API 5-集群部署 6-分布式缓存 7-重启策略 8-Fli ...

- Flink从入门到放弃(入门篇4) DataStreamAPI

戳更多文章: 1-Flink入门 2-本地环境搭建&构建第一个Flink应用 3-DataSet API 4-DataSteam API 5-集群部署 6-分布式缓存 7-重启策略 8-Fli ...

- Flink从入门到精通系列文章

戳更多文章: 1-Flink入门 2-本地环境搭建&构建第一个Flink应用 3-DataSet API 4-DataSteam API 5-集群部署 6-分布式缓存 7-重启策略 8-Fli ...

- Flink快速入门--安装与示例运行

flink是一款开源的大数据流式处理框架,他可以同时批处理和流处理,具有容错性.高吞吐.低延迟等优势,本文简述flink在windows和linux中安装步骤,和示例程序的运行. 首先要想运行Flin ...

- 「Flink」使用Java lambda表达式实现Flink WordCount

本篇我们将使用Java语言来实现Flink的单词统计. 代码开发 环境准备 导入Flink 1.9 pom依赖 <dependencies> <dependency> < ...

- Flink(一)Flink的入门简介

一. Flink的引入 这几年大数据的飞速发展,出现了很多热门的开源社区,其中著名的有 Hadoop.Storm,以及后来的 Spark,他们都有着各自专注的应用场景.Spark 掀开了内存计算的先河 ...

随机推荐

- C#委托的最简单入门和理解

委托是.net语言中非常重要的一个概念,初学不太好理解也没有关系的,在一次一次的攻关后会领会到委托的精妙,可以说 .net 没有委托就没有后面更高级的事件,异步多线程等等特性的形成可能.所以一定要 ...

- 物无定味适口者珍,Python3并发场景(CPU密集/IO密集)任务的并发方式的场景抉择(多线程threading/多进程multiprocessing/协程asyncio)

原文转载自「刘悦的技术博客」https://v3u.cn/a_id_221 一般情况下,大家对Python原生的并发/并行工作方式:进程.线程和协程的关系与区别都能讲清楚.甚至具体的对象名称.内置方法 ...

- Vue 样式绑定 && 条件渲染

1 <!DOCTYPE html> 2 <html> 3 <head> 4 <meta charset="UTF-8" /> 5 & ...

- 获取进程产生了多少次pagefault

怎么获取某个进程产生了多少次pagefault? 这个在ps 命令中可以看到,比如查看java的pagefault情况. ps -o maj_flt -o min_flt -p `ps -e|grep ...

- 【HMS core】【FAQ】典型问题合集7

1.[HMS core][Account Kit][问题描述] 集成华为帐号服务后,登录服务异常,无法获取用户信息,报statusCode为907135001,抓取报错日志:Failed to re ...

- 上传代码到GitHub仓库

上传代码到GitHub仓库 准备工作 意思是自从 21 年 8 月 13 后不再支持用户名密码的方式验证了,需要创建个人访问令牌(personal access token). 这里就不多说了 Git ...

- HTML引用CSS实现自适应背景图

链接图片背景代码 body {background: url('链接') no-repeat center 0;} 颜色代码 body{background:#FFF} 链接图片背景代码2 <b ...

- 【Java】学习路径34-文件IO练习题

练习题: 1.检测某目录(scr目录为例)下java源程序文件的数量. 参考思路: 首先获取到scr目录,然后使用list()获取所有名字,再使用String类下的endsWith方法检查即可. 参考 ...

- 【java】学习路径27-HashSet、TreeSet,HashMap

学习路径20-27的所有源代码都可以在此下载 https://www.aliyundrive.com/s/cg8jTRbg6vy HashSet.TreeSet中,Set表示集合,特性在于:无序的.不 ...

- 《网页设计基础——HTML注释与CSS注释》

网页设计基础--HTML注释与CSS注释 一.HTML注释: 格式: <!-- 在此处书写注释 --> 例如: <html> <head> <ti ...