17.Azkaban实战

首先创建一个command.job文件

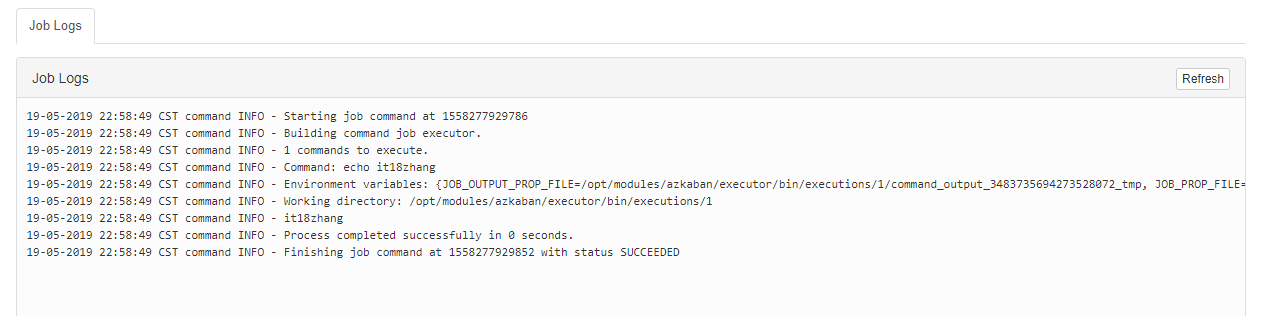

#command.job

type=command

command=echo it18zhang

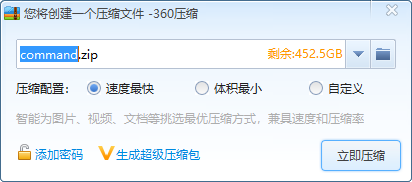

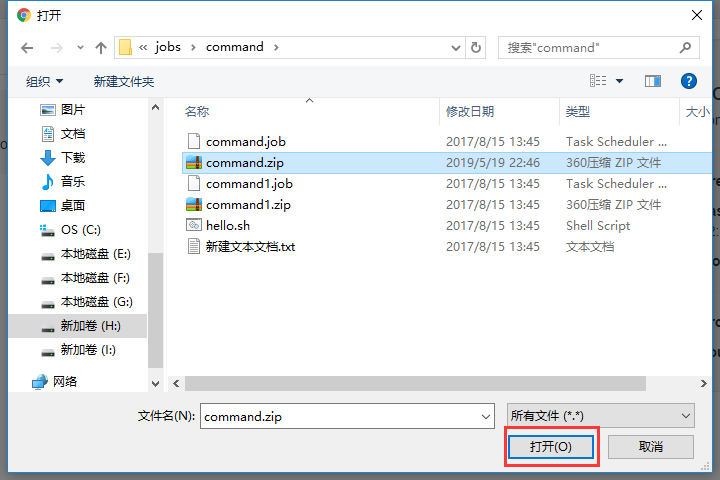

然后打成zip压缩包

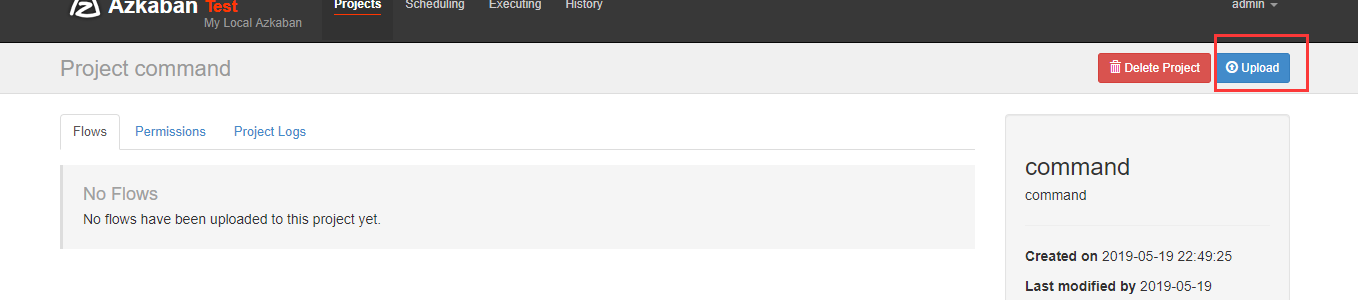

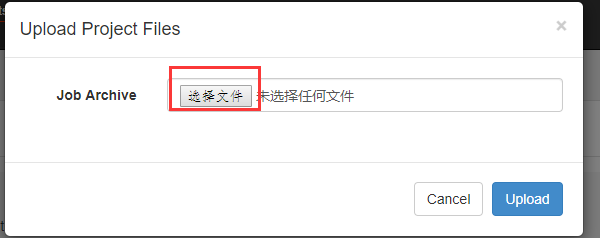

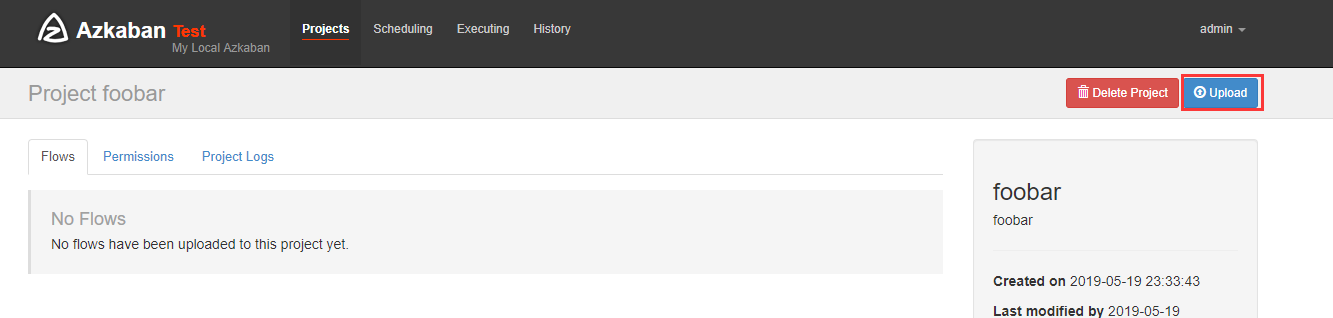

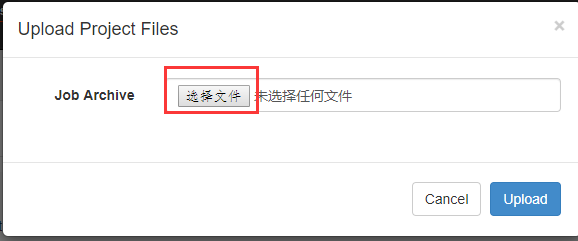

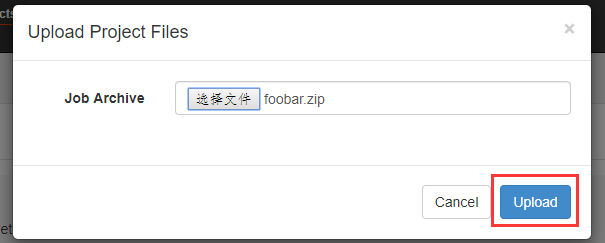

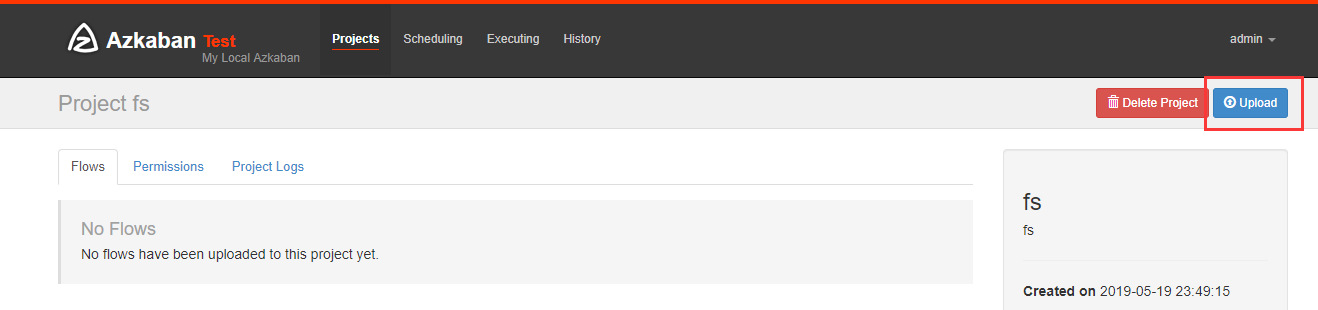

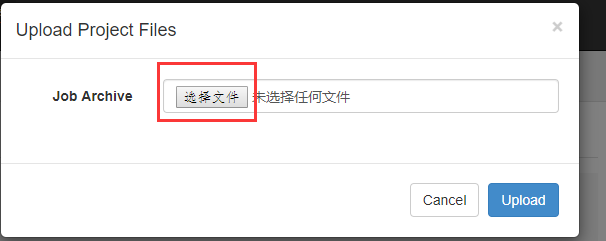

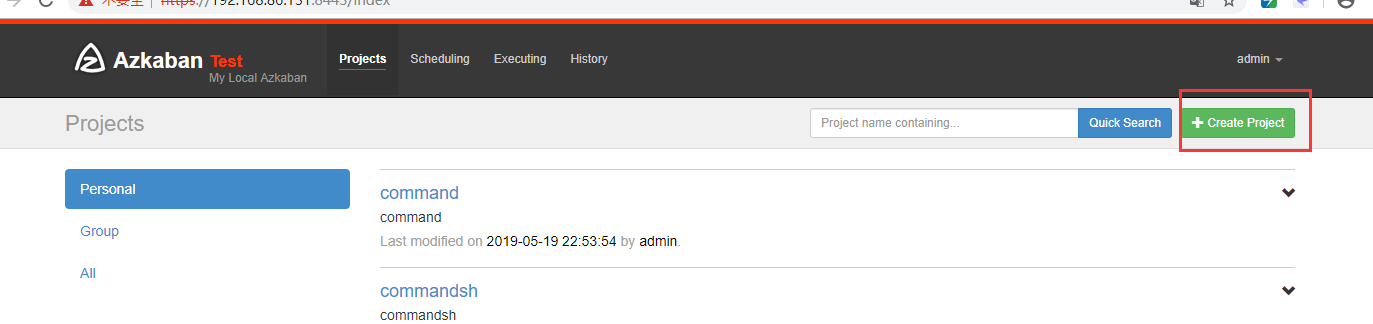

上传刚刚打包的zip包

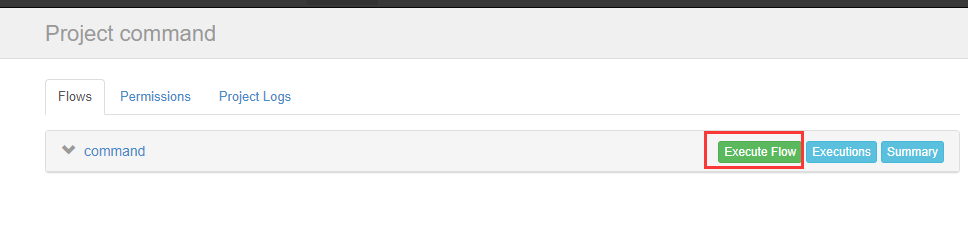

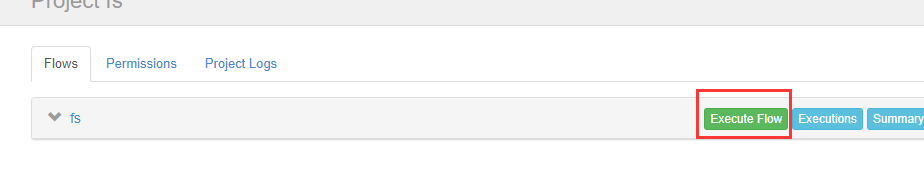

上传完后可以执行他

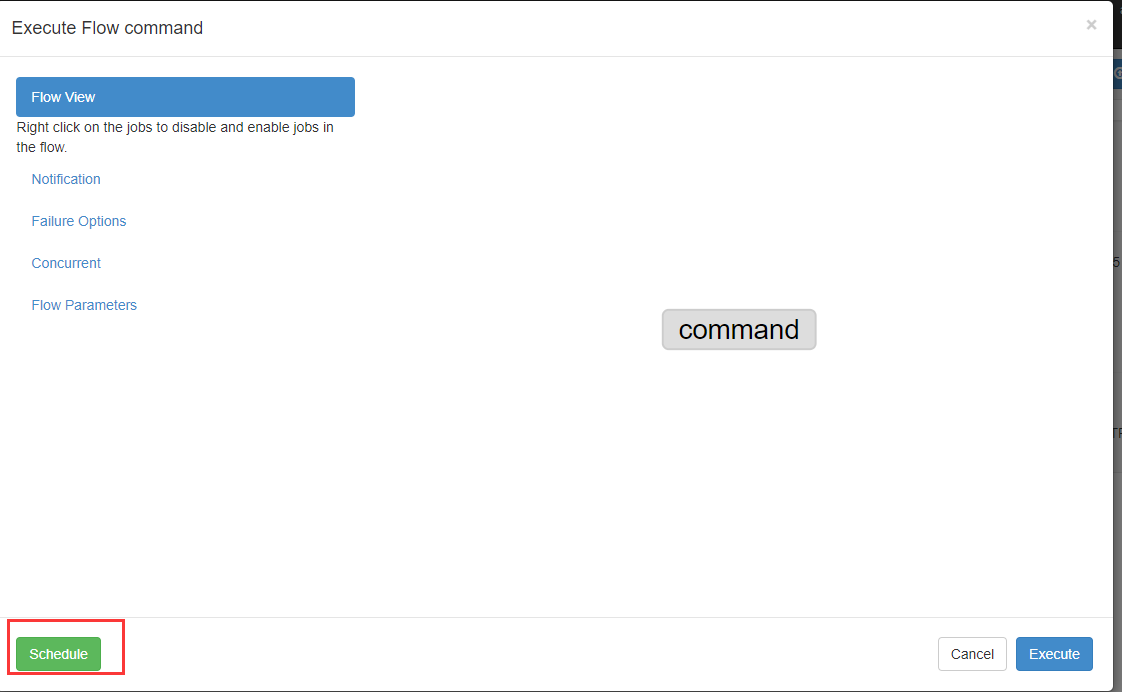

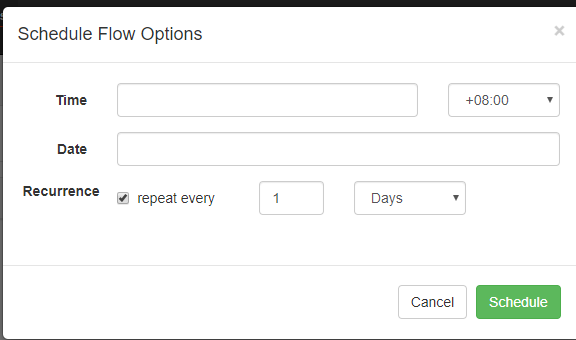

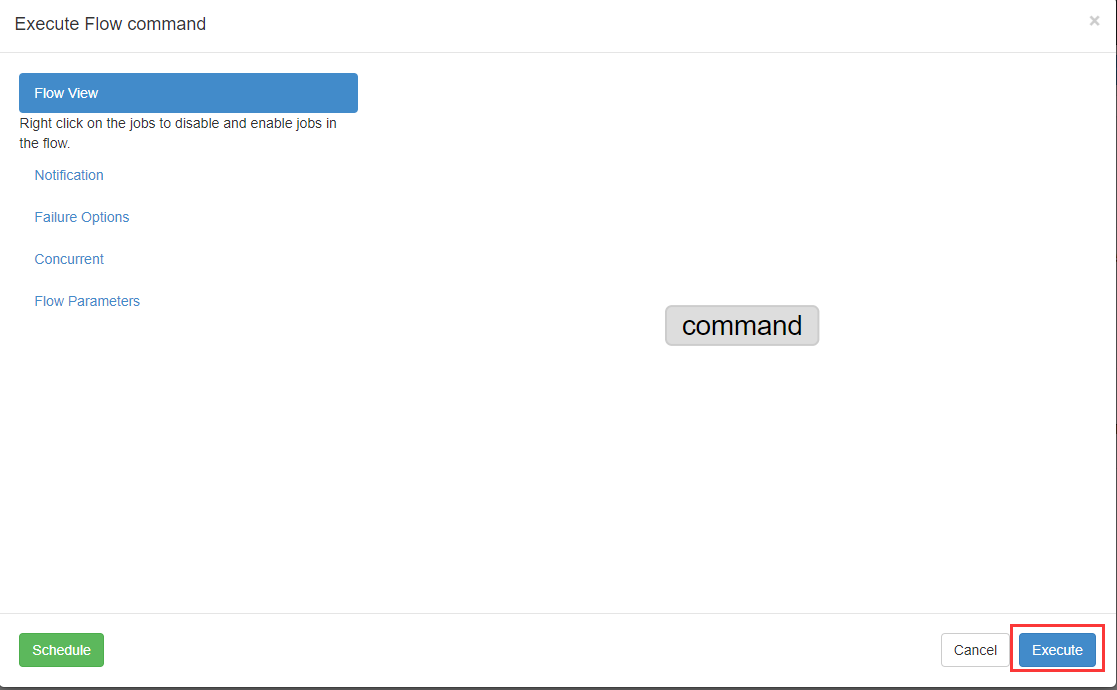

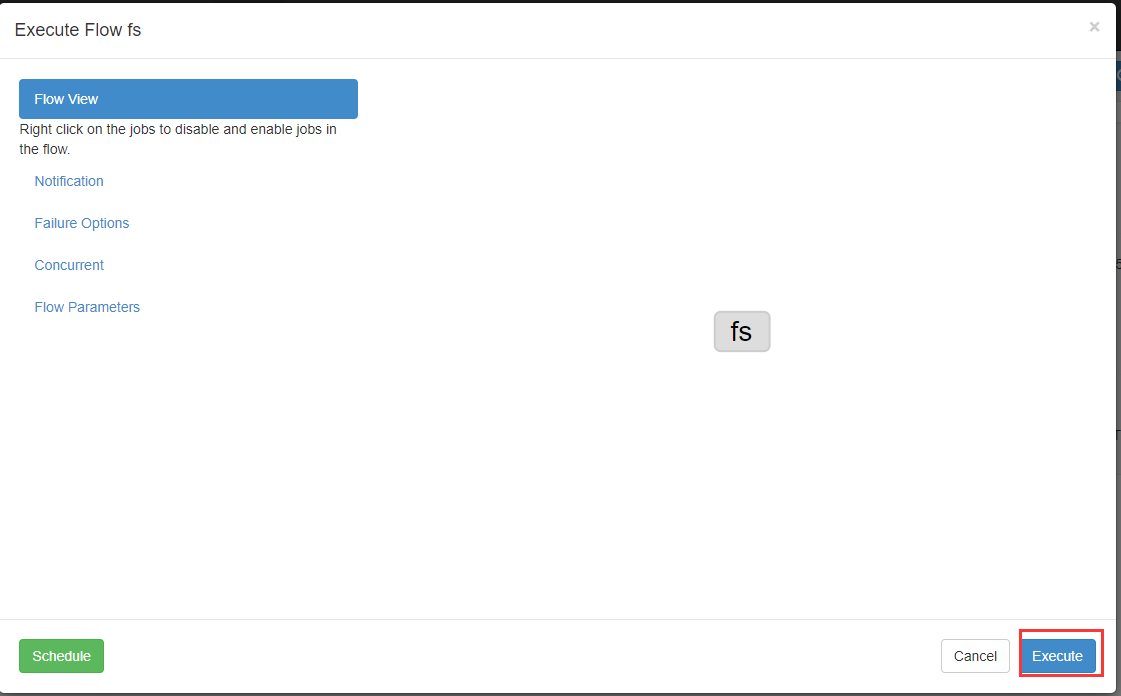

可以定时执行

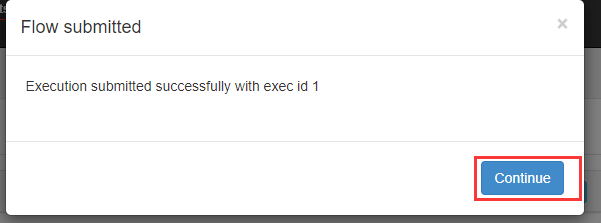

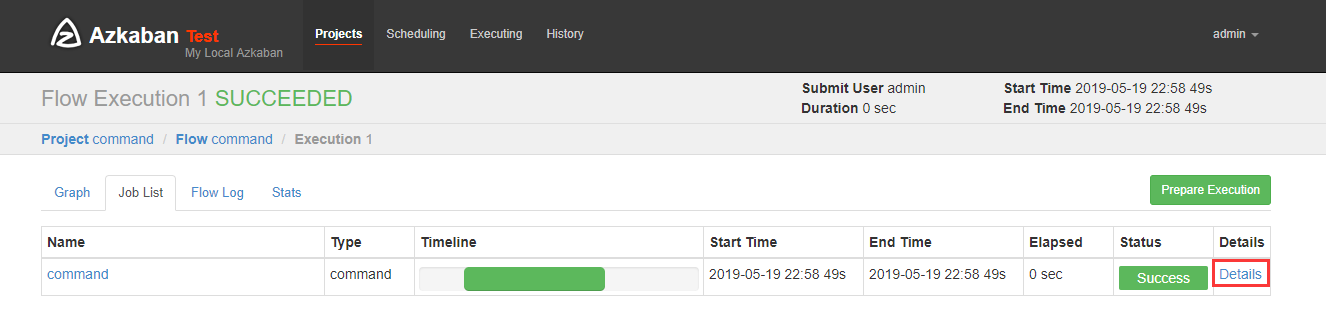

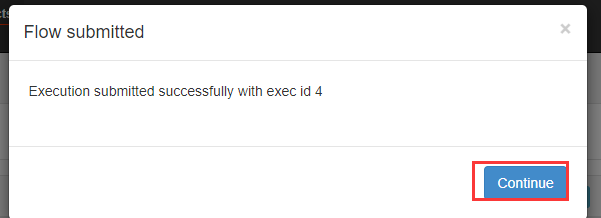

现在我们立马执行

现在我们要执行一个脚本

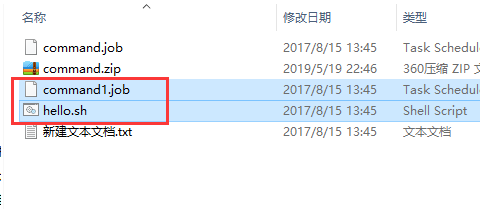

新建一个commad1.job文件

#command.job

type=command

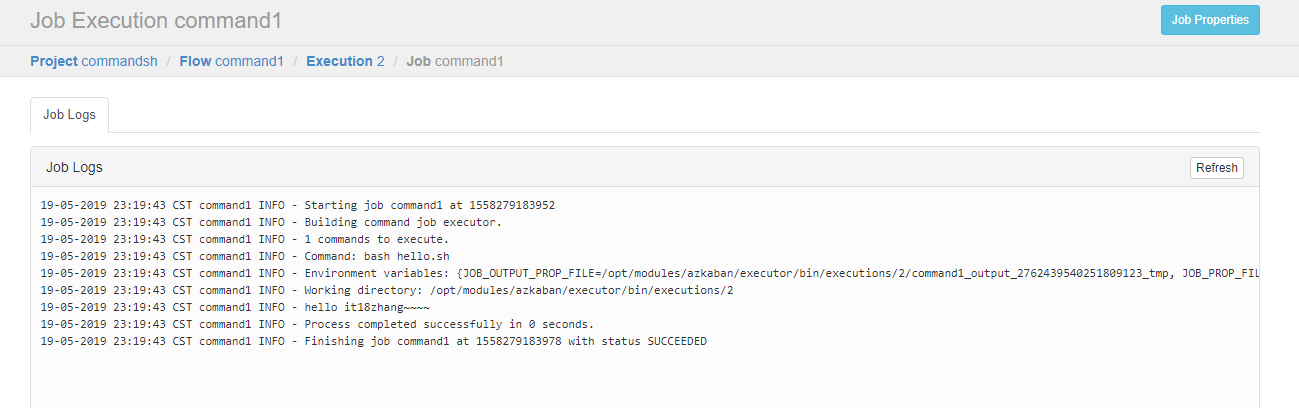

command=bash hello.sh

再编写一个hello,sh脚本

#!/bin/bash

echo 'hello it18zhang~~~~'

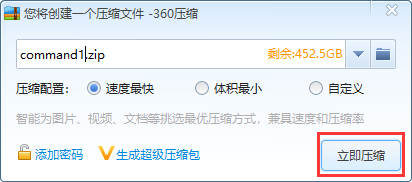

把两个文件都选上一起打包

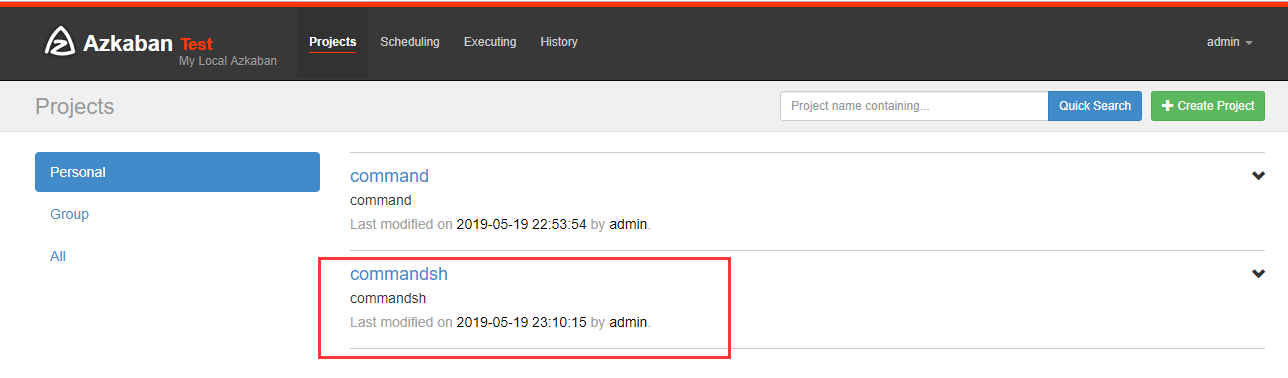

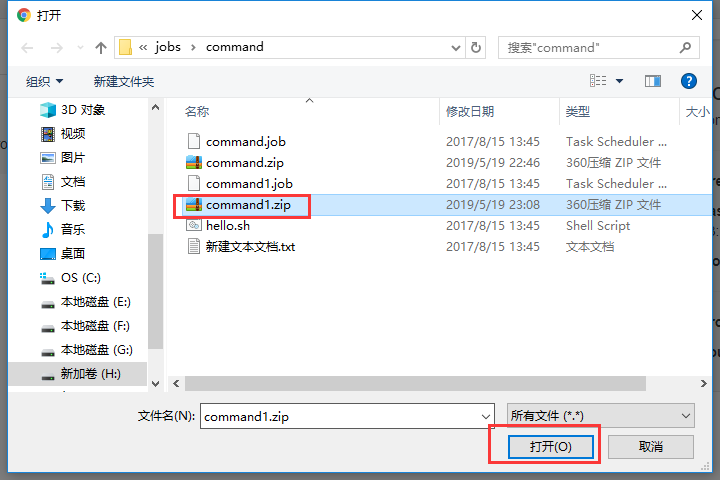

上传刚刚打的zip包

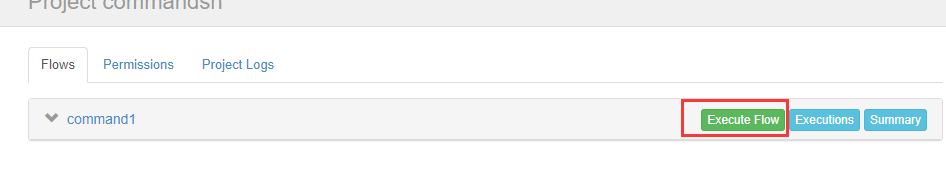

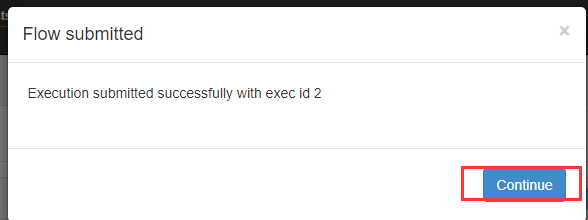

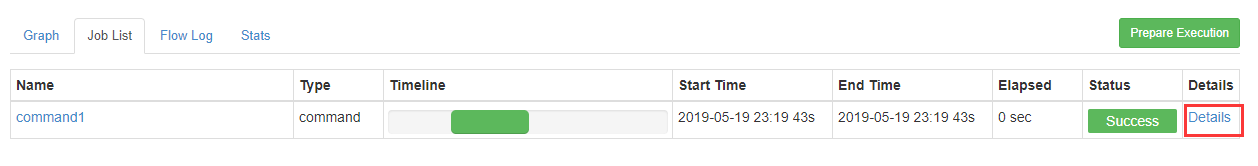

执行

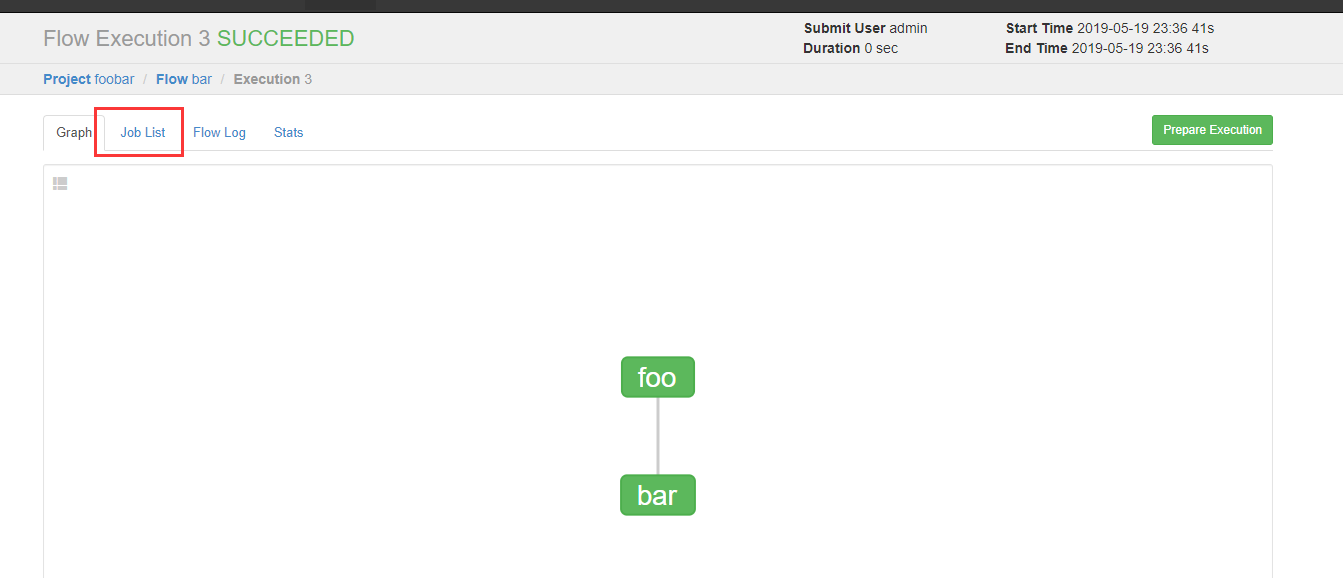

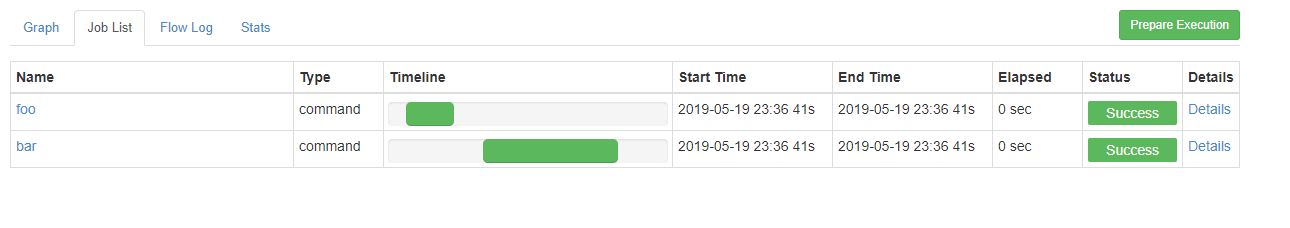

创建有依赖关系的多个job描述

新建一个bar.job

# bar.job

type=command

dependencies=foo

command=echo bar

新建一个foo.job

# foo.job

type=command

command=echo foo

把这两个文件一起打成zip包

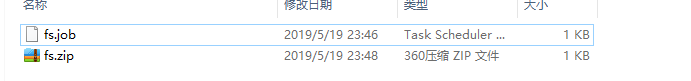

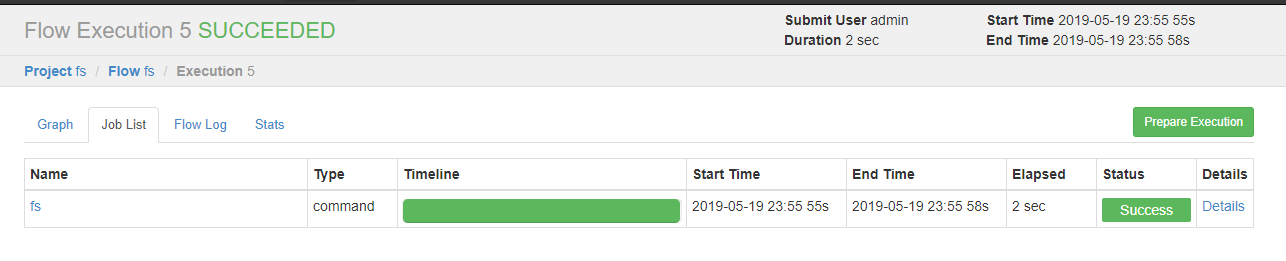

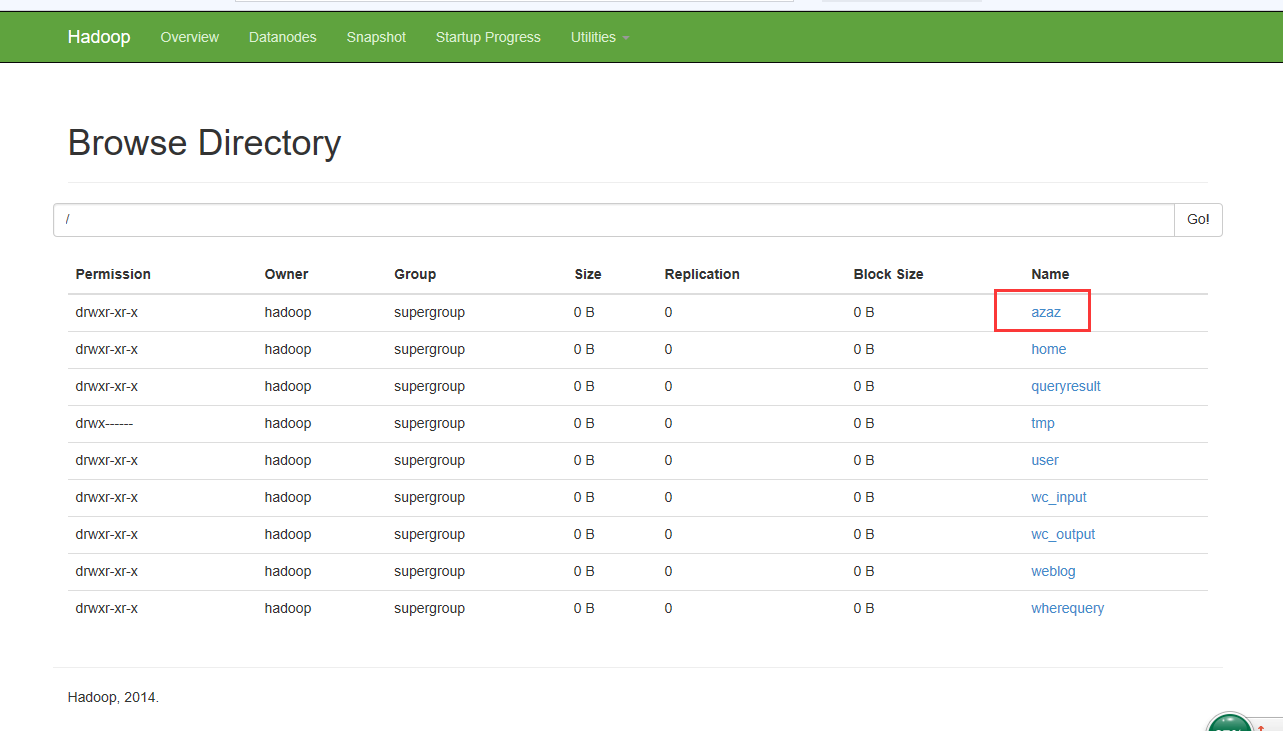

HDFS操作任务

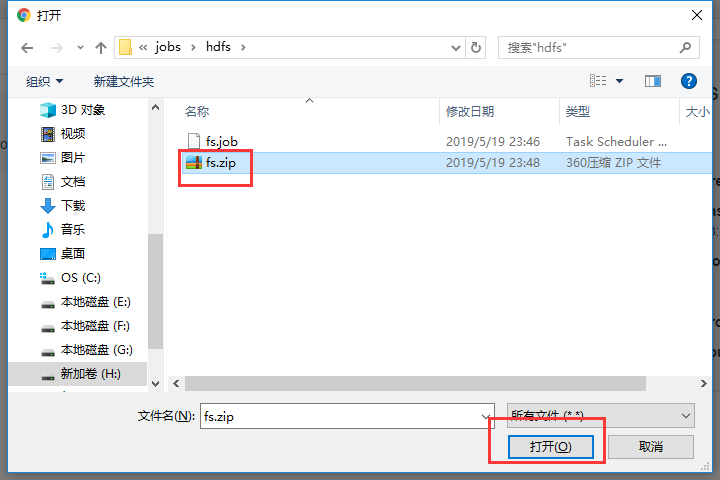

新建文件fs.job

# fs.job

type=command

command=/opt/modules/hadoop-2.6./bin/hadoop fs -mkdir /azaz

打包成zip包

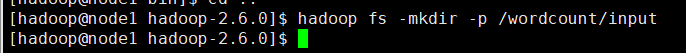

MAPREDUCE任务

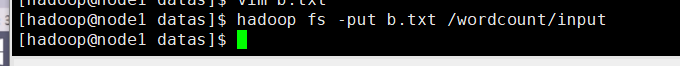

先创建一个输入路径

创建一个数据文件b.txt

输入一些单词

把b.txt文件上传到hdfs上

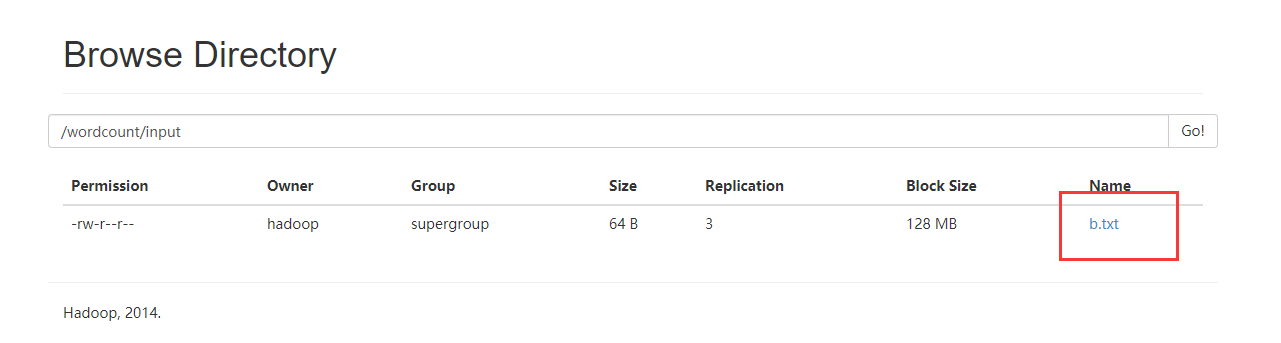

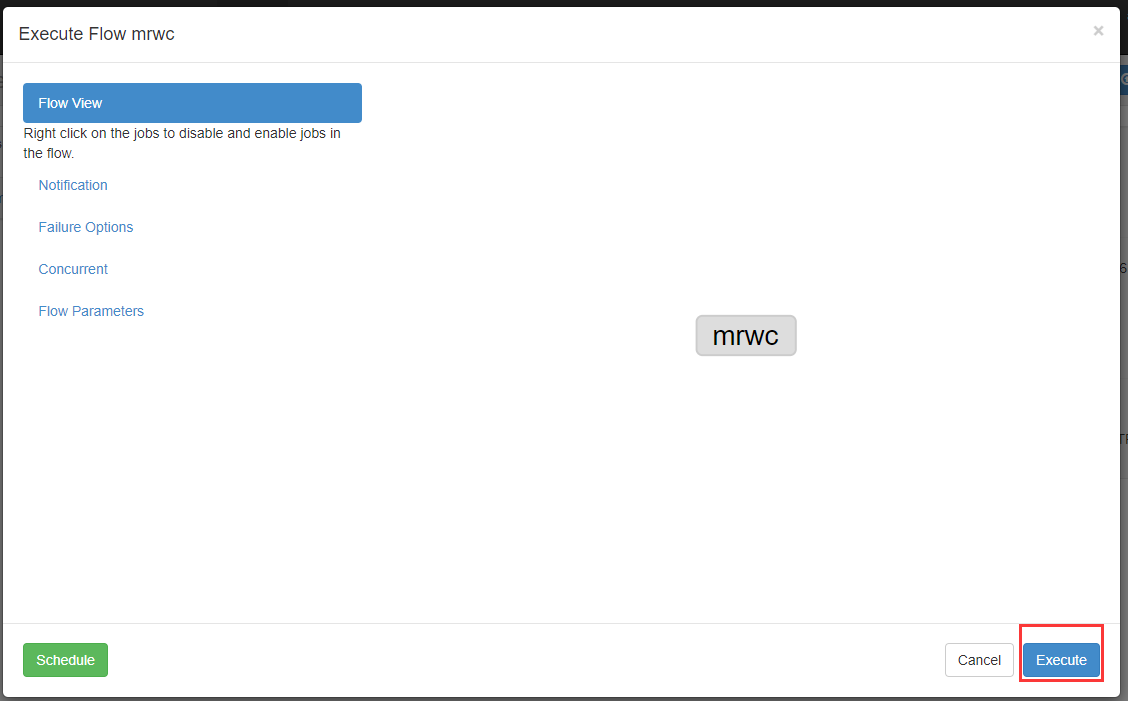

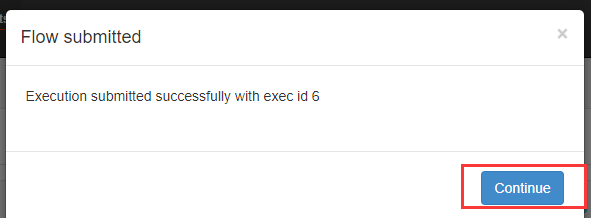

创建mrwc.job文件

# mrwc.job

type=command

command=/opt/modules/hadoop-2.6./bin/hadoop jar hadoop-mapreduce-examples-2.6..jar wordcount /wordcount/input /wordcount/azout

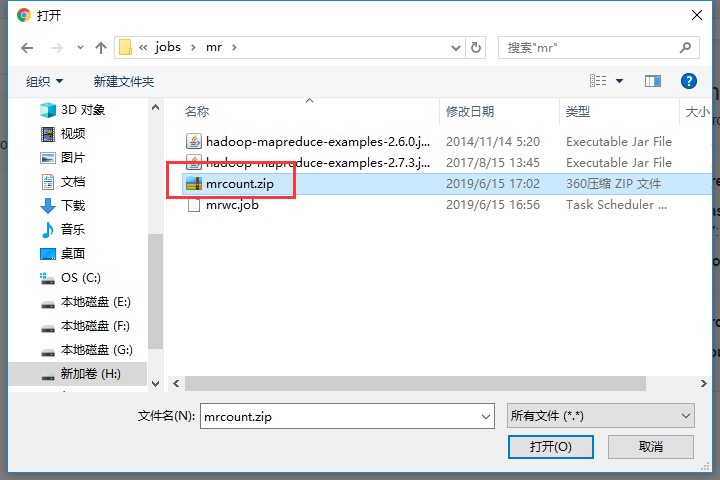

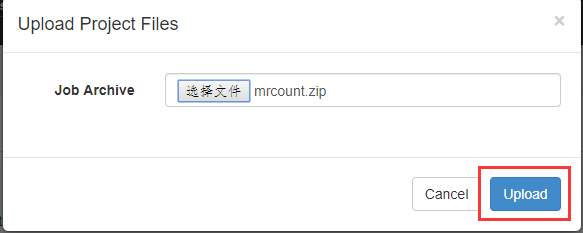

把这两个文件一起打包

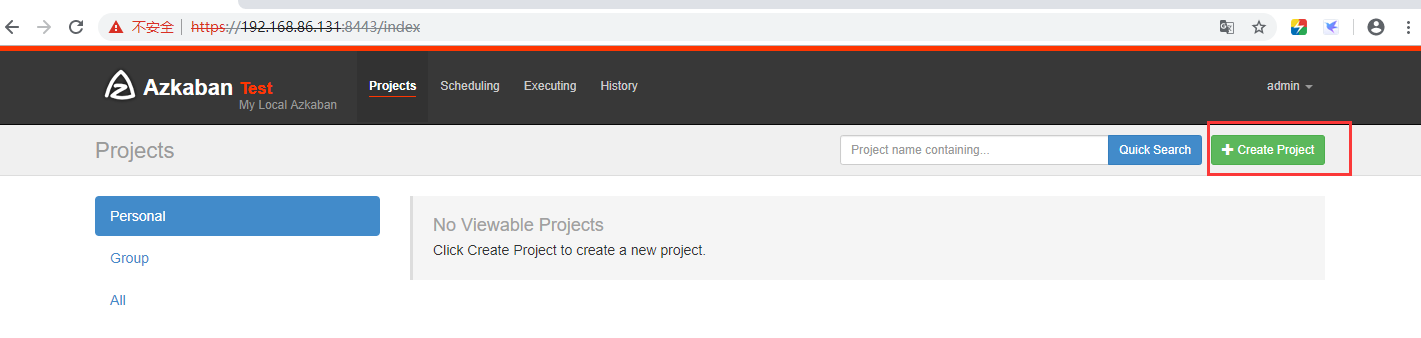

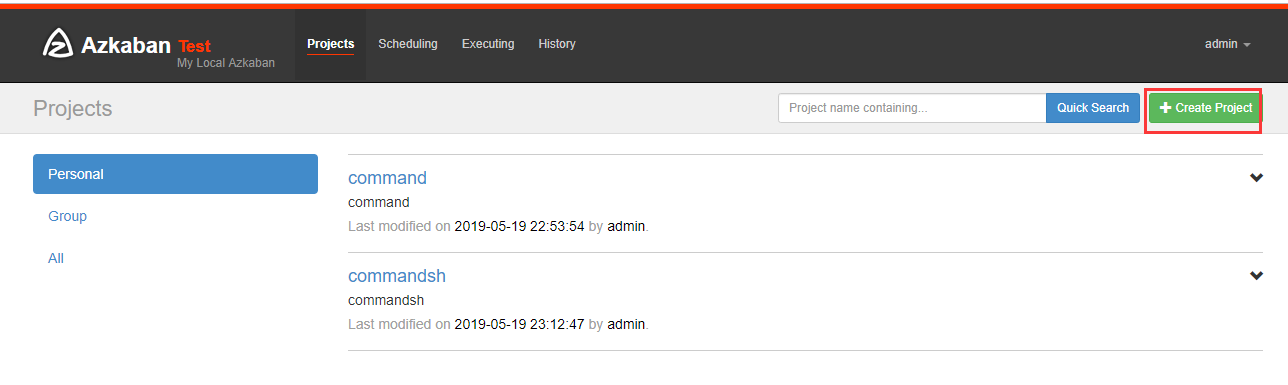

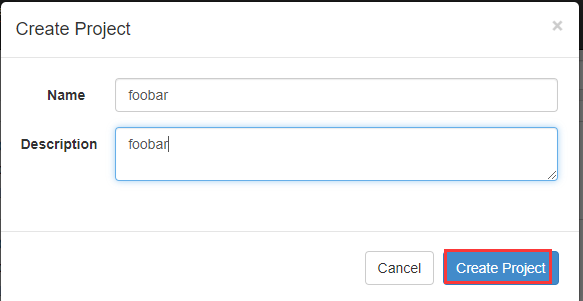

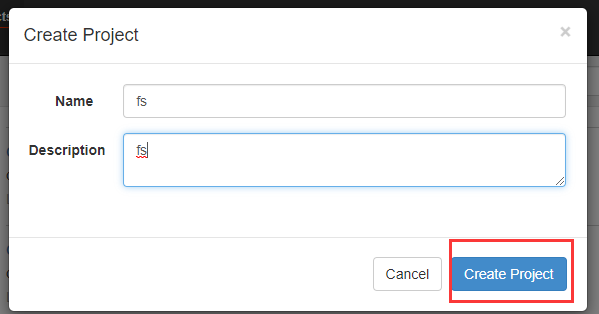

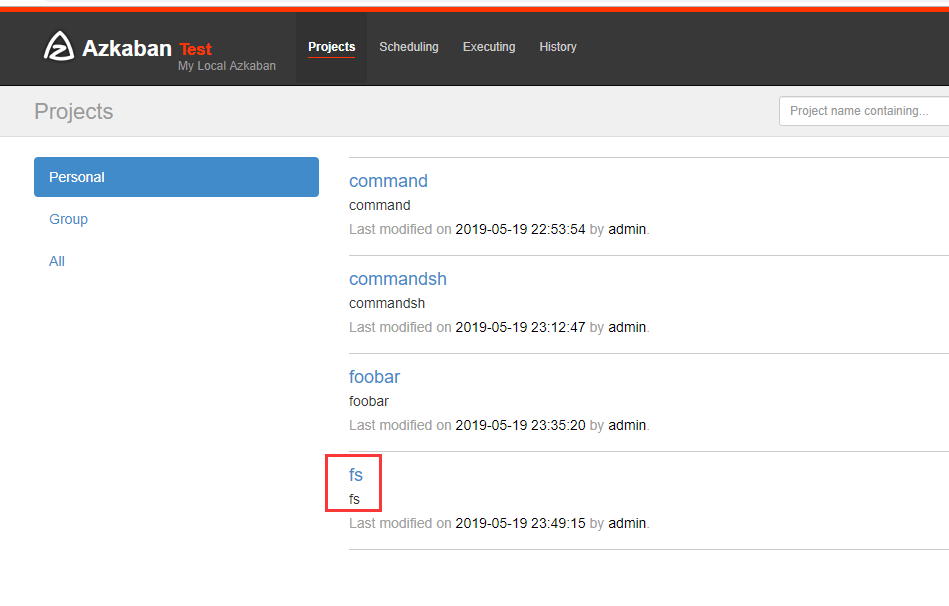

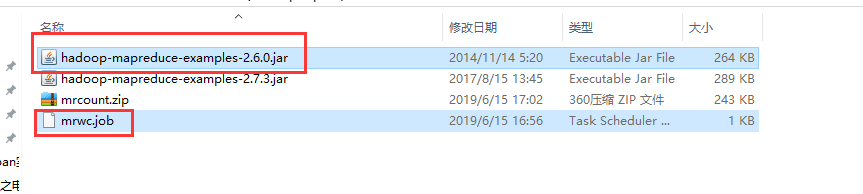

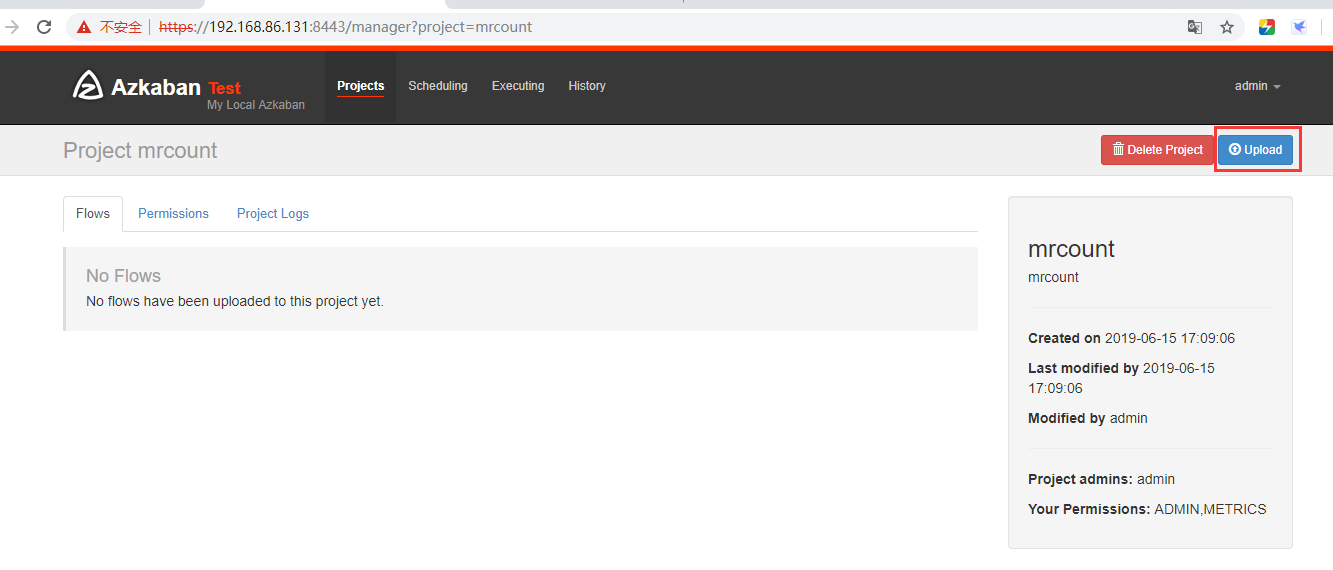

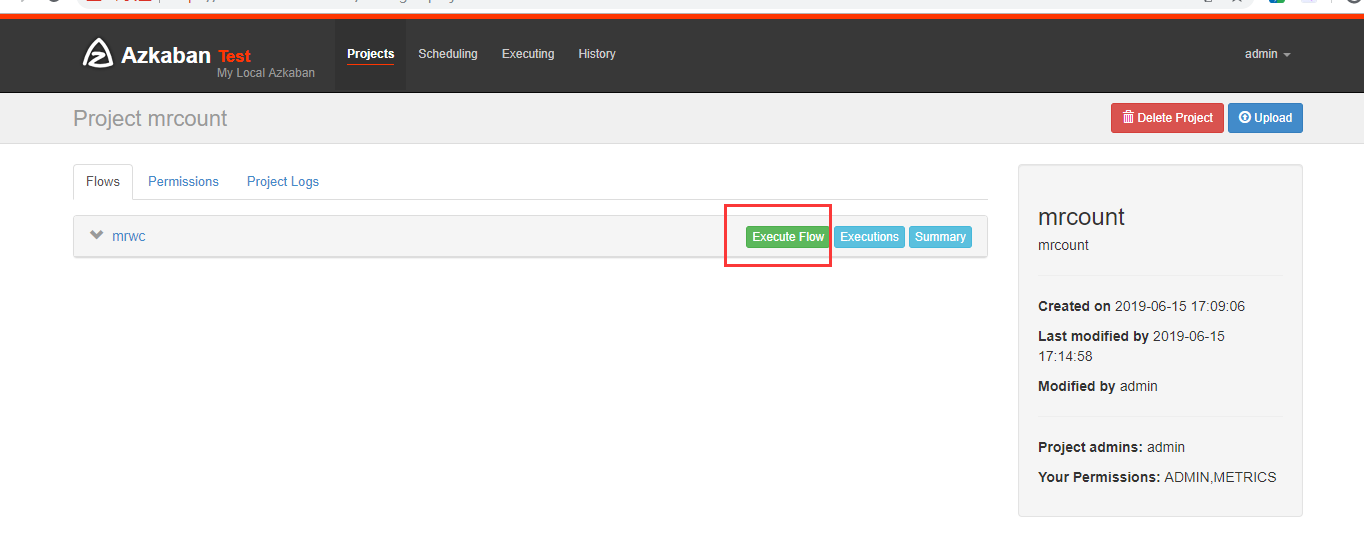

在azkaban创建一个project

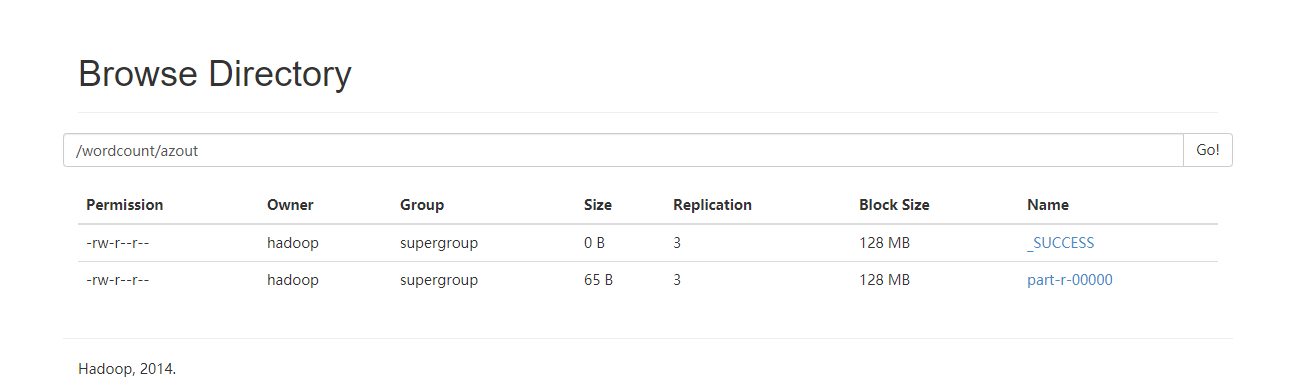

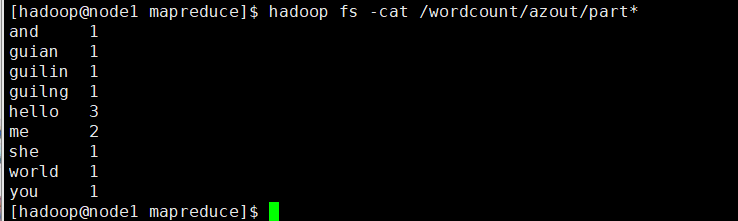

可以看到执行成功了

HIVE脚本任务

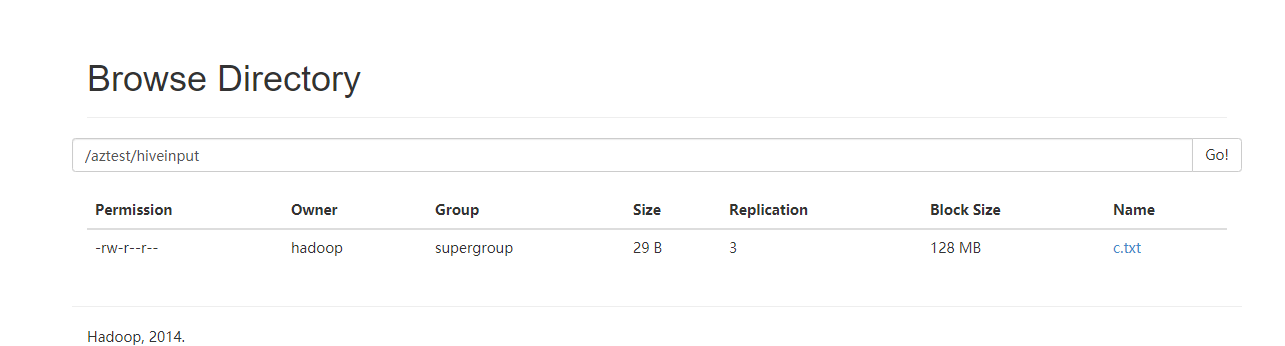

先创建目录

hadoop fs -mkdir -p /aztest/hiveinput

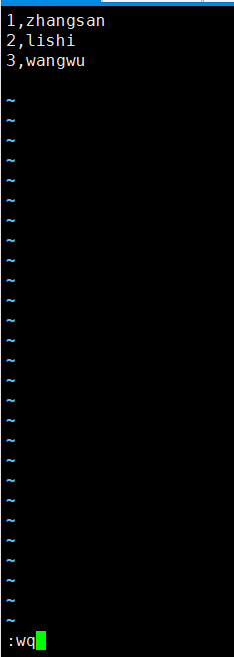

新建一个c.txt数据文件

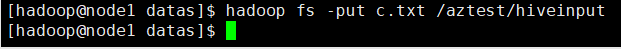

把c.txt文件上传到HDFS上

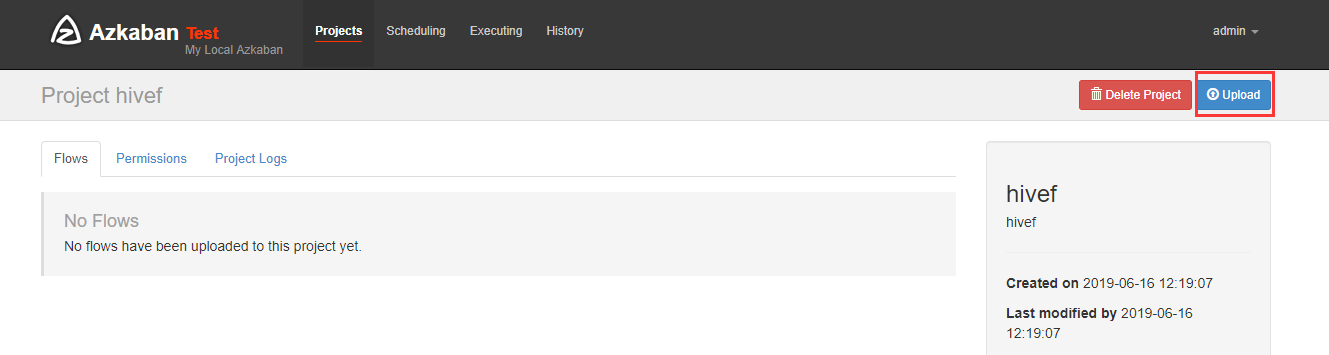

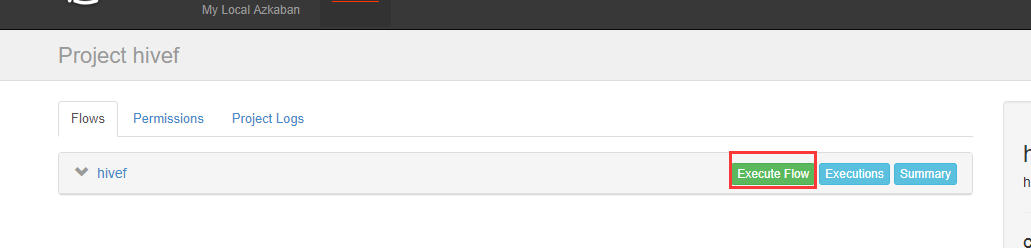

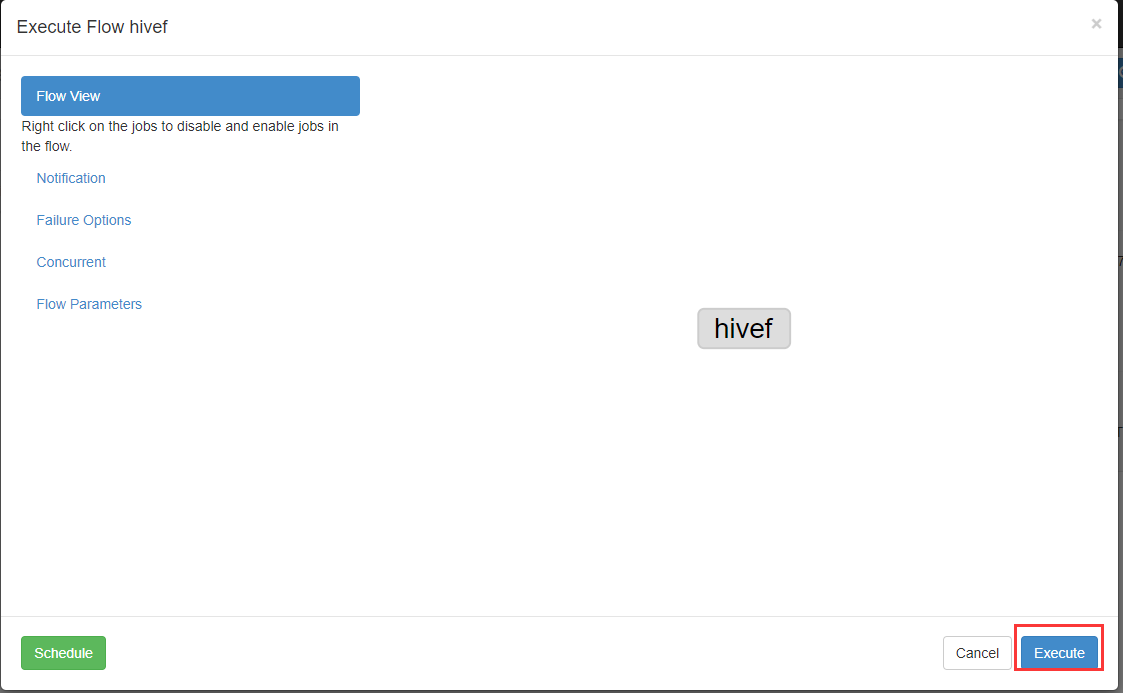

新建hivef.job

# hivef.job

type=command

command=/opt/modules/hive/bin/hive -f 'test.sql'

新建test.sql

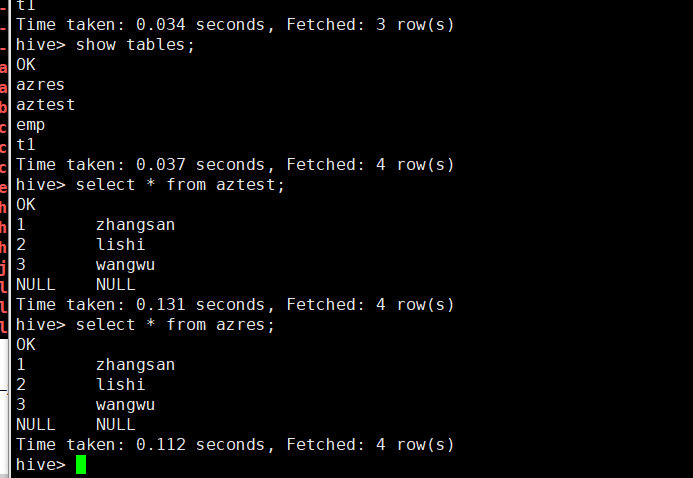

use default;

drop table aztest;

create table aztest(id int,name string) row format delimited fields terminated by ',' ;

load data inpath '/aztest/hiveinput' into table aztest;

create table azres as select * from aztest;

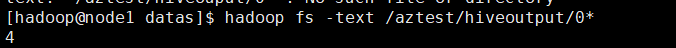

insert overwrite directory '/aztest/hiveoutput' select count() from aztest;

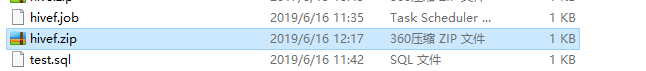

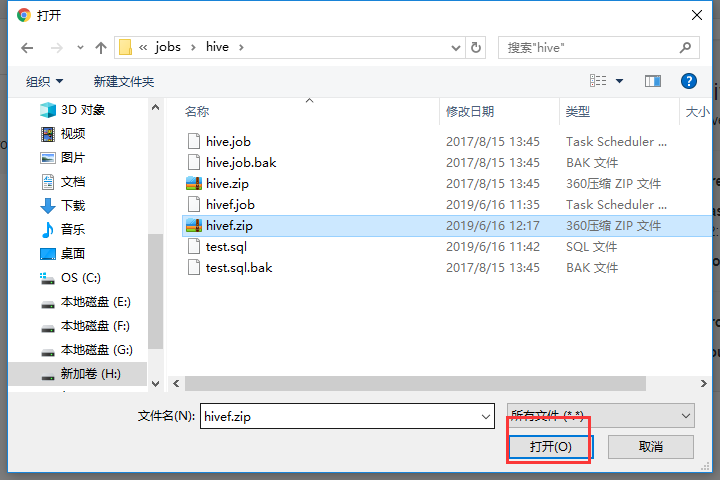

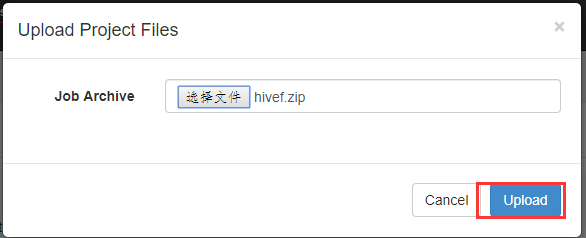

打包成hivef.zip

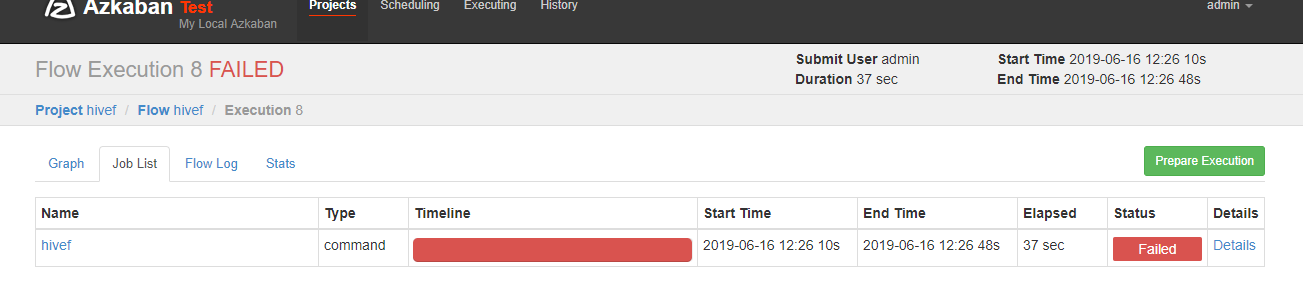

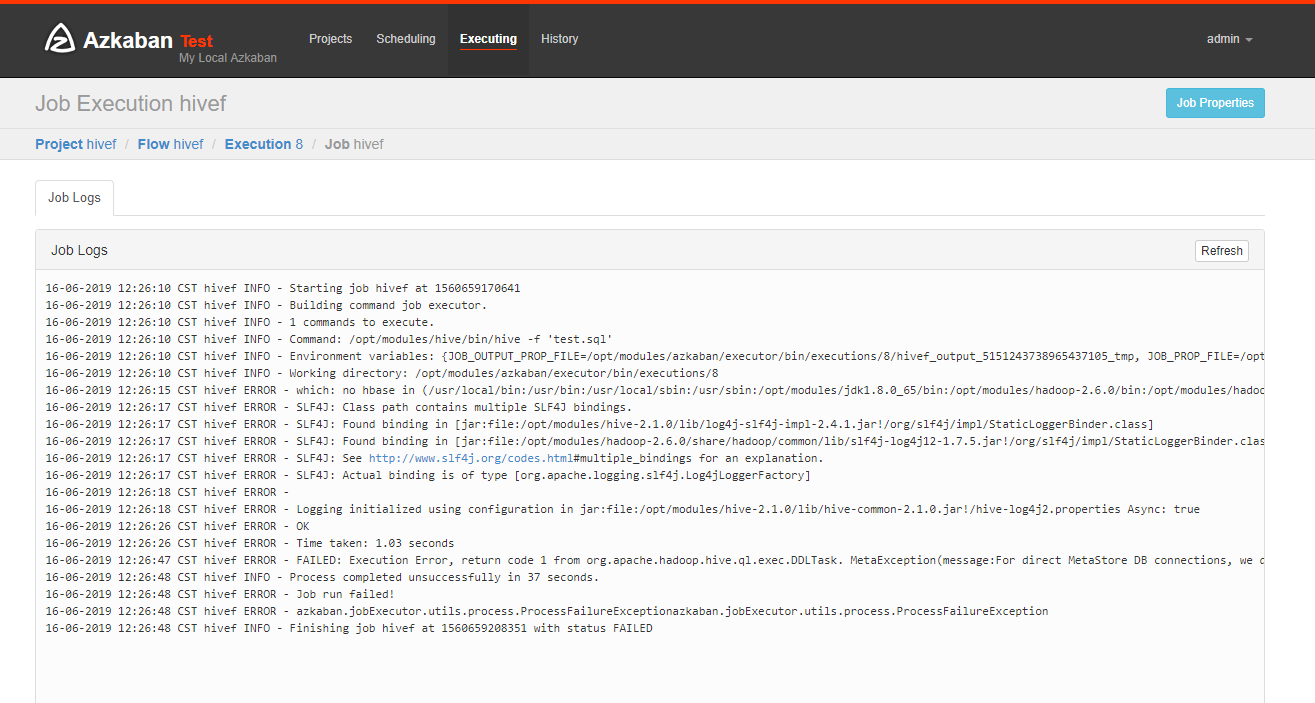

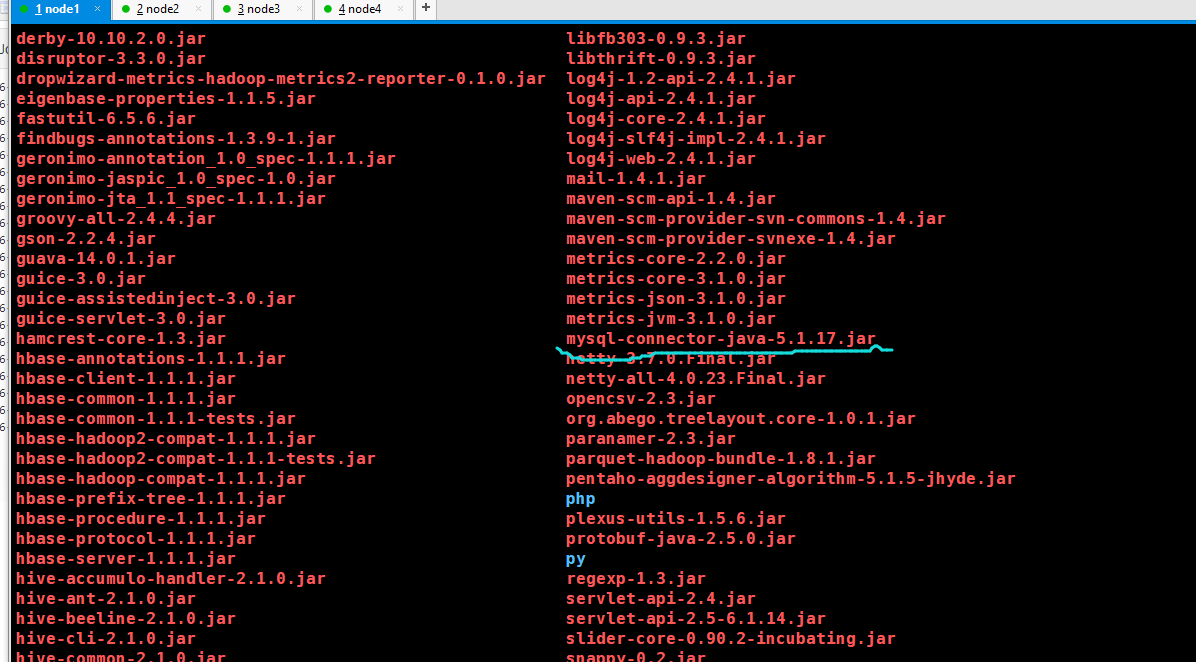

可以看到失败了,查看原因

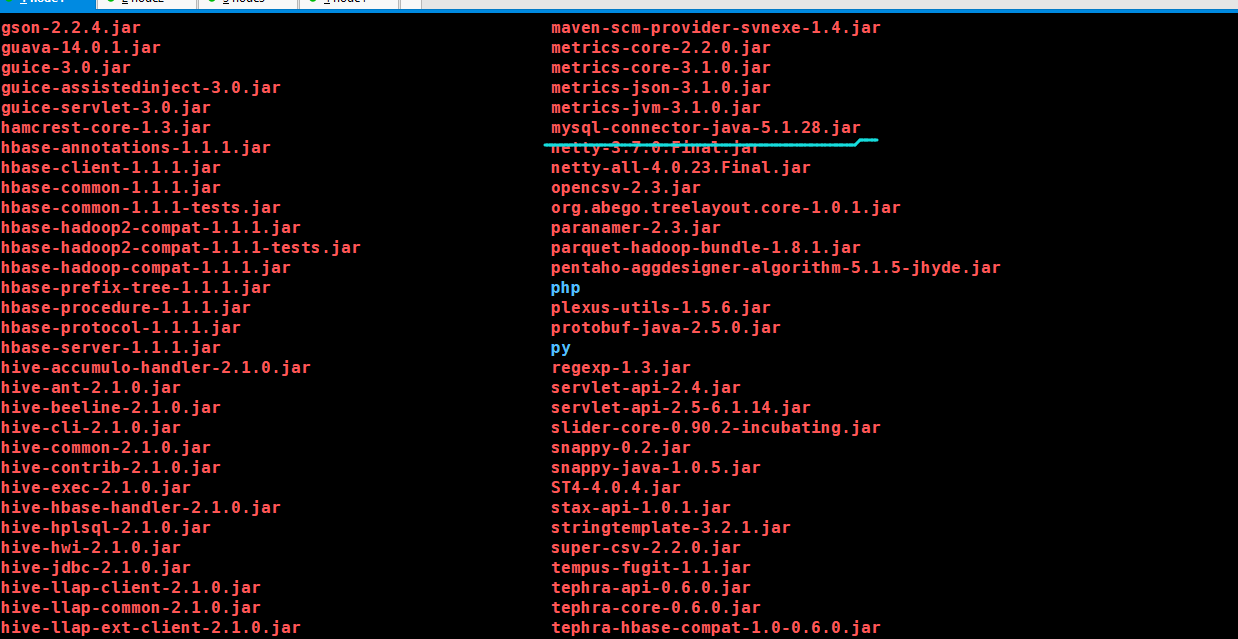

把本地hive的Lib目录下的mysql连接包的版本更换一下

换成这个5.1.28版本

再运行一次,同样失败了,但是hive和hdfs上出来了相应的结果,具有原因我也不懂

17.Azkaban实战的更多相关文章

- 大数据技术之_13_Azkaban学习_Azkaban(阿兹卡班)介绍 + Azkaban 安装部署 + Azkaban 实战

一 概述1.1 为什么需要工作流调度系统1.2 常见工作流调度系统1.3 各种调度工具特性对比1.4 Azkaban 与 Oozie 对比二 Azkaban(阿兹卡班) 介绍三 Azkaban 安装部 ...

- Azkaban实战,Command类型单一job示例,任务中执行外部shell脚本,Command类型多job工作flow,HDFS操作任务,MapReduce任务,HIVE任务

本文转载自:https://blog.csdn.net/tototuzuoquan/article/details/73251616 1.Azkaban实战 Azkaba内置的任务类型支持comman ...

- Hadoop生态圈-Azkaban实战之Command类型执行指定脚本

Hadoop生态圈-Azkaban实战之Command类型执行指定脚本 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 1>.服务端测试代码(别忘记添加权限哟!) [yinzh ...

- Hadoop生态圈-Azkaban实战之Command类型多job工作流flow

Hadoop生态圈-Azkaban实战之Command类型多job工作流flow 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. Azkaban内置的任务类型支持command.ja ...

- azkaban(安装配置加实战)

为什么需要工作流调度系统 一个完整的数据分析系统通常都是由大量任务单元组成:shell 脚本程序,java 程序,mapreduce 程序.hive 脚本等 各任务单元之间存在时间先后及前后依赖关 ...

- Flume+Sqoop+Azkaban笔记

大纲(辅助系统) 离线辅助系统 数据接入 Flume介绍 Flume组件 Flume实战案例 任务调度 调度器基础 市面上调度工具 Oozie的使用 Oozie的流程定义详解 数据导出 sqoop基础 ...

- 【大数据】Azkaban学习笔记

一 概述 1.1 为什么需要工作流调度系统 1)一个完整的数据分析系统通常都是由大量任务单元组成: shell脚本程序,java程序,mapreduce程序.hive脚本等 2)各任务单元之间存在时间 ...

- 《Spring 3.x 企业应用开发实战》目录

图书信息:陈雄华 林开雄 编著 ISBN 978-7-121-15213-9 概述: 第1章:对Spring框架进行宏观性的概述,力图使读者建立起对Spring整体性的认识. 第2章:通过一个简单的例 ...

- AI人工智能顶级实战工程师 课程大纲

课程名称 内容 阶段一.人工智能基础 — 高等数学必知必会 1.数据分析 "a. 常数eb. 导数c. 梯度d. Taylore. gini系数f. 信息熵与组合数 ...

随机推荐

- 小米oj 有多少个公差为2的等差数列

有多少个公差为 2 的等差数列 序号:#31难度:有挑战时间限制:1000ms内存限制:10M 描述 给出一个正整数N(2<= N <=10000000),统计有多少公差为2的正整数等差 ...

- luogu4281

P4281 [AHOI2008]紧急集合 / 聚会 题目描述 欢乐岛上有个非常好玩的游戏,叫做“紧急集合”.在岛上分散有N个等待点,有N-1条道路连接着它们,每一条道路都连接某两个等待点,且通过这些道 ...

- JQuery动画之滑入滑出动画

1. 滑入动画(类似于商店的卷帘门) $(selector).slideDown(speed, 回调函数); 解释: 此语句实现的功能为, 在XX时间内, 下拉动画, 显现元素. 当 slideDow ...

- Mybatis源码学习之资源加载(六)

类加载器简介 Java虚拟机中的类加载器(ClassLoader)负责加载来自文件系统.网络或其他来源的类文件.Java虚拟机中的类加载器默认使用的是双亲委派模式,如图所示,其中有三种默认使用的类加载 ...

- Vue_(Router路由)-vue-router路由的基本用法

vue-router官网:传送门 vue-router起步:传送门 vue-router路由:Vue.js官网推出的路由管理器,方便的构建单页应用 单页应用:Single Page Applicati ...

- ELK(ElasticSearch, Logstash, Kibana) 实现 Java 分布式系统日志分析架构

一.首先理解为啥要使用ELK 日志主要分为三类:系统日志.应用程序日志和安全日志.系统运维和开发人员可以通过日志了解服务器软硬件信息.检查配置过程中的错误及错误发生的原因.通过分析日志可以了解服务器的 ...

- [MyBatis]最简MyBatis工程

下载地址:https://files.cnblogs.com/files/xiandedanteng/fillMillionDatum01_191005.rar --END-- 2019年10月5日1 ...

- 前端知识点回顾——Javascript篇(一)

DOM特殊元素获取 document.documentElement //HTML标签 document.head //head标签 document.title //title标签 document ...

- Android Dalvik、ART及APK编译过程

0.1 先对Dalvik以及ART做简单介绍: 什么是Dalvik: Dalvik是Google公司自己设计用于Android平台的Java虚拟机.dex格式是专为Dalvik应用设计的一种压缩格式, ...

- babel 实践

一.@babel/core var babel = require("@babel/core");babel.transform(code, options, function(e ...