Python实战:如何隐藏自己的爬虫身份

使用爬虫访问网站,需要尽可能的隐藏自己的身份,以防被服务器屏蔽,在工作工程中,我们有2种方式来实现这一目的,分别是延时访问和动态代理,接下来我们会对这两种方式进行讲解

1、延时访问

见名之意,延时访问就是在访问网站时设置一个访问周期,每隔几秒钟访问一次,这样的方式更像是人为访问网站

-

import time

-

import urllib.request

-

-

cnt = 0

-

#隐藏自己爬虫的身份的第一种策略是设置访问周期,使得程序更像是人为访问的

-

while True: #每隔5秒钟访问一次百度网

-

url = "https://www.baidu.com" #设置url地址

-

param = {} #设置参数,参数是字典

-

param = urllib.parse.urlencode(param).encode('utf_8') #将参数以utf-8编码方式来编码

-

-

req = urllib.request.Request(url, param)

-

#设置header的User-Agent属性,模拟该请求是由狐火浏览器发送的,也就是说欺骗服务器是人为发送的并未程序发送的

-

req.add_header("User-Agent", "Mozilla/5.0 (Macintosh; Intel Mac OS X 10.12; rv:53.0) Gecko/20100101 Firefox/53.0")

-

response = urllib.request.urlopen(req) #访问网络

-

-

html = response.read() #读取响应的结果

-

result = html.decode("utf-8") #按照utf-8编码来进行解码

-

if result != "":

-

cnt += 1

-

print("第%s次攻击百度网" %cnt)

-

time.sleep(5) #程序睡眠5秒钟

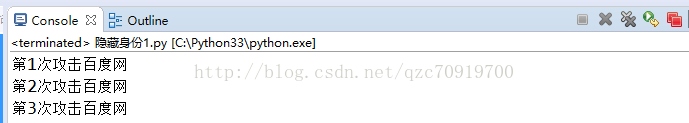

运行结果:

每隔5秒钟访问一次百度网

2、动态代理

使用代理服务器来访问网站,这种方法非常霸道,可以模拟出不同的服务器访问网站,也是最为推荐的一种方式,我们可以在百度网上查找免费的代理服务器IP

-

import urllib.request

-

import random

-

-

ipList = ['119.6.144.73:81', '183.203.208.166:8118', '111.1.32.28:81'] #定义多个代理IP,代理IP可以在网上搜免费的

-

cnt = 0

-

#隐藏自己爬虫的身份的第二种策略是使用代理,意思是模拟多个服务器访问

-

while True: #使用代理服务器不停的访问百度网

-

proxy_support = urllib.request.ProxyHandler({'http':random.choice(ipList)}) #定义一个代理对象,使用随机的ip

-

-

opener = urllib.request.build_opener(proxy_support)

-

opener.add_handlers = [("User-Agent", "Mozilla/5.0 (Macintosh; Intel Mac OS X 10.12; rv:53.0) Gecko/20100101 Firefox/53.0")]

-

urllib.request.install_opener(opener)

-

-

response = urllib.request.urlopen("https://www.baidu.com") #访问网络

-

-

html = response.read() #读取响应的结果

-

result = html.decode("utf-8") #按照utf-8编码来进行解码

-

if result != "":

-

cnt += 1

-

print("第%s次攻击百度网" %cnt)

运行结果:

不停的攻击百度网

Python实战:如何隐藏自己的爬虫身份的更多相关文章

- Python实战:Python爬虫学习教程,获取电影排行榜

Python应用现在如火如荼,应用范围很广.因其效率高开发迅速的优势,快速进入编程语言排行榜前几名.本系列文章致力于可以全面系统的介绍Python语言开发知识和相关知识总结.希望大家能够快速入门并学习 ...

- 零基础入门Python实战:四周实现爬虫网站 Django项目视频教程

点击了解更多Python课程>>> 零基础入门Python实战:四周实现爬虫网站 Django项目视频教程 适用人群: 即将毕业的大学生,工资低工作重的白领,渴望崭露头角的职场新人, ...

- Python实战:美女图片下载器,海量图片任你下载

Python应用现在如火如荼,应用范围很广.因其效率高开发迅速的优势,快速进入编程语言排行榜前几名.本系列文章致力于可以全面系统的介绍Python语言开发知识和相关知识总结.希望大家能够快速入门并学习 ...

- 再一波Python实战项目列表

前言: 近几年Python可谓是大热啊,很多人都纷纷投入Python的学习中,以前我们实验楼总结过多篇Python实战项目列表,不但有用还有趣,最主要的是咱们实验楼不但有详细的开发教程,更有在线开发环 ...

- (转)Python新手写出漂亮的爬虫代码2——从json获取信息

https://blog.csdn.net/weixin_36604953/article/details/78592943 Python新手写出漂亮的爬虫代码2——从json获取信息好久没有写关于爬 ...

- Python实战之自己主动化评论

Python实战之自己主动化评论 玩csdn博客一个多月了,渐渐发现了一些有意思的事,常常会有人用相同的评论到处刷.不知道是为了加没什么用的积分,还是纯粹为了表达楼主好人.那么问题来了,这种无聊的事情 ...

- python scrapy版 极客学院爬虫V2

python scrapy版 极客学院爬虫V2 1 基本技术 使用scrapy 2 这个爬虫的难点是 Request中的headers和cookies 尝试过好多次才成功(模拟登录),否则只能抓免费课 ...

- zeromq 学习和python实战

参考文档: 官网 http://zeromq.org/ http://www.cnblogs.com/rainbowzc/p/3357594.html 原理解读 zeromq只是一层针对socke ...

- 【python】一个简单的贪婪爬虫

这个爬虫的作用是,对于一个给定的url,查找页面里面所有的url连接并依次贪婪爬取 主要需要注意的地方: 1.lxml.html.iterlinks() 可以实现对页面所有url的查找 2.获取页面 ...

随机推荐

- 【解决方法】Unexpected namespace prefix “xmlns” found for tag Layout

问题描写叙述 出错代码例如以下: <LinearLayout xmlns:android="http://schemas.android.com/apk/res/android&quo ...

- 开源课程管理系统(CMS):Moodle

开源课程管理系统(CMS):Moodle 一.总结 1.php开发的cms,可借鉴参考用 二.Moodle(百度) Moodle(Modular Object-Oriented Dynamic Lea ...

- HDF文件的显示策略

作者:朱金灿 来源:http://blog.csdn.net/clever101 hdf格式(类似还有netcdf格式)格式是国际上通用的遥感数据格式.它们都是采用不规则存储的格式,就是在一个hdf文 ...

- 11G、12C Data Guard Physical Standby Switchover转换参考手册

Switchover转换 Step 1: switchover 切换先前检查 (1)确保主备两端log_archive_config和db_unique_name参数都已经正确设置. 需要注意的是 ...

- Android 监听电量的状态

监控手机电量的变化和充电状态 在BatteryManager中有一个粘性广播,不需要BroadcastReceiver作为接收器,在注册时将传入null IntentFilter filter = n ...

- amazeui学习笔记--css(常用组件16)--文章页Article

amazeui学习笔记--css(常用组件16)--文章页Article 一.总结 1.基本使用:文章内容页的排版样式,包括标题.文章元信息.分隔线等样式. .am-article 文章内容容器 .a ...

- 网络IO

1.前言 在网络编程中,阻塞.非阻塞.同步.异步经常被提到.unix网络编程第一卷第六章专门讨论五种不同的IO模型,Stevens讲的非常详细,我记得去年看第一遍时候,似懂非懂,没有深入理解.网上有详 ...

- 6.1、Android硬件访问服务之框架

1.通过前面led点亮的例子,其流程如下 Android app(java)(通过loadLibrary)——>C library(C库做如下事情)——>1.JNI_Onload 2.jn ...

- JAVA 如何将String进行大小写转换

private String convertString(String str, Boolean beginUp){ char[] ch = str.toCharArray(); StringBuff ...

- 一个例子讲解wav头文件 stm32声音程序 录音和播放 wav

下面我们一wav头文件来分析一下: 下面是双声道的,16位,48000采样录的wav文件: 打开属性,能看到的有用信息只有比特率了: 上图的比特率就是 wav头文件里的bitrate: 1536kbp ...