Python pytagcloud 中文分词 生成标签云 系列(一)

转载地址:https://zhuanlan.zhihu.com/p/20432734

工具

Python 2.7 (前几天试了试 Scrapy 所以用的 py2 。血泪的教训告诉我们能用 py3 千万别用 py2 ,编码问题累死人)

jieba 结巴分词 fxsjy/jieba · GitHub

pytagcloud 词云生成 atizo/PyTagCloud · GitHub

安装过程应该没什么坑,不像 Scrapy 光安装都能写一篇出来。自行补充依赖就好。

Step 1 爬虫抓取文本

这个阶段比较简单。虽然我欠了半年的爬虫系列一直没有写,但是抓个贴子标题都不涉及模拟登陆,对入门的人应该问题不大。随便改了一下以前的代码就跑出来了。

# -*- coding: utf-8 -*- import requests

import re

import os

import codecs def get_title(url):

s = requests.session()

h = s.get(url)

html = h.content.decode('utf-8')

#print html qurl = r'<a href="forum.*? class="s xst">(.*?)</a>'

qurllist = re.findall(qurl,html)

#print qurllist for each in qurllist:

f = codecs.open("result.txt", 'a', 'utf-8')

f.write(each+'\n')

print each

#f.flush()

f.close() for i in range(1,1000):

url = 'http://rs.xidian.edu.cn/forum.php?mod=forumdisplay&fid=72&page='+str(i)

get_title(url)

值得注意的还是编码问题,用 py3 的可以忽略。

Step 2 中文分词,提取关键词

jieba 的分词效果还是比较理想的。不过我在统计词频的时候一时没想起什么太好的解决办法,加上编码问题把我烦的够呛。于是偷懒地选择了 jieba 自带的提取关键词并给出权重的功能。

详见 jieba/extract_tags.py at master · fxsjy/jieba · GitHub

import sys

sys.path.append('../') import jieba

import jieba.analyse

from optparse import OptionParser USAGE = "usage: python extract_tags_with_weight.py [file name] -k [top k] -w [with weight=1 or 0]" parser = OptionParser(USAGE)

parser.add_option("-k", dest="topK")

parser.add_option("-w", dest="withWeight")

opt, args = parser.parse_args() if len(args) < 1:

print(USAGE)

sys.exit(1) file_name = args[0] if opt.topK is None:

topK = 10

else:

topK = int(opt.topK) if opt.withWeight is None:

withWeight = False

else:

if int(opt.withWeight) is 1:

withWeight = True

else:

withWeight = False content = open(file_name, 'rb').read() tags = jieba.analyse.extract_tags(content, topK=topK, withWeight=withWeight) if withWeight is True:

for tag in tags:

print("tag: %s\t\t weight: %f" % (tag[0],tag[1]))

else:

print(",".join(tags))

需要命令行运行。

先 cd 到目录,然后使用命令

python extract_tags_with_weight.py [file name] -k [top k] -w [with weight=1 or 0]

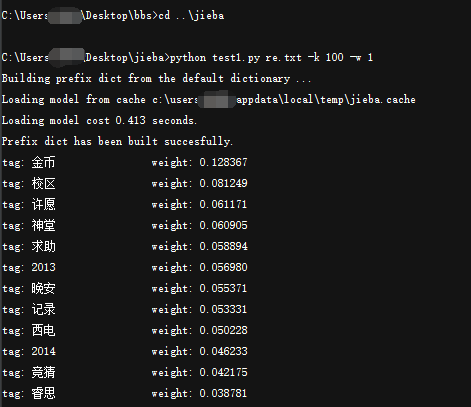

其中 -k 后输入关键词个数 -w 选择是否显示权重。如图:(具体的文本和结果我后面打包发一下,就不贴了)

说明:

说明:

其实标准的过程应该是分词以后统计词频,生成 k-v 的 Python 字典然后交由 pytagcloud 生成词云。由于我也是刚接触分词这块,不太熟悉,统计词频时力不从心,所以直接用了现成的关键词提取。

另外由于生成词云时需要的格式为 Python 字典(k-v),我自己在中间用 Notepad++ 和 Excel 做了一些文本上的预处理,这方面就八仙过海各显神通了。

还有,我使用了默认词典,没有自定义内容(jieba 是可以自定义词典的),所以一些词在提取时出现偏差,比如"新校区"、"老校区"就全部提成了"校区",X号楼只保留下来了"号楼"。另外我没有做词性筛选,导致许多无意义副词出现在结果里,后面生成词云时自己手动去掉了。

Step 3 生成词云

关于 pytagcloud ,搜到的唯一一篇比较有价值的文章就是Python中文标签云之pytagcloud 更多的还是要参考官方示例 atizo/PyTagCloud · GitHub 。我也没把功能全试完,大家可以自己向深处挖掘。

# -*- coding: utf-8 -*-

import codecs

import random

from pytagcloud import create_tag_image, create_html_data, make_tags, \

LAYOUT_HORIZONTAL, LAYOUTS

from pytagcloud.colors import COLOR_SCHEMES

from pytagcloud.lang.counter import get_tag_counts wd = {} fp=codecs.open("rsa.txt", "r",'utf-8'); alllines=fp.readlines(); fp.close(); for eachline in alllines:

line = eachline.split(' ')

#print eachline,

wd[line[0]] = int(line[1])

print wd from operator import itemgetter

swd = sorted(wd.iteritems(), key=itemgetter(1), reverse=True)

tags = make_tags(swd,minsize = 50, maxsize = 240,colors=random.choice(COLOR_SCHEMES.values()))

create_tag_image(tags, 'keyword_tag_cloud4.png', background=(0, 0, 0, 255),

size=(2400, 1000),layout=LAYOUT_HORIZONTAL,

fontname="SimHei")

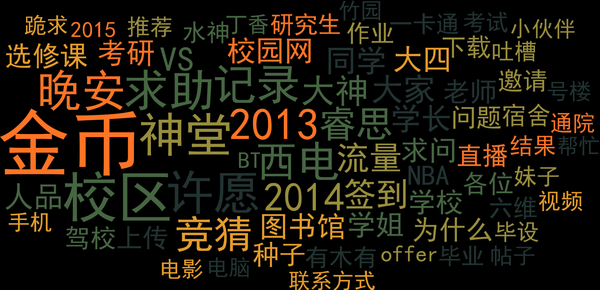

输出结果如图。

补充:使用 pytagcloud 一定要记得添加中文字体并修改其配置文件,具体方法:

准备一个 ttf 中文字体,如 simhei.ttf ,将其移动到 C:\Users\~\AppData\Roaming\Python\Python27\site-packages\pytagcloud\fonts

并修改该文件夹下的 fonts.json 文件,添加相应的字体记录,如

{

"name": "SimHei",

"ttf": "simhei.ttf",

"web": "none"

},

输出结果还是比较有趣的,不过校外的人可能不熟悉。当然这本身也只是个很入门的东西,算作娱乐吧。

代码部分原创的不多…很多是网上拼拼凑凑找的。但是 pytagcloud 相关的内容搜出来比较少,对中文支持也需要自己修改,有人要自己做的话最好用谷歌搜索,然后参考前几篇文章和官方示例自己尝试。

在此顺便吐槽百度一发,实在难用,百度搜来搜去的结果,远不如谷歌直击要害。当然英语好就更棒了,能直接读文档和看 stackoverflow 。

想要自己尝试的可以用我这次的文档,或者自己抓感兴趣的资料。

http://pan.baidu.com/s/1mhn4mN2

拓展的话,感兴趣的可以多尝试几款分词比较一下。具体的就不推荐了我也不了解,搜一下会有很多,功能很丰富,语义分析,情感倾向,都有,可玩性比较高吧。

另外有另一款 Python 下的词云生成器 amueller/word_cloud · GitHub 留作以后研究吧。另外过程中看文章时发现好多词频统计和标签云是用 R 做的,有机会可以学习一下。

噢对了, pytagcloud 支持直接生成 HTML 网页的标签云,官方 demo 里有,我这边没做,就不展示了。

Python pytagcloud 中文分词 生成标签云 系列(一)的更多相关文章

- python3生成标签云

标签云是现在大数据里面最喜欢使用的一种展现方式,其中在python3下也能实现标签云的效果,贴图如下: -------------------进入正文--------------------- 首先要 ...

- Python word_cloud 样例 标签云系列(三)

转载地址:https://zhuanlan.zhihu.com/p/20436642word_cloud/examples at master · amueller/word_cloud · GitH ...

- Python word_cloud 部分文档翻译 标签云系列(二)

转载地址:https://zhuanlan.zhihu.com/p/20436581上文末尾提到 Python 下还有一款词云生成器.amueller/word_cloud · GitHub 可以直接 ...

- Python3+pdfminer+jieba+wordcloud+matplotlib生成词云(以深圳十三五规划纲要为例)

一.各库功能说明 pdfminer----用于读取pdf文件的内容,python3安装pdfminer3k jieba----用于中文分词 wordcloud----用于生成词云 matplotlib ...

- WordPress彩色背景标签云实现

网上有很多的这种效果,但是却几乎没有什么关于彩色背景标签云的教程,网上讲的基本都是让标签云的字体变成彩色而不是背景,我觉得让字体变成彩色有的标签会看不清楚,而且也没有让背景变成彩色好看.先看看效果: ...

- 使用jieba和wordcloud进行中文分词并生成《悲伤逆流成河》词云

因为词云有利于体现文本信息,所以我就将那天无聊时爬取的<悲伤逆流成河>的评论处理了一下,生成了词云. 关于爬取影评的爬虫大概长这个样子(实际上是没有爬完的): #!/usr/bin/env ...

- NLP+词法系列(二)︱中文分词技术简述、深度学习分词实践(CIPS2016、超多案例)

摘录自:CIPS2016 中文信息处理报告<第一章 词法和句法分析研究进展.现状及趋势>P4 CIPS2016 中文信息处理报告下载链接:http://cips-upload.bj.bce ...

- Python第三方库jieba(中文分词)入门与进阶(官方文档)

jieba "结巴"中文分词:做最好的 Python 中文分词组件 github:https://github.com/fxsjy/jieba 特点 支持三种分词模式: 精确模式, ...

- Python3.7+jieba(结巴分词)配合Wordcloud2.js来构造网站标签云(关键词集合)

原文转载自「刘悦的技术博客」https://v3u.cn/a_id_138 其实很早以前就想搞一套完备的标签云架构了,迫于没有时间(其实就是懒),一直就没有弄出来完整的代码,说到底标签对于网站来说还是 ...

随机推荐

- 微软职位内部推荐-Software Engineer II_VS

微软近期Open的职位: Job Title: Software Engineer II Division: Visual Studio China – Developer Division Work ...

- Navicat新建查询,系统找不到指定路径 独家解决办法

Navicat新建查询系统找不到指定路径,很多人用了网上流行的那些解决办法,还是无法解决.比如: https://jingyan.baidu.com/article/86112f1387a713273 ...

- OGG 跳过事务(转)

http://blog.chinaunix.net/uid-26190993-id-3434074.html 在OGG运行过程中,通常会因为各种各样的原因导致容灾端的REPLICAT进程ABEN ...

- 使用socket发送http请求(get/post)

手动发送http请求 解释说明 https://blog.csdn.net/zhangliang_571/article/details/23508953 http://www.cnblogs.com ...

- Daily Scrum (2015/11/3)

今天我们的爬虫能在pc上成功运行并且把所爬取的数据存到服务器上了!我们已经搭建好数据库,把相关信息存到数据库中,并把数据存到D盘里共享给数据处理小组使用. 成员 今日工作 时间 明日工作 符美潇 完成 ...

- github基础操作

1.最简单实用的操作 更新远程仓库 git status git add . git commit -m "add" git push #git push -u origin ma ...

- Codeforces Round #299 (Div. 2) D. Tavas and Malekas kmp

题目链接: http://codeforces.com/problemset/problem/535/D D. Tavas and Malekas time limit per test2 secon ...

- C51中的关键字data,idata,xdata,pdata,bdata

写在最前面的话:官方网站的解答是最可信的.英语不错的必看.http://www.keil.com/support/man/docs/c51/c51_le_memtypes.htm 下面转载几篇中文的, ...

- 前端基础(http协议相关篇)

网络协议篇: 1.http请求过程 DNS解析——tcp三次握手——建立tcp连接后发起http请求——服务器响应http请求 ——浏览器得到资源——浏览器渲染 2.http报文 通用首部:可以出现在 ...

- JabRef学习笔记(一)

JabRef简介 JabRef is an open source bibliography reference manager. The native file format used by Jab ...