协程与concurent.furtrue实现线程池与进程池

1concurent.furtrue实现线程池与进程池

2协程

1concurent.furtrue实现线程池与进程池

实现进程池

#进程池

from concurrent.futures import ProcessPoolExecutor

import os,time,random

def task(n):

print('%s is running' %os.getpid())

time.sleep(2)

return n**2 if __name__ == '__main__':

p=ProcessPoolExecutor()#实例化

l=[]

start=time.time()

for i in range(10):

obj=p.submit(task,i)

l.append(obj)

p.shutdown()

print('='*30)

# print([obj for obj in l])

print([obj.result() for obj in l])

print(time.time()-start)

线程池

from concurrent.futures import ThreadPoolExecutor

import threading

import os,time,random

def task(n):

print('%s:%s is running' %(threading.currentThread().getName(),os.getpid()))

time.sleep(2)#相当于I/O操作

return n**2 if __name__ == '__main__':

p=ThreadPoolExecutor()

l=[]

start=time.time()

for i in range(10):

obj=p.submit(task,i)#返回的obj是一个对象,需要用rusult()取出

l.append(obj)

p.shutdown()#相当于close和join方法一起用的

print('='*30)

print([obj.result() for obj in l])

print(time.time()-start)

不管是线程还是进程都可以使用:# p.submit(task,i).result()即同步执行例如:

# p.submit(task,i).result()即同步执行

from concurrent.futures import ProcessPoolExecutor,ThreadPoolExecutor

import os,time,random

def task(n):

print('%s is running' %os.getpid())

time.sleep(2)

return n**2 if __name__ == '__main__':

p=ProcessPoolExecutor()

start=time.time()

for i in range(10):

res=p.submit(task,i).result()#这种方法耗时比较多,不推荐使用

print(res)

print('='*30)

print(time.time()-start)

map方法

from concurrent.futures import ProcessPoolExecutor,ThreadPoolExecutor

import os,time,random

def task(n):

print('%s is running' %os.getpid())

time.sleep(2)

return n**2 if __name__ == '__main__':

p=ProcessPoolExecutor()

obj=p.map(task,range(10))

p.shutdown()

print('='*30)

print(list(obj))#map方法需要用list

回调函数

from concurrent.futures import ProcessPoolExecutor,ThreadPoolExecutor

import requests

import os

import time

from threading import currentThread

def get_page(url):

print('%s:<%s> is getting [%s]' %(currentThread().getName(),os.getpid(),url))

response=requests.get(url)

time.sleep(2)

return {'url':url,'text':response.text}

def parse_page(res):

res=res.result()#返回的是一个一个对象需要得到值,

print('%s:<%s> parse [%s]' %(currentThread().getName(),os.getpid(),res['url']))

with open('db.txt','a') as f:

parse_res='url:%s size:%s\n' %(res['url'],len(res['text']))

f.write(parse_res)

if __name__ == '__main__':

# p=ProcessPoolExecutor()

p=ThreadPoolExecutor()

urls = [

'https://www.baidu.com',

'https://www.baidu.com',

'https://www.baidu.com',

'https://www.baidu.com',

'https://www.baidu.com',

'https://www.baidu.com',

] for url in urls:

# multiprocessing.pool_obj.apply_async(get_page,args=(url,),callback=parse_page)

p.submit(get_page, url).add_done_callback(parse_page)

p.shutdown()

print('主',os.getpid())

2.协程

引子:

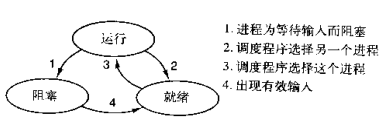

本节主题是实现单线程下的并发,即只在一个主线程,并且很明显的是,可利用的cpu只有一个情况下实现并发,为此我们需要先回顾下并发的本质:切换+保存状态

cpu正在运行一个任务,会在两种情况下切走去执行其他的任务(切换由操作系统强制控制),一种情况是该任务发生了阻塞,另外一种情况是该任务计算的时间过长。我们希望程序一直在运行状态或者就绪状态而不是在阻塞状态。

是单线程下的并发,又称微线程,纤程。英文名Coroutine。一句话说明什么是线程:协程是一种用户态的轻量级线程,即协程是由用户程序自己控制调度的。

#1. python的线程属于内核级别的,即由操作系统控制调度(如单线程遇到io或执行时间过长就会被迫交出cpu执行权限,切换其他线程运行)

#2. 单线程内开启协程,一旦遇到io,就会从应用程序级别(而非操作系统)控制切换,以此来提升效率(!!!非io操作的切换与效率无关)

对比操作系统控制线程的切换,用户在单线程内控制协程的切换

优点如下:

#1. 协程的切换开销更小,属于程序级别的切换,操作系统完全感知不到,因而更加轻量级

#2. 单线程内就可以实现并发的效果,最大限度地利用cpu

缺点如下:

#1. 协程的本质是单线程下,无法利用多核,可以是一个程序开启多个进程,每个进程内开启多个线程,每个线程内开启协程

#2. 协程指的是单个线程,因而一旦协程出现阻塞,将会阻塞整个线程

总结协程特点:

- 必须在只有一个单线程里实现并发

- 修改共享数据不需加锁

- 用户程序里自己保存多个控制流的上下文栈

- 附加:一个协程遇到IO操作自动切换到其它协程(如何实现检测IO,yield、greenlet都无法实现,就用到了gevent模块(select机制))

Greenlet

如果我们在单个线程内有20个任务,要想实现在多个任务之间切换,使用yield生成器的方式过于麻烦(需要先得到初始化一次的生成器,然后再调用send。。。非常麻烦),而使用greenlet模块可以非常简单地实现这20个任务直接的切换

from greenlet import greenlet

import time

def eat(name):

print('%s eat 1' %name)

time.sleep(10)

g2.switch('egon')

print('%s eat 2' %name)

g2.switch()

def play(name):

print('%s play 1' %name)

g1.switch()

print('%s play 2' %name) g1=greenlet(eat)

g2=greenlet(play) g1.switch('egon')#可以在第一次switch时传入参数,以后都不需要

单纯的切换(在没有io的情况下或者没有重复开辟内存空间的操作),反而会降低程序的执行速度

#顺序执行

import time

def f1():

res=1

for i in range(100000000):

res+=i def f2():

res=1

for i in range(100000000):

res*=i start=time.time()

f1()

f2()

stop=time.time()

print('run time is %s' %(stop-start)) #10.985628366470337 #切换

from greenlet import greenlet

import time

def f1():

res=1

for i in range(100000000):

res+=i

g2.switch() def f2():

res=1

for i in range(100000000):

res*=i

g1.switch() start=time.time()

g1=greenlet(f1)

g2=greenlet(f2)

g1.switch()

stop=time.time()

print('run time is %s' %(stop-start)) # 52.763017892837524

greenlet只是提供了一种比generator更加便捷的切换方式,当切到一个任务执行时如果遇到io,那就原地阻塞,仍然是没有解决遇到IO自动切换来提升效率的问题。

单线程里的这20个任务的代码通常会既有计算操作又有阻塞操作,我们完全可以在执行任务1时遇到阻塞,就利用阻塞的时间去执行任务2。。。。如此,才能提高效率,这就用到了Gevent模块。

from gevent import monkey;monkey.patch_all()#补丁

import gevent

import time

def eat(name):

print('%s eat 1' %name)

time.sleep(2)

print('%s eat 2' %name)

return 'eat' def play(name):

print('%s play 1' %name)

time.sleep(3)

print('%s play 2' %name)

return 'play' start=time.time()

g1=gevent.spawn(eat,'egon')#传入参数

g2=gevent.spawn(play,'egon')#传入参数

# g1.join()

# g2.join()

gevent.joinall([g1,g2])

print('主',(time.time()-start))

print(g1.value)

print(g2.value)

#爬虫应用

from gevent import monkey;monkey.patch_all()

import gevent

import requests

import time def get_page(url):

print('GET: %s' %url)

response=requests.get(url)

if response.status_code == 200:

print('%d bytes received from %s' %(len(response.text),url)) start_time=time.time() # get_page('https://www.python.org/')

# get_page('https://www.yahoo.com/')

# get_page('https://github.com/') g1=gevent.spawn(get_page, 'https://www.python.org/')#传入参数

g2=gevent.spawn(get_page, 'https://www.yahoo.com/')

g3=gevent.spawn(get_page, 'https://github.com/') gevent.joinall([g1,g2,g3])

stop_time=time.time()

print('run time is %s' %(stop_time-start_time))

用协程实现服务端与客户端

服务端

from gevent import monkey;monkey.patch_all()

import gevent

from socket import *

def talk(conn,addr):

while True:

data=conn.recv(1024)

print('%s:%s %s' %(addr[0],addr[1],data))

conn.send(data.upper())

conn.close() def server(ip,port):

s = socket(AF_INET, SOCK_STREAM)

s.setsockopt(SOL_SOCKET, SO_REUSEADDR, 1)

s.bind((ip,port))

s.listen(5)

while True:

conn,addr=s.accept()

gevent.spawn(talk,conn,addr)

s.close() if __name__ == '__main__':

server('127.0.0.1', 8088)

客户端

from multiprocessing import Process

from socket import *

def client(server_ip,server_port):

client=socket(AF_INET,SOCK_STREAM)

client.connect((server_ip,server_port))

while True:

client.send('hello'.encode('utf-8'))

msg=client.recv(1024)

print(msg.decode('utf-8')) if __name__ == '__main__':

for i in range(500):

p=Process(target=client,args=('127.0.0.1',8088))

p.start()

协程与concurent.furtrue实现线程池与进程池的更多相关文章

- Python 线程池,进程池,协程,和其他

本节内容 线程池 进程池 协程 try异常处理 IO多路复用 线程的继承调用 1.线程池 线程池帮助你来管理线程,不再需要每个任务都创建一个线程进行处理任务. 任务需要执行时,会从线程池申请线程,有则 ...

- 线程池、进程池(concurrent.futures模块)和协程

一.线程池 1.concurrent.futures模块 介绍 concurrent.futures模块提供了高度封装的异步调用接口 ThreadPoolExecutor:线程池,提供异步调用 Pro ...

- python爬虫之线程池和进程池

一.需求 最近准备爬取某电商网站的数据,先不考虑代理.分布式,先说效率问题(当然你要是请求的太快就会被封掉,亲测,400个请求过去,服务器直接拒绝连接,心碎),步入正题.一般情况下小白的我们第一个想到 ...

- 多进程 multiprocessing 多线程Threading 线程池和进程池concurrent.futures

multiprocessing.procsess 定义一个函数 def func():pass 在if __name__=="__main__":中实例化 p = process( ...

- python之线程池和进程池

线程池和进程池 一.池的概念 池是用来保证计算机硬件安全的情况下最大限度的利用计算机 它降低了程序的运行效率但是保证了计算机硬件的安全从而让你写的程序能够正常运行 ''' 无论是开设进程也好还是开设线 ...

- 使用concurrent.futures模块中的线程池与进程池

使用concurrent.futures模块中的线程池与进程池 线程池与进程池 以线程池举例,系统使用多线程方式运行时,会产生大量的线程创建与销毁,创建与销毁必定会带来一定的消耗,甚至导致系统资源的崩 ...

- concurrent.futures模块简单介绍(线程池,进程池)

一.基类Executor Executor类是ThreadPoolExecutor 和ProcessPoolExecutor 的基类.它为我们提供了如下方法: submit(fn, *args, ** ...

- Python线程池与进程池

Python线程池与进程池 前言 前面我们已经将线程并发编程与进程并行编程全部摸了个透,其实我第一次学习他们的时候感觉非常困难甚至是吃力.因为概念实在是太多了,各种锁,数据共享同步,各种方法等等让人十 ...

- day 7-7 线程池与进程池

一. 进程池与线程池 在刚开始学多进程或多线程时,我们迫不及待地基于多进程或多线程实现并发的套接字通信,然而这种实现方式的致命缺陷是:服务的开启的进程数或线程数都会随着并发的客户端数目地增多而增多,这 ...

随机推荐

- 图像边缘检测——几种图像边缘检测算子的学习及python 实现

本文学习利用python学习边缘检测的滤波器,首先读入的图片代码如下: import cv2 from pylab import * saber = cv2.imread("construc ...

- C++基础知识小记

最近在帮华为接口人研究自动化部署项目AutoDeploy,把代码发给我了,不过都是用C++写的,自己虽然在大学也学了一学期的C++不过也是很菜鸟,只是学了基本语法,还远未达到实战项目,不管怎么说就是撸 ...

- 初始mvc4(一) 新建项目

mvc4和mvc4.5基本大同小异,vs2012中已经集成了mvc,不需要手动安装了,现在就来看看如何新建mvc项目 一.首先打开vs2012,新建项目,选中web中mvc4 二.选择项目模板 这里面 ...

- T-SQL:开窗函数(十二)

1.基本概念 开窗函数分为两个部分分别是 1.聚合,排名,偏移,分布函数 . 2.开窗分区,排序,框架. 下面举个例子 SELECT empid, ordermonth, val, SUM(val) ...

- Internet Download Manager IDM 破解器

IDM 全名Internet Download Manager 是一款国外的多线程下载神器(简称IDM),Internet Download Manager 支持多媒体下载.自动捕获链接.自动识别文 ...

- 获取url参数的方法(web)

//获取url参数的方法(web) function GetQueryString(name) { var reg = new RegExp("(^|&)" + n ...

- PHP会话(Session)实现用户登陆功能 转自#落人间#

对比起 Cookie,Session 是存储在服务器端的会话,相对安全,并且不像 Cookie 那样有存储长度限制,本文简单介绍 Session 的使用. 由于 Session 是以文本文件形式存储在 ...

- loadrunner 脚本开发-调用java jar文件远程操作Oracle数据库测试

调用java jar文件远程操作Oracle数据库测试 by:授客 QQ:1033553122 测试环境 数据库:linux 下Oracle_11g_R2 Loadrunner:11 备注:想学ora ...

- Java虚拟机(一)结构原理与运行时数据区域

我们来学习Java虚拟机的结构原理与运行时数据区域. 1.Java虚拟机概述 Oracle官方定义的Java技术体系主要包括以下几个部分: Java程序设计语言 各种平台的Java虚拟机 Class文 ...

- OneAPM大讲堂 | Java 异常日志记录最佳实践

[编者按]本文作者是 Casey Dunham.Casey 是一位具有 10 多年经验的专业软件开发人员,以其独特的方式应对应用安全问题而闻名.本文系国内 ITOM 管理平台 OneAPM 工程师编译 ...