大数据基础总结---HDFS分布式文件系统

HDFS分布式文件系统

文件系统的基本概述

- 文件系统定义:文件系统是一种存储和组织计算机数据的方法,它使得对其访问和查找变得容易。

- 文件名:在文件系统中,文件名是用于定位存储位置。

- 元数据(Metadata):保存文件属性的数据,如文件名,文件长度,文件所属用户组,文件存储位置等。

- 数据块(Block):存储文件的最小单元。对存储介质划分了固定的区域,使用时按这些区域分配使用。

HDFS的概述

HDFS(Hadoop Distributed File System)基于Google发布的GFS论文设计开发。

HDFS是Hadoop技术框架中的分布式文件系统,对部署在多台独立物理机器上的文件进行管理。

可用于多种场景,如: 网站用户行为数据存储。 生态系统数据存储。 气象数据存储。

HDFS的优点和缺点

其除具备其它分布式文件系统相同特性外,还有自己特有的特性:

- 高容错性:认为硬件总是不可靠的。

- 高吞吐量:为大量数据访问的应用提供高吞吐量支持。

- 大文件存储:支持存储TB-PB级别的数据。

不适用场景

[1] 低时间延迟数据访问的应用,例如几十毫秒范围。

- 原因:HDFS是为高数据吞吐量应用优化的,这样就会造成以高时间延迟为代价。

[2] 大量小文件 。

- 原因:NameNode启动时,将文件系统的元数据加载到内存,因此文件系统所能存储的文件总数受限于NameNode内存容量。,那么需要的内存空间将是非常大的。

[3] 多用户写入,任意修改文件。

- 原因:现在HDFS文件只有一个writer,而且写操作总是写在文件的末尾。

流式数据访问

- 流式数据访问:在数据集生成后,长时间在此数据集上进行各种分析。每次分析都将涉及该数据集的大部分数据甚至全部数据,因此读取整个数据集的时间延迟比读取第一条记录的时间延迟更重要。

- 与流数据访问对应的是随机数据访问:它要求定位、查询或修改数据的延迟较小,比较适合于创建数据后再多次读写的情况,传统关系型数据库很符合这一点。

HDFS的架构

HDFS架构包含三个部分:NameNode,DataNode,Client。

- NameNode:NameNode用于存储、生成文件系统的元数据。运行一个实例。

- DataNode:DataNode用于存储实际的数据,将自己管理的数据块上报给NameNode ,运行多个实例。

- Client:支持业务访问HDFS,从NameNode ,DataNode获取数据返回给业务。多个实例,和业务一起运行。

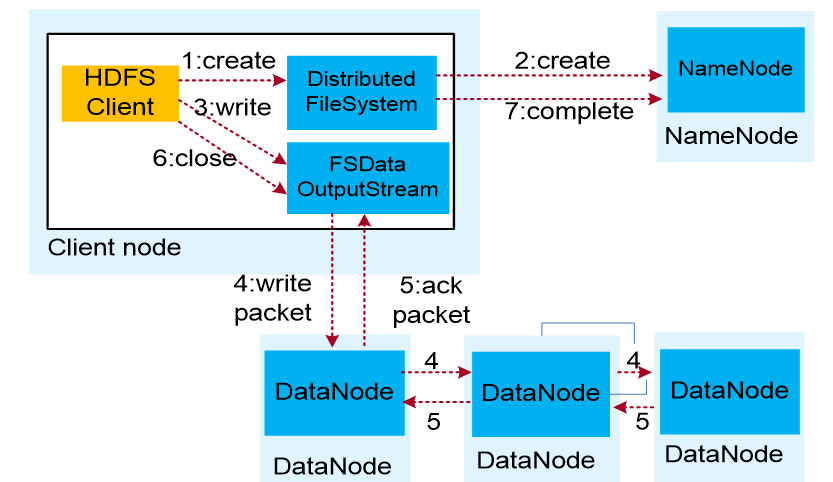

HDFS数据的写入流程

- 业务应用调用HDFS Client提供的API,请求写入文件。

- HDFS Client联系NameNode,NameNode在元数据中创建文件节点。

- 业务应用调用write API写入文件。

- HDFS Client收到业务数据后,从NameNode获取到数据块编号、位置信息后,联系DataNode,并将需要写入数据的DataNode建立起流水线。完成后,客户端再通过自有协议写入数据到DataNode1,再由DataNode1复制到DataNode2, DataNode3。

- 写完的数据,将返回确认信息给HDFS Client。

- 所有数据确认完成后,业务调用HDFS Client关闭文件。

- 业务调用close, flush后HDFSClient联系NameNode,确认数据写完成,NameNode持久化元数据。

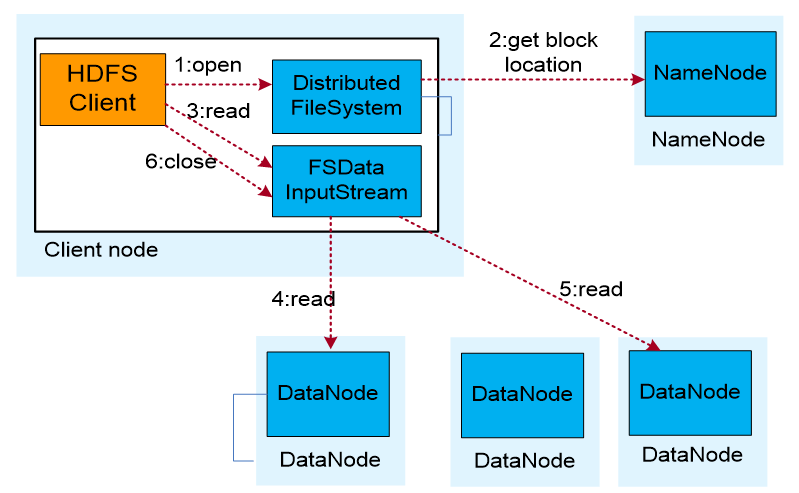

HDFS数据的读取流程

- 业务应用调用HDFS Client提供的API打开文件。

- HDFS Client联系NameNode,获取到文件信息(数据块、DataNode位置信息)。

- 业务应用调用read API读取文件。

- HDFS Client根据从NameNode获取到的信息,联系DataNode,获取相应的数据块。(Client采用就近原则读取数据)。

- HDFS Client会与多个DataNode通讯获取数据块。

- 数据读取完成后,业务调用close关闭连接。

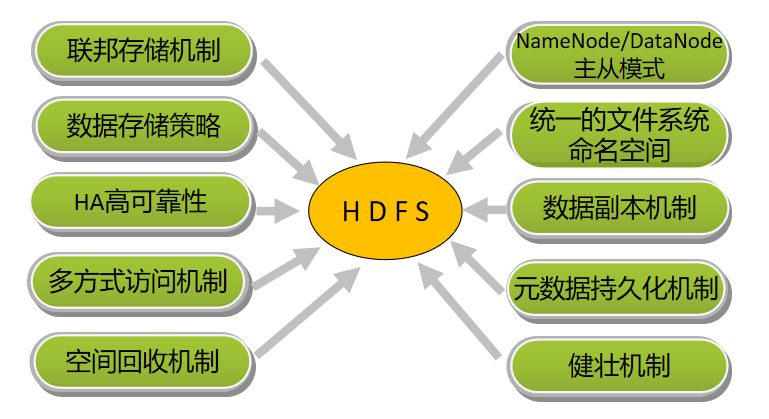

HDFS的关键特性

HDFS的高可靠性(HA)

- HDFS的高可靠性(HA)主要体现在利用zookeeper实现主备NameNode,以解决单点NameNode故障问题。

- ZooKeeper主要用来存储HA下的状态文件,主备信息。ZK个数建议3个及以上且为奇数个。

- NameNode主备模式,主提供服务,备同步主元数据并作为主的热备。

- ZKFC(ZooKeeper Failover Controller)用于监控NameNode节点的主备状态。

- JN(JournalNode)用于存储Active NameNode生成的Editlog。Standby NameNode加载JN上Editlog,同步元数据。

ZKFC控制NameNode主备仲裁

- ZKFC作为一个精简的仲裁代理,其利用zookeeper的分布式锁功能,实现主备仲裁,再通过命令通道,控制NameNode的主备状态。ZKFC与NN部署在一起,两者个数相同。

元数据同步

- 主NameNode对外提供服务。生成的Editlog同时写入本地和JN,同时更新主NameNode内存中的元数据。

- 备NameNode监控到JN上Editlog变化时,加载Editlog进内存,生成新的与主NameNode一样的元数据。元数据同步完成。

- 主备的FSImage仍保存在各自的磁盘中,不发生交互。FSImage是内存中元数据定时写到本地磁盘的副本,也叫元数据镜像。

元数据持久化

- EditLog:记录用户的操作日志,用以在FSImage的基础上生成新的文件系统镜像。

- FSImage:用以阶段性保存文件镜像。

- FSImage.ckpt:在内存中对fsimage文件和EditLog文件合并(merge)后产生新的fsimage,写到磁盘上,这个过程叫checkpoint.。备用NameNode加载完fsimage和EditLog文件后,会将merge后的结果同时写到本地磁盘和NFS。此时磁盘上有一份原始的fsimage文件和一份新生成的checkpoint文件:fsimage.ckpt. 而后将fsimage.ckpt改名为fsimage(覆盖原有的fsimage)。

- EditLog.new: NameNode每隔1小时或Editlog满64MB就触发合并,合并时,将数据传到Standby NameNode时,因数据读写不能同步进行,此时NameNode产生一个新的日志文件Editlog.new用来存放这段时间的操作日志。Standby NameNode合并成fsimage后回传给主NameNode替换掉原有fsimage,并将Editlog.new 命名为Editlog。

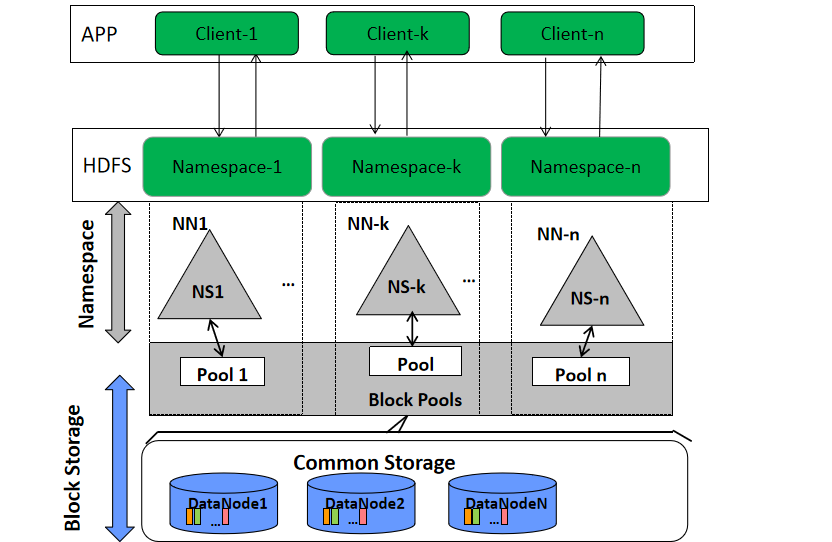

HDFS联邦(Federation)

- 产生原因:单Active NN的架构使得HDFS在集群扩展性和性能上都有潜在的问题,当集群大到一定程度后,NN进程使用的内存可能会达到上百G,NN成为了性能的瓶颈。

- 应用场景:超大规模文件存储。如互联网公司存储用户行为数据、电信历史数据、语音数据等超大规模数据存储。此时NameNode的内存不足以支撑如此庞大的集群。常用的估算公式为1G对应1百万个块,按缺省块大小计算的话,大概是128T (这个估算比例是有比较大的富裕的,其实,即使是每个文件只有一个块,所有元数据信息也不会有1KB/block)。

- Federation简单理解:各NameNode负责自己所属的目录。与Linux挂载磁盘到目录类似,此时每个NameNode只负责整个hdfs集群中部分目录。如NameNode1负责/database目录,那么在/database目录下的文件元数据都由NameNode1负责。各NameNode间元数据不共享,每个NameNode都有对应的standby。

- 块池(block pool):属于某一命名空间(NS)的一组文件块。联邦环境下,每个namenode维护一个命名空间卷(namespace volume),包括命名空间的元数据和在该空间下的文件的所有数据块的块池。

- namenode之间是相互独立的,两两之间并不互相通信,一个失效也不会影响其他namenode。

- datanode向集群中所有namenode注册,为集群中的所有块池存储数据。

- NameSpace(NS):命名空间。 HDFS的命名空间包含目录、文件和块。可以理解为NameNode所属的逻辑目录。

数据副本机制

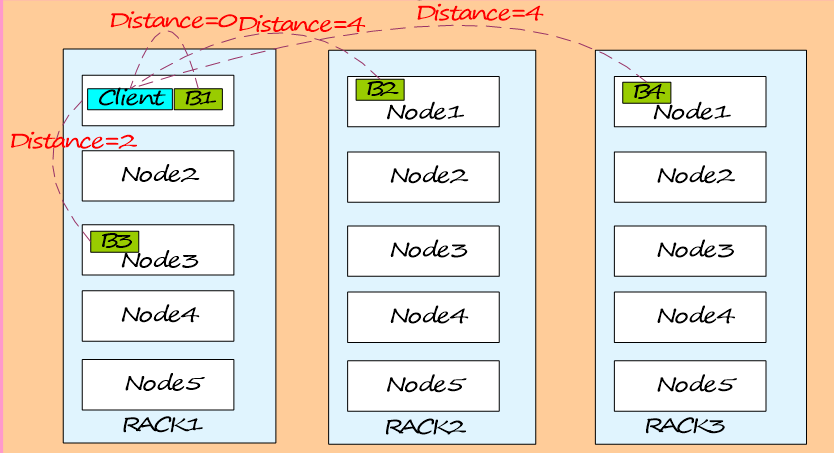

副本距离计算公式:

- Distance(Rack1/D1, Rack1/D1)=0,同一台服务器的距离为0。

- Distance(Rack1/D1, Rack1/D3)=2,同一机架不同的服务器距离为2。

- Distance(Rack1/D1, Rack2/D1)=4,不同机架的服务器距离为4。

副本放置策略:

- 第一个副本在本节点。

- 第二个副本在远端机架的节点。

- 第三个副本看之前的两个副本是否在同一机架,如果是则选择其他机架,否则选择和第一个副本相同机架的不同节点,第四个及以上,随机选择副本存放位置。

如果写请求方所在机器是其中一个DataNode,则直接存放在本地,否则随机在集群中选择一个DataNode。

- Rack1:表示机架1。

- D1:表示DataNode节点1。

- B1:表示节点上的block块1。

配置HDFS数据存储策略

默认情况下,HDFS NameNode自动选择DataNode保存数据的副本。在实际业务中,存在以下场景:

- DataNode上存在的不同的存储设备,数据需要选择一个合适的存储设备分级存储数据。

- DataNode不同目录中的数据重要程度不同,数据需要根据目录标签选择一个合适的DataNode节点保存。

- DataNode集群使用了异构服务器,关键数据需要保存在具有高度可靠性的节点组中。

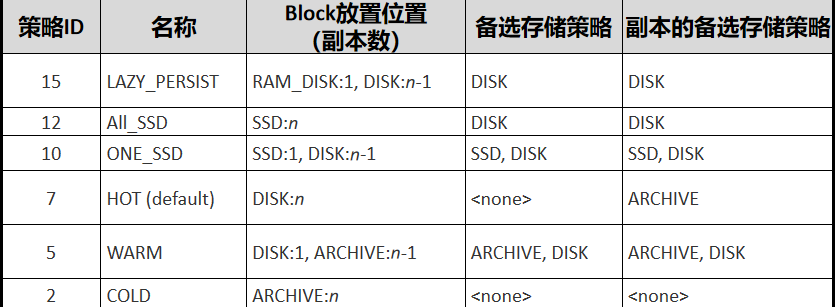

配置HDFS数据存储策略--分级存储

配置DataNode使用分级存储

- HDFS的分级存储框架提供了RAM_DISK(内存盘)、DISK(机械硬盘)、ARCHIVE(高密度低成本存储介质)、SSD(固态硬盘)四种存储类型的存储设备。

- 通过对四种存储类型进行合理组合,即可形成适用于不同场景的存储策略。

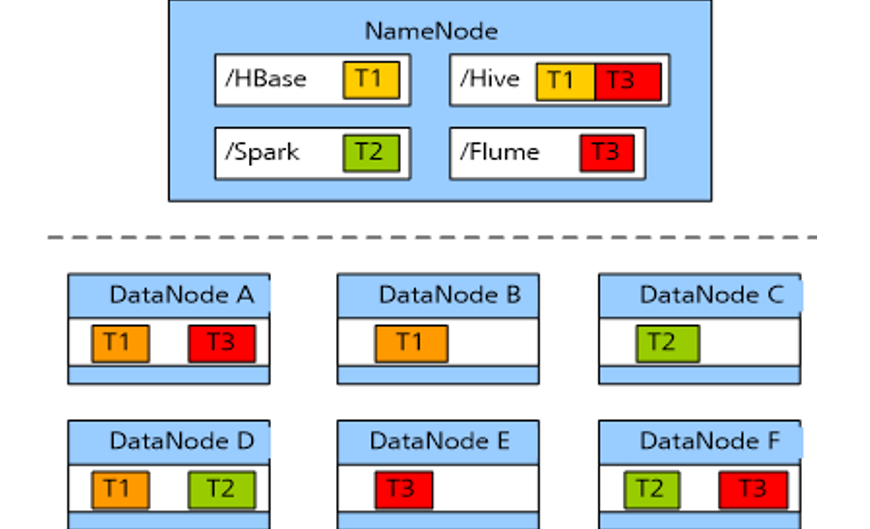

配置HDFS数据存储策略--标签存储

配置DataNode使用标签存储:

- 用户需要通过数据特征灵活配置HDFS文件数据块的存储节点。通过设置HDFS目 录/文件对应一个标签表达式,同时设置每个Datanode对应一个或多个标签,从而给文件的数据块存储指定了特定范围的Datanode。

- 当使用基于标签的数据块摆放策略,为指定的文件选择DataNode节点进行存放时,会根据文件的标签表达式选择出将要存放的Datanode节点范围,然后在这些Datanode节点范围内,选择出合适的存放节点。

支持用户将数据块的各个副本存放在指定具有不同标签的节点,如某个文件的数据块的2个副本放置在标签L1对应节点中,该数据块的其他副本放置在标签L2对应的节点中。

支持选择节点失败情况下的策略,如随机从全部节点中选一个。

简单的说:给DataNode设置标签,被存储的数据也有标签。当存储数据时,数据就会存储到标签相同的DataNode中。

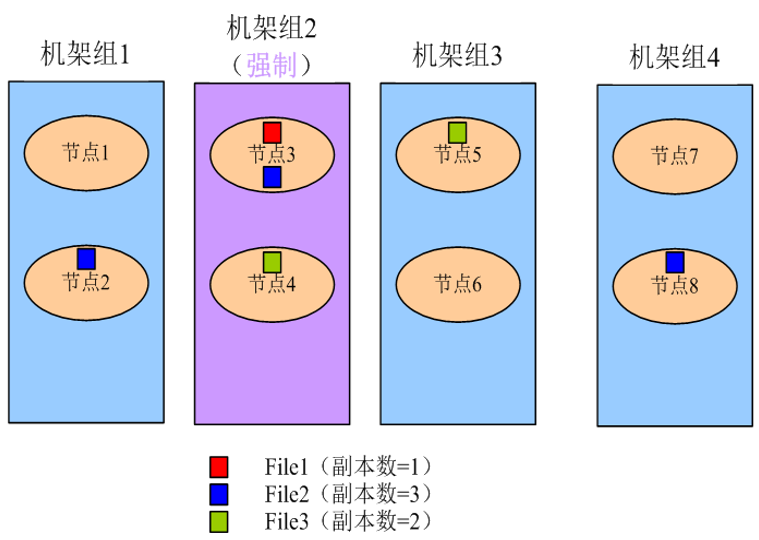

配置HDFS数据存储策略--节点组存储

配置DataNode使用节点组存储:

- 关键数据根据实际业务需要保存在具有高度可靠性的节点中,通过修改DataNode的存储策略,系统可以将数据强制保存在指定的节点组中。

使用约束:

- 第一份副本将从强制机架组(机架组2)中选出,如果在强制机架组中没有可用节点,则写入失败。

- 第二份副本将从本地客户端机器或机架组中的随机节点中(当客户端机器机架组不为强制机架组时)选出。

- 第三份副本将从其他机架组中选出。

- 各副本应存放在不同的机架组中。如果所需副本的数量大于可用的机架组数量,则会将多出的副本存放在随机机架组中。

- 由于副本数量的增加或数据块受损导致再次备份时,如果有一份以上的副本缺失或无法存放至强制机架组,将不会进行再次备份。系统将会继续尝试进行重新备份,直至强制组中有正常节点恢复可用状态。

- 简单的说:就是强制某些关键数据存储到指定服务器中。

Colocation同分布

- 同分布(Colocation)的定义:将存在关联关系的数据或可能要进行关联操作的数据存储在相同的存储节点上。

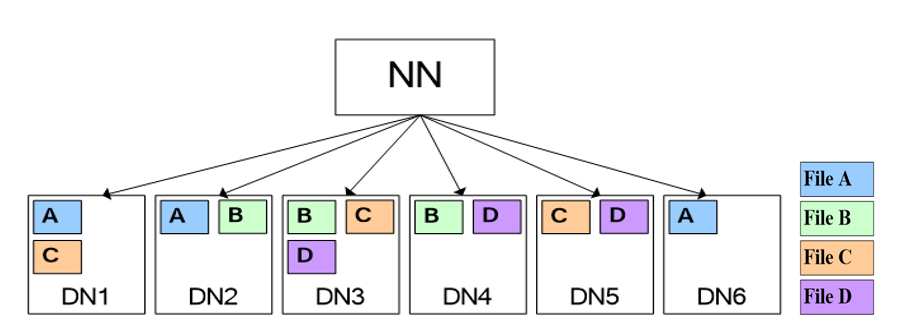

- 按照下图存放,假设要将文件A和文件D进行关联操作,此时不可避免地要进行大量的数据搬迁,整个集群将由于数据传输占据大量网络带宽,严重影响大数据的处理速度与系统性能。

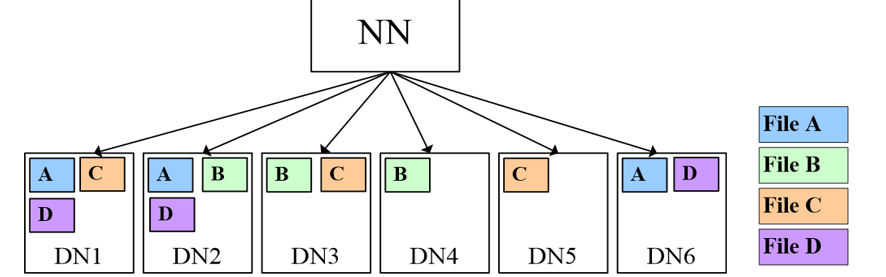

- HDFS文件同分布的特性,将那些需进行关联操作的文件存放在相同数据节点上,在进行关联操作计算时避免了到其他的数据节点上获取数据,大大降低网络带宽的占用。

- 使用同分布特性,文件A、D进行join时,由于其对应的block都在相同节点,因此大大降低资源消耗。

- Hadoop实现文件同分布,即存在相关联的多个文件的所有块都分布在同一存储节点上。文件级同分布实现文件的快速访问,避免了因数据搬迁带来的大量网络开销。

HDFS数据完整性保障

HDFS主要目的是保证存储数据完整性,对于各组件的失效,做了可靠性处理。

重建失效数据盘的副本数据

- DataNode向NameNode周期上报失败时,NameNode发起副本重建动作以恢复丢失副本。

集群数据均衡

- HDFS架构设计了数据均衡机制,此机制保证数据在各个DataNode上分布是平均的。

元数据可靠性保证

- 采用日志机制操作元数据,同时元数据存放在主备NameNode上。

- 快照机制实现了文件系统常见的快照机制,保证数据误操作时,能及时恢复。

安全模式

- HDFS提供独有安全模式机制,在数据节点故障,硬盘故障时,能防止故障扩散。

重建失效数据盘的副本数据

- DataNode与NameNode之间通过心跳周期汇报数据状态,NameNode管理数据块是否上报完整,如果DataNode因硬盘损坏未上报数据块,

- NameNode将发起副本重建动作以恢复丢失的副本。

安全模式防止故障扩散

- 当节点硬盘故障时,进入安全模式,HDFS只支持访问元数据,此时HDFS 上的数据是只读的,其他的操作如创建、删除文件等操作都会导致失败。待硬盘问题解决、数据恢复后,再退出安全模式。

HDFS架构其他关键设计要点说明

统一的文件系统:

- HDFS对外仅呈现一个统一的文件系统。

空间回收机制:

- 支持回收站机制,以及副本数的动态设置机制。

数据组织:

- 数据存储以数据块为单位,存储在操作系统的HDFS文件系统上。

访问方式:

- 提供JAVA API,HTTP方式,SHELL方式访问HDFS数据。

磁盘使用率:

- 比如磁盘100G,用了30G,使用率30%。

负载均衡避免了节点间数据分布不均匀,导致热点节点问题。

思考题

1HDFS是什么,适合于做什么?

- 运行在通用硬件上的分布式文件系统。适合于大文件存储与访问、流式数据访问。

2HDFS包含那些角色?

- NameNode、DataNode、Client。

3 请简述HDFS的读写流。

- 读取:Client联系NameNode,获取文件信息。Client根据从NameNode获取到的信息,联系DataNode,获取相应的数据块;数据读取完成后,业务调用close关闭连接。

- 写入:Client联系NameNode,NameNode在元数据中创建文件节点;Client联系DataNode并建立流水线,完成后,客户端再通过自有协议写入数据到 DataNode1,再由DataNode1复制到DataNode2,DataNode3;业务调用close关 闭连接;Client联系NameNode,确认数据写完成。

大数据基础总结---HDFS分布式文件系统的更多相关文章

- 大数据学习笔记2 - 分布式文件系统HDFS(待续)

分布式文件系统结构 分布式文件系统是一种通过网络实现文件在多台主机上进行分布式存储的文件系统,采用C/S模式实现文件系统数据访问,目前广泛应用的分布式文件系统主要包括GFS和HDFS,后者是前者的开源 ...

- 【大数据作业十】分布式文件系统HDFS 练习

作业要求来自: https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3292 利用Shell命令与HDFS进行交互 以”./bin/dfs ...

- 【原创】大数据基础之HDFS(2)HDFS副本数量检查及复制逻辑

HDFS会周期性的检查是否有文件缺少副本,并触发副本复制逻辑使之达到配置的副本数, <property> <name>dfs.replication</name> ...

- 【原创】大数据基础之HDFS(1)HDFS新创建文件如何分配Datanode

HDFS中的File由Block组成,一个File包含一个或多个Block,当创建File时会创建一个Block,然后根据配置的副本数量(默认是3)申请3个Datanode来存放这个Block: 通过 ...

- Hadoop基础-HDFS分布式文件系统的存储

Hadoop基础-HDFS分布式文件系统的存储 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.HDFS数据块 1>.磁盘中的数据块 每个磁盘都有默认的数据块大小,这个磁盘 ...

- 大数据基础知识:分布式计算、服务器集群[zz]

大数据中的数据量非常巨大,达到了PB级别.而且这庞大的数据之中,不仅仅包括结构化数据(如数字.符号等数据),还包括非结构化数据(如文本.图像.声音.视频等数据).这使得大数据的存储,管理和处理很难利用 ...

- 大数据基础知识问答----hadoop篇

handoop相关知识点 1.Hadoop是什么? Hadoop是一个由Apache基金会所开发的分布式系统基础架构.用户可以在不了解分布式底层细节的情况下,开发分布式程序.充分利用集群的威力进行高速 ...

- 1、HDFS分布式文件系统

1.HDFS分布式文件系统 分布式存储 分布式计算 2.hadoop hadoop含有四个模块,分别是 common. hdfs和yarn. common 公共模块. HDFS hadoop dist ...

- 【史上最全】Hadoop 核心 - HDFS 分布式文件系统详解(上万字建议收藏)

1. HDFS概述 Hadoop 分布式系统框架中,首要的基础功能就是文件系统,在 Hadoop 中使用 FileSystem 这个抽象类来表示我们的文件系统,这个抽象类下面有很多子实现类,究竟使用哪 ...

随机推荐

- 我的第一次diy装机记录——小白的装机篇

接上一篇<我的第一次diy装机记录——小白的配置篇> 处理器 AMD Ryzen 5 2600X 六核主板 微星 B450M MORTAR (MS-7B89) ( AMD PCI 标准主机 ...

- Mybatis使用Mybatis-generator插件及配置(数据库逆向工程)

Mybatis使用Mybatis-generator插件 首先在POM.xml文件添加架包,我这里用的是SpringBoot,所以用的也是SpringBoot架包,最少要mybatis,generat ...

- Tomcat部署项目时,发布的项目页面部分乱码,且页面渲染文件也是乱码。

catalina.bat中必须设置为UTF-8,如果我不设置为UTF-8,页面接收到的就是乱码了,尝试过各种UTF-8的调试,都无解,最后还是只能在catalina.bat的set "JAV ...

- lua脚本之钉钉免密登录

nginx.conf worker_processes ; error_log logs/error.log; events { worker_connections ; } http { resol ...

- [小程序]微信小程序获取input并发送网络请求

1. 获取输入框数据wxml中的input上增加bindinput属性,和方法值在js部分定义与之对应的方法,只要在输入的时候,数据就会绑定调用到该方法,存入data属性变量中 2. 调用get请求发 ...

- SpringBoot使用Hibernate,实现自动创建数据库表【博客数据库设计】

我们准备设计博客,那就要设计数据库. 我们可以使用Hibernate来自动生成数据库. 博客数据库的结构: 实体类: 博客 Blog 博客分类 Type 博客标签 Tag 博客评论 Comment 用 ...

- 石欣钰-201871010117 《面向对象程序设计(java)》第六、七周学习总结

项目 内容 这个作业属于哪个课程 https://www.cnblogs.com/nwnu-daizh/ 这个作业要求在哪里 https://www.cnblogs.com/nwnu-daizh/p/ ...

- docker 持久化存储

1.data Volume mysql5.7:dockerfile FROM debian:stretch-slim # add our user and group first to make s ...

- day9_7.9 函数的定义

一.基础 1.什么是函数? 函数就是工具,方便开发人员开发软件,非常简洁的工具. 函数的关键字是def 在函数的编写阶段,只检验其语法是否正确,不检验代码. 在函数的调用阶段,可以通过函数名+()来调 ...

- 【Oracle】Windows启动

cd D:\app\Administrator\product\\dbhome_1\BIN D: sqlplus /nolog conn sys/system as sysdba startup pf ...