python scrapy爬取知乎问题和收藏夹下所有答案的内容和图片

上文介绍了爬取知乎问题信息的整个过程,这里介绍下爬取问题下所有答案的内容和图片,大致过程相同,部分核心代码不同.

爬取一个问题的所有内容流程大致如下:

- 一个问题url

- 请求url,获取问题下的答案个数(我不需要,因为之前获取问题信息的时候保存了问题的回答个数)

- 通过答案的接口去获取答案(如果一次获取5个答案,总计100个答案,需要计算的出访问20次答案接口)[答案的接口地址如下图所示]

- 答案接口返回的内容保存到mysql

- 提取内容中的图片地址,保存到本地

爬取代码:

从mysql库中查到question的id, 然后直接访问 答案接口 去获取数据.

answer_template="https://www.zhihu.com/api/v4/questions/%s/answers?include=data[*].is_normal,admin_closed_comment,reward_info,is_collapsed,annotation_action,annotation_detail,collapse_reason,is_sticky,collapsed_by,suggest_edit,comment_count,can_

comment,content,editable_content,voteup_count,reshipment_settings,comment_permission,created_time,updated_time,review_info,relevant_info,question,excerpt,relationship.is_authorized,is_author,voting,is_thanked,is_nothelp;data[*].mark_infos[*].url;dat

a[*].author.follower_count,badge[?(type=best_answerer)].topics&limit=5&offset=%s&sort_by=default"

def check_login(self, response):

#从mysql中读取question的信息,来进行爬取

db = MySQLdb.connect("localhost", "root", "", "crawl", charset='utf8' )

cursor = db.cursor()

selectsql="select questionid,answer_num from zhihu_question where id in ( 251,138,93,233,96,293,47,24,288,151,120,311,214,33) ;"

try:

cursor.execute(selectsql)

results = cursor.fetchall()

for row in results:

questionid = row[0]

answer_num = row[1]

fornum = answer_num/5 #计算需要访问答案接口的次数

print("questionid : "+ str(questionid)+" answer_Num: "+str(answer_num))

for i in range(fornum+1):

answer_url = self.answer_template % (str(questionid), str(i*5))

yield scrapy.Request(answer_url,callback=self.parse_answer, headers=self.headers)

except Exception as e:

print(e)

db.close()

解析response

parser_anser解析接口里的内容,这里就比较方便了, 因为是json格式的

代码如下:

def parse_answer(self,response):

#测试时把返回结果写到本地, 然后写pythonmain方法测试,测试方法都在test_code目录下

#temfn= str(random.randint(0,100))

#f = open("/var/www/html/scrapy/answer/"+temfn,'wb')

#f.write(response.body)

#f.write("------")

#f.close()

res=json.loads(response.text)

#print (res)

data=res['data']

# 一次返回多个(默认5个)答案, 需要遍历

for od in data:

#print(od)

item = AnswerItem()

item['answer_id']=str(od['id']) # answer id

item['question_id']=str(od['question']['id'])

item['question_title']=od['question']['title']

item['author_url_token']=od['author']['url_token']

item['author_name']=od['author']['name']

item['voteup_count']=str(od['voteup_count'])

item['comment_count']=str(od["comment_count"])

item['content']=od['content']

yield item

testh = etree.HTML(od['content'])

itemimg = MyImageItem()

itemimg['question_answer_id'] = str(od['question']['id'])+"/"+str(od['id'])

itemimg['image_urls']=testh.xpath("//img/@data-original")

yield itemimg

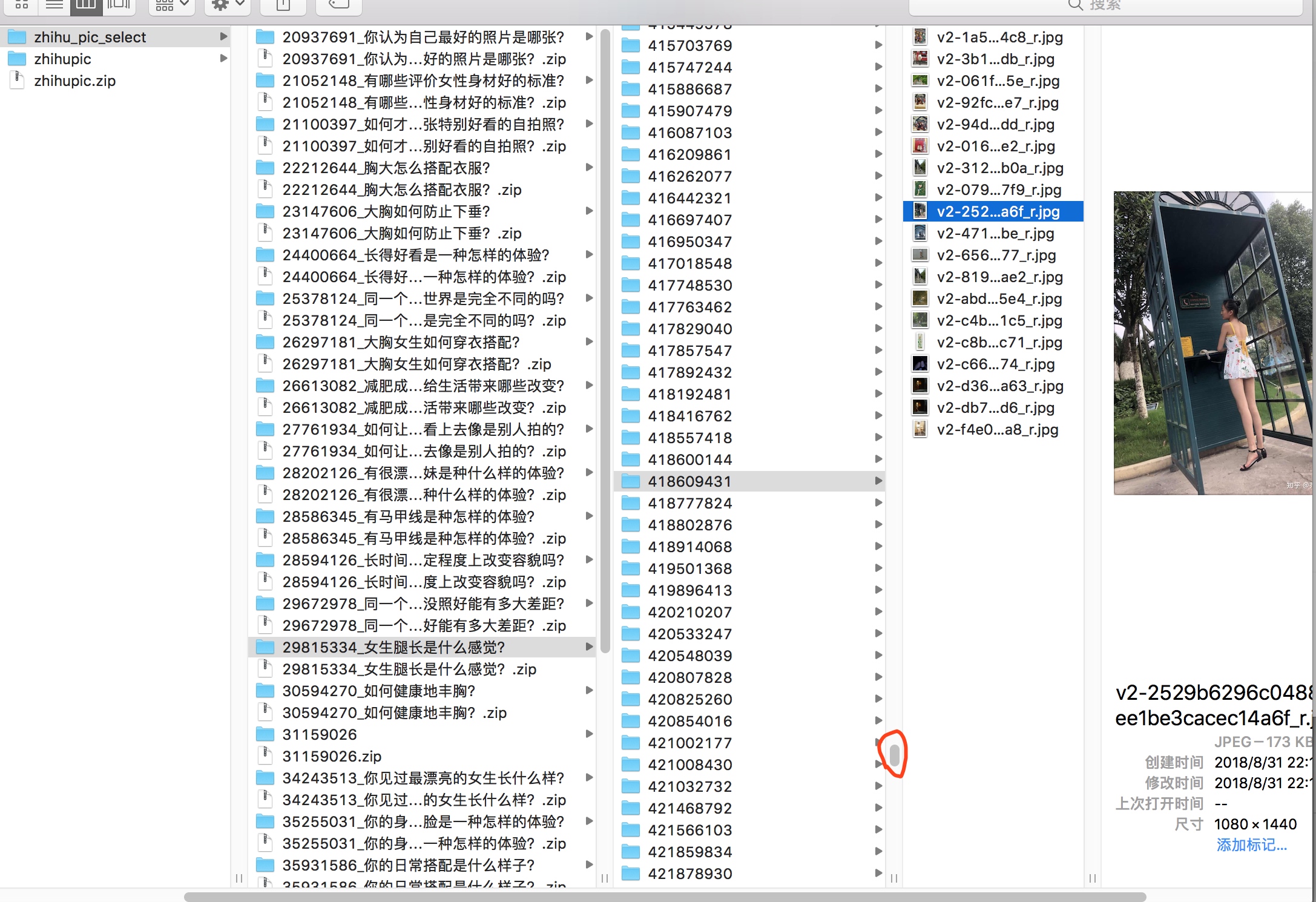

成果展示

爬取了4w+个答案和12G图片(个人服务器只有12G空间了~)

爬取收藏夹下的答案内容和图片:

爬取收藏夹下的回答的流程和爬取问题下回答基本流程一样,区别在于:

- 问题的start_urls为多个,收藏夹是一个一个爬取

- 问题页面上找到了内容接口,返回json.方便. 收藏夹页面没有找到接口(我没有找到),我是访问每页,然后解析的html.

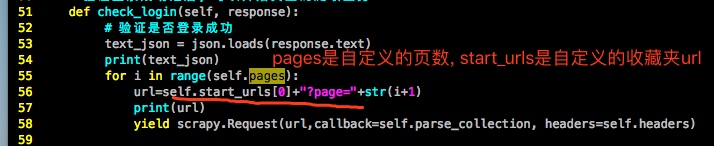

构造每页的起始地址:

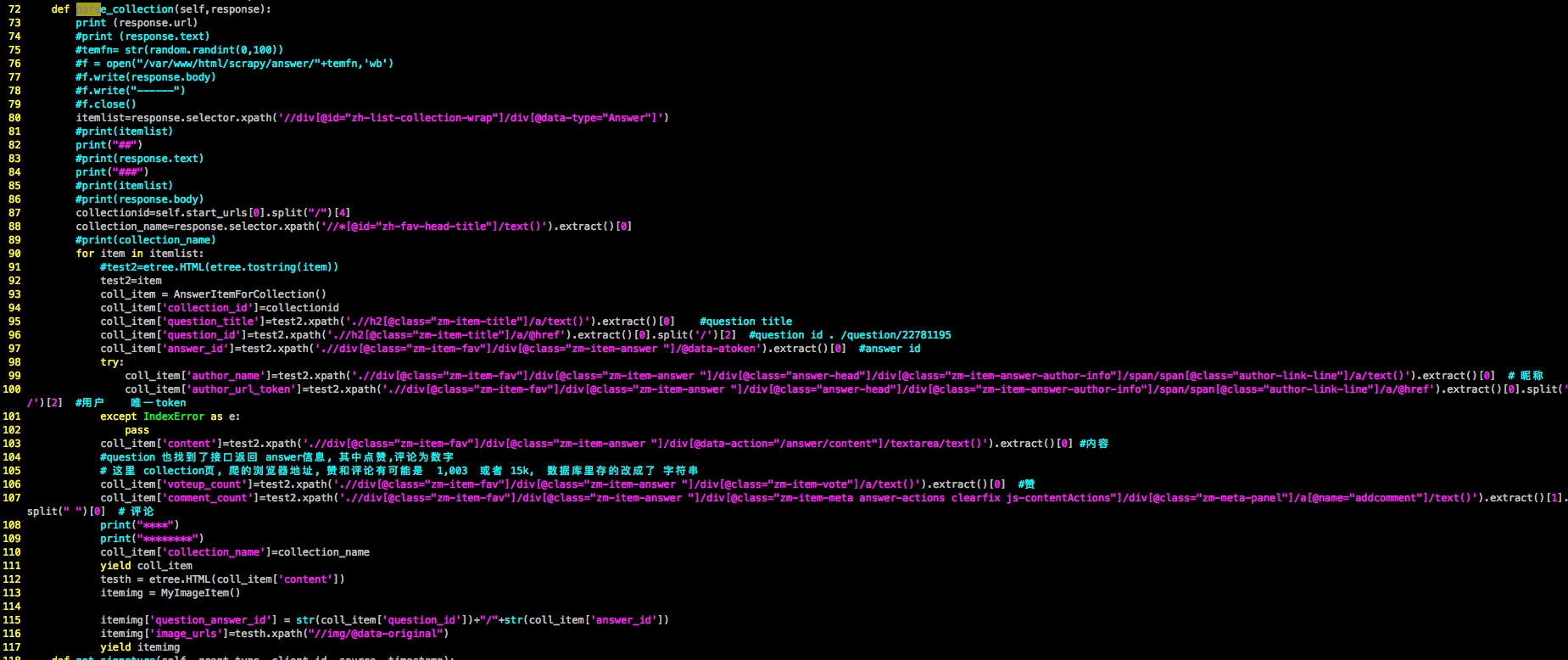

解析html核心代码:

python scrapy爬取知乎问题和收藏夹下所有答案的内容和图片的更多相关文章

- 使用python scrapy爬取知乎提问信息

前文介绍了python的scrapy爬虫框架和登录知乎的方法. 这里介绍如何爬取知乎的问题信息,并保存到mysql数据库中. 首先,看一下我要爬取哪些内容: 如下图所示,我要爬取一个问题的6个信息: ...

- 一个简单的python爬虫,爬取知乎

一个简单的python爬虫,爬取知乎 主要实现 爬取一个收藏夹 里 所有问题答案下的 图片 文字信息暂未收录,可自行实现,比图片更简单 具体代码里有详细注释,请自行阅读 项目源码: # -*- cod ...

- scrapy 爬取知乎问题、答案 ,并异步写入数据库(mysql)

python版本 python2.7 爬取知乎流程: 一 .分析 在访问知乎首页的时候(https://www.zhihu.com),在没有登录的情况下,会进行重定向到(https://www. ...

- 利用 Scrapy 爬取知乎用户信息

思路:通过获取知乎某个大V的关注列表和被关注列表,查看该大V和其关注用户和被关注用户的详细信息,然后通过层层递归调用,实现获取关注用户和被关注用户的关注列表和被关注列表,最终实现获取大量用户信息. 一 ...

- scrapy爬取知乎某个问题下的所有图片

前言: 1.仅仅是想下载图片,别人上传的图片也是没有版权的,下载来可以自己欣赏做手机背景但不商用 2.由于爬虫周期的问题,这个代码写于2019.02.13 1.关于知乎爬虫 网上能访问到的理论上都能爬 ...

- python scrapy爬取HBS 汉堡南美航运公司柜号信息

下面分享个scrapy的例子 利用scrapy爬取HBS 船公司柜号信息 1.前期准备 查询提单号下的柜号有哪些,主要是在下面的网站上,输入提单号,然后点击查询 https://www.hamburg ...

- Python——Scrapy爬取链家网站所有房源信息

用scrapy爬取链家全国以上房源分类的信息: 路径: items.py # -*- coding: utf-8 -*- # Define here the models for your scrap ...

- scrapy爬取知乎问答

登陆 参考 https://github.com/zkqiang/Zhihu-Login # -*- coding: utf-8 -*- import scrapy import time impor ...

- Python scrapy爬取带验证码的列表数据

首先所需要的环境:(我用的是Python2的,可以选择python3,具体遇到的问题自行解决,目前我这边几百万的数据量爬取) 环境: Python 2.7.10 Scrapy Scrapy 1.5.0 ...

随机推荐

- 【杂谈】线程中断——Interrupt

前言 以前有一个错误的认识,以为中断操作都会抛出异常,后来才发现并不是这样,所以今天就来做一个关于中断的总结. 如何关闭线程 已被弃用的Stop方法 早期,Thread类中有一个stop方法,用于强行 ...

- 获取访问者的IP地址

function getIp() { $realip = NULL; if(isset($_SERVER['HTTP_X_FORWARDED_FOR'])) { $ipArray = explode( ...

- windows下mongodb基础玩法系列二CURD附加一

windows下mongodb基础玩法系列 windows下mongodb基础玩法系列一介绍与安装 windows下mongodb基础玩法系列二CURD操作(创建.更新.读取和删除) windows下 ...

- Linux卸载搭建环境

本章内容 卸载Apache PHP MySQL 卸载Apache 查看apache安装版本 $ apachectl -v 查看安装httpd相关软件包(红色部分) sudo yum list inst ...

- SpringMVC+SpringJdbc+SQLServer+EasyUI增删改查

前言 前天用SpringJdbc连接了一把SQLServer,早上起来用SpringMVC+SpringJdbc+EasUI写了个增删改查的demo,主要是熟悉下SpringMVC相关知识点,如vie ...

- S3C2440 DMA 驱动示例

将 DMA 抽象为一个字符设备,在初始化函数中调用 void *dma_alloc_writecombine(struct device *dev, size_t size, dma_addr_t * ...

- hadoop 核心概念及入门

Hadoop Hadoop背景 什么是HADOOP HADOOP是apache旗下的一套开源软件平台HADOOP提供利用服务器集群,根据用户的自定义业务逻辑,对海量数据进行分布式处理,HADOOP的核 ...

- MathJax: 让前端支持数学公式

文章图片存储在GitHub,网速不佳的朋友,请看<MathJax:让前端支持数学公式> 或者 来我的技术小站 godbmw.com 1. 必须要说 1.1 开发背景 博主使用Vue开发的个 ...

- Javascript 自动执行函数(立即调用函数)

开头:各种原因总结一下javascript中的自动执行函数(立即调用函数)的一些方法,正文如下 在Javascript中,任何function在执行的时候都会创建一个执行上下文,因为function声 ...

- Python 中 and 和 or 的短路原则

对于 and 来说: 如果第一个条件的结论为假,那么 and 前后两个条件组成的表达式计算结果一定为假,后面的条件计算机不会进行计算 对于 or 来说: 如果第一个条件的结论为真,那么 or 前后两个 ...