爬虫---PyQuert简介

今天写一篇最近刚学习的一个第3方库pyquery,pyquery比bs4,lxml更强大的一个网页解析工具。

什么是pyQuery

Pyquery是python的第3方库,PyQuery库也是一个非常强大又灵活的网页解析库,它提供了和jQuery 类似的语法来解析HTML 文梢,支持css 选择器,使用非常方便。Beautifu l Soup 一样,初始化PyQuery 的时候,也需要传入HTML 文本来初始化一个PyQue1y对象。它的初始化方式有多种,比如直接传入字符串,传入URL,传人文件名

官方文档:http://pyquery.readthedocs.io/en/latest/

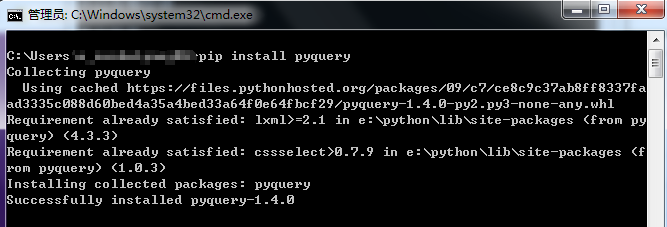

安装PyQuery

# pip安装

pip install pyquery

PyQuery使用

写一个简单的html供下面学习

text =

'''

<html>

<body>

<div id="test">

<ul class="list">

<li class="item-0"><a href="link1.html">今天天气</a></li>

<li class="item-1"><a href="link2.html">明天天气</a></li>

<li class="item-2"><a href="link3.html">后天天气</a></li>

<li class="item-3"><a href="link4.html">周末天气</a></li>

</ul>

</div>

</body>

</html>

'''

基本css选择器

# 导入pyquery

from pyquery import PyQuery as pq

# 创建对象

doc = pq(text)

# 通过css选择器先查找id再查找class

item = doc('#test .list')

print(item) 代码结果:

<ul class="list">

<li class="item-0"><a href="link1.html">今天天气</a></li>

<li class="item-1"><a href="link2.html">明天天气</a></li>

<li class="item-2"><a href="link3.html">后天天气</a></li>

<li class="item-3"><a href="link4.html">周末天气</a></li>

</ul>

查找子节点

# 导入pyquery

from pyquery import PyQuery as pq

# 创建对象

doc = pq(text)

# 通过css选择器先查找id再查找class

item = doc('#test .list')

# 查找子节点li

child = item.children('li')

# 或者使用find()函数

# child = item.find('li')

print(child) 代码结果:

<li class="item-0"><a href="link1.html">今天天气</a></li>

<li class="item-1"><a href="link2.html">明天天气</a></li>

<li class="item-2"><a href="link3.html">后天天气</a></li>

<li class="item-3"><a href="link4.html">周末天气</a></li>

查找父节点

# 导入pyquery

from pyquery import PyQuery as pq

# 创建对象

doc = pq(text)

# 通过css选择器先查找id再查找class

item = doc('#test .list')

# 查找父节点

container = item.parent()

print(container) 代码结果:

<div id="test">

<ul class="list">

<li class="item-0"><a href="link1.html">今天天气</a></li>

<li class="item-1"><a href="link2.html">明天天气</a></li>

<li class="item-2"><a href="link3.html">后天天气</a></li>

<li class="item-3"><a href="link4.html">周末天气</a></li>

</ul>

</div>

查找兄弟节点

# 导入pyquery

from pyquery import PyQuery as pq

# 创建对象

doc = pq(text)

# 查找兄弟其中一个

item = doc('.item-0')

# 查找兄弟节点

xiongdi = item.siblings('li')

print(xiongdi) 代码结果:

<li class="item-1"><a href="link2.html">明天天气</a></li>

<li class="item-2"><a href="link3.html">后天天气</a></li>

<li class="item-3"><a href="link4.html">周末天气</a></li>

遍历读取内容

1、遍历读取a标签

这个地方需要使用一个方法items(),使用该方法后得到一个生成器

# 导入pyquery

from pyquery import PyQuery as pq

# 创建对象

doc = pq(text)

item = doc('.list a').items()

for i in item:

print(i) 代码结果:

<a href="link1.html">今天天气</a>

<a href="link2.html">明天天气</a>

<a href="link3.html">后天天气</a>

<a href="link4.html">周末天气</a>

2、获取href的值

这个地方需要用到attr()方法

# 导入pyquery

from pyquery import PyQuery as pq

# 创建对象

doc = pq(text)

item = doc('.list a').items()

for i in item:

print(i.attr('href')) 代码结果:

link1.html

link2.html

link3.html

link4.html

3、获取a标签下的文字

通过调用text()方法来实现

# 导入pyquery

from pyquery import PyQuery as pq

# 创建对象

doc = pq(text)

item = doc('.list a').items()

for i in item:

print(i.text()) 代码结果:

今天天气

明天天气

后天天气

周末天气

下一篇通过简单的案例更加深刻的了解pyquery库~~~~

写了一些简单的介绍,还是那一句话,方法多多种,喜欢那种用那种~~~大家喜欢的话,也可以点个关注哈

爬虫---PyQuert简介的更多相关文章

- Python 爬虫一 简介

什么是爬虫? 爬虫可以做什么? 爬虫的本质 爬虫的基本流程 什么是request&response 爬取到数据该怎么办 什么是爬虫? 网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间 ...

- 【搜索引擎Jediael开发笔记1】搜索引擎初步介绍及网络爬虫

详细可参考 (1)书箱:<这就是搜索引擎><自己动手写网络爬虫><解密搜索引擎打桩实践> (2)[搜索引擎基础知识1]搜索引擎的技术架构 (3)[搜索引擎基础知识2 ...

- 97、爬虫框架scrapy

本篇导航: 介绍与安装 命令行工具 项目结构以及爬虫应用简介 Spiders 其它介绍 爬取亚马逊商品信息 一.介绍与安装 Scrapy一个开源和协作的框架,其最初是为了页面抓取 (更确切来说, ...

- 爬虫框架 Scrapy

一 介绍 crapy一个开源和协作的框架,其最初是为了页面抓取 (更确切来说, 网络抓取 )所设计的,使用它可以以快速.简单.可扩展的方式从网站中提取所需的数据.但目前Scrapy的用途十分广泛,可用 ...

- Python 爬虫七 Scrapy

Scrapy Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架. 其可以应用在数据挖掘,信息处理或存储历史数据等一系列的程序中.其最初是为了页面抓取 (更确切来说, 网络抓取 )所设 ...

- 爬虫框架之Scrapy

一.介绍 二.安装 三.命令行工具 四.项目结构以及爬虫应用简介 五.Spiders 六.Selectors 七.Items 八.Item Pipelin 九. Dowloader Middeware ...

- 爬虫基础线程进程学习-Scrapy

性能相关 学习参考:http://www.cnblogs.com/wupeiqi/articles/6229292.html 在编写爬虫时,性能的消耗主要在IO请求中,当单进程单线程模式下请求URL时 ...

- 爬虫、框架scrapy

阅读目录 一 介绍 二 安装 三 命令行工具 四 项目结构以及爬虫应用简介 五 Spiders 六 Selectors 七 Items 八 Item Pipeline 九 Dowloader Midd ...

- 爬虫之Scrapy详解

性能相关 在编写爬虫时,性能的消耗主要在IO请求中,当单进程单线程模式下请求URL时必然会引起等待,从而使得请求整体变慢. import requests def fetch_async(url): ...

随机推荐

- 微信小程序官方文档中表单组建button部分有关function(type)中type的个人理解

官方文档关于button组件的简介 xml页面挺容易理解,但js部分起初对整体写的形式都不太理解,随着逐渐阅读代码基本理解了 xml页面代码: <button type="defaul ...

- SQL注入:DNS注入

DNS注入原理: 通过我们构造的数据,访问搭建好的DNS服务器,查看DNS访问的日志即可获取我们想要得到的数据. DNS注入使用场景: 在某些无法直接利用漏洞获得回显的情况下,但是目标可以发起请求,这 ...

- Druid-代码段-1-1

所属文章:池化技术(一)Druid是如何管理数据库连接的? 本代码段对应主流程1,具体用来获取一个连接: lic DruidPooledConnection getConnection(long ma ...

- HashMap与HashTable的区别和理解

Hashmap的理解 1:HashMap是基于哈希表的Map接口的非同步实现.此实现提供所有可选的映射操作,并允许使用null值和null键.HashMap储存的是键值对,HashMap很快.此类不保 ...

- [Linux]终端设备关系

1.概述 tty中基本上可以划分为console(/dev/console).虚拟终端(/dev/tty0~n)和伪终端(/dev/pts/0~n). 它们之间存在一定的关系. 为了说明这段关系,先要 ...

- JAVA实现二维码生成加背景图

pom.xml依赖 <!-- 二维码生成 --> <!-- https://mvnrepository.com/artifact/com.google.zxing/c ...

- IDEA如何打包可运行jar,外部引用jar包版

背景: 有时候,我们会用IDEA来开发一些小工具,需要打成可运行的JAR包:或者某些项目不是WEB应用,纯粹是后台应用,发布时,也需要打成可运行的JAR包.并且,如果依赖第三方jar时,又不希望第三方 ...

- AcWing 791. 高精度加法 解题记录

题目地址 https://www.acwing.com/problem/content/description/793/ 题目描述给定两个正整数,计算它们的和. 输入格式共两行,每行包含一个整数. 输 ...

- POI2008 CLO-Toll

[POI2008]CLO-Toll 题意描述 Byteotia城市有n个 towns m条双向roads. 每条 road 连接 两个不同的 towns ,没有重复的road. 你要把其中一些road ...

- 集成Hive和HBase

1. MapReduce 用MapReduce将数据从本地文件系统导入到HBase的表中, 比如从HBase中读取一些原始数据后使用MapReduce做数据分析. 结合计算型框架进行计算统计查看HBa ...