大数据【八】Flume部署

如果说大数据中分布式收集日志用的是什么,你完全可以回答Flume!(面试小心问到哦)

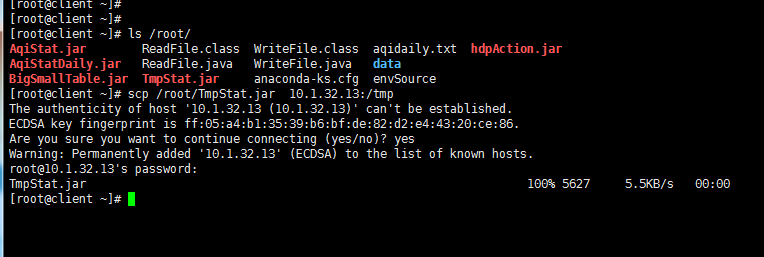

首先说一个复制本服务器文件到目标服务器上,需要目标服务器的ip和密码:

命令: scp filename ip:目标路径

一 概述

Flume是Cloudera提供的一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于收集数据;同时,Flume提供对数据进行简单处理,并写到各种数据接受方(可定制)的能力。

Flume提供对数据进行简单处理,并写到各种数据接受方(可定制)的能力 Flume提供了从console(控制台)、RPC(Thrift-RPC)、text(文件)、tail(UNIX tail)、syslog(syslog日志系统,支持TCP和UDP等2种模式),exec(命令执行)等数据源上收集数据的能力。

当前Flume有两个版本Flume 0.9X版本的统称Flume-og,Flume1.X版本的统称Flume-ng。由于Flume-ng经过重大重构,与Flume-og有很大不同,使用时请注意区分。

Flume-og采用了多Master的方式。为了保证配置数据的一致性,Flume引入了ZooKeeper,用于保存配置数据,ZooKeeper本身可保证配置数据的一致性和高可用,另外,在配置数据发生变化时,ZooKeeper可以通知Flume Master节点。Flume Master间使用gossip协议同步数据。

Flume-ng最明显的改动就是取消了集中管理配置的 Master 和 Zookeeper,变为一个纯粹的传输工具。Flume-ng另一个主要的不同点是读入数据和写出数据现在由不同的工作线程处理(称为 Runner)。 在 Flume-og 中,读入线程同样做写出工作(除了故障重试)。如果写出慢的话(不是完全失败),它将阻塞 Flume 接收数据的能力。这种异步的设计使读入线程可以顺畅的工作而无需关注下游的任何问题。

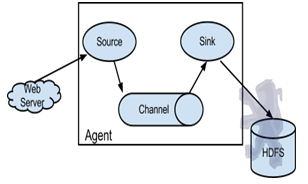

Flume以agent为最小的独立运行单位。一个agent就是一个JVM。单agent由Source、Sink和Channel三大组件构成。

二 启动Flume集群

1‘ 首先,启动Hadoop集群(详情见前博客)。

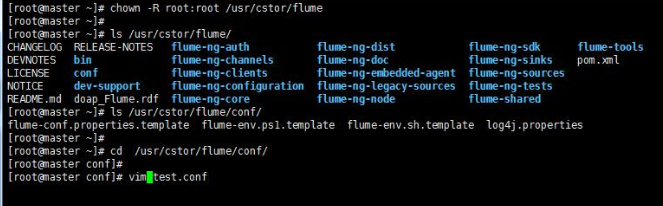

2’ 其次,(剩下的所有步骤只需要在master上操作就可以了)安装并配置Flume任务,内容如下:

将Flume 安装包解压到/usr/cstor目录,并将flume目录所属用户改成root:root。

tar -zxvf flume-1.5.2.tar.gz -c /usr/cstor

chown -R root:root /usr/cstor/flume

3‘ 进入解压目录下,在conf目录下新建test.conf文件并添加以下配置内容:

#定义agent中各组件名称

agent1.sources=source1

agent1.sinks=sink1

agent1.channels=channel1

# source1组件的配置参数

agent1.sources.source1.type=exec

#此处的文件/home/source.log需要手动生成,见后续说明

agent1.sources.source1.command=tail -n +0 -F /home/source.log

# channel1的配置参数

agent1.channels.channel1.type=memory

agent1.channels.channel1.capacity=1000

agent1.channels.channel1.transactionCapactiy=100

# sink1的配置参数

agent1.sinks.sink1.type=hdfs

agent1.sinks.sink1.hdfs.path=hdfs://master:8020/flume/data

agent1.sinks.sink1.hdfs.fileType=DataStream

#时间类型

agent1.sinks.sink1.hdfs.useLocalTimeStamp=true

agent1.sinks.sink1.hdfs.writeFormat=TEXT

#文件前缀

agent1.sinks.sink1.hdfs.filePrefix=%Y-%m-%d-%H-%M

#60秒滚动生成一个文件

agent1.sinks.sink1.hdfs.rollInterval=60

#HDFS块副本数

agent1.sinks.sink1.hdfs.minBlockReplicas=1

#不根据文件大小滚动文件

agent1.sinks.sink1.hdfs.rollSize=0

#不根据消息条数滚动文件

agent1.sinks.sink1.hdfs.rollCount=0

#不根据多长时间未收到消息滚动文件

agent1.sinks.sink1.hdfs.idleTimeout=0

# 将source和sink 绑定到channel

agent1.sources.source1.channels=channel1

agent1.sinks.sink1.channel=channel1

4' 然后,在HDFS上创建/flume/data目录:

cd /usr/cstor/hadoop/bin

./hdfs dfs -mkdir /flume

./hdfs dfs -mkdir /flume/data

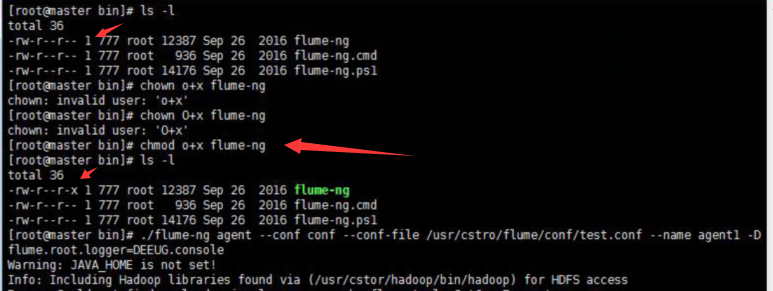

5' 最后,进入Flume安装的bin目录下

cd /usr/cstor/flume/bin

6' 启动Flume,开始收集日志信息。

./flume-ng agent --conf conf --conf-file /usr/cstor/flume/conf/test.conf --name agent1 -Dflume.root.logger=DEBUG,console

!!!>>运行此命令有时候会出现一个权限问题,此时需要用命令 chmod o+x flume-ng

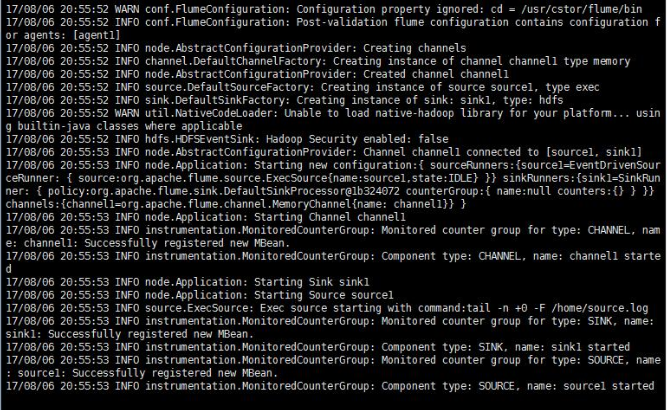

如果正常运行,最后悔显示 started,如图:

三 收集日志

1’ 启动成功之后需要手动生成消息源即配置文件中的/home/source.log,使用如下命令去不断的写入文字到/home/source.log中:

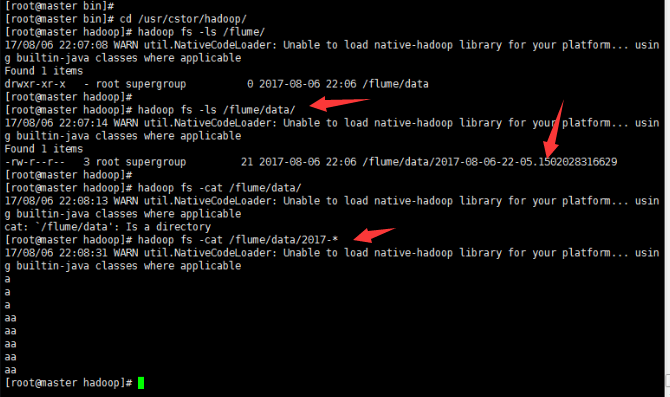

2' 到此就可以去查看生成结果:

小结:

这只是配置Flume,然后简单的读写日志。想要深入下去,还要收集更复杂,更庞大的日志。

大数据【八】Flume部署的更多相关文章

- 大数据(9) - Flume的安装与使用

Flume简介 --(实时抽取数据的工具) 1) Flume提供一个分布式的,可靠的,对大数据量的日志进行高效收集.聚集.移动的服务,Flume只能在Unix环境下运行. 2) Flume基于流式架构 ...

- FusionInsight大数据开发---Flume应用开发

Flume应用开发 要求: 了解Flume应用开发适用场景 掌握Flume应用开发 Flume应用场景Flume的核心是把数据从数据源收集过来,在送到目的地.为了保证输送一定成功,发送到目的地之前,会 ...

- 大数据学习——flume安装部署

1.Flume的安装非常简单,只需要解压即可,当然,前提是已有hadoop环境 上传安装包到数据源所在节点上 然后解压 tar -zxvf apache-flume-1.6.0-bin.tar.gz ...

- Redis安装,mongodb安装,hbase安装,cassandra安装,mysql安装,zookeeper安装,kafka安装,storm安装大数据软件安装部署百科全书

伟大的程序员版权所有,转载请注明:http://www.lenggirl.com/bigdata/server-sofeware-install.html 一.安装mongodb 官网下载包mongo ...

- 大数据之Flume

什么是Flume ApacheFlume是一个分布式的.可靠的.可用的系统,用于高效地收集.聚合和将大量来自不同来源的日志数据移动到一个集中的数据存储区. 系统要求 1. JDK 1.8 或以上版本 ...

- 大数据学习——flume日志分类采集汇总

1. 案例场景 A.B两台日志服务机器实时生产日志主要类型为access.log.nginx.log.web.log 现在要求: 把A.B 机器中的access.log.nginx.log.web.l ...

- 大数据学习——flume拦截器

flume 拦截器(interceptor)1.flume拦截器介绍拦截器是简单的插件式组件,设置在source和channel之间.source接收到的事件event,在写入channel之前,拦截 ...

- 入门大数据---通过Flume、Sqoop分析日志

一.Flume安装 参考:Flume 简介及基本使用 二.Sqoop安装 参考:Sqoop简介与安装 三.Flume和Sqoop结合使用案例 日志分析系统整体架构图: 3.1配置nginx环境 请参考 ...

- 最新版大数据平台安装部署指南,HDP-2.6.5.0,ambari-2.6.2.0

一.服务器环境配置 1 系统要求 名称 地址 操作系统 root密码 Master1 10.1.0.30 Centos 7.7 Root@bidsum1 Master2 10.1.0.105 Cent ...

- 成都大数据Hadoop与Spark技术培训班

成都大数据Hadoop与Spark技术培训班 中国信息化培训中心特推出了大数据技术架构及应用实战课程培训班,通过专业的大数据Hadoop与Spark技术架构体系与业界真实案例来全面提升大数据工程师 ...

随机推荐

- Java读取文件加锁代码Demo(利用Java的NIO)

本博文部分转载于:http://blog.csdn.net/wangbaochu/article/details/48546717 Java 提供了文件锁FileLock类,利用这个类可以控制不同程序 ...

- WebFlux基础之响应式编程

上篇文章,我们简单的了解了WebFlux的一些基础与背景,并通过示例来写了一个demo.我们知道WebFlux是响应式的web框架,其特点之一就是可以通过函数式编程方式配置route.另外究竟什么是响 ...

- Intellij IDEA 环境配置与使用

Intellij IDEA 是我感觉最牛X的IDE开发工具,没有之一! 先share一篇教程: http://pan.baidu.com/s/1i3fzJff 调整字体 设置默认的JDK 显示行号 版 ...

- tomcat如何正确的开启远程调试功能

在日常开发中,有时需要对远程服务器上的应用进行远程调试,对于tomcat,要进行远程调试其实很简单,只需要在启动tomcat时开启jpda服务即可. 什么是JPDA呢? JPDA(JavaPlatfo ...

- postgresql逻辑结构--表(二)

一.创建表 语法: create table table_name( col01_name data_type, col02_name data_type, col03_name data_type, ...

- Tomcat学习总结(11)——Linux下的Tomcat安全优化

1.web.xml配置及修改: 站点默认主页: <welcome-file-list> <welcome-file>index.html</welcome-file> ...

- 安装win8/win10提示无法在驱动器0分区上安装windows解决方法

在通过U盘或光盘安装win8/win8.1/win10系统时,不少用户遇到无法安装的问题,提示“无法在驱动器0的分区1上安装windows”,格式化分区1也不能解决,进而提示Windows无法安装到这 ...

- 布局中的BFC---重点是前言

一.前言 说实话,听到BFC这个概念我心里一阵咯噔,这到底是什么?有种似曾相识的感觉,但是又很模糊.问了一下度娘,看到张鑫旭的<CSS深入理解流体特性和BFC特性下多栏自适应布局>.呀,原 ...

- Java设计模式学习记录-简单工厂模式、工厂方法模式

前言 之前介绍了设计模式的原则和分类等概述.今天开启设计模式的学习,首先要介绍的就是工厂模式,在介绍工厂模式前会先介绍一下简单工厂模式,这样由浅入深来介绍. 简单工厂模式 做法:创建一个工厂(方法或类 ...

- C#Redis集合set

快过年了,任务也没那么多了,可以有时间了解下其他的内容,今天看到一个博客关于weex的,觉得还挺实用的,等有空了可以了解了解.不过还是把今年的目标要完成.今天继续redis. 一.前戏 在Redis中 ...