python BitTornado P2P分发大文件

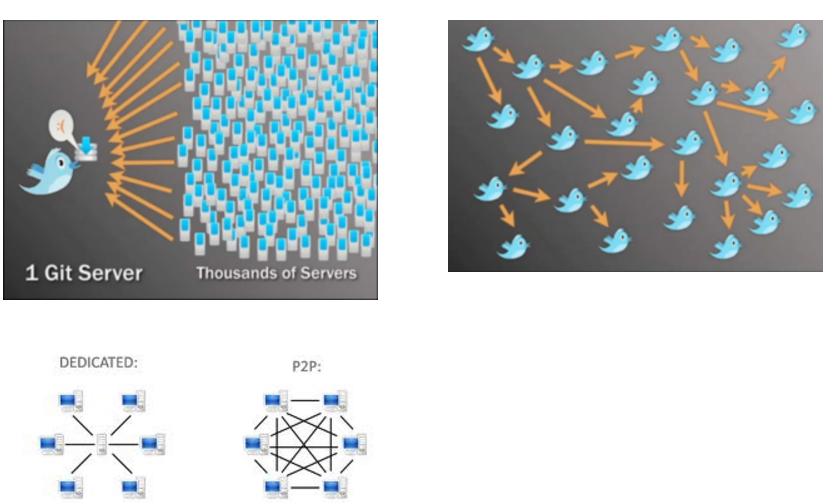

P2P分发大文件思路

1、将软件包生成种子文件

2、通过saltstack将种子文件分发至每台服务器

3、每台服务器进行种子下载

推荐使用Twitter开源的murder。Twitter用它来分发大文件完成代码更新。

下载地址: https://github.com/lg/murder

本文介绍murder的dist,它是基于python开发的。

murder dist

- murder_tracker.py 可以理解它为调度中心

- murder_make_torrent.py 生成种子,并且注册在调度中心

- murder_client.py 播种和获取文件包(上传、下载)

举例部署结构:

192.168.1.11 调度中心

192.168.1.12 种子生成、第一个播种文件服务器

192.168.1.100-200 下载文件

1、启动调度中心

- python murder_tracker.py --port 8998 --dfile data --logfile urder_tracker.log

- --port 监听的端口,默认是8998

- --dfile 存储近期下载信息的文件

- --logfile 日志文件,默认是标准输出

shell启动脚本

- #!/bin/bash

- #

- # Start/Stop murder-tracker

- #

- # description: murder-tracker

- # processname: murder-tracker

- if [ -f /etc/rc.d/init.d/functions ]; then

- . /etc/rc.d/init.d/functions

- fi

- name="murder-tracker"

- murder_tracker_bin="/usr/local/dist/murder_tracker.py"

- murder_tracker_log="/usr/local/dist/logs/murder_tracker.log"

- murder_tracker_data="/usr/local/dist/var/tracker_data"

- murder_user=murder

- find_tracker_process () {

- PID=`ps -ef | grep murder_tracker | grep python |grep -v $|grep -v grep|grep -v sh|grep -v root| awk '{ print $2 }'`

- echo $PID

- }

- start () {

- getent passwd $murder_user >/dev/null || useradd -r -s /sbin/nologin $murder_user

- LOG_DIR=`dirname ${murder_tracker_log}`

- DATA_DIR=`dirname ${murder_tracker_data}`

- if [ ! -d $LOG_DIR ]; then

- echo -e "\e[35mLog dir ${LOG_DIR} doesn't exist. Creating\e[0m"

- mkdir -p $LOG_DIR

- fi

- if [ ! -d $DATA_DIR ]; then

- echo -e "\e[35mLog dir ${DATA_DIR} doesn't exist. Creating\e[0m"

- mkdir -p $DATA_DIR

- fi

- chown -R $murder_user:$murder_user $DATA_DIR $LOG_DIR

- find_tracker_process

- if [ "$PID" != "" ]; then

- echo -e "\e[35m$name is already running!\e[0m"

- else

- daemon --user $murder_user nohup python $murder_tracker_bin --dfile $murder_tracker_data --logfile $murder_tracker_log > /dev/null >& &

- echo -e "\e[35mStarting $name Done\e[0m"

- fi

- }

- stop () {

- find_tracker_process

- if [ "$PID" != "" ]; then

- echo -e "\e[35mStopping $name\e[0m"

- kill $PID

- else

- echo -e "\e[35m$name is not running yet\e[0m"

- fi

- }

- case $ in

- start)

- start

- ;;

- stop)

- stop

- exit

- ;;

- restart)

- stop

- sleep

- start

- ;;

- status)

- find_tracker_process

- if [ "$PID" != "" ]; then

- echo -e "\e[35m$name is running: $PID\e[0m"

- exit

- else

- echo -e "\e[35m$name is not running\e[0m"

- exit

- fi

- ;;

- *)

- echo -e "\e[35mUsage: $0 {start|stop|restart|status}\e[0m"

- RETVAL=

- esac

- exit

2、生成种子文件

- python murder_make_torrent.py deploy.tar.gz 192.168.1.11:8998 deploy.torrent

3、创建第一个播种文件服务节点

- python murder_client.py seed deploy.torrent deploy.tar.gz 192.168.1.12

- 最后一个参数是本机的IP地址

4、通过saltstack将种子文件deploy.torrent发送到每台服务器上

5、所有节点192.168.1.100-200获取文件包,这些服务器下载文件,同时也承担播种节点

- python murder_client.py peer deploy.torrent deploy.tar.gz 192.168.1.xxx

- 最后一个参数是本机的IP地址

备注:这些主机分发时防火墙需要放开,程序中默认使用10000-60000之间端口,BitTornado/download_bt1.py中定义

- ('minport', 10000, 'minimum port to listen on, counts up if unavailable'),

- ('maxport', 60000, 'maximum port to listen on'),

- ('random_port', 1, 'whether to choose randomly inside the port range ' +

- 'instead of counting up linearly'),

参考博文:http://john88wang.blog.51cto.com/2165294/1793080

python BitTornado P2P分发大文件的更多相关文章

- 结合P2P软件使用Ansible分发大文件

一 应用场景描述 现在我需要向50+数量的服务器分发Logstash新版本的rpm包,大概220MB左右,直接使用Ansible的copy命令进行传输,命令如下: 1 ansible all -m ...

- Python:高效计算大文件中的最长行的长度

在操作某个很多进程都要频繁用到的大文件的时候,应该尽早释放文件资源(f.close()) 前2种方法主要用到了列表解析,性能稍差,而最后一种使用的时候生成器表达式,相比列表解析,更省内存 列表解析和生 ...

- 【Python】实现对大文件的增量读取

背景 前段时间在做一个算法测试,需要对源于日志的数据进行分析才能获取到结果:日志文件较大,所以想要获取数据的变化曲线,增量读取是最好的方式. 网上有很多人的技术博客都是写的用for循环readline ...

- python如何打开一个大文件?

with open('a.csv','r') as f: for i in f: print(i) while True: a = f.readline() if not a: break f.rea ...

- 在python中逐行读取大文件

在我们日常工作中,难免会有处理日志文件的时候,当文件小的时候,基本不用当心什么,直接用file.read()或readlines()就可以了,但是如果是将一个10G大小的日志文件读取,即文件大于内存的 ...

- Python之requests模块-大文件分片上传

最近在做接口测试时,拿到一个分片上传文件的接口,http接口请求头中的Content-Type为multipart/form-data.需要在客户端将大文件分片成数据块后,依次传给服务端,由服务端还原 ...

- python chunk 方式读取大文件——本质上还是file read自身支持

参考:https://stackoverflow.com/questions/519633/lazy-method-for-reading-big-file-in-python 最优雅方式: file ...

- python下载大文件

1. wget def download_big_file_with_wget(url, target_file_name): """ 使用wget下载大文件 Note: ...

- Python 大文件处理

非内存资源可以使用with 在python中逐行读取大文件 在我们日常工作中,难免会有处理日志文件的时候,当文件小的时候,基本不用当心什么,直接用file.read()或readlines()就可以了 ...

随机推荐

- webVR全景图多种方案实现(pannellum,aframe,Krpano,three,jquery-vrview)

前言 有一篇文章我说了H5实现全景图预览,全景视频播放的原理,有需要的小伙伴可以自行去看一下 今天我就拿出我的实践干货出来,本人实测实测过 需求 老板:我需要可以上传全景图片,然后手机网站上都可以36 ...

- 我的SQL SERVER数据库会装满吗?

概述 今天有个客户问我一个蛮有意思的问题.我使用的SQL SERVER 2008数据库,目前数据库130多G,其中某个表的记录条数就有3亿1千多万,占用了50多G.那SQL SERVER 数据库中的表 ...

- 《Effective Java》学习笔记 —— 枚举、注解与方法

Java的枚举.注解与方法... 第30条 用枚举代替int常量 第31条 用实例域代替序数 可以考虑定义一个final int 代替枚举中的 ordinal() 方法. 第32条 用EnumSet代 ...

- ERP条码解决方案,金蝶盘点机条码解决方案,应用PDA的信息化管理能给我们的生产管理带来怎么样的变化的探讨

ERP条码解决方案,金蝶盘点机条码解决方案,应用PDA的信息化管理能给我们的生产管理带来怎么样的变化的探讨. 当前越来越多的大大小小的中国企业已经接受了ERP的思想,大多数的商店,企业,工厂都会上一套 ...

- 基于tensorflow 1.x 的检索机器人chatbot-retrieval

Chatbot-retrieval说基于tensorflow的检索机器人,原版的代码路径是 https://github.com/dennybritz/chatbot-retrieval, 但是在te ...

- Linux第二章读书笔记

1.获取内核源码 1.1Git 分布式的:下载和管理Linux内核源代码: - 获取最新提交到版本树的一个副本 $ git clone git://git.kernel.org/pub/scm/lin ...

- Git学习笔记 --第一章

本系列学习笔记参考廖雪峰Git教程 安装Git Linux平台 Ubuntu/Debian命令:sudo apt-get install git 其他版本 Git官网下载源码,然后解压,依次输入:. ...

- dispatch_block_t

通常我写一个不带参数的块回调函数是这样写的 在 . h 头文件中 定义类型 typedef void (^leftBlockAction)(); 在定义一个回调函数 -(void)leftButton ...

- ELK 性能(2) — 如何在大业务量下保持 Elasticsearch 集群的稳定

ELK 性能(2) - 如何在大业务量下保持 Elasticsearch 集群的稳定 介绍 如何在大业务量下保持 Elasticsearch 集群的稳定? 内容 当我们使用 Elasticsearch ...

- 【补】debug

懒得翻别人博客了,之前的按钮不显示名字,应该是文字ui文件名写错了. 现在不存在任何已知bug.