02_Flume1.6.0安装及单节点Agent实践

Flume1.6.0的安装

1、上传Flume-1.6.0-tar.gz到待部署的所有机器

以我的为例: /usr/local/src/

2、解压得到flume文件夹

# tar -xzvf flume-1.6.0-tar.gz

3、修改文件夹名称,属主,及权限

# mv flume-1.6.0 flume

# chown -R root:root flume

# chmod 755 flume

4、安装完毕,解压后可以直接使用,通过flume/conf下的配置文件修改就可以各种调戏了~

实践1 - 单节点Agent

1、配置文件

# -flume-netcat-test

# agent name: a1

# source: netcat

# channel: memory

# sink: logger, local console # define source,channel,sink name

a1.sources = r1

a1.channels = c1

a1.sinks = k1 # define source

a1.sources.r1.type = netcat

a1.sources.r1.bind = localhost # ip地址也OK

a1.sources.r1.port = # define sink

a1.sinks.k1.type = logger # flume sink将拉取到的信息,event形式打印到自己被启动时的终端 # define channel

a1.channels.c1.type = memory

# number of events in memory queue 内存队列中的最大event数值

a1.channels.c1.capacity =

# number of events for commit(每次向memory queuet放入event,取出event的最大值),所以肯定是比内存队列中的event小

a1.channels.c1.transactioncapacity = # bind source,sink to channel

a1.sources.r1.channels = c1 # 1个source可以有多个channel

a1.sinks.k1.channel = c1 # 1个sink只能从1个channel取数据

2、启动本节点上的flume agent

# bin/flume-ng agent --conf conf --conf-file ./conf/flume-netcat.properties --name a1 -Dflume.root.logger=INFO,console

解读:使用conf目录下的flume-netcat.properties文件,启动agent, agent的名称为a1;

flume向console打印INFO级别及以上的日志信息

3、观察Flume agent的启动

flume启动过程中会向当前console打印INFO及以上级别的日志,在日志的最后可以看到a1启动,并且netcat source启动了1个serversocket,监听本机的4444端口

4、测试该Agent

再开启1个到telnet到Agent所在机器的命令行窗口,连接建立后输入数据,查看flume是否向console打印出了输入数据

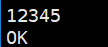

1) telnet输入

2) Flume输出event到console

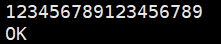

3) telnet输入16个以上字符

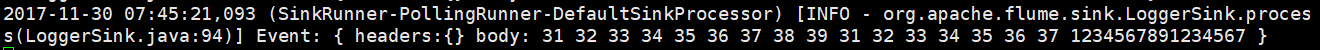

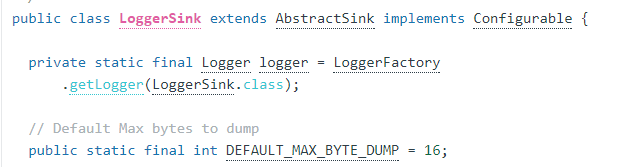

4) Flume的logger sink, 输出event只有16个字符

telnet退出:ctrl+], 然后quit

通过flume的Git源码发现,默认情况下logger sink能够输出的最大字符数为16,该问题已经被提交修改,但flume-1.6.0版本并没有解决该问题

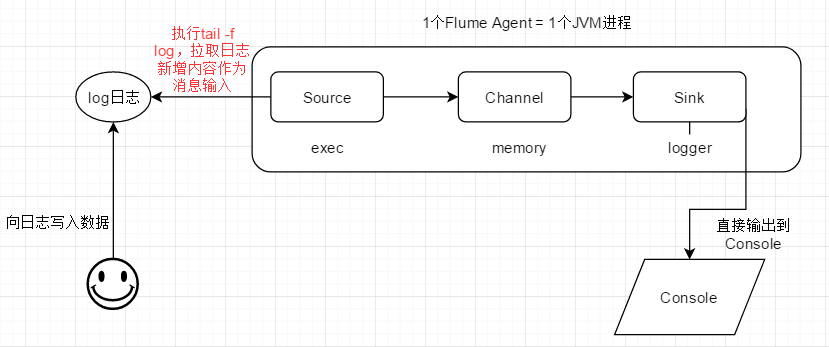

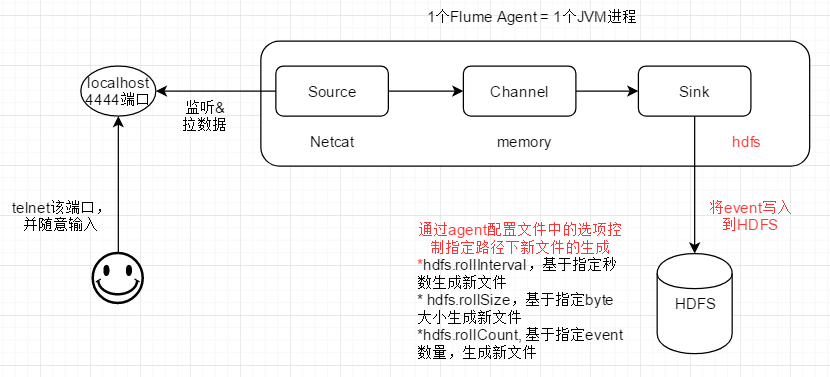

实践2 - 单节点Agent

exec source:执行配置文件中给定的命令,监听命令的输出,输出的每一行被作为一个event

1、停止前一个flume agent进程

# ps -aux | grep flume 找到该进程的pid

# kill pid 不要kill -9 pid

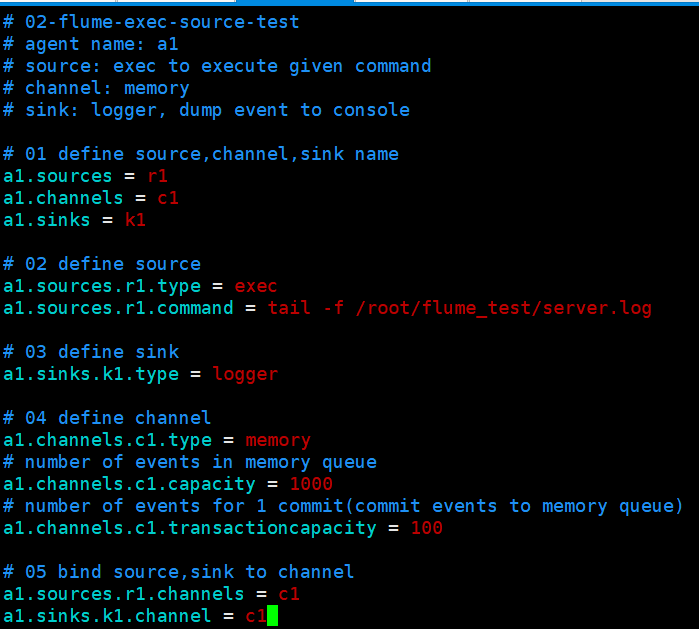

2、配置文件

3、在agent运行的主机上创建测试用log文件,和配置文件中的路径及名称保持一致:/root/flume_test/server.log

4、启动本节点上的flume agent

# bin/flume-ng agent --conf conf --conf-file ./conf/flume-exec.properties --name a1 -Dflume.root.logger=INFO,console

解读:

使用conf目录下的flume-exec.properties文件,启动agent, agent的名称为a1;

flume向console打印INFO级别及以上的日志信息

5、根据flume agent启动时的日志,判断exec agent是否正常启动,执行给定命令,并监听输出(一行为一个event)

6、向flume agent机器上的测试log日志,写入内容,查看flume是否将新的输出转换为event,最终输出到终端

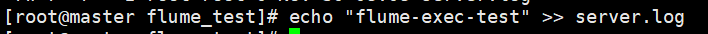

1)管道追加方式向server.log文件写入数据

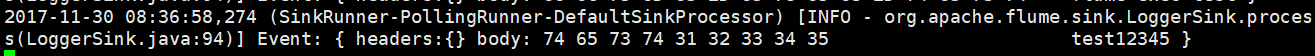

2)flume输出event到自身被启动时的终端

3)再追加一次

4)查看flume是否输出event到自身被启动时的终端

5)查看server.log的文件结构,验证是否一行数据对应一个event

管道方式追加,在文件中生成了2行记录,分别对应一个flume event (命令执行结果的每一行输出,对应一个event)

实践3 - 单节点Agent

1、停止前一个flume agent进程

# ps -aux | grep flume 找到该进程的pid

# kill pid 不要kill -9 pid

2、配置文件

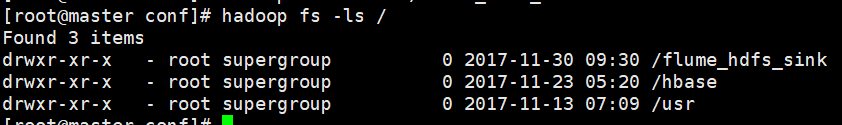

3、在HDFS上创建event落地的目录

# hadoop fs -mkdir /flume_hdfs_sink

4、启动本节点上的flume agent

# bin/flume-ng agent --conf conf --conf-file ./conf/flume-hdfs.properties --name a1 -Dflume.root.logger=INFO,console

解读:

使用conf目录下的flume-hdfs.properties文件,启动agent, agent的名称为a1;

flume向console打印INFO级别及以上的日志信息

5. 再开启1个到telnet到Agent所在机器的命令行窗口,连接建立后输入数据,查看flume是否在HDFS目录上生成文件,将event写入

1) telnet输入

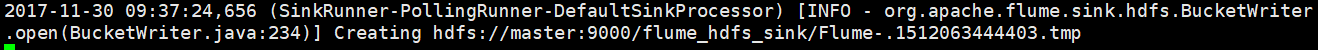

2) Flume输出

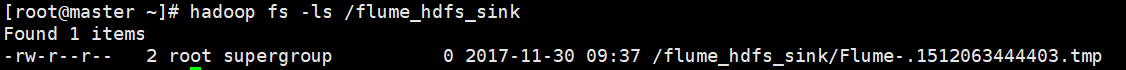

HDFS上此时存在临时文件,数据还没有真正写入

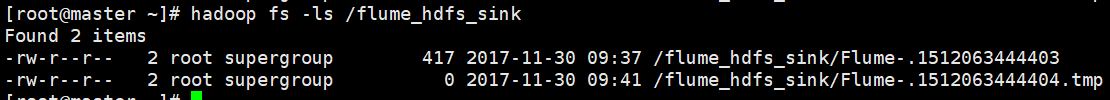

3) telnet多次输入,第11次写入时,HDFS上落地生成新文件(rollCount=10此时满足)

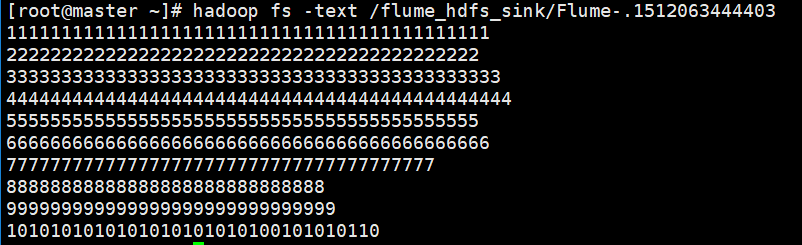

查看HDFS文件的内容

落地到HDFS文件中的内容,将只保留实际数据,不再是event形式

HDFS Sink的配置项参考(来自flume官网用户手册)

02_Flume1.6.0安装及单节点Agent实践的更多相关文章

- hbase伪分布式安装(单节点安装)

hbase伪分布式安装(单节点安装) http://hbase.apache.org/book.html#quickstart 1. 前提配置好java,环境java变量 上传jdk ...

- Elasticsearch.安装(单节点)

Elasticsearch.安装(单节点) 环境Linux 7.x jdk 1.8 elasticsearch 5.x 环境目录结构(根目录多了两个文件夹): /resources /** 存放 ...

- Ubuntu 12.04 Openstack Essex 安装(单节点)

这是陈沙克一篇非常好的博文,当时在进行openstack排错的时候,多亏了这篇文章里面有些内容 帮我找到了问题的所在: 原文:http://www.chenshake.com/ubuntu-12-04 ...

- 离线安装Cloudera Manager 5和CDH5(最新版5.9.3) 完全教程(四)数据库安装(单节点)

一.卸载CentOS自带的MySQL 1.1 查看之前是否安装过mysql [root@master mysql]# rpm -qa|grep -i mysql mysql-libs--.el6.x8 ...

- Dubbo入门到精通学习笔记(八):ActiveMQ的安装与使用(单节点)、Redis的安装与使用(单节点)、FastDFS分布式文件系统的安装与使用(单节点)

文章目录 ActiveMQ的安装与使用(单节点) 安装(单节点) 使用 目录结构 edu-common-parent edu-demo-mqproducer edu-demo-mqconsumer 测 ...

- .netcore consul实现服务注册与发现-单节点部署

原文:.netcore consul实现服务注册与发现-单节点部署 一.Consul的基础介绍 Consul是HashiCorp公司推出的开源工具,用于实现分布式系统的服务发现与配置.与其他分 ...

- 02_Kafka单节点实践

1.实践场景 开始前的准备条件: 1) 确认各个节点的jdk版本,将jdk升级到和kafka配套的版本(解压既完成安装,修改/etc/profile下的JAVA_HOME,source /etc/pr ...

- kafka系列一:单节点伪分布式集群搭建

Kafka集群搭建分为单节点的伪分布式集群和多节点的分布式集群两种,首先来看一下单节点伪分布式集群安装.单节点伪分布式集群是指集群由一台ZooKeeper服务器和一台Kafka broker服务器组成 ...

- Cloudera Manager安装之利用parcels方式安装单节点集群(包含最新稳定版本或指定版本的安装)(添加服务)(CentOS6.5)(四)

不多说,直接上干货! 福利 => 每天都推送 欢迎大家,关注微信扫码并加入我的4个微信公众号: 大数据躺过的坑 Java从入门到架构师 人工智能躺过的坑 ...

随机推荐

- java list map用法

1.初始化,方法1 //初始化List List<string> list = new ArrayList</string><string>(); list.add ...

- 解决FileInputStream读取文本时 最后端会多出字符问题

使用 read(byte[]) 方法读取文本的时候,要用 String str = new String(byte[],int offset,int len) 来将数组中的元素转换为String字符串 ...

- openstack 部署笔记--neutron控制节点

控制节点 配置neutron用户及服务 $ . admin-openrc $ openstack user create --domain default --password-prompt neut ...

- php中&运算符的理解与使用

php的引用(就是在变量或者函数.对象等前面加上&符号) 在PHP 中引用的意思是:不同的名字访问同一个变量内容. 变量的引用 PHP 的引用允许你用两个变量来指向同一个内容 例一: < ...

- python写http post请求的四种请求体

Web自动化测试(25) HTTP 协议规定 POST 提交的数据必须放在消息主体(entity-body)中,但协议并没有规定数据必须使用什么编码方式.常见的四种编码方式如下: 1.appli ...

- Oracle的FIXED_DATE参数

今天发现一个有意思的问题, 我们知道,在Oracle数据库中正常执行 select sysdate from dual 都可以返回当前主机的系统时间. 正常修改系统时间,对应的查询结果也会变成修改后的 ...

- VMware Coding Challenge: The Heist

类似BackpackII问题 static int maximize_loot(int[] gold, int[] silver) { int[][] res = new int[gold.lengt ...

- OAuth 白话简明教程 1.简述

转自:http://www.cftea.com/c/2016/11/6702.asp OAuth 白话简明教程 1.简述 OAuth 白话简明教程 2.授权码模式(Authorization Code ...

- mysql的转储SQL文件

1.转储数据库的SQL文件,有两个选择,一是转储结构:另一种是转储数据与结构: 2.以上两种转储都不会将事件(定时器)转储,所以特别注意这个,否则以为将数据库备份完了,其实漏掉了所有的事件代码,所以需 ...

- C++11使用emplace_back代替push_back

最近在写一段代码的时候,突然很好奇C++11中对push_back有没有什么改进以增加效率,上网搜了一些资料,发现果然新增了emplace_back方法,比push_back的效率要高很多. 首先,写 ...