Neural Networks and Deep Learning 课程笔记(第三周)浅层神经网络(Shallow neural networks)

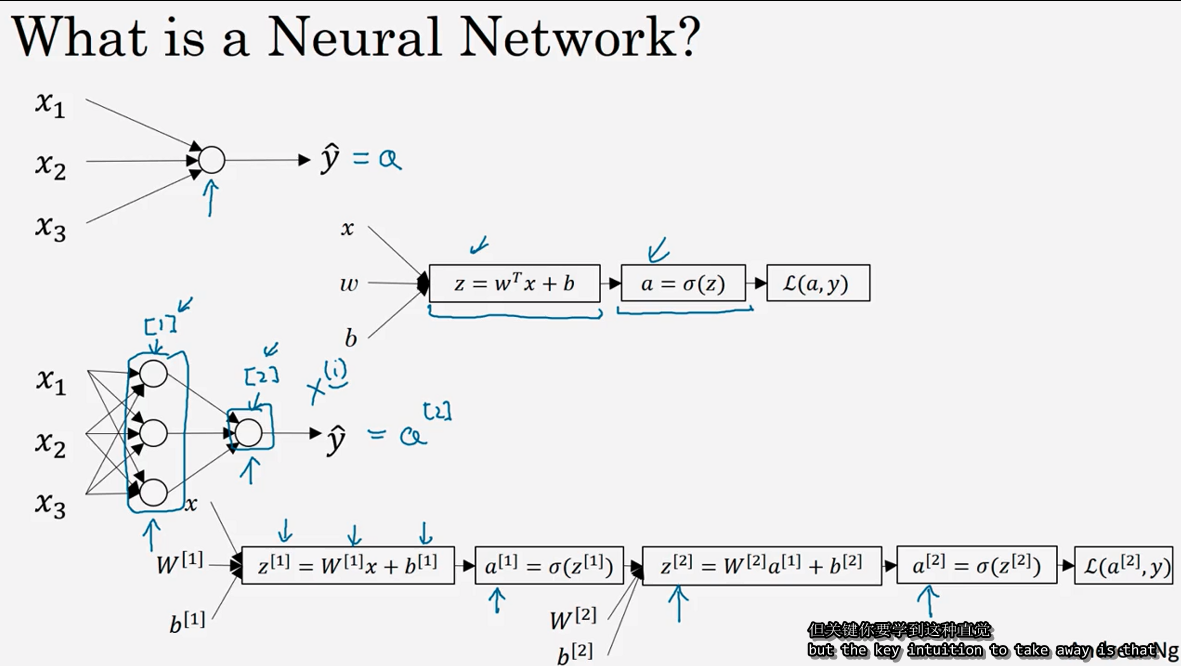

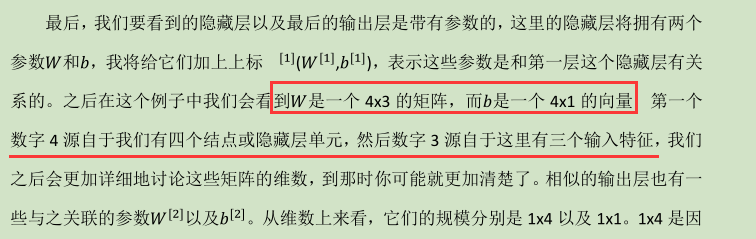

3.1 神经网络概述(Neural Network Overview )

(神经网络中,我们要反复计算a和z,最终得到最后的loss function)

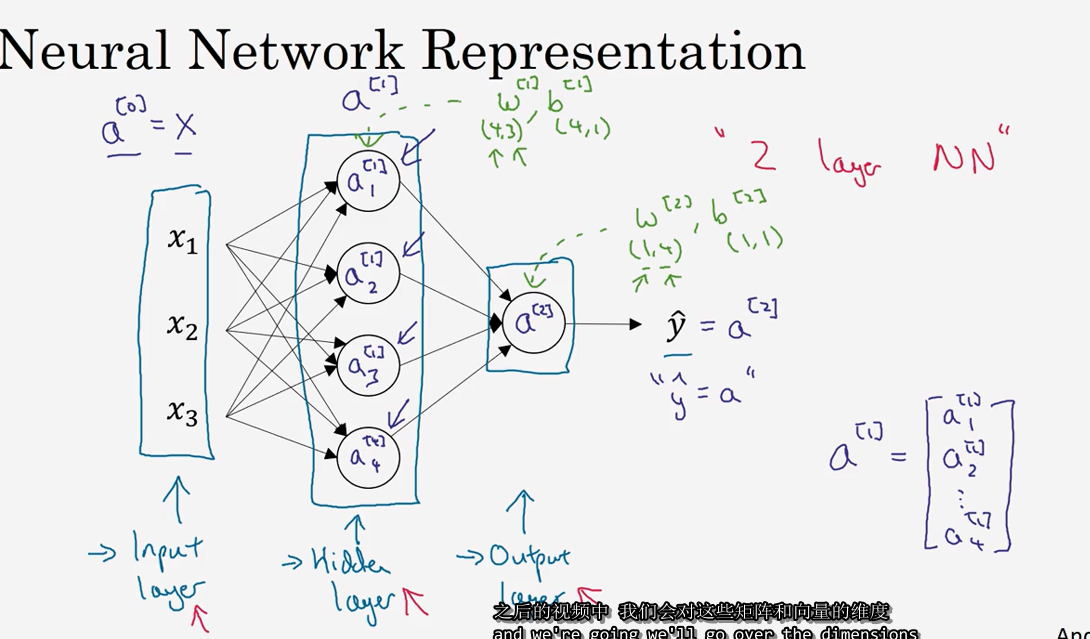

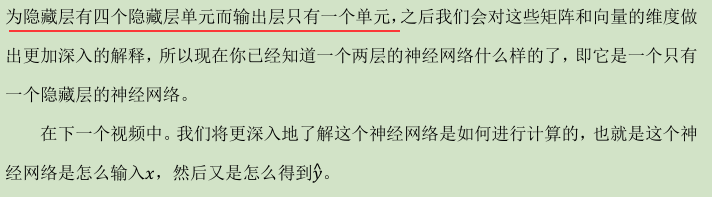

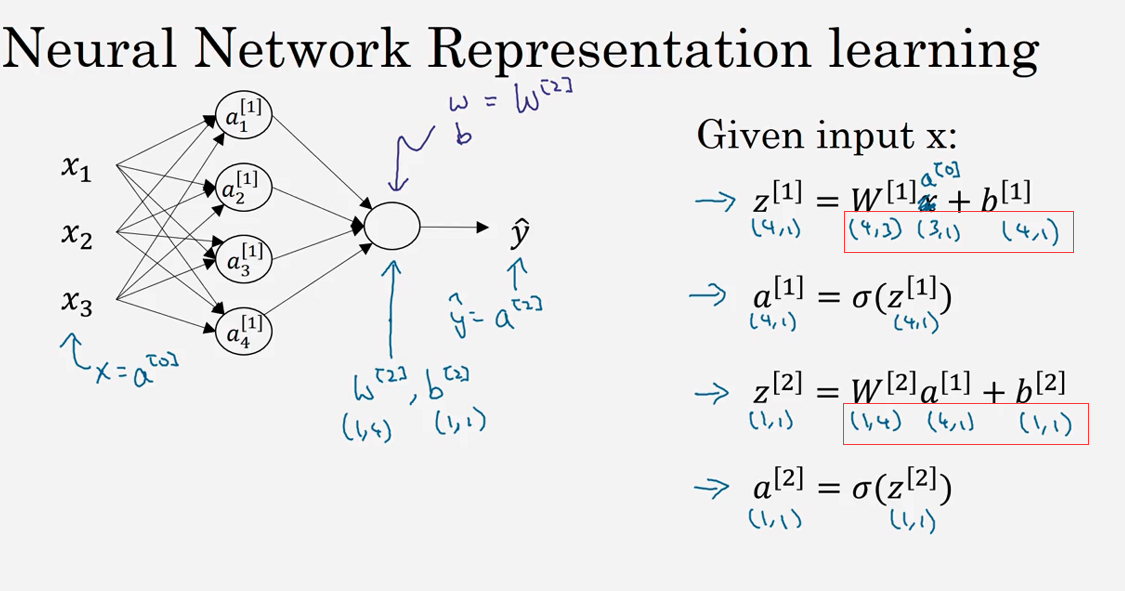

3.2 神经网络的表示(Neural Network Representation)

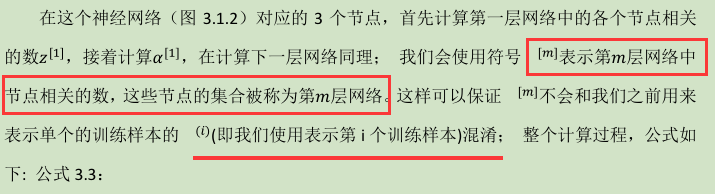

3.3 计算一个神经网络的输出(Computing a Neural Network's output )

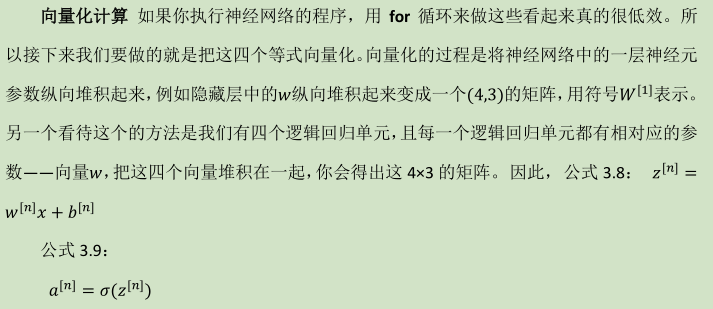

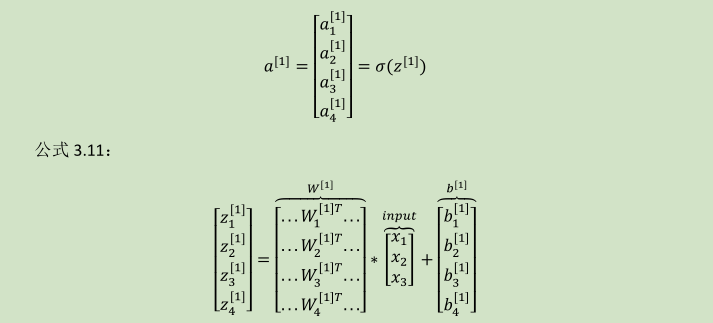

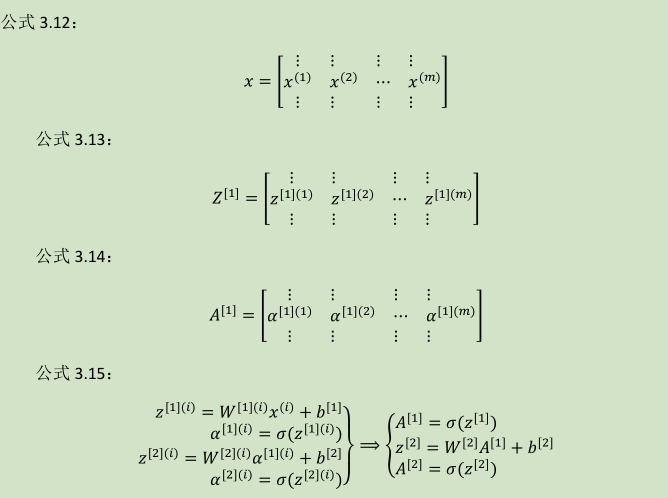

向量化计算:

详细过程见下: 公式 3.10:

(W---4x3)

(W---4x3)

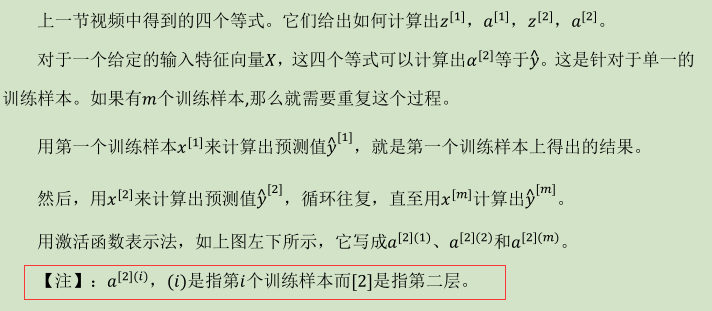

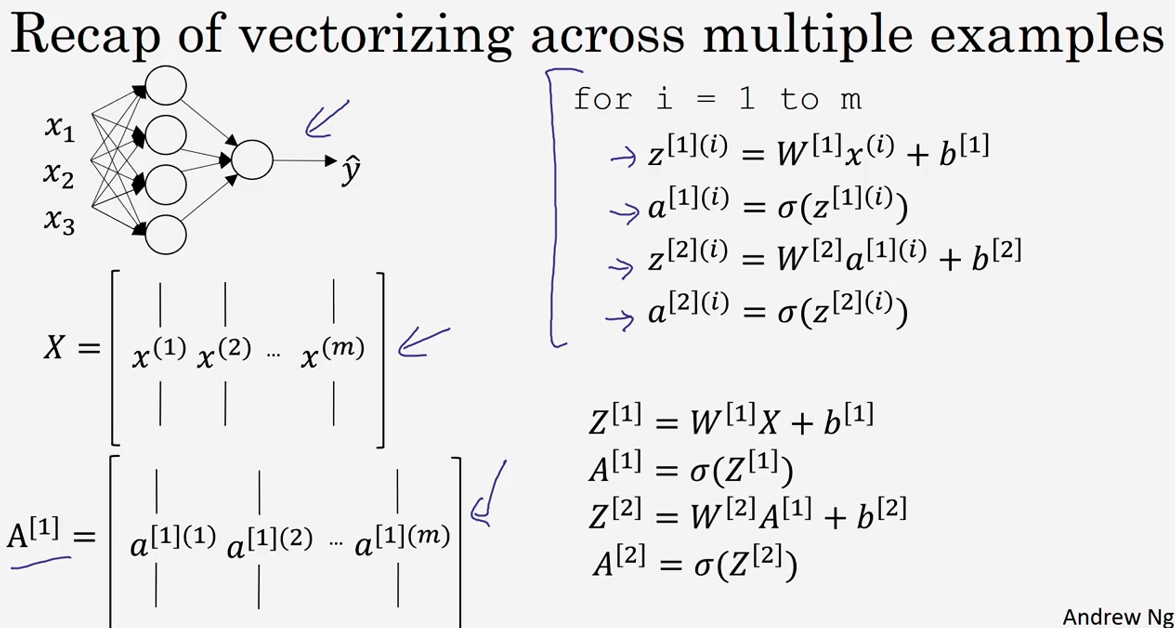

3.4 多样本向量化(Vectorizing across multiple examples )

所以横向矩阵A会扫过不同的训练样本,竖向是矩阵A中的不同指标。

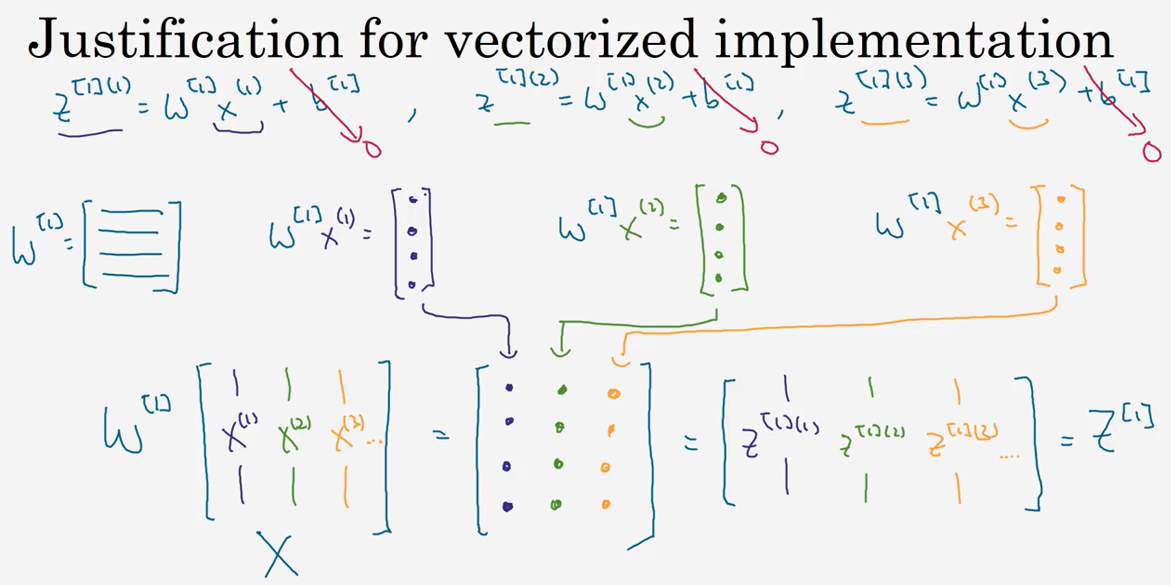

3.5 向 量 化 实 现 的 解 释 (Justification for vectorized implementation)

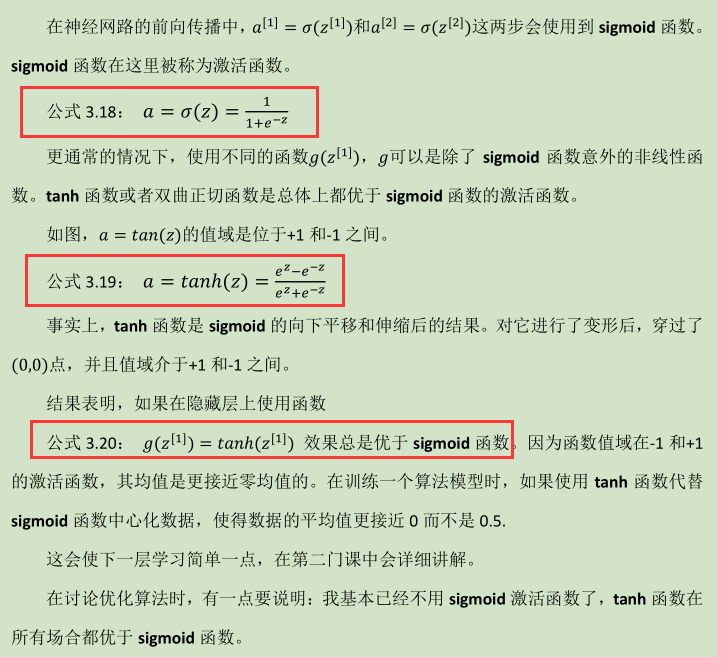

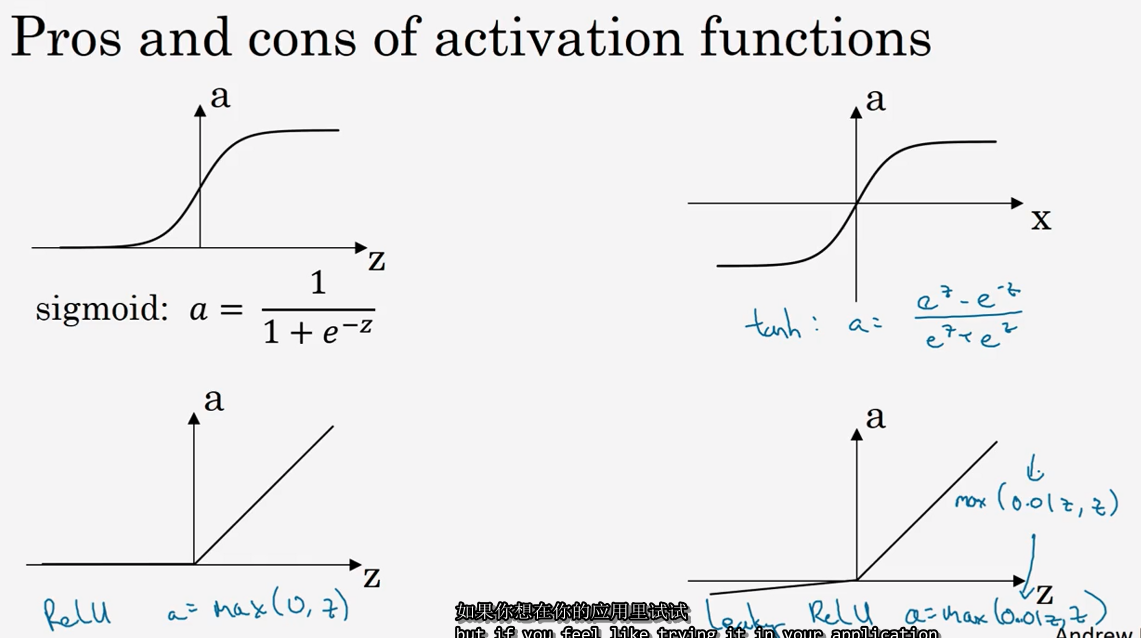

3.6 激活函数 (Activation functions)

tanh函数

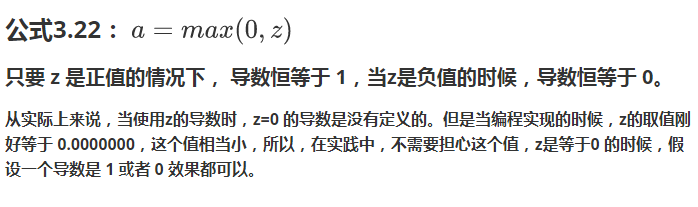

修正线性单元的函数(ReLu)(默认选项!)

如果输出是 0、1 值(二分类问题),则输出层选择 sigmoid 函数,然后其它的所有单元都选择 Relu 函数。

这是很多激活函数的默认选择,如果在隐藏层上不确定使用哪个激活函数,那么通常会使用 Relu 激活函数。有时,也会使用 tanh 激活函数,但 Relu 的一个缺点是:当z是负值的时候,导数等于 0。

这里也有另一个版本的 Relu 被称为 Leaky Relu。当z是负值时,这个函数的值不是等于 0,而是轻微的倾斜,如图。这个函数通常比 Relu 激活函数效果要好,尽管在实际中 Leaky ReLu 使用的并不多。

快速概括一下不同激活函数的过程和结论。

- sigmoid 激活函数:除了输出层是一个二分类问题基本不会用它。

- tanh 激活函数:tanh 是非常优秀的,几乎适合所有场合。

- ReLu 激活函数:最常用的默认函数,,如果不确定用哪个激活函数,就使用 ReLu

- Leaky ReLu: 公式 3.23:

Neural Networks and Deep Learning 课程笔记(第三周)浅层神经网络(Shallow neural networks)的更多相关文章

- Neural Networks and Deep Learning 课程笔记(第四周)深层神经网络(Deep Neural Networks)

1. 深层神经网络(Deep L-layer neural network ) 2. 前向传播和反向传播(Forward and backward propagation) 3. 总结 4. 深层网络 ...

- Neural Networks and Deep Learning 课程笔记(第二周)神经网络的编程基础 (Basics of Neural Network programming)

总结 一.处理数据 1.1 向量化(vectorization) (height, width, 3) ===> 展开shape为(heigh*width*3, m)的向量 1.2 特征归一化( ...

- 吴恩达《深度学习》-第一门课 (Neural Networks and Deep Learning)-第三周:浅层神经网络(Shallow neural networks) -课程笔记

第三周:浅层神经网络(Shallow neural networks) 3.1 神经网络概述(Neural Network Overview) 使用符号$ ^{[

- Neural Networks and Deep Learning学习笔记ch1 - 神经网络

近期開始看一些深度学习的资料.想学习一下深度学习的基础知识.找到了一个比較好的tutorial,Neural Networks and Deep Learning,认真看完了之后觉得收获还是非常多的. ...

- 吴恩达《深度学习》-第二门课 (Improving Deep Neural Networks:Hyperparameter tuning, Regularization and Optimization)-第一周:深度学习的实践层面 (Practical aspects of Deep Learning) -课程笔记

第一周:深度学习的实践层面 (Practical aspects of Deep Learning) 1.1 训练,验证,测试集(Train / Dev / Test sets) 创建新应用的过程中, ...

- AndrewNG Deep learning课程笔记 - CNN

参考, An Intuitive Explanation of Convolutional Neural Networks http://www.hackcv.com/index.php/archiv ...

- AndrewNG Deep learning课程笔记

神经网络基础 Deep learning就是深层神经网络 神经网络的结构如下, 这是两层神经网络,输入层一般不算在内,分别是hidden layer和output layer hidden layer ...

- AndrewNG Deep learning课程笔记 - RNN

The Unreasonable Effectiveness of Recurrent Neural Networks,http://karpathy.github.io/2015/05/21/rnn ...

- 《Neural Networks and Deep Learning》课程笔记

Lesson 1 Neural Network and Deep Learning 这篇文章其实是 Coursera 上吴恩达老师的深度学习专业课程的第一门课程的课程笔记. 参考了其他人的笔记继续归纳 ...

随机推荐

- Selenium Grid的Java调用方法

java -jar selenium-server-standalone-.jar -role hub explorer http://192.168.1.173:4444/grid/console ...

- mysql 表注释的添加、查看 、修改

表创建时添加注释: create table user( id int not null default 0 comment '用户id', account varchar(20) not nul ...

- Oracle 数据库 Only 导出空表的方法

1. 之前因为oracle11.2.0.1 的bug(deferred_segment_creation) 引起无法将空表导出. 有时给同事解释上半个小时他们也不知道 如何处理 或者是 他们不会用ex ...

- SQLSERVER case when 的学习

sqlserver 查询时的CASE WHEN学习记录 ) as '任务数', RPATask_State as id, case RPATask_State when then '已接收' when ...

- Qt__文件打开保存对话框(QFileDialog)

转自豆子空间 使用QFileDialog有两种方法,一种是比较简单的使用"静态函数法",另一种是可以自定义各个细节的"构造函数法". 静态函数法 修改MainW ...

- 关于mybatis的@Param注解和参数

1,使用@Param注解 当以下面的方式进行写SQL语句时: @Select("select column from table where userid = #{userid} " ...

- java List 根据属性排序

Collections.sort(fileItems, new Comparator<FileItem>() { public int compare(FileItem arg0, Fil ...

- BZOJ4127Abs——树链剖分+线段树

题目描述 给定一棵树,设计数据结构支持以下操作 1 u v d 表示将路径 (u,v) 加d 2 u v 表示询问路径 (u,v) 上点权绝对值的和 输入 第一行两个整数n和m,表示结点个数和操作数 ...

- Java8 使用

Java8 使用 链接:https://www.jianshu.com/p/936d97ba0362 链接:https://www.jianshu.com/p/41de7b5ac7b9 本文主要总结了 ...

- STM32外设地址查询

问题的提出 DMA传输SDIO驱动的SD卡的数据,其中外设地址的确定 问题的解决 打开数据参考手册,在存储器和总线架构一章存储器映像小节,有一个寄存器组起始地址表,列举所有外设对应的起始地址,再到相应 ...

- Neural Networks and Deep Learning 课程笔记(第四周)深层神经网络(Deep Neural Networks)