Spark 个人实战系列(1)--Spark 集群安装

前言:

CDH4不带yarn和spark, 因此需要自己搭建spark集群. 这边简单描述spark集群的安装过程, 并讲述spark的standalone模式, 以及对相关的脚本进行简单的分析.

spark官网: http://spark.apache.org/downloads.html

*)安装和部署

环境: 172.16.1.109~172.16.1.111三台机器(对应域名为tw-node109~tw-node111), centos6.4, 已部署cdh4

目标是: 搭建一个spark集群(standlone), 部署目录统一为$SPARK_HOME=/root/mmxf/spark, 172.16.1.109部署Master, 172.16.1.109~172.16.1.111部署Worker节点.

预先的准备工作:

#) 在各个节点已配置/etc/hosts

172.16.1.109 tw-node109

172.16.1.110 tw-node110

172.16.1.111 tw-node111

#) 进行ssh无密钥登录设置(ssh-genkey, ssh-copy-it)

1. 下载pre-build cdh4版spark

wget http://mirrors.hust.edu.cn/apache/spark/spark-1.0.1/spark-1.0.1-bin-cdh4.tgz

2. 解压spark

tar zxvf spark-1.0.1-bin-cdh4.tgz

ln -s spark-1.0.1-bin-cdh4 spark

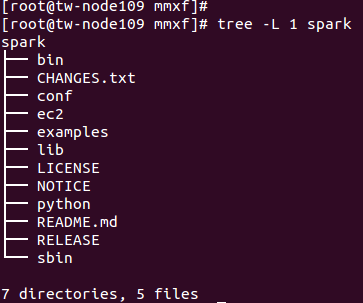

目录结构如下:

3. 配置属性

配置${SPARK_HOME}/conf/spark-env.sh

cd conf/

cp spark-env.sh.template spark-env.sh

SPARK_MASTER_IP=172.16.1.109

SPARK_MASTER_PORT=7077

MASTER=spark://${SPARK_MASTER_IP}:${SPARK_MASTER_PORT}

修改${SPARK_HOME}/conf/slaves

tw-node109

tw-node110

tw-node111

4. 使用rsync做同步

SPARK_INSTALL_DIR=/root/mmxf

rsync -avh ${SPARK_INSTALL_DIR} <username>@<server>:${SPARK_INSTALL_DIR}

rsync -avh /root/mmxf/ root@172.16.1.110:/root/mmxf/

rsync -avh /root/mmxf/ root@172.16.1.111:/root/mmxf/

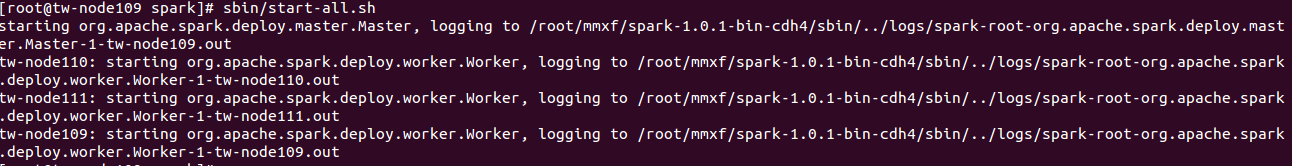

5. 启用服务

sbin/start-all.sh

sbin/stop-all.sh

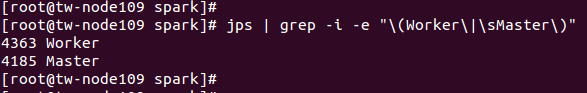

6. 验证

jps | grep -i -e "\(Worker\|\sMaster\)"

集群UI展示

官方提供的测试用例: bin/run-example SparkPi 10

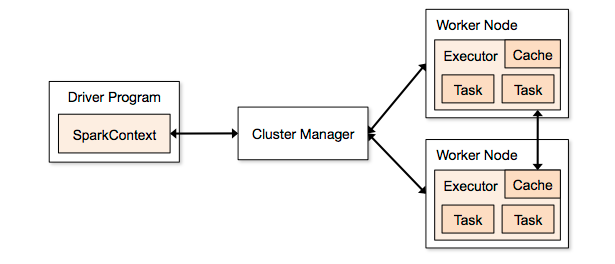

7. standlalone架构

总结:

spark集群的搭建还是很简单的, 服务启动维护亦然.

Spark 个人实战系列(1)--Spark 集群安装的更多相关文章

- Spark入门实战系列--3.Spark编程模型(下)--IDEA搭建及实战

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 . 安装IntelliJ IDEA IDEA 全称 IntelliJ IDEA,是java语 ...

- Spark入门实战系列--1.Spark及其生态圈简介

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .简介 1.1 Spark简介 年6月进入Apache成为孵化项目,8个月后成为Apache ...

- Spark入门实战系列--2.Spark编译与部署(上)--基础环境搭建

[注] 1.该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取: 2.Spark编译与部署将以CentOS 64位操作系统为基础,主要是考虑到实际应用 ...

- Spark入门实战系列--2.Spark编译与部署(下)--Spark编译安装

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .编译Spark .时间不一样,SBT是白天编译,Maven是深夜进行的,获取依赖包速度不同 ...

- Spark入门实战系列--3.Spark编程模型(上)--编程模型及SparkShell实战

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .Spark编程模型 1.1 术语定义 l应用程序(Application): 基于Spar ...

- Spark入门实战系列--4.Spark运行架构

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 1. Spark运行架构 1.1 术语定义 lApplication:Spark Appli ...

- Spark入门实战系列--7.Spark Streaming(上)--实时流计算Spark Streaming原理介绍

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .Spark Streaming简介 1.1 概述 Spark Streaming 是Spa ...

- Spark入门实战系列--7.Spark Streaming(下)--实时流计算Spark Streaming实战

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .实例演示 1.1 流数据模拟器 1.1.1 流数据说明 在实例演示中模拟实际情况,需要源源 ...

- Spark入门实战系列--8.Spark MLlib(下)--机器学习库SparkMLlib实战

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .MLlib实例 1.1 聚类实例 1.1.1 算法说明 聚类(Cluster analys ...

- Spark入门实战系列--9.Spark图计算GraphX介绍及实例

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .GraphX介绍 1.1 GraphX应用背景 Spark GraphX是一个分布式图处理 ...

随机推荐

- Redis - pipelining(管道)

客户端向服务器发送一个查询请求,并监听 socket 返回,等待服务器响应.通常是阻塞模式,在收到服务器响应之前是挂起的,不能继续发送请求. 可以使用管道来改善这种情况.在使用管道的情况下,客户端可以 ...

- 背景:表A数据误操作,被delete了,恢复。

SELECT MAX(Scn) FROM Sys.Smon_Scn_Time WHERE Time_Dp < TO_DATE('2015-09-18', 'YYYY/MM/DD') select ...

- union (共用声明和共用一变量定义)

"联合"是一种特殊的类,也是一种构造类型的数据结构.在一个"联合"内可以定义多种不同的数据类型, 一个被说明为该"联合"类型的变量中,允许装 ...

- 0020 Linux 文件操作命令

1. 创建文件 touch 文件名 2. 删除文件 rm 文件名 3. 复制文件 cp 源文件 目录 4.剪切文件 mv 源文件 目标文件 5.重命名文件 mv 源文件名 新文件名 6.改变文件权限 ...

- GUI 测试

图形用户界面( GUI )对软件测试提出了有趣的挑战,因为 GUI 开发环境有可复用的构件,开发用户界面更加省时而且更加精确.同时, GUI 的复杂性也增加了,从而加大了设计和执行测试用例的难度.因为 ...

- 加强型无穷集合:InfiniteList<T>,可指定遍历方向和偏移量,只要集合有元素并且偏移量不为 0,将永远遍历下去。

主类: public class InfiniteList<T> : IEnumerable<T> { public List<T> SourceList { ge ...

- 修改placeholder提示内容的颜色以及文本框输入文字内容的颜色

一般表单文本框提示信息:placeholder=" ",默认颜色是灰色的,输入文本信息也是默认为黑色的,如图所示: 修改placeholder提示内容的颜色关键代码及实现: 实现输 ...

- [双连通分量] POJ 3694 Network

Network Time Limit: 5000MS Memory Limit: 65536K Total Submissions: 9434 Accepted: 3511 Descripti ...

- android-Okhttp初步使用

自从谷歌把android的请求框架换成Okhttp后,android开发人员对其的讨论就变的越来越火热,所有咱作为一枚吊丝android程序员,也不能太落后,所以拿来自己研究一下,虽然目前项目开发用的 ...

- C语言样式的文件操作函数

使用C语言样式的文件操作函数,需要包含stdio.h头文件. 1.打开文件的函数: //oflag的取值为“w”或“r”,分别表示以写或读的方式打开 FILE* fd = fopen(filename ...