Python 爬虫入门(一)

毕设是做爬虫相关的,本来想的是用java写,也写了几个爬虫,其中一个是爬网易云音乐的用户信息,爬了大概100多万,效果不是太满意。之前听说Python这方面比较强,就想用Python试试,之前也没用过Python。所以,边爬边学,边学边爬。废话不多说,进入正题。

1.首先是获取目标页面,这个对用python来说,很简单

#encoding=utf8

import urllib res = urllib.urlopen("http://www.baidu.com")

print res.read()

运行结果和打开百度页面,查看源代码一样。这里针对python的语法有几点说明。

a).import 就是引入的意思,java也用import,C/C++用的是include,作用一样

b).urllib 这个是python自带的模块,在以后开发的时候,如果遇到自己需要的功能,python自带的模块中没有的时候,可以试着去网上找一找,比如需要操作MySql数据 库,这个时候python是没有自带的,就可以在网上找到MySQLdb,然后安装引入就行了。

c).res是一个变量,不用像java,C语言那样声明。用的时候直接写就行了

d).标点符号。像java,C这些语言,每行代码后面都要用分号或者别的符号,作为结束标志,python不用,用了反了会出错。不过有的时候,会用标点符号,比如冒号, 这个后面再说

e).关于print,在python2.7中,有print()函数,也有print 语句,作用基本差不多。

f).#注释

g).encoding=utf8代表使用utf8编码,这个在代码中有中文的时候特别有用

2.解析获取的网页中的元素,取得自己想要的,以豆瓣为例,我们想获取这个页面中的所有书籍名称(仅供学习交流)

http://www.douban.com/tag/%E5%B0%8F%E8%AF%B4/?focus=book

首先获取页面代码:

#encoding=utf8

import urllib

res = urllib.urlopen("http://www.douban.com/tag/%E5%B0%8F%E8%AF%B4/?focus=book")

print res.read()

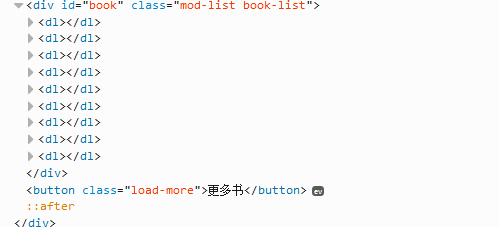

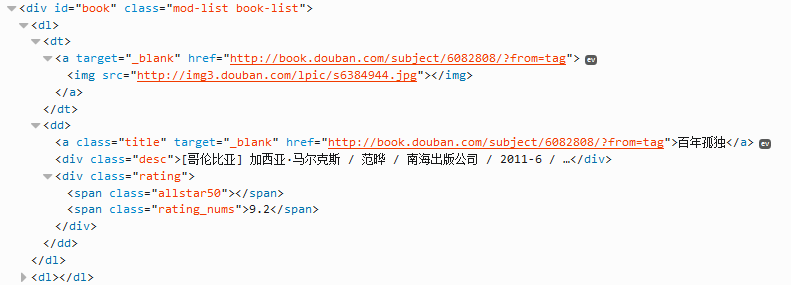

获取结果,通过分析页面源代码(建议用firefox浏览器,按F12,可看到源代码),可以定位到有效代码如下:

下面我们开始解析(这里用BeautifulSoup,自行下载安装),基本流程:

a).缩小范围,这里我们通过id="book"获取所有的书

b).然后通过class="title",遍历所有的书名。

代码如下:

#encoding=utf8

import urllib

import BeautifulSoup res = urllib.urlopen("http://www.douban.com/tag/%E5%B0%8F%E8%AF%B4/?focus=book")

soup = BeautifulSoup.BeautifulSoup(res)

book_div = soup.find(attrs={"id":"book"})

book_a = book_div.findAll(attrs={"class":"title"})

for book in book_a:

print book.string

代码说明:

a).book_div 通过id=book获取div标签

b).book_a 通过class="title"获取所有的book a标签

c).for循环 是遍历book_a所有的a标签

d).book.string 是输出a标签中的内容

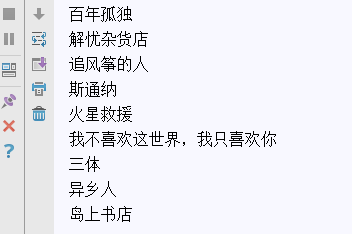

结果如下:

3.存储获取的数据,比如写入数据库,我的数据库用的Mysql,这里就以Mysql为例(下载安装MySQLdb模块这里不做叙述),只写怎么执行一条sql语句

代码如下:

connection = MySQLdb.connect(host="***",user="***",passwd="***",db="***",port=3306,charset="utf8")

cursor = connection.cursor()

sql = "*******"

sql_res = cursor.execute(sql)

connection.commit()

cursor.close()

connection.close()

说明:

a).这段代码是执行sql语句的流程,针对不同的sql语句,会有不同的处理。比如,执行select的语句,我怎么获取执行的结果,执行update语句,怎么之后成没成功。这 些就要自己动手了

b).创建数据库的时候一定要注意编码,建议使用utf8

4.至此,一个简单的爬虫就完成了。之后是针对反爬虫的一些策略,比如,用代理突破ip访问量限制

声明:

代码仅供学习交流使用,不能用于恶意采集、破坏等不良行为,出问题概不负责

如有问题,欢迎指正。

转载请注明出处。

Python 爬虫入门(一)的更多相关文章

- Python爬虫入门一之综述

大家好哈,最近博主在学习Python,学习期间也遇到一些问题,获得了一些经验,在此将自己的学习系统地整理下来,如果大家有兴趣学习爬虫的话,可以将这些文章作为参考,也欢迎大家一共分享学习经验. Pyth ...

- python爬虫入门-开发环境与小例子

python爬虫入门 开发环境 ubuntu 16.04 sublime pycharm requests库 requests库安装: sudo pip install requests 第一个例子 ...

- Python爬虫入门教程 48-100 使用mitmdump抓取手机惠农APP-手机APP爬虫部分

1. 爬取前的分析 mitmdump是mitmproxy的命令行接口,比Fiddler.Charles等工具方便的地方是它可以对接Python脚本. 有了它我们可以不用手动截获和分析HTTP请求和响应 ...

- Python爬虫入门教程 43-100 百思不得姐APP数据-手机APP爬虫部分

1. Python爬虫入门教程 爬取背景 2019年1月10日深夜,打开了百思不得姐APP,想了一下是否可以爬呢?不自觉的安装到了夜神模拟器里面.这个APP还是比较有名和有意思的. 下面是百思不得姐的 ...

- Python 爬虫入门(二)——爬取妹子图

Python 爬虫入门 听说你写代码没动力?本文就给你动力,爬取妹子图.如果这也没动力那就没救了. GitHub 地址: https://github.com/injetlee/Python/blob ...

- Python爬虫入门之正则表达式

在前面我们已经搞定了怎样获取页面的内容,不过还差一步,这么多杂乱的代码夹杂文字我们怎样把它提取出来整理呢?下面就开始介绍一个十分强大的工具,正则表达式! 1.了解正则表达式 正则表达式是对字符串操作的 ...

- Python爬虫入门之Cookie的使用

本节我们一起来看一下Cookie的使用. 为什么要使用Cookie呢? Cookie,指某些网站为了辨别用户身份.进行session跟踪而储存在用户本地终端上的数据(通常经过加密) 比如说有些网站需要 ...

- Python爬虫入门之Urllib库的高级用法

1.设置Headers 有些网站不会同意程序直接用上面的方式进行访问,如果识别有问题,那么站点根本不会响应,所以为了完全模拟浏览器的工作,我们需要设置一些Headers 的属性. 首先,打开我们的浏览 ...

- Python爬虫入门之Urllib库的基本使用

那么接下来,小伙伴们就一起和我真正迈向我们的爬虫之路吧. 1.分分钟扒一个网页下来 怎样扒网页呢?其实就是根据URL来获取它的网页信息,虽然我们在浏览器中看到的是一幅幅优美的画面,但是其实是由浏览器解 ...

- 3.Python爬虫入门三之Urllib和Urllib2库的基本使用

1.分分钟扒一个网页下来 怎样扒网页呢?其实就是根据URL来获取它的网页信息,虽然我们在浏览器中看到的是一幅幅优美的画面,但是其实是由浏览器解释才呈现出来的,实质它是一段HTML代码,加 JS.CSS ...

随机推荐

- 配置Ubuntu16.04虚拟机 (用途:CTF_pwn)

因为学习需要16.xx的虚拟机,所以把之前18.04的Ubuntu卸掉重装了一遍Ubuntu16.04, 考虑到我有备份和重装系统的爱好,故记之,以备后用. 目录: //最后更新时间:190122·1 ...

- oozie-ext

安装oozie的时候需要ext的包支持,网站上找了一遍不是没有就是这个csdn下载还需要币,麻蛋...下面给出这个链接,在百度云上,如果失效了,在评论区或者给我留言,再发,一下是ext2.2.zip ...

- JSBridge实现示例

前言 参考来源 前人栽树,后台乘凉,本文参考了以下来源 Hybrid APP架构设计思路 marcuswestin/WebViewJavascriptBridge 楔子 本文介绍JSBridge的完整 ...

- java.util.ConcurrentModificationException: null

是因为在map.foreach中又put新的值了 在map.foreach中可能是不可以增删改

- 奔跑吧DKY——团队Scrum冲刺阶段-Day 2

今日完成任务 各个成员今日完成的任务(如果完成的任务为开发或测试任务,需给出对应的Github代码签入记录截图:如果完成的任务为调研任务,需给出对应的调研总结博客链接:如果完成的任务为学习技术任务,需 ...

- 【请仔细核对Git地址】关于代码量排名的说明

1.截至2017年3月14日,1623班级代码统计情况如下: 2.代码量排名是基于码云的git地址统计的,请大家仔细核对以下个人地址,如有问题请及时联系我. 20162301 20162302 201 ...

- OC中的私有方法

1.不写在.h文件中 2.不写在.m文件中 一.私有方法: 没有在.h文件当中进行声明的方法在OC中都被称为私有方法 私有方法子类是无法继承到的

- java集合LinkedList

基于jdk_1.8.0 关于List,主要是有序的可重复的数据结构.jdk主要实现类有ArrayList(底层使用数组).LinkedList(底层使用双向链表) LinkedList: (一)继承关 ...

- Android开发--第一个活动

一.创建工程 1 项目名:MyActivity 包名:com.iflytek.myactivity 2 为了便于学习,不勾选Create Activity.然后finish,工程创建完成 END ...

- 360Vedio To NFOV Vedio

Deep 360 Pilot Learning a Deep Agent for Piloting through 360° Sports Videos 源码.数据集和视频演示 ego-centric ...