CNN 手写数字识别

1. 知识点准备

在了解 CNN 网络神经之前有两个概念要理解,第一是二维图像上卷积的概念,第二是 pooling 的概念。

a. 卷积

关于卷积的概念和细节可以参考这里,卷积运算有两个非常重要特性,以下面这个一维的卷积为例子:

第一个特性是稀疏连接。可以看到, layer m 上的每一个节点都只与 layer m-1 对应区域的三个节点相连接。这个局部范围也叫感受野。第二个特性是相同颜色的线条代表了相同的权重,即权重共享。这样做有什么好处呢?一方面权重共享可以极大减小参数的数目,学习起来更加有效,另一方面,相同的权重可以让过滤器不受图像位置的影响来检测图像的特性,从而使 CNN 具有更强的泛化能力。

b. 池化

理论上,我们将图像利用不同的过滤器通过卷积之后得到了多个卷积之后的图像,然后直接利用这些图像进行分类,但是这样计算量太大了。利用池化操作可以将数据量减小,同时在一定程度上保留原有的图像特征。关于 pooling, 概念更加简单了,详情可以参考这里。池化又可以分为平均池化和最大池化,这里我们将采用最大池化。注意到,池化的区域是不重叠的,卷积的感受野是重叠的。

2. 卷积神经网络的搭建

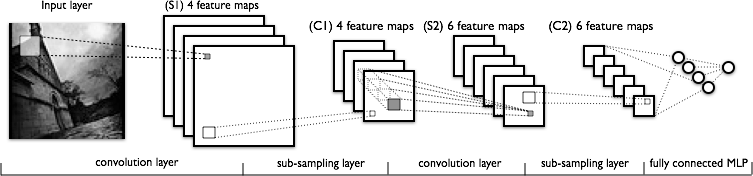

下图是手写数字识别中采用的 lenet-5 简单的卷积神经网络模型:

原图是 28 × 28 的手写数字图片,通过第一次 20 个 5 × 5 的卷积核之后,得到 20 张卷积图片。卷积核的权重是取一定范围内的随机值,这样,一张 28 × 28 的图片就变为 20 张 (28-5+1)× (28-5+1)=24×24 的图片了。

将 24×24 的图片进行 2 × 2 的最大池化,得到 20 张 12 × 12 的图片。该图片的像素还需要进行 tanh 函数的变换才能作为下一个卷积层的输入。

将 tanh 变化之后的 12 × 12 大小的图片同样进行 20 × 50 个 5 × 5 的卷积操作之后得到 50 张 (12-5+1)× (12-5+1) = 8 × 8 的图片。

将 8×8 的图片进行 2×2 的最大池化,得到 50 张 4×4 的图片,再经过 tanh 函数进行归一化处理,就可以作为 MLP 的 800 个输入了。

余下来就是 MLP 的训练工作了。

3. LR, MLP,CNN 识别代码

已经训练好的模型系数的下载地址。

三种方法识别手写数字的代码:

import cPickle import numpy import theano

import theano.tensor as T

from theano.tensor.signal import downsample

from theano.tensor.nnet import conv ########################################

# define the classifer constructs

######################################## class LogisticRegression(object):

def __init__(self, input, W=None, b=None): if W is None:

fle = open("../model_param/lr_sgd_best.pkl")

W, b = cPickle.load(fle)

fle.close() self.W = W

self.b = b self.outputs = T.nnet.softmax(T.dot(input, self.W) + b) self.pred = T.argmax(self.outputs, axis=1) class MLP(object):

def __init__(self, input, params=None):

if params is None:

fle = open("../model_param/mlp_best.pkl")

params = cPickle.load(fle)

fle.close() self.hidden_W, self.hidden_b, self.lr_W, self.lr_b = params self.hiddenlayer = T.tanh(T.dot(input, self.hidden_W) + self.hidden_b) self.outputs = T.nnet.softmax(T.dot(self.hiddenlayer, self.lr_W) \

+ self.lr_b) self.pred = T.argmax(self.outputs, axis=1) class CNN(object):

def __init__(self, input, params=None):

if params is None:

fle = open("../model_param/cnn_best.pkl")

params = cPickle.load(fle)

fle.close() ################

self.layer3_W, self.layer3_b, self.layer2_W, self.layer2_b, \

self.layer1_W, self.layer1_b, self.layer0_W, self.layer0_b = params # compute layer0

self.conv_out0 = conv.conv2d(input=input, filters=self.layer0_W)

# filter_shape=(20, 1, 5, 5), image_shape=(1, 1, \

# 28, 28))

self.pooled_out0 = downsample.max_pool_2d(input=self.conv_out0, \

ds=(2, 2), ignore_border=True)

self.layer0_output = T.tanh(self.pooled_out0 + \

self.layer0_b.dimshuffle('x', 0, 'x', 'x')) # compute layer1

self.conv_out1 = conv.conv2d(input=self.layer0_output, filters=self.layer1_W)

# filter_shape=(50, 20, 5, 5), image_shape=(1, 20, \

# 12, 12))

self.pooled_out1 = downsample.max_pool_2d(input=self.conv_out1, \

ds=(2, 2), ignore_border=True)

self.layer1_output = T.tanh(self.pooled_out1 + \

self.layer1_b.dimshuffle('x', 0, 'x', 'x')) # compute layer2

self.layer2_input = self.layer1_output.flatten(2) self.layer2_output = T.tanh(T.dot(self.layer2_input, self.layer2_W) + \

self.layer2_b) # compute layer3

self.outputs = T.nnet.softmax(T.dot(self.layer2_output, self.layer3_W)\

+ self.layer3_b) self.pred = T.argmax(self.outputs, axis=1) ########################################

# build classifier

######################################## def lr(input):

input.shape = 1, -1 x = T.fmatrix('x')

classifer = LogisticRegression(input=x) get_p_y = theano.function(inputs=[x], outputs=classifer.outputs)

pred_y = theano.function(inputs=[x], outputs=classifer.pred)

return (get_p_y(input), pred_y(input)) def mlp(input):

input.shape = 1, -1 x = T.fmatrix('x')

classifer = MLP(input=x) get_p_y = theano.function(inputs=[x], outputs=classifer.outputs)

pred_y = theano.function(inputs=[x], outputs=classifer.pred)

return (get_p_y(input), pred_y(input)) def cnn(input):

input.shape = (1, 1, 28, 28)

x = T.dtensor4('x')

classifer = CNN(input=x)

get_p_y = theano.function(inputs=[x], outputs=classifer.outputs)

pred_y = theano.function(inputs=[x], outputs=classifer.pred)

return (get_p_y(input), pred_y(input))

CNN 手写数字识别的更多相关文章

- 卷积神经网络CNN 手写数字识别

1. 知识点准备 在了解 CNN 网络神经之前有两个概念要理解,第一是二维图像上卷积的概念,第二是 pooling 的概念. a. 卷积 关于卷积的概念和细节可以参考这里,卷积运算有两个非常重要特性, ...

- Keras cnn 手写数字识别示例

#基于mnist数据集的手写数字识别 #构造了cnn网络拟合识别函数,前两层为卷积层,第三层为池化层,第四层为Flatten层,最后两层为全连接层 #基于Keras 2.1.1 Tensorflow ...

- pytorch CNN 手写数字识别

一个被放弃的入门级的例子终于被我实现了,虽然还不太完美,但还是想记录下 1.预处理 相比较从库里下载数据集(关键是经常失败,格式也看不懂),更喜欢直接拿图片,从网上找了半天,最后从CSDN上下载了一个 ...

- kaggle 实战 (2): CNN 手写数字识别

文章目录 Tensorflow 官方示例 CNN 提交结果 Tensorflow 官方示例 import tensorflow as tf mnist = tf.keras.datasets.mnis ...

- keras框架的CNN手写数字识别MNIST

参考:林大贵.TensorFlow+Keras深度学习人工智能实践应用[M].北京:清华大学出版社,2018. 首先在命令行中写入 activate tensorflow和jupyter notebo ...

- 【深度学习系列】手写数字识别卷积神经--卷积神经网络CNN原理详解(一)

上篇文章我们给出了用paddlepaddle来做手写数字识别的示例,并对网络结构进行到了调整,提高了识别的精度.有的同学表示不是很理解原理,为什么传统的机器学习算法,简单的神经网络(如多层感知机)都可 ...

- Android+TensorFlow+CNN+MNIST 手写数字识别实现

Android+TensorFlow+CNN+MNIST 手写数字识别实现 SkySeraph 2018 Email:skyseraph00#163.com 更多精彩请直接访问SkySeraph个人站 ...

- 第三节,TensorFlow 使用CNN实现手写数字识别(卷积函数tf.nn.convd介绍)

上一节,我们已经讲解了使用全连接网络实现手写数字识别,其正确率大概能达到98%,这一节我们使用卷积神经网络来实现手写数字识别, 其准确率可以超过99%,程序主要包括以下几块内容 [1]: 导入数据,即 ...

- [Python]基于CNN的MNIST手写数字识别

目录 一.背景介绍 1.1 卷积神经网络 1.2 深度学习框架 1.3 MNIST 数据集 二.方法和原理 2.1 部署网络模型 (1)权重初始化 (2)卷积和池化 (3)搭建卷积层1 (4)搭建卷积 ...

随机推荐

- 用Qemu模拟vexpress-a9 (四) --- u-boot引导kernel,用nfs挂载根文件系统

环境介绍 Win7 64 + Vmware 11 + ubuntu14.04 32 u-boot 版本:u-boot-2015-04 Linux kernel版本:linux-3.16.y busyb ...

- UIView.frame的骗局

如果你刚刚开始接触IOS编程, 刚刚接触UIKit, 肯定会被 frame, bounds, center, layer.anchorPoint, layer.position 这些乱七八糟得属性折腾 ...

- 边工作边刷题:70天一遍leetcode: day 72

Missing Range 要点:题简单,这类题的特点都是记录上一步的状态,比如这题是end 错误点: 三种情况:一是连续的,即和上一个end差1,而是中间只差1个数,没有'->',最后是大于1 ...

- ios--Attributes和ParagraphStyle介绍

NSMutableParagraphStyle的部分属性: typedef NS_ENUM(NSInteger, NSLineBreakMode) {/* What to do with long l ...

- Spring 4 bak

IOC (参考<Spring企业开发>.<Spring实战 第三版 第四版>) IoC概述 1. 控制反转 2.依赖注入 控制反转:大多数情况下,想要 ...

- jqXHR 对象(post完成后再调用函数)

场景: function A() { B(); C(); } function B() { $.post(url, {}, function () { alert("我错了!"); ...

- 点击劫持(CLICKJACKING)与X-FRAME-OPTIONS HEADER

转载: http://www.tuicool.com/articles/mqUBfa 目录 前言 1.1 点击劫持(clickjacking attacks) 1.2 Frame Bursters. ...

- webpack+react+redux+es6

一.预备知识 node, npm, react, redux, es6, webpack 二.学习资源 ECMAScript 6入门 React和Redux的连接react-redux Redux 入 ...

- Contains Duplicate II

Given an array of integers and an integer k, find out whether there there are two distinct indices i ...

- CAS 单点登录流程

经验:在网上学东西不要指望一篇文章就能让你明白——我在网上学CAS流程,看了五六篇博文,其中三篇是觉得作者表达能力不行,或者作者自己就没明白怎么回事就出来写东西,看到一半就跳过了,剩下两篇每篇看了两遍 ...