大数据技术之HBase原理与实战归纳分享-下

@

整合Phoenix

定义

Phoenix 官网地址 https://phoenix.apache.org/

Phoenix作为一款OLTP和Apache Hadoop的操作分析,是面向HBase的开源 SQL 皮肤,其通过 JDBC API 代替繁重的 HBase 客户端 API来创建表,插入数据和查询 HBase 数据。目前最新版本为5.1.2

Apache Phoenix通过结合两者的优点,在Hadoop中为低延迟应用提供OLTP和操作分析,标准SQL和JDBC api的强大功能与完整的ACID事务功能,以及通过利用HBase作为其后备存储,采用NoSQL使得读写数据更加灵活性。Apache Phoenix与其他Hadoop产品(如Spark、Hive、Pig、Flume和Map Reduce)完全集成。

为何要使用

官方原文:Doesn’t putting an extra layer between my application and HBase just slow things down?

Actually, no. Phoenix achieves as good or likely better performance than if you hand-coded it yourself (not to mention with a heck of a lot less code) by:

翻译为在 Client 和 HBase 之间放一个 Phoenix 中间层不会减慢速度,因为用户编写的数据处理代码和 Phoenix 编写的没有区别(更不用说你写的垃圾的多),不仅如此Phoenix 对于用户输入的 SQL 同样会有大量的优化手段(就像 hive 自带 sql 优化器一样)。

Phoenix 在 5.0 版本默认提供有两种客户端使用(瘦客户端和胖客户端),在 5.1.2 版本安装包中删除了瘦客户端,本文也不再使用瘦客户端。而胖客户端和用户自己写 HBase 的API 代码读取数据之后进行数据处理是完全一样的。

安装

# 当前版本4.16.1可以运行在Apache HBase 1.3、1.4、1.5和1.6上;当前版本5.1.2可以运行在Apache HBase 2.1、2.2、2.3和2.4上。

# 由于前面Hbase是2.5版本,我们先尝试下载phoenix最新版本使用

wget --no-check-certificate https://dlcdn.apache.org/phoenix/phoenix-5.1.2/phoenix-hbase-2.4.0-5.1.2-bin.tar.gz

# 解压 tar 包

tar -xvf phoenix-hbase-2.4.0-5.1.2-bin.tar.gz

# 复制 server 包并拷贝到各个节点的 hbase/lib

cp phoenix-hbase-2.4.0-5.1.2-bin/phoenix-server-hbase-2.4.0-5.1.2.jar hbase-2.5.0/lib/

scp hbase-2.5.0/lib/phoenix-server-hbase-2.4.0-5.1.2.jar hadoop2:/home/commons/hbase-2.5.0/lib/

scp hbase-2.5.0/lib/phoenix-server-hbase-2.4.0-5.1.2.jar hadoop3:/home/commons/hbase-2.5.0/lib/

# 三个节点上都配置环境变量

export PHOENIX_HOME=/home/commons/phoenix-hbase-2.4.0-5.1.2-bin

export PHOENIX_CLASSPATH=$PHOENIX_HOME

export PATH=$PATH:$PHOENIX_HOME/bin

# 三个节点上都使环境变量生效

source /etc/profile

# 先停止

bin/stop-hbase.sh

# 启动

bin/start-hbase.sh

# 进入phoenix根目录

cd phoenix-hbase-2.4.0-5.1.2-bin

# 连接phoenix

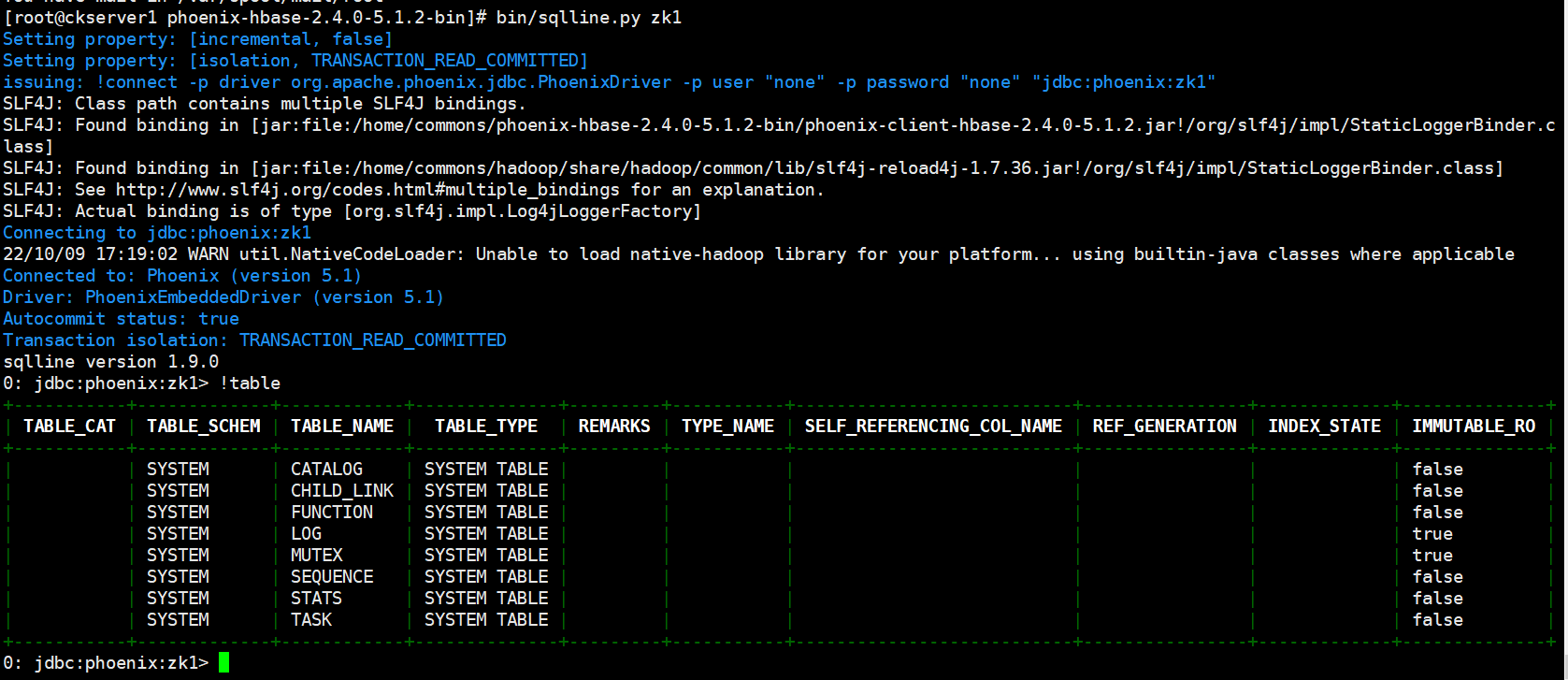

bin/sqlline.py zk1

# 显示所有表

!table

!tables

# 退出

!quit

SHELL操作

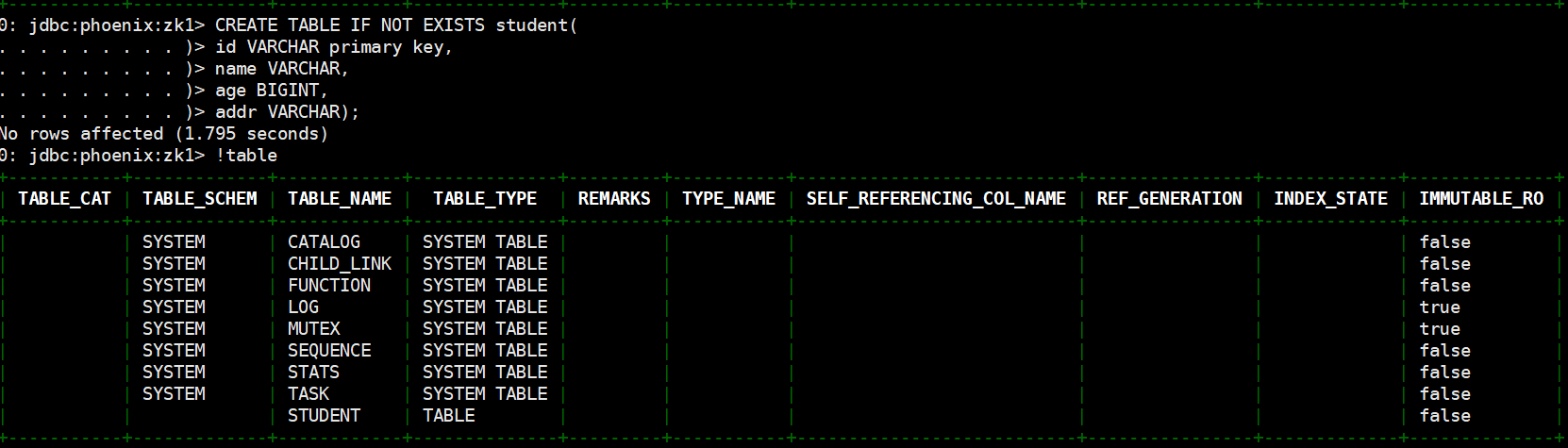

# 创建表,直接指定单个列作为 RowKey

CREATE TABLE IF NOT EXISTS student(

id VARCHAR primary key,

name VARCHAR,

age BIGINT,

addr VARCHAR);

# 在 phoenix 中,表名等会自动转换为大写,若要小写,使用双引号,如"us_population"。

# 指定多个列的联合作为 RowKey

CREATE TABLE IF NOT EXISTS student1 (

id VARCHAR NOT NULL,

name VARCHAR NOT NULL,

age BIGINT,

addr VARCHAR

CONSTRAINT my_pk PRIMARY KEY (id, name));

注:Phoenix 中建表,会在 HBase 中创建一张对应的表。为了减少数据对磁盘空间的占用,Phoenix 默认会对 HBase 中的列名做编码处理。具体规则可参考官网链接:https://phoenix.apache.org/columnencoding.html,若不想对列名编码,可在建表语句末尾加上 COLUMN_ENCODED_BYTES = 0;

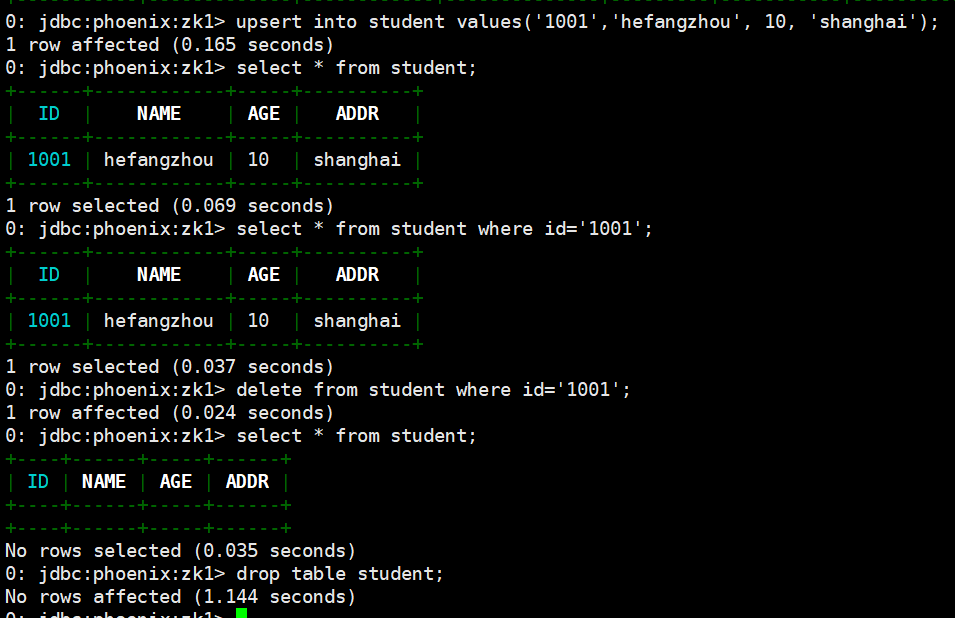

# 插入数据

upsert into student values('1001','hefangzhou', 10, 'shanghai');

# 查询记录

select * from student;

select * from student where id='1001';

# 删除记录

delete from student where id='1001';

# 删除表

drop table student;

表的映射

表的关系在默认情况下, HBase 中已存在的表,通过 Phoenix 是不可见的。如果要在 Phoenix 中操作 HBase 中已存在的表,可以在 Phoenix 中进行表的映射。映射方式有两种:视图映射和表映射。

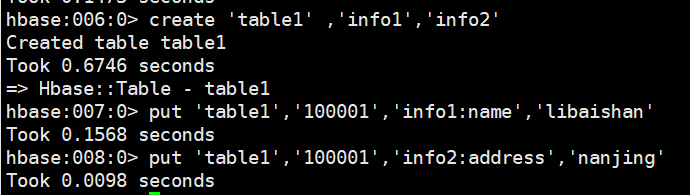

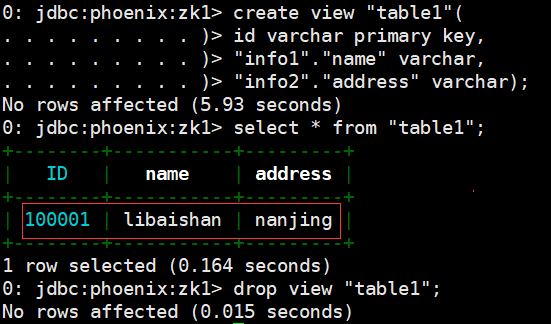

- 视图映射:Phoenix 创建的视图是只读的,所以只能用来做查询,无法通过视图对数据进行修改等操作。在 phoenix 中创建关联 table1 表的视图

# HBase 中 table1 的表结构如下,两个列族 info11、info12。先执行hbase shell

create 'table1' ,'info1','info2'

put 'table1','100001','info1:name','libaishan'

put 'table1','100001','info2:address','nanjing'

# Phoenix shell执行视图创建,先执行bin/sqlline.py zk1

create view "table1"(

id varchar primary key,

"info1"."name" varchar,

"info2"."address" varchar);

select * from "table1";

# 删除视图

drop view "table1";

- 视图映射:在 Pheonix 创建表去映射 HBase 中已经存在的表,是可以修改删除 HBase 中已经存在的数据的。而且,删除 Phoenix 中的表,那么 HBase 中被映射的表也会被删除。注:进行表映射时,不能使用列名编码,需将 column_encoded_bytes 设为 0。

create table "table2"(

id varchar primary key,

"info1"."name" varchar,

"info2"."address" varchar)

column_encoded_bytes=0;

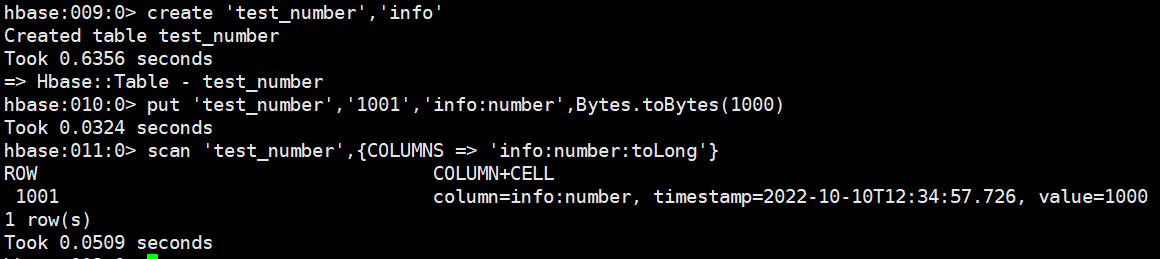

- 数字类型说明:HBase 中的数字,底层存储为补码,而 Phoenix 中的数字,底层存储为在补码的基础上,将符号位反转。故当在 Phoenix 中建表去映射 HBase 中已存在的表,当 HBase 中有数字类型的字段时,会出现解析错误的现象。

# Hbase 操作示例

create 'test_number','info'

put 'test_number','1001','info:number',Bytes.toBytes(1000)

scan 'test_number',{COLUMNS => 'info:number:toLong'}

# phoenix 操作示例

create view "test_number"(id varchar primary key,"info"."number" bigint);

select * from "test_number";

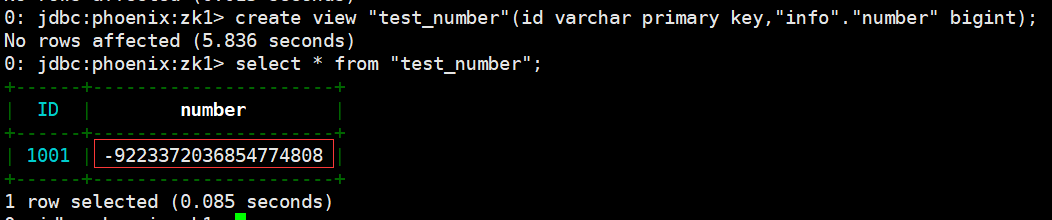

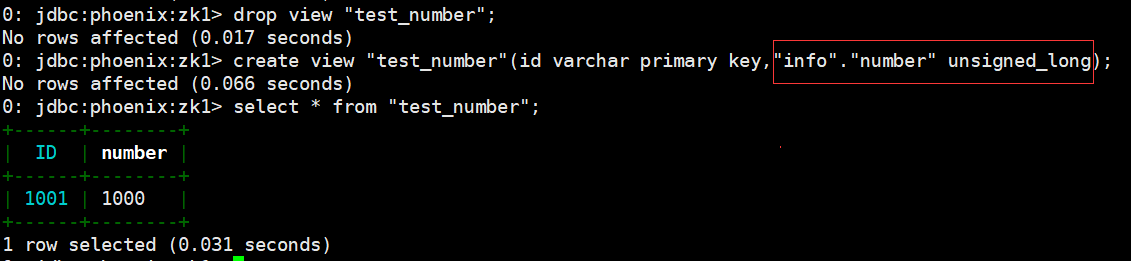

解决上述问题的方案有以下两种:

- Phoenix 种提供了 unsigned_int,unsigned_long 等无符号类型,其对数字的编码解码方式和 HBase 是相同的,如果无需考虑负数,那在 Phoenix 中建表时采用无符号类型是最合适的选择。

- phoenix 演示:

drop view "test_number";

create view "test_number"(id varchar primary key,"info"."number" unsigned_long);

select * from "test_number";

- 如需考虑负数的情况,则可通过 Phoenix 自定义函数,将数字类型的最高位,即符号位反转即可,自定义函数可参考如下接:https://phoenix.apache.org/udf.html。

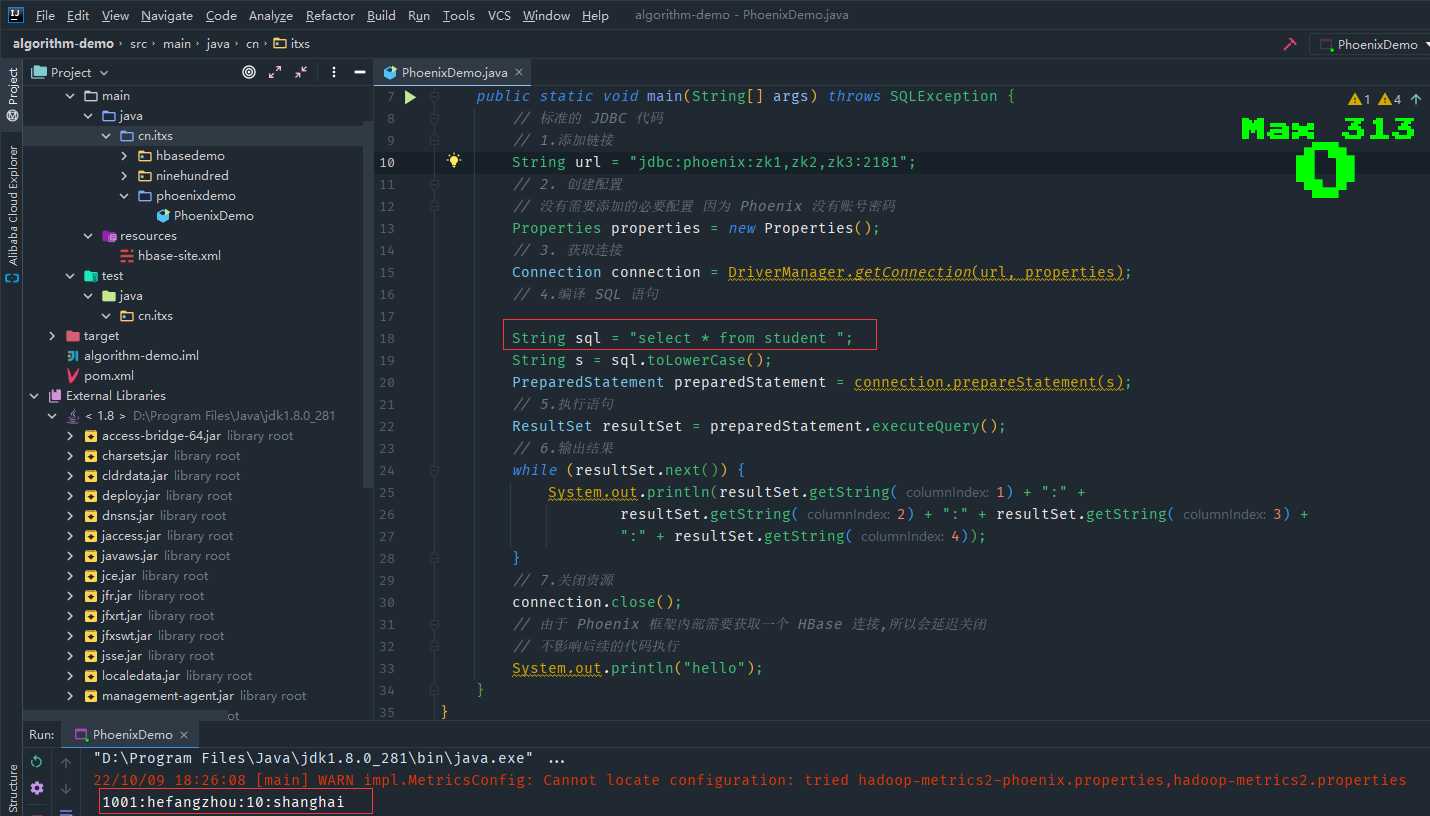

简易JDBC示例

这里演示一个标准的 JDBC 连接操作,实际开发中会直接使用别的框架内嵌的Phoenix 连接,添加maven 依赖

<dependency> <groupId>org.apache.phoenix</groupId> <artifactId>phoenix-client-hbase-2.4</artifactId> <version>5.1.2</version> </dependency>

重新执行phoenix shell操作关于student表创建和插入数据,测试代码PhoenixDemo.java

package cn.itxs.phoenixdemo;

import java.sql.*;

import java.util.Properties;

public class PhoenixDemo {

public static void main(String[] args) throws SQLException {

// 标准的 JDBC 代码

// 1.添加链接

String url = "jdbc:phoenix:zk1,zk2,zk3:2181";

// 2. 创建配置

// 没有需要添加的必要配置 因为 Phoenix 没有账号密码

Properties properties = new Properties();

// 3. 获取连接

Connection connection = DriverManager.getConnection(url, properties);

// 4.编译 SQL 语句

String sql = "select * from student ";

String s = sql.toLowerCase();

PreparedStatement preparedStatement = connection.prepareStatement(s);

// 5.执行语句

ResultSet resultSet = preparedStatement.executeQuery();

// 6.输出结果

while (resultSet.next()) {

System.out.println(resultSet.getString(1) + ":" +

resultSet.getString(2) + ":" + resultSet.getString(3) +

":" + resultSet.getString(4));

}

// 7.关闭资源

connection.close();

// 由于 Phoenix 框架内部需要获取一个 HBase 连接,所以会延迟关闭

// 不影响后续的代码执行

System.out.println("hello");

}

}

运行程序,打印出前面phoenix shell插入的数据

二级索引

二级索引配置文件

添加如下配置到 HBase 的 HRegionserver 节点的 hbase-site.xml,之后重启Hbase集群

<!-- phoenix regionserver 配置参数-->

<property>

<name>hbase.regionserver.wal.codec</name>

<value>org.apache.hadoop.hbase.regionserver.wal.IndexedWALEditCodec</value>

</property>

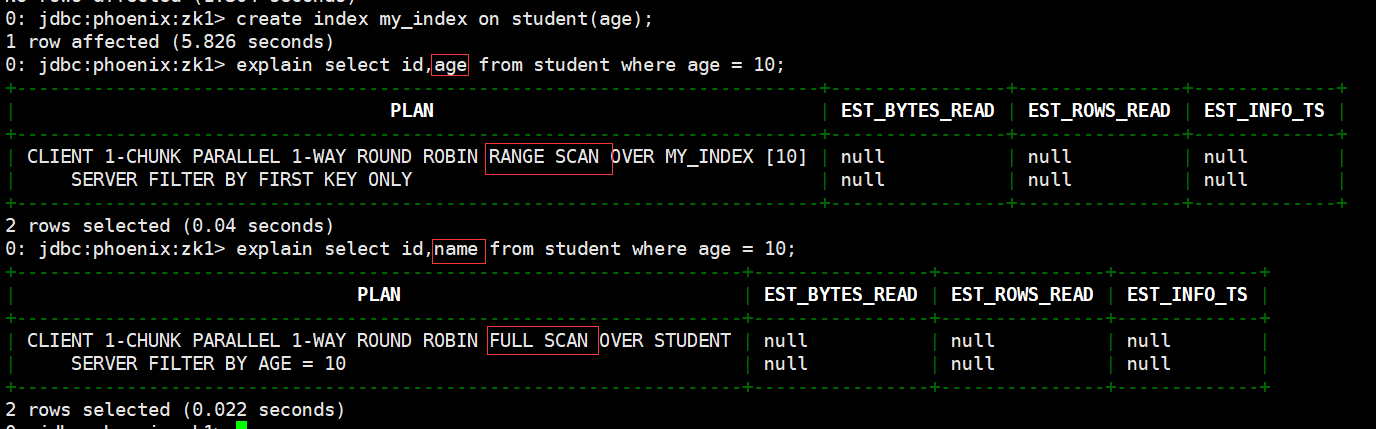

全局索引

Global Index 是默认的索引格式,创建全局索引时,会在 HBase 中建立一张新表。也就是说索引数据和数据表是存放在不同的表中的,因此全局索引适用于多读少写的业务场景。

写数据的时候会消耗大量开销,因为索引表也要更新,而索引表是分布在不同的数据节点上的,跨节点的数据传输带来了较大的性能消耗。在读数据的时候 Phoenix 会选择索引表来降低查询消耗的时间。

创建单个字段的全局索引。

# 创建索引语法

CREATE INDEX my_index ON my_table (my_col);

# 例如

create index my_index on student(age);

# 查看二级索引是否有效,可以使用 explain 执行计划,有二级索引之后会变成范围扫描.

explain select id,age from student where age = 10;

# 如果想查询的字段不是索引字段的话索引表不会被使用,也就是说不会带来查询速度的提升。

explain select id,name from student where age = 10;

# 删除索引语法

DROP INDEX my_index ON my_table

# 例如

drop index my_index on student;

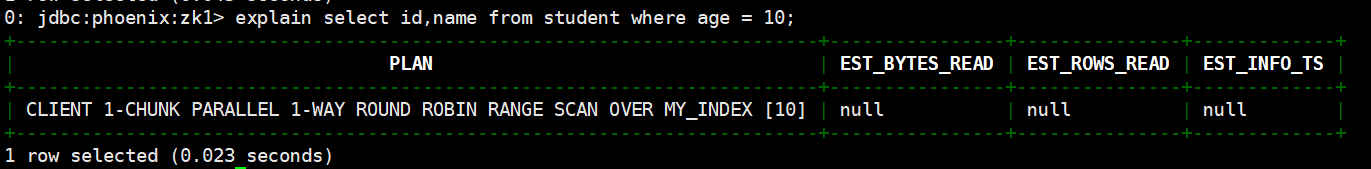

若想解决上述问题,可采用如下方案:

- 使用包含索引

- 使用本地索引

包含索引

包含索引(covered index)创建携带其他字段的全局索引(本质还是全局索引)

# 包含索引语法如下

CREATE INDEX my_index ON my_table (v1) INCLUDE (v2);

# 先删除之前的索引:

drop index my_index on student1;

#创建包含索引

create index my_index on student(age) include (name);

# 使用执行计划查看效果,结果显示已走了RANGE SACN

explain select id,name from student where age = 10;

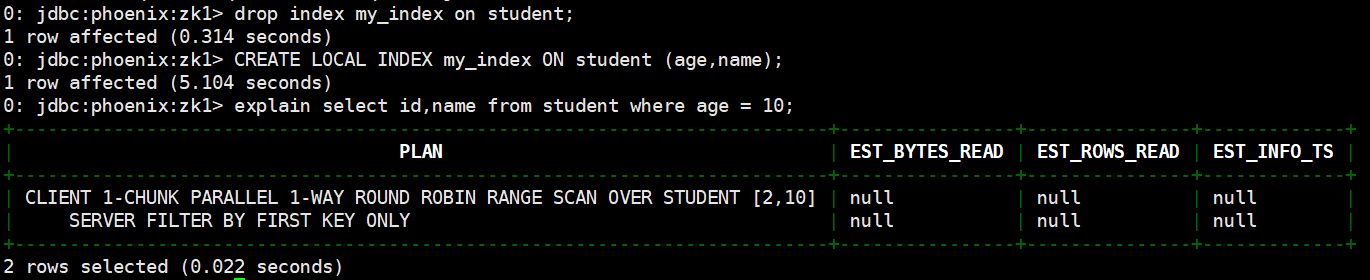

本地索引(local index)

本地索引(local index) 适用于写操作频繁的场景。索引数据和数据表的数据是存放在同一张表中(且是同一个 Region),避免了在写操作的时候往不同服务器的索引表中写索引带来的额外开销。

# 本地索引语法如下,my_column 可以是多个。

CREATE LOCAL INDEX my_index ON my_table (my_column);

# 本地索引会将所有的信息存在一个影子列族中,虽然读取的时候也是范围扫描,但是没有全局索引快,优点在于不用写多个表了。

# 删除之前的索引

drop index my_index on student;

# 创建本地索引

CREATE LOCAL INDEX my_index ON student (age,name);

# 使用执行计划

explain select id,name from student where age = 10;

HBase与 Hive 的集成

使用场景

如果大量的数据已经存放在 HBase 上面,需要对已经存在的数据进行数据分析处理,那么 Phoenix 并不适合做特别复杂的 SQL 处理,此时可以使用 hive 映射 HBase 的表格,之后写 HQL 进行分析处理。

集成方法

在 hive-site.xml 中添加 zookeeper 的属性,如下:

<property>

<name>hive.zookeeper.quorum</name>

<value>zk1,zk2,zk3</value>

</property>

<property>

<name>hive.zookeeper.client.port</name>

<value>2181</value>

</property>

示例

接下来先建立 Hive 表,关联 HBase 表,插入数据到 Hive 表的同时能够影响 HBase 表

- 在 Hive 中创建表同时关联 HBase

CREATE TABLE hive_emp(

empno INT,

empname string,

deptno INT

) STORED BY 'org.apache.hadoop.hive.hbase.HBaseStorageHandler' WITH SERDEPROPERTIES (

"hbase.columns.mapping" = ":key,info:empname,info:deptno"

) TBLPROPERTIES ("hbase.table.name" = "hbase_emp");

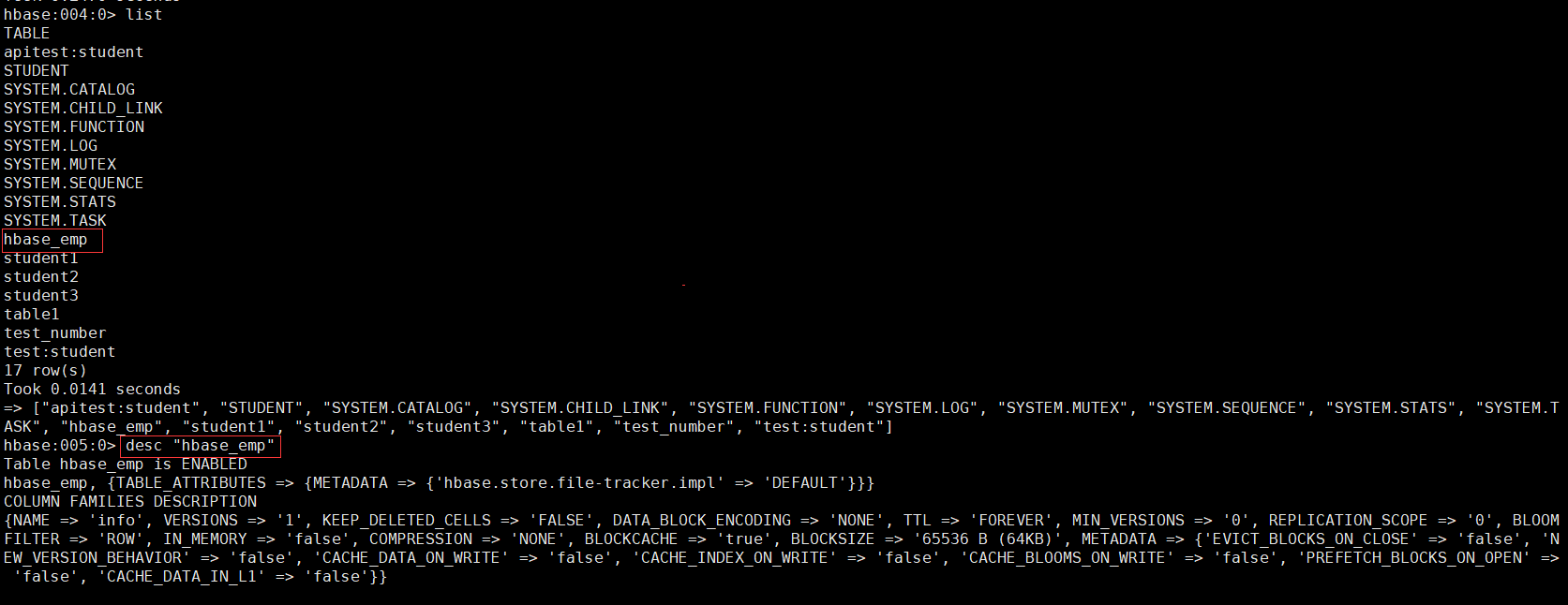

完成之后,可以分别进入 Hive 和 HBase 查看,都生成了对应的表。

- 在 Hive 中创建临时中间表,用于 load 文件中的数据。(不能将数据直接 load 进 Hive 所关联 HBase 的那张表中)

CREATE TABLE emp_mid( empno int, ename string, deptno int)row format delimited fields terminated by ' ';

- 新建导入数据文件emp.txt。

1001 zhangsan 1001002 lisi 1001003 hangong 1001004 xieren 1011005 lili 1011006 guojia 102

- 往Hive 中间表emp_mid中 load 数据

load data local inpath '/home/commons/data/emp.txt' into table emp_mid;

- 通过 insert 命令将中间表中的数据导入到 Hive 关联 Hbase 的那张表中。

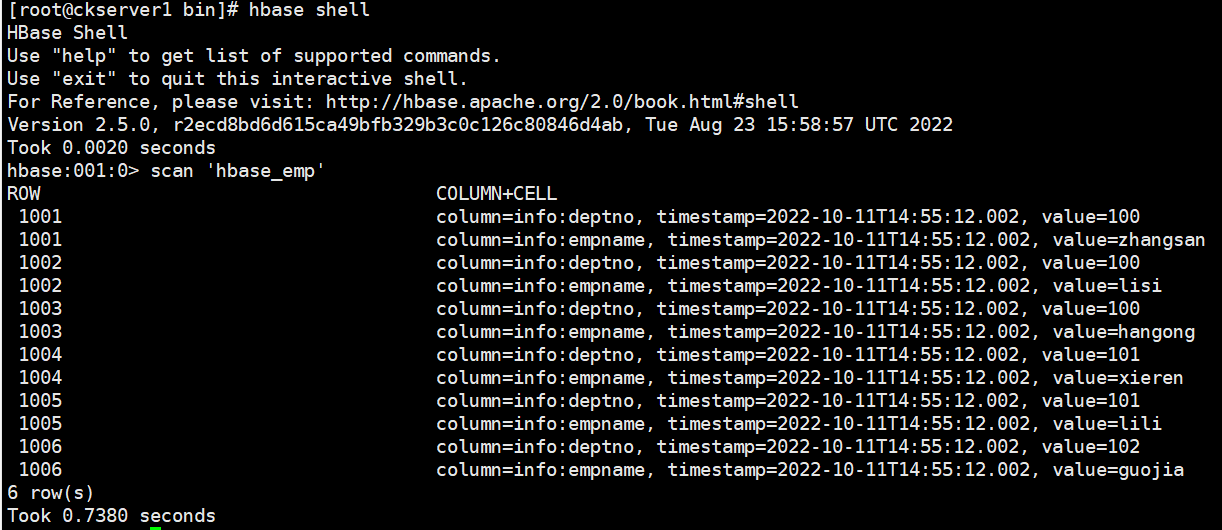

insert into table hive_emp select * from emp_mid;

- 查看 Hive 以及关联的 HBase 表中是否已经成功的同步插入了数据。

# Hive表中查看数据select * from hive_emp;

# HBase表中查看数据scan 'hbase_emp'

整合已有HBase表示例

上个示例中在 HBase 中已存储了表 hbase_emp,接着我们在 Hive 中创建一个外部表hive_emp_external来关联 HBase 中的 hbase_emp 这张表,使之可以借助 Hive 来分析 HBase 这张表中的数据。

- 在 Hive 中创建外部表hive_emp_external

CREATE EXTERNAL TABLE hive_emp_external( empno INT, empname string, deptno INT) STORED BY 'org.apache.hadoop.hive.hbase.HBaseStorageHandler' WITH SERDEPROPERTIES ( "hbase.columns.mapping" = ":key,info:empname,info:deptno") TBLPROPERTIES ("hbase.table.name" = "hbase_emp");

- 关联后就可以使用 Hive 函数进行一些分析操作了

select deptno,count(empname) from hive_emp_external group by deptno;

**本人博客网站 **IT小神 www.itxiaoshen.com

大数据技术之HBase原理与实战归纳分享-下的更多相关文章

- 大数据技术之HBase原理与实战归纳分享-中

@ 目录 底层原理 Master架构 RegionServer架构 Region/Store/StoreFile/Hfile之间的关系 写流程 写缓存刷写 读流程 文件合并 分区 JAVA API编程 ...

- 大数据技术之HBase原理与实战归纳分享-上

@ 目录 概述 定义 特点 数据模型 概述 逻辑结构 物理存储结构 数据模型 应用场景 基础架构 安装 前置条件 部署 启动服务 高可用 Shell操作 基础操作 命令空间 DDL DML 概述 定义 ...

- 大数据技术之HBase

第1章 HBase简介 1.1 什么是HBase HBase的原型是Google的BigTable论文,受到了该论文思想的启发,目前作为Hadoop的子项目来开发维护,用于支持结构化的数据存储. 官方 ...

- 【大数据技术】HBase介绍

1.HBase简介1.1 Hbase是什么HBase是一种构建在HDFS之上的分布式.面向列.多版本.非关系型的数据库,是Google Bigtable 的开源实现. 在需要实时读写.随机访问超大规模 ...

- 《大数据技术应用与原理》第二版-第三章分布式文件系统HDFS

3.1分布式文件 HDFS默认一个块的大小是64MB,与普通文件不同的是如果一个文件小于数据块的大小,它并不占用整个数据块的存储空间. 主节点又叫名称节点:另一个叫从节点又叫数据节点.名称节点负责文件 ...

- 【大数据技术】HBase与Solr系统架构设计

如何在保证存储量的情况下,又能保证数据的检索速度. HBase提供了完善的海量数据存储机制,Solr.SolrCloud提供了一整套的数据检索方案. 使用HBase搭建结构数据存储云,用来存储海量数据 ...

- 大数据技术之_08_Hive学习_05_Hive实战之谷粒影音(ETL+TopN)+常见错误及解决方案

第10章 Hive实战之谷粒影音10.1 需求描述10.2 项目10.2.1 数据结构10.2.2 ETL原始数据10.3 准备工作10.3.1 创建表10.3.2 导入ETL后的数据到原始表10.3 ...

- 《大数据技术应用与原理》第二版-第二章大数据处理架构Hadoop

2.1概述 Hadoop是Apache旗下的开源分布式计算平台,是基于Java开发的,具有很好的跨平台特性,其中核心文件是MapReduce和HDFS,而HDFS是根据谷歌文件系统GFS开源实现,是面 ...

- 【学习笔记】大数据技术原理与应用(MOOC视频、厦门大学林子雨)

1 大数据概述 大数据特性:4v volume velocity variety value 即大量化.快速化.多样化.价值密度低 数据量大:大数据摩尔定律 快速化:从数据的生成到消耗,时间窗口小,可 ...

随机推荐

- YII缓存操作

//文件依赖 $dependency = new \yii\caching\FileDependency(['filename'=>'hw.txt'])}; $cache->add(&qu ...

- Python花式读取大文件(10g/50g/1t)遇到的性能问题(面试向)

原文转载自「刘悦的技术博客」https://v3u.cn/a_id_97 最近无论是面试还是笔试,有一个高频问题始终阴魂不散,那就是给一个大文件,至少超过10g,在内存有限的情况下(低于2g),该以什 ...

- Vue脚手架(CLI)第一天

vue 1.脚手架的搭建(CLI) 1.1.下载nodejs,在官网, [nodejs官网地址][ https://nodejs.org/en/ ] 无脑下一步就可以了.环境自动安装 1.2.下载脚手 ...

- 在生鲜零售业,DolphinScheduler 还能这么玩!

点击上方 蓝字关注我们 ✎ 编 者 按 2021 年,Apache DolphinScheduler 社区又迎来了新的蓬勃发展,社区活跃度持续提高.目前,项目 GitHub Star 已达 6.7k, ...

- postgresql用户与权限管理

pg使用角色的概念管理数据库访问权限,角色是一系列相关权限的集合.为了管理方便,通常把一系列先关的权限赋予给一个角色,如果哪个用户需要这些权限,就把这些角色赋予给响应的用户. 由于用户也拥有一系列的相 ...

- Springboot重定向,没有位置没有加“/user”,但是url在请求位置的前面“/user”就出现了

是因为":"后面没有加"/" 原先的 return "redirect:main.html"; 正确的 return "redir ...

- 第四十七篇:webpack的基本使用(一) --安装和配置webpack

好家伙, 1.webpack的基本使用 写个例子:实现一个奇偶行变色列表 步骤如下: ① 新建项目空白目录,并运行 npm init-y命令,初始化包管理配置文件 package.json② 新建sr ...

- KingbaseES R6 集群禁用 root ssh 后需要修改集群为es_server 案例

案例说明: 在生产环境下,由于安全需要,主机间不允许建立root用户的ssh信任连接,这样导致KingbaseES R6 repmgr集群,通过sys_monitor.sh脚本启动集群时,节点之间不能 ...

- Taurus.MVC-Java 版本打包上传到Maven中央仓库(详细过程):3、Maven独立插件安装与settings.xml配置

文章目录: Taurus.MVC-Java 版本打包上传到Maven中央仓库(详细过程):1.JIRA账号注册 Taurus.MVC-Java 版本打包上传到Maven中央仓库(详细过程):2.PGP ...

- 华南理工大学 Python第1章课后小测

1.(单选)计算机有两个基本特性:功能性和()性.(本题分数:5)A) 可存储B) 可计算C) 可通信D) 可编程您的答案:D 正确率:100%2.(单选)计算机硬件可以直接识别和执行的程序设计语言 ...