读论文SRCNN:Learning a Deep Convolutional Network for Image Super-Resolution

Learning a Deep Convolutional Network for Image Super-Resolution

SRCNN是深度学习应用于SR领域的开山之作。

Pytorch代码 与论文的细节设置有些不同。

实验细节总结:

1 数据集

set5:5张图片

set14:14张图片

用到的数据集为set5、set14、ImageNet。

其中,为和之前其他的方法保持相同的条件,先用91张图片作为训练集,set5、set14作为测试集,其中set5的5张图片用作x2x3x4的测试集,set14的14张图片用作x3的测试集。得出的模型效果比之前其他的方法更好。随后用ImageNet的大数据量训练(网络的参数发生了一些改变),得出训练数据集的增加,会给结果带来更好效果,同时训练时间和推理时间也会增加。

在文章的4 Experiments中,描述如下,

Datasets. For a fair comparison with traditional example-based methods, we use the same training set, test sets, and protocols as in [20].

Specifically, the training set consists of 91 images.

The Set5 [2] (5 images) is used to evaluate the performance of upscaling factors 2, 3, and 4, and Set14 [28] (14 images) is used to evaluate the upscaling factor 3.

In addition to the 91-image training set, we also investigate a larger training set in Section 5.2.

具体来说,训练集包含91张图片。set5的五张图片用来估计模型在上采样x2,x3,x4时的表现,set14用来估计模型在上采样x3的表现。除了91张图片之外,在5.2节也用了大数据集训练。

值得注意的是,文章中提出了sub-images(即子图)的概念。

在训练阶段,地面真实图像{Xi}是从训练图像中随机裁剪出来的32张32×32像素的子图像。我们所说的“子图像”是指这些样本被视为小的“图像”而不是“补丁”,在这个意义上,“补丁”是重叠的,需要一些平均作为后处理,但“子图像”不需要。为了合成低分辨率样本{Yi},我们用适当的高斯核模糊子图像,用放大因子进行子采样,并通过双边插值对相同的因子进行放大。这91张训练图像提供了大约24,800张子图像。子图像从原始图像中提取,步幅为14。我们尝试了较小的进步,但没有观察到显著的性能改善。从我们的观察来看,训练集足以训练所提出的深度网络。

2 实验流程

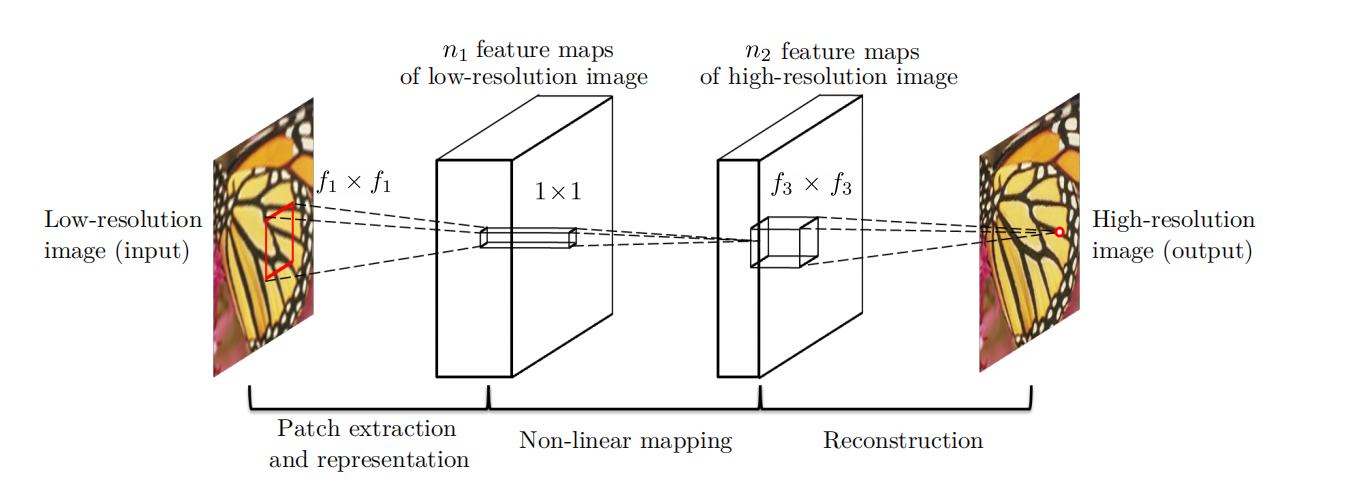

输入为32x32像素的子图sub-image,经过三层卷积,得到输出。

提前对输入input进行了双三次插值,所以网络的输入和输出是相同大小的。

第一层卷积的参数为:(kernel size)9x9,(input channel)1,(outputchannel)64

第二层卷积的参数为:1x1,64,32

第三层卷积的参数为:5x5,32,1

至于为什么第一层网络中输入通道为1,文章中这样说是为了和之前的方法进行对比,所以采用相同的通道数。

在[20]之后,我们在实验中只考虑亮度通道(在YCrCb颜色空间中),所以在第一/最后一层考虑c=1。

这两个色度通道仅为显示的目的而进行双边上采样,而不是用于训练/测试。

请注意,我们的方法可以通过设置c=3来扩展到直接的彩色图像训练。

我们使用c=1主要是为了与以前的方法进行公平的比较,因为大多数方法只涉及亮度通道。

步长s=1;训练时为避免边缘效应,无padding;测试时为保持和input image相同的大小,padding填充0。

所以,训练时的网络输出为20x20像素的子图。因为损失函数为MSE损失函数,所以调整损失函数为仅通过Xi(input image)的中心20×20与网络输出之间的差异来评估。

为了解决边界效应,在每个卷积层中,每个像素的输出(在ReLU之前)被有效输入像素的数量归一化,这可以预先计算。(ReLu激活之前归一化输入像素)

卷积核(kernel or filter)初始化为从一个均值为0,标准差为0.001(偏差为0)的高斯分布中随机抽取来初始化。

前两层的学习率为 \(10^{-4}\) ,最后一层的学习率为 \(10^{-5}\).作者通过经验发现,在最后一层的一个较小的学习速率对网络的收敛是很重要的(类似于去噪的情况[12])。

优化方式为普通的梯度下降SGD。

文章中没写epoch,batch-size。只写了训练 \(8 \times 10^8\) 个反向传播需要三天时间。

网络结构:

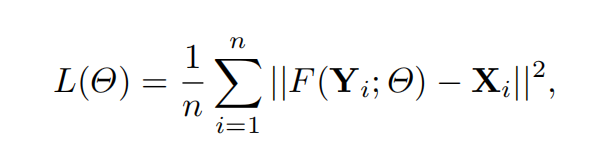

3 损失函数:MSE损失函数

其中,n为像素点的个数,F为网络的输出,X为网络的输入,i表示第i个图像。其中,训练集和测试集的计算方式有区别。

4 实验结果

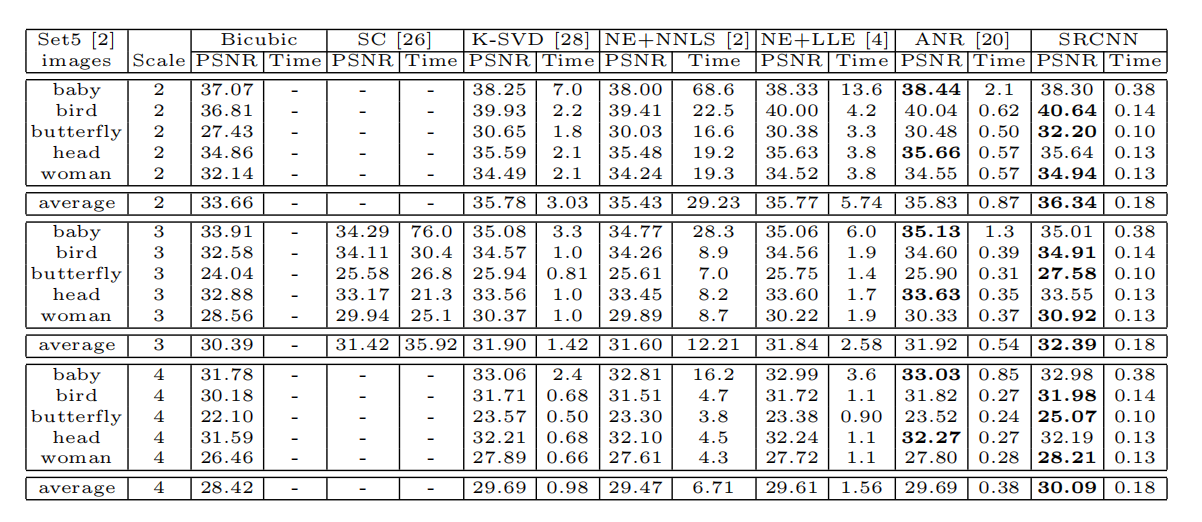

表一 在set5数据集上的PSNR(dB)和测试时间(sec,秒)

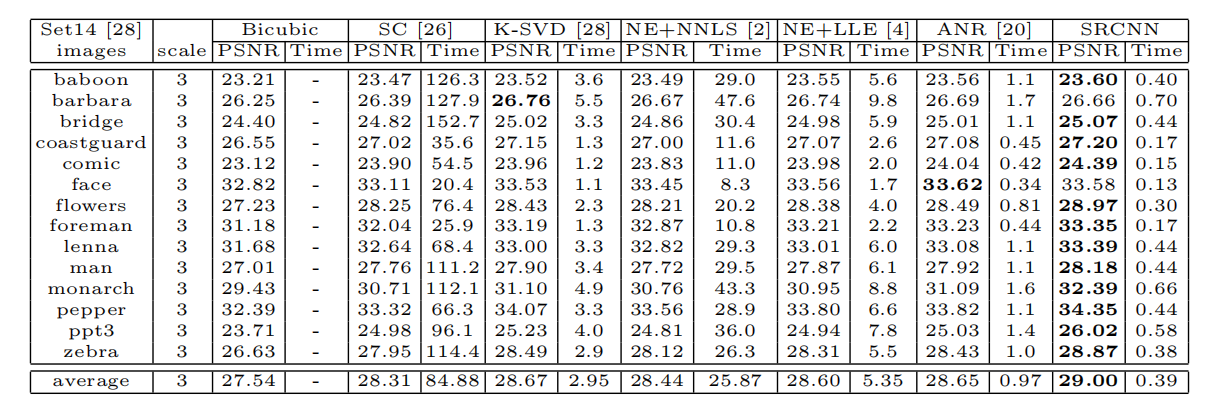

表2 set14数据集上的PSNR(dB)和测试时间(sec)

5 实验配置

GTX 770 GPU

c++

IntelCPU3.10 GHz

16GB内存

读论文SRCNN:Learning a Deep Convolutional Network for Image Super-Resolution的更多相关文章

- 论文学习 :Learning a Deep Convolutional Network for Image Super-Resolution 2014

(Learning a Deep Convolutional Network for Image Super-Resolution, ECCV2014) 摘要:我们提出了一种单图像超分辨率的深度学习方 ...

- 论文笔记之:UNSUPERVISED REPRESENTATION LEARNING WITH DEEP CONVOLUTIONAL GENERATIVE ADVERSARIAL NETWORKS

UNSUPERVISED REPRESENTATION LEARNING WITH DEEP CONVOLUTIONAL GENERATIVE ADVERSARIAL NETWORKS ICLR 2 ...

- ASPLOS'17论文导读——SC-DCNN: Highly-Scalable Deep Convolutional Neural Network using Stochastic Computing

今年去参加了ASPLOS 2017大会,这个会议总体来说我感觉偏系统和偏软一点,涉及硬件的相对少一些,对我这个喜欢算法以及硬件架构的菜鸟来说并不算非常契合.中间记录了几篇相对比较有趣的paper,今天 ...

- ASRWGAN: Wasserstein Generative Adversarial Network for Audio Super Resolution

ASEGAN:WGAN音频超分辨率 这篇文章并不具有权威性,因为没有发表,说不定是外国的某个大学的毕业设计,或者课程结束后的作业.或者实验报告. CS230: Deep Learning, Sprin ...

- Deep Learning 27:Batch normalization理解——读论文“Batch normalization: Accelerating deep network training by reducing internal covariate shift ”——ICML 2015

这篇经典论文,甚至可以说是2015年最牛的一篇论文,早就有很多人解读,不需要自己着摸,但是看了论文原文Batch normalization: Accelerating deep network tr ...

- 论文笔记(6):Weakly-and Semi-Supervised Learning of a Deep Convolutional Network for Semantic Image Segmentation

这篇文章的主要贡献点在于: 1.实验证明仅仅利用图像整体的弱标签很难训练出很好的分割模型: 2.可以利用bounding box来进行训练,并且得到了较好的结果,这样可以代替用pixel-level训 ...

- DCGAN: "Unsupervised Representation Learning with Deep Convolutional Generative Adversarial Network" Notes

- Alec Radford, ICLR2016 原文:https://arxiv.org/abs/1511.06434 论文翻译:https://www.cnblogs.com/lyrichu/p/ ...

- Discriminative Learning of Deep Convolutional Feature Point Descriptors 论文阅读笔记

介绍 该文提出一种基于深度学习的特征描述方法,并且对尺度变化.图像旋转.透射变换.非刚性变形.光照变化等具有很好的鲁棒性.该算法的整体思想并不复杂,使用孪生网络从图块中提取特征信息(得到一个128维的 ...

- 读论文Machine Learning for Improved Diagnosis and Prognosis in Healthcare

Deep Learning的基本思想 假设我们有一个系统S,它有n层(S1,…Sn),它的输入是I,输出是O,形象地表示为: I =>S1=>S2=>…..=>Sn => ...

- Paper | Compression artifacts reduction by a deep convolutional network

目录 1. 故事 2. 方法 3. 实验 这是继SRCNN(超分辨)之后,作者将CNN的战火又烧到了去压缩失真上.我们看看这篇文章有什么至今仍有启发的故事. 贡献: ARCNN. 讨论了low-lev ...

随机推荐

- 老板:你为什么要选择 Vue?

大家好,我是 Kagol,Vue DevUI 开源组件库和 EditorX 富文本编辑器创建者,专注于前端组件库建设和开源社区运营. 假如你是团队的前端负责人,现在老板要拓展新业务,需要开发一个 We ...

- Linux 下使用Docker 安装 LNMP环境 超详细

首先在阿里云购买了一台服务器 选择了华南-深圳地区 操作系统选用了 CentOS8.0 64位 1. 初始化账号密码 登陆xshell,开始装Docker 一.安装docker 1.Docker 要求 ...

- go-micro v3 rpc服务一次改造经历

地址:https://github.com/go-micro/go-micro grpc-test-demo:https://gitee.com/jn-shao/go-gmicro-rpc-test. ...

- week_9(推荐系统)

Andrew Ng 机器学习笔记 ---By Orangestar Week_9(推荐系统) 1. Problem Formulation 这节就仅仅简单地介绍了一下 推荐系统的应用和实例.完全可以略 ...

- [python]《Python编程快速上手:让繁琐工作自动化》学习笔记1

1. 模式匹配与正则表达式笔记(第7章)(代码下载) 正则表达式,又称规则表达式.(英语:Regular Expression,在代码中常简写为regex.regexp或RE),计算机科学的一个概念. ...

- [OpenCV实战]15 基于深度学习的目标跟踪算法GOTURN

目录 1 什么是对象跟踪和GOTURN 2 在OpenCV中使用GOTURN 3 GOTURN优缺点 4 参考 在这篇文章中,我们将学习一种基于深度学习的目标跟踪算法GOTURN.GOTURN在Caf ...

- [cocos2d-x]飞机大战 遇到的bug和总结(一)

第一点: Sequence* sequence=Sequence::create(actionMove, actionFinished,NULL); create方法的最后必须加上NULL,不然会报出 ...

- 推荐一款在浏览器编辑`Blazor`的`IDE`

不知道是否有Blazor用户羡慕过React或者Vue用户,在一些组件库中,它们就提供了在当前的组件预览对于组件的实时编辑并且预览? 比如semi-design的这种 在比如codepen这种 由于B ...

- 看不懂打我系列------图文并茂基于CentOS Linux release 7.8.2003 Core安装并Docker化你的Node.js应用

@图文并茂基于CentOS Linux release 7.8.2003 Core安装并Docker化你的Node.js应用 简体中文 | English 说明 本文介绍如何在CentOS Linux ...

- 引子 - 实现轻量的 ioc 容器

IoC 反转控制原则也被叫做依赖注入 DI, 容器按照配置注入实例化的对象. 假设 A 的相互依赖关系如下图, 如何将 A 对象实例化并注入属性. 本文将实现一个轻量化的 IoC 容器, 完成对象的实 ...