【KAWAKO】TVM-使用c++进行推理

前言

在tvm工程的apps目录下,有一个howto_deploy的工程,根据此工程进行修改,可以得到c++推理程序。

修改cpp_deploy.cc文件

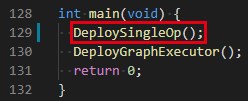

DeploySingleOp()函数不需要,直接将其和相关的Verify函数一起删掉。

修改DeployGraphExecutor()函数

读取指定模型,同时获得后面所需的函数

LOG(INFO) << "Running graph executor...";

printf("load in the library\n");

DLDevice dev{kDLCPU, 1};

tvm::runtime::Module mod_factory = tvm::runtime::Module::LoadFromFile("../model_autotune.so");

printf("create the graph executor module\n");

tvm::runtime::Module gmod = mod_factory.GetFunction("default")(dev);printf(" default\n");

tvm::runtime::PackedFunc set_input = gmod.GetFunction("set_input");printf(" set_input\n");

tvm::runtime::PackedFunc get_output = gmod.GetFunction("get_output");printf(" get_output\n");

tvm::runtime::PackedFunc run = gmod.GetFunction("run");printf(" run\n");

定义输入输出的变量

printf("Use the C++ API\n");

tvm::runtime::NDArray input = tvm::runtime::NDArray::Empty({1, 1, 640}, DLDataType{kDLFloat, 32, 1}, dev);

tvm::runtime::NDArray input_state = tvm::runtime::NDArray::Empty({1, 2, 128, 2}, DLDataType{kDLFloat, 32, 1}, dev);

tvm::runtime::NDArray output = tvm::runtime::NDArray::Empty({1, 1, 640}, DLDataType{kDLFloat, 32, 1}, dev);

tvm::runtime::NDArray output_state = tvm::runtime::NDArray::Empty({1, 2, 128, 2}, DLDataType{kDLFloat, 32, 1}, dev);

从bin文件中读取数据

float input_storage[1 * 1 * 640];

FILE* fp = fopen("../input.bin", "rb");

fread(input->data, 1 * 1 * 640, 4, fp);

fclose(fp);

float input_state_storage[1 * 2 * 128 * 2];

FILE* fp_state = fopen("../input_state.bin", "rb");

fread(input_state->data, 1 * 2 * 128 * 2, 4, fp_state);

fclose(fp_state);

将数据输入到网络

printf("set the right input\n");

set_input("input_4", input);

set_input("input_5", input_state);

运行推理

struct timeval t0, t1;

int times = 100000; // 3394

gettimeofday(&t0, 0);

printf("run the code\n");

for(int i=0;i<times;i++)

run();

gettimeofday(&t1, 0);

printf("%.5fms\n", ((t1.tv_sec - t0.tv_sec) * 1000 + (t1.tv_usec - t0.tv_usec) / 1000.f)/times);

得到输出

printf("get the output\n");

get_output(0, output);printf(" 0\n");

get_output(1, output_state);printf(" 1\n");

将输出保存到bin文件

FILE* fp_out = fopen("output.bin", "wb");

fwrite(output->data, 1 * 1 * 640, 4, fp_out);

fclose(fp_out);

FILE* fp_out_state = fopen("output_state.bin", "wb");

fwrite(output_state->data, 1 * 2 * 128 * 2, 4, fp_out_state);

fclose(fp_out_state);

numpy与bin文件的互相转换

numpy转bin

import numpy as np

import os

input_1 = np.load("./input.npy")

input_2 = np.load("./input_states.npy")

build_dir = "./"

with open(os.path.join(build_dir, "input.bin"), "wb") as fp:

fp.write(input_1.astype(np.float32).tobytes())

with open(os.path.join(build_dir, "input_state.bin"), "wb") as fp:

fp.write(input_2.astype(np.float32).tobytes())

bin转numpy

output = np.fromfile("./output.bin", dtype=np.float32)

output_state = np.fromfile("./output_state.bin", dtype=np.float32)

使用CMakeLists.txt进行编译

在howto_deploy目录下创建CMakeLists.txt

cmake_minimum_required(VERSION 3.2)

project(how2delploy C CXX)

SET(CMAKE_CXX_FLAGS_DEBUG "$ENV{CXXFLAGS} -O3 -Wall -g2 -ggdb")

SET(CMAKE_CXX_FLAGS_RELEASE "$ENV{CXXFLAGS} -O3 -Wall -fPIC")

set(TVM_ROOT /path/to/tvm)

set(DMLC_CORE ${TVM_ROOT}/3rdparty/dmlc-core)

include_directories(${TVM_ROOT}/include)

include_directories(${DMLC_CORE}/include)

include_directories(${TVM_ROOT}/3rdparty/dlpack/include)

link_directories(${TVM_ROOT}/build/Release)

add_definitions(-DDMLC_USE_LOGGING_LIBRARY=<tvm/runtime/logging.h>)

add_executable(cpp_deploy_norm cpp_deploy.cc)

target_link_libraries(cpp_deploy_norm ${TVM_ROOT}/build/libtvm_runtime.so)

老四连

mkdir build

cd build

cmake ..

make

运行

cd build

./cpp_deploy_norm

【KAWAKO】TVM-使用c++进行推理的更多相关文章

- 使用Tensorize评估硬件内部特性

使用Tensorize评估硬件内部特性 这是有关如何在TVM中执行张量的入门文档. 通过使用调度原语tensorize,人们可以用相应的内部函数代替计算单元,从而轻松利用handcrafted mic ...

- 【翻译】借助 NeoCPU 在 CPU 上进行 CNN 模型推理优化

本文翻译自 Yizhi Liu, Yao Wang, Ruofei Yu.. 的 "Optimizing CNN Model Inference on CPUs" 原文链接: h ...

- AI推理与Compiler

AI推理与Compiler AI芯片编译器能加深对AI的理解, AI芯片编译器不光涉及编译器知识,还涉及AI芯片架构和并行计算如OpenCL/Cuda等.如果从深度学习平台获得IR输入,还需要了解深度 ...

- 将TVM集成到PyTorch

将TVM集成到PyTorch 随着TVM不断展示出对深度学习执行效率的改进,很明显PyTorch将从直接利用编译器堆栈中受益.PyTorch的主要宗旨是提供无缝且强大的集成,而这不会妨碍用户.PyTo ...

- TVM代码生成codegen

TVM代码生成codegen 硬件后端提供程序(例如Intel,NVIDIA,ARM等),提供诸如cuBLAS或cuDNN之类的内核库以及许多常用的深度学习内核,或者提供框架例,如带有图形引擎的DNN ...

- 桥接PyTorch和TVM

桥接PyTorch和TVM 人工智能最引人入胜的一些应用是自然语言处理.像BERT或GPT-2之类的模型及其变体,可以获住足够多的文本信息. 这些模型属于称为Transformers的神经网络类体系结 ...

- TVM适配NN编译Compiler缺陷

TVM适配NN编译Compiler缺陷 内容纲要 前言 TVM针对VTA的编译流程 自定义VTA架构:TVM的缺陷与性能瓶颈 TVM缺陷与瓶颈 缺陷一:SRAM配置灵活性差 缺陷二:计算阵列配置僵硬 ...

- TVM优化GPU机器翻译

TVM优化GPU机器翻译 背景 神经机器翻译(NMT)是一种自动化的端到端方法,具有克服传统基于短语的翻译系统中的弱点的潜力.最近,阿里巴巴集团正在为全球电子商务部署NMT服务. 将Transform ...

- TVM 优化 ARM GPU 上的移动深度学习

TVM 优化 ARM GPU 上的移动深度学习 随着深度学习的巨大成功,将深度神经网络部署到移动设备的需求正在迅速增长.与桌面平台上所做的类似,在移动设备中使用 GPU 既有利于推理速度,也有利于能源 ...

- 端到端TVM编译器(下)

端到端TVM编译器(下) 4.3 Tensorization DL工作负载具有很高的运算强度,通常可以分解为张量运算符,如矩阵乘法或一维卷积.这些自然分解导致了最近的添加张量计算原语.这些新的原语带来 ...

随机推荐

- 【每日一题】【DFS&每个点都调用一次前后左右】由1连接的岛屿数量-211031/220216

给你一个由 '1'(陆地)和 '0'(水)组成的的二维网格,请你计算网格中岛屿的数量. 岛屿总是被水包围,并且每座岛屿只能由水平方向和/或竖直方向上相邻的陆地连接形成. 此外,你可以假设该网格的四条边 ...

- 【机器学习】李宏毅——自注意力机制(Self-attention)

前面我们所讲的模型,输入都是一个向量,但有没有可能在某些场景中输入是多个向量,即一个向量集合,并且这些向量的数目并不是固定的呢? 这一类的场景包括文字识别.语音识别.图网络等等. 那么先来考虑输出的类 ...

- echarts去除下载小图标

toolbox: { show: true, orient: 'vertical', left: 'right', top: 'center', feature: { dataView: { read ...

- matlab狄拉克锥的三维图

石墨烯(graphene)中的狄拉克锥(Dirac cone)图形.直接按照能级公式绘图,公式参考[1]中 energy of the electrons 公式. %matlab代码 clear; g ...

- 洛谷P2196例题分析

[NOIP1996 提高组] 挖地雷(原题) 题目描述 在一个地图上有\(N\)个地窖\((N \le 20)\),每个地窖中埋有一定数量的地雷.同时,给出地窖之间的连接路径.当地窖及其连接的数据给出 ...

- 2、Java封装、继承与多态

/** * 类.对象.面向过程.面向对象的理解: * 1.类:类是封装对象的属性和方法的载体 * * 2.对象:对象是类抽象出来的一个实例 * * 3.面向过程:面向过程注重的是具体的实现过程,因果关 ...

- MYSQL进阶学习笔记

MySQL在Linux中的使用: 1.查看mysql在linux的安装版本 mysqladmin –version 2.mysql服务的启动与停止 (1).启动: service mysql star ...

- JavaScript 深拷贝的循环引用问题

如果说道实现深拷贝最简单的方法,我们第一个想到的就是 JSON.stringify() 方法,因为JSON.stringify()后返回的是字符串,所以我们会再使用JSON.parse()转换为对象, ...

- [OpenCV实战]48 基于OpenCV实现图像质量评价

本文主要介绍基于OpenCV contrib中的quality模块实现图像质量评价.图像质量评估Image Quality Analysis简称IQA,主要通过数学度量方法来评价图像质量的好坏. 本文 ...

- 初学《python编程从入门到实践》web应用程序,出现错误

一开始是遇到了TemplateDoesNotExist的错误,上百度都是说改settings.py里面的TEMPLATE的DIRS, 但我改了还是出现问题, 我用的<python编程从入门到实践 ...