C++卷积神经网络实例:tiny_cnn代码具体解释(7)——fully_connected_layer层结构类分析

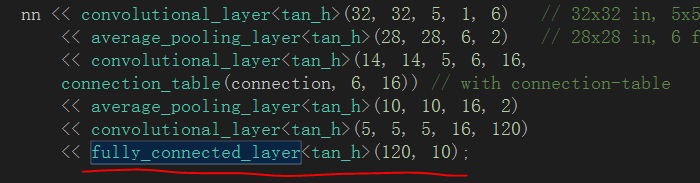

之前的博文中已经将卷积层、下採样层进行了分析。在这篇博文中我们对最后一个顶层层结构fully_connected_layer类(全连接层)进行分析:

一、卷积神经网路中的全连接层

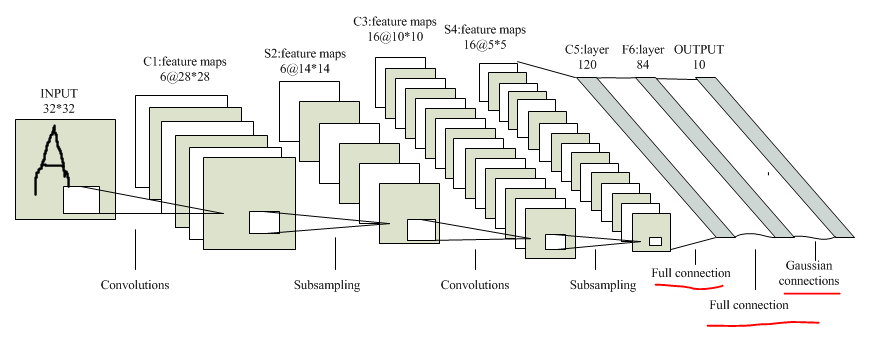

在卷积神经网络中全连接层位于网络模型的最后部分,负责对网络终于输出的特征进行分类预測,得出分类结果:

LeNet-5模型中的全连接层分为全连接和高斯连接,该层的终于输出结果即为预測标签,比如这里我们须要对MNIST数据库中的数据进行分类预測,当中的数据一共同拥有10类(数字0~9),因此全全连接层的终于输出就是一个10维的预測结果向量,哪一维的值为非零,则预測结果相应的就是几。

二、fully_connected_layer类结构

与之前卷积层和下採样层不同的是,这里的全连接层fully_connected_layer类继承自基类layer,当中类成员一共可分为四大部分:成员变量、构造函数、前向传播函数、反向传播函数。

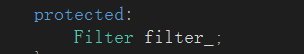

2.1 成员变量

fully_connected_layer类的成员变量仅仅有一个。就是一个Filter类型的变量:

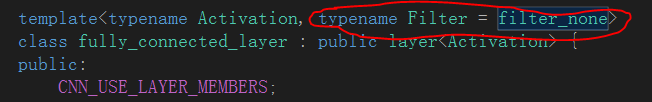

而这里的Filter是通过类模板參数传入的一个缺省filter_none类型,具体例如以下:

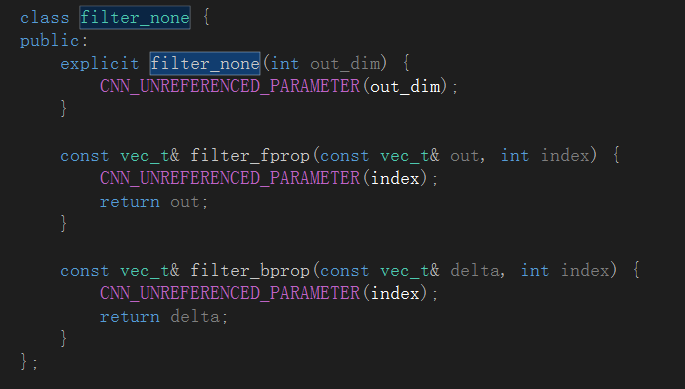

至于filter_none类型,从名称推断应该是一个和滤波器核相关的类封装,具体定义在dropout.h文件里:

有关dropout.h文件里封装的相关类的具体信息我会在之后的博文中进行具体的介绍。这里先留一个坑,只是事先透漏一点,卷积神经网络中的dropout本质上是为了改善网络过拟合性能而设计的。

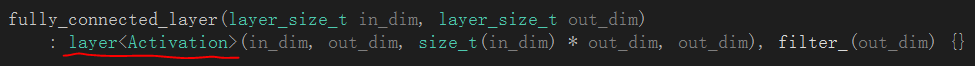

2.2 构造函数

构造函数极其简单。单纯的调用了基类layer的构造函数:

至于基类layer,里面封装了大量的虚函数以及纯虚函数,并给出了网络层主要的框架设定。对layer_base类进行了一部分实例化,这几点我们以后会具体说的。

2.3 前向传播函数

众所周知,卷积神经网络在训练时和BP神经网络的训练极其类似。包含一个样本预測的前向传播过程和误差的反向传播过程。

首先前向传播函数的代码例如以下:

const vec_t& forward_propagation(const vec_t& in, size_t index) {

vec_t &a = a_[index];

vec_t &out = output_[index];

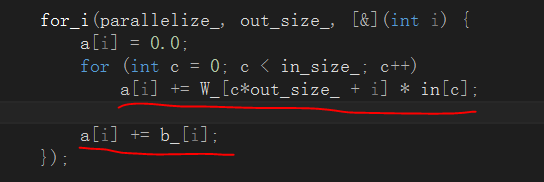

for_i(parallelize_, out_size_, [&](int i) {

a[i] = 0.0;

for (int c = 0; c < in_size_; c++)

a[i] += W_[c*out_size_ + i] * in[c];

a[i] += b_[i];

});

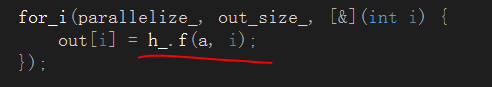

for_i(parallelize_, out_size_, [&](int i) {

out[i] = h_.f(a, i);

});

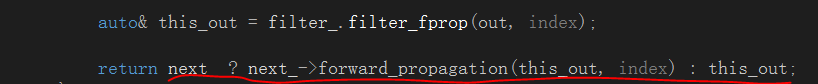

auto& this_out = filter_.filter_fprop(out, index);

return next_ ?

next_->forward_propagation(this_out, index) : this_out;

}

从代码中能够看出这个前向传播函数本质上属于一个递归函数,用递归的方式实现层层传播的功能:

在前向传播的过程中,主要有两个阶段。一是通过当前层的卷积核和偏置完毕对输入数据的映射:

从代码中可见,卷积层的映射过程本质上就是一个卷积操作,然后在对卷积结果累加偏置。第二个阶段就是将卷积层的映射结果送入激活函数中进行处理:

激活函数的主要作用是对卷积层的映射输出进行规范化。调整期数据分布。经典的激活函数是Sigmoid函数。主要对输出特征进行平滑。在之后学者又提出Relu类型的激活函数。主要是对输出特征进行稀疏化规范,使其更接近于人脑的视觉映射机理。在tiny_cnn中作者封装了sigmoid、relu、leaky_relu、softmax、tan_h、tan_hp1m2等激活函数,这些类都定义在activation命名空间中,具体在activation_function.h文件里,在兴许的篇幅中我会专门拿出一篇博文的篇幅对tiny_cnn的激活函数做集中的分析。

2.4 反向传播函数

反向传播算法是BP类型神经网络的经典特征。大部分都採用随机梯度下降法对误差进行求导和传播。因为反向传播算法涉及到误差的求偏导、灵敏度传递等概念,导致其在原理上相对于前向传播过程显得更为复杂,代码实现也较为繁琐。我们这里仅仅是先给出反向传播的代码,在兴许的博文中在针对这个传播过程进行更文具体的分析。OK,又是一个坑:

const vec_t& back_propagation(const vec_t& current_delta, size_t index) {

const vec_t& curr_delta = filter_.filter_bprop(current_delta, index);

const vec_t& prev_out = prev_->output(index);

const activation::function& prev_h = prev_->activation_function();

vec_t& prev_delta = prev_delta_[index];

vec_t& dW = dW_[index];

vec_t& db = db_[index];

for (int c = 0; c < this->in_size_; c++) {

// propagate delta to previous layer

// prev_delta[c] += current_delta[r] * W_[c * out_size_ + r]

prev_delta[c] = vectorize::dot(&curr_delta[0], &W_[c*out_size_], out_size_);

prev_delta[c] *= prev_h.df(prev_out[c]);

}

for_(parallelize_, 0, out_size_, [&](const blocked_range& r) {

// accumulate weight-step using delta

// dW[c * out_size + i] += current_delta[i] * prev_out[c]

for (int c = 0; c < in_size_; c++)

vectorize::muladd(&curr_delta[0], prev_out[c], r.end() - r.begin(), &dW[c*out_size_ + r.begin()]);

for (int i = r.begin(); i < r.end(); i++)

db[i] += curr_delta[i];

});

return prev_->back_propagation(prev_delta_[index], index);

}

四、注意事项

1、卷积层和下採样层的前向/反向传播函数

在fully_connected_layer类中我们发现其内部封装了前向/反向传播函数,但在之前介绍的卷积层和均值下採样层中我们并没有发现前向/反向传播函数的影子,但前向/反向传播函数确实是一个全局的过程。不可能出现断层,因此细致研究就会发现原来作者是将convolutional_layer类和average_pooling_layer相应的前向/反向传播函数封装在了它们共同的基类:partial_connected_layer中了。

2、前向传播函数和反向传播函数

在这篇博文中我为兴许的博文中挖下了非常多大坑,尤其像前向/反向传播函数这样的卷积神经网络训练的精华部分,是最能体现作者编程功力和框架设计功力的地方,一两篇博文都不一定能讲的清楚,所以请大家不要着急,我会尽快把当中的玄机弄明确。然后用通俗的语言进行解释的,所以说。坑一定会都一一填上的。

C++卷积神经网络实例:tiny_cnn代码具体解释(7)——fully_connected_layer层结构类分析的更多相关文章

- C++卷积神经网络实例:tiny_cnn代码具体解释(8)——partial_connected_layer层结构类分析(上)

在之前的博文中我们已经将顶层的网络结构都介绍完毕,包括卷积层.下採样层.全连接层,在这篇博文中主要有两个任务.一是总体贯通一下卷积神经网络在对图像进行卷积处理的整个流程,二是继续我们的类分析.这次须要 ...

- C++卷积神经网络实例:tiny_cnn代码具体解释(6)——average_pooling_layer层结构类分析

在之前的博文中我们着重分析了convolutional_layer类的代码结构.在这篇博文中分析相应的下採样层average_pooling_layer类: 一.下採样层的作用 下採样层的作用理论上来 ...

- DeepLearning.ai学习笔记(四)卷积神经网络 -- week2深度卷积神经网络 实例探究

一.为什么要进行实例探究? 通过他人的实例可以更好的理解如何构建卷积神经网络,本周课程主要会介绍如下网络 LeNet-5 AlexNet VGG ResNet (有152层) Inception 二. ...

- C++卷积神经网络实例(一)

跟着这位博主来学习C++的卷积网络实例,因为作者一直在更新代码,所以新的代码和这位博主的分析有所不同:这位博主写的东西太泛了,没有讲到实质, 可以参考下他分析的类与类之间的关系图.. 前四节:http ...

- 经典的卷积神经网络及其Pytorch代码实现

1.LeNet LeNet是指LeNet-5,它是第一个成功应用于数字识别的卷积神经网络.在MNIST数据集上,可以达到99.2%的准确率.LeNet-5模型总共有7层,包括两个卷积层,两个池化层,两 ...

- 卷积神经网络CNN的原理(三)---代码解析

卷积神经网络在几个主流的神经网络开源架构上面都有实现,我这里不是想实现一个自己的架构,主要是通过分析一个最简单的卷积神经网络实现代码,来达到进一步的加深理解卷积神经网络的目的. 笔者在github上找 ...

- 深入学习卷积神经网络(CNN)的原理知识

网上关于卷积神经网络的相关知识以及数不胜数,所以本文在学习了前人的博客和知乎,在别人博客的基础上整理的知识点,便于自己理解,以后复习也可以常看看,但是如果侵犯到哪位大神的权利,请联系小编,谢谢.好了下 ...

- Deep Learning模型之:CNN卷积神经网络(一)深度解析CNN

http://m.blog.csdn.net/blog/wu010555688/24487301 本文整理了网上几位大牛的博客,详细地讲解了CNN的基础结构与核心思想,欢迎交流. [1]Deep le ...

- 卷积神经网络CNN与深度学习常用框架的介绍与使用

一.神经网络为什么比传统的分类器好 1.传统的分类器有 LR(逻辑斯特回归) 或者 linear SVM ,多用来做线性分割,假如所有的样本可以看做一个个点,如下图,有蓝色的点和绿色的点,传统的分类器 ...

随机推荐

- 【bzoj1002】[FJOI2007]轮状病毒 矩阵树定理+高精度

题目描述 轮状病毒有很多变种,所有轮状病毒的变种都是从一个轮状基产生的.一个N轮状基由圆环上N个不同的基原子和圆心处一个核原子构成的,2个原子之间的边表示这2个原子之间的信息通道.如下图所示 N轮状病 ...

- 【Luogu】P2473奖励关(期望DP)

题目链接 逆推期望DP.设f[i][j]为1~i-1中吃到的宝物集合为j,在i~k轮能得到的最大期望分数. 如果不吃显然f[i][j]+=f[i+1][j]/n 如果吃就是f[i][j]+=max(f ...

- ActiveMQ使用经验与优化

摘自:http://blog.csdn.net/m13321169565/article/details/8081314 1.1 不要频繁的建立和关闭连接 JMS使用长连接方式,一个程序,只要和JMS ...

- java面试题之你了解守护线程吗?它和非守护线程有什么区别

程序运行完毕,jvm会等待非守护线程完成后关闭,但是jvm不会等待守护线程. 守护线程最典型的的例子是:GC线程

- 关于vue属性绑定的问题

<el-submenu index="></el-submenu> 类似于这样的形式,这里的index是以string的数据格式存在的. <el-submenu ...

- 【CF56E】Domino Principle(线性扫描,伪DP)

每块多米诺骨牌所在的位置设为x,每块多米诺骨牌高度为h.如果将x位置上的多米诺骨牌向右翻到,它就可以影响[x+1, x+h-1]范围内的所有多米诺骨牌,让他们也翻到,同时这些被翻到的多米诺骨牌还能影响 ...

- Android系统默认输入法的修改为搜狗输入法

1. frameworks\base\packages\SettingsProvider\res\values\defaults.xml 文件中修改默认输入法为搜狗输入法 <stringnam ...

- Linux 之 Memcached

Memcached的安装使用 参考教程:[千峰教育] 环境:CentOS 6.8 一.简介: memcached作为高速运行的分布式缓存服务器,具有以下的特点. · 协议简单 · 基于libevent ...

- Codeforces Gym101502 J-取数博弈

还有J题,J题自己并不是,套的板子,大家写的都一样,因为大家都是套板子过的,贴一下代码,等学会了写一篇博客... J.Boxes Game 代码: 1 //J. Boxes Game-取数博弈-不会, ...

- vs2017秘钥

VS2017专业版和企业版激活密钥 需要的请自取- Enterprise: NJVYC-BMHX2-G77MM-4XJMR-6Q8QF Professional: KBJFW-NXHK6-W4WJM- ...