074 hbase与mapreduce集成

一:运行给定的案例

1.获取jar包里的方法

2.运行hbase自带的mapreduce程序

lib/hbase-server-0.98.6-hadoop2.jar

3.具体运行

注意命令:mapredcp。

HADOOP_CLASSPATH是当前运行时需要的环境。

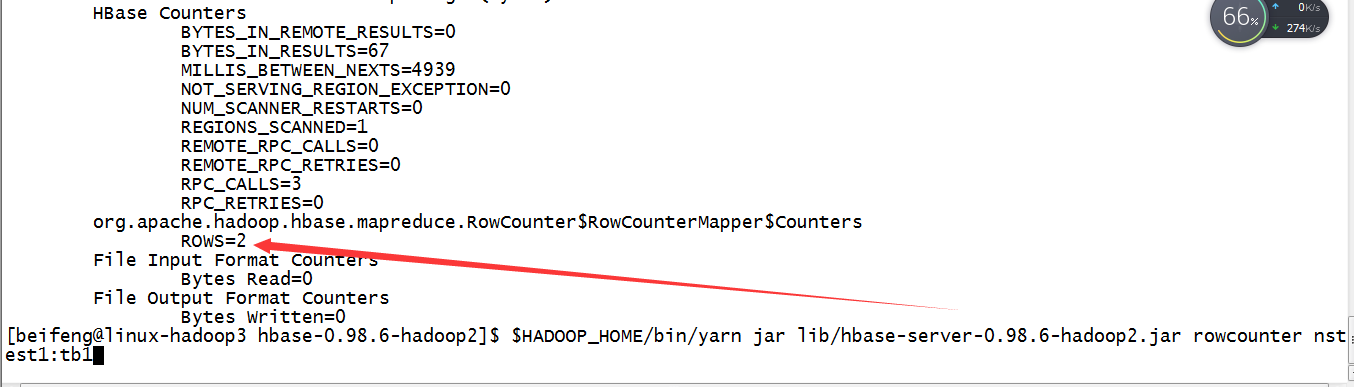

4.运行一个小方法

$HADOOP_HOME/bin/yarn jar lib/hbase-server-0.98.6-hadoop2.jar rowcounter nstest1:tb1

二:自定义hbase的数据拷贝

1.需求

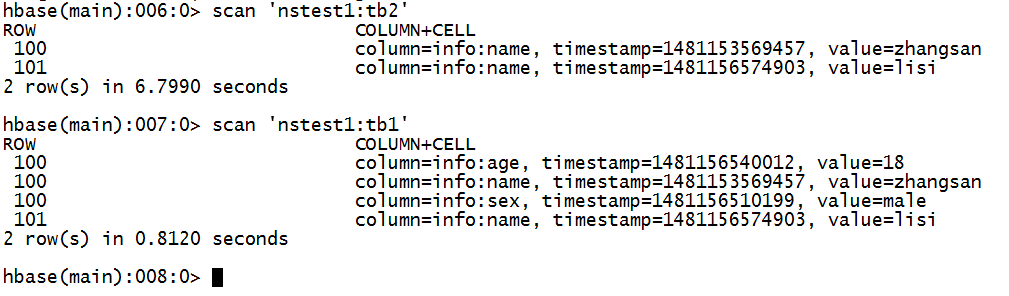

将nstest1:tb1的数据info:name列拷贝到nstest1:tb2

2.新建tb2表

3.书写mapreduce程序

输入:rowkey,result。

package com.beifeng.bigdat; import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.conf.Configured;

import org.apache.hadoop.hbase.Cell;

import org.apache.hadoop.hbase.CellUtil;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.client.Put;

import org.apache.hadoop.hbase.client.Result;

import org.apache.hadoop.hbase.client.Scan;

import org.apache.hadoop.hbase.io.ImmutableBytesWritable;

import org.apache.hadoop.hbase.mapreduce.TableMapReduceUtil;

import org.apache.hadoop.hbase.mapreduce.TableMapper;

import org.apache.hadoop.hbase.mapreduce.TableReducer;

import org.apache.hadoop.hbase.util.Bytes;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper.Context;

import org.apache.hadoop.util.Tool;

import org.apache.hadoop.util.ToolRunner; public class HBaseMRTest extends Configured implements Tool{

/**

* map

* @author *

*/

public static class tbMap extends TableMapper<ImmutableBytesWritable, Put>{ @Override

protected void map(ImmutableBytesWritable key, Result value,Context context) throws IOException, InterruptedException {

Put put=new Put(key.get());

for(Cell cell:value.rawCells()){

if("info".equals(Bytes.toString(CellUtil.cloneFamily(cell)))){

if("name".equals(Bytes.toString(CellUtil.cloneQualifier(cell)))){

put.add(cell);

context.write(key, put);

}

}

}

} }

/**

* reduce

* @author *

*/

public static class tbReduce extends TableReducer<ImmutableBytesWritable, Put, ImmutableBytesWritable>{ @Override

protected void reduce(ImmutableBytesWritable key, Iterable<Put> values,Context context)throws IOException, InterruptedException {

for(Put put:values){

context.write(key, put);

}

} } public int run(String[] args) throws Exception {

Configuration conf=super.getConf();

Job job =Job.getInstance(conf, "hbasemr");

job.setJarByClass(HBaseMRTest.class);

Scan scan=new Scan();

TableMapReduceUtil.initTableMapperJob(

"nstest1:tb1",

scan,

tbMap.class,

ImmutableBytesWritable.class,

Put.class,

job);

TableMapReduceUtil.initTableReducerJob(

"nstest1:tb2",

tbReduce.class,

job);

boolean issucess=job.waitForCompletion(true);

return issucess?0:1;

}

public static void main(String[] args) throws Exception{

Configuration conf=HBaseConfiguration.create();

int status=ToolRunner.run(conf, new HBaseMRTest(), args);

System.exit(status);

} }

4.打成jar包

5.运行语句

加上需要的export前提。

$HADOOP_HOME/bin/yarn jar /etc/opt/datas/HBaseMR.jar com.beifeng.bigdat.HBaseMRTest

6.效果

074 hbase与mapreduce集成的更多相关文章

- HBase概念学习(七)HBase与Mapreduce集成

这篇文章是看了HBase权威指南之后,依据上面的解说搬下来的样例,可是略微有些不一样. HBase与mapreduce的集成无非就是mapreduce作业以HBase表作为输入,或者作为输出,也或者作 ...

- HBase 与 MapReduce 集成

6. HBase 与 MapReduce 集成 6.1 官方 HBase 与 MapReduce 集成 查看 HBase 的 MapReduce 任务的执行:bin/hbase mapredcp; 环 ...

- hbase与mapreduce集成

一:运行给定的案例 1.获取jar包里的方法 2.运行hbase自带的mapreduce程序 lib/hbase-server-0.98.6-hadoop2.jar 3.具体运行 4.运行一个小方法 ...

- 【HBase】HBase与MapReduce集成——从HDFS的文件读取数据到HBase

目录 需求 步骤 一.创建maven工程,导入jar包 二.开发MapReduce程序 三.结果 需求 将HDFS路径 /hbase/input/user.txt 文件的内容读取并写入到HBase 表 ...

- hbase运行mapreduce设置及基本数据加载方法

hbase与mapreduce集成后,运行mapreduce程序,同时需要mapreduce jar和hbase jar文件的支持,这时我们需要通过特殊设置使任务可以同时读取到hadoop jar和h ...

- 【HBase】HBase与MapReduce的集成案例

目录 需求 步骤 一.创建maven工程,导入jar包 二.开发MapReduce程序 三.运行结果 HBase与MapReducer集成官方帮助文档:http://archive.cloudera. ...

- 大数据技术之_11_HBase学习_02_HBase API 操作 + HBase 与 Hive 集成 + HBase 优化

第6章 HBase API 操作6.1 环境准备6.2 HBase API6.2.1 判断表是否存在6.2.2 抽取获取 Configuration.Connection.Admin 对象的方法以及关 ...

- Hbase与hive集成与对比

HBase与Hive的对比 1.Hive (1) 数据仓库 Hive的本质其实就相当于将HDFS中已经存储的文件在Mysql中做了一个双射关系,以方便使用HQL去管理查询. (2) 用于数据分析.清洗 ...

- 《OD大数据实战》HBase整合MapReduce和Hive

一.HBase整合MapReduce环境搭建 1. 搭建步骤1)在etc/hadoop目录中创建hbase-site.xml的软连接.在真正的集群环境中的时候,hadoop运行mapreduce会通过 ...

随机推荐

- android ListView 分页加载数据

1.mainActivity <LinearLayout xmlns:android="http://schemas.android.com/apk/res/android" ...

- .net 重新注册

今天同事问 一个IIS 的监控站点 .net 出现问题:对于windows 一般都停留在重启生效思想:然并没有生效: 于是建议重新注册.NET : 一般出现原因: 在默认安装路径 重启注册: 默认的安 ...

- Storm 集群

Apache Storm Storm是一个分布式的,可靠的,容错的数据流处理系统.Storm集群的输入流由一个被称作spout的组件管理,spout把数据传递给bolt,bolt要么把数据保存到某种存 ...

- Java SE之String,字符串和子字符串的存储与区别

理解String 是怎么占用内存的 来看一个每个String对象的各个属性,一个String包括如下的属性: 一个char数组(是个独立的对象用来存储字符串中的字符) 一个int 的off ...

- 如何在同一台服务器上部署两个tomcat

因为测试的需要,有时我们必须在同一个服务器上部署两个tomcat,然后去做应用的部署,那么很多同学可能会觉得比较为难,找的资料也比较的不齐全,那么今天华华就来给大家讲讲如何部署2个tomcat,并能够 ...

- C - Portals Gym - 102006C (网络流最小割)

题目链接:https://cn.vjudge.net/contest/283918#problem/C 题目大意:T个测试数据,然后给你一个字符串,每一个字符串包括‘s’,‘t’,‘o’,‘#’,‘. ...

- geeksforgeeks-Array-Rotate and delete

As usual Babul is again back with his problem and now with numbers. He thought of an array of number ...

- SpringAOP+注解实现简单的日志管理

今天在再次深入学习SpringAOP之后想着基于注解的AOP实现日志功能,在面试过程中我们也经常会被问到:假如项目已经上线,如何增加一套日志功能?我们会说使用AOP,AOP也符合开闭原则:对代码的修改 ...

- OA协同办公软件

OA协同办公软件: 泛微软件. 九思软件. 华天动力. 万户OA.:北京万户网络技术有限公司创立于1998年2月,是北京华宇软件股份有限公司(股票简称:“华宇软件”,股票代码:300271)的全资子公 ...

- saltstack自动化运维系列⑥SaltStack实践安装配置HAproxy的Keepalived

saltstack自动化运维系列⑥SaltStack实践安装配置HAproxy的Keepalived 安装配置Keepalived 1.编写功能模块 #创建keepalived目录# mkdir -p ...