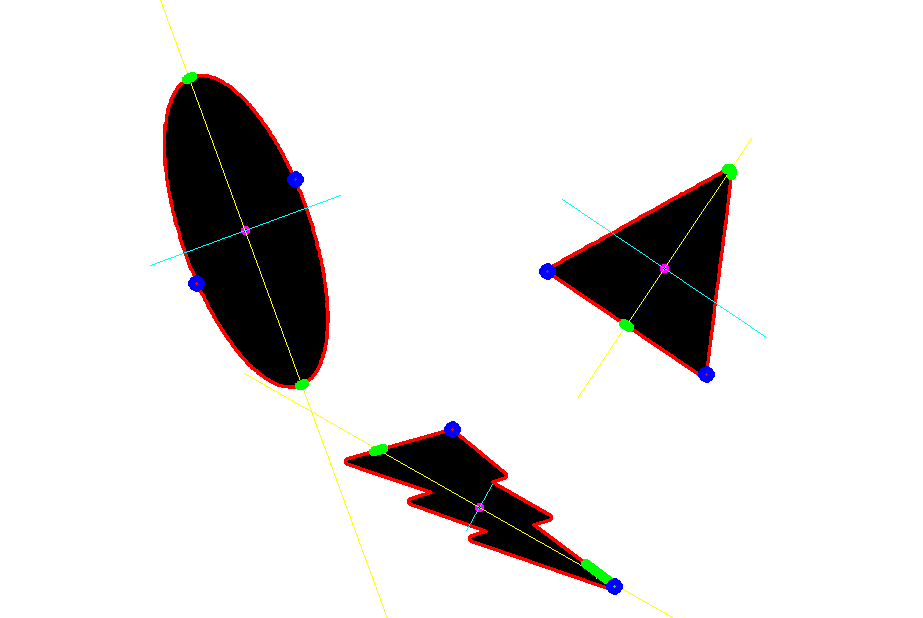

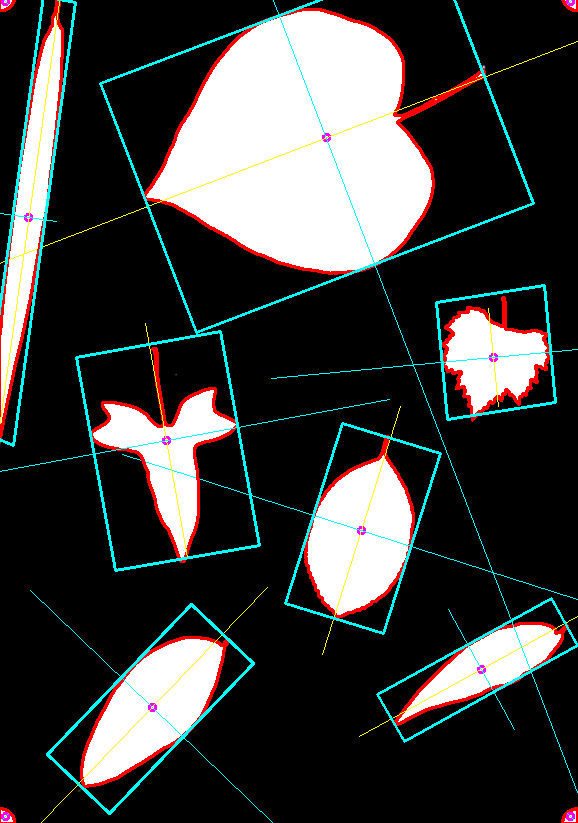

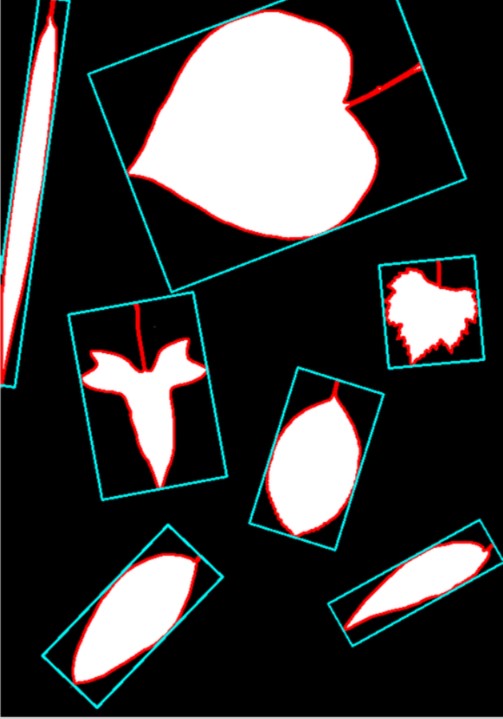

【4Opencv】如何识别出轮廓准确的长和宽

问题来源:

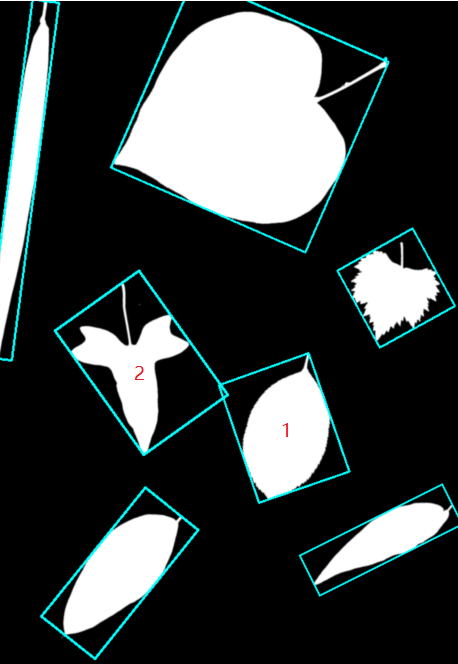

int main( int argc, char** argv )

{

//read the image

Mat img = imread("e:/sandbox/leaf.jpg");

Mat bw;

bool dRet;

//resize

pyrDown(img,img);

pyrDown(img,img);

cvtColor(img, bw, COLOR_BGR2GRAY);

//morphology operation

threshold(bw, bw, 150, 255, CV_THRESH_BINARY);

//bitwise_not(bw,bw);

//find and draw contours

vector<vector<Point> > contours;

vector<Vec4i> hierarchy;

findContours(bw, contours, hierarchy, CV_RETR_LIST, CV_CHAIN_APPROX_NONE);

for (int i = 0;i<contours.size();i++)

{

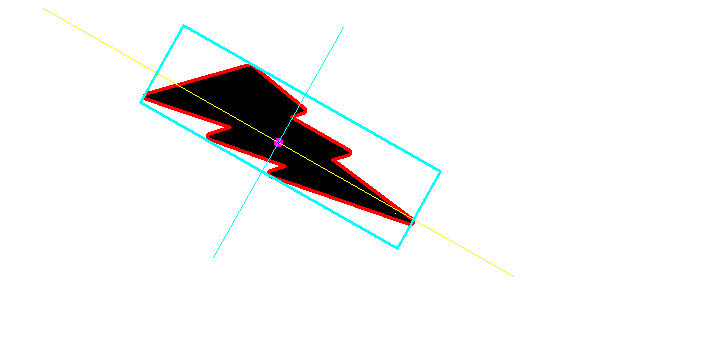

RotatedRect minRect = minAreaRect( Mat(contours[i]) );

Point2f rect_points[4];

minRect.points( rect_points );

for( int j = 0; j < 4; j++ )

line( img, rect_points[j], rect_points[(j+1)%4],Scalar(255,255,0),2);

}

imshow("img",img);

waitKey();

return 0;

}

// line( img, rect_points[j], rect_points[(j+1)%4],Scalar(0,0,255),2);

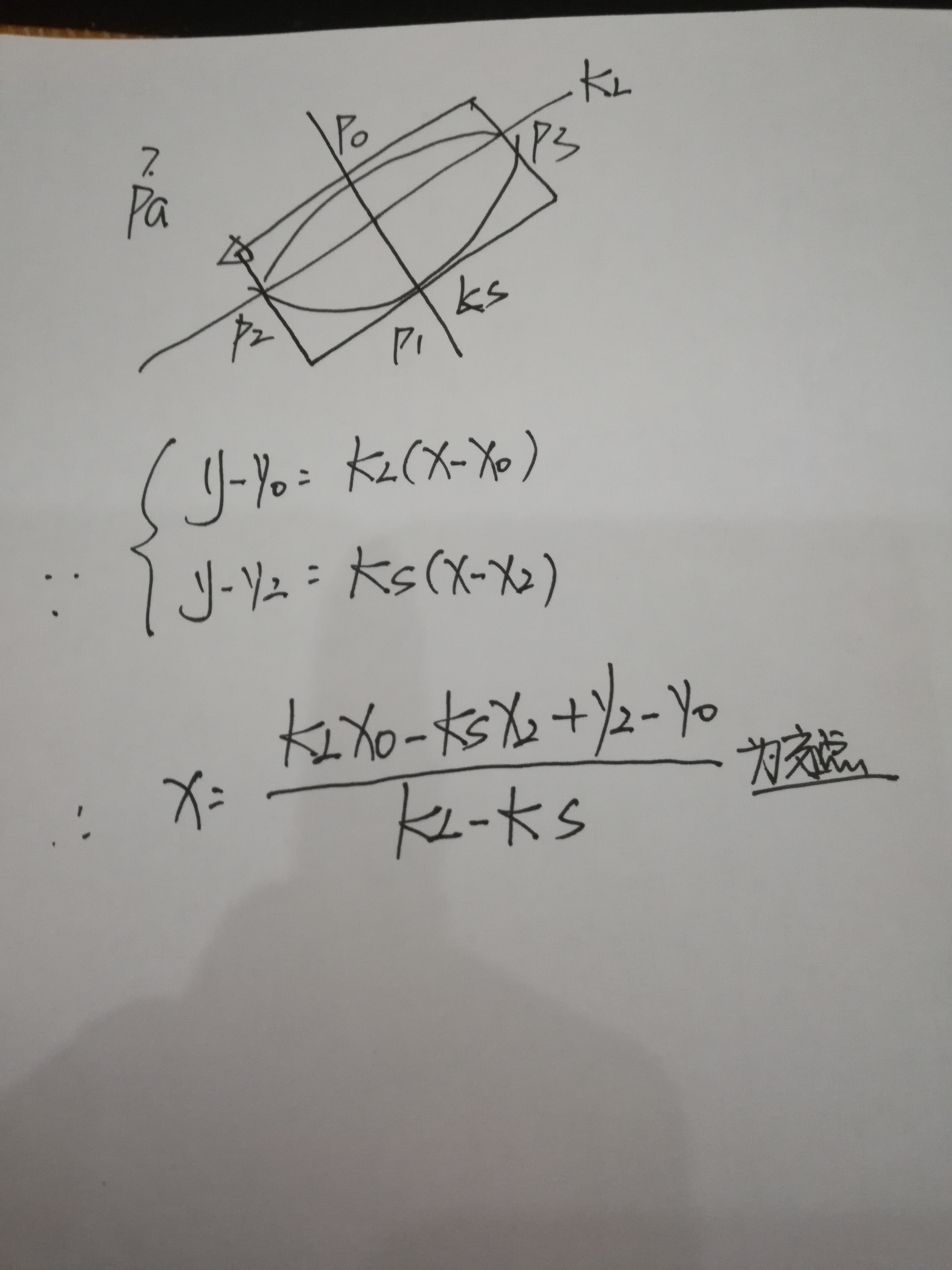

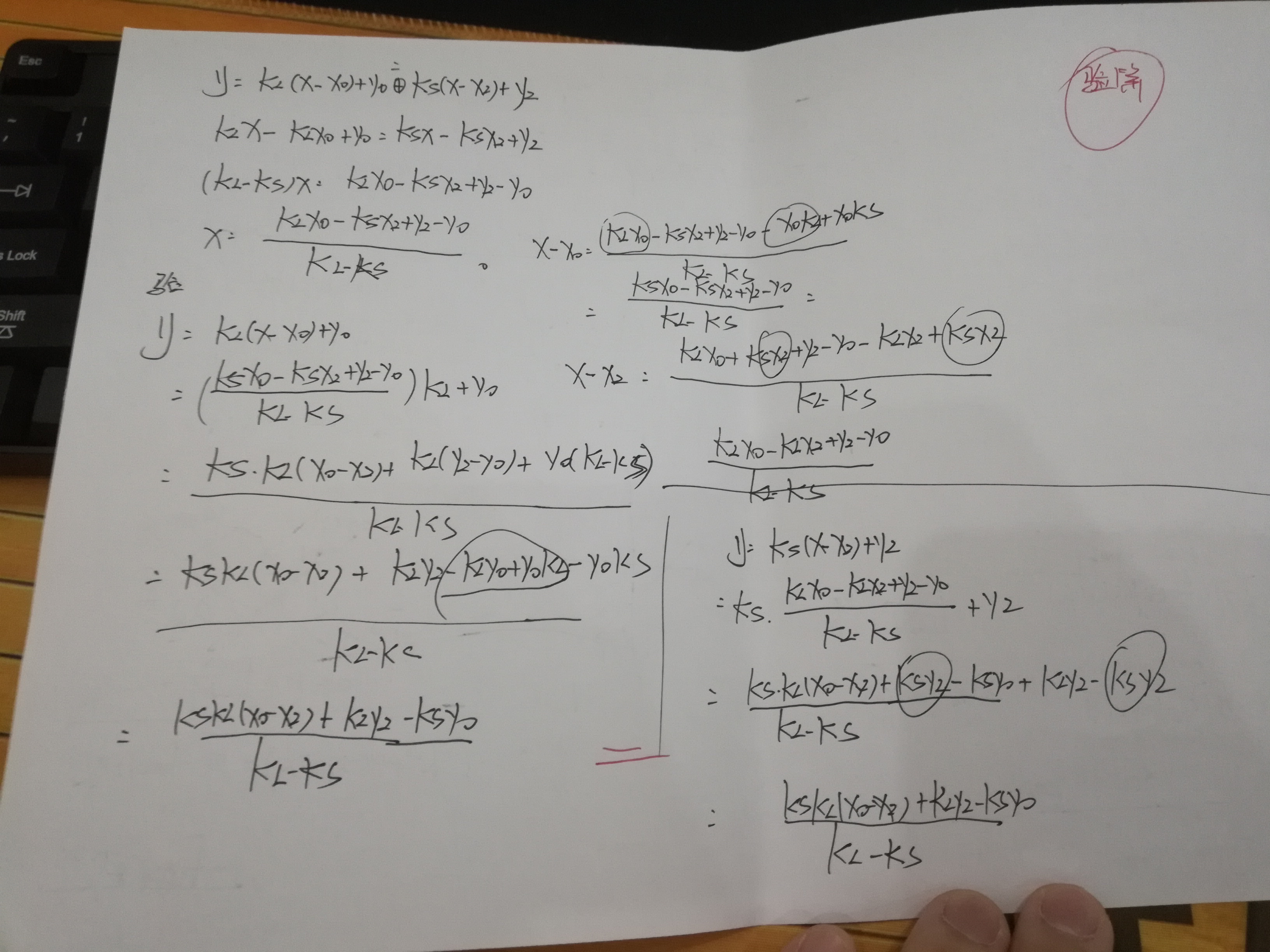

p[3].y = (p[3].x - _p[1].x)*k_long + _p[1].y;

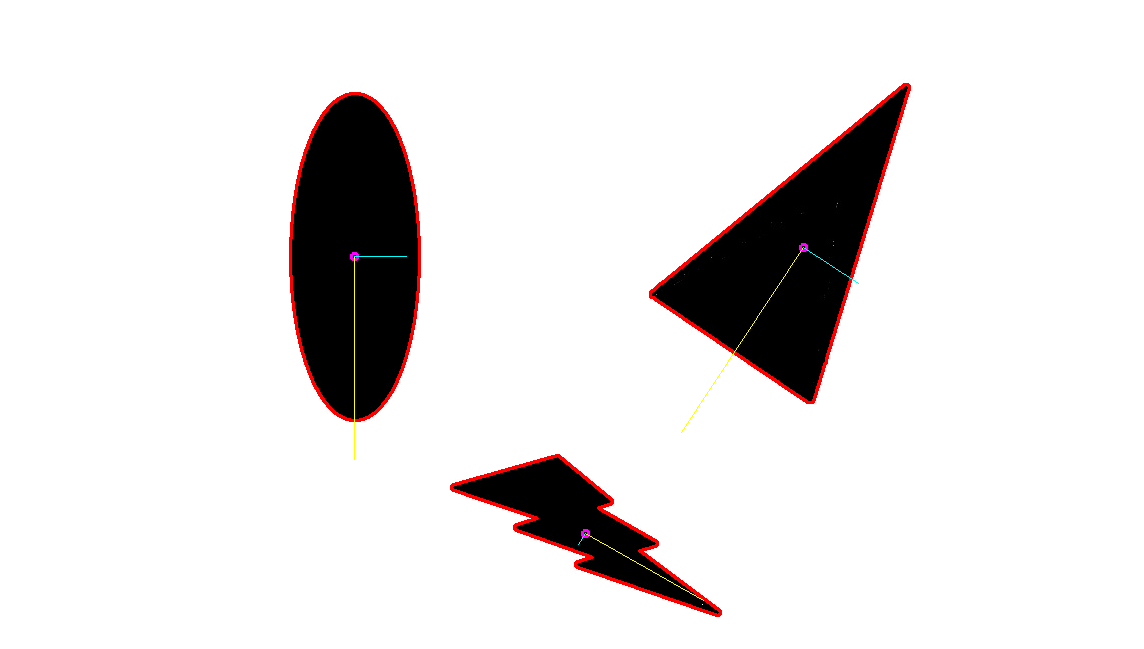

cv::RotatedRect cv::minAreaRect( InputArray _points )

{

CV_INSTRUMENT_REGION()

Mat hull;

Point2f out[3];

RotatedRect box;

convexHull(_points, hull, true, true);

if( hull.depth() != CV_32F )

{

Mat temp;

hull.convertTo(temp, CV_32F);

hull = temp;

}

int n = hull.checkVector(2);

const Point2f* hpoints = hull.ptr<Point2f>();

if( n > 2 )

{

rotatingCalipers( hpoints, n, CALIPERS_MINAREARECT, (float*)out );

box.center.x = out[0].x + (out[1].x + out[2].x)*0.5f;

box.center.y = out[0].y + (out[1].y + out[2].y)*0.5f;

box.size.width = (float)std::sqrt((double)out[1].x*out[1].x + (double)out[1].y*out[1].y);

box.size.height = (float)std::sqrt((double)out[2].x*out[2].x + (double)out[2].y*out[2].y);

box.angle = (float)atan2( (double)out[1].y, (double)out[1].x );

}

else if( n == 2 )

{

box.center.x = (hpoints[0].x + hpoints[1].x)*0.5f;

box.center.y = (hpoints[0].y + hpoints[1].y)*0.5f;

double dx = hpoints[1].x - hpoints[0].x;

double dy = hpoints[1].y - hpoints[0].y;

box.size.width = (float)std::sqrt(dx*dx + dy*dy);

box.size.height = 0;

box.angle = (float)atan2( dy, dx );

}

else

{

if( n == 1 )

box.center = hpoints[0];

}

box.angle = (float)(box.angle*180/CV_PI);

return box;

}

maybe:

- find principal axes of your shape (PCA)

- rotate to upright (warp)

- boundingRect() (image axis aligned)

附件列表

【4Opencv】如何识别出轮廓准确的长和宽的更多相关文章

- 机器学习进阶-项目实战-信用卡数字识别 1.cv2.findContour(找出轮廓) 2.cv2.boudingRect(轮廓外接矩阵位置) 3.cv2.threshold(图片二值化操作) 4.cv2.MORPH_TOPHAT(礼帽运算突出线条) 5.cv2.MORPH_CLOSE(闭运算图片内部膨胀) 6. cv2.resize(改变图像大小) 7.cv2.putText(在图片上放上文本)

7. cv2.putText(img, text, loc, text_font, font_scale, color, linestick) # 参数说明:img表示输入图片,text表示需要填写的 ...

- 【4opencv】识别复杂的答题卡1(主要算法)

一.问题提出 由于GPY进行了纠偏,所以在采集的时候,就已经获得了质量较高的答题卡图片 下一步就是需要从这张图片中,识别出人眼识别出来的那些信息,并且将这个过程尽可能地鲁棒化,提高识别的准确率. 二. ...

- android开发期间使用真机调试但系统无法识别出真机

前言 前些天重装了系统,好不容易把所有的软件装好,结果发现打开android studio真机调试却出了问题. 一.症状: 1.手机端设置完全没问题(打开了调试模式......) 2.电脑端右下角不出 ...

- GOCR.js – 使用 JS 识别出图片中的文本

GOCR.js 是 GOCR(开源的 OCR 光学识别程序)项目的纯 JavaScript 版本,使用 Emscripten 进行自动转换.这是一个简单的 OCR (光学字符识别)程序,可以扫描图像中 ...

- cas未能够识别出目标 ***;票根

使用cas做单点登录,在验证ticket的时候,报下面的错误: <cas:serviceResponse xmlns:cas='http://www.yale.edu/tp/cas'> & ...

- 人脸检测及识别python实现系列(2)——识别出人脸

人脸检测及识别python实现系列(2)——识别出人脸 http://www.cnblogs.com/neo-T/p/6430583.html

- 人脸检测及识别python实现系列(6)——终篇:从实时视频流识别出“我”

人脸检测及识别python实现系列(6)——终篇:从实时视频流识别出“我” 终于到了最后一步,激动时刻就要来临了,先平复一下心情,把剩下的代码加上,首先是为Model类增加一个预测函数: #识别人脸 ...

- Tesseract.js 一个几乎能识别出图片中所有语言的JS库

Tesseract.js 一个几乎能识别出图片中所有语言的JS库. 官网:http://tesseract.projectnaptha.com/ git:https://github.com/napt ...

- Java日期时间API系列39-----中文语句中的时间语义识别(time NLP 输入一句话,能识别出话里的时间)原理分析

NLP (Natural Language Processing) 是人工智能(AI)的一个子领域.自然语言是人类智慧的结晶,自然语言处理是人工智能中最为困难的问题之一(来自百度百科). 其中中文更是 ...

随机推荐

- Jmeter获取响应结果中参数出现的次数

在测试中,有时候会遇到要统计响应结果中某个参数出现了多少次,如果量级很大,一个一个数不太现实,下面讲一下实现自动打印出该参数出现的次数的方法. 例如我的响应信息为:{"ip":&q ...

- sqlmap常用技巧整理

言 通过在乌云网上出现的很多SQL注入漏洞,因此来总结一下,大致使用SQLMAP所遇到的参数. 基本结构 基本SQLMAP的使用方式就如下所示,使用参数式的方式,按需求添加. 12 sqlmap.py ...

- HDU 3306 Another kind of Fibonacci(矩阵+ll超时必须用int&输入必须取模&M必须是int类型)

Another kind of Fibonacci [题目链接]Another kind of Fibonacci [题目类型]矩阵+ll超时必须用int&输入必须取模&M必须是int ...

- python文件基础IO,OS

#!/usr/bin/python # -*- coding: UTF-8 -*- import os # 导入 Phone 包 #File 对象方法: file对象提供了操作文件的一系列方法. #O ...

- 019-JQuery(Ajax异步请求)

使用jquery完成异步操作 ->开发文档提供的异步API url:请求地址 type:请求方式,主要是get.post data:{}:请求的数据 dataType:返回值的类型,主要有xml ...

- jQuery显示隐藏

<!DOCTYPE html> <html> <head lang="en"> <meta charset="UTF-8&quo ...

- 【AngularJS】解决ng-if中的ng-model值无效的问题(转)

from:http://blog.csdn.net/u013451157/article/details/60866210 与其他指令一样,ng-if指令也会创建一个子级作用域,因此,如果在ng-if ...

- AngularJs ng-change事件/指令(转)

from:http://blog.csdn.net/u011127019/article/details/52564111 定义和用法 ng-change 指令用于告诉 AngularJS 在 HTM ...

- JDBC连接自定义sqlserver数据库实例名(多个实例)

java语言中,通过jdbc访问sqlserver2005(2008)数据库默认实例可以按常用的写法来写url连接.代码如下: <span style="font-size:12px; ...

- factory源码分析——component_registry和object_registry

registry类主要是为object和component提供一个轻量级的代理(lightweight proxy)来方便factory实现: registry class从uvm_object_wr ...