机器学习:python使用BP神经网络示例

1.简介(只是简单介绍下理论内容帮助理解下面的代码,如果自己写代码实现此理论不够)

1) BP神经网络是一种多层网络算法,其核心是反向传播误差,即: 使用梯度下降法(或其他算法),通过反向传播来不断调整网络的权值和阈值,使网络的误差平方和最小。

BP神经网络模型拓扑结构包括输入层(input)、隐藏层(hidden layer)和输出层(output layer),每层包含多个神经元。

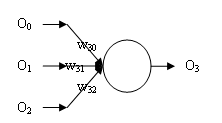

2)BP神经网络示例图

上图就是一个简单的三层BP神经网络。网络共有6个单元,O0用于表示阈值,O1、O2为输入层,O3、O4为第一隐层,也是唯一隐层,O5为输出层单元。网络接收两个输入 ,发送一个输出

,发送一个输出 。每个单元接收一组输入,发送一个输出。

。每个单元接收一组输入,发送一个输出。 为权值,例如W40 表示O0与O4之间的权重。

为权值,例如W40 表示O0与O4之间的权重。

3)神经单元(计算单元)

如上图所示,每个圆表示一个神经单元。其接收一组数据,经过计算输出一个数据。

4)传播过程

a)正向传递

例如:从O1-->O4-->05,这是正向传递过程中的一个路径(O4除了接收O1,还接收O0、O2的输入)。这里重点说下权重,W41表示O1和O4之间的权重,假如O1=1,O4=4,W41=0.5,那么O5=1*4*0.5=2(2不是最终输出,最终输出还需要加上O0、O2 的计算结果).

b)反向传递(过程比较复杂,这个表述不是特别精确,只是为了方便理解)

例如:从O1<--O4<--05,在这个过程中,O5是计算出的值,参与计算的O4的值不是其本身的值,而是在正向传递过程中计算出的值(即输出值)。而权重也是这个过程中调整的。

2.MLPClassifier函数

此函数是sklearn.neural_network中的函数,它是利用反向传播误差进行计算的多层感知器算法。

a) 主要参数

hidden_layer_sizes:隐藏层,例如:(5,2) 表示有2个隐藏层,第一隐藏层有5个神经单元,第二个隐藏层有2个神经单元;(5,2,4)表示有三个隐藏层。

activation:激活函数,在反向传递中需要用到。有以下四个可选项:

'identity':无激活操作,有助于实现线性瓶颈, 返回 f(x) = x

'logistic':逻辑函数, 返回 f(x) = 1 / (1 + exp(-x)).

'tanh': 双曲线函数, 返回 f(x) = tanh(x).

'relu': 矫正线性函数, 返回 f(x) = max(0, x),(默认)

solver:反向传播过程中采用的算法,有以下三个选项:

'lbfgs': 准牛顿算法.适用于较小数据集

'sgd': 随机梯度下降算法.

'adam':优化的随机梯度下降算法(默认)。适用于较大数据集

alpha:L2惩罚系数

learning_rate:学习速率,有以下几个选项:(只有当slver='sgd'时有用)

constant:参数learning_rate_init指定的恒定学习速率.(默认选项)

invscaling’:使用“scale_t”的反向缩放指数逐渐降低每个时间步长t 的学习率。effective_learning_rate = learning_rate_init / pow(t,power_t)(power_t是另外一个参数)

adaptive: 自适应,只要损失不断下降就是用learning_rate_init。否则会自动调整(由另外一个参数tol决定)。

learning_rate_init:初始学习速率

b)属性

coefs_:权重列表

n_layers_:神经网络的总层数

3.示例一

本示例使用的数据:机器学习:从编程的角度去理解逻辑回归 。在下面的参数情况下正确率95%。

import numpy as np

import os

import pandas as pd

from sklearn.neural_network import MLPClassifier def loadDataSet():

##运行脚本所在目录

base_dir=os.getcwd()

##记得添加header=None,否则会把第一行当作头

data=pd.read_table(base_dir+r"\lr.txt",header=None)

##dataLen行dataWid列 :返回值是dataLen=100 dataWid=3

dataLen,dataWid = data.shape

##训练数据集

xList = []

##标签数据集

lables = []

##读取数据

for i in range(dataLen):

row = data.values[i]

xList.append(row[0:dataWid-1])

lables.append(row[-1])

return xList,lables def GetResult():

dataMat,labelMat=loadDataSet()

clf = MLPClassifier(solver='lbfgs', alpha=1e-5,

hidden_layer_sizes=(5,2), random_state=1)

clf.fit(dataMat, labelMat)

#print("层数----------------------")

#print(clf.n_layers_)

#print("权重----------------------")

#for cf in clf.coefs_:

# print(cf)

#print("预测值----------------------")

y_pred=clf.predict(dataMat)

m = len(y_pred)

##分错4个

t = 0

f = 0

for i in range(m):

if y_pred[i] ==labelMat[i]:

t += 1

else :

f += 1

print("正确:"+str(t))

print("错误:"+str(f)) if __name__=='__main__':

GetResult()

4.示例二(数据来源)

这次使用的数据还是红酒。因为红酒的口感得分是整数,所以也可以当作是分类。但是针对此实验数据,在多次调整参数的过程中(主要是调整隐藏层)正确率最高只有61%。这正是BP神经网络的一个缺陷:隐含层的选取缺乏理论的指导。

代码:

import numpy as np

import os

import pandas as pd

from sklearn.neural_network import MLPClassifier ##运行脚本所在目录

base_dir=os.getcwd()

##记得添加header=None,否则会把第一行当作头

data=pd.read_table(base_dir+r"\wine.txt",header=None,sep=';')

##dataLen行dataWid列 :返回值是dataLen=1599 dataWid=12

dataLen,dataWid = data.shape ##训练数据集

xList = []

##标签数据集

lables = []

##读取数据

for i in range(dataLen):

row = data.values[i]

xList.append(row[0:dataWid-1])

lables.append(row[-1])

##设置训练函数

clf = MLPClassifier(solver='lbfgs', alpha=1e-5,

hidden_layer_sizes=(14,14,30), random_state=1)

##开始训练数据

clf.fit(xList, lables)

##读取预测值

y_pred=clf.predict(xList)

m = len(y_pred) t = 0

f = 0

##预测结果分析

for i in range(m):

if int(y_pred[i]) == lables[i]:

t += 1

else :

f += 1

print("正确:"+str(t))

print("错误:"+str(f))

5.BP神经网络的缺点

1)容易形成局部极小值而得不到全局最优值。BP神经网络中极小值比较多,所以很容易陷入局部极小值,这就要求对初始权值和阀值有要求,要使得初始权值和阀值随机性足够好,可以多次随机来实现。

2)训练次数多使得学习效率低,收敛速度慢。

3)隐含层的选取缺乏理论的指导。

4)训练时学习新样本有遗忘旧样本的趋势。(可以把最优的权重记录下来)

机器学习:python使用BP神经网络示例的更多相关文章

- python对BP神经网络实现

python对BP神经网络实现 一.概念理解 开始之前首先了解一下BP神经网络,BP的英文是back propagationd的意思,它是一种按误差反向传播(简称误差反传)训练的多层前馈网络,其算法称 ...

- Python实现bp神经网络识别MNIST数据集

title: "Python实现bp神经网络识别MNIST数据集" date: 2018-06-18T14:01:49+08:00 tags: [""] cat ...

- python构建bp神经网络_曲线拟合(一个隐藏层)__2.代码实现

IDE:jupyter 抽象程度可能不是那么高,以后再优化. 理论和代码实现的差距还是挺大的 数据集请查看 python构建bp神经网络(一个隐藏层)__1.数据可视化 部分代码预览 git上传.ip ...

- 用Python实现BP神经网络(附代码)

用Python实现出来的机器学习算法都是什么样子呢? 前两期线性回归及逻辑回归项目已发布(见文末链接),今天来讲讲BP神经网络. BP神经网络 全部代码 https://github.com/lawl ...

- 08机器学习实战之BP神经网络

1. 背景: 1.1 以人脑中的神经网络为启发,历史上出现过很多不同版本 1.2 最著名的算法是1980年的 backpropagation 2. 多层向前神经网络(Multil ...

- python构建bp神经网络_曲线拟合(一个隐藏层)__1.可视化数据

1.将数据写入csv文件,应该可以python代码直接实现数据集的写入,但我对文件读取这块不太熟练,等我成功了再加上,这里我直接手写将数据集写入Excel 2.然后把后缀改成.csv就可以了,利用pa ...

- python构建bp神经网络_鸢尾花分类(一个隐藏层)__2.代码实现

IDE:jupyter 数据集请查看:鸢尾花数据集 测试效果预览 成功率96.7% 代码已上传到码云

- python构建bp神经网络_鸢尾花分类(一个隐藏层)__1.数据集

IDE:jupyter 目前我知道的数据集来源有两个,一个是csv数据集文件另一个是从sklearn.datasets导入 1.1 csv格式的数据集(下载地址已上传到博客园----数据集.rar) ...

- BP神经网络与Python实现

人工神经网络是一种经典的机器学习模型,随着深度学习的发展神经网络模型日益完善. 联想大家熟悉的回归问题, 神经网络模型实际上是根据训练样本创造出一个多维输入多维输出的函数, 并使用该函数进行预测, 网 ...

随机推荐

- 深度学习中 --- 解决过拟合问题(dropout, batchnormalization)

过拟合,在Tom M.Mitchell的<Machine Learning>中是如何定义的:给定一个假设空间H,一个假设h属于H,如果存在其他的假设h’属于H,使得在训练样例上h的错误率比 ...

- Jquery 事件冒泡、元素的默认行为的阻止、获取事件类型、触发事件

$(function(){// 事件冒泡 $('').bind("click",function(event){ //事件内容 //停止事件冒泡 event.stopPropaga ...

- C/C++的内存泄漏检测工具Valgrind memcheck的使用经历

Linux下的Valgrind真是利器啊(不知道Valgrind的请自觉查看参考文献(1)(2)),帮我找出了不少C++中的内存管理错误,前一阵子还在纠结为什么VS 2013下运行良好的程序到了Lin ...

- [转]ubuntu ssh登陆显示系统信息

Welcome to Ubuntu LTS (GNU/Linux --generic i686) * Documentation: https://help.ubuntu.com/ System in ...

- 微信小程序开发UI组件

第一 view和input和button组件 1.UI组件的通用属性 (1)id 唯一标识 (2)class 设置组件的样式类 (3)style 设置组件的内联样式 (4)hidden ...

- Bash Game 巴什博弈

巴什博弈(Bash Game,同余理论):只有一堆n个物品,两个人轮流从这堆物品中取物,规定每次至少取一个,最多取m个.最后取光者得胜. 显然,如果n=m+1,那么由于一次最多只能取m个,所以,无论先 ...

- BroadcastReceiver 接收系统短信广播

BroadcastReceiver 接收系统短信广播 /* 注册广播: * |--静态注册 (在AndroidManifest .xml 中注册) * <receiver androi ...

- SharePoint 2013 pre-config

#region 1. add winrm, application server and web server role Add-WindowsFeature winrm-iis-ext, Appli ...

- bzoj4817/luogu3703 树点涂色 (LCT+dfs序+线段树)

我们发现,这个染色的操作他就很像LCT中access的操作(为什么??),然后就自然而然地想到,其实一个某条路径上的颜色数量,就是我们做一个只有access操作的LCT,这条路径经过的splay的数量 ...

- pyEcharts

例子: from pyecharts import Line line = Line("我的第一个图表", "这里是副标题",width="800px ...