利用Pycharm本地调试spark-streaming(包含kafka和zookeeper等操作)

环境准备就不说了!

第一步:打开Pycharm,在File->Setting->Project Structure中点击Add Content Root 添加本地python调用java和spark的组件(因为python和spark通讯是通过调用Jvm的相关组件实现的) ,包含两个压缩包可以在spark的安装包里面找到

第二步:在项目文件内添加本地配置

os.environ['SPARK_HOME'] = r'C:\Users\fengxu\Desktop\bigdata-software\spark-1.6.0-bin-hadoop2.6'

os.environ['JAVA_HOME'] = r'C:\software\jdk1.8'

sys.path.append(r"C:\Users\fengxu\Desktop\bigdata-software\spark-1.6.0-bin-hadoop2.6\python") 第三步:也是最重要的一步需要在本地的spark安装包内找到spark-defaults.conf的配置文件在末尾添加一行

spark.jars.packages org.apache.spark:spark-streaming-kafka-0-8_2.10:2.0.1

这是本地操作kafka和一些组件的必备jar包。配置完毕以后就可以在maven仓库下载相关jar包了

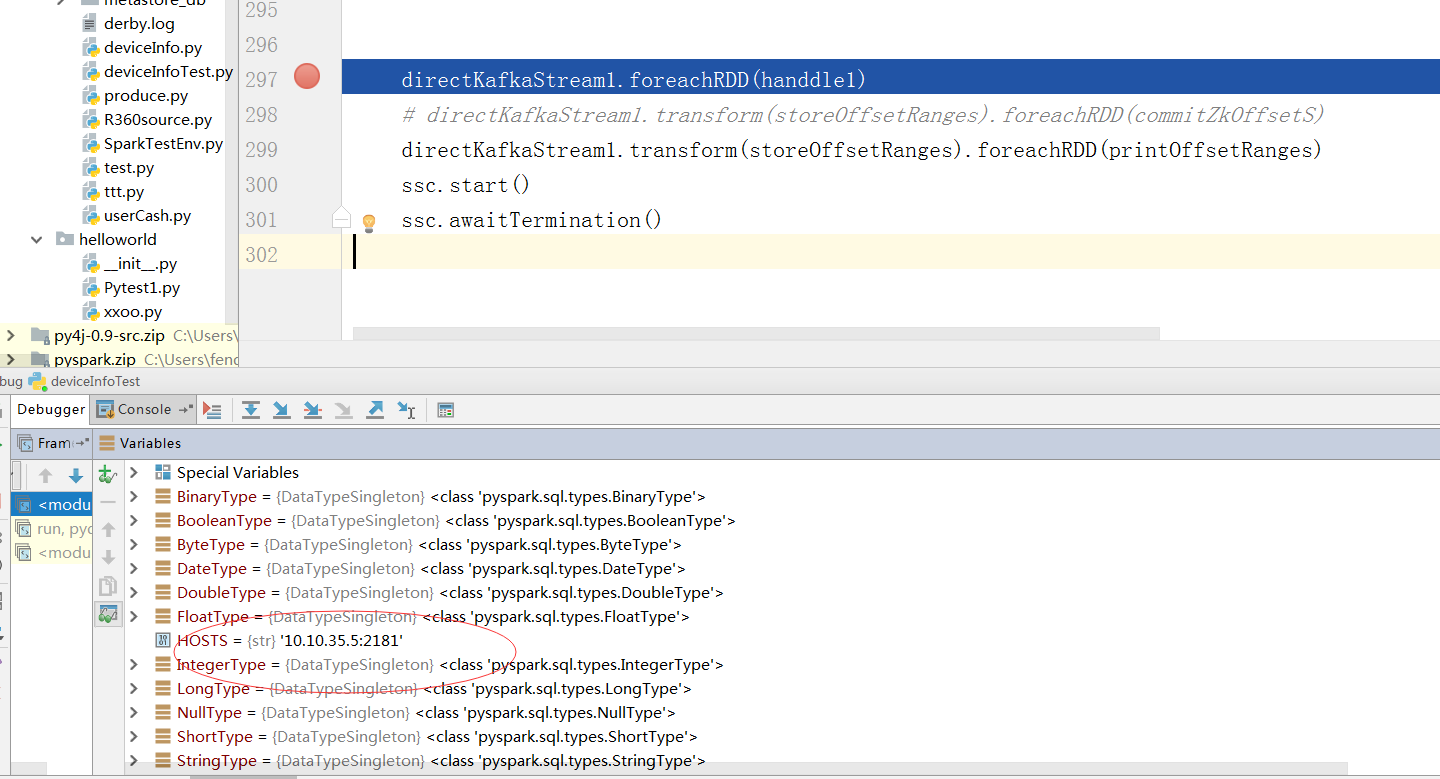

(报了很多错误,查阅了很多英文文档才找到答案,国内没有找到相关问题答案) 成功后就可以利用本地的python和本地相关组件(spark,kafka hdfs)调试和操作远程组件了!

成功后会在本地环境生成(多线程模拟集群)写入的hdfs文件可以调试了,操作本地文件还是很有用的哈!

利用Pycharm本地调试spark-streaming(包含kafka和zookeeper等操作)的更多相关文章

- Spark streaming消费Kafka的正确姿势

前言 在游戏项目中,需要对每天千万级的游戏评论信息进行词频统计,在生产者一端,我们将数据按照每天的拉取时间存入了Kafka当中,而在消费者一端,我们利用了spark streaming从kafka中不 ...

- Spark学习之路(十六)—— Spark Streaming 整合 Kafka

一.版本说明 Spark针对Kafka的不同版本,提供了两套整合方案:spark-streaming-kafka-0-8和spark-streaming-kafka-0-10,其主要区别如下: s ...

- Spark 系列(十六)—— Spark Streaming 整合 Kafka

一.版本说明 Spark 针对 Kafka 的不同版本,提供了两套整合方案:spark-streaming-kafka-0-8 和 spark-streaming-kafka-0-10,其主要区别如下 ...

- Spark Streaming和Kafka整合保证数据零丢失

当我们正确地部署好Spark Streaming,我们就可以使用Spark Streaming提供的零数据丢失机制.为了体验这个关键的特性,你需要满足以下几个先决条件: 1.输入的数据来自可靠的数据源 ...

- spark streaming 整合kafka(二)

转载:https://www.iteblog.com/archives/1326.html 和基于Receiver接收数据不一样,这种方式定期地从Kafka的topic+partition中查询最新的 ...

- Spark Streaming之四:Spark Streaming 与 Kafka 集成分析

前言 Spark Streaming 诞生于2013年,成为Spark平台上流式处理的解决方案,同时也给大家提供除Storm 以外的另一个选择.这篇内容主要介绍Spark Streaming 数据接收 ...

- Spark Streaming和Kafka整合是如何保证数据零丢失

转载:https://www.iteblog.com/archives/1591.html 当我们正确地部署好Spark Streaming,我们就可以使用Spark Streaming提供的零数据丢 ...

- spark streaming 对接kafka记录

spark streaming 对接kafka 有两种方式: 参考: http://group.jobbole.com/15559/ http://blog.csdn.net/kwu_ganymede ...

- Spark Streaming、Kafka结合Spark JDBC External DataSouces处理案例

场景:使用Spark Streaming接收Kafka发送过来的数据与关系型数据库中的表进行相关的查询操作: Kafka发送过来的数据格式为:id.name.cityId,分隔符为tab zhangs ...

随机推荐

- 学习Ajax

1.XHR对象 IE7+.Firefox.Opera.Chrome和Safari都支持原生XMLHttpRequest对象,IE6不支持,只支持ActiveXObject对象,该对象在IE11中已经不 ...

- [解读REST] 1.REST的起源

0. 世界上第一个网站 1990年12月20日,这一天对于现在的互联网来说意义非凡.欧洲核子研究组织(CREN)的科学家Tim Berners-Lee在一台NeXT电脑上启动了世界上的第一个网站(当然 ...

- ABAP 动态内表 动态ALV

DATA: DY_TABLE TYPE REF TO DATA, DY_WA TYPE REF TO DATA. FIELD-SYMBOLS: <DYN_TABLE> TYPE TABLE ...

- 《阿里巴巴Java开发规约》插件使用介绍

一.简介 阿里巴巴于10月14日在杭州云栖大会上,正式发布了<阿里巴巴Java开发规约>扫描插件!该插件基于<阿里巴巴Java开发规约>手册内容,在扫描代码后,将不符合规约的代 ...

- 即时通信系统Openfire分析之八:集群管理

前言 在第六章<路由表>中,客户端进行会话时,首先要获取对方的Session实例.获取Session实例的方法,是先查找本地路由表,若找不到,则通过路由表中的缓存数据,由定位器获取. 路由 ...

- Python 中的装饰器

说到装饰器是我们每个学Python人中的心痛. 装饰器作用:是用来装饰其他函数的,为其他函数添加新功能. 原则:1.不能改变被修饰函数的源代码. 2.不能修改被修饰函数的调用方式. 学装饰器前还需要了 ...

- 记一次vscode升级后,格式化Vue出现的问题

一.VSCode中使用vetur插件格式化vue文件时,stylus代码会自动加上大括号.冒号和分号 本来就是简写比较方便舒服,结果一个格式化回到十年前 解决方案: vscode 文件 ->首 ...

- VMware Tools安装方法及共享文件夹设置方法

正确安装好VMware Tools后,可以实现主机与虚拟机之间的文件共享, 可以设置共享文件夹,以及在主机与虚拟机之间直接进行复制黏贴的操作. 安装方法: 选择"虚拟机"-> ...

- C#实现局域网内远程开机

1.远程开机原理 远程开机Wake on LAN(WOL),俗称远程唤醒,远程唤醒的实现主要是向目标主机发送特殊格式的数据包,是AMD公司制作的MagicPacket这套软件以生成网络唤醒所需要的特殊 ...

- 企业微信开发之向员工付款(C#)

一.企业微信API 地址:http://work.weixin.qq.com/api/doc#11545 二.参数说明 1.向员工付款 请求方式:POST(HTTPS)请求地址:https://api ...