Python分布式爬虫必学框架Scrapy打造搜索引擎

Python分布式爬虫必学框架Scrapy打造搜索引擎

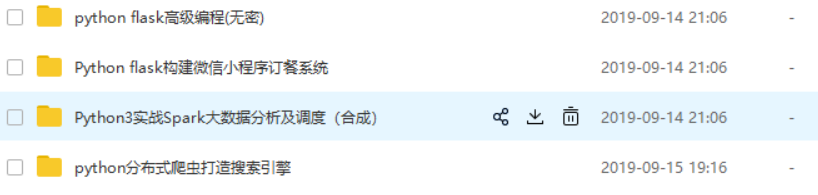

部分课程截图:

点击链接或搜索QQ号直接加群获取其它资料:

链接: https://pan.baidu.com/s/1-wHr4dTAxfd51Mj9DxiJ4Q

https://pan.baidu.com/s/1-wHr4dTAxfd51Mj9DxiJ4Q

提取码:ik1n

免费分享,如若链接失效请加群

其它资源在群里,私聊管理员即可免费领取;群——517432778,点击加群,或扫描二维码

第1章 课程介绍

介绍课程目标、通过课程能学习到的内容、和系统开发前需要具备的知识

- 1-1 python分布式爬虫打造搜索引擎简介试看

第2章 windows下搭建开发环境

介绍项目开发需要安装的开发软件、 python虚拟virtualenv和 virtualenvwrapper的安装和使用、 最后介绍pycharm和navicat的简单使用

- 2-1 pycharm的安装和简单使用

- 2-2 mysql和navicat的安装和使用

- 2-3 windows和linux下安装python2和python3

- 2-4 虚拟环境的安装和配置

第3章 爬虫基础知识回顾

介绍爬虫开发中需要用到的基础知识包括爬虫能做什么,正则表达式,深度优先和广度优先的算法及实现、爬虫url去重的策略、彻底弄清楚unicode和utf8编码的区别和应用。

- 3-1 技术选型 爬虫能做什么

- 3-2 正则表达式-1

- 3-3 正则表达式-2

- 3-4 正则表达式-3

- 3-5 深度优先和广度优先原理

- 3-6 url去重方法

- 3-7 彻底搞清楚unicode和utf8编码

第4章 scrapy爬取知名技术文章网站

搭建scrapy的开发环境,本章介绍scrapy的常用命令以及工程目录结构分析,本章中也会详细的讲解xpath和css选择器的使用。然后通过scrapy提供的spider完成所有文章的爬取。然后详细讲解item以及item loader方式完成具体字段的提取后使用scrapy提供的pipeline分别将数据保存到json文件以及mysql数据库中。...

- 4-1 关于文章网站不能访问的解决办法(本章学习之前的注意事项)

- 4-2 scrapy安装以及目录结构介绍

- 4-3 pycharm 调试scrapy 执行流程

- 4-4 xpath的用法 - 1

- 4-5 xpath的用法 - 2

- 4-6 xpath的用法 - 3

- 4-7 css选择器实现字段解析 - 1

- 4-8 css选择器实现字段解析 - 2

- 4-9 编写spider爬取jobbole的所有文章 - 1

- 4-10 编写spider爬取jobbole的所有文章 - 2

- 4-11 items设计 - 1

- 4-12 items设计 - 2

- 4-13 items设计 - 3

- 4-14 数据表设计和保存item到json文件

- 4-15 通过pipeline保存数据到mysql - 1

- 4-16 通过pipeline保存数据到mysql - 2

- 4-17 scrapy item loader机制 - 1

- 4-18 scrapy item loader机制- 2

第5章 scrapy爬取知名问答网站

本章主要完成网站的问题和回答的提取。本章除了分析出问答网站的网络请求以外还会分别通过requests和scrapy的FormRequest两种方式完成网站的模拟登录, 本章详细的分析了网站的网络请求并分别分析出了网站问题回答的api请求接口并将数据提取出来后保存到mysql中。...

- 5-1 session和cookie自动登录机制试看

- 5-2 . selenium模拟登录知乎 - 1new

- 5-3 . selenium模拟登录知乎-2new

- 5-4 . selenium模拟登录知乎-3new

- 5-5 . 知乎倒立文字识别 new

- 5-6 . selenium自动识别验证码完成模拟登录-1new

- 5-7 . selenium自动识别验证码完成模拟登录 - 2 new

- 5-8 requests模拟登陆知乎 - 1(可选观看)

- 5-9 requests模拟登陆知乎 - 2(可选观看)

- 5-10 requests模拟登陆知乎 - 3(可选观看)

- 5-11 scrapy模拟知乎登录(可选观看)

- 5-12 知乎分析以及数据表设计1

- 5-13 知乎分析以及数据表设计 - 2

- 5-14 item loder方式提取question - 1

- 5-15 item loder方式提取question - 2

- 5-16 item loder方式提取question - 3

- 5-17 知乎spider爬虫逻辑的实现以及answer的提取 - 1

- 5-18 知乎spider爬虫逻辑的实现以及answer的提取 - 2

- 5-19 保存数据到mysql中 -1

- 5-20 保存数据到mysql中 -2

- 5-21 保存数据到mysql中 -3

第6章 通过CrawlSpider对招聘网站进行整站爬取

本章完成招聘网站职位的数据表结构设计,并通过link extractor和rule的形式并配置CrawlSpider完成招聘网站所有职位的爬取,本章也会从源码的角度来分析CrawlSpider让大家对CrawlSpider有深入的理解。

- 6-1 数据表结构设计

- 6-2 CrawlSpider源码分析-新建CrawlSpider与settings配置

- 6-3 CrawlSpider源码分析

- 6-4 Rule和LinkExtractor使用

- 6-5 拉勾网302之后的模拟登录和cookie传递(网站需要登录时学习本视频教程)

- 6-6 item loader方式解析职位

- 6-7 职位数据入库-1

- 6-8 职位信息入库-2

第7章 Scrapy突破反爬虫的限制

本章会从爬虫和反爬虫的斗争过程开始讲解,然后讲解scrapy的原理,然后通过随机切换user-agent和设置scrapy的ip代理的方式完成突破反爬虫的各种限制。本章也会详细介绍httpresponse和httprequest来详细的分析scrapy的功能,最后会通过云打码平台来完成在线验证码识别以及禁用cookie和访问频率来降低爬虫被屏蔽的可能性。...

- 7-1 爬虫和反爬的对抗过程以及策略试看

- 7-2 scrapy架构源码分析

- 7-3 Requests和Response介绍

- 7-4 通过downloadmiddleware随机更换user-agent-1

- 7-5 通过downloadmiddleware随机更换user-agent - 2

- 7-6 scrapy实现ip代理池 - 1

- 7-7 scrapy实现ip代理池 - 2

- 7-8 scrapy实现ip代理池 - 3

- 7-9 云打码实现验证码识别

- 7-10 cookie禁用、自动限速、自定义spider的settings

第8章 scrapy进阶开发

本章将讲解scrapy的更多高级特性,这些高级特性包括通过selenium和phantomjs实现动态网站数据的爬取以及将这二者集成到scrapy中、scrapy信号、自定义中间件、暂停和启动scrapy爬虫、scrapy的核心api、scrapy的telnet、scrapy的web service和scrapy的log配置和email发送等。 这些特性使得我们不仅只是可以通过scrapy来完成...

- 8-1 selenium动态网页请求与模拟登录知乎

- 8-2 selenium模拟登录微博, 模拟鼠标下拉

- 8-3 chromedriver不加载图片、phantomjs获取动态网页

- 8-4 selenium集成到scrapy中

- 8-5 其余动态网页获取技术介绍-chrome无界面运行、scrapy-splash、selenium-grid, splinter

- 8-6 scrapy的暂停与重启

- 8-7 scrapy url去重原理

- 8-8 scrapy telnet服务

- 8-9 spider middleware 详解

- 8-10 scrapy的数据收集

- 8-11 scrapy信号详解

- 8-12 scrapy扩展开发

第9章 scrapy-redis分布式爬虫

Scrapy-redis分布式爬虫的使用以及scrapy-redis的分布式爬虫的源码分析, 让大家可以根据自己的需求来修改源码以满足自己的需求。最后也会讲解如何将bloomfilter集成到scrapy-redis中。

- 9-1 分布式爬虫要点

- 9-2 redis基础知识 - 1

- 9-3 redis基础知识 - 2

- 9-4 scrapy-redis编写分布式爬虫代码

- 9-5 scrapy源码解析-connection.py、defaults.py-

- 9-6 scrapy-redis源码剖析-dupefilter.py-

- 9-7 scrapy-redis源码剖析- pipelines.py、 queue.py-

- 9-8 scrapy-redis源码分析- scheduler.py、spider.py-

- 9-9 集成bloomfilter到scrapy-redis中

第10章 elasticsearch搜索引擎的使用

本章将讲解elasticsearch的安装和使用,将讲解elasticsearch的基本概念的介绍以及api的使用。本章也会讲解搜索引擎的原理并讲解elasticsearch-dsl的使用,最后讲解如何通过scrapy的pipeline将数据保存到elasticsearch中。

- 10-1 elasticsearch介绍

- 10-2 elasticsearch安装

- 10-3 elasticsearch-head插件以及kibana的安装

- 10-4 elasticsearch的基本概念

- 10-5 倒排索引

- 10-6 elasticsearch 基本的索引和文档CRUD操作

- 10-7 elasticsearch的mget和bulk批量操作

- 10-8 elasticsearch的mapping映射管理

- 10-9 elasticsearch的简单查询 - 1

- 10-10 elasticsearch的简单查询 - 2

- 10-11 elasticsearch的bool组合查询

- 10-12 scrapy写入数据到elasticsearch中 - 1

- 10-13 scrapy写入数据到elasticsearch中 - 2

第11章 django搭建搜索网站

本章讲解如何通过django快速搭建搜索网站, 本章也会讲解如何完成django与elasticsearch的搜索查询交互。

- 11-1 es完成搜索建议-搜索建议字段保存 - 1

- 11-2 es完成搜索建议-搜索建议字段保存 - 2

- 11-3 django实现elasticsearch的搜索建议 - 1

- 11-4 django实现elasticsearch的搜索建议 - 2

- 11-5 django实现elasticsearch的搜索功能 -1

- 11-6 django实现elasticsearch的搜索功能 -2

- 11-7 django实现搜索结果分页

- 11-8 搜索记录、热门搜索功能实现 - 1

- 11-9 搜索记录、热门搜索功能实现 - 2

第12章 scrapyd部署scrapy爬虫

本章主要通过scrapyd完成对scrapy爬虫的线上部署。

- 12-1 scrapyd部署scrapy项目

Python分布式爬虫必学框架Scrapy打造搜索引擎的更多相关文章

- Python分布式爬虫必学框架Scrapy打造搜索引擎 ✌✌

Python分布式爬虫必学框架Scrapy打造搜索引擎 ✌✌ (一个人学习或许会很枯燥,但是寻找更多志同道合的朋友一起,学习将会变得更加有意义✌✌) 第1章 课程介绍 介绍课程目标.通过课程能学习到 ...

- Python分布式爬虫必学框架scrapy打造搜索引擎✍✍✍

Python分布式爬虫必学框架scrapy打造搜索引擎 整个课程都看完了,这个课程的分享可以往下看,下面有链接,之前做java开发也做了一些年头,也分享下自己看这个视频的感受,单论单个知识点课程本身 ...

- Python分布式爬虫必学框架Scrapy打造搜索引擎 学习教程

Python分布式爬虫打造搜索引擎Scrapy精讲—用Django实现搜索的自动补全功能 elasticsearch(搜索引擎)提供了自动补全接口 1.创建搜索自动补全字段suggest自动补全需要用 ...

- 聚焦Python分布式爬虫必学框架Scrapy 打造搜索引擎视频教程

下载链接:https://www.yinxiangit.com/595.html 目录: 第1章 课程介绍介绍课程目标.通过课程能学习到的内容.和系统开发前需要具备的知识 第2章 windows下搭建 ...

- 第三百四十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—通过downloadmiddleware中间件全局随机更换user-agent浏览器用户代理

第三百四十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—通过downloadmiddleware随机更换user-agent浏览器用户代理 downloadmiddleware介绍中间件是 ...

- 第三百四十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—通过自定义中间件全局随机更换代理IP

第三百四十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—通过自定义中间件全局随机更换代理IP 设置代理ip只需要,自定义一个中间件,重写process_request方法, request ...

- 第三百四十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—爬虫数据保存

第三百四十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—爬虫数据保存 注意:数据保存的操作都是在pipelines.py文件里操作的 将数据保存为json文件 spider是一个信号检测 ...

- Python分布式爬虫打造搜索引擎完整版-基于Scrapy、Redis、elasticsearch和django打造一个完整的搜索引擎网站

Python分布式爬虫打造搜索引擎 基于Scrapy.Redis.elasticsearch和django打造一个完整的搜索引擎网站 https://github.com/mtianyan/Artic ...

- 第三百七十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapyd部署scrapy项目

第三百七十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapyd部署scrapy项目 scrapyd模块是专门用于部署scrapy项目的,可以部署和管理scrapy项目 下载地址:h ...

随机推荐

- 算法与数据结构基础 - 字典树(Trie)

Trie基础 Trie字典树又叫前缀树(prefix tree),用以较快速地进行单词或前缀查询,Trie节点结构如下: //208. Implement Trie (Prefix Tree)clas ...

- Java——字符串

1.不可变的String String对象是不可变的.String类中的每一个看起来会修改String值的方法,实际上都是创建了一个全新的String对象,以包含修改修改后的字符串内容. public ...

- WPF中TimeSpan的坑

记一次在WPF中,在将格式为“DD.HH:mm:ss”字符串转换成TimeSpan时遇到的坑 如果字符串为:DD.HH:mm:ss,转换结果正确.例如: var currentValue = &quo ...

- 康托(Cantor)展开

直接进入正题. 康托展开 Description 现在有"ABCDEFGHIJ”10个字符,将其所有的排列中按字典序排列,给出任意一种排列,说出这个排列在所有的排列中是第几小的? Input ...

- unsqueeze 和 squeeze

squeeze压缩的意思 就是在第几维为1 去掉 unsqueeze 解缩 在第几维增加 变成*1 squeeze用法 c = b.view(1, 1, 1, 2, 3) c.squeeze(0) # ...

- JSP引擎、JSP容器、Web服务器

JSP引擎与JSP容器指的都是同一样的东西,他们都是用来同一管理和运行Web引用程序的“软件”.常见的JSP引擎有Tomcat.JRun.Resin 广义上来说,JSP引擎是用来管理和运行Web应用程 ...

- pyinstaller打包django项目成exe以及遇到的一些问题

1. 环境 环境为:win7 + Python3.6 + Django (2.1.10) + PyInstaller (3.5) 注意: 这里的PyInstaller,笔者是直接使用pip安装,中间会 ...

- 通知神器——java调用钉钉群自定义机器人

创建群自定义机器人 在指定钉钉群(或者随便拉两个人建个群,然后把别人T出去)的群设置里选择 群机器人 -> 自定义,如图: 然后,添加机器人,设置名字,添加成功时如下图: 其中webhook非常 ...

- Go组件学习——database/sql数据库连接池你用对了吗

1.案例 case1: maxOpenConns > 1 func fewConns() { db, _ := db.Open("mysql", "root:roo ...

- Java和Tomcat安装教程

jdk安装与配置1.下载好对应的jdk2.安装JDK 直接运行exe可执行程序,默认安装即可:备注:路径可以选其他盘符,路径要全部为英文. 3.配置环境变量 新建变量名:JAVA_HOME,变量值:D ...