RocketMQ 升级到主从切换(DLedger、多副本)实战

本文主要介绍如何将 RocketMQ 集群从原先的主从同步升级到主从切换。

首先先介绍与 DLedger 多副本即 RocketMQ 主从切换相关的核心配置属性,然后尝试搭建一个主从同步集群,再从原先的 RocketMQ 集群平滑升级到 DLedger 集群的示例,并简单测试一下主从切换功能。

@

1、RocketMQ DLedger 多副本即主从切换核心配置参数详解

其主要的配置参数如下所示:

- enableDLegerCommitLog

是否启用 DLedger,即是否启用 RocketMQ 主从切换,默认值为 false。如果需要开启主从切换,则该值需要设置为 true 。 - dLegerGroup

节点所属的 raft 组,建议与 brokerName 保持一致,例如 broker-a。 - dLegerPeers

集群节点信息,示例配置如下:n0-127.0.0.1:40911;n1-127.0.0.1:40912;n2-127.0.0.1:40913,多个节点用英文冒号隔开,单个条目遵循 legerSlefId-ip:端口,这里的端口用作 dledger 内部通信。 - dLegerSelfId

当前节点id。取自 legerPeers 中条目的开头,即上述示例中的 n0,并且特别需要强调,只能第一个字符为英文,其他字符需要配置成数字。 - storePathRootDir

DLedger 日志文件的存储根目录,为了能够支持平滑升级,该值与 storePathCommitLog 设置为不同的目录。

2、搭建主从同步环境

首先先搭建一个传统意义上的主从同步架构,往集群中灌一定量的数据,然后升级到 DLedger 集群。

在 Linux 服务器上搭建一个 rocketmq 主从同步集群我想不是一件很难的事情,故本文就不会详细介绍按照过程,只贴出相关配置。

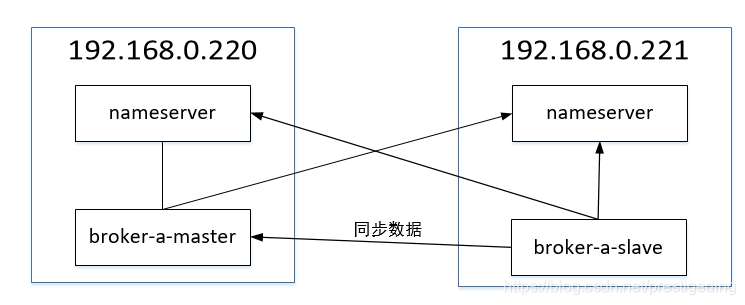

实验环境的部署结构采取 一主一次,其部署图如下:

下面我就重点贴一下 broker 的配置文件。

220 上的 broker 配置文件如下:

brokerClusterName = DefaultCluster

brokerName = broker-a

brokerId = 0

deleteWhen = 04

fileReservedTime = 48

brokerRole = ASYNC_MASTER

flushDiskType = ASYNC_FLUSH

brokerIP1=192.168.0.220

brokerIP2=192.168.0.220

namesrvAddr=192.168.0.221:9876;192.168.0.220:9876

storePathRootDir=/opt/application/rocketmq-all-4.5.2-bin-release/store

storePathCommitLog=/opt/application/rocketmq-all-4.5.2-bin-release/store/commitlog

autoCreateTopicEnable=false

autoCreateSubscriptionGroup=false

221 上 broker 的配置文件如下:

brokerClusterName = DefaultCluster

brokerName = broker-a

brokerId = 1

deleteWhen = 04

fileReservedTime = 48

brokerRole = SLAVE

flushDiskType = ASYNC_FLUSH

brokerIP1=192.168.0.221

brokerIP2=192.168.0.221

namesrvAddr=192.168.0.221:9876;192.168.0.220:9876

storePathRootDir=/opt/application/rocketmq-all-4.5.2-bin-release/store

storePathCommitLog=/opt/application/rocketmq-all-4.5.2-bin-release/store/commitlog

autoCreateTopicEnable=false

autoCreateSubscriptionGroup=false

相关的启动命令如下:

nohup bin/mqnamesrv /dev/null 2>&1 &

nohup bin/mqbroker -c conf/broker.conf /dev/null 2>&1 &

安装后的集群信息如图所示:

3、主从同步集群升级到DLedger

3.1 部署架构

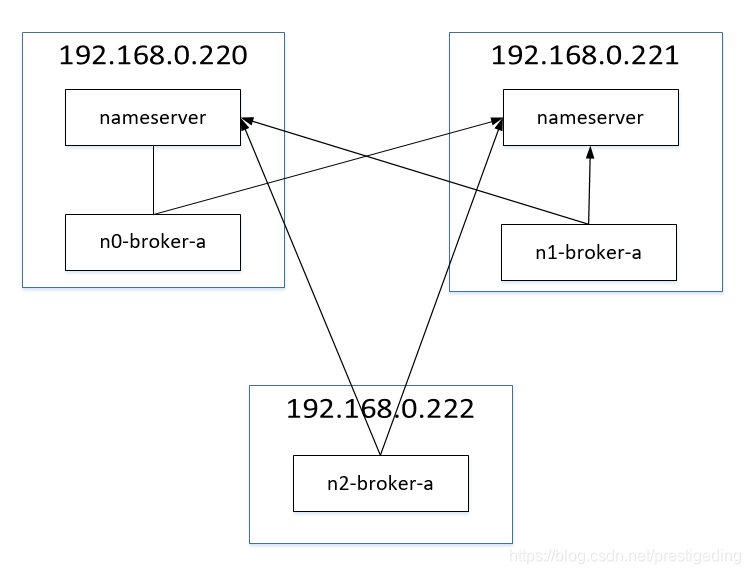

DLedger 集群至少需要3台机器,故搭建 DLedger 还需要再引入一台机器,其部署结构图如下:

从主从同步集群升级到 DLedger 集群,用户最关心的还是升级后的集群是否能够兼容原先的数据,即原先存储在消息能否能被消息消费者消费端,甚至于能否查询到。

为了方便后续验证,首先我使用下述程序向 mq 集群中添加了一篇方便查询的消息(设置消息的key)。

public class Producer {

public static void main(String[] args) throws MQClientException, InterruptedException {

DefaultMQProducer producer = new DefaultMQProducer("producer_dw_test");

producer.setNamesrvAddr("192.168.0.220:9876;192.168.0.221:9876");

producer.start();

for(int i =600000; i < 600100; i ++) {

try {

Message msg = new Message("topic_dw_test_by_order_01",null , "m" + i,("Hello RocketMQ" + i ).getBytes(RemotingHelper.DEFAULT_CHARSET));

SendResult sendResult = producer.send(msg);

//System.out.printf("%s%n", sendResult);

} catch (Exception e) {

e.printStackTrace();

Thread.sleep(1000);

}

}

producer.shutdown();

System.out.println("end");

}

}

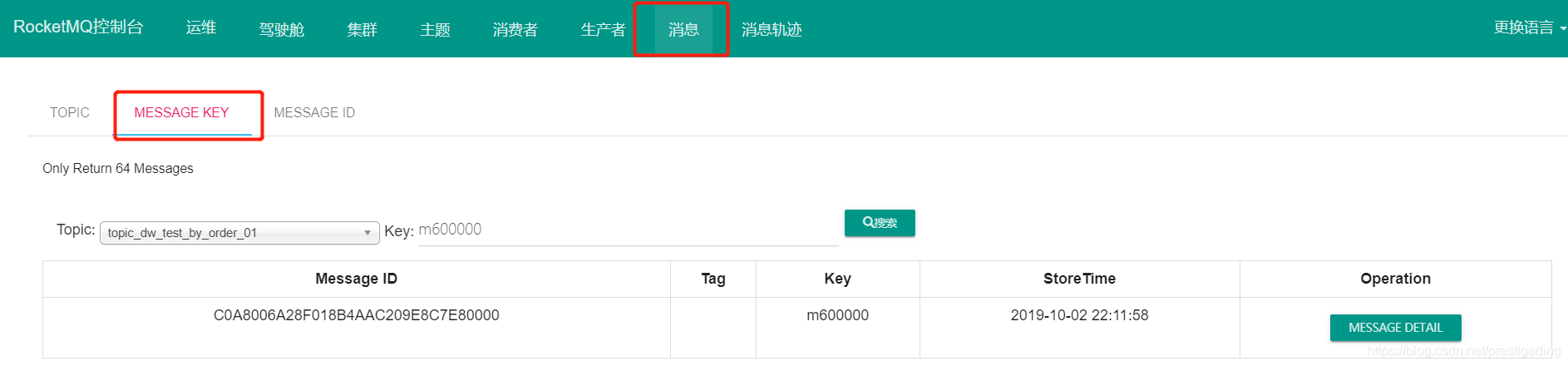

消息的查询结果示例如下:

3.2 升级步骤

Step1:将 192.168.0.220 的 rocketmq 拷贝到 192.168.0.222,可以使用如下命令进行操作。在 192.168.0.220 上敲如下命令:

scp -r rocketmq-all-4.5.2-bin-release/ root@192.168.0.222:/opt/application/rocketmq-all-4.5.2-bin-release

温馨提示:示例中由于版本是一样,实际过程中,版本需要升级,故需先下载最新的版本,然后将老集群中的 store 目录完整的拷贝到新集群的 store 目录。

Step2:依次在三台服务器的 broker.conf 配置文件中添加与 dledger 相关的配置属性。

192.168.0.220 broker配置文件如下:

brokerClusterName = DefaultCluster

brokerId = 0

deleteWhen = 04

fileReservedTime = 48

brokerRole = ASYNC_MASTER

flushDiskType = ASYNC_FLUSH

brokerIP1=192.168.0.220

brokerIP2=192.168.0.220

namesrvAddr=192.168.0.221:9876;192.168.0.220:9876

storePathRootDir=/opt/application/rocketmq-all-4.5.2-bin-release/store

storePathCommitLog=/opt/application/rocketmq-all-4.5.2-bin-release/store/commitlog

autoCreateTopicEnable=false

autoCreateSubscriptionGroup=false

# 与 dledger 相关的属性

enableDLegerCommitLog=true

storePathRootDir=/opt/application/rocketmq-all-4.5.2-bin-release/store/dledger_store

dLegerGroup=broker-a

dLegerPeers=n0-192.168.0.220:40911;n1-192.168.0.221:40911;n2-192.168.0.222:40911

dLegerSelfId=n0

192.168.0.221 broker配置文件如下:

brokerClusterName = DefaultCluster

brokerName = broker-a

brokerId = 1

deleteWhen = 04

fileReservedTime = 48

brokerRole = SLAVE

flushDiskType = ASYNC_FLUSH

brokerIP1=192.168.0.221

brokerIP2=192.168.0.221

namesrvAddr=192.168.0.221:9876;192.168.0.220:9876

storePathRootDir=/opt/application/rocketmq-all-4.5.2-bin-release/store

storePathCommitLog=/opt/application/rocketmq-all-4.5.2-bin-release/store/commitlog

autoCreateTopicEnable=false

autoCreateSubscriptionGroup=false

# 与dledger 相关的配置属性

enableDLegerCommitLog=true

storePathRootDir=/opt/application/rocketmq-all-4.5.2-bin-release/store/dledger_store

dLegerGroup=broker-a

dLegerPeers=n0-192.168.0.220:40911;n1-192.168.0.221:40911;n2-192.168.0.222:40911

dLegerSelfId=n1

192.168.0.222 broker配置文件如下:

brokerClusterName = DefaultCluster

brokerName = broker-a

brokerId = 0

deleteWhen = 04

fileReservedTime = 48

brokerRole = ASYNC_MASTER

flushDiskType = ASYNC_FLUSH

brokerIP1=192.168.0.222

brokerIP2=192.168.0.222

namesrvAddr=192.168.0.221:9876;192.168.0.220:9876

storePathRootDir=/opt/application/rocketmq-all-4.5.2-bin-release/store

storePathCommitLog=/opt/application/rocketmq-all-4.5.2-bin-release/store/commitlog

autoCreateTopicEnable=false

autoCreateSubscriptionGroup=false

# 与 dledger 相关的配置

enableDLegerCommitLog=true

storePathRootDir=/opt/application/rocketmq-all-4.5.2-bin-release/store/dledger_store

dLegerGroup=broker-a

dLegerPeers=n0-192.168.0.220:40911;n1-192.168.0.221:40911;n2-192.168.0.222:40911

dLegerSelfId=n2

温馨提示:legerSelfId 分别为 n0、n1、n2。在真实的生产环境中,broker配置文件中的 storePathRootDir、storePathCommitLog 尽量使用单独的根目录,这样判断其磁盘使用率时才不会相互影响。

Step3:将 store/config 下的 所有文件拷贝到 dledger store 的 congfig 目录下。

cd /opt/application/rocketmq-all-4.5.2-bin-release/store/

cp config/* dledger_store/config/

温馨提示:该步骤按照各自按照时配置的目录进行复制即可。

Step4:依次启动三台 broker。

nohup bin/mqbroker -c conf/broker.conf /dev/null 2>&1 &

如果启动成功,则在 rocketmq-console 中看到的集群信息如下:

3.3 验证消息发送与消息查找

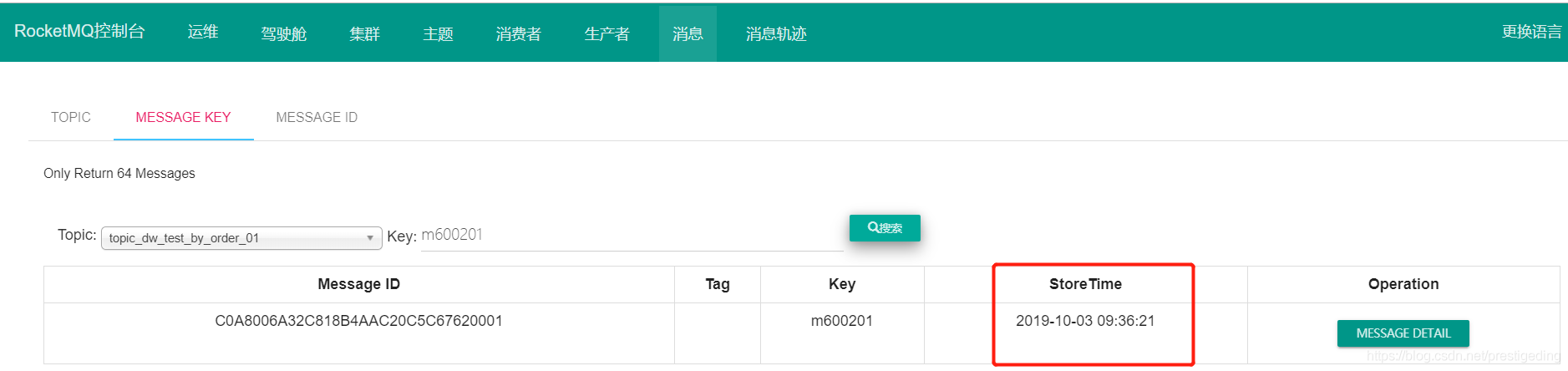

首先我们先验证升级之前的消息是否能查询到,那我们还是查找key 为 m600000 的消息,查找结果如图所示:

然后我们来测试一下消息发送。测试代码如下:

public class Producer {

public static void main(String[] args) throws MQClientException, InterruptedException {

DefaultMQProducer producer = new DefaultMQProducer("producer_dw_test");

producer.setNamesrvAddr("192.168.0.220:9876;192.168.0.221:9876");

producer.start();

for(int i =600200; i < 600300; i ++) {

try {

Message msg = new Message("topic_dw_test_by_order_01",null , "m" + i,("Hello RocketMQ" + i ).getBytes(RemotingHelper.DEFAULT_CHARSET));

SendResult sendResult = producer.send(msg);

System.out.printf("%s%n", sendResult);

} catch (Exception e) {

e.printStackTrace();

Thread.sleep(1000);

}

}

producer.shutdown();

System.out.println("end");

}

}

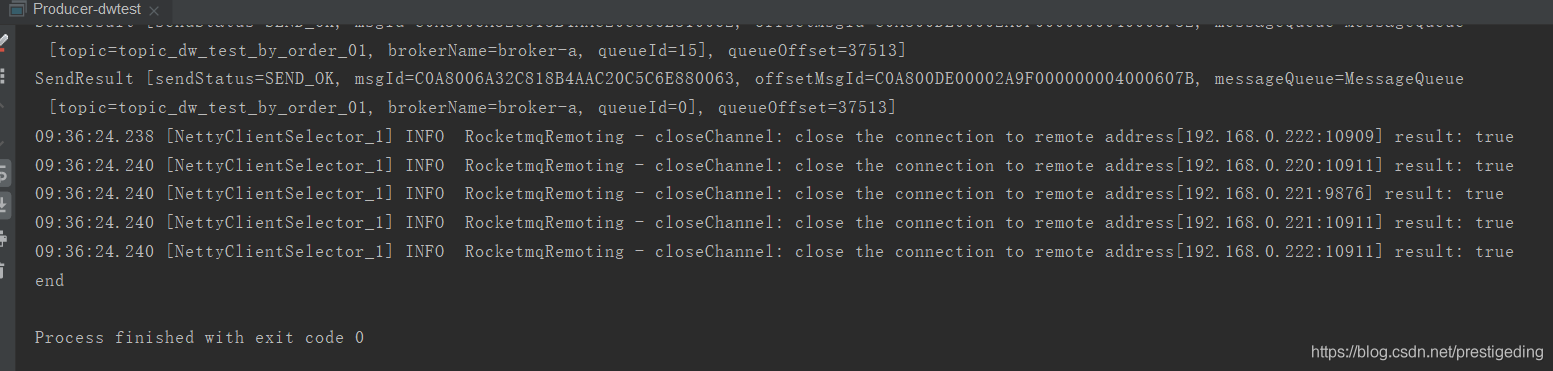

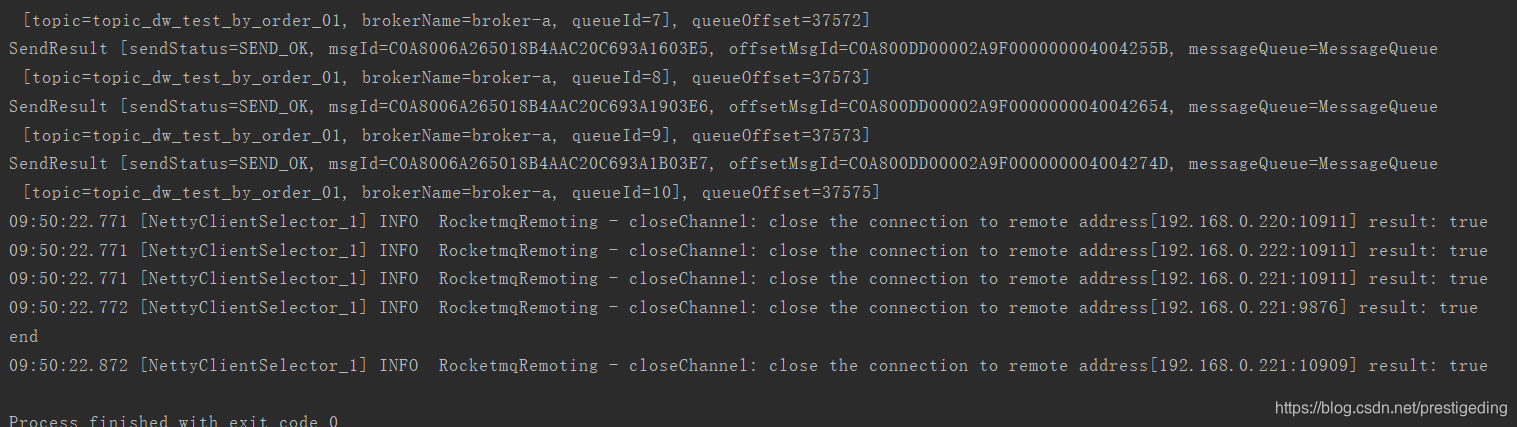

执行结果如下:

再去控制台查询一下消息,其结果也表明新的消息也能查询到。

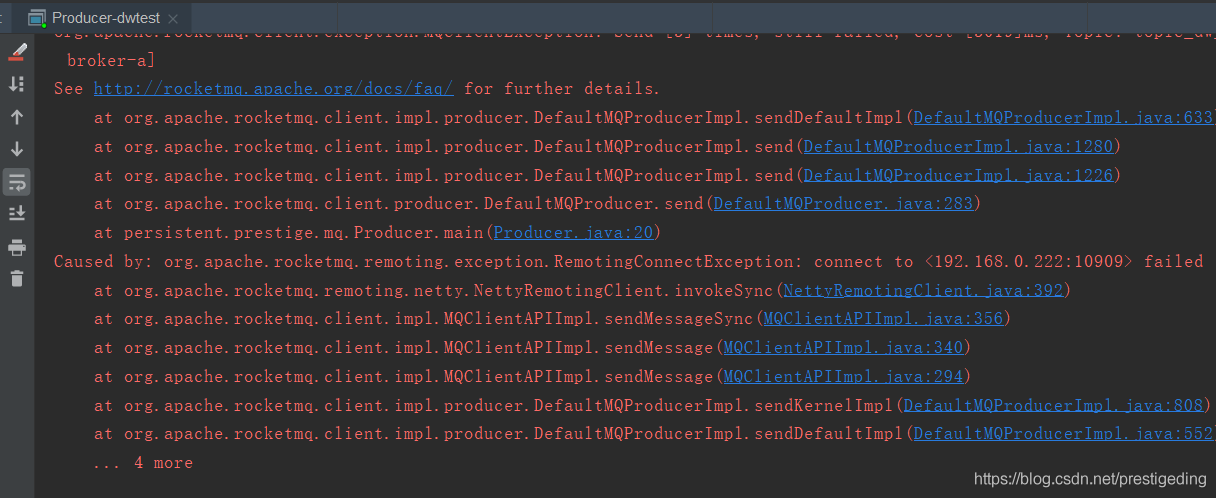

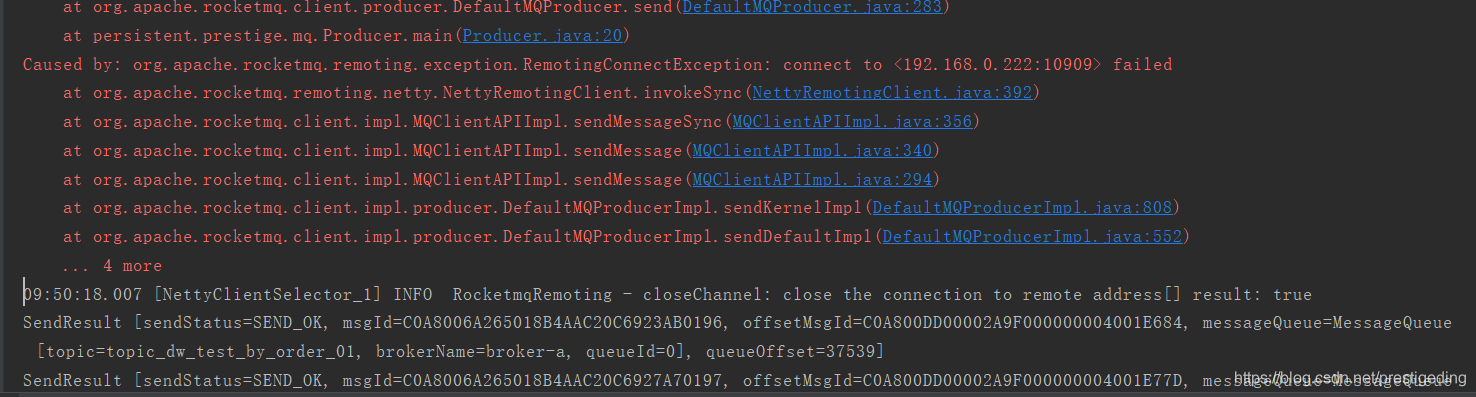

最后我们再来验证一下主节点宕机,消息发送是否会受影响。

在消息发送的过程中,去关闭主节点,其截图如下:

再来看一下集群的状态:

再来看一下集群的状态:

等待该复制组重新完成主服务器选举后,即可继续处理消息发送。

温馨提示:由于本示例是一主一从,故在选举期间,消息不可用,但在真实的生产环境上,其部署架构是多主主从,即一个复制组在 leader 选举期间,其他复制组可以接替该复制组完成消息的发送,实现消息服务的高可用。

与 DLedger 相关的日志,默认存储在 broker_default.log 文件中。

本文就介绍到这里了,如果觉得文章对您有帮助的话,还希望帮忙点个赞,谢谢。

推荐阅读:源码分析 RocketMQ DLedger 多副本即主从切换系列文章:

1、RocketMQ 多副本前置篇:初探raft协议

2、源码分析 RocketMQ DLedger 多副本之 Leader 选主

3、源码分析 RocketMQ DLedger 多副本存储实现

4、源码分析 RocketMQ DLedger(多副本) 之日志追加流程

5、源码分析 RocketMQ DLedger(多副本) 之日志复制(传播)

6、基于 raft 协议的 RocketMQ DLedger 多副本日志复制设计原理

7、RocketMQ 整合 DLedger(多副本)即主从切换实现平滑升级的设计技巧

8、源码分析 RocketMQ DLedger 多副本即主从切换实现原理

作者介绍:丁威,《RocketMQ技术内幕》作者,RocketMQ 社区布道师,公众号:中间件兴趣圈 维护者,目前已陆续发表源码分析Java集合、Java 并发包(JUC)、Netty、Mycat、Dubbo、RocketMQ、Mybatis等源码专栏。可以点击链接加入中间件知识星球 ,一起探讨高并发、分布式服务架构,交流源码。

RocketMQ 升级到主从切换(DLedger、多副本)实战的更多相关文章

- RocketMQ 整合 DLedger(多副本)即主从切换实现平滑升级的设计技巧

目录 1.阅读源码之前的思考 2.从 Broker 启动流程看 DLedger 2.1 构建 DefaultMessageStore 2.2 增加节点状态变更事件监听器 2.3 调用 DefaultM ...

- 源码分析 RocketMQ DLedger 多副本之 Leader 选主

目录 1.DLedger关于选主的核心类图 1.1 DLedgerConfig 1.2 MemberState 1.3 raft协议相关 1.4 DLedgerRpcService 1.5 DLedg ...

- 源码分析 RocketMQ DLedger(多副本) 之日志复制(传播)

目录 1.DLedgerEntryPusher 1.1 核心类图 1.2 构造方法 1.3 startup 2.EntryDispatcher 详解 2.1 核心类图 2.2 Push 请求类型 2. ...

- 基于 raft 协议的 RocketMQ DLedger 多副本日志复制设计原理

目录 1.RocketMQ DLedger 多副本日志复制流程图 1.1 RocketMQ DLedger 日志转发(append) 请求流程图 1.2 RocketMQ DLedger 日志仲裁流程 ...

- mongodb主从备份 和 手动主从切换

环境: 主机A:172.16.160.91 主机B:172.16.160.92 配置主机A [root@master zhxf]# cat docker-compose.yml version: '3 ...

- RocketMQ(九):主从同步的实现

分布式系统的三大理论CAP就不说了,但是作为分布式消息系统的rocketmq, 主从功能是最最基础的了.也许该功能现在已经不是很常用了,但是对于我们理解一些分布式系统的常用工作原理还是有些积极意义的. ...

- Sentinel-Redis高可用方案(二):主从切换

Redis 2.8版开始正式提供名为Sentinel的主从切换方案,Sentinel用于管理多个Redis服务器实例,主要负责三个方面的任务: 1. 监控(Monitoring): Senti ...

- Mycat读写分离、主从切换、分库分表的操作记录

系统开发中,数据库是非常重要的一个点.除了程序的本身的优化,如:SQL语句优化.代码优化,数据库的处理本身优化也是非常重要的.主从.热备.分表分库等都是系统发展迟早会遇到的技术问题问题.Mycat是一 ...

- Redis哨兵模式(sentinel)学习总结及部署记录(主从复制、读写分离、主从切换)

Redis的集群方案大致有三种:1)redis cluster集群方案:2)master/slave主从方案:3)哨兵模式来进行主从替换以及故障恢复. 一.sentinel哨兵模式介绍Sentinel ...

随机推荐

- let和const总结(ES6)

文章目录 let const 1. let要好好用 1. 基本用法 2. let声明的变量不存在变量提升 3. TDZ(temporal dead zone)暂时性死区 4. 不允许重复声明 2. 块 ...

- 【重大更新】AppWizard来了,emWin6.10版本来了

说明: 1.快圣诞节了,MDK和SEGGER都太生猛了,发布了大量软件更新,而且都是比较大的改进,待我周报再给大家分享. 2.不枉我这么多年对emWin的支持,官方也用心,终于带来AppWizard, ...

- JMeter多脚本间的启动延时

JMeter做压测时,当需要多个jmx脚本依次执行时,需要用到“启动延时”,即间隔可设置的时间后启动运行下一个jmx脚本. 实现“启动延时”的方法有2个. 方法一.利用JMeter线程组中的" ...

- Android组件体系之Service解析

一.调用方式 1.启动服务 只启动一个服务,不进行通信,包括startService.startForegroundService两种调用方式.第二种方式适用于后台应用启动前台服务,在启动 ...

- IT兄弟连 HTML5教程 “无意义”的HTML元素div和span

HTML只是赋予内容的手段,大部分HTML标签都有其意义(例如,标签a创建链接,标签h1创建标题等),然而div和span标签似乎没有任何内容上的意义,听起来就像一个泡沫做成的锤子一样无用.但实际上, ...

- 【nagios监控】基于linux搭建nagios监控

nagios工作原理 nagios的功能是监控服务和主机,但是其自身并不包括这些功能,所有的监控.检测功能都是通过各种插件来完成的. 启动nagios后,它会周期性的自动调用插件去检测服务器状态,同时 ...

- UWP 利用VisualTreeHelper查找页面中的元素

一般我们在展示数据的时候,都会采用DataTemplate的预先设置数据模板,再使用Set ItemsSource的方式进行数据绑定 这样就能满足大部分的需求. 不过有时候需要对页面已经展示出来的元素 ...

- 解决bcp导出CSV文件没有表头

思路: 1.输出表头文件到指定目录 2.bcp导出csv文件到temp目录 3.将以上导出文件与表头文件合并 4.删除temp目录下的文件 实现: create proc exportCSV ( @i ...

- Git实战指南----跟着haibiscuit学Git(第三篇)

笔名: haibiscuit 博客园: https://www.cnblogs.com/haibiscuit/ Git地址: https://github.com/haibiscuit?tab=re ...

- 好的js书写习惯

1:单一判断 bad if (result) { console.log("秋叶"); } if (!result) { console.log("秋叶"); ...