Spark学习之路(十)—— Spark SQL 外部数据源

一、简介

1.1 多数据源支持

Spark支持以下六个核心数据源,同时Spark社区还提供了多达上百种数据源的读取方式,能够满足绝大部分使用场景。

- CSV

- JSON

- Parquet

- ORC

- JDBC/ODBC connections

- Plain-text files

注:以下所有测试文件均可从本仓库的resources目录进行下载

1.2 读数据格式

所有读取API遵循以下调用格式:

// 格式

DataFrameReader.format(...).option("key", "value").schema(...).load()

// 示例

spark.read.format("csv")

.option("mode", "FAILFAST") // 读取模式

.option("inferSchema", "true") // 是否自动推断schema

.option("path", "path/to/file(s)") // 文件路径

.schema(someSchema) // 使用预定义的schema

.load()

读取模式有以下三种可选项:

| 读模式 | 描述 |

|---|---|

permissive |

当遇到损坏的记录时,将其所有字段设置为null,并将所有损坏的记录放在名为_corruption t_record的字符串列中 |

dropMalformed |

删除格式不正确的行 |

failFast |

遇到格式不正确的数据时立即失败 |

1.3 写数据格式

// 格式

DataFrameWriter.format(...).option(...).partitionBy(...).bucketBy(...).sortBy(...).save()

//示例

dataframe.write.format("csv")

.option("mode", "OVERWRITE") //写模式

.option("dateFormat", "yyyy-MM-dd") //日期格式

.option("path", "path/to/file(s)")

.save()

写数据模式有以下四种可选项:

| Scala/Java | 描述 |

|---|---|

SaveMode.ErrorIfExists |

如果给定的路径已经存在文件,则抛出异常,这是写数据默认的模式 |

SaveMode.Append |

数据以追加的方式写入 |

SaveMode.Overwrite |

数据以覆盖的方式写入 |

SaveMode.Ignore |

如果给定的路径已经存在文件,则不做任何操作 |

二、CSV

CSV是一种常见的文本文件格式,其中每一行表示一条记录,记录中的每个字段用逗号分隔。

2.1 读取CSV文件

自动推断类型读取读取示例:

spark.read.format("csv")

.option("header", "false") // 文件中的第一行是否为列的名称

.option("mode", "FAILFAST") // 是否快速失败

.option("inferSchema", "true") // 是否自动推断schema

.load("/usr/file/csv/dept.csv")

.show()

使用预定义类型:

import org.apache.spark.sql.types.{StructField, StructType, StringType,LongType}

//预定义数据格式

val myManualSchema = new StructType(Array(

StructField("deptno", LongType, nullable = false),

StructField("dname", StringType,nullable = true),

StructField("loc", StringType,nullable = true)

))

spark.read.format("csv")

.option("mode", "FAILFAST")

.schema(myManualSchema)

.load("/usr/file/csv/dept.csv")

.show()

2.2 写入CSV文件

df.write.format("csv").mode("overwrite").save("/tmp/csv/dept2")

也可以指定具体的分隔符:

df.write.format("csv").mode("overwrite").option("sep", "\t").save("/tmp/csv/dept2")

2.3 可选配置

为节省主文篇幅,所有读写配置项见文末9.1小节。

三、JSON

3.1 读取JSON文件

spark.read.format("json").option("mode", "FAILFAST").load("/usr/file/json/dept.json").show(5)

需要注意的是:默认不支持一条数据记录跨越多行(如下),可以通过配置multiLine为true来进行更改,其默认值为false。

// 默认支持单行

{"DEPTNO": 10,"DNAME": "ACCOUNTING","LOC": "NEW YORK"}

//默认不支持多行

{

"DEPTNO": 10,

"DNAME": "ACCOUNTING",

"LOC": "NEW YORK"

}

3.2 写入JSON文件

df.write.format("json").mode("overwrite").save("/tmp/spark/json/dept")

3.3 可选配置

为节省主文篇幅,所有读写配置项见文末9.2小节。

四、Parquet

Parquet是一个开源的面向列的数据存储,它提供了多种存储优化,允许读取单独的列非整个文件,这不仅节省了存储空间而且提升了读取效率,它是Spark是默认的文件格式。

4.1 读取Parquet文件

spark.read.format("parquet").load("/usr/file/parquet/dept.parquet").show(5)

2.2 写入Parquet文件

df.write.format("parquet").mode("overwrite").save("/tmp/spark/parquet/dept")

2.3 可选配置

Parquet文件有着自己的存储规则,因此其可选配置项比较少,常用的有如下两个:

| 读写操作 | 配置项 | 可选值 | 默认值 | 描述 |

|---|---|---|---|---|

| Write | compression or codec | None, uncompressed, bzip2, deflate, gzip, lz4, or snappy |

None | 压缩文件格式 |

| Read | mergeSchema | true, false | 取决于配置项spark.sql.parquet.mergeSchema |

当为真时,Parquet数据源将所有数据文件收集的Schema合并在一起,否则将从摘要文件中选择Schema,如果没有可用的摘要文件,则从随机数据文件中选择Schema。 |

更多可选配置可以参阅官方文档:https://spark.apache.org/docs/latest/sql-data-sources-parquet.html

五、ORC

ORC是一种自描述的、类型感知的列文件格式,它针对大型数据的读写进行了优化,也是大数据中常用的文件格式。

5.1 读取ORC文件

spark.read.format("orc").load("/usr/file/orc/dept.orc").show(5)

4.2 写入ORC文件

csvFile.write.format("orc").mode("overwrite").save("/tmp/spark/orc/dept")

六、SQL Databases

Spark同样支持与传统的关系型数据库进行数据读写。但是Spark程序默认是没有提供数据库驱动的,所以在使用前需要将对应的数据库驱动上传到安装目录下的jars目录中。下面示例使用的是Mysql数据库,使用前需要将对应的mysql-connector-java-x.x.x.jar上传到jars目录下。

6.1 读取数据

读取全表数据示例如下,这里的help_keyword是mysql内置的字典表,只有help_keyword_id和name两个字段。

spark.read

.format("jdbc")

.option("driver", "com.mysql.jdbc.Driver") //驱动

.option("url", "jdbc:mysql://127.0.0.1:3306/mysql") //数据库地址

.option("dbtable", "help_keyword") //表名

.option("user", "root").option("password","root").load().show(10)

从查询结果读取数据:

val pushDownQuery = """(SELECT * FROM help_keyword WHERE help_keyword_id <20) AS help_keywords"""

spark.read.format("jdbc")

.option("url", "jdbc:mysql://127.0.0.1:3306/mysql")

.option("driver", "com.mysql.jdbc.Driver")

.option("user", "root").option("password", "root")

.option("dbtable", pushDownQuery)

.load().show()

//输出

+---------------+-----------+

|help_keyword_id| name|

+---------------+-----------+

| 0| <>|

| 1| ACTION|

| 2| ADD|

| 3|AES_DECRYPT|

| 4|AES_ENCRYPT|

| 5| AFTER|

| 6| AGAINST|

| 7| AGGREGATE|

| 8| ALGORITHM|

| 9| ALL|

| 10| ALTER|

| 11| ANALYSE|

| 12| ANALYZE|

| 13| AND|

| 14| ARCHIVE|

| 15| AREA|

| 16| AS|

| 17| ASBINARY|

| 18| ASC|

| 19| ASTEXT|

+---------------+-----------+

也可以使用如下的写法进行数据的过滤:

val props = new java.util.Properties

props.setProperty("driver", "com.mysql.jdbc.Driver")

props.setProperty("user", "root")

props.setProperty("password", "root")

val predicates = Array("help_keyword_id < 10 OR name = 'WHEN'") //指定数据过滤条件

spark.read.jdbc("jdbc:mysql://127.0.0.1:3306/mysql", "help_keyword", predicates, props).show()

//输出:

+---------------+-----------+

|help_keyword_id| name|

+---------------+-----------+

| 0| <>|

| 1| ACTION|

| 2| ADD|

| 3|AES_DECRYPT|

| 4|AES_ENCRYPT|

| 5| AFTER|

| 6| AGAINST|

| 7| AGGREGATE|

| 8| ALGORITHM|

| 9| ALL|

| 604| WHEN|

+---------------+-----------+

可以使用numPartitions指定读取数据的并行度:

option("numPartitions", 10)

在这里,除了可以指定分区外,还可以设置上界和下界,任何小于下界的值都会被分配在第一个分区中,任何大于上界的值都会被分配在最后一个分区中。

val colName = "help_keyword_id" //用于判断上下界的列

val lowerBound = 300L //下界

val upperBound = 500L //上界

val numPartitions = 10 //分区综述

val jdbcDf = spark.read.jdbc("jdbc:mysql://127.0.0.1:3306/mysql","help_keyword",

colName,lowerBound,upperBound,numPartitions,props)

想要验证分区内容,可以使用mapPartitionsWithIndex这个算子,代码如下:

jdbcDf.rdd.mapPartitionsWithIndex((index, iterator) => {

val buffer = new ListBuffer[String]

while (iterator.hasNext) {

buffer.append(index + "分区:" + iterator.next())

}

buffer.toIterator

}).foreach(println)

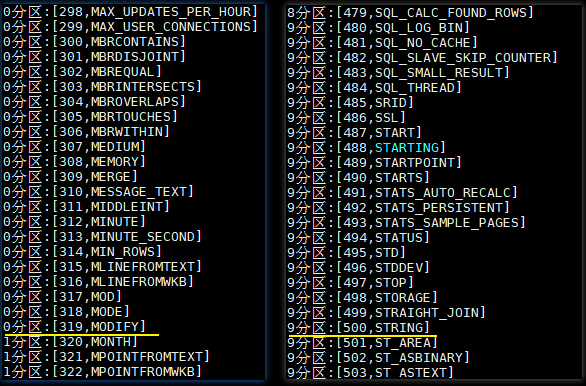

执行结果如下:help_keyword这张表只有600条左右的数据,本来数据应该均匀分布在10个分区,但是0分区里面却有319条数据,这是因为设置了下限,所有小于300的数据都会被限制在第一个分区,即0分区。同理所有大于500的数据被分配在9分区,即最后一个分区。

6.2 写入数据

val df = spark.read.format("json").load("/usr/file/json/emp.json")

df.write

.format("jdbc")

.option("url", "jdbc:mysql://127.0.0.1:3306/mysql")

.option("user", "root").option("password", "root")

.option("dbtable", "emp")

.save()

七、Text

Text文件在读写性能方面并没有任何优势,且不能表达明确的数据结构,所以其使用的比较少,读写操作如下:

7.1 读取Text数据

spark.read.textFile("/usr/file/txt/dept.txt").show()

7.2 写入Text数据

df.write.text("/tmp/spark/txt/dept")

八、数据读写高级特性

8.1 并行读

多个Executors不能同时读取同一个文件,但它们可以同时读取不同的文件。这意味着当您从一个包含多个文件的文件夹中读取数据时,这些文件中的每一个都将成为DataFrame中的一个分区,并由可用的Executors并行读取。

8.2 并行写

写入的文件或数据的数量取决于写入数据时DataFrame拥有的分区数量。默认情况下,每个数据分区写一个文件。

8.3 分区写入

分区和分桶这两个概念和Hive中分区表和分桶表是一致的。都是将数据按照一定规则进行拆分存储。需要注意的是partitionBy指定的分区和RDD中分区不是一个概念:这里的分区表现为输出目录的子目录,数据分别存储在对应的子目录中。

val df = spark.read.format("json").load("/usr/file/json/emp.json")

df.write.mode("overwrite").partitionBy("deptno").save("/tmp/spark/partitions")

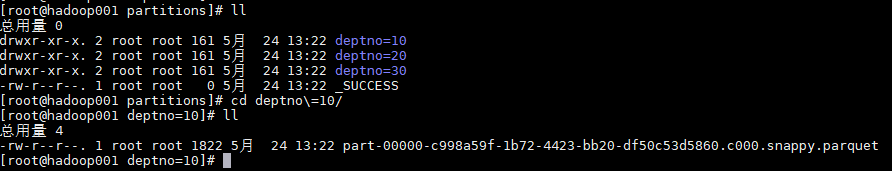

输出结果如下:可以看到输出被按照部门编号分为三个子目录,子目录中才是对应的输出文件。

8.3 分桶写入

分桶写入就是将数据按照指定的列和桶数进行散列,目前分桶写入只支持保存为表,实际上这就是Hive的分桶表。

val numberBuckets = 10

val columnToBucketBy = "empno"

df.write.format("parquet").mode("overwrite")

.bucketBy(numberBuckets, columnToBucketBy).saveAsTable("bucketedFiles")

8.5 文件大小管理

如果写入产生小文件数量过多,这时会产生大量的元数据开销。Spark和HDFS一样,都不能很好的处理这个问题,这被称为“small file problem”。同时数据文件也不能过大,否则在查询时会有不必要的性能开销,因此要把文件大小控制在一个合理的范围内。

在上文我们已经介绍过可以通过分区数量来控制生成文件的数量,从而间接控制文件大小。Spark 2.2引入了一种新的方法,以更自动化的方式控制文件大小,这就是maxRecordsPerFile参数,它允许你通过控制写入文件的记录数来控制文件大小。

// Spark将确保文件最多包含5000条记录

df.write.option(“maxRecordsPerFile”, 5000)

九、可选配置附录

9.1 CSV读写可选配置

| 读\写操作 | 配置项 | 可选值 | 默认值 | 描述 |

|---|---|---|---|---|

| Both | seq | 任意字符 | ,(逗号) |

分隔符 |

| Both | header | true, false | false | 文件中的第一行是否为列的名称。 |

| Read | escape | 任意字符 | \ | 转义字符 |

| Read | inferSchema | true, false | false | 是否自动推断列类型 |

| Read | ignoreLeadingWhiteSpace | true, false | false | 是否跳过值前面的空格 |

| Both | ignoreTrailingWhiteSpace | true, false | false | 是否跳过值后面的空格 |

| Both | nullValue | 任意字符 | “” | 声明文件中哪个字符表示空值 |

| Both | nanValue | 任意字符 | NaN | 声明哪个值表示NaN或者缺省值 |

| Both | positiveInf | 任意字符 | Inf | 正无穷 |

| Both | negativeInf | 任意字符 | -Inf | 负无穷 |

| Both | compression or codec | None, uncompressed, bzip2, deflate, gzip, lz4, or snappy |

none | 文件压缩格式 |

| Both | dateFormat | 任何能转换为 Java的 SimpleDataFormat的字符串 |

yyyy-MM-dd | 日期格式 |

| Both | timestampFormat | 任何能转换为 Java的 SimpleDataFormat的字符串 |

yyyy-MMdd’T’HH:mm:ss.SSSZZ | 时间戳格式 |

| Read | maxColumns | 任意整数 | 20480 | 声明文件中的最大列数 |

| Read | maxCharsPerColumn | 任意整数 | 1000000 | 声明一个列中的最大字符数。 |

| Read | escapeQuotes | true, false | true | 是否应该转义行中的引号。 |

| Read | maxMalformedLogPerPartition | 任意整数 | 10 | 声明每个分区中最多允许多少条格式错误的数据,超过这个值后格式错误的数据将不会被读取 |

| Write | quoteAll | true, false | false | 指定是否应该将所有值都括在引号中,而不只是转义具有引号字符的值。 |

| Read | multiLine | true, false | false | 是否允许每条完整记录跨域多行 |

9.2 JSON读写可选配置

| 读\写操作 | 配置项 | 可选值 | 默认值 |

|---|---|---|---|

| Both | compression or codec | None, uncompressed, bzip2, deflate, gzip, lz4, or snappy |

none |

| Both | dateFormat | 任何能转换为 Java的 SimpleDataFormat的字符串 | yyyy-MM-dd |

| Both | timestampFormat | 任何能转换为 Java的 SimpleDataFormat的字符串 | yyyy-MMdd’T’HH:mm:ss.SSSZZ |

| Read | primitiveAsString | true, false | false |

| Read | allowComments | true, false | false |

| Read | allowUnquotedFieldNames | true, false | false |

| Read | allowSingleQuotes | true, false | true |

| Read | allowNumericLeadingZeros | true, false | false |

| Read | allowBackslashEscapingAnyCharacter | true, false | false |

| Read | columnNameOfCorruptRecord | true, false | Value of spark.sql.column&NameOf |

| Read | multiLine | true, false | false |

9.3 数据库读写可选配置

| 属性名称 | 含义 |

|---|---|

| url | 数据库地址 |

| dbtable | 表名称 |

| driver | 数据库驱动 |

| partitionColumn, lowerBound, upperBoun |

分区总数,上界,下界 |

| numPartitions | 可用于表读写并行性的最大分区数。如果要写的分区数量超过这个限制,那么可以调用coalesce(numpartition)重置分区数。 |

| fetchsize | 每次往返要获取多少行数据。此选项仅适用于读取数据。 |

| batchsize | 每次往返插入多少行数据,这个选项只适用于写入数据。默认值是1000。 |

| isolationLevel | 事务隔离级别:可以是NONE,READ_COMMITTED, READ_UNCOMMITTED,REPEATABLE_READ或SERIALIZABLE,即标准事务隔离级别。 默认值是READ_UNCOMMITTED。这个选项只适用于数据读取。 |

| createTableOptions | 写入数据时自定义创建表的相关配置 |

| createTableColumnTypes | 写入数据时自定义创建列的列类型 |

数据库读写更多配置可以参阅官方文档:https://spark.apache.org/docs/latest/sql-data-sources-jdbc.html

参考资料

- Matei Zaharia, Bill Chambers . Spark: The Definitive Guide[M] . 2018-02

- https://spark.apache.org/docs/latest/sql-data-sources.html

更多大数据系列文章可以参见个人 GitHub 开源项目: 程序员大数据入门指南

Spark学习之路(十)—— Spark SQL 外部数据源的更多相关文章

- [转]Spark学习之路 (三)Spark之RDD

Spark学习之路 (三)Spark之RDD https://www.cnblogs.com/qingyunzong/p/8899715.html 目录 一.RDD的概述 1.1 什么是RDD? ...

- Spark学习笔记2(spark所需环境配置

Spark学习笔记2 配置spark所需环境 1.首先先把本地的maven的压缩包解压到本地文件夹中,安装好本地的maven客户端程序,版本没有什么要求 不需要最新版的maven客户端. 解压完成之后 ...

- Spark学习之路(八)—— Spark SQL 之 DataFrame和Dataset

一.Spark SQL简介 Spark SQL是Spark中的一个子模块,主要用于操作结构化数据.它具有以下特点: 能够将SQL查询与Spark程序无缝混合,允许您使用SQL或DataFrame AP ...

- Spark学习之路 (二十二)SparkStreaming的官方文档

官网地址:http://spark.apache.org/docs/latest/streaming-programming-guide.html 一.简介 1.1 概述 Spark Streamin ...

- Spark学习之路(十四)—— Spark Streaming 基本操作

一.案例引入 这里先引入一个基本的案例来演示流的创建:获取指定端口上的数据并进行词频统计.项目依赖和代码实现如下: <dependency> <groupId>org.apac ...

- Spark学习之路(十一)—— Spark SQL 聚合函数 Aggregations

一.简单聚合 1.1 数据准备 // 需要导入spark sql内置的函数包 import org.apache.spark.sql.functions._ val spark = SparkSess ...

- Spark学习之路(十六)—— Spark Streaming 整合 Kafka

一.版本说明 Spark针对Kafka的不同版本,提供了两套整合方案:spark-streaming-kafka-0-8和spark-streaming-kafka-0-10,其主要区别如下: s ...

- Spark学习之路(十五)—— Spark Streaming 整合 Flume

一.简介 Apache Flume是一个分布式,高可用的数据收集系统,可以从不同的数据源收集数据,经过聚合后发送到分布式计算框架或者存储系统中.Spark Straming提供了以下两种方式用于Flu ...

- Spark学习之路 (八)SparkCore的调优之开发调优

摘抄自:https://tech.meituan.com/spark-tuning-basic.html 前言 在大数据计算领域,Spark已经成为了越来越流行.越来越受欢迎的计算平台之一.Spark ...

- Spark学习之路 (八)SparkCore的调优之开发调优[转]

前言 在大数据计算领域,Spark已经成为了越来越流行.越来越受欢迎的计算平台之一.Spark的功能涵盖了大数据领域的离线批处理.SQL类处理.流式/实时计算.机器学习.图计算等各种不同类型的计算操作 ...

随机推荐

- openresty: nginx worker不同请求之间共享数据

To globally share data among all the requests handled by the same nginx worker process, encapsulate ...

- visualsvn server 提交修改日志

修改日志时遇到以下错误: Repository has not been enabled to accept revision propchanges;ask the administrator to ...

- 跟我学ASP.NET MVC之九:SportsStrore产品管理

摘要: 在这篇文章中,我将继续完成SportsStore应用程序,让站点管理者可以管理产品列表.我将添加创建.修改和删除产品功能. 本篇文章将分模块的方式,逐个介绍SportsStore站点管理功能的 ...

- ZOJ 2319 Beatuiful People(单调递增序列的变形)

Beautiful People Time Limit: 5 Seconds Memory Limit: 32768 KB Special Judge The most prest ...

- Ubuntu 14.04 64位字体美化(使用黑文泉驿)

Ubuntu 14.04安装和升级后,,斜体字体变得很难看,昨天,我得到一个晚上,最终,管理一个线索,这里整洁. 在线调研后,.一致的观点是,,使用开源字体库文泉驿理想的黑色字体效果,效果甚至没有丢失 ...

- wpf 绑定数据无法更新ui控件可能存在的问题

BindingMode的枚举值有: ① OneWay ② TwoWay ③ OneTime:根据源端属性值设置目标属性值,之后的改变会被忽略,除非调用BindingExpression.UpdateT ...

- C#并口热敏小票打印机打印位图

原文:C#并口热敏小票打印机打印位图 最近一直在研究并口小票打印机打印图片问题,这也是第一次和硬件打交道,不过还好,最终成功了. 这是DEMO的窗体: 下面是打印所需要调用的代码: class ...

- WPF/Silverlight 页面绑定Model验证机制升级版

关于WPF/Silverlight的数据验证,想必大家都不陌生了. 各大牛的博客里都不泛对这方面讨论的文章. 个人比较赞赏 JV9的“Silverlight实例教程”里的Validation数据验证. ...

- layui弹出框打开第二次select内容无法显示问题

今天, 在使用layui弹出框的时候, 第一次进入select内容加载是正常的, 将弹出框关闭再次进入后select下拉框内容为空, 经排查是因为每次弹出窗口z-index都会改变, 弹出框的z-in ...

- 程序定义了多个入口点。使用 /main (指定包含入口点的类型)进行编译

原文:请使用/main进行编译,以指定包含入口点类型 在使用VS工具初学C#的时候需要不停的写小程序,觉得每次都新建项目太过麻烦,所以试着把程序写在一个项目下面,结果编译的时候出错了,因为我每个小程序 ...