机器学习---用python实现最小二乘线性回归算法并用随机梯度下降法求解 (Machine Learning Least Squares Linear Regression Application SGD)

在《机器学习---线性回归(Machine Learning Linear Regression)》一文中,我们主要介绍了最小二乘线性回归算法以及简单地介绍了梯度下降法。现在,让我们来实践一下吧。

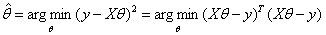

先来回顾一下用最小二乘法求解参数的公式: 。

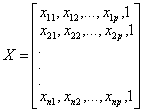

。

(其中: ,

, ,

, )

)

再来看一下随机梯度下降法(Stochastic Gradient Descent)的算法步骤:

除了算法中所需的超参数α(学习速率,代码中写为lr)和epsilon(误差值),我们增加了另一个超参数epoch(迭代次数)。此外,为方便起见,在代码中我们用w代替θ。

我们自己创建了一组数据,是最简单的一元线性回归,以便画图展示。由于整个过程基本上就是上述算法步骤的重复,故在此次不一一分解了,请自行查看完整代码。至于学习速率alpha的选择,请查看:如何选择梯度下降法中的学习速率α(Gradient Descent Alpha)。

完整代码如下:

import matplotlib.pyplot as plt

fig,ax=plt.subplots()

import numpy as np #创建数据

x=np.linspace(0,100,10).reshape(10,1)

rng=np.random.RandomState(4)

noise=rng.randint(-10,10,size=(10,1))*4

y=4*x+4+noise class Linear_Regression:

def __init__(self):

self._w = None def fit(self, X, y, lr=0.01, epsilon=0.01, epoch=1000):

#训练数据

#将输入的X,y转换为numpy数组

X, y = np.asarray(X, np.float32), np.asarray(y, np.float32)

#给X增加一列常数项

X=np.hstack((X,np.ones((X.shape[0],1))))

#初始化w

self._w = np.zeros((X.shape[1],1)) for _ in range(epoch):

#随机选择一组样本计算梯度

random_num=np.random.choice(len(X))

x_random=X[random_num].reshape(1,2)

y_random=y[random_num] gradient=(x_random.T)*(np.dot(x_random,self._w)-y_random) #如果收敛,那么停止迭代

if (np.abs(self._w-lr*gradient)<epsilon).all():

break

#否则,更新w

else:

self._w =self._w-lr*gradient return self._w def print_results(self):

print("参数w:{}".format(self._w))

print("回归拟合线:y={}x+{}".format(self._w[0],self._w[1])) def draw_pics(self,X):

#画出原始数据

ax.scatter(X,y,marker="o")

ax.set_xlabel("x")

ax.set_ylabel("y") #画出拟合线

line_x=np.linspace(0,100,10)

line_y=self._w[0]*line_x+self._w[1]

ax.plot(line_x,line_y) def predict(self,x):

x=np.asarray(x, np.float32)

x=x.reshape(x.shape[0],1)

x=np.hstack((x,np.ones((x.shape[0],1))))

return np.dot(x,self._w) if __name__=="__main__":

Regression=Linear_Regression()

Regression.fit(x,y,lr=0.0001,epsilon=0.001,epoch=20)

Regression.print_results()

Regression.draw_pics(x)

运行结果:

参数w:[[3.95933261]

[0.06683964]]

回归拟合线:y=[3.95933261]x+[0.06683964]

画出的拟合线:

机器学习---用python实现最小二乘线性回归算法并用随机梯度下降法求解 (Machine Learning Least Squares Linear Regression Application SGD)的更多相关文章

- 机器学习---最小二乘线性回归模型的5个基本假设(Machine Learning Least Squares Linear Regression Assumptions)

在之前的文章<机器学习---线性回归(Machine Learning Linear Regression)>中说到,使用最小二乘回归模型需要满足一些假设条件.但是这些假设条件却往往是人们 ...

- 谷歌机器学习速成课程---降低损失 (Reducing Loss):随机梯度下降法

在梯度下降法中,批量指的是用于在单次迭代中计算梯度的样本总数.到目前为止,我们一直假定批量是指整个数据集.就 Google 的规模而言,数据集通常包含数十亿甚至数千亿个样本.此外,Google 数据集 ...

- sklearn中实现随机梯度下降法(多元线性回归)

sklearn中实现随机梯度下降法 随机梯度下降法是一种根据模拟退火的原理对损失函数进行最小化的一种计算方式,在sklearn中主要用于多元线性回归算法中,是一种比较高效的最优化方法,其中的梯度下降系 ...

- ubuntu之路——day8.1 深度学习优化算法之mini-batch梯度下降法

所谓Mini-batch梯度下降法就是划分训练集和测试集为等分的数个子集,比如原来有500W个样本,将其划分为5000个baby batch,每个子集中有1000个样本,然后每次对一个mini-bat ...

- [机器学习Lesson 2]代价函数之线性回归算法

本章内容主要是介绍:单变量线性回归算法(Linear regression with one variable) 1. 线性回归算法(linear regression) 1.1 预测房屋价格 该问题 ...

- 机器学习算法之旅A Tour of Machine Learning Algorithms

In this post we take a tour of the most popular machine learning algorithms. It is useful to tour th ...

- 谷歌机器学习速成课程---3降低损失 (Reducing Loss):梯度下降法

迭代方法图(图 1)包含一个标题为“计算参数更新”的华而不实的绿框.现在,我们将用更实质的方法代替这种华而不实的算法. 假设我们有时间和计算资源来计算 w1 的所有可能值的损失.对于我们一直在研究的回 ...

- 梯度下降法VS随机梯度下降法 (Python的实现)

# -*- coding: cp936 -*- import numpy as np from scipy import stats import matplotlib.pyplot as plt # ...

- tensorflow实现svm iris二分类——本质上在使用梯度下降法求解线性回归(loss是定制的而已)

iris二分类 # Linear Support Vector Machine: Soft Margin # ---------------------------------- # # This f ...

随机推荐

- 8 search中的timeout参数

默认的search,是没有时间限制的.比如,一个search,可能要10分钟才能搜完,那么,es就会等10分钟,直到结果出来. 然而,在某些场景下,客户是等不了10分钟的.比如,电商网站,客户宁可 ...

- 3:基于乐观锁(两种)控制并发: version、external锁

ES是基于乐观锁进行并发控制的. 如果有并发的业务场景,可以直接使用ES内置乐观锁机制. 使用的时候,java程序需要先Get指定的记录,获取到版本号,然后Put的时候,带着该版本号,请求更新. ES ...

- 使用CertUtil.exe下载远程文件

使用CertUtil.exe下载远程文件 证书 https://www.cnblogs.com/17bdw/p/8728656.html 1.前言 经过国外文章信息,CertUtil.exe下载恶意软 ...

- Mongodb 学习笔记(一)

MongoDB 是一款开源.跨平台.分布式,具有大数据处理能力的文档存储数据库.在 2007 年由 MongoDB 软件公司开发完成,并实现全部代码源发展.目 前,该文档数据库被国内外众多知名网因所采 ...

- 深入理解TCP三握四挥

面试中被问到不少次TCP的三握四挥,今天特意来做一个总结(一些资料是很久前找的,忘了参考的链接了) 一.三次握手 首先来看一张图 最初,客户机A与服务器B的TCP进程都处于 CLOSED 状态. 然后 ...

- 转换属性transform

transform: rotate(45deg);旋转 rotate(值) 值为正,表示元素顺时针旋转 值为负,表示元素逆时针旋转 transform: translate(200px,100px); ...

- 深入理解React 组件状态(State)

React 的核心思想是组件化的思想,应用由组件搭建而成,而组件中最重要的概念是State(状态),State是一个组件的UI数据模型,是组件渲染时的数据依据. 一. 如何定义State 定义一个合适 ...

- 虹软人脸识别SDK在网络摄像头中的实际应用

目前在人脸识别领域中,网络摄像头的使用很普遍,但接入网络摄像头和人脸识别SDK有一定门槛,在此篇中介绍过虹软人脸识别SDK的接入流程,本文着重介绍网络摄像头获取视频流并处理的流程(红色框内),以下内容 ...

- Android笔记(三十六) AsyncTask是如何执行的?

在上一个例子中,我们是在LoadImage的onPostExecute中修改的UI,不是说只允许在主线程中修改UI吗?我们看一下源代码是如何操作的. MainActicity.java package ...

- 04 -- 元类和ORM

本篇主要介绍元类,为什么说一切皆对象:如何动态的创建类等:以及ORM,即什么是ORM等知识 一.元类 1.1 在Python中一切皆对象 在学习元类中我们首先需要了解一个概念-- python中一切皆 ...