scrapy框架爬取糗妹妹网站妹子图分类的所有图片

爬取所有图片,一个页面的图片建一个文件夹。难点,图片中有不少.gif图片,需要重写下载规则,

创建scrapy项目

scrapy startproject qiumeimei

创建爬虫应用

cd qiumeimei scrapy genspider -t crawl qmm www.xxx.com

items.py文件中定义下载字段

import scrapy class QiumeimeiItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

page = scrapy.Field()

image_url = scrapy.Field()

qmm.py文件中写爬虫主程序

import scrapy

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from qiumeimei.items import QiumeimeiItem class QmmSpider(CrawlSpider):

name = 'qmm'

# allowed_domains = ['www.xxx.com']

start_urls = ['http://www.qiumeimei.com/image'] rules = (

Rule(LinkExtractor(allow=r'http://www.qiumeimei.com/image/page/\d+'), callback='parse_item', follow=True),

) def parse_item(self, response):

page = response.url.split('/')[-1]

if not page.isdigit():

page = ''

image_urls = response.xpath('//div[@class="main"]/p/img/@data-lazy-src').extract()

for image_url in image_urls:

item = QiumeimeiItem()

item['image_url'] = image_url

item['page'] = page

yield item

pipelines.py文件中定义下载规则

import scrapy

import os

from scrapy.utils.misc import md5sum

# 导入scrapy 框架里的 管道文件的里的图像 图像处理的专用管道文件

from scrapy.pipelines.images import ImagesPipeline

# 导入图片路径名称

from qiumeimei.settings import IMAGES_STORE as images_store

# 必须继承 ImagesPipeline

class QiumeimeiPipeline(ImagesPipeline):

# 定义返回文件名

def file_path(self, request, response=None, info=None):

file_name = request.url.split('/')[-1]

return file_name

# 重写父类的 下载文件的 方法

def get_media_requests(self, item, info):

yield scrapy.Request(url=item['image_url'])

# 完成图片存储的方法 名称

def item_completed(self, results, item, info):

# print(results)

page = item['page']

print('正在下载第'+page+'页图片')

image_url = item['image_url']

image_name = image_url.split('/')[-1]

old_name_list = [x['path'] for t, x in results if t]

# 真正的原图片的存储路径

old_name = images_store + old_name_list[0]

image_path = images_store + page + "/"

# 判断图片存放的目录是否存在

if not os.path.exists(image_path):

# 根据当前页码创建对应的目录

os.mkdir(image_path)

# 新名称

new_name = image_path + image_name

# 重命名

os.rename(old_name, new_name)

return item

# 重写下载规则

def image_downloaded(self, response, request, info):

checksum = None

for path, image, buf in self.get_images(response, request, info):

if checksum is None:

buf.seek(0)

checksum = md5sum(buf)

width, height = image.size

if self.check_gif(image):

self.persist_gif(path, response.body, info)

else:

self.store.persist_file(

path, buf, info,

meta={'width': width, 'height': height},

headers={'Content-Type': 'image/jpeg'})

return checksum def check_gif(self, image):

if image.format is None:

return True def persist_gif(self, key, data, info):

root, ext = os.path.splitext(key)

absolute_path = self.store._get_filesystem_path(key)

self.store._mkdir(os.path.dirname(absolute_path), info)

f = open(absolute_path, 'wb') # use 'b' to write binary data.

f.write(data)

settings.py文件中定义请求头和打开下载管道

USER_AGENT = 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/39.0.2171.71 Safari/537.36'

ITEM_PIPELINES = {

'qiumeimei.pipelines.QiumeimeiPipeline': 300,

}

运行爬虫

scrapy crawl qmm --nolog

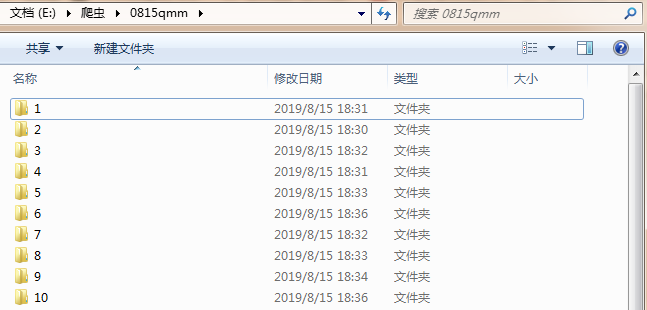

查看文件夹是否下载成功

.gif为动态图。

done。

scrapy框架爬取糗妹妹网站妹子图分类的所有图片的更多相关文章

- python爬虫scrapy框架——爬取伯乐在线网站文章

一.前言 1. scrapy依赖包: 二.创建工程 1. 创建scrapy工程: scrapy staratproject ArticleSpider 2. 开始(创建)新的爬虫: cd Artic ...

- 使用scrapy框架爬取自己的博文(2)

之前写了一篇用scrapy框架爬取自己博文的博客,后来发现对于中文的处理一直有问题- - 显示的时候 [u'python\u4e0b\u722c\u67d0\u4e2a\u7f51\u9875\u76 ...

- (java)selenium webdriver爬虫学习--爬取阿里指数网站的每个分类的top50 相关数据;

主题:java 爬虫--爬取'阿里指数'网站的每个分类的top50 相关数据: 网站网址为:http://index.1688.com/alizs/top.htm?curType=offer& ...

- 爬虫入门(四)——Scrapy框架入门:使用Scrapy框架爬取全书网小说数据

为了入门scrapy框架,昨天写了一个爬取静态小说网站的小程序 下面我们尝试爬取全书网中网游动漫类小说的书籍信息. 一.准备阶段 明确一下爬虫页面分析的思路: 对于书籍列表页:我们需要知道打开单本书籍 ...

- scrapy框架爬取笔趣阁完整版

继续上一篇,这一次的爬取了小说内容 pipelines.py import csv class ScrapytestPipeline(object): # 爬虫文件中提取数据的方法每yield一次it ...

- scrapy框架爬取笔趣阁

笔趣阁是很好爬的网站了,这里简单爬取了全部小说链接和每本的全部章节链接,还想爬取章节内容在biquge.py里在加一个爬取循环,在pipelines.py添加保存函数即可 1 创建一个scrapy项目 ...

- scrapy框架爬取妹子图片

首先,建立一个项目#可在github账户下载完整代码:https://github.com/connordb/scrapy-jiandan2 scrapy startproject jiandan2 ...

- scrapy框架爬取智联招聘网站上深圳地区python岗位信息。

爬取字段,公司名称,职位名称,公司详情的链接,薪资待遇,要求的工作经验年限 1,items中定义爬取字段 import scrapy class ZhilianzhaopinItem(scrapy.I ...

- Python Scrapy 爬取煎蛋网妹子图实例(一)

前面介绍了爬虫框架的一个实例,那个比较简单,这里在介绍一个实例 爬取 煎蛋网 妹子图,遗憾的是 上周煎蛋网还有妹子图了,但是这周妹子图变成了 随手拍, 不过没关系,我们爬图的目的是为了加强实战应用,管 ...

随机推荐

- .NET ftp文件上传和下载

文章参考来源地址:https://blog.csdn.net/wybshyy/article/details/52095542 本次对代码进行了一点扩展:将文件上传到ftp指定目录下,若目录不存在则创 ...

- 理解CNN中的感受野(receptive-field)

1. 阅读论文:Understanding the Effective Receptive Field in Deep Convolutional Neural Networks 理解感受野 定义:r ...

- Git 查看更改

当向仓库中添加文件或删除文件后,可能需要查看更改. 查看更改有多种方式. 1.查看状态 # git status 结果 1 2 # 位于分支 master 无文件要提交,干净的工作区 2.查看日志 # ...

- jdbc(mysql)数据库连接

0.将驱动引入项目 在项目根目录新建文件夹lib,把数据库驱动mysql-connector-java-5.1.7-bin.jar放入该文件夹. 右键点击项目名称->properties-> ...

- Java后台验证

前台的js验证,可以通过其他手段绕过,存在安全问题,所以引入Java后台进行验证 一.导入jar包 此为hibernate-validator jar包,进行Java后台验证使用,在Java 1.9及 ...

- Vue框架(四)——路由跳转、路由传参、cookies、axios、跨域问题、element-ui模块

路由跳转 三种方式: $router.push / $router.go / router-link to this.$router.push('/course'); this.$router.pus ...

- CF1109F Sasha and Algorithm of Silence's Sounds LCT、线段树

传送门 构成一棵树可以分成两个限制:图不成环.图的点数-边数=1. 我们考虑枚举右端点\(r\)计算所有可能的左端点\(l\)的答案.我们先考虑第一个限制:图不成环.注意到当\(r\)确定的时候,满足 ...

- 备份和还原 第三篇:master 数据库的备份和还原

在SQL Server 中,master 数据库记录系统级别的元数据,例如,logon accounts, endpoints, linked servers, and system configur ...

- git 学习笔记 --创建与合并分支

在版本回退里,你已经知道,每次提交,Git都把它们串成一条时间线,这条时间线就是一个分支.截止到目前,只有一条时间线,在Git里,这个分支叫主分支,即master分支.HEAD严格来说不是指向提交,而 ...

- ajax标准写法

ajax 标准写法 $.ajax({ url:"http://www.microsoft.com", //请求的url地址 dataType:"json", / ...