Spark高级函数应用【combineByKey、transform】

一.combineByKey算子简介

功能:实现分组自定义求和及计数。

特点:用于处理(key,value)类型的数据。

实现步骤:

1.对要处理的数据进行初始化,以及一些转化操作

2.检测key是否是首次处理,首次处理则添加,否则则进行分区内合并【根据自定义逻辑】

3.分组合并,返回结果

二.combineByKey算子代码实战

package big.data.analyse.scala.arithmetic import org.apache.spark.sql.SparkSession

/**

* Created by zhen on 2019/9/7.

*/

object CombineByKey {

def main (args: Array[String]) {

val spark = SparkSession.builder().appName("CombineByKey").master("local[2]").getOrCreate()

val sc = spark.sparkContext

sc.setLogLevel("error") val initialScores = Array((("hadoop", "R"), 1), (("hadoop", "java"), 1),

(("spark", "scala"), 1), (("spark", "R"), 1), (("spark", "java"), 1)) val d1 = sc.parallelize(initialScores) val result = d1.map(x => (x._1._1, (x._1._2, x._2))).combineByKey(

(v : (String, Int)) => (v : (String, Int)), // 初始化操作,当key首次出现时初始化以及执行一些转化操作

(c : (String, Int), v : (String, Int)) => (c._1 + "," + v._1, c._2 + v._2), // 分区内合并,非首次出现时进行合并

(c1 : (String,Int),c2 : (String,Int)) => (c1._1 + "," + c2._1, c1._2 + c2._2)) // 分组合并

.collect() result.foreach(println)

}

}

三.combineByKey算子执行结果

四.transform算子简介

在spark streaming中使用,用于实现把一个DStream转化为另一个DStream。

五.transform算子代码实现

package big.data.analyse.streaming

import org.apache.log4j.{Level, Logger}

import org.apache.spark.SparkConf

import org.apache.spark.streaming.{Seconds, StreamingContext}

/**

* Created by zhen on 2019/09/21.

*/

object StreamingSocket {

def functionToCreateContext():StreamingContext = {

val conf = new SparkConf().setMaster("local[2]").setAppName("StreaingTest")

val ssc = new StreamingContext(conf, Seconds(10))

val lines = ssc.socketTextStream("192.168.245.137", 9999)

val words = lines.flatMap(_.split(" "))

val pairs = words.map(word=>(word,1))

/**

* 过滤内容

*/

val filter = ssc.sparkContext.parallelize(List("money","god","oh","very")).map(key => (key,true))

val result = pairs.transform(rdd => { // transform:把一个DStream转化为另一个SDtream

val leftRDD = rdd.leftOuterJoin(filter)

val word = leftRDD.filter( tuple =>{

val y = tuple._2

if(y._2.isEmpty){

true

}else{

false

}

})

word.map(tuple =>(tuple._1,1))

}).reduceByKey(_+_)

result.foreachRDD(rdd => {

if(!rdd.isEmpty()){

rdd.foreach(println)

}

})

ssc.checkpoint("D:\\checkpoint")

ssc

}

Logger.getLogger("org").setLevel(Level.WARN) // 设置日志级别

def main(args: Array[String]) {

val ssc = StreamingContext.getOrCreate("D:\\checkpoint", functionToCreateContext _)

ssc.start()

ssc.awaitTermination()

ssc.stop()

}

}

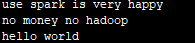

六.transform算子执行结果

输入:

输出:

备注:若在执行流计算时报:Some blocks could not be recovered as they were not found in memory. To prevent such data loss, enable Write Ahead Log (see programming guide for more details.,可以清空checkpoint目录下对应的数据【当前执行生成的数据】,可以解决这个问题。

Spark高级函数应用【combineByKey、transform】的更多相关文章

- Spark核心RDD:combineByKey函数详解

https://blog.csdn.net/jiangpeng59/article/details/52538254 为什么单独讲解combineByKey? 因为combineByKey是Spark ...

- spark aggregate函数详解

aggregate算是spark中比较常用的一个函数,理解起来会比较费劲一些,现在通过几个详细的例子带大家来着重理解一下aggregate的用法. 1.先看看aggregate的函数签名在spark的 ...

- Spark高级数据分析——纽约出租车轨迹的空间和时间数据分析

Spark高级数据分析--纽约出租车轨迹的空间和时间数据分析 一.地理空间分析: 二.pom.xml 原文地址:https://www.jianshu.com/p/eb6f3e0c09b5 作者:II ...

- javascript高级函数

高级函数 安全的类型检测 js内置的类型检测并非完全可靠,typeof操作符难以判断某个值是否为函数 instanceof在多个frame的情况下,会出现问题. 例如:var isArray = va ...

- js 高级函数 之示例

js 高级函数作用域安全构造函数 function Person(name, age) { this.name = name; this.age = age; ...

- 浅谈JS中的高级函数

在JavaScript中,函数的功能十分强大.它们是第一类对象,也可以作为另一个对象的方法,还可以作为参数传入另一个函数,不仅如此,还能被一个函数返回!可以说,在JS中,函数无处不在,无所不能,堪比孙 ...

- php一些高级函数方法

PHP高级函数 1.call_user_func (http://php.net/manual/zh/function.call-user-func.php) 2.get_class (http:// ...

- Spark 用户自定义函数 Java 示例

Spark UDF Java 示例 在这篇文章中提到了用Spark做用户昵称文本聚类分析,聚类需要选定K个中心点,然后迭代计算其他样本点到中心点的距离.由于中文文字分词之后(n-gram)再加上昵称允 ...

- Python函数式编程(二):常见高级函数

一个函数的参数中有函数作为参数,这个函数就为高级函数. 下面学习几个常见高级函数. ---------------------------------------------------------- ...

随机推荐

- ERP(Enterprise Resource Planning,企业资源计划)

企业资源计划或称企业资源规划简称ERP(Enterprise Resource Planning),由美国著名管理咨询公司Gartner Group Inc.于1990年提出来的,最初被定义为应用软件 ...

- 【转】C++ 异常机制分析

阅读目录 C++异常机制概述 throw 关键字 异常对象 catch 关键字 栈展开.RAII 异常机制与构造函数 异常机制与析构函数 noexcept修饰符与noexcept操作符 异常处理的性能 ...

- dfs的两种处理方法

方法一: 对于源点s,初始化vis[s]=1,并且在dfs之后vis[s]=1,为下一次调用做准备 .对于dfs递归中的寻找后继的循环体,入栈出栈语句写在循环内. 模板: //调用 vis[s]=; ...

- Echarts数据更新大坑

今天使用了一个Echarts来实现柱状图和直线图统计组合,每次通过axios(ajax库)来请求新数据来刷新数据,但是发现请求数据确实是对应变化到了options变量中,后台数据条数只有一条,但是图表 ...

- java语言总结

优点: 安全(废弃指针) 任何一个学过C或者C++的人都知道指针的操作对于他们是很重要的,指针能够支持内存的直接操作,这样的直接操作能够带来的是效率上的提高.但是任何一个东西都是有副作用的,指针给程序 ...

- Sc config http start= disabled

我不小心使用这个命令 Sc config http start= disabled, 现在http服务 无法启动 管理员运行 sc config http start= demand & ne ...

- c# winFrom Close报错 System.ObjectDisposedException:“无法访问已释放的对象。

System.ObjectDisposedException:“无法访问已释放的对象. ObjectDisposed_ObjectName_Name” 查了一下发现是 InitializeCompon ...

- Alpha冲刺——总结篇

课程信息 课程 软件工程1916|W(福州大学) 团队名称 修!咻咻! 作业要求 项目Alpha冲刺 团队目标 切实可行的计算机协会维修预约平台 团队信息 队员学号 队员姓名 个人博客地址 备注 22 ...

- Java利用IText导出PDF(更新)

我很久以前写的还是上大学的时候写的:https://www.cnblogs.com/LUA123/p/5108007.html ,今天心血来潮决定更新一波. 看了下官网(https://itextpd ...

- jmeter 获取总的线程数

String threads="${__BeanShell(ctx.getThreadGroup().getNumThreads())}"; vars.put("thre ...