【转】Python爬虫:抓取新浪新闻数据

案例一

抓取对象:

新浪国内新闻(http://news.sina.com.cn/china/),该列表中的标题名称、时间、链接。

完整代码:

- from bs4 import BeautifulSoup

- import requests

- url = 'http://news.sina.com.cn/china/'

- web_data = requests.get(url)

- web_data.encoding = 'utf-8'

- soup = BeautifulSoup(web_data.text,'lxml')

- for news in soup.select('.news-item'):

- if(len(news.select('h2')) > 0):

- h2 = news.select('h2')[0].text

- time = news.select('.time')[0].text

- a = news.select('a')[0]['href']

- print(h2,time,a)

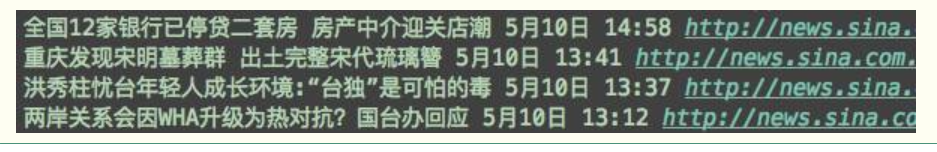

运行结果:(只展示部分)

详细解说:

1. 首先插入需要用到的库:BeautifulSoup、requests,然后解析网页。解析完后print下,确认是否解析正确。

- from bs4 import BeautifulSoup

- import requests

- url = 'http://news.sina.com.cn/china/'

- web_data = requests.get(url)

- soup = BeautifulSoup(web_data.text,'lxml')

- print(soup)

这时,我们可以看到,解析出来的网页里面有很多乱码,并没有正确解析。观察下结果,看到开头的这句:

- <meta content="text/html; charset=utf-8" http-equiv="Content-type"/>

【charset=utf-8】表示当前内容的字符集是采用utf-8编码格式,所以我们需要用encoding来解锁下,这时就能解析出来正常内容。

- from bs4 import BeautifulSoup

- import requests

- url = 'http://news.sina.com.cn/china/'

- web_data = requests.get(url)

- web_data.encoding = 'utf-8'

- soup = BeautifulSoup(web_data.text,'lxml')

- print(soup)

2. 解析出网页后,开始抓取我们需要的内容。首先,先补充几点知识。

看下面代码中的第一行,soup.select('.news-item'),取出含有特定CSS属性的元素时,比如:

- 找出所有class为news-item的元素,class名前面需要加点(.),即英文状态下的句号;

- 找出所有id为artibodyTitle的元素,id名前面需要加井号(#)。

另外,取得含有特定标签的HTML元素时,直接在select后写标签名即可,如下面for循环中的第3行,news.select('h2')。

- for news in soup.select('.news-item'):

- # print(news)

- if(len(news.select('h2')) > 0):

- # print(news.select('h2')[0].text)

- h2 = news.select('h2')[0].text

- time = news.select('.time')[0].text

- a = news.select('a')[0]['href']

- print(h2,time,a)

现在来详细看下这段代码每行的释义。

第1行:soup.select('.news-item'),取出news-item该类中的元素;

第2行:print下news,查看是否被正常解析,正常后继续,不用时可以注释掉;

第3行:通过观察代码,可以看到标题被储存在标签h2中,如果h2的长度大于0,这里是为了去除为空的标题数据;

第4行:print中news.select('h2')[0].text,[0]是取该列表中的第一个元素,text是取文本数据,print后查看是否正确,不用时可以注释掉;

第5行:将news.select('h2')[0].text存储在变量h2中;

第6行:time是class类型,前面加点来表示,同上,将其数据存储在变量time中;

第7行:我们要抓取的链接存放在a标签中,链接已经不是text了,后面用href,将链接数据存储在变量a中;

第8行:最后输出我们想要抓取的数据,标题、时间、链接。

案例二

抓取对象:

抓取新闻详情页的标题、时间(进行格式转换)、新闻来源、新闻详情、责任编辑、评论数量和新闻ID。

示例新闻:http://news.sina.com.cn/c/nd/2017-05-08/doc-ifyeycfp9368908.shtml

完整代码:

- from bs4 import BeautifulSoup

- import requests

- from datetime import datetime

- import json

- import re

- news_url = 'http://news.sina.com.cn/c/nd/2017-05-08/doc-ifyeycfp9368908.shtml'

- web_data = requests.get(news_url)

- web_data.encoding = 'utf-8'

- soup = BeautifulSoup(web_data.text,'lxml')

- title = soup.select('#artibodyTitle')[0].text

- print(title)

- time = soup.select('.time-source')[0].contents[0].strip()

- dt = datetime.strptime(time,'%Y年%m月%d日%H:%M')

- print(dt)

- source = soup.select('.time-source span span a')[0].text

- print(source)

- print('\n'.join([p.text.strip() for p in soup.select('#artibody p')[:-1]]))

- editor = soup.select('.article-editor')[0].text.lstrip('责任编辑:')

- print(editor)

- comments = requests.get('http://comment5.news.sina.com.cn/page/info?version=1&format=js&channel=gn&newsid=comos-fyeycfp9368908&group=&compress=0&ie=utf-8&oe=utf-8&page=1&page_size=20')

- comments_total = json.loads(comments.text.strip('var data='))

- print(comments_total['result']['count']['total'])

- news_id = re.search('doc-i(.+).shtml',news_url)

- print(news_id.group(1))

运行结果:

国土部:5月到9月实行汛期地质灾害日报告制度

2017-05-08 17:21:00

央视新闻

原标题:国土资源部:地质灾害高发期 实行日报告制度

国土资源部消息,5月份将逐渐进入地质灾害的高发期,防灾减灾形势更加严峻。据中国气象局预计,5月份我国江南大部、华南东部、西北地区大部降水较常年同期偏多,应加强防范极端气象事件诱发的滑坡、泥石流等地质灾害。对此从5月起至9月,国土资源部应急办实行汛期地质灾害日报告制度,各地必须将每天发生的灾情险情及其重大工作部署于当天下午3点前报告国土资源部应急办。

李伟山

fyeycfp9368908

详细解说:

1. 首先插入需要用到的库:BeautifulSoup、requests、datetime(时间处理)、json(解码:把json格式字符串解码转换成Python对象)、re(正则表达式),然后解析网页。

先抓取标题:

- from bs4 import BeautifulSoup

- import requests

- from datetime import datetime

- import json

- import re

- url = 'http://news.sina.com.cn/c/nd/2017-05-08/doc-ifyeycfp9368908.shtml'

- web_data = requests.get(url)

- web_data.encoding = 'utf-8'

- soup = BeautifulSoup(web_data.text,'lxml')

- title = soup.select('#artibodyTitle')[0].text

- print(title)

datetime、json、re在后面时间转换和从js中抓取数据时会用到。

我们主要来看下倒数第二行代码:title = soup.select('#artibodyTitle')[0].text,这里的用法和案例一中一样,id前用井号(#)来表示该类元素的位置,解锁唯一元素用[0],提取文本信息text。

2. 抓取时间,并将原有日期格式转化为标准格式:

- 1 # time = soup.select('.time-source')[0]

- 2 # print(time)

- 3 time = soup.select('.time-source')[0].contents[0].strip()

- 4 dt = datetime.strptime(time,'%Y年%m月%d日%H:%M')

- 5 print(dt)

第1行:抓取时间;

第2行:print下时间,这时会发现运行结果中既含有时间,还有新闻的来源,如下:

- <span class="time-source" id="navtimeSource">2017年05月08日17:21 <span> <span data-sudaclick="media_name"><a href="http://m.news.cctv.com/2017/05/08/ARTIPEcvpHjWzuGDPWQhn77z170508.shtml" rel="nofollow" target="_blank">央视新闻</a></span></span> </span>

那么,接下来我们需要想办法将时间和来源分开来,这时需要使用到contents;

第3行:我们先在后面加上.contents,运行下后会看到上面的内容会在列表中分为如下2个元素,此时,我们取的时间为第一个元素,在contents后加[0],最后的.strip()可以去除时间末尾的\t;

- ['2017年05月08日17:21\t\t', <span> <span data-sudaclick="media_name"><a href="http://m.news.cctv.com/2017/05/08/ARTIPEcvpHjWzuGDPWQhn77z170508.shtml" rel="nofollow" target="_blank">央视新闻</a></span></span>, '\n']

第4行:用datetime.strptime()来做时间格式化,原有的时间是年月日时分,所以转化时用到年月日时分,其中%Y是四位数的年份表示、%m是月份、%d是月份内的一天、%H是24小时制中的小时、%M是分钟数,并将其存储在变量dt中;

第5行:输出dt,会得到格式化后的时间,比如:2017-05-08 17:21:00。

3. 抓取新闻来源:

之前文章《Python爬虫:爬取人人都是产品经理的数据》中有提到可以用【Copy selector】来复制粘贴出新闻来源的位置,如下第一行;也可以用本篇文章经常用到的class类的表述方法说明其位置,如下第二行;

- 1 # source = soup.select('#navtimeSource > span > span > a')[0].text

- 2 source = soup.select('.time-source span span a')[0].text

- 3 print(source)

4. 抓取新闻详情:

- 1 article = []

- 2 for p in soup.select('#artibody p')[:-1]:

- 3 article.append(p.text.strip())

- 4 # print(article)

- 5 print('\n'.join(article))

第1行:article为空列表;

第2行:通过观察代码可以发现,新闻详情存放在p标签中,如果直接输出,能看到最后一栏有责任编辑的信息,如果不想要责任编辑,增加[:-1]可以去除最后一个编辑信息;

第3行:将抓取的数据插入article列表中,.strip()去除空白信息;

第4行:可以先print下看结果是否正确,发现新闻详情的原标题和正文是在一排的,不是很好,注释掉后我们换新的方法;

第5行:join()方法用来将列表中的元素用指定的字符连接生成新的字符串,这里用\n换行来连接列表中的原标题和正文两块内容。

上面这是一种文章连接的方法,当然还有比较简洁的写法。我们将上面的for循环一句拿出来,前面加p.text.strip(),然后整体加中括号,这样就形成了一个列表,然后前面再用join将其连接起来,就用简单的一行代码替代了上面的多行代码。

- 1 print('\n'.join([p.text.strip() for p in soup.select('#artibody p')[:-1]]))

5. 抓取责任编辑:

这里用到的lstrip是去除左侧的内容,括号内‘责任编辑:’是指去除这部分内容,只保留编辑人员姓名。之前用到的strip是去除两侧,lstrip是去除左侧,后面会用到的rstrip是去除右侧内容。

- 1 editor = soup.select('.article-editor')[0].text.lstrip('责任编辑:')

- 2 print(editor)

6. 抓取评论数:

- # comments = soup.select('#commentCount1')

- # print(comment)

- comments = requests.get('http://comment5.news.sina.com.cn/page/info?version=1&format=js&channel=gn&newsid=comos-fyeycfp9368908&group=&compress=0&ie=utf-8&oe=utf-8&page=1&page_size=20')

- # print(comments.text)

- comments_total = json.loads(comments.text.strip('var data='))

- # print(comments_total)

- print(comments_total['result']['count']['total'])

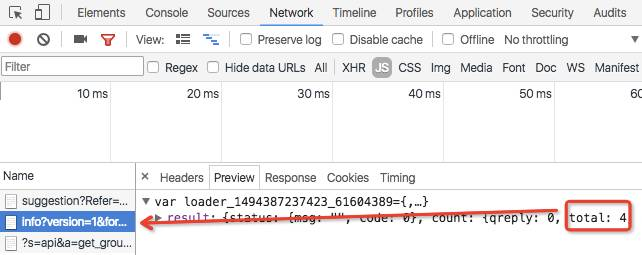

首先,我们先select('#commentCount1')来筛选出评论数,这时print下输出结果为[<span id="commentCount1"></span>],span中间为空白信息,没有我们想要的评论数。

这时,我们需要重新去观察下网页代码,发现评论数可能是通过JavaScript来增加上去的,那么我们需要找到是从哪里调用JavaScript(即JS)的。

鼠标放在评论数(4)上,Google浏览器鼠标右键点击“检查”,选择顶部的network,然后在下面海量的链接里找到有数量4的链接。

复制该链接,中间加粗部分是newid,最后有一段像时间戳的字串“&jsvar=loader_1494295822737_91802706”,我们需要把这块内容去掉,然后试着print下,可以发现结果也不会有影响。

- http://comment5.news.sina.com.cn/page/info?version=1&format=js&channel=gn&newsid=comos-fyeycfp9368908&group=&compress=0&ie=utf-8&oe=utf-8&page=1&page_size=20&jsvar=loader_1494295822737_91802706

处理好链接后,那么,我们该如何从JavaScript中读取数据呢?这时我们需要使用到json来处理,在开头,我们导入库的时候已经import json了,这里可以直接使用。

json.loads是用于解码json数据的。第5行,我们将解码后的数据存储在变量comments_total中;第6行,我们print该变量时,会得到结果,发现除了评论数之外,还有一些其他的信息。

所以我们需要重新输出,根据上一行print的结果,观察发现,最后一行我们可以用['result']['count']['total']来表示评论数的位置。

7. 抓取新闻ID:

- 1 print(news_url.split('/')[-1].rstrip('.shtml').lstrip('doc-i'))

刚在上面第6点抓取评论数时,我们发现链接中有一个newsid,该新闻页面的链接中也有相同的ID部分,这时我们可以明确其新闻ID的位置。

split()是通过指定分隔符对字符串进行切片,[-1]是截取最后一个元素,然后用rstrip去除掉末尾的.shtml,用lstrip去除掉左侧的doc-i,得到我们想要的新闻ID。

除了这种方法外,我们还可以用正则表达式来表达。这时我们需要用到re库,在开头时,我们已经事先import re了,这里直接使用。

其中re.search是扫描整个字符串并返回第一个成功的匹配,group()是匹配到的字符串,其中group(0),是匹配到的字符串全部显示(doc-ifyeycfp9368908.shtml),group(1)是(.+)内的显示,即我们想要的新闻ID。

- 1 news_id = re.search('doc-i(.+).shtml',news_url)

- 2 # print(news_id.group(0))

- 3 print(news_id.group(1))

操作环境:Python版本,3.6;PyCharm版本,2016.2;电脑:Mac

----- End -----

(转自https://www.cnblogs.com/duwangdan/archive/2017/05/31/6923578.html)

【转】Python爬虫:抓取新浪新闻数据的更多相关文章

- Python爬虫:抓取新浪新闻数据

案例一 抓取对象: 新浪国内新闻(http://news.sina.com.cn/china/),该列表中的标题名称.时间.链接. 完整代码: from bs4 import BeautifulSou ...

- Python抓取新浪新闻数据(二)

以下是抓取的完整代码(抓取了网页的title,newssource,dt,article,editor,comments)举例: 转载于:https://blog.51cto.com/2290153/ ...

- Python爬虫抓取东方财富网股票数据并实现MySQL数据库存储

Python爬虫可以说是好玩又好用了.现想利用Python爬取网页股票数据保存到本地csv数据文件中,同时想把股票数据保存到MySQL数据库中.需求有了,剩下的就是实现了. 在开始之前,保证已经安装好 ...

- python3爬虫-爬取新浪新闻首页所有新闻标题

准备工作:安装requests和BeautifulSoup4.打开cmd,输入如下命令 pip install requests pip install BeautifulSoup4 打开我们要爬取的 ...

- php使用pthreads v3多线程的抓取新浪新闻信息

我们使用pthreads,来写一个多线程的抓取页面小程序,把结果存到数据库里. 数据表结构如下: CREATE TABLE `tb_sina` ( `id` int(11) unsigned NOT ...

- python3.4学习笔记(十四) 网络爬虫实例代码,抓取新浪爱彩双色球开奖数据实例

python3.4学习笔记(十四) 网络爬虫实例代码,抓取新浪爱彩双色球开奖数据实例 新浪爱彩双色球开奖数据URL:http://zst.aicai.com/ssq/openInfo/ 最终输出结果格 ...

- selenium+BeautifulSoup+phantomjs爬取新浪新闻

一 下载phantomjs,把phantomjs.exe的文件路径加到环境变量中,也可以phantomjs.exe拷贝到一个已存在的环境变量路径中,比如我用的anaconda,我把phantomjs. ...

- python 爬虫抓取心得

quanwei9958 转自 python 爬虫抓取心得分享 urllib.quote('要编码的字符串') 如果你要在url请求里面放入中文,对相应的中文进行编码的话,可以用: urllib.quo ...

- Python爬虫----抓取豆瓣电影Top250

有了上次利用python爬虫抓取糗事百科的经验,这次自己动手写了个爬虫抓取豆瓣电影Top250的简要信息. 1.观察url 首先观察一下网址的结构 http://movie.douban.com/to ...

随机推荐

- 【记录一次坑经历】axios使用x-www-form-urlencoded 服务器报400(错误的请求。 )(后端.Net MVC5 WebApi OAuth,前端Electron-Vue)

首先放上源码 electron-vue axios 注册 import Vue from 'vue' import axios from 'axios' axios.defaults.baseUR ...

- 杭电ACM2005--第几天?

第几天? Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Others)Total Submis ...

- [MySQL] 索引中的b树索引

1.索引如果没有特别指明类型,一般是说b树索引,b树索引使用b树数据结构存储数据,实际上很多存储引擎使用的是b+树,每一个叶子节点都包含指向下一个叶子节点的指针,从而方便叶子节点的范围遍历 2.底层的 ...

- 2019年10个最受欢迎的JavaScript动画库!

摘要: 非常炫酷的动画库! 原文:值得看看,2019 年 11 个受欢迎的 JavaScript 动画库! 作者:前端小智 Fundebug经授权转载,版权归原作者所有. 1. Three.js 超过 ...

- es6 Moduel 默认名与非默认名

export default default 本质是将后面变量(值)赋给 default,然后以default名称输出. import 在获取default变量时,写在大括号的外面 ,可自定义名称. ...

- Js与jQuery的相互转换

$()与jQuery() jQuery中$函数,根据传入参数的不同,进行不同的调用,实现不同的功能.返回的是jQuery对象 jQuery这个js库,除了$之外,还提供了另外一个函数:jQuery j ...

- js中slice,SubString和SubStr的区别

来自:https://blog.csdn.net/qq_37120738/article/details/79086706 侵删 slice() 定义和用法 slice() 方法可从已有的数组中返回选 ...

- Python 通过脚本获取Android的apk的部分属性,再通过加密算法生成秘钥。

Python 通过脚本获取Android的apk的部分属性,再通过加密算法生成秘钥. #!/usr/bin/env python # -*- coding: utf- -*- import os im ...

- Android 反射获取一个方法(方法的参数不一样)

private Method forget; private Method connect_netID; private Method connect_wifiConfig; private Meth ...

- MySQL InnoDB下关于MVCC的一个问题的分析

这个是网友++C++在群里问的一个关于MySQL的问题,本篇文章实验测试环境为MySQL 5.6.20,事务隔离级别为REPEATABLE-READ ,在演示问题前,我们先准备测试环境.准备一个测 ...