Hive SQL 分类

题目:

请使用Hive SQL实现下面的题目。

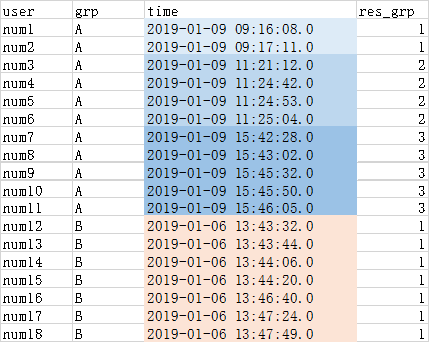

下面是一张表名为user_buy_log的表,有三个字段,user(用户),grp(分组编号),time(购物时间)。

需要将用户按照grp分组,对time进行升序排序,

如果用户间购物时间间隔小于5分钟,则认为是一个小团体,标号为1;

如果时间间隔大于5分,标号开始累加1。

|

user |

grp |

time |

|

num15 |

B |

2019-01-06 13:44:20.0 |

|

num17 |

B |

2019-01-06 13:47:24.0 |

|

num10 |

A |

2019-01-09 15:45:50.0 |

|

num18 |

B |

2019-01-06 13:47:49.0 |

|

num16 |

B |

2019-01-06 13:46:40.0 |

|

num3 |

A |

2019-01-09 11:21:12.0 |

|

num4 |

A |

2019-01-09 11:24:42.0 |

|

num1 |

A |

2019-01-09 09:16:08.0 |

|

num12 |

B |

2019-01-06 13:43:32.0 |

|

num13 |

B |

2019-01-06 13:43:44.0 |

|

num2 |

A |

2019-01-09 09:17:11.0 |

|

num7 |

A |

2019-01-09 15:42:28.0 |

|

num11 |

A |

2019-01-09 15:46:05.0 |

|

num5 |

A |

2019-01-09 11:24:53.0 |

|

num9 |

A |

2019-01-09 15:45:32.0 |

|

num8 |

A |

2019-01-09 15:43:02.0 |

|

num6 |

A |

2019-01-09 11:25:04.0 |

|

num14 |

B |

2019-01-06 13:44:06.0 |

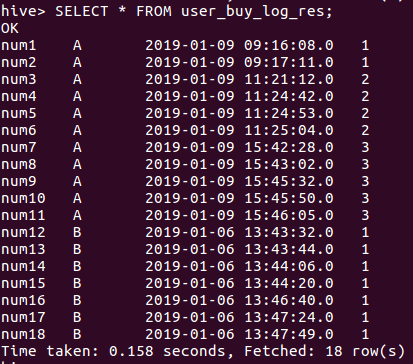

最终输出结果表名:user_buy_log_res,结果如下:

结果解析:

由于num1,num2时间间隔小于5分钟,而且他们是组A的最开始的分组,因此组号(res_grp)为1。

由于num3与num2的时间间隔超过5分钟,因此num3的组号(res_grp)开始累加,因此(res_grp)为2。

Num7跟num6的间隔超过5分钟,num7组号(res_grp)开始再次累加,因此(res_grp)为3。

num12是属于新的分组B,因此其(res_grp)重新从1开始编号,因为后续用户的购物时间间隔都小于5分钟,因此编号没有再累加。

解决办法:

set hive.support.sql11.reserved.keywords=false;

create database tab

use tab

create table user_buy_log (user string, grp string,time string)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY '\t'

STORED AS TEXTFILE;

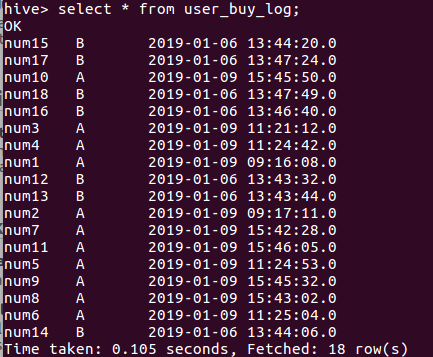

load data local inpath '/home/hadoop/Desktop/user_buy_log.txt' into table user_buy_log;

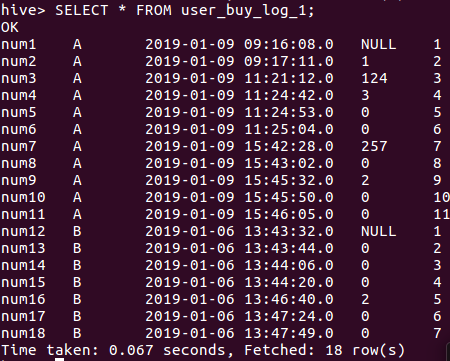

CREATE TABLE user_buy_log_1 AS

SELECT user,grp,time,

CAST(( UNIX_TIMESTAMP(time)-UNIX_TIMESTAMP(lag(time) over(PARTITION BY grp ORDER BY time ASC)))/60 AS INT) period,

row_number() over (PARTITION BY grp ORDER BY time ASC) AS row_num

FROM user_buy_log;

SELECT * FROM user_buy_log_1;

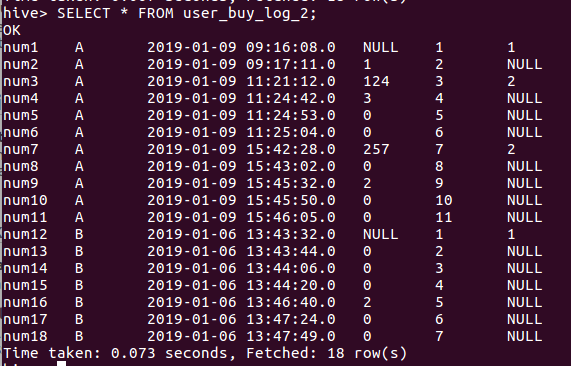

CREATE TABLE user_buy_log_2 AS

SELECT user,grp,time, period , row_num,CASE

WHEN period > 5 THEN 2

WHEN period is null THEN 1

ELSE NULL

END

AS res_grp

FROM user_buy_log_1;

SELECT * FROM user_buy_log_2;

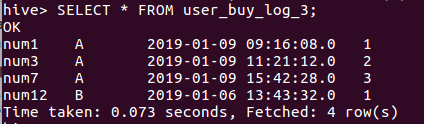

CREATE TABLE user_buy_log_3 AS

SELECT user,grp,time,row_number() over (PARTITION BY grp ORDER BY time ASC) AS row_num

FROM user_buy_log_2

WHERE res_grp is not null;

SELECT * FROM user_buy_log_3;

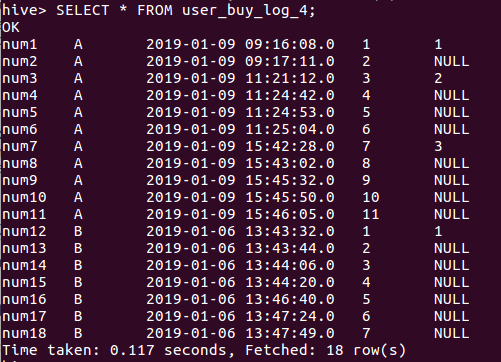

CREATE TABLE user_buy_log_4 AS

SELECT t2.user,t2.grp,t2.time,t2.row_num,t3.row_num AS res_grp

FROM user_buy_log_2 t2

LEFT JOIN user_buy_log_3 t3

ON t2.user = t3.user;

SELECT * FROM user_buy_log_4;

CREATE TABLE user_buy_log_res AS

SELECT user,grp,time,

MAX(res_grp) over(PARTITION BY grp ORDER BY time ASC) AS res_grp

FROM user_buy_log_4;

SELECT * FROM user_buy_log_res;

所有代码:

set hive.support.sql11.reserved.keywords=false; create database tab use tab create table user_buy_log (user string, grp string,time string)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY '\t'

STORED AS TEXTFILE; load data local inpath '/home/hadoop/Desktop/user_buy_log.txt' into table user_buy_log; CREATE TABLE user_buy_log_1 AS

SELECT user,grp,time,

CAST(( UNIX_TIMESTAMP(time)-UNIX_TIMESTAMP(lag(time) over(PARTITION BY grp ORDER BY time ASC)))/60 AS INT) period,

row_number() over (PARTITION BY grp ORDER BY time ASC) AS row_num

FROM user_buy_log; SELECT * FROM user_buy_log_1; CREATE TABLE user_buy_log_2 AS

SELECT user,grp,time, period , row_num,CASE

WHEN period > 5 THEN 2

WHEN period is null THEN 1

ELSE NULL

END

AS res_grp

FROM user_buy_log_1; SELECT * FROM user_buy_log_2; CREATE TABLE user_buy_log_3 AS

SELECT user,grp,time,row_number() over (PARTITION BY grp ORDER BY time ASC) AS row_num

FROM user_buy_log_2

WHERE res_grp is not null; SELECT * FROM user_buy_log_3; CREATE TABLE user_buy_log_4 AS

SELECT t2.user,t2.grp,t2.time,t2.row_num,t3.row_num AS res_grp

FROM user_buy_log_2 t2

LEFT JOIN user_buy_log_3 t3

ON t2.user = t3.user; SELECT * FROM user_buy_log_4; CREATE TABLE user_buy_log_res AS

SELECT user,grp,time,

MAX(res_grp) over(PARTITION BY grp ORDER BY time ASC) AS res_grp

FROM user_buy_log_4; SELECT * FROM user_buy_log_res;

user_buy_log.txt

num15 B 2019-01-06 13:44:20.0

num17 B 2019-01-06 13:47:24.0

num10 A 2019-01-09 15:45:50.0

num18 B 2019-01-06 13:47:49.0

num16 B 2019-01-06 13:46:40.0

num3 A 2019-01-09 11:21:12.0

num4 A 2019-01-09 11:24:42.0

num1 A 2019-01-09 09:16:08.0

num12 B 2019-01-06 13:43:32.0

num13 B 2019-01-06 13:43:44.0

num2 A 2019-01-09 09:17:11.0

num7 A 2019-01-09 15:42:28.0

num11 A 2019-01-09 15:46:05.0

num5 A 2019-01-09 11:24:53.0

num9 A 2019-01-09 15:45:32.0

num8 A 2019-01-09 15:43:02.0

num6 A 2019-01-09 11:25:04.0

num14 B 2019-01-06 13:44:06.0

Hive SQL 分类的更多相关文章

- 【甘道夫】使用HIVE SQL实现推荐系统数据补全

需求 在推荐系统场景中,假设基础行为数据太少,或者过于稀疏,通过推荐算法计算得出的推荐结果非常可能达不到要求的数量. 比方,希望针对每一个item或user推荐20个item,可是通过计算仅仅得到8个 ...

- Hive sql函数

date: 2018-11-16 19:03:08 updated: 2018-11-16 19:03:08 Hive sql函数 一.关系运算 等值比较: = select 1 from dual ...

- 最强最全面的Hive SQL开发指南,超四万字全面解析

本文整体分为两部分,第一部分是简写,如果能看懂会用,就直接从此部分查,方便快捷,如果不是很理解此SQL的用法,则查看第二部分,是详细说明,当然第二部分语句也会更全一些! 第一部分: hive模糊搜索表 ...

- 【hive】——Hive sql语法详解

Hive 是基于Hadoop 构建的一套数据仓库分析系统,它提供了丰富的SQL查询方式来分析存储在Hadoop 分布式文件系统中的数据,可以将结构 化的数据文件映射为一张数据库表,并提供完整的SQL查 ...

- Hive SQL 监控系统 - Hive Falcon

1.概述 在开发工作当中,提交 Hadoop 任务,任务的运行详情,这是我们所关心的,当业务并不复杂的时候,我们可以使用 Hadoop 提供的命令工具去管理 YARN 中的任务.在编写 Hive SQ ...

- hive sql 语法详解

Hive 是基于Hadoop 构建的一套数据仓库分析系统,它提供了丰富的SQL查询方式来分析存储在Hadoop 分布式文件系统中的数据,可以将结构 化的数据文件映射为一张数据库表,并提供完整的SQL查 ...

- Hive sql 语法解读

一. 创建表 在官方的wiki里,example是这种: Sql代码 CREATE [EXTERNAL] TABLE [IF NOT EXISTS] table_name [(col_name d ...

- Spark(Hive) SQL中UDF的使用(Python)

相对于使用MapReduce或者Spark Application的方式进行数据分析,使用Hive SQL或Spark SQL能为我们省去不少的代码工作量,而Hive SQL或Spark SQL本身内 ...

- Spark(Hive) SQL数据类型使用详解(Python)

Spark SQL使用时需要有若干“表”的存在,这些“表”可以来自于Hive,也可以来自“临时表”.如果“表”来自于Hive,它的模式(列名.列类型等)在创建时已经确定,一般情况下我们直接通过Spar ...

随机推荐

- 用kali执行arp攻击-----------使对方断网

实现原理 其主要原理是局域网内的"攻击机"通过冒充同网络号下的"受害者主机"的物理地址(mac地址),通过欺骗网关,让网关原来应该发给"受害者主机&q ...

- Docker:测试环境的准备-centos7上安装docker

Dockers官方部署文档:https://docs.docker.com/install/linux/docker-ce/centos/ 1.建议先关闭 selinux (selinux是 linu ...

- Scrapy案例01-爬取传智播客主页上的老师信息

目录 1. 新建scrapy项目 2. 爬虫文件: 2.1. 查看需要爬取内容存在哪里: 2.2. 设置item需要保存的数据变量 2.3. 创建爬虫文件 2.4. 保存数据 2.5. yield的用 ...

- Java多线程与并发相关问题

1.什么是线程? 2.线程和进程有什么区别? 3.如何在Java中实现线程? 4.Java关键字volatile与synchronized作用与区别? volatile修饰的变量不保留拷贝,直接访问主 ...

- jsplumb 中文基础教程

jsplumb 中文基础教程 https://github.com/wangduanduan/jsplumb-chinese-tutorial

- python3 Counter模块

from collections import Counter c = Counter("周周周周都方法及")print(c)print(type(c))print('__iter ...

- Guava Cache探索及spring项目整合GuavaCache实例

背景 对于高频访问但是低频更新的数据我们一般会做缓存,尤其是在并发量比较高的业务里,原始的手段我们可以使用HashMap或者ConcurrentHashMap来存储. 这样没什么毛病,但是会面临一个问 ...

- Java面试准备之多线程

什么叫线程安全?举例说明 多个线程访问某个类时,不管运行时环境采用何种调度方式或者这些线程将如何交替执行,并且在主调代码中不需要任何额外的同步或者协同,这个类都能表现出正确的行为,那么就称这个类是线程 ...

- js把变量转换成json数据

var a="";var MessageList=JSON.stringify(a);

- 好坑吖,几乎GG,关于Nginx和supervisor的配置

从没想过部署个站点居然这么费劲.这还是搞了好多回且环境都具备的前提一下. 不过问题还是挺刁钻的,下面详细说一下. 1.net core编译少dll文件问题 发布到服务器上执行dotnet FileSe ...