Linear Regression Using Gradient Descent 代码实现

参考吴恩达<机器学习>, 进行 Octave, Python(Numpy), C++(Eigen) 的原理实现, 同时用 scikit-learn, TensorFlow, dlib 进行生产环境实现.

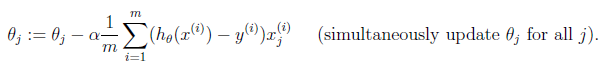

1. 原理

cost function

gradient descent

2. 原理实现

octave

cost function

function J = costFunction(X, Y, theta)

m = size(X, );

predictions = X * theta;

sqrErrors = (predictions - Y) .^ ;

J = / ( * m) * sum(sqrErrors);

Linear regression using gradient descent

function [final_theta, Js] = gradientDescent(X, Y, init_theta, learning_rate=0.01, max_times=)

convergence = ;

m = size(X, );

tmp_theta = init_theta;

Js = zeros(m, 1); for i=:max_times,

tmp = learning_rate / m * ((X * tmp_theta - Y)' * X)';

tmp_theta -= tmp;

Js(i) = costFunction(X, Y, tmp_theta);

end; final_theta = tmp_theta;

python

# -*- coding:utf8 -*-

import numpy as np

import matplotlib.pyplot as plt def cost_function(input_X, _y, theta):

"""

cost function

:param input_X: np.matrix input X

:param _y: np.array y

:param theta: np.matrix theta

:return: float

"""

rows, cols = input_X.shape

predictions = input_X * theta

sqrErrors = np.array(predictions - _y) ** 2

J = 1.0 / (2 * rows) * sqrErrors.sum() return J def gradient_descent(input_X, _y, theta, learning_rate=0.1,

iterate_times=3000):

"""

gradient descent

:param input_X: np.matrix input X

:param _y: np.array y

:param theta: np.matrix theta

:param learning_rate: float learning rate

:param iterate_times: int max iteration times

:return: tuple

"""

convergence = 0

rows, cols = input_X.shape

Js = [] for i in range(iterate_times):

errors = input_X * theta - _y

delta = 1.0 / rows * (errors.transpose() * input_X).transpose()

theta -= learning_rate * delta

Js.append(cost_function(input_X, _y, theta)) return theta, Js def generate_data():

"""

generate training data y = 2*x^2 + 4*x + 2

"""

x = np.linspace(0, 2, 50)

X = np.matrix([np.ones(50), x, x**2]).T

y = 2 * X[:, 0] - 4 * X[:, 1] + 2 * X[:, 2] + np.mat(np.random.randn(50)).T / 25

np.savetxt('linear_regression_using_gradient_descent.csv',

np.column_stack((X, y)), delimiter=',') def test():

"""

main

:return: None

"""

m = np.loadtxt('linear_regression_using_gradient_descent.csv', delimiter=',')

input_X, y = np.asmatrix(m[:, :-1]), np.asmatrix(m[:, -1]).T

# theta 的初始值必须是 float

theta = np.matrix([[0.0], [0.0], [0.0]])

final_theta, Js = gradient_descent(input_X, y, theta) t1, t2, t3 = np.array(final_theta).reshape(-1,).tolist()

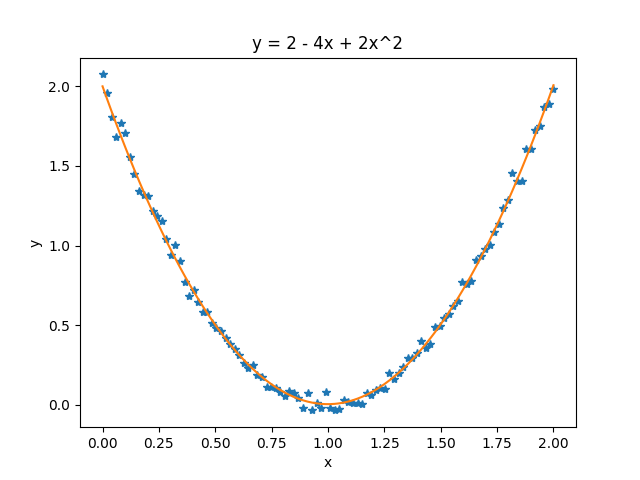

print('对测试数据 y = 2 - 4x + 2x^2 求得的参数为: %.3f, %.3f, %.3f\n' % (t1, t2, t3)) plt.figure('theta')

predictions = np.array(input_X * final_theta).reshape(-1,).tolist()

x1 = np.array(input_X[:, 1]).reshape(-1,).tolist()

y1 = np.array(y).reshape(-1,).tolist()

plt.plot(x1, y1, '*')

plt.plot(x1, predictions)

plt.xlabel('x')

plt.ylabel('y')

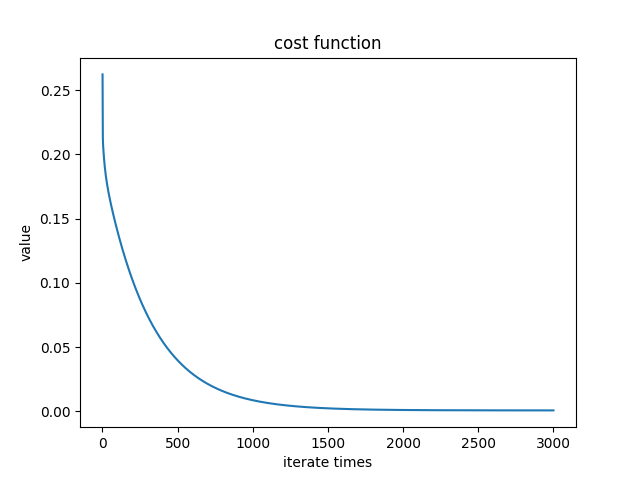

plt.title('y = 2 - 4x + 2x^2') plt.figure('cost')

x2 = range(1, len(Js) + 1)

y2 = Js

plt.plot(x2, y2)

plt.xlabel('iterate times')

plt.ylabel('value')

plt.title('cost function') plt.show() if __name__ == '__main__':

test()

Python 中需要注意的是, numpy.array, numpy.matrix 和 list 等进行计算时, 有时会进行默认类型转换, 默认类型转换的结果, 往往不是期望的情况.

theta 的初始值必须是 float, 因为如果是 int, 则在更新 theta 时会报错.

测试数据:

Cost function:

c++

#include <iostream>

#include <vector>

#include <Eigen/Dense> using namespace Eigen;

using namespace std; double cost_function(MatrixXd &input_X, MatrixXd &_y, MatrixXd &theta) {

double rows = input_X.rows();

MatrixXd predictions = input_X * theta;

ArrayXd sqrErrors = (predictions - _y).array().square();

double J = 1.0 / ( * rows) * sqrErrors.sum(); return J;

} class Gradient_descent {

public:

Gradient_descent(MatrixXd &x, MatrixXd &y, MatrixXd &t,

double r=0.1, int m=): input_X(x), _y(y), theta(t),

learning_rate(r), iterate_times(m){}

MatrixXd theta;

vector<double> Js;

void run();

private:

MatrixXd input_X;

MatrixXd _y;

double rows;

double learning_rate;

int iterate_times;

}; void Gradient_descent::run() {

double rows = input_X.rows();

for(int i=; i < iterate_times; ++i) {

MatrixXd errors = input_X * theta - _y;

MatrixXd delta = 1.0 / rows * (errors.transpose() * input_X).transpose();

theta -= learning_rate * delta;

double J = cost_function(input_X, _y, theta);

Js.push_back(J);

}

} void generate_data(MatrixXd &input_X, MatrixXd &y) {

ArrayXd v = ArrayXd::LinSpaced(, , );

input_X.col() = VectorXd::Constant(, , );

input_X.col() = v.matrix();

input_X.col() = v.square().matrix();

y.col() = * input_X.col() - * input_X.col() + * input_X.col();

y.col() += VectorXd::Random() / ;

} int main() {

MatrixXd input_X(, ), y(, );

MatrixXd theta = MatrixXd::Zero(, );

generate_data(input_X, y);

Gradient_descent gd(input_X, y, theta);

gd.run();

cout << gd.theta << endl;

}

3. 生产环境

Python (Scikit-learn)

todo

Python (TensorFlow)

todo

C++ (dlib)

todo

Linear Regression Using Gradient Descent 代码实现的更多相关文章

- 线性回归、梯度下降(Linear Regression、Gradient Descent)

转载请注明出自BYRans博客:http://www.cnblogs.com/BYRans/ 实例 首先举个例子,假设我们有一个二手房交易记录的数据集,已知房屋面积.卧室数量和房屋的交易价格,如下表: ...

- 斯坦福机器学习视频笔记 Week1 Linear Regression and Gradient Descent

最近开始学习Coursera上的斯坦福机器学习视频,我是刚刚接触机器学习,对此比较感兴趣:准备将我的学习笔记写下来, 作为我每天学习的签到吧,也希望和各位朋友交流学习. 这一系列的博客,我会不定期的更 ...

- 斯坦福机器学习视频笔记 Week1 线性回归和梯度下降 Linear Regression and Gradient Descent

最近开始学习Coursera上的斯坦福机器学习视频,我是刚刚接触机器学习,对此比较感兴趣:准备将我的学习笔记写下来, 作为我每天学习的签到吧,也希望和各位朋友交流学习. 这一系列的博客,我会不定期的更 ...

- Linear Regression and Gradient Descent

随着所学算法的增多,加之使用次数的增多,不时对之前所学的算法有新的理解.这篇博文是在2018年4月17日再次编辑,将之前的3篇博文合并为一篇. 1.Problem and Loss Function ...

- Linear Regression and Gradient Descent (English version)

1.Problem and Loss Function Linear Regression is a Supervised Learning Algorithm with input matrix ...

- Logistic Regression and Gradient Descent

Logistic Regression and Gradient Descent Logistic regression is an excellent tool to know for classi ...

- Logistic Regression Using Gradient Descent -- Binary Classification 代码实现

1. 原理 Cost function Theta 2. Python # -*- coding:utf8 -*- import numpy as np import matplotlib.pyplo ...

- flink 批量梯度下降算法线性回归参数求解(Linear Regression with BGD(batch gradient descent) )

1.线性回归 假设线性函数如下: 假设我们有10个样本x1,y1),(x2,y2).....(x10,y10),求解目标就是根据多个样本求解theta0和theta1的最优值. 什么样的θ最好的呢?最 ...

- machine learning (7)---normal equation相对于gradient descent而言求解linear regression问题的另一种方式

Normal equation: 一种用来linear regression问题的求解Θ的方法,另一种可以是gradient descent 仅适用于linear regression问题的求解,对其 ...

随机推荐

- Ubuntu 14.04 DNS 配置

最近得到一个比较好用的DNS,每次重启后都修改DNS配置文件 /etc/resolv.conf 重启就会失效 从网上得知 /etc/resolv.conf中的DNS配置是从/etc/resolvcon ...

- 题目1006:ZOJ问题(递推规律)

题目链接:http://ac.jobdu.com/problem.php?pid=1006 详解链接:https://github.com/zpfbuaa/JobduInCPlusPlus 参考代码: ...

- Ajax提交表单时验证码自动验证 php后端验证码检测

本文通过源码展示如何实现表单提交前,验证码先检测正确性,不正确则不提交表单,更新验证码. 1.前端代码 index.html <!DOCTYPE html> <html> &l ...

- !important:element.style 覆盖样式问题

问题: 浏览器F12看到是这个样子. 但是我设置的样式是这样子. #iframe_close { width:750px; } 无论怎么设置样式,都无法覆盖掉element.style的样式,widt ...

- Linux下使用 xrandr 命令设置屏幕分辨率

最近在Linux下修改屏幕分辨率的时候,发现了一个非常有用的命令:xrandr 使用这个命令,可以方便的设置您显示器的的分辨率.尤其是当你使用了一些需要或者会自动改动您屏幕分辨率的程序以后. 您可以使 ...

- -bash: locate: command not found

部分版本的linux系统使用locate快速查找某文件路径会报以下错误: -bash: locate: command not found 其原因是没有安装mlocate这个包 安装:yum -y ...

- [MySQL]修改root密码的4种方法(以windows为例)

方法1: 用SET PASSWORD命令 首先登录MySQL. 格式:mysql> set password for 用户名@localhost = password('新密码'); 例子:my ...

- Docker学习计划三:Dockerfile 使用

我们使用 Dockerfile 定义镜像,依赖镜像来运行容器,因此 Dockerfile 是镜像和容器的关键,Dockerfile 可以非常容易的定义镜像内容 首先通过一张图来了解 Docker 镜像 ...

- Spark2 Dataset DataFrame空值null,NaN判断和处理

import org.apache.spark.sql.SparkSession import org.apache.spark.sql.Dataset import org.apache.spark ...

- K-means中的K值选择

关于如何选择Kmeans等聚类算法中的聚类中心个数,主要有以下方法(译自维基): 1. 最简单的方法:K≍sqrt(N/2) 2. 拐点法:把聚类结果的F-test值(类间Variance和全局Var ...