Spark Streaming之六:Transformations 普通的转换操作

与RDD类似,DStream也提供了自己的一系列操作方法,这些操作可以分成四类:

- Transformations 普通的转换操作

- Window Operations 窗口转换操作

- Join Operations 合并操作

- Output Operations 输出操作

2.2.3.1 普通的转换操作

普通的转换操作如下表所示:

|

转换 |

描述 |

|

map(func) |

源 DStream的每个元素通过函数func返回一个新的DStream。 |

|

flatMap(func) |

类似与map操作,不同的是每个输入元素可以被映射出0或者更多的输出元素。 |

|

filter(func) |

在源DSTREAM上选择Func函数返回仅为true的元素,最终返回一个新的DSTREAM 。 |

|

repartition(numPartitions) |

通过输入的参数numPartitions的值来改变DStream的分区大小。 |

|

union(otherStream) |

返回一个包含源DStream与其他 DStream的元素合并后的新DSTREAM。 |

|

count() |

对源DStream内部的所含有的RDD的元素数量进行计数,返回一个内部的RDD只包含一个元素的DStreaam。 |

|

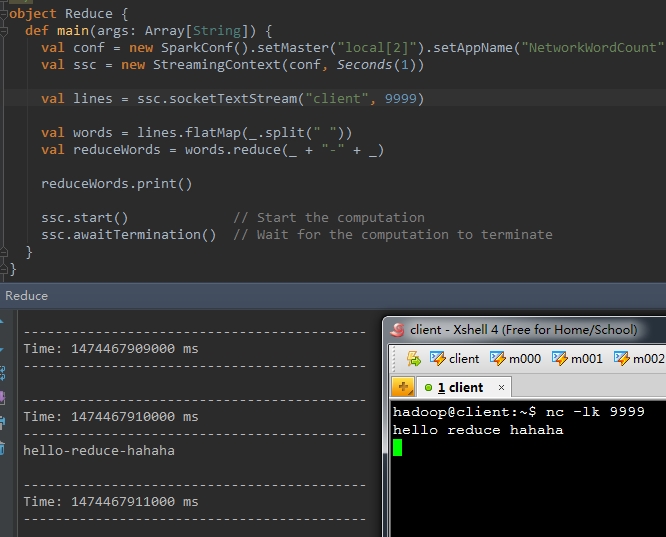

reduce(func) |

使用函数func(有两个参数并返回一个结果)将源DStream 中每个RDD的元素进行聚 合操作,返回一个内部所包含的RDD只有一个元素的新DStream。 |

|

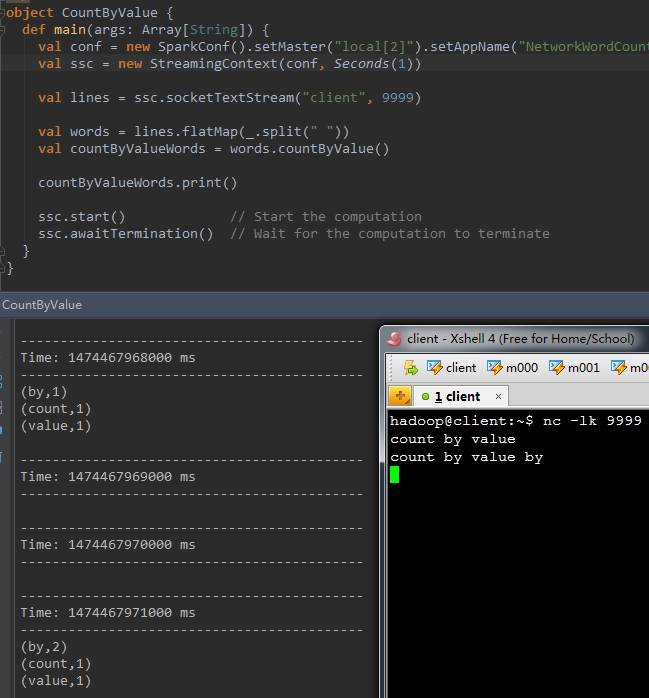

countByValue() |

计算DStream中每个RDD内的元素出现的频次并返回新的DStream[(K,Long)],其中K是RDD中元素的类型,Long是元素出现的频次。 |

|

reduceByKey(func, [numTasks]) |

当一个类型为(K,V)键值对的DStream被调用的时候,返回类型为类型为(K,V)键值对的新 DStream,其中每个键的值V都是使用聚合函数func汇总。注意:默认情况下,使用 Spark的默认并行度提交任务(本地模式下并行度为2,集群模式下位8),可以通过配置numTasks设置不同的并行任务数。 |

|

join(otherStream, [numTasks]) |

当被调用类型分别为(K,V)和(K,W)键值对的2个DStream 时,返回类型为(K,(V,W))键值对的一个新DSTREAM。 |

|

cogroup(otherStream, [numTasks]) |

当被调用的两个DStream分别含有(K, V) 和(K, W)键值对时,返回一个(K, Seq[V], Seq[W])类型的新的DStream。 |

|

transform(func) |

通过对源DStream的每RDD应用RDD-to-RDD函数返回一个新的DStream,这可以用来在DStream做任意RDD操作。 |

|

updateStateByKey(func) |

返回一个新状态的DStream,其中每个键的状态是根据键的前一个状态和键的新值应用给定函数func后的更新。这个方法可以被用来维持每个键的任何状态数据。 |

在上面列出的这些操作中,transform()方法和updateStateByKey()方法值得我们深入的探讨一下:

l transform(func)操作

该transform操作(转换操作)连同其其类似的 transformWith操作允许DStream 上应用任意RDD-to-RDD函数。它可以被应用于未在 DStream API 中暴露任何的RDD操作。例如,在每批次的数据流与另一数据集的连接功能不直接暴露在DStream API 中,但可以轻松地使用transform操作来做到这一点,这使得DStream的功能非常强大。例如,你可以通过连接预先计算的垃圾邮件信息的输入数据流(可能也有Spark生成的),然后基于此做实时数据清理的筛选,如下面官方提供的伪代码所示。事实上,也可以在transform方法中使用机器学习和图形计算的算法。

示例:

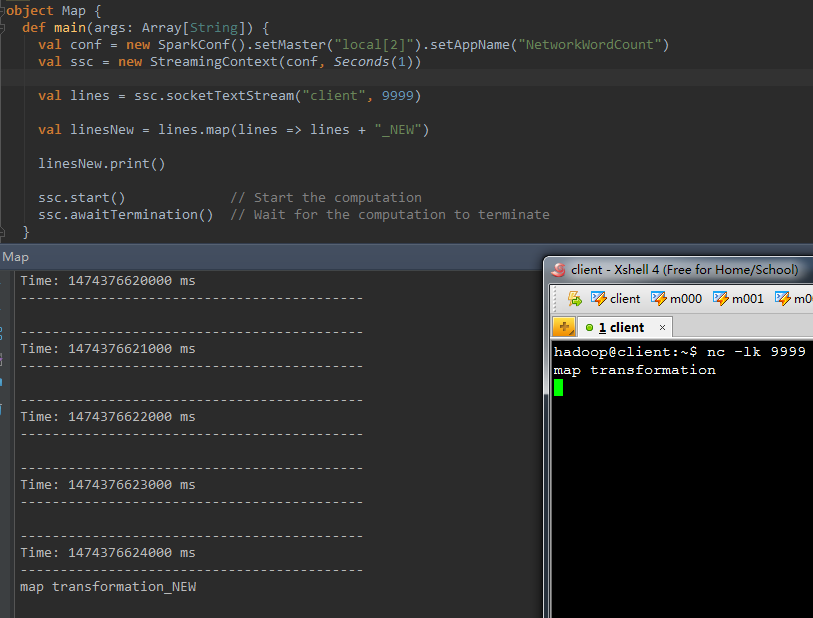

1、map(func)

val b = a.map(func)

val linesNew = lines.map(lines => lines + "_NEW" )

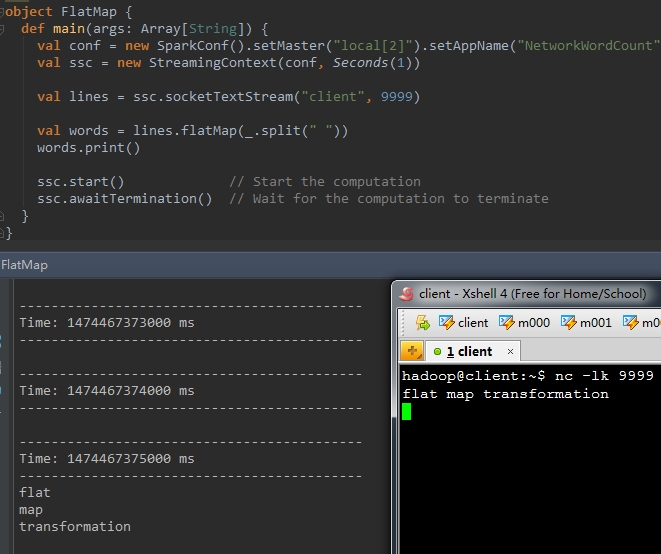

2、flatMap(func)

val b = a.flatMap(func)

val words = lines.flatMap(_.split( " " ))

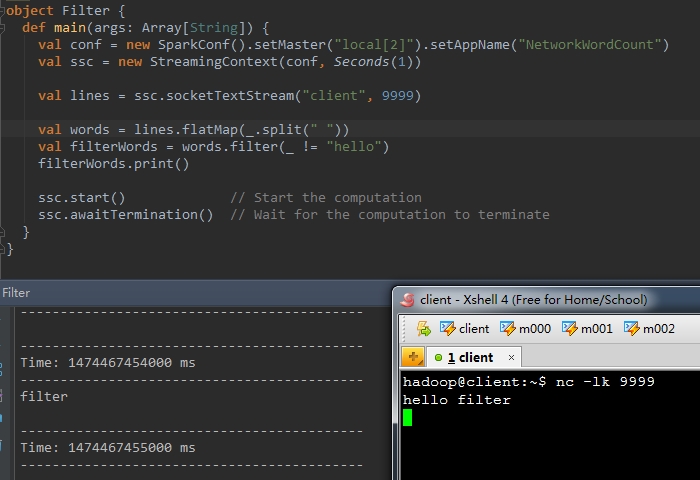

val b = a.filter(func)

val wordsOne = words.map(_ + "_one" )

val wordsTwo = words.map(_ + "_two" )

val unionWords = wordsOne.union(wordsTwo) wordsOne.print()

wordsTwo.print()

unionWords.print()

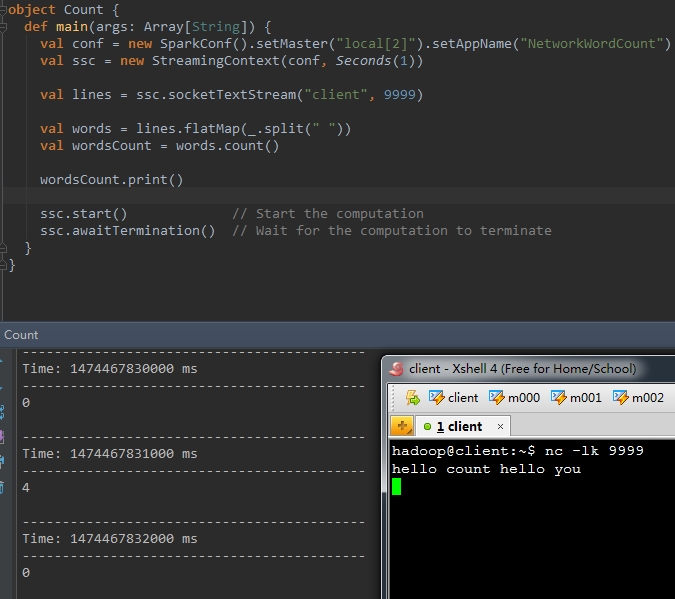

val wordsCount = words.count()

val reduceWords = words.reduce(_ + "-" + _)

val countByValueWords = words.countByValue()

val pairs = words.map(word => (word , 1))

val wordCounts = pairs.reduceByKey(_ + _)

val wordsOne = words.map(word => (word , word + "_one" ))

val wordsTwo = words.map(word => (word , word + "_two" ))

val joinWords = wordsOne.join(wordsTwo)

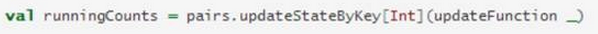

l updateStateByKey操作

该 updateStateByKey 操作可以让你保持任意状态,同时不断有新的信息进行更新。要使用此功能,必须进行两个步骤 :

(1) 定义状态 - 状态可以是任意的数据类型。

(2) 定义状态更新函数 - 用一个函数指定如何使用先前的状态和从输入流中获取的新值 更新状态。

让我们用一个例子来说明,假设你要进行文本数据流中单词计数。在这里,正在运行的计数是状态而且它是一个整数。我们定义了更新功能如下:

此函数应用于含有键值对的DStream中(如前面的示例中,在DStream中含有(word,1)键值对)。它会针对里面的每个元素(如wordCount中的word)调用一下更新函数,newValues是最新的值,runningCount是之前的值。

Spark Streaming之六:Transformations 普通的转换操作的更多相关文章

- Spark Streaming之一:整体介绍

提到Spark Streaming,我们不得不说一下BDAS(Berkeley Data Analytics Stack),这个伯克利大学提出的关于数据分析的软件栈.从它的视角来看,目前的大数据处理可 ...

- 初步了解Spark生态系统及Spark Streaming

一. 场景 ◆ Spark[4]: Scope: a MapReduce-like cluster computing framework designed for low-laten ...

- spark第六篇:Spark Streaming Programming Guide

预览 Spark Streaming是Spark核心API的扩展,支持高扩展,高吞吐量,实时数据流的容错流处理.数据可以从Kafka,Flume或TCP socket等许多来源获取,并且可以使用复杂的 ...

- Spark Streaming的编程模型

Spark Streaming的编程和Spark的编程如出一辙,对于编程的理解也非常类似.对于Spark来说,编程就是对于RDD的操作:而对于Spark Streaming来说,就是对DStream的 ...

- Spark Streaming:大规模流式数据处理的新贵(转)

原文链接:Spark Streaming:大规模流式数据处理的新贵 摘要:Spark Streaming是大规模流式数据处理的新贵,将流式计算分解成一系列短小的批处理作业.本文阐释了Spark Str ...

- Spark Streaming:大规模流式数据处理的新贵

转自:http://www.csdn.net/article/2014-01-28/2818282-Spark-Streaming-big-data 提到Spark Streaming,我们不得不说一 ...

- Spark Streaming之五:Window窗体相关操作

SparkStreaming之window滑动窗口应用,Spark Streaming提供了滑动窗口操作的支持,从而让我们可以对一个滑动窗口内的数据执行计算操作.每次掉落在窗口内的RDD的数据,会被聚 ...

- spark系列-8、Spark Streaming

参考链接:http://spark.apache.org/docs/latest/streaming-programming-guide.html 一.Spark Streaming 介绍 Spark ...

- Spark入门实战系列--7.Spark Streaming(上)--实时流计算Spark Streaming原理介绍

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .Spark Streaming简介 1.1 概述 Spark Streaming 是Spa ...

随机推荐

- windows7下cmd命令窗口没有滚动条的解救方法

由于昨天的好123问题没有解决,我想查看一下本机的ip地址等,于是打开了cmd窗口,输入ipconfig/all命令进行查看,但是发现出现了下面的窗口,无法进行滚动,完全无法查看详细的信息. 然后我百 ...

- linux c编程:Posix消息队列

Posix消息队列可以认为是一个消息链表. 有足够写权限的线程可以往队列中放置消息, 有足够读权限的线程可以从队列中取走消息 在某个进程往一个队列写入消息前, 并不需要另外某个进程在该队列上等待消息的 ...

- postgres=# psql -U postgres -h 127.0.0.1 -p 5432 -d dreamstart_dev -w

postgres=# psql -U postgres -h 127.0.0.1 -p 5432 -d dreamstart_dev -wpostgres-# \dNo relations found ...

- PHP的依赖管理工具----composer

安装Composer 参考:https://getcomposer.org/doc/01-basic-usage.md composer 是PHP依赖管理工具 PHP最低版本要求5.3.2,需要允许o ...

- spring+hibernate+springmvc整合框架搭建

搭建maven web项目这里不再讲述,详情请查看http://www.cnblogs.com/wql025/p/5215570.html 现在讲述项目的搭建过程. 1.通过maven导入项目所用的j ...

- shell编程3 ---流程控制语句

shell编程流程控制语句 一.if流程控制语句 1.单分支if条件判断语句 if [ 条件判断式 ]:then 或者 if[ 条件判断式 ] 程序 ...

- python利用wxpy监控微信公众号

此次利用wxpy可以进行微信公众号的消息推送监测(代码超级简单),这样能进行实时获取链接.但是不光会抓到公众号的消息,好友的消息也会抓到(以后会完善的,毕竟现在能用了,而且做项目的微信号肯定是没有好友 ...

- Ubuntu安装教程

http://www.linuxdiyf.com/linux/13198.html 简易配置说明 磁盘分区,新分区的磁盘必须是未分配的, 到管理-磁盘管理下面查看磁盘是不是未分配的,如果已分配了,在磁 ...

- Eclipse cdt mingw配置记录

本人下载的是Eclipse C/C++ IDE for Neon.3,下载页面是:http://www.eclipse.org/cdt/downloads.php. 1. 运行eclipse后,在He ...

- Java多线程系列 JUC线程池04 线程池原理解析(三)

转载 http://www.cnblogs.com/skywang12345/p/3509954.html https://blog.csdn.net/qq_22929803/article/det ...