【Spark】快来学习RDD的创建以及操作方式吧!

目录

RDD的创建

三种方式

从一个集合中创建

val rdd1 = sc.parallelize(Array(1,2,3,4,5,6,7,8))

从文件中创建

val rdd2 = sc.textFile("/words.txt")

从其他的RDD转化而来

val rdd3=rdd2.flatMap(_.split(" "))

RDD编程常用API

算子分类

Transformation

概述

Transformation —— 根据数据集创建一个新的数据集,计算后返回一个新的RDD,但不会直接返回计算结果,二是记住这些应用到数据集(例如一个文件)上的转换动作,只有当发生一个要求返回结果给Driver的动作是,这些转换才会真正运行。

帮助文档

http://spark.apache.org/docs/2.2.0/rdd-programming-guide.html#transformations

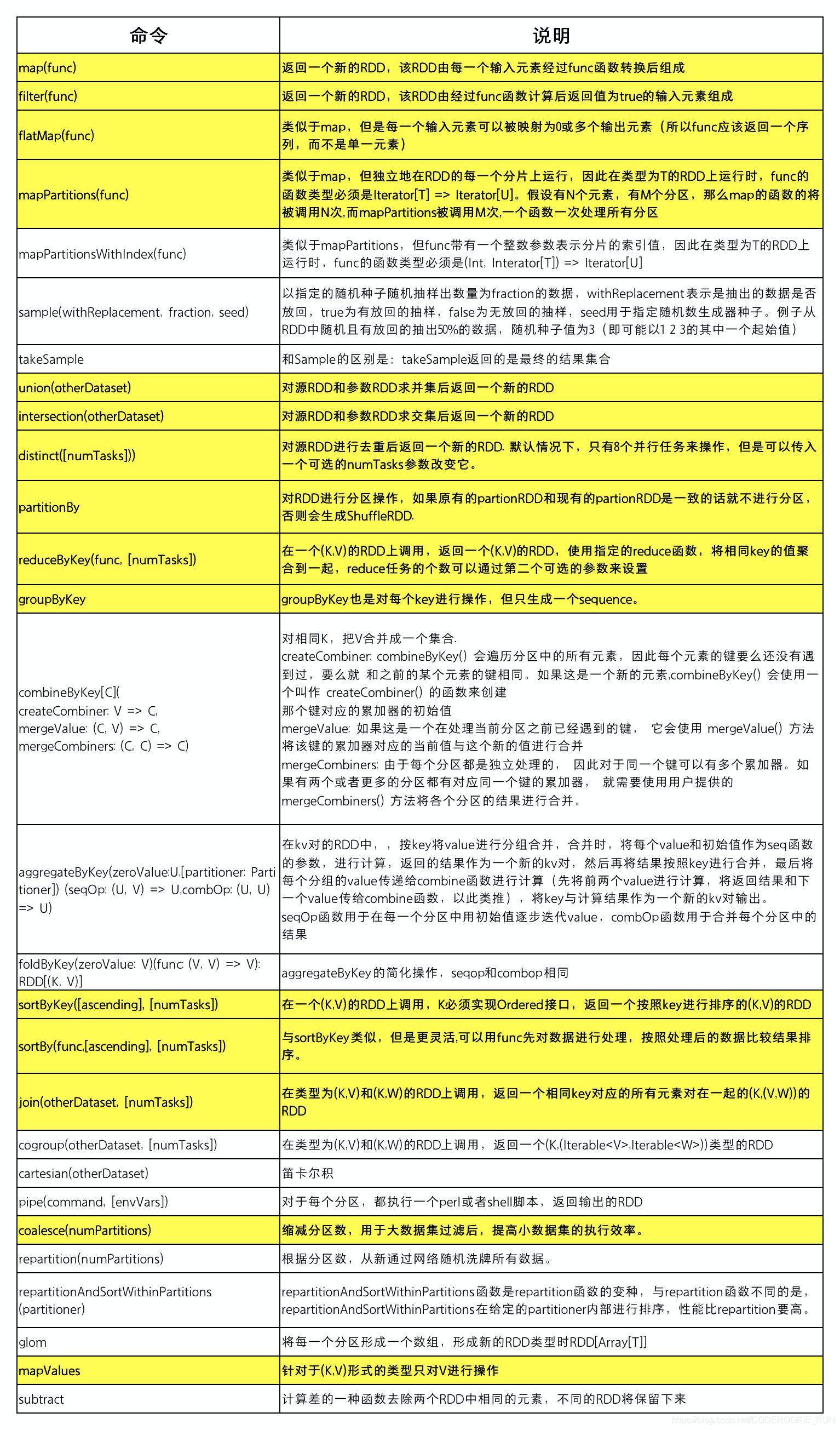

常用Transformation表

Transformation使用实例

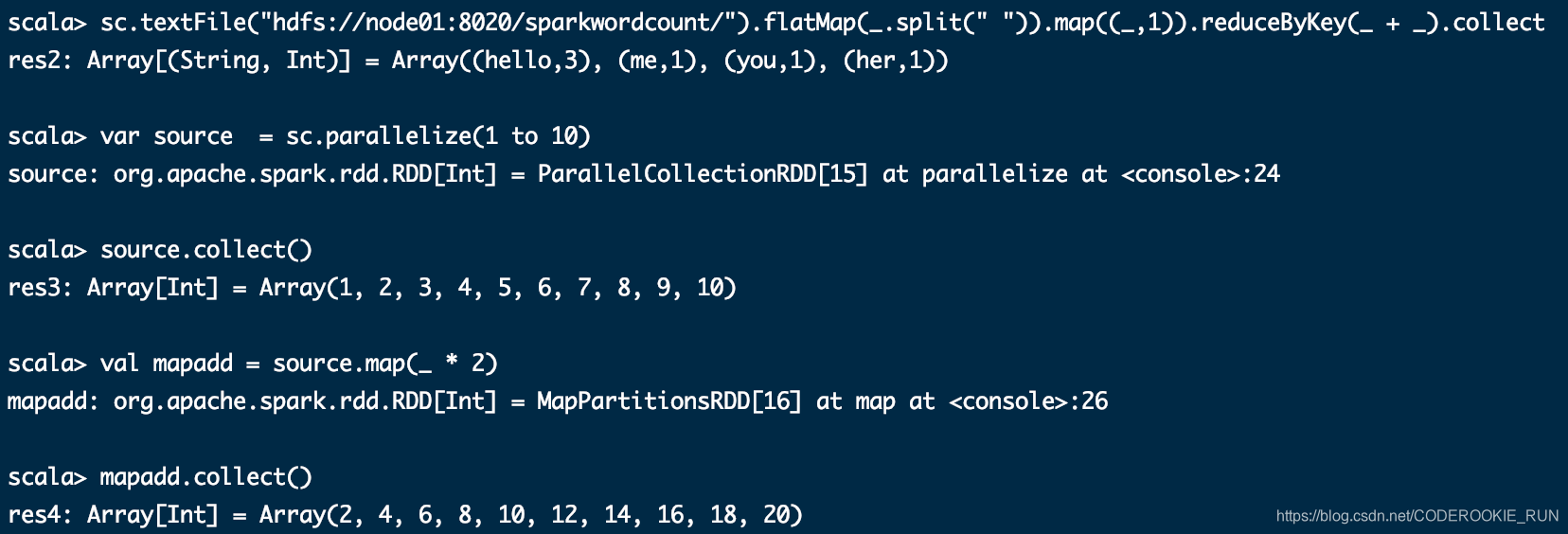

map(func)

将分区里面每一条数据取出来,进行处理

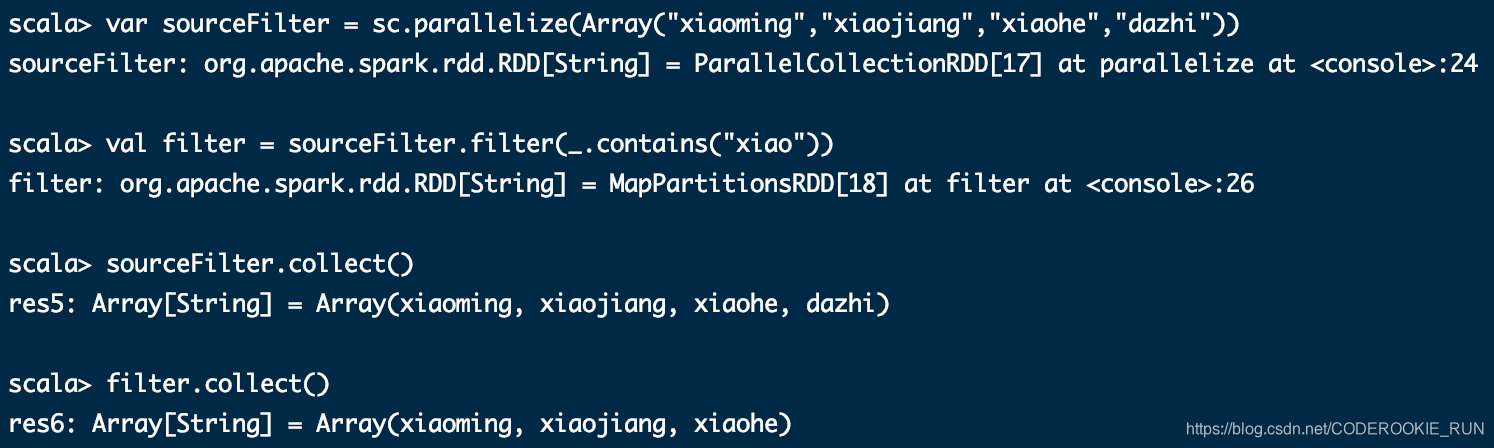

filter(func)

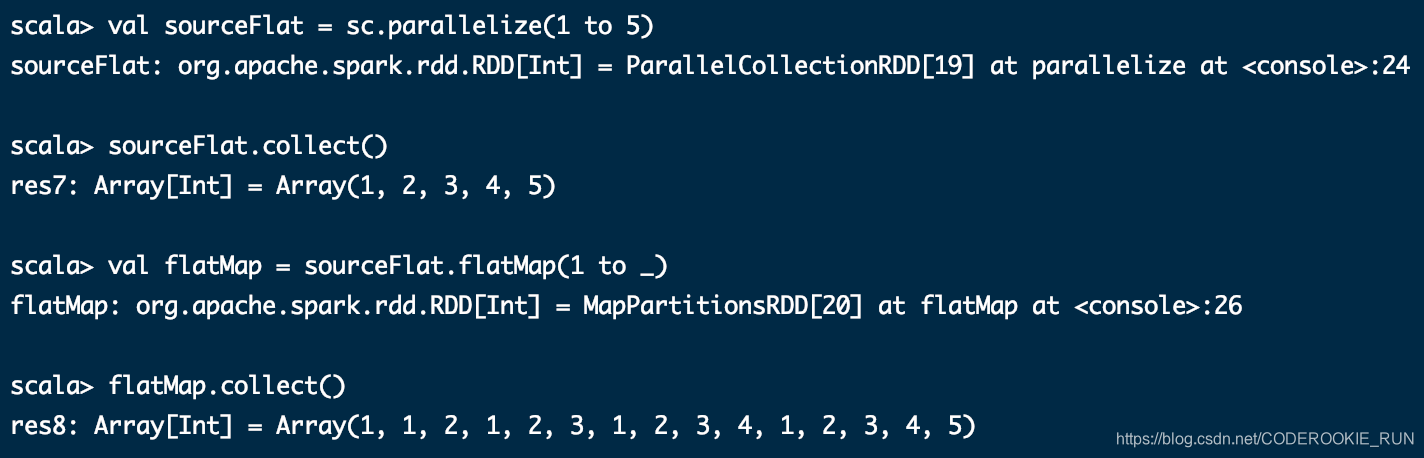

flatMap(func)

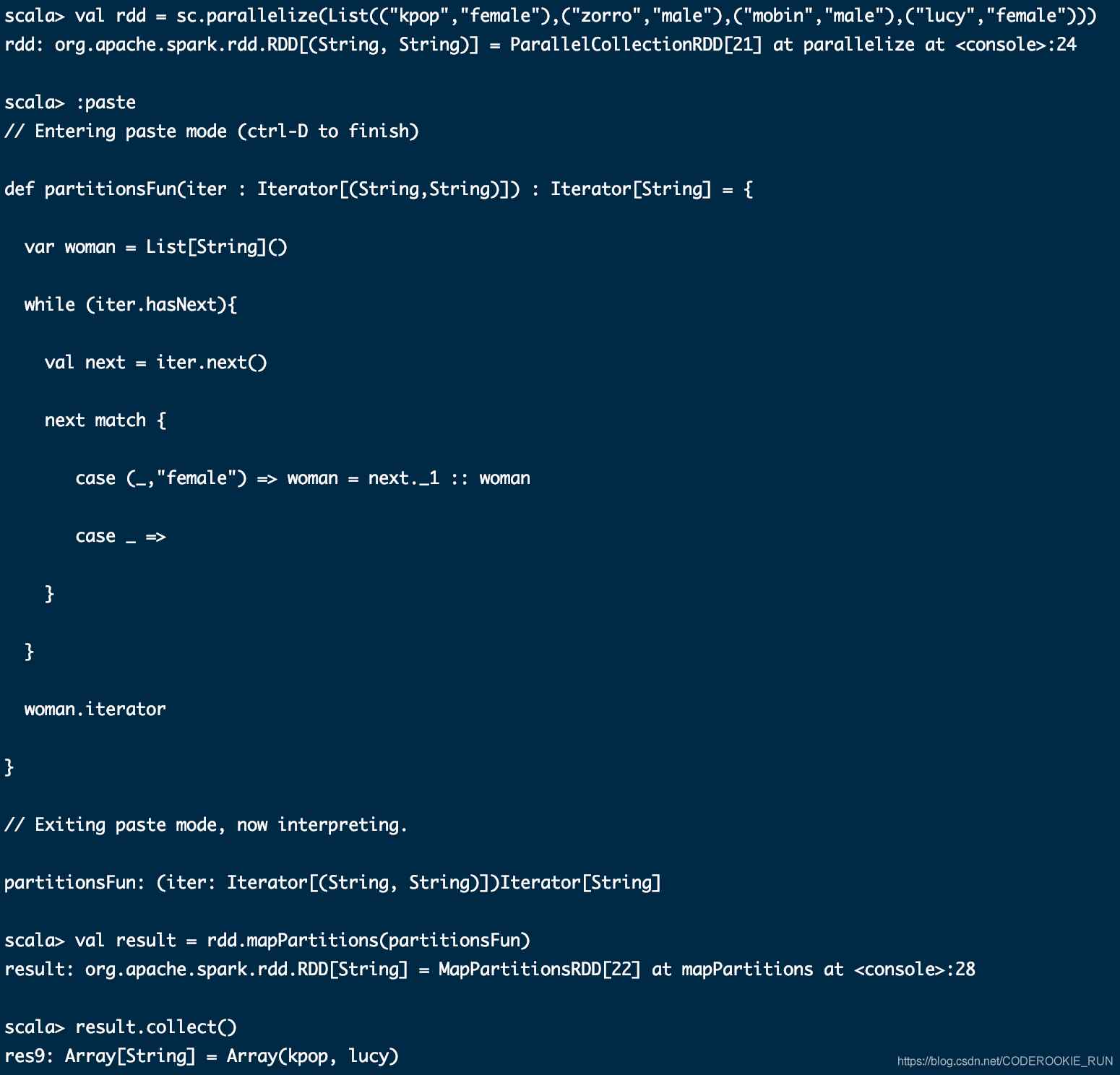

mapPartitions(func)

一次性将一个分区里面的数据全部取出来。效率更高

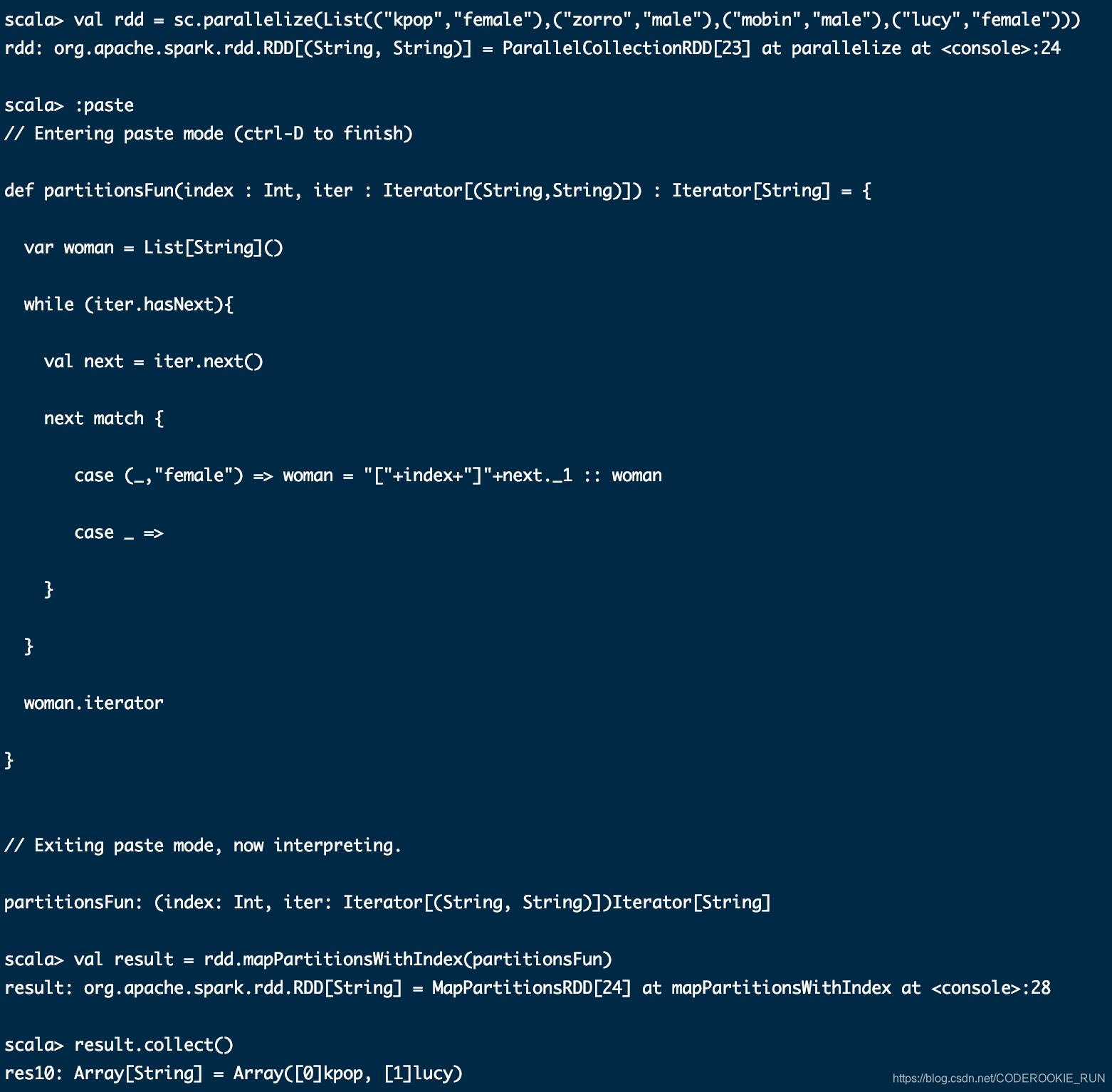

mapPartitionsWithIndex(func)

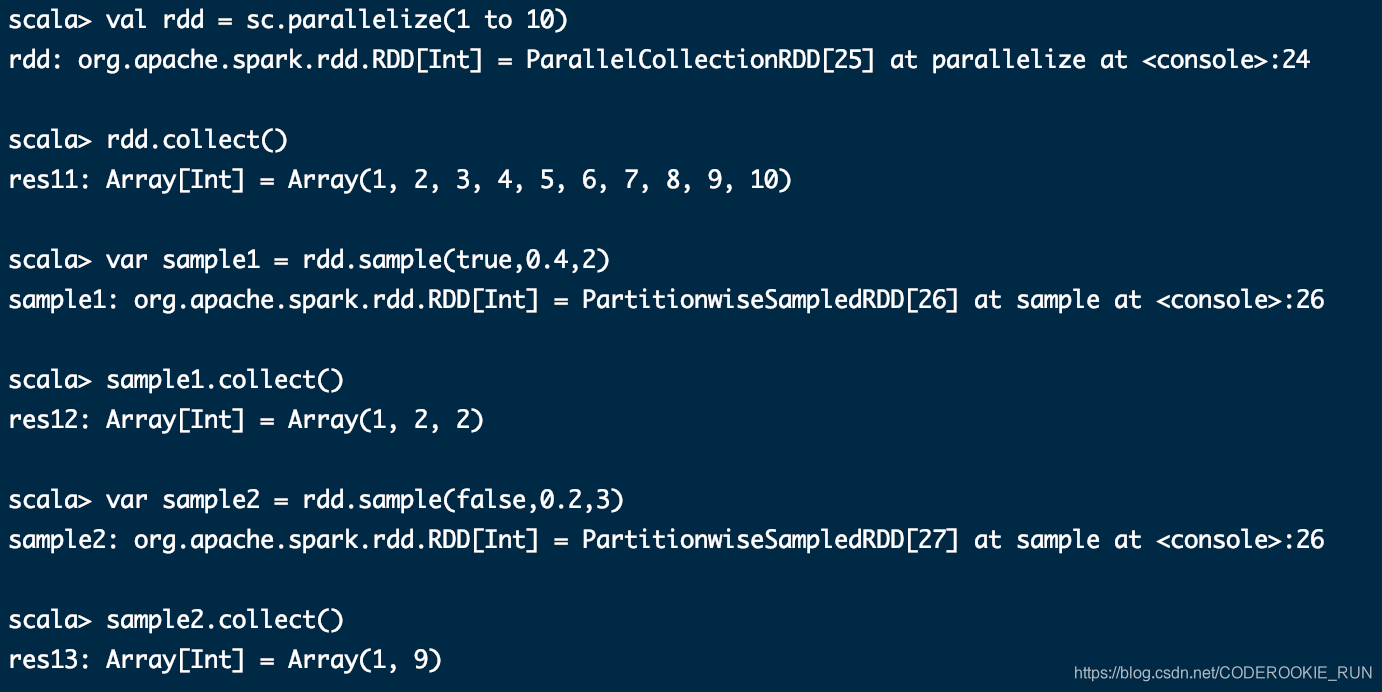

sample(withReplacement, fraction, seed)

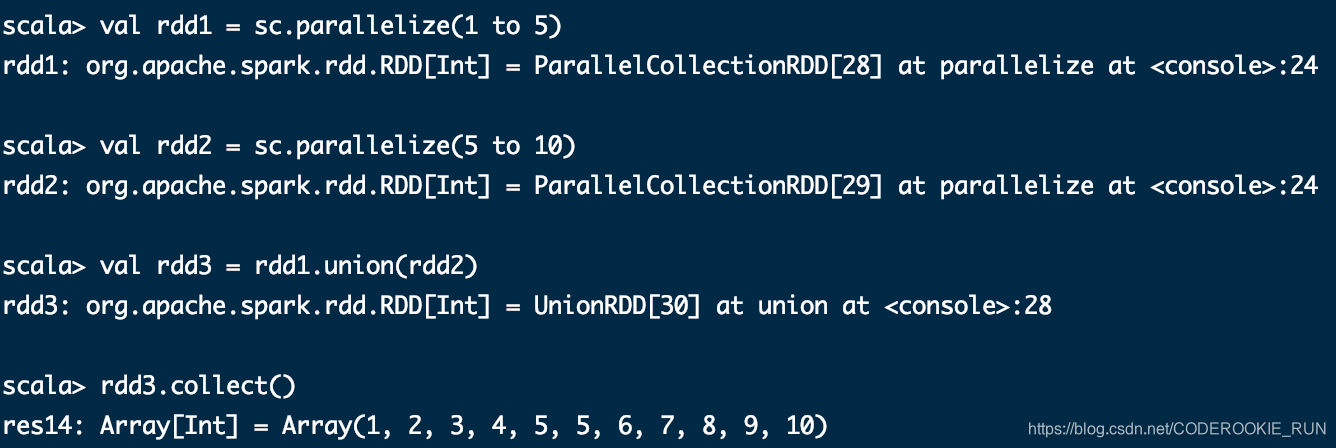

union(otherDataset)

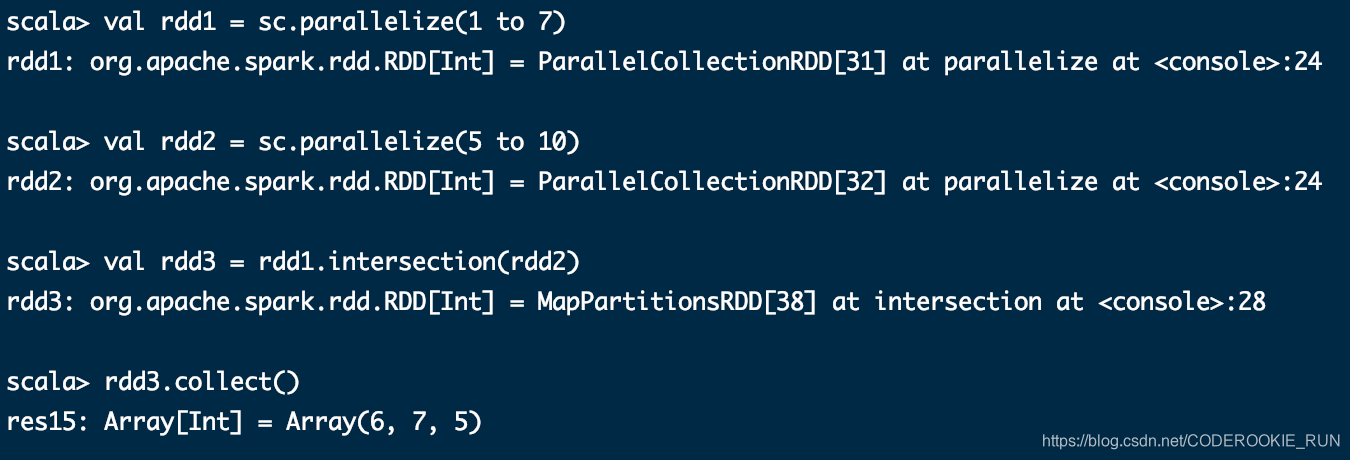

intersection(otherDataset)

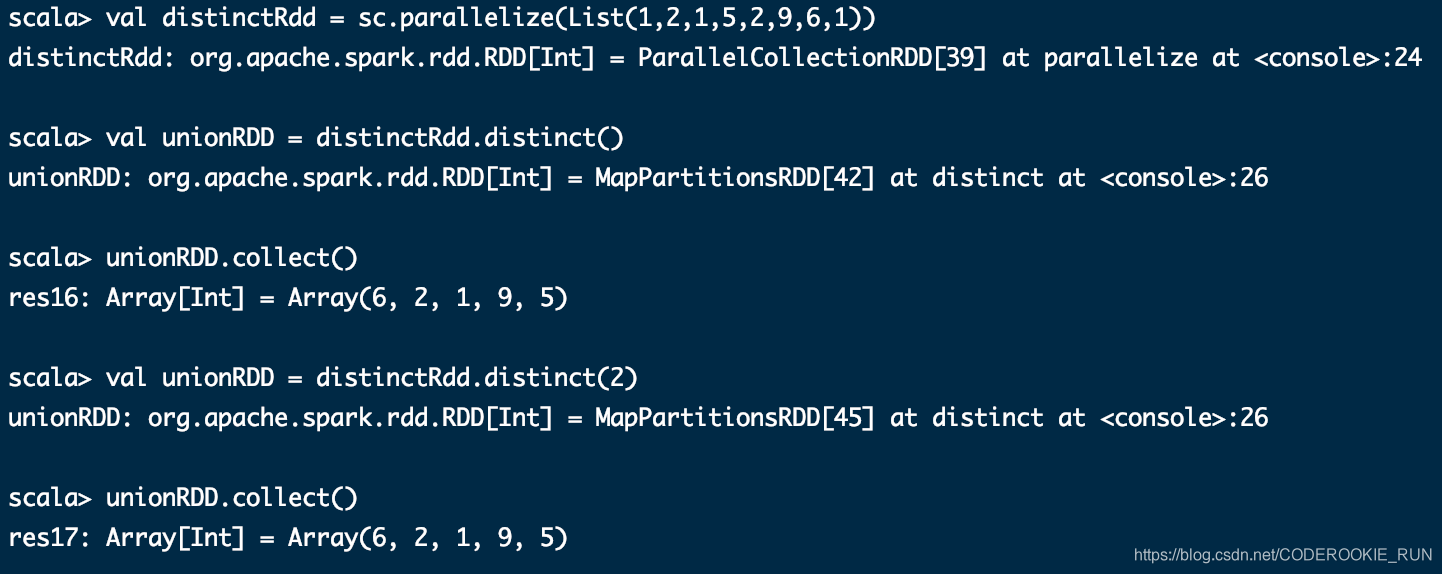

distinct([numTasks]))

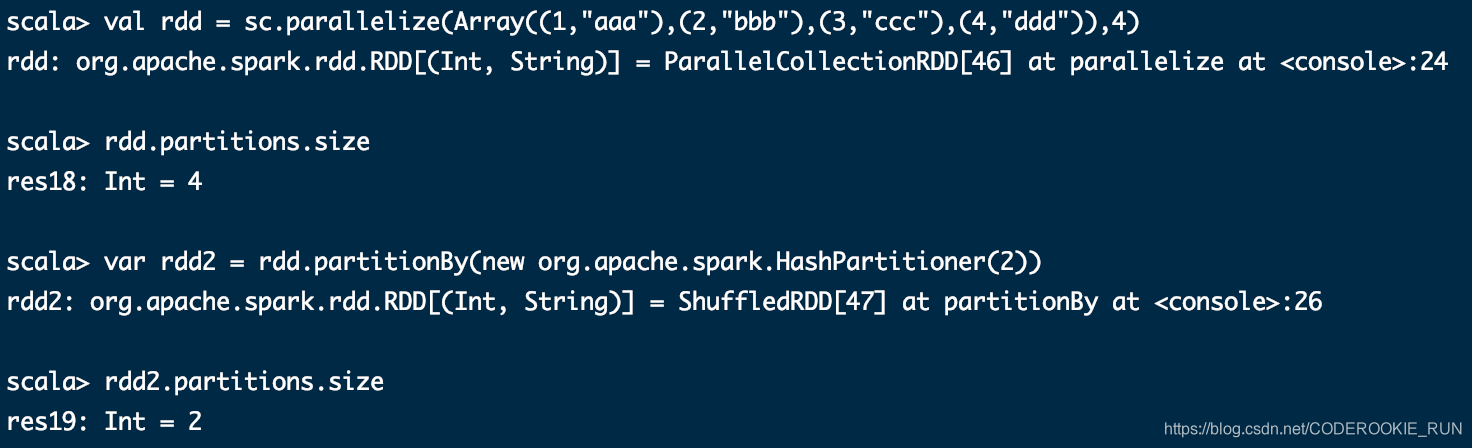

partitionBy

重新分区,分区数可以手动指定的。分区可能变多也可能变少,而且partitionBy还会产生shuffle过程

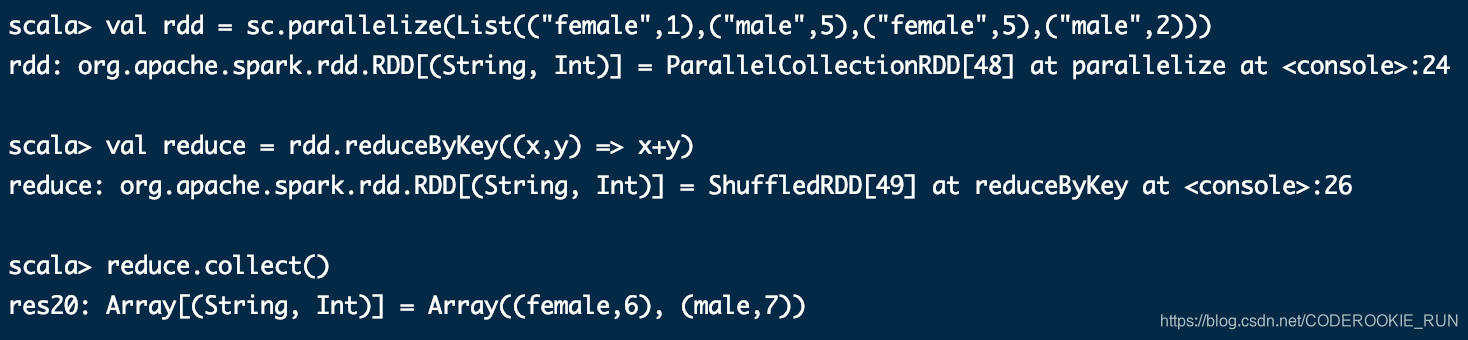

reduceByKey(func, [numTasks])

效率更高,会对数据提前进行部分的聚合,减少数据的key的shuffle

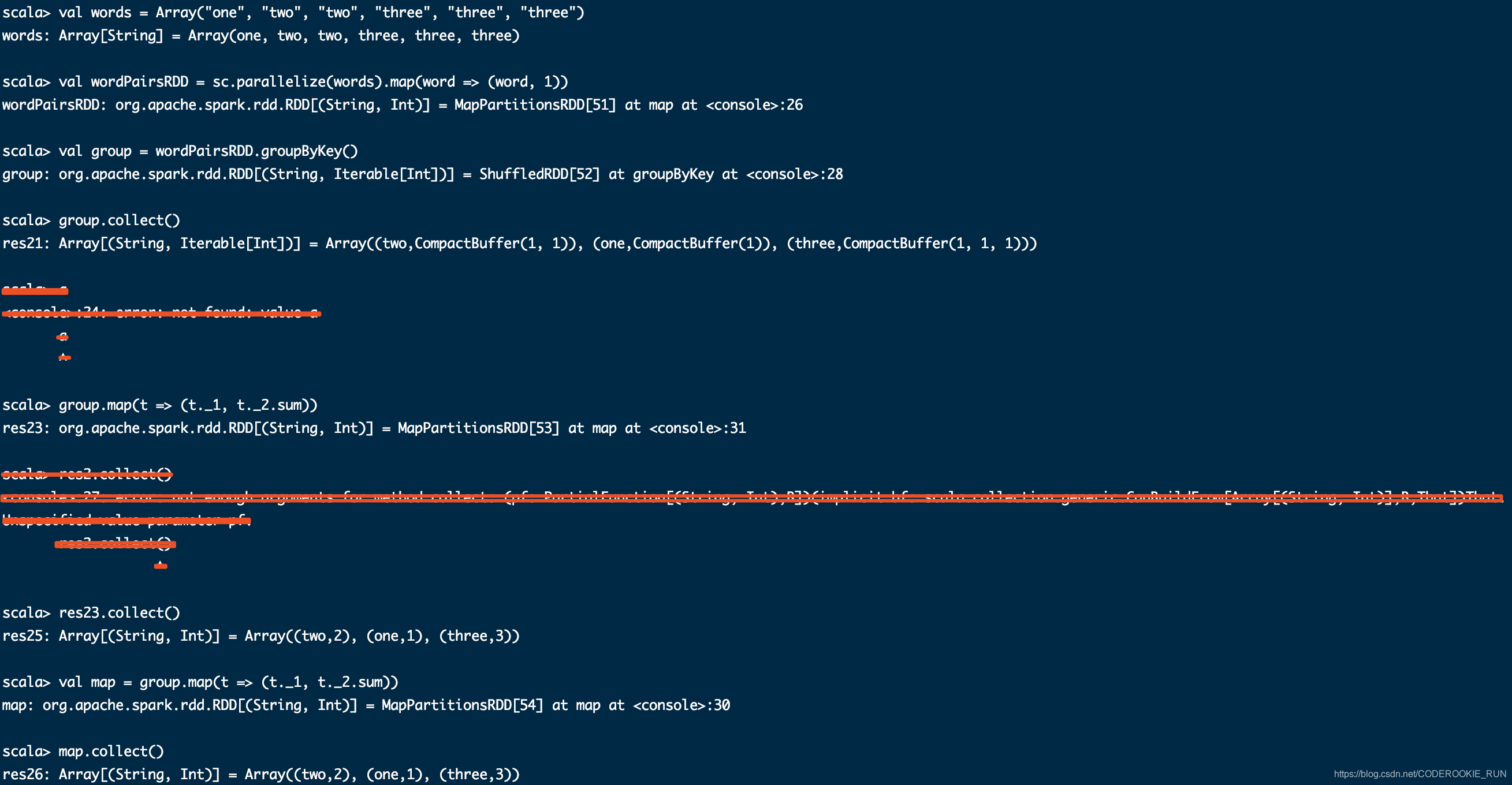

groupByKey

效率低下,尽量不要用

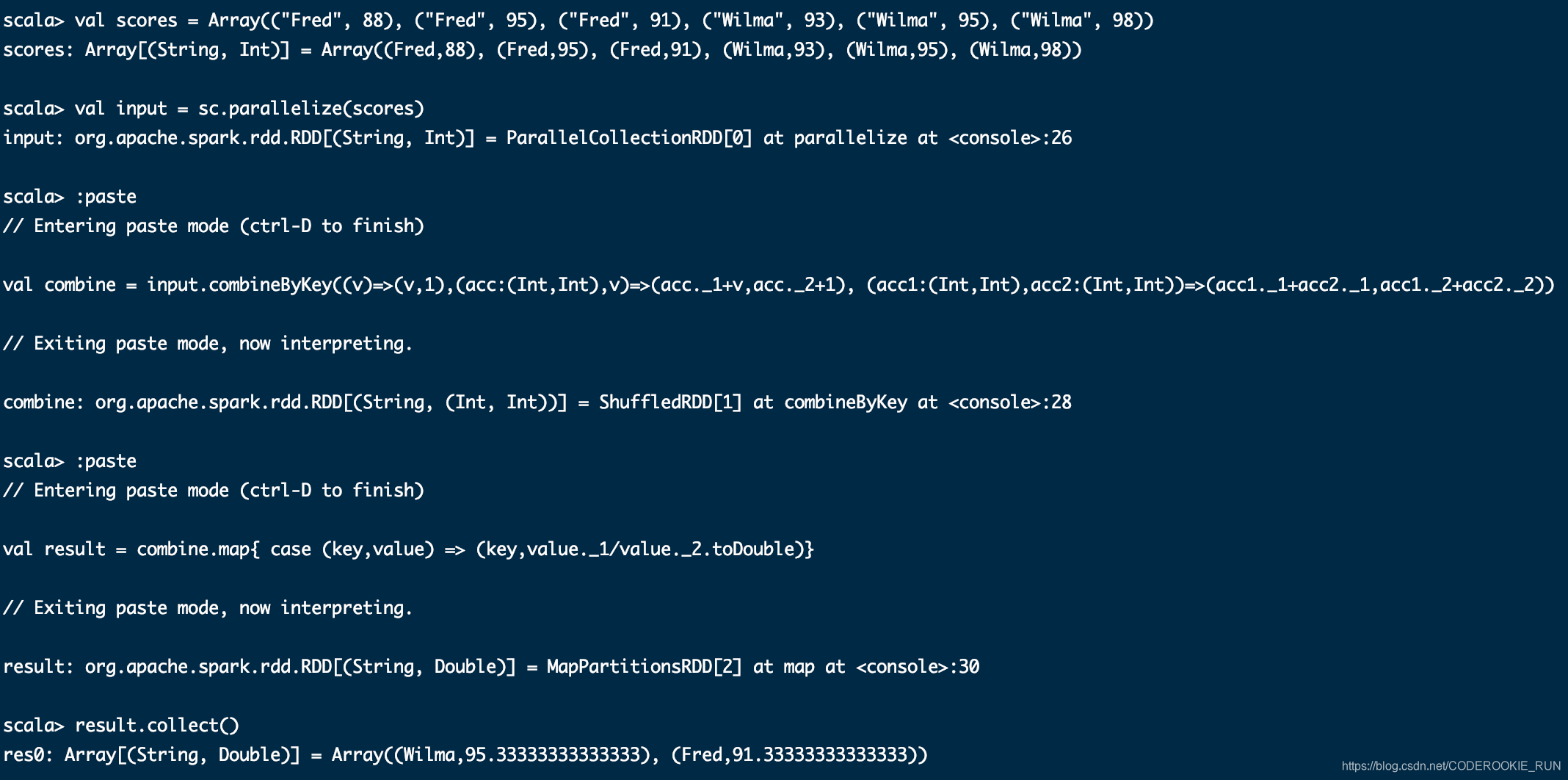

combineByKey

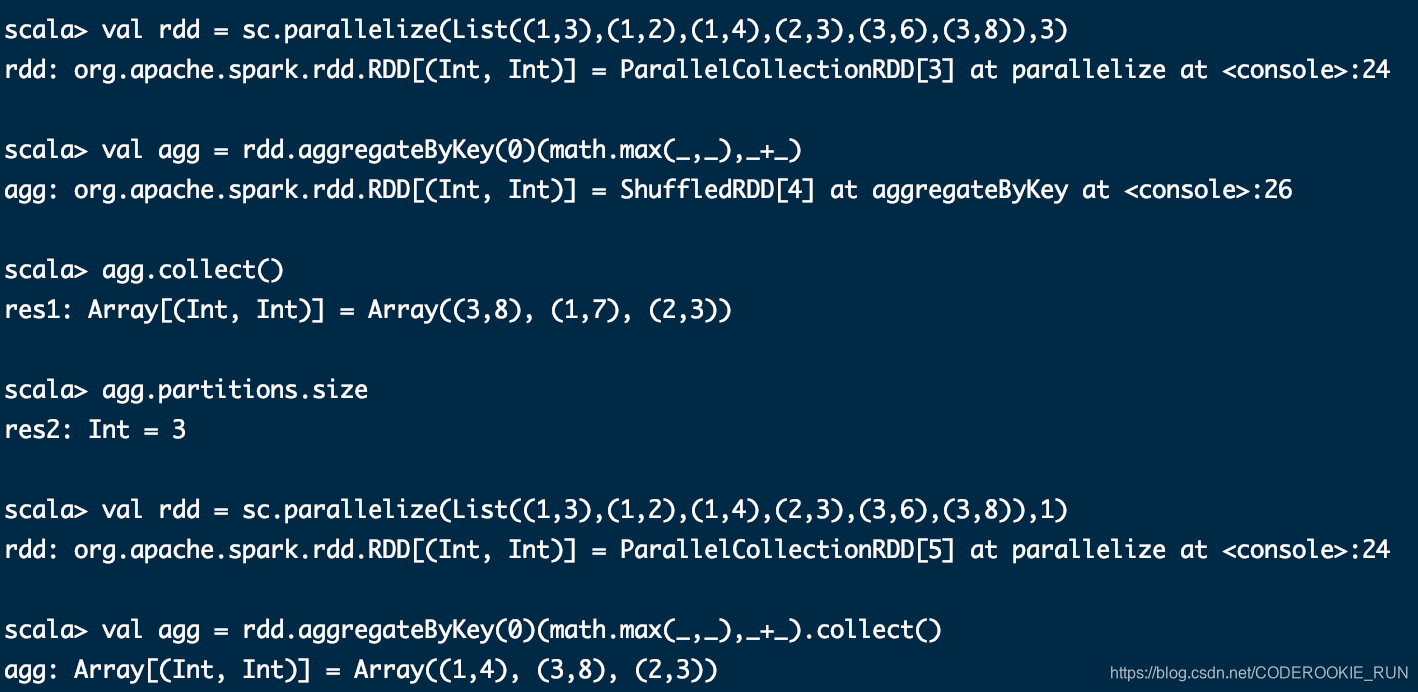

aggregateByKey(zeroValue:U,[partitioner: Partitioner]) (seqOp: (U, V) => U,combOp: (U, U) => U)

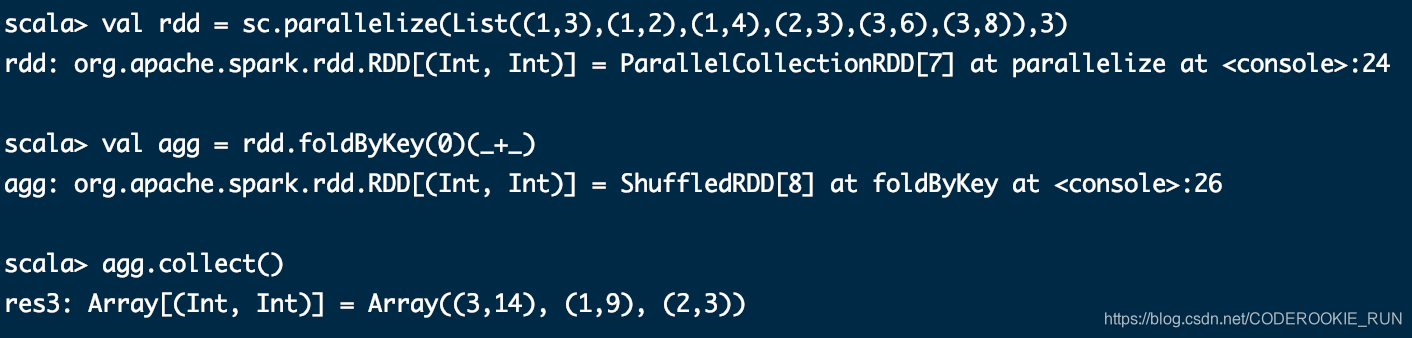

foldByKey(zeroValue: V)(func: (V, V) => V): RDD[(K, V)]

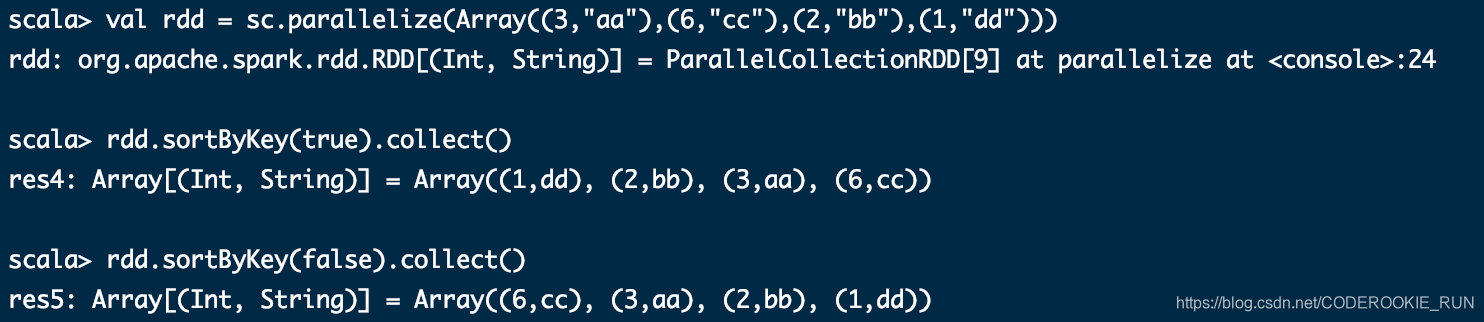

sortByKey([ascending], [numTasks])

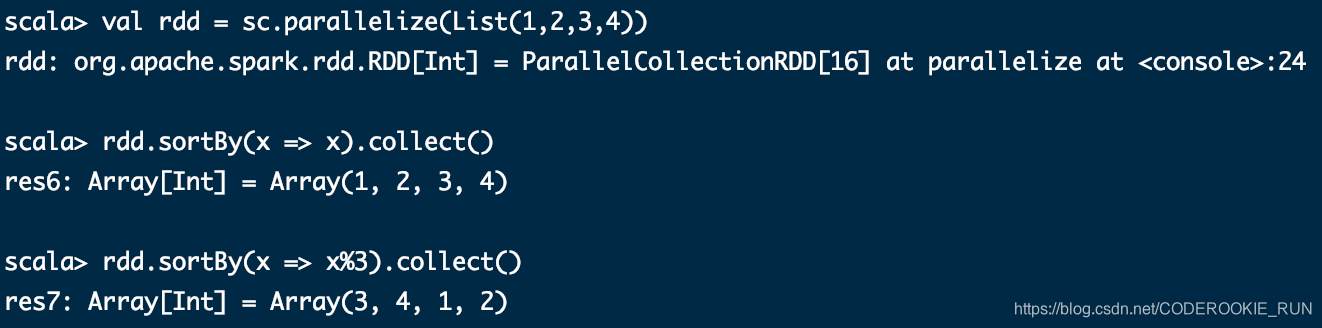

sortBy(func,[ascending], [numTasks])

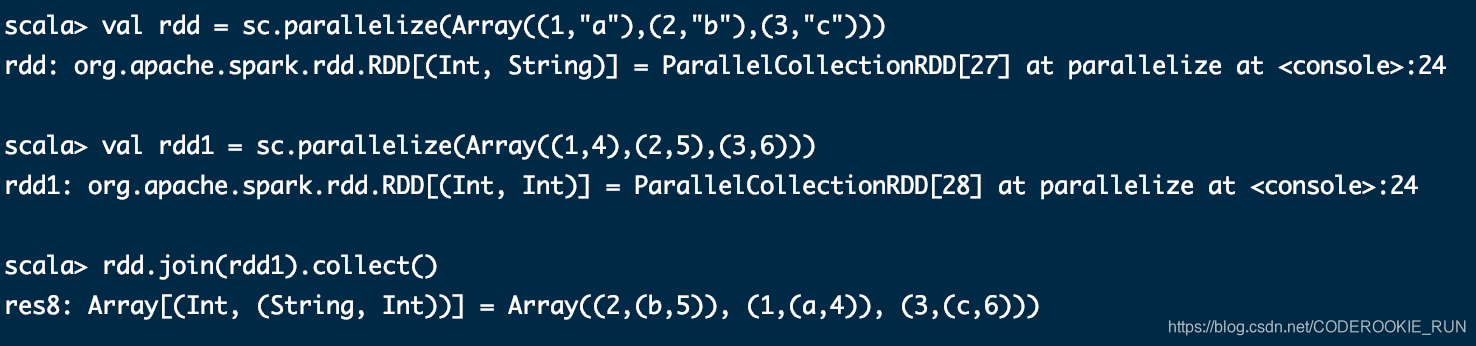

join(otherDataset, [numTasks])

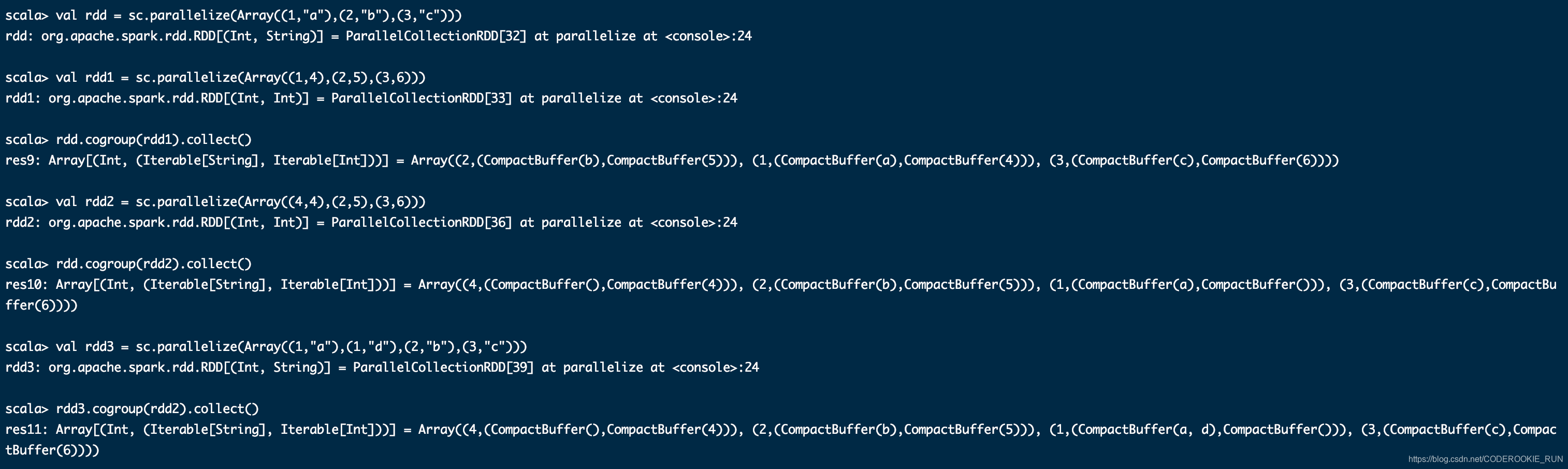

cogroup(otherDataset, [numTasks])

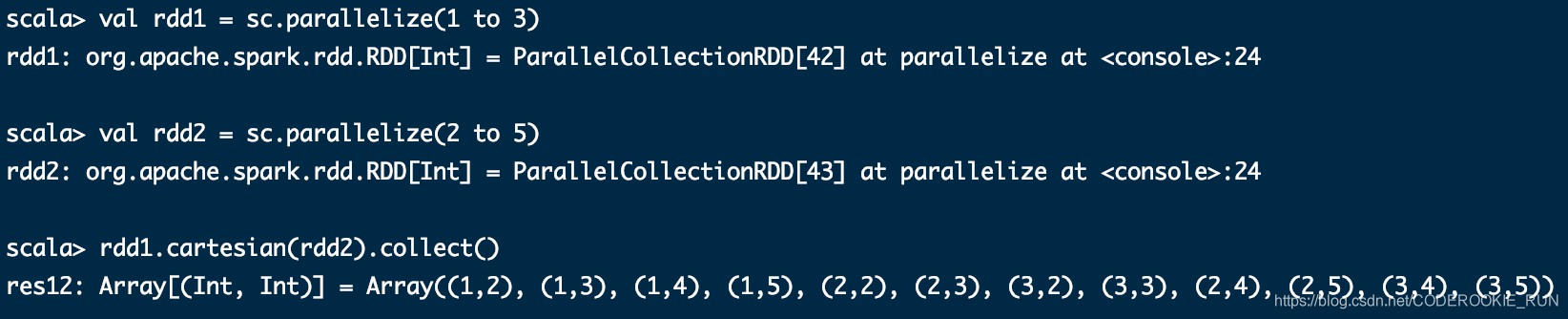

cartesian(otherDataset)

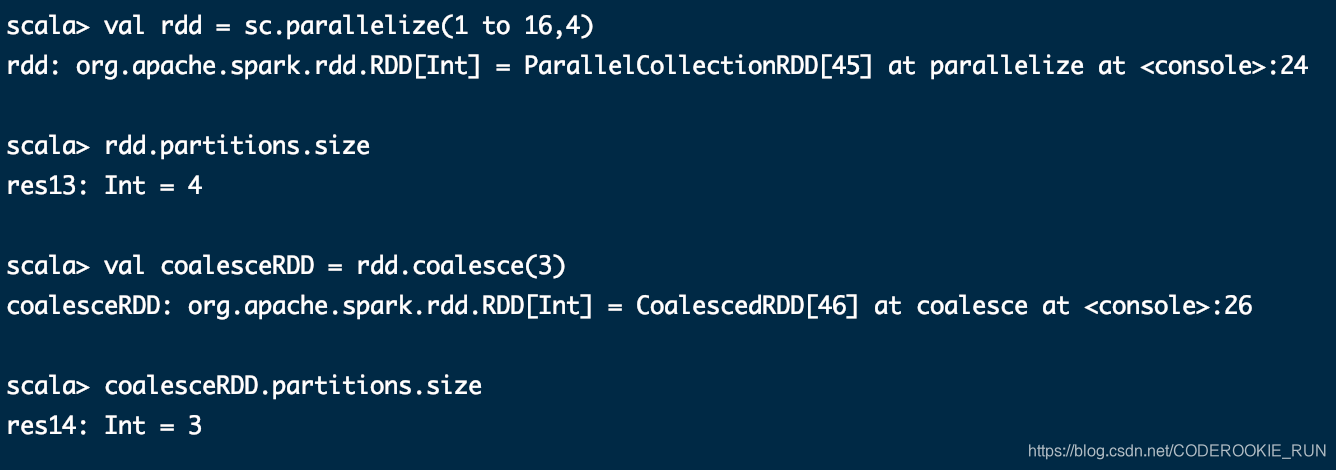

coalesce(numPartitions)

缩减分区数到指定的值,分区的个数只能减少,不能变多。不会产生shuffle过程

适用于一些大的数据集filter过滤之后,进行缩减分区,提高效率

1280M数据 ==> 10个block块 ==> 10个分区,每个分区128M数据 ==> filter ==> 10个分区,每个分区里面剩下了1KB数据 ==> coalesce => 1个分区

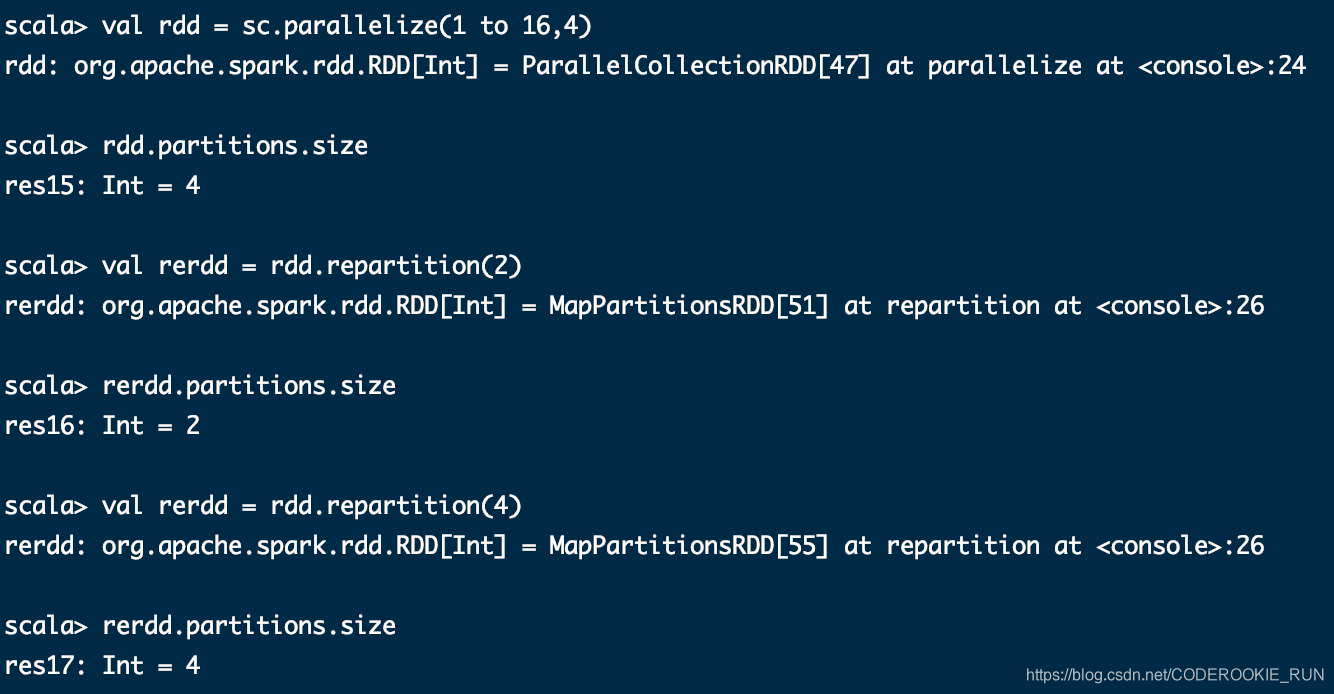

repartition(numPartitions)

数据随机洗牌冲洗分区,没有任何规则,可以将分区数变大,或者变小,会产生shuffle的过程

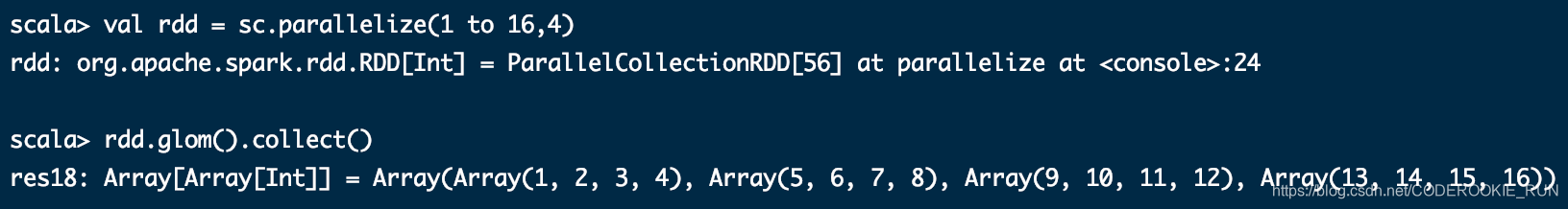

glom

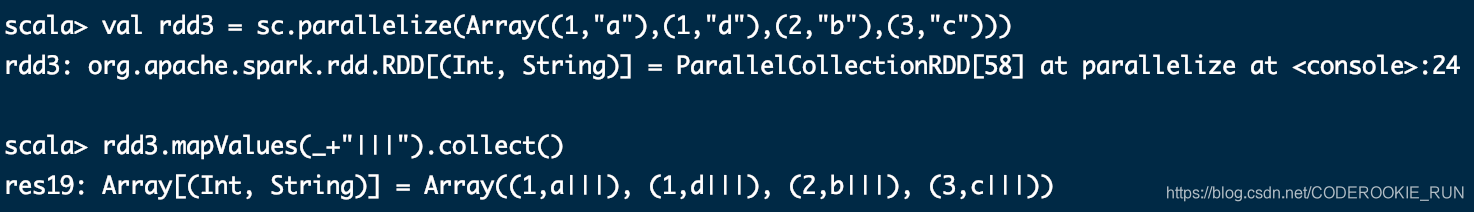

mapValues

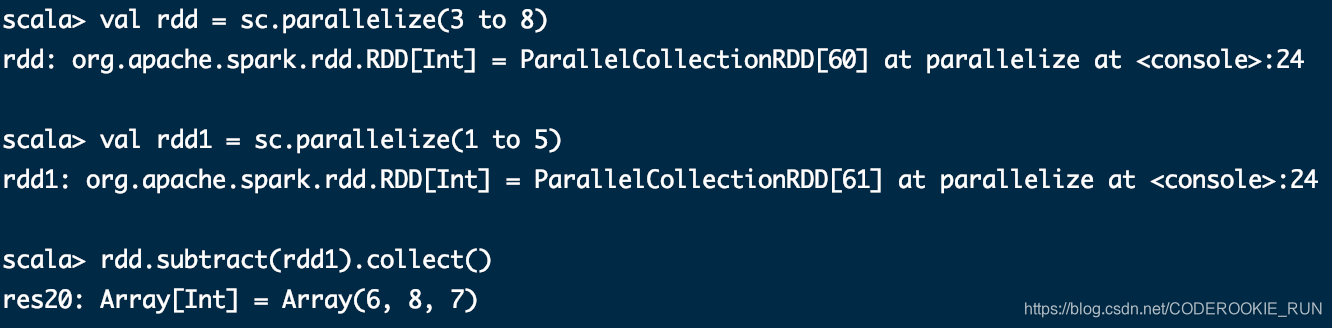

subtract

Action

帮助文档

http://spark.apache.org/docs/2.2.0/rdd-programming-guide.html#actions

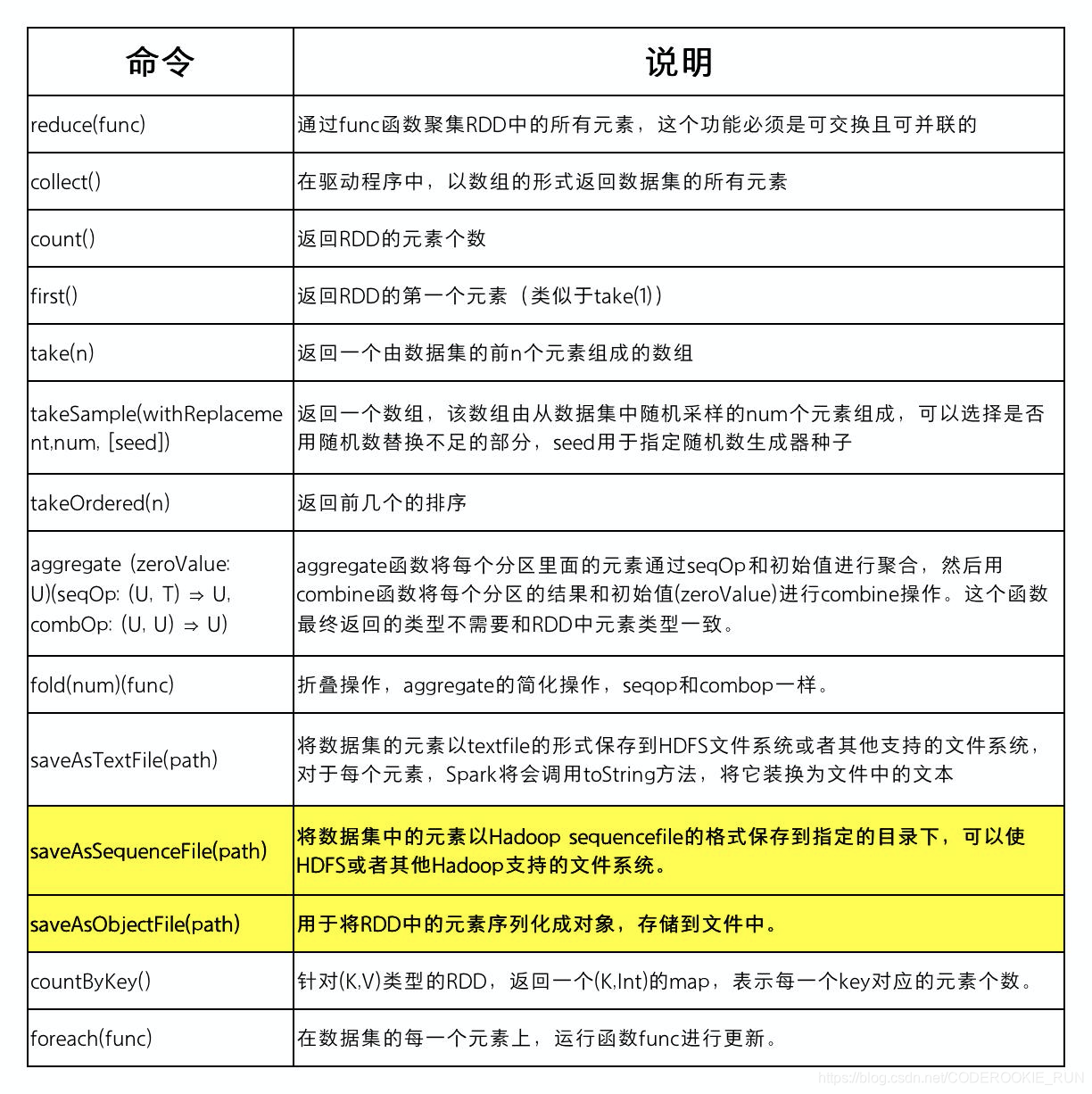

常用Action表

Action使用实例

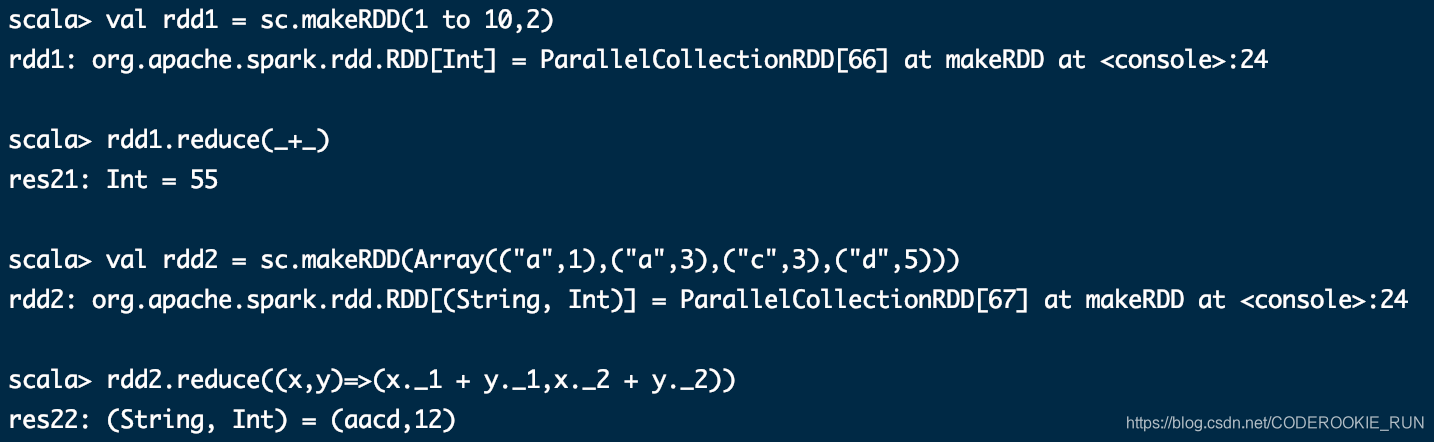

reduce(func)

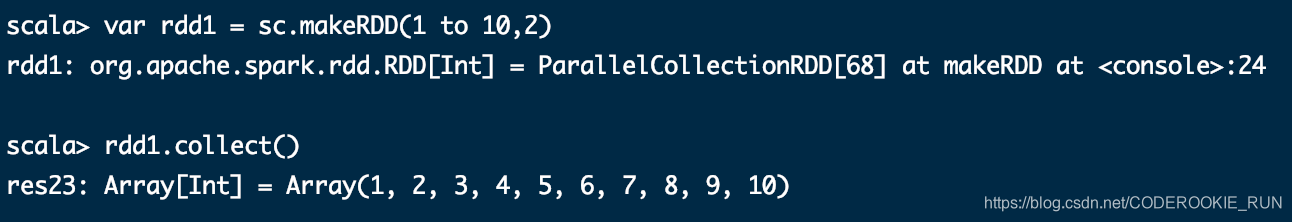

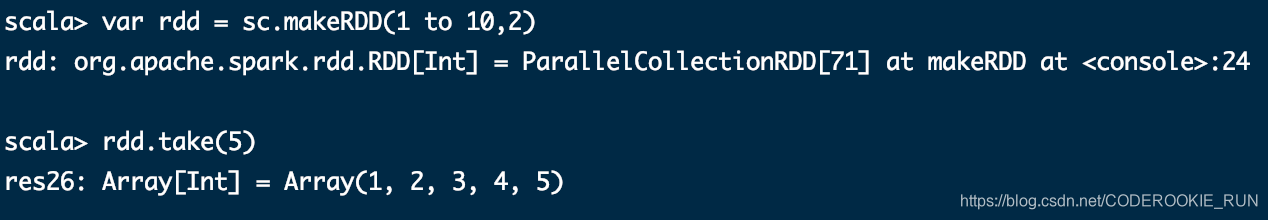

collect()

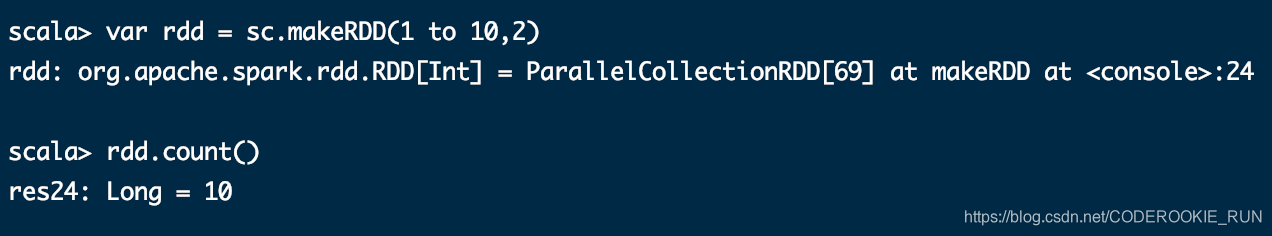

count()

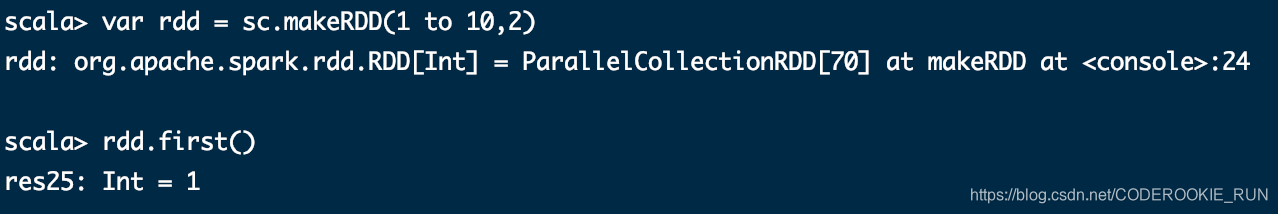

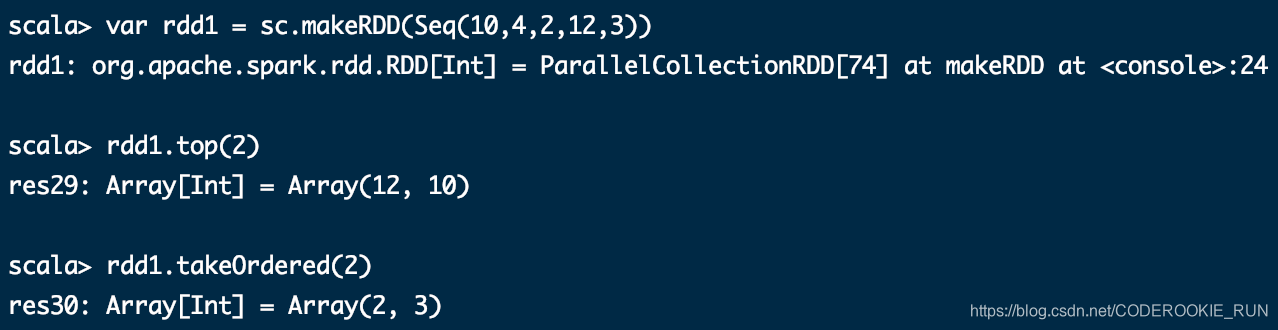

first()

take(n)

takeSample(withReplacement,num, [seed])

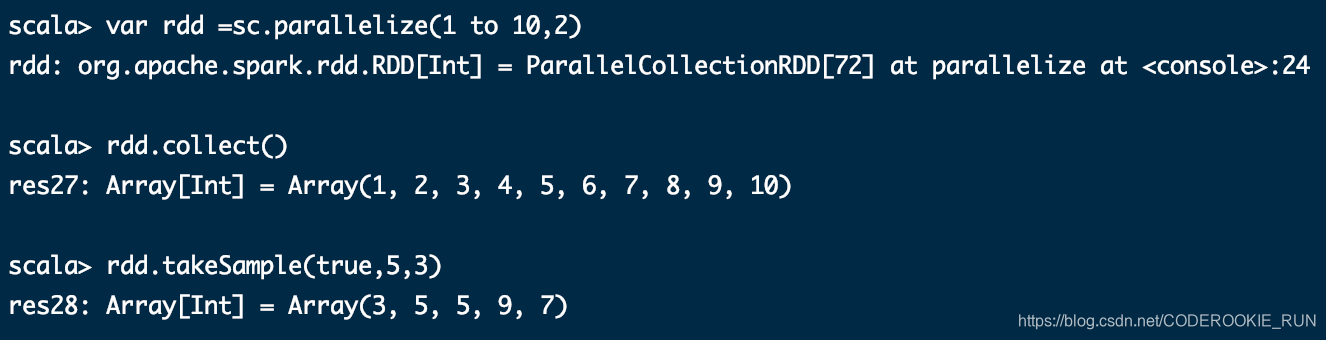

takeOrdered(n)

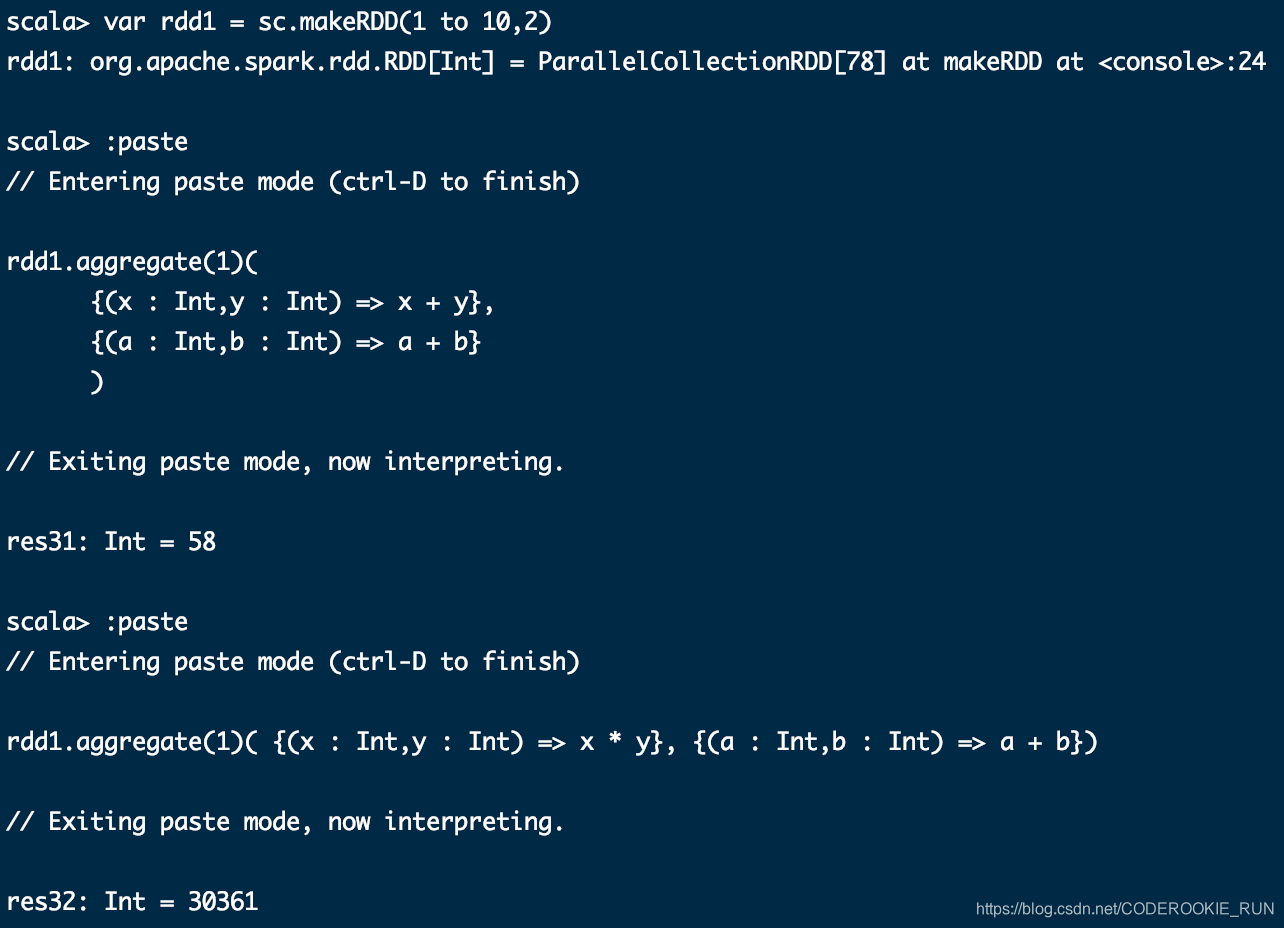

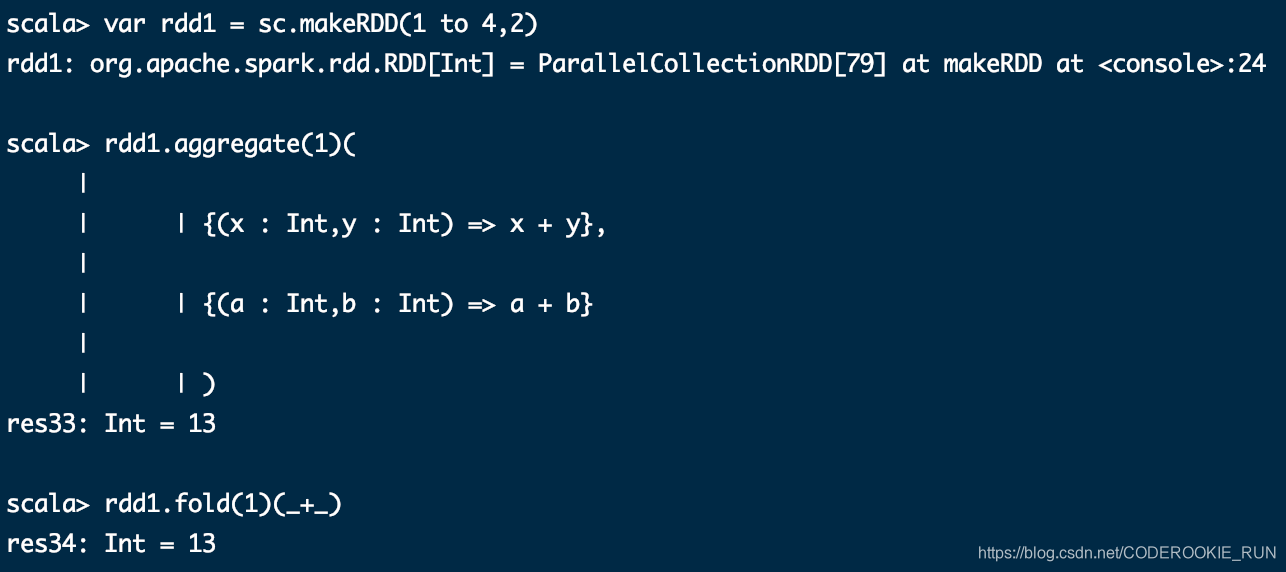

aggregate (zeroValue: U)(seqOp: (U, T) ⇒ U, combOp: (U, U) ⇒ U)

fold(num)(func)

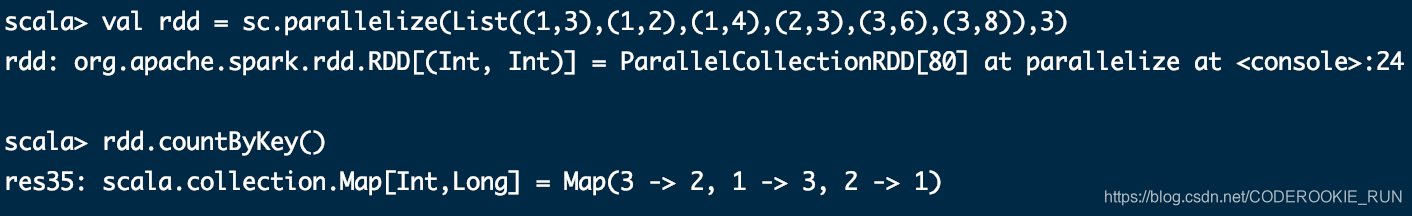

countByKey

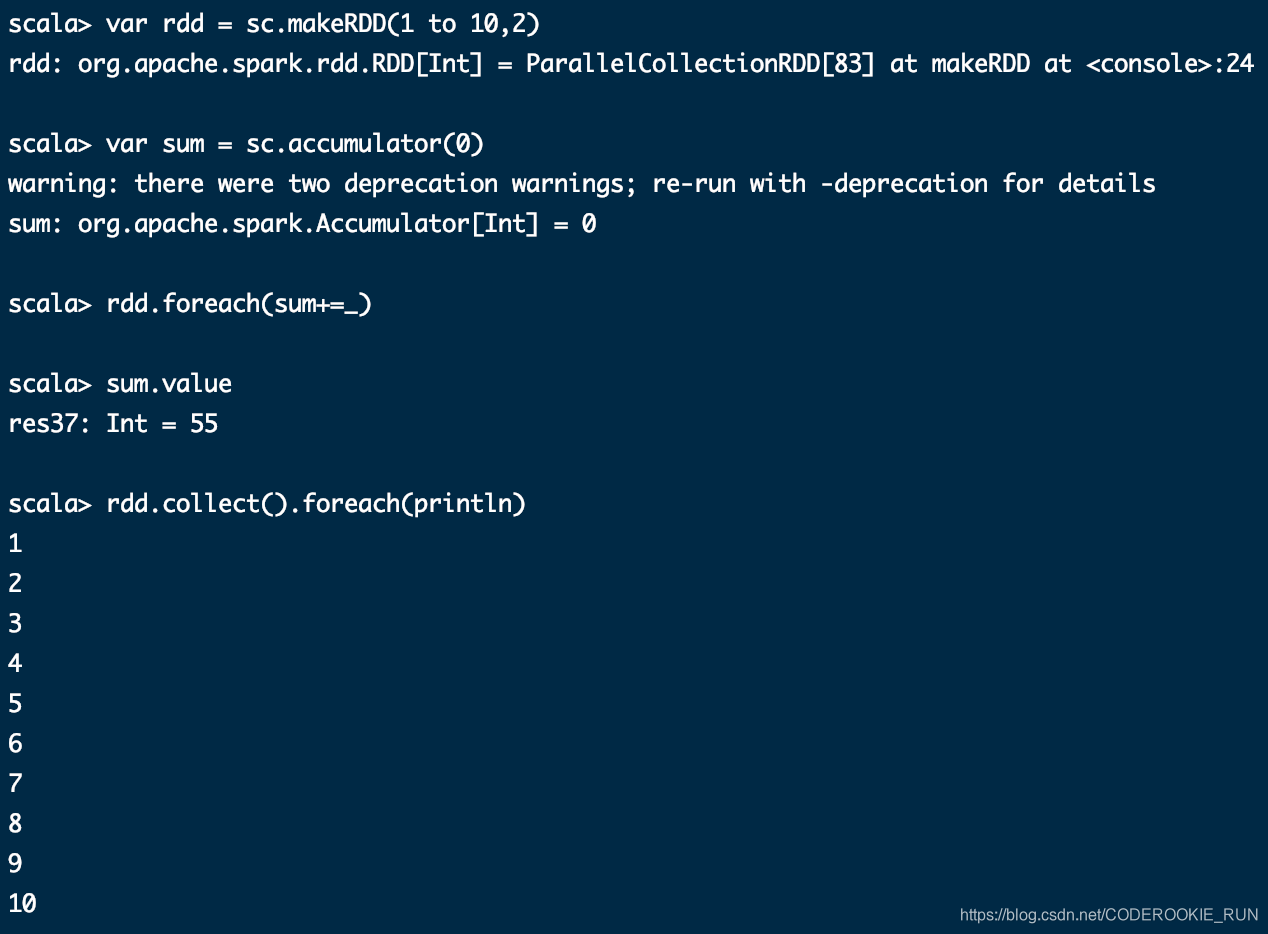

foreach(func)

这里没有列出所有的算子,更多算子可以到RDD的源码中查看

【Spark】快来学习RDD的创建以及操作方式吧!的更多相关文章

- 【原】Learning Spark (Python版) 学习笔记(一)----RDD 基本概念与命令

<Learning Spark>这本书算是Spark入门的必读书了,中文版是<Spark快速大数据分析>,不过豆瓣书评很有意思的是,英文原版评分7.4,评论都说入门而已深入不足 ...

- Spark RDD概念学习系列之RDD的创建(六)

RDD的创建 两种方式来创建RDD: 1)由一个已经存在的Scala集合创建 2)由外部存储系统的数据集创建,包括本地文件系统,还有所有Hadoop支持的数据集,比如HDFS.Cassandra.H ...

- Learning Spark (Python版) 学习笔记(一)----RDD 基本概念与命令

<Learning Spark>这本书算是Spark入门的必读书了,中文版是<Spark快速大数据分析>,不过豆瓣书评很有意思的是,英文原版评分7.4,评论都说入门而已深入不足 ...

- 【Spark】【RDD】初次学习RDD 笔记 汇总

RDD Author:萌狼蓝天 [哔哩哔哩]萌狼蓝天 [博客]https://mllt.cc [博客园]萌狼蓝天 - 博客园 [微信公众号]mllt9920 [学习交流QQ群]238948804 目录 ...

- 【原】Learning Spark (Python版) 学习笔记(三)----工作原理、调优与Spark SQL

周末的任务是更新Learning Spark系列第三篇,以为自己写不完了,但为了改正拖延症,还是得完成给自己定的任务啊 = =.这三章主要讲Spark的运行过程(本地+集群),性能调优以及Spark ...

- SPARK快学大数据分析概要

Spark 是一个用来实现快速而通用的集群计算的平台.在速度方面,Spark 扩展了广泛使用的MapReduce 计算模型,而且高效地支持更多计算模式,包括交互式查询和流处理.在处理大规模数据集时,速 ...

- 【原创】大数据基础之Spark(4)RDD原理及代码解析

一 简介 spark核心是RDD,官方文档地址:https://spark.apache.org/docs/latest/rdd-programming-guide.html#resilient-di ...

- spark第一篇:RDD Programming Guide

预览 在高层次上,每一个Spark应用(application)都包含一个驱动程序(driver program),该程序运行用户的主函数(main function),并在集群上执行各种并行操作. ...

- Spark 并行计算模型:RDD

Spark 允许用户为driver(或主节点)编写运行在计算集群上,并行处理数据的程序.在Spark中,它使用RDDs代表大型的数据集,RDDs是一组不可变的分布式的对象的集合,存储在executor ...

随机推荐

- 数据结构与算法--堆(heap)与栈(stack)的区别

堆和栈的区别 在C.C++编程中,经常需要操作的内存可分为以下几个类别: 栈区(stack):由编译器自动分配和释放,存放函数的参数值,局部变量的值等,其操作方式类似于数据结构中的栈. 堆区(heap ...

- ADO.NET(一)

最近在公司有用到了ADO.NET技术,由浅入深的复习一下. 如图所示,水源就像一个水库,进水龙头就像Connection,同理,抽水机:Command,输水管:DataAdapter 或 DataRe ...

- 深入分析Redis的主从复制机制

一.前言 最近由于疫情影响,时间比较多,所以开始学习之前一直想学,但是却没时间学的Redis.这两天研究了一下Redis的持久化以及主从复制机制,现在已经很晚了,就不多废话了.这篇博客就来谈一谈R ...

- serialize和json_encode 区别

(1)serialize主要用于php的序列化,存储到文件或者数据库中,json_encode 也是序列化,但是 主要用于与其他语言比如js进行交互使用,对于传输来说,json有许多优点. (2)在显 ...

- udp包最大数据长度是多少

因为udp包头有2个byte用于记录包体长度. 2个byte可表示最大值为: 2^16-1=64K-1=65535 udp包头占8字节, ip包头占20字节, 65535-28 = 65507 ...

- Ubuntu 18.04更换apt-get源

使用apt-get安装时,会很慢,更换了国内的源后,就可以解决这个问题了. 1. 备份sources.list文件 sudo cp /etc/apt/sources.list /etc/apt/sou ...

- (转)ATOM介绍和使用

一,Atom介绍 Atom 是 Github 开源的文本编辑器,这个编辑器完全是使用Web技术构建的(基于Node-Webkit).启动速度快,提供很多常用功能的插件和主题,可以说Atom已经足以胜任 ...

- 还在写CURD?试试这款基于mybatis-plus的springboot代码生成器

目录 ⚡Introduction ✔️Release Features Quick Start Examples 1.Controller模板代码示例 2.Service模板代码示例 3.Servic ...

- c语言----实战植物大战僵尸

1. 原理 通过指针先找到阳光的地址,然后修改地址对应的值即修改阳光值. 2. 工具 CheatEngine --- 查询进程中变量的地址 Dll注入工具 ----- 注入 VS2017 3. ...

- Bootstrap表格组件 Bootstrap Table

Bootstrap Table是Bootstrap的一个组件 Bootstrap Table Demo:http://issues.wenzhixin.net.cn/bootstrap-table/i ...