Nginx 笔记(四)nginx 原理与优化参数配置 与 nginx 搭建高可用集群

个人博客网:https://wushaopei.github.io/ (你想要这里多有)

一、nginx 原理与优化参数配置

二、nginx 搭建高可用集群

1、什么是 nginx 高可用

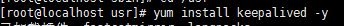

2、Keepalived+Nginx 高可用集群(主从模式)

global_defs {

notification_email {

acassen@firewall.loc

failover@firewall.loc

sysadmin@firewall.loc

}

notification_email_from Alexandre.Cassen@firewall.loc

smtp_server 192.168.17.129

smtp_connect_timeout 30

router_id LVS_DEVEL

}

vrrp_script chk_http_port {

script "/usr/local/src/nginx_check.sh"

interval 2 #(检测脚本执行的间隔)

weight 2

}

vrrp_instance VI_1 {

state BACKUP # 备份服务器上将 MASTER 改为 BACKUP

interface ens33 //网卡

virtual_router_id 51 # 主、备机的 virtual_router_id 必须相同

priority 100 # 主、备机取不同的优先级,主机值较大,备份机值较小

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.17.50 // VRRP H 虚拟地址

}

}

#!/bin/bash

A=`ps -C nginx –no-header |wc -l`

if [ $A -eq 0 ];then

/usr/local/nginx/sbin/nginx

sleep 2

if [ `ps -C nginx --no-header |wc -l` -eq 0 ];then

killall keepalived

fi

fi # systemctl stop firewalld //关闭防火墙

# sed -i 's/^SELINUX=.*/SELINUX=disabled/' /etc/sysconfig/selinux //关闭 selinux,重启

生效

# setenforce 0 //关闭 selinux,临时生效

# ntpdate 0.centos.pool.ntp.org //时间同步

# yum install nginx -y //安装 nginx# echo "`hostname` `ifconfig ens33 |sed -n 's#.*inet \(.*\)netmask.*#\1#p'`" >

/usr/share/nginx/html/index.html //准备测试文件,此处是将主机名和 ip 写到 index.html 页

面中

# vim /etc/nginx/nginx.conf //编辑配置文件

user nginx;

worker_processes auto;

error_log /var/log/nginx/error.log;

pid /run/nginx.pid;

include /usr/share/nginx/modules/*.conf;

events {

worker_connections 1024;

}

http {

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

access_log /var/log/nginx/access.log main;

sendfile on;

tcp_nopush on;

tcp_nodelay on;

keepalive_timeout 65;

types_hash_max_size 2048;

include /etc/nginx/mime.types;

default_type application/octet-stream;

include /etc/nginx/conf.d/*.conf;

server {

listen 80;

server_name www.mtian.org;

location / {

root /usr/share/nginx/html;

}

access_log /var/log/nginx/access.log main;

}

}

# systemctl start nginx //启动 nginx

# systemctl enable nginx //加入开机启动# vim /etc/nginx/nginx.conf

user nginx;

worker_processes auto;

error_log /var/log/nginx/error.log;

pid /run/nginx.pid;

include /usr/share/nginx/modules/*.conf;

events {

worker_connections 1024;

}

http {

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

access_log /var/log/nginx/access.log main;

sendfile on;

tcp_nopush on;

tcp_nodelay on;

keepalive_timeout 65;

types_hash_max_size 2048;

include /etc/nginx/mime.types;

default_type application/octet-stream;

include /etc/nginx/conf.d/*.conf;

upstream backend {

server 192.168.1.33:80 weight=1 max_fails=3 fail_timeout=20s;

server 192.168.1.34:80 weight=1 max_fails=3 fail_timeout=20s;

}

server {

listen 80;

server_name www.mtian.org;

location / {

proxy_pass http://backend;

proxy_set_header Host $host:$proxy_port;

proxy_set_header X-Forwarded-For $remote_addr;

}

}

}

# systemctl start nginx //启动 nginx

# systemctl enable nginx //加入开机自启动[root@node01 ~]# cat /etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

192.168.1.32 www.mtian.org

192.168.1.31 www.mtian.org

// 测试时候轮流关闭 lb1 和 lb2 节点,关闭后还是能够访问并看到轮循效果即表示 nginx lb 集群搭建

成功。

[root@node01 ~]# curl www.mtian.org

web01 192.168.1.33

[root@node01 ~]# curl www.mtian.org

web02 192.168.1.34

[root@node01 ~]# curl www.mtian.org

web01 192.168.1.33

[root@node01 ~]# curl www.mtian.org

web02 192.168.1.34

[root@node01 ~]# curl www.mtian.org

web01 192.168.1.33

[root@node01 ~]# curl www.mtian.org

web02 192.168.1.34# yum install keepalived -y[root@LB-01 ~]# vim /etc/keepalived/keepalived.conf

! Configuration File for keepalived

global_defs {

notification_email {

381347268@qq.com

}

smtp_server 192.168.200.1

smtp_connect_timeout 30

router_id LVS_DEVEL

}

vrrp_instance VI_1 {

state MASTER

interface ens33

virtual_router_id 51

priority 150

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.1.110/24 dev ens33 label ens33:1

}

}

[root@LB-01 ~]# systemctl start keepalived //启动 keepalived

[root@LB-01 ~]# systemctl enable keepalived //加入开机自启动

[root@LB-01 ~]# ip a //查看 IP,会发现多出了 VIP 192.168.1.110

......

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:0c:29:94:17:44 brd ff:ff:ff:ff:ff:ff

inet 192.168.1.31/24 brd 192.168.1.255 scope global ens33

valid_lft forever preferred_lft forever

inet 192.168.1.110/24 scope global secondary ens33:1

valid_lft forever preferred_lft forever

inet6 fe80::20c:29ff:fe94:1744/64 scope link

valid_lft forever preferred_lft forever

......[root@LB-02 ~]# vim /etc/keepalived/keepalived.conf

! Configuration File for keepalived

global_defs {

notification_email {

381347268@qq.com

}

smtp_server 192.168.200.1

smtp_connect_timeout 30

router_id LVS_DEVEL

}

vrrp_instance VI_1 {

state BACKUP

interface ens33

virtual_router_id 51

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.1.110/24 dev ens33 label ens33:1

}

}

[root@LB-02 ~]# systemctl start keepalived //启动 keepalived

[root@LB-02 ~]# systemctl enable keepalived //加入开机自启动

[root@LB-02 ~]# ifconfig //查看 IP,此时备节点不会有 VIP(只有当主挂了的时候,VIP 才会飘到备

节点)

ens33: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 192.168.1.32 netmask 255.255.255.0 broadcast 192.168.1.255

inet6 fe80::20c:29ff:feab:6532 prefixlen 64 scopeid 0x20<link>

ether 00:0c:29:ab:65:32 txqueuelen 1000 (Ethernet)

RX packets 43752 bytes 17739987 (16.9 MiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 4177 bytes 415805 (406.0 KiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

......[root@node01 ~]# curl 192.168.1.110

web01 192.168.1.33

[root@node01 ~]# curl 192.168.1.110

web02 192.168.1.34

[root@node01 ~]# curl 192.168.1.110

web01 192.168.1.33

[root@node01 ~]# curl 192.168.1.110

web02 192.168.1.34

//关闭 LB-01 节点上面 keepalived 主节点。再次访问

[root@LB-01 ~]# systemctl stop keepalived

[root@node01 ~]#

[root@node01 ~]# curl 192.168.1.110

web01 192.168.1.33

[root@node01 ~]# curl 192.168.1.110

web02 192.168.1.34

[root@node01 ~]# curl 192.168.1.110

web01 192.168.1.33

[root@node01 ~]# curl 192.168.1.110

web02 192.168.1.34

//此时查看 LB-01 主节点上面的 IP ,发现已经没有了 VIP

[root@LB-01 ~]# ifconfig

ens33: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 192.168.1.31 netmask 255.255.255.0 broadcast 192.168.1.255

inet6 fe80::20c:29ff:fe94:1744 prefixlen 64 scopeid 0x20<link>

ether 00:0c:29:94:17:44 txqueuelen 1000 (Ethernet)

RX packets 46813 bytes 18033403 (17.1 MiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 9350 bytes 1040882 (1016.4 KiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

...

//查看 LB-02 备节点上面的 IP,发现 VIP 已经成功飘过来了

[root@LB-02 ~]# ifconfig

ens33: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 192.168.1.32 netmask 255.255.255.0 broadcast 192.168.1.255

inet6 fe80::20c:29ff:feab:6532 prefixlen 64 scopeid 0x20<link>

ether 00:0c:29:ab:65:32 txqueuelen 1000 (Ethernet)

RX packets 44023 bytes 17760070 (16.9 MiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 4333 bytes 430037 (419.9 KiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

ens33:1: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 192.168.1.110 netmask 255.255.255.0 broadcast 0.0.0.0

ether 00:0c:29:ab:65:32 txqueuelen 1000 (Ethernet)

...3、Keepalived+Nginx 高可用集群(双主模式)

[root@LB-01 ~]# vim /etc/keepalived/keepalived.conf //编辑配置文件,增加一段新的

vrrp_instance 规则

! Configuration File for keepalived

global_defs {

notification_email {

381347268@qq.com

}

smtp_server 192.168.200.1

smtp_connect_timeout 30

router_id LVS_DEVEL

}

vrrp_instance VI_1 {

state MASTER

interface ens33

virtual_router_id 51

priority 150

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.1.110/24 dev ens33 label ens33:1

}

}

vrrp_instance VI_2 {

state BACKUP

interface ens33

virtual_router_id 52

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 2222

}

virtual_ipaddress {

192.168.1.210/24 dev ens33 label ens33:2

}

}

[root@LB-01 ~]# systemctl restart keepalived //重新启动 keepalived

// 查看 LB-01 节点的 IP 地址,发现 VIP(192.168.1.110)同样还是默认在该节点

[root@LB-01 ~]# ip a

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:0c:29:94:17:44 brd ff:ff:ff:ff:ff:ff

inet 192.168.1.31/24 brd 192.168.1.255 scope global ens33

valid_lft forever preferred_lft forever

inet 192.168.1.110/24 scope global secondary ens33:1

valid_lft forever preferred_lft forever

inet6 fe80::20c:29ff:fe94:1744/64 scope link

valid_lft forever preferred_lft forever[root@LB-02 ~]# vim /etc/keepalived/keepalived.conf //编辑配置文件,增加一段新的

vrrp_instance 规则

! Configuration File for keepalived

global_defs {

notification_email {

381347268@qq.com

}

smtp_server 192.168.200.1

smtp_connect_timeout 30

router_id LVS_DEVEL

}

vrrp_instance VI_1 {

state BACKUP

interface ens33

virtual_router_id 51

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.1.110/24 dev ens33 label ens33:1

}

}

vrrp_instance VI_2 {

state MASTER

interface ens33

virtual_router_id 52

priority 150

advert_int 1

authentication {

auth_type PASS

auth_pass 2222

}

virtual_ipaddress {

192.168.1.210/24 dev ens33 label ens33:2

}

}

[root@LB-02 ~]# systemctl restart keepalived //重新启动 keepalived

// 查看 LB-02 节点 IP,会发现也多了一个 VIP(192.168.1.210),此时该节点也就是一个主了。

[root@LB-02 ~]# ip a

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:0c:29:ab:65:32 brd ff:ff:ff:ff:ff:ff

inet 192.168.1.32/24 brd 192.168.1.255 scope global ens33

valid_lft forever preferred_lft forever

inet 192.168.1.210/24 scope global secondary ens33:2

valid_lft forever preferred_lft forever

inet6 fe80::20c:29ff:feab:6532/64 scope link

valid_lft forever preferred_lft forever

(3)测试

[root@node01 ~]# curl 192.168.1.110

web01 192.168.1.33

[root@node01 ~]# curl 192.168.1.110

web02 192.168.1.34

[root@node01 ~]# curl 192.168.1.210

web01 192.168.1.33

[root@node01 ~]# curl 192.168.1.210

web02 192.168.1.34

// 停止 LB-01 节点的 keepalived 再次测试

[root@LB-01 ~]# systemctl stop keepalived

[root@node01 ~]# curl 192.168.1.110

web01 192.168.1.33

[root@node01 ~]# curl 192.168.1.110

web02 192.168.1.34

[root@node01 ~]# curl 192.168.1.210

web01 192.168.1.33

[root@node01 ~]# curl 192.168.1.210

web02 192.168.1.34Nginx 笔记(四)nginx 原理与优化参数配置 与 nginx 搭建高可用集群的更多相关文章

- keepalive + nginx 搭建高可用集群动态网站

环境准备: 两台节点部署keepalived,并且设为互为主从,实现高可用. 两台从节点部署nginx以及相关组件,作为真实服务器实现动态网站上线. 一.MASTER(BACKUP)节点下载keepa ...

- linux高可用集群(HA)原理详解(转载)

一.什么是高可用集群 高可用集群就是当某一个节点或服务器发生故障时,另一个 节点能够自动且立即向外提供服务,即将有故障节点上的资源转移到另一个节点上去,这样另一个节点有了资源既可以向外提供服务.高可用 ...

- linux高可用集群(HA)原理详解

高可用集群 一.什么是高可用集群 高可用集群就是当某一个节点或服务器发生故障时,另一个节点能够自动且立即向外提供服务,即将有故障节点上的资源转移到另一个节点上去,这样另一个节点有了资源既可以向外提供服 ...

- Nginx(四):Keepalived+Nginx 高可用集群

Keepalived+Nginx 高可用集群 (主从模式) 集群架构图 安装keepalived [root@localhost ~]# yum install -y keepalived 查看状态 ...

- keepalived+nginx 高可用集群

一.什么是高可用? nginx做负载均衡,能达到分发请求的目的,但是不能很好的避免单点故障. 1.nginx集群单点问题 分发器宕机怎么处理? 假如nginx服务器挂掉了,那么所有的服务也会跟着瘫 ...

- Keepalived+Nginx高可用集群

Keepalived简介 Keepalived的作用是检测服务器的状态,如果有一台web服务器宕机,或工作出现故障,Keepalived将检测到,并将有故障的服务器从系统中剔除,同时使用其他服务器代替 ...

- Nginx+Keepalived高可用集群应用实践

Nginx+Keepalived高可用集群应用实践 1.Keepalived高可用软件 1.1 Keepalived服务的三个重要功能 1.1.1管理LVS负载均衡软件 早期的LVS软件,需要通过命令 ...

- 实战| Nginx+keepalived 实现高可用集群

一个执着于技术的公众号 前言 今天通过两个实战案例,带大家理解Nginx+keepalived 如何实现高可用集群,在学习新知识之前您可以选择性复习之前的知识点: 给小白的 Nginx 10分钟入门指 ...

- 【工具-Nginx】从入门安装到高可用集群搭建

文章已收录至https://lichong.work,转载请注明原文链接. ps:欢迎关注公众号"Fun肆编程"或添加我的私人微信交流经验 一.Nginx安装配置及常用命令 1.环 ...

随机推荐

- 小程序-for循环遍历的使用

.js文件: Page({ /** * 页面的初始数据 */ data: { datas:[ { title: '提交申请', txt: '选择服务类型,填写基本信息,提交' }, { title: ...

- CI与CD之Docker上安装Jenkins

一.CI,CD,Jenkins的介绍 CI:持续集成(Continuous integration,简称 CI),在传统的软件开发环境中,有集成,但是没有持续集成这种说法,长时间的分支与主干脱离,导致 ...

- Mysql 常用函数(19)- mod 函数

Mysql常用函数的汇总,可看下面系列文章 https://www.cnblogs.com/poloyy/category/1765164.html mod 的作用 求余数,和%一样 mod的语法格式 ...

- HTTP Status完整枚举

HTTP Status完整枚举 public enum HttpStatus { // 1xx Informational 1xx信息类的 继续 CONTINUE(100, "C ...

- ScrollView 内嵌百度地图问题解决

在ScrollView上内嵌百度地图遇到两个问题 事件冲突,移动地图的时候屏幕滚动了 移动ScrollView的时候,百度地图出现黑边 问题1的处理就有各种办法了,核心都是拦截事件,我使用的办法是加一 ...

- 初识spring boot maven管理--SpringMVC

springboot完美的支持了springmvc,自家东西当然是支持最好的啦! @EnableAutoConfiguration自动注入了一下信息 1.包含了ContentNegotiatingVi ...

- 我的linux学习日记day8

链接文件 linux中链接有两种,一种是硬链接,一种是软链接 一.硬链接 硬链接是指通过索引节点来进行链接创建硬链接的方法如下:ln 源文件 硬链接文件具有相同inode号的多个文件互为硬链接文件删除 ...

- javaScript ES7 ES8 ES9 ES10新特性

参考文献: https://tuobaye.com/2018/11/27/%E7%BB%86%E8%A7%A3JavaScript-ES7-ES8-ES9-%E6%96%B0%E7%89%B9%E6% ...

- webpack+vue img的src问题

在vue中给图片添加路径试过三种方式: 1.在css的background中添加路径: 2.将路径写在data属性中,然后动态注入img标签的src属性: 3.在img标签中奖src属性写死 第三种方 ...

- Django视图函数之三种响应模式

视图函数响应处理: from django.shortcuts import render,HttpResponse,redirect (1)render 处理模板文件,可以渲染模板,第一个参数必须为 ...