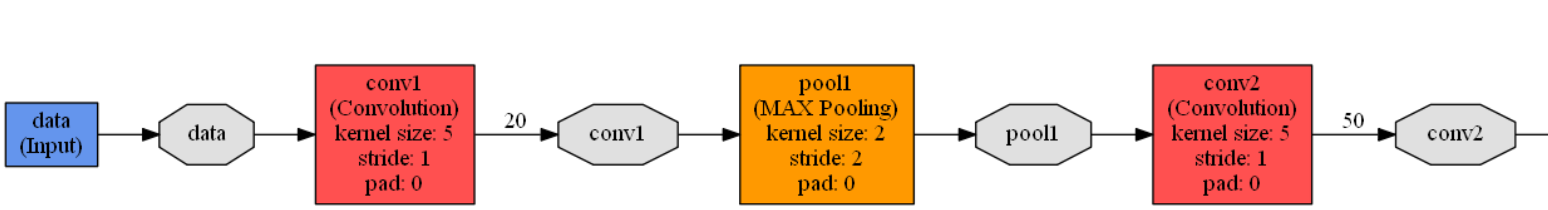

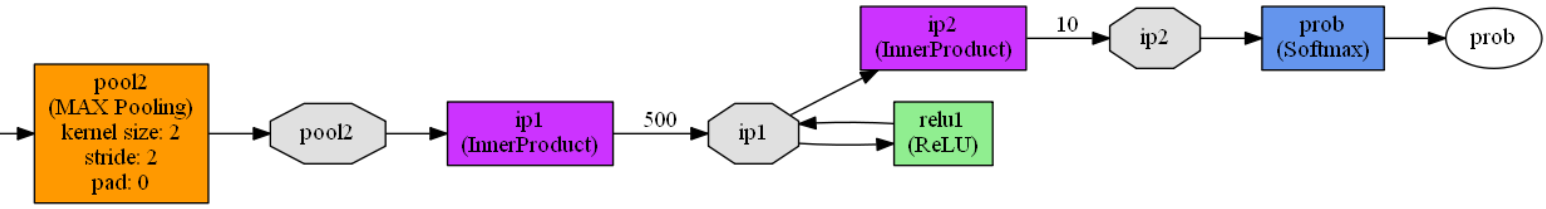

caffe中LetNet-5卷积神经网络模型文件lenet.prototxt理解

caffe在 .\examples\mnist文件夹下有一个 lenet.prototxt文件,这个文件定义了一个广义的LetNet-5模型,对这个模型文件逐段分解一下。

name: "LeNet" //网络的名称是LeNet

layer { //定义一个网络层

name: "data" //定义该网络层的名称为 data

type: "Input" //定义网络层的类型是 输入层

top: "data" //定义网络层的输出名称为data

//定义该网络层的训练参数

input_param {

//如果同时读取过多张图片进行训练,训练耗时比较久

//所以CNN中分组读入训练图片

//shape中第一个参数定义每组中包含图片数量

//第二个参数定义组数

//第三和第四个参数定义图片大小

//定义读取数据维度是: 64 1 28 28

shape: { dim: 64 dim: 1 dim: 28 dim: 28 }

}

}

//第一卷积层定义

layer { //定义一个网络层

name: "conv1" //网络层的名称是conv1

type: "Convolution" //网络层的类型是 卷积层

//模型结构图有两种常用画法,一种是从左到右,一种是从下到上

//caffe中使用从下到上画法,所以“bottom”表示的是上一层(输入层)

bottom: "data" //网络层的输入层是 data层

//同理,输出层在上,“top”表示输出

top: "conv1" //该层的输出层名称为conv1

//param定义权重和偏置的学习率,学习率大,迭代速度快,但是容易找不到最优解

//学习率小,迭代速度慢,耗时久

//如果有两个lr_mult参数,第一个表示权重(卷积核)的学习率系数,第二个表示偏置的学习率系数

//lr_mult定义的只是学习率系数,最终的值需要乘以solver.prototxt配置文件中配置的base_lr的值

//一般偏置的学习率系数是权重学习率系数的2倍

param {

lr_mult: 1 //该层权重学习率的系数为1

}

param {

lr_mult: 2 //该层偏置学习率的系数为2

}

//卷积操作的参数设置

convolution_param {

num_output: 20 //卷积输出特征图的数量为20

kernel_size: 5 //卷积核的大小是5*5

stride: 1 //卷积操作的步长是1,即卷积核逐个移动

weight_filler {

type: "xavier" //卷积核参数采用xavier方法初始化

}

bias_filler {

type: "constant" //偏置初始值为0

}

}

} //卷积完成之后,数据的维度变成 64 20 24 24

//第一池化层定义

layer {

name: "pool1" //网络层的名称是pool1

type: "Pooling" //网络层的类型是池化层

bottom: "conv1" //网络层的输入时conv1(第一卷积层)

top: "pool1" //网络层的输出名称是 pool1

//池化操作的参数设置

pooling_param {

pool: MAX //最大值池化

kernel_size: 2 //池化核尺寸 是2*2

stride: 2 //池化步长是2

}

} //第一池化完成之后,数据的维度变成 64 20 12 12

//第二卷积层定义

layer {

name: "conv2" //网络层的名称是conv2

type: "Convolution" //网络层的类型是卷积层

bottom: "pool1" //网络层的输入时 pool1(第一池化层)

top: "conv2" //网络层的输出名称是 conv2

param {

lr_mult: 1 //卷积核的学习率系数是1

}

param {

lr_mult: 2 //偏置的学习率系数是2

}

//第二卷积层参数设置

convolution_param {

num_output: 50 //输出特征图的数量

kernel_size: 5 //卷积核的尺寸是5*5

stride: 1 //卷积操作步长是1

weight_filler {

type: "xavier" //卷积核参数采用xavier方法初始化

}

bias_filler {

type: "constant" //偏置初始值为0

}

}

} //第二卷积操作完成之后,数据维度是 64 50 8 8

//第二池化层

layer {

name: "pool2" //网络层的名称是 pool2

type: "Pooling" //网络层的类型是池化层

bottom: "conv2" //网络层的输入时 conv2(第二卷积层)

top: "pool2" //网络层的输出名称是 pool2

pooling_param {

pool: MAX //池化方式是最大值池化

kernel_size: 2 //池化核大小是2*2

stride: 2 //池化步长是2

}

} //第二池化层完成之后,数据维度是 64 50 4 4

//第一层全连接层定义

layer {

name: "ip1" //网络层的名称是ip1

type: "InnerProduct" //网络层的类型是 全连接层

bottom: "pool2" //网络层的输入时 pool2(第二池化层)

top: "ip1" //网络层的输出名称是ip1

param {

lr_mult: 1 //卷积核的学习率系数是1

}

param {

lr_mult: 2 //偏置的学习率系数是2

}

//第一全连接层参数设置

inner_product_param {

num_output: 500 //输出向量维度,500个输出神经元

weight_filler {

type: "xavier" //卷积核参数采用xavier方法初始化

}

bias_filler {

type: "constant" //偏置初始值为0

}

}

} //第一全连接层完成之后数据的维度是 1 500 1 1

//激活函数层的定义

layer {

name: "relu1" //网络层的名称是relu1

type: "ReLU" //网络层的类型是ReLU激活函数

bottom: "ip1" //网络层的输入时ip1(第一全连接层)

top: "ip1" //网络层的输出名称是 ip1,跟输入名称一样

} //激活层完成之后,数据的维度是 1 500 1 1

//第二全连接层定义

//数据的分类判断在本层完成

layer {

name: "ip2" //网络层的名称是 ip2

type: "InnerProduct" //网络层的类型是全连接层

bottom: "ip1" //网络层的输入时 ip1(激活函数层)

top: "ip2" //网络层的输出名称是 ip2

param {

lr_mult: 1 //卷积核的学习率系数是1

}

param {

lr_mult: 2 //偏置的学习率系数是2

}

//第二全连接层参数设置

inner_product_param {

num_output: 10 //输出维度是10,分别是0~9的数字

weight_filler {

type: "xavier" //卷积核参数采用xavier方法初始化

}

bias_filler {

type: "constant" //偏置初始值为0

}

}

} //第二全连接层完成之后,数据的维度是 1 10 1 1

//输出层定义

layer {

name: "prob" //网络的名称是 prob

type: "Softmax" //网络的类型是损失函数

bottom: "ip2" //网络的输入是 ip2(第二全连接层)

top: "prob" //网络的输出名称是 prob

}lenet.prototxt模型可视化,可以作为对比:

caffe中LetNet-5卷积神经网络模型文件lenet.prototxt理解的更多相关文章

- 使用PyTorch简单实现卷积神经网络模型

这里我们会用 Python 实现三个简单的卷积神经网络模型:LeNet .AlexNet .VGGNet,首先我们需要了解三大基础数据集:MNIST 数据集.Cifar 数据集和 ImageNet 数 ...

- CNN-1: LeNet-5 卷积神经网络模型

1.LeNet-5模型简介 LeNet-5 模型是 Yann LeCun 教授于 1998 年在论文 Gradient-based learning applied to document ...

- 手写数字识别 ----卷积神经网络模型官方案例注释(基于Tensorflow,Python)

# 手写数字识别 ----卷积神经网络模型 import os import tensorflow as tf #部分注释来源于 # http://www.cnblogs.com/rgvb178/p/ ...

- 利用Tensorflow实现卷积神经网络模型

首先看一下卷积神经网络模型,如下图: 卷积神经网络(CNN)由输入层.卷积层.激活函数.池化层.全连接层组成,即INPUT-CONV-RELU-POOL-FC池化层:为了减少运算量和数据维度而设置的一 ...

- 【TensorFlow/简单网络】MNIST数据集-softmax、全连接神经网络,卷积神经网络模型

初学tensorflow,参考了以下几篇博客: soft模型 tensorflow构建全连接神经网络 tensorflow构建卷积神经网络 tensorflow构建卷积神经网络 tensorflow构 ...

- CNN-4: GoogLeNet 卷积神经网络模型

1.GoogLeNet 模型简介 GoogLeNet 是2014年Christian Szegedy提出的一种全新的深度学习结构,该模型获得了ImageNet挑战赛的冠军. 2.GoogLeNet 模 ...

- CNN-2: AlexNet 卷积神经网络模型

1.AlexNet 模型简介 由于受到计算机性能的影响,虽然LeNet在图像分类中取得了较好的成绩,但是并没有引起很多的关注. 知道2012年,Alex等人提出的AlexNet网络在ImageNet大 ...

- CNN-3: VGGNet 卷积神经网络模型

1.VGGNet 模型简介 VGG Net由牛津大学的视觉几何组(Visual Geometry Group)和 Google DeepMind公司的研究员一起研发的的深度卷积神经网络,在 ILSVR ...

- 吴裕雄--天生自然python Google深度学习框架:经典卷积神经网络模型

import tensorflow as tf INPUT_NODE = 784 OUTPUT_NODE = 10 IMAGE_SIZE = 28 NUM_CHANNELS = 1 NUM_LABEL ...

随机推荐

- UVA - 1642 Magical GCD 数学

Magical GCD The Magical GCD of a nonempty sequence of positive integer ...

- Windows挂载NFS目录权限问题

windows挂载Linux上的NFS后, 可能会出现没有权限打开文件的问题 解决方法: 在注册表中添加匿名用户的默认UID和GID 计算机\HKEY_LOCAL_MACHINE\SOFTWA ...

- 16.unix网络编程一卷 unp.h

unix网络编程 --ubuntu下建立编译环境 1.安装编译器,安装build-essential sudo apt-get install build-essential 2.下载本书的头文件 下 ...

- 1. Two Sum[E]两数之和

题目 Given an array of integers, return indices of the two numbers such that they add up to a specific ...

- 动态连通性问题:union-find算法

写在前面的话: 一枚自学Java和算法的工科妹子. 算法学习书目:算法(第四版) Robert Sedgewick 算法视频教程:Coursera Algorithms Part1&2 本文 ...

- 一个javascript面试题解析

; function fn(){ console.log(this.length); } var obj = { length: , method: function (fn) { fn(); // ...

- Paper-[acmi 2015]Image based Static Facial Expression Recognition with Multiple Deep Network Learning

[acmi 2015]Image based Static Facial Expression Recognition with Multiple Deep Network Learning ABST ...

- How an Event Enters a Cocoa Application

How an Event Enters a Cocoa Application An event is a low-level record of a user action that is usua ...

- 路飞学城Python-Day19(practise)

# 特性1.继承:2.多态:3.封装 # 1.继承的用处:通过继承就可以解决类与类之间的代码冗余关系 # 2.多态的用处:1.增加了程序的灵活性,以不变应万变,使用者都是同一种形式去调用(func(a ...

- 多进程Socket_Server

import socketserverclass MyServer(socketserver.BaseRequestHandler): def handle(self): #继承BaseRequest ...